基于多特征融合和深度置信网络的稻田苗期杂草识别

邓向武,齐 龙,马 旭,蒋 郁,2,陈学深,刘海云,陈伟烽

基于多特征融合和深度置信网络的稻田苗期杂草识别

邓向武1,齐 龙1※,马 旭1,蒋 郁1,2,陈学深1,刘海云1,陈伟烽1

(1. 华南农业大学工程学院,广州 510642;2. 华南农业大学现代教育技术中心,广州 510642)

杂草的准确识别是田间杂草精准防控管理的前提,机器视觉技术是实现杂草准确识别的有效手段。该文以水稻苗期杂草为研究对象,采集稻田自然背景下和不同光照条件下的6种杂草图像共928幅,包括空心莲子草、丁香蓼、鳢肠、野慈姑、稗草和千金子。采用1.1颜色因子将杂草RGB图像进行灰度化,选择自动阈值自动分割得到杂草前景二值图像,通过腐蚀膨胀形态学操作进行叶片内部孔洞填充,应用面积滤波去除其他干扰目标,最后将杂草二值图像与RGB图像进行掩膜运算得到去除背景的杂草图像;提取杂草图像的颜色特征、形状特征和纹理特征共101维特征,并对其进行归一化处理。在双隐含层和单隐含层的深度置信网络(deep belief networks,DBN)结构基础上,对DBN隐含层节点数选择方法进行研究。针对双隐含层DBN节点数,选择恒值型、升值型和降值型3种节点组合方式进行优化研究,当网络结构为101-210-55-6时杂草识别率为83.55%;通过对单隐含层节点参数优化得到网络结构为101-200-6时杂草识别率达到91.13%。以同一测试样本的运行时间值作为模型的测试时间对3种不同模型进行耗时测试,SVM模型、BP模型和DBN模型测试结果分别为0.029 7、0.030 6和0.034 1 s,试验结果表明基于多特征融合的DBN模型的识别精度最高,且耗时较其他2种模型相差不大,可满足实时检测的速度要求,所以在实际应用中应优先选择基于多特征融合的DBN模型。该研究可为稻田杂草识别与药剂选择性喷施提供参考。

机器视觉;图像处理;杂草识别;深度置信网络;多特征融合;特征提取

0 引 言

中国水稻种植面积常年稳定在3 000万hm2,超过65%的人口以稻米为主食[1]。在水稻生长过程中,稻田杂草与秧苗竞争养分、水分和生长空间,影响水稻秧苗的正常生长,降低水稻产量和质量;同时杂草为病虫害提供滋生和蔓延的条件,导致水稻病虫害爆发引起大量减产。目前农田杂草防控方式主要为化学除草[2-3],采用除草剂大面积均匀喷施方式,然而这种传统的除草剂施用方式常常造成化学药剂的过量施用,引起作物药害、土壤和水源污染、稻米农药残留等问题[4]。农药的精准喷施可在不影响杂草防控效果的前提下,有效节约40%~60%的农药用量[5]。稻田杂草种类识别是选择高效除草剂的依据,是稻田杂草精确防控管理的基础,因此,如何快速准确对稻田杂草自动识别具有重要意义。

机器视觉技术具有成本低和便捷易操作等特点,在精准农业方面得到了广泛应用。基于机器视觉技术的杂草识别[6]过程包括2大部分:1)特征选择和提取;2)分类器选择和训练。如何选择和设计有效的识别特征是杂草识别技术的关键所在,国内外学者分别对杂草的颜色[7-9]、形状[10-11]、纹理[12]等特征进行了研究和探索。为避免单一特征的局限性,进一步提高杂草识别精度和鲁棒性,颜色、形状和纹理等特征的融合[13-16]得到广泛应用。分类器选择是基于机器视觉技术杂草识别的另一个重点,在分类器选择上,当前分类学习算法多为浅层结构算法,包括常见的支持向量机(support vector machine,SVM)[17]、Booting[18]和逻辑回归[19]等。

近几年,深度学习以其强大的特征提取能力,在图像分类等任务上取得巨大成功。其中基于卷积神经网络(convolutional neural network,CNN)的旱田杂草识别[20]和水稻病害识别[21]取得很好的效果。基于原始图像直接构建CNN模型需大样本数据集,而针对小样本数据集,可基于训练好的经典CNN模型(如AlexNet[22]、GoogLeNet[23]和ResNet[24]等)提取特征建立分类模型,或通过迁移学习建立分类模型[25],但基于CNN模型的卷积计算对硬件资源要求较高[26]。因此,针对本文的稻田杂草小样本图像数据集,采用另一种应用广泛的深度置信网络(deep belief network,DBN)模型[27],其对硬件资源要求较小,且可作为特征分类器单独使用。深度置信网络(deep belief network,DBN)在农业领域已被成功应用于猪咳嗽声疾病预警[28]、苹果霉心病无损检测[29]、大棚冬枣病虫害预测[30]和鸡胚雌雄早期识别[31]等。

上述研究主要是针对所提取得到的各种特征进行DBN建模,但DBN结构参数都是在基于经验的基础上通过反复试验来选择,缺乏对DBN结构参数选择方法的相关研究。由于稻田杂草颜色差异小,同科属间杂草形态具有一定的相似性,此外稻田反光、倒影等因素也给稻田杂草种类的图像识别造成一定困难。本文提出一种DBN杂草图像分类算法,首先提取稻田杂草图像的颜色、形状和纹理等特征,然后以这些特征融合作为DBN的输入数据进行训练,并对DBN结构参数选择方法进行研究。通过对颜色、纹理和形状的多特征融合,解决稻田杂草单一特征识别率不高的问题,采用DBN进行训练,以克服单一特征及浅层结构算法(SVM、Boosting等)分类效果不佳的缺点。

1 材料与方法

1.1 图像获取及预处理

1.1.1 图像获取

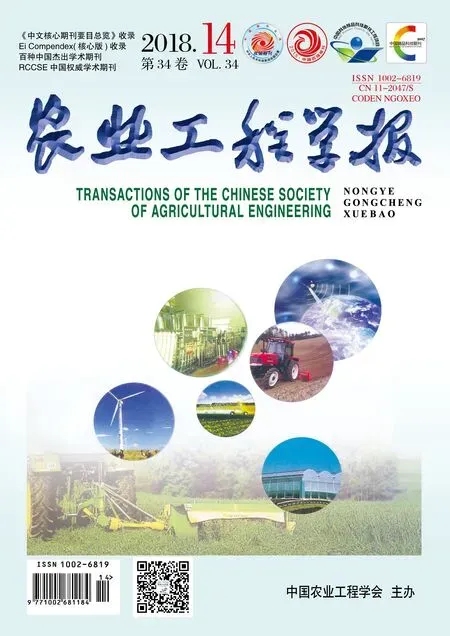

分别于2017年4月10-11日和同年8月7-8日在广东江门农科所农业试验基地稻田自然环境下,水稻试验田为机插秧试验田,固定行距为30 cm。由于除草剂的选择性使其具有不同的杀草谱,稻田杂草种类的准确识别可为除草剂的选择以及混合配方施用提供科学依据。在稻田化学除草精准防控管理过程中,主要针对稻苗行间杂草进行选择性喷施除草剂,所以本文采集杂草全部在水稻秧苗行间采集,不涉及稻苗图像的采集。采集早稻和晚稻秧苗移栽后7~15 d水稻田内的单株杂草图像,杂草处于幼苗生长期。为了充分考虑自然场景的天气条件,分别选择了晴天、多云和阴天进行图像采集。为了获取的图像有较大的代表性,采集方式为距离杂草20~40 cm、相机镜头垂直于稻田水面进行拍摄。采集设备为佳能单反数码相机,型号为IXUS 1000 HS(EF-S 36-360 mm f/3.4-5.6 IS STM),焦距设定为自动智能对焦,图像分辨率为640×480像素[32]。共采集华南稻区常规恶性杂草图像928幅,形成了稻田杂草图像库,分别为空心莲子草165幅、丁香蓼90幅、鳢肠243幅、野慈姑98幅、稗草165幅、千金子167幅,用于杂草识别模型的训练与测试,6种稻田杂草图像如图1所示。

1.1.2 图像预处理

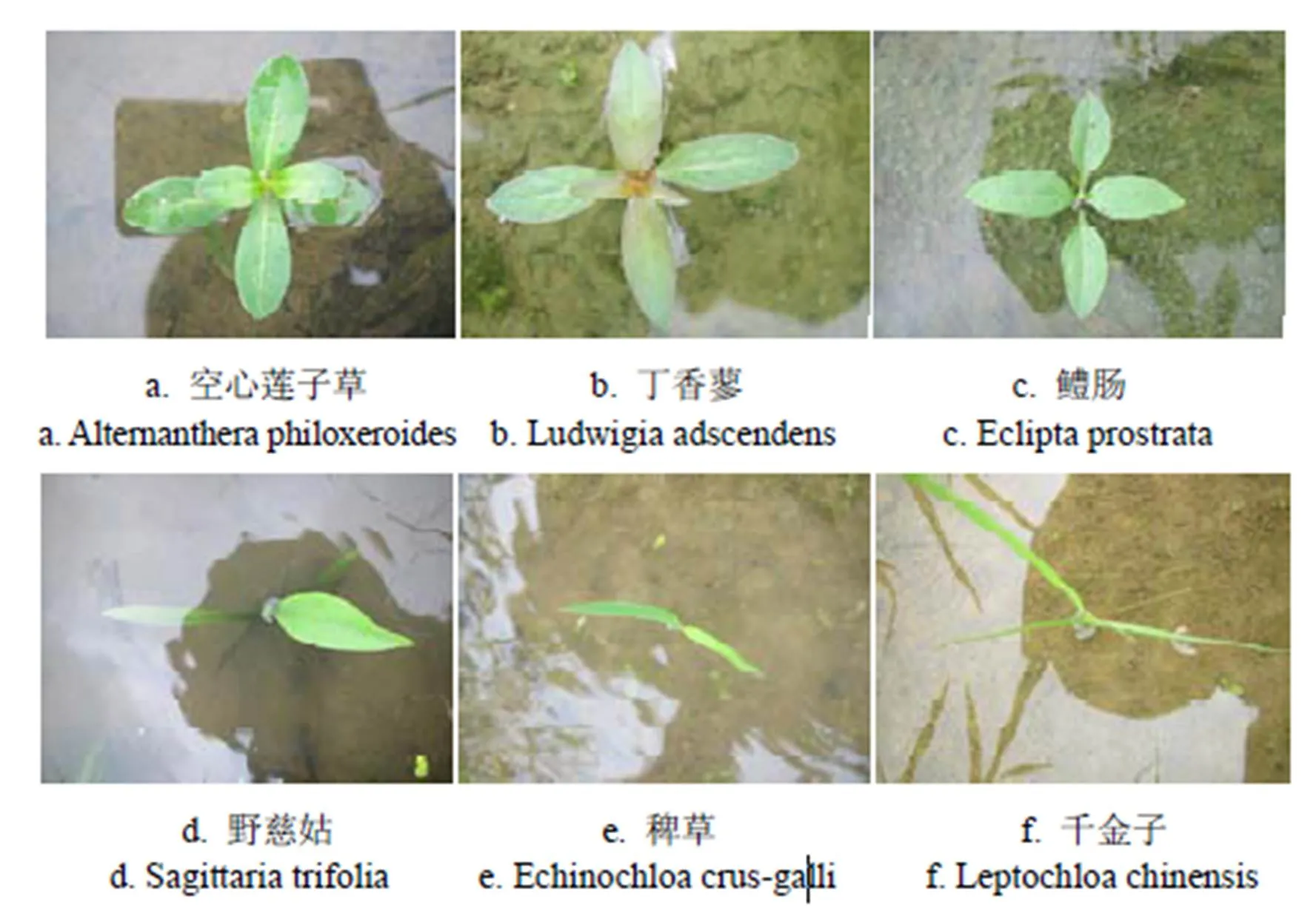

由于杂草图像全部是在上述田间自然环境下获取,图像拍摄时背景和光照都不同,背景包括水、泥土、阴影和秸秆等,光照条件有太阳直射、斜射、阴天和多云等天气情况,如图2所示。

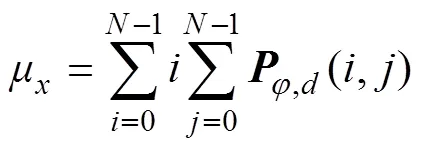

为突出稻田杂草自身颜色为绿色的特征,在去除RGB杂草图像背景的过程中,首先采用式(1)中的1.1颜色因子将空心莲子草RGB图像(如图3a所示)灰度化得到杂草的灰度图像,结果如图3b所示;基于最大类间方差法(OTSU法)计算阈值[33],将杂草灰度图像自动分割为二值图像,结果如图3c所示;通过腐蚀膨胀形态学操作进行叶片内部孔洞填充,应用面积滤波去除其他干扰目标,将杂草二值图像与RGB图像进行掩膜运算得到杂草的前景图像,结果如图3d所示。

图1 稻田杂草图像

图2 复杂背景和光照的空心莲子草图像

式中()为像素坐标为()的灰度值,和分别表示像素的红和绿2个颜色分量。

1.2 特征提取

由于稻田同科属间杂草颜色和形态间具有一定相似性,为提高识别效果,本文提取杂草图像的颜色、纹理、形状共3类特征作为稻田杂草的识别特征。

1.2.1 颜色特征

颜色特征是基于图像像素提取而来,具有旋转、尺度和平移不变性等优点。由于6种稻田苗期杂草颜色都为绿色,不同杂草RGB图像间颜色分量值存在较大的重叠部分;由于颜色矩能体现出图像的颜色分布特征,因此分析统计颜色特征中的颜色矩特征[34]能提高特征的辨识度。

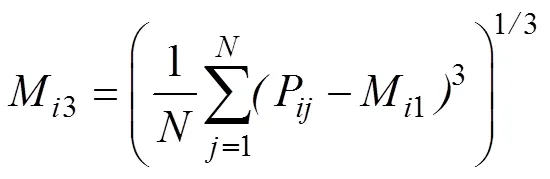

由于HSV(色调,饱和度,明度)颜色空间模型为RGB颜色空间模型转换而来,其更适合基于机器视觉的颜色表达,可作为杂草图像颜色特征的补充。但HSV颜色模型中的V分量与色彩无关,所以本文只需提取杂草图像RGB和HSV颜色空间模型下分量的颜色矩特征(一阶矩、二阶矩及三阶矩),共计15个颜色特征,计算如式(2)~(4)所示。

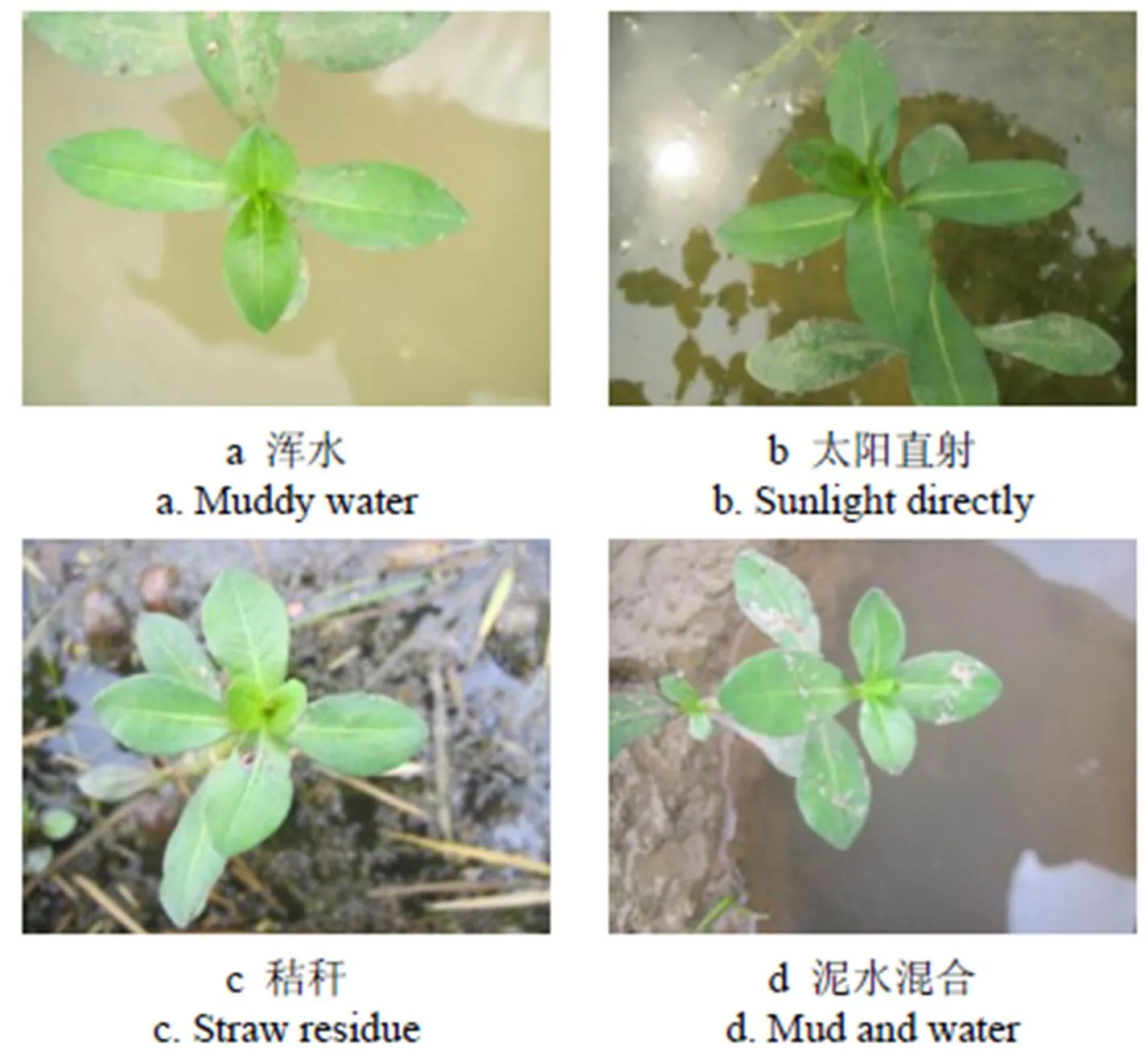

式中M1、M2、M3表示颜色的一阶矩(mean)、二阶矩(variance)和三阶矩(skewness),表示图像中像素的个数,P表示RGB图像中第个颜色通道分量中灰度的像素出现的概率。

1.2.2 形状特征

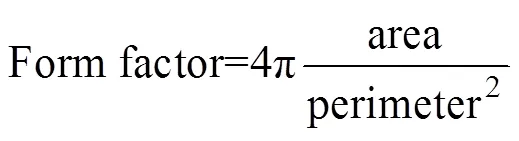

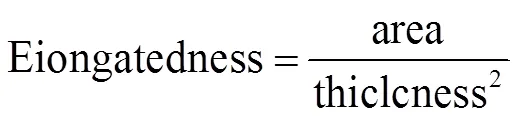

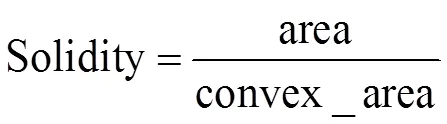

形态特征主要描述对象的形状参数,与人的视觉感知系统具有较好的关联性。由于不同种类杂草具有很大的形态差异,因此本文选择7个Hu不变矩[35-36]特征和几何特征作为杂草的形状特征,本文共采用4种几何特征[16]。

1)圆形度(Form factor)的计算公式为:

式中area为目标的面积,即目标的像素总数。perimeter为目标的周长,即目标的最外轮廓长度。

2)细长比(Eiongatedness)的计算公式为:

式中thiclcness为目标最小外接矩的宽。

3)凹凸度(Convexity)的计算公式为:

式中convex_perimeter为目标最小凸多边形的周长。

4)固靠度(Solidity)的计算公式为:

式中convex_area为目标最小凸多边形的面积。

1.2.3 纹理特征

纹理特征是一种反映像素间空间分布的区域特征,体现了物体表面组织结构的周期性变化。纹理包括规则纹理和随机纹理,而杂草图像纹理特征属于规则纹理和随机纹理的组合。由于在纹理提取方法中基于统计的纹理分析方法最常用且研究最多[37],本文选择基于统计纹理分析方法的灰度共生矩阵(gray-level co-occurrence matrix,GLCM)[38]和局部二进制模式(local binary patterns,LBP)[39],将2种纹理特征进行融合作为杂草图像的纹理特征。

1)灰度共生矩阵

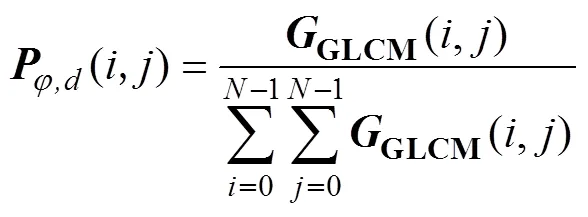

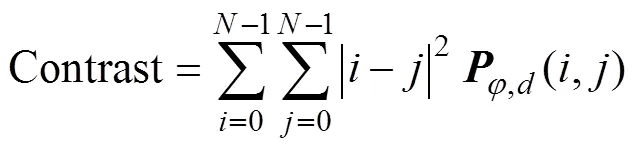

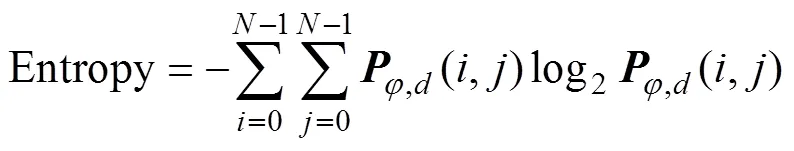

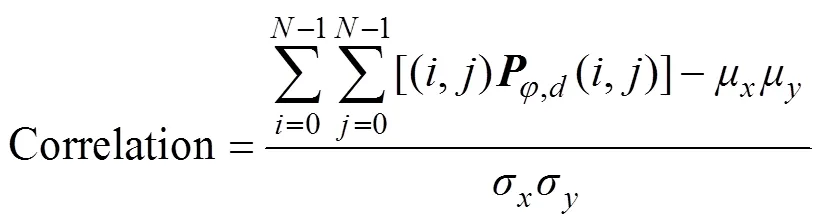

Cotlieb等[40]在研究GLCM中各种统计特征的基础上,通过试验得出GLCM的4个关键特征:对比度(contrast)、能量(asm)、嫡(entropy)和相关性(correlation)。在计算之前要对GLCM进行归一化,计算方法依次如式(9)~(13)所示。

式中(,)为归一化后的灰度共生矩阵,GLCM(,)为原灰度共生矩阵值。

在试验中首先将预处理后的图像转换为16个灰度级,然后计算4个方向(0°,45°,90°和135°)的4个GLCM关键特征,得到共计16个特征值。

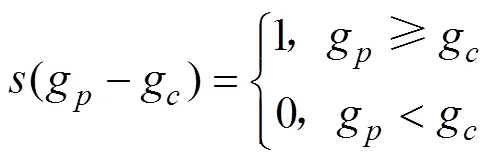

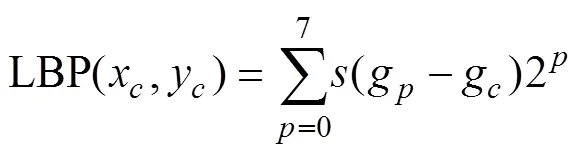

2)LBP特征

LBP具有原理简单、计算量小、灰度不变性和旋转不变性等优点[39]。LBP相关的基本符号定义如下:g表示局部区域中心点的灰度值,g(= 0,1,…,7)对应于中心点周围等距分布的点,(x,y)表示中心点的坐标。以(x,y)为中心的LBP局部区域纹理计算方法如式(14)~(15)所示。

对于邻域有8个点的LBP算子将会产生28种LBP值,邻域内采样点的数量决定纹理特征的维度。本文采用Uniform模式[41]对LBP特征维度进行降维,对于8个采样点,LBP特征维度减少为59种,如图4所示。

1.3 建立稻田杂草识别模型

DBN是由多个限制玻尔兹曼机(restricted boltzmann machine,RBM)构成的结构模型[42],因此DBN拥有和RBM一样的结构。本文重点对DBN网络结构参数选择方法进行研究,DBN网络结构参数主要包括网络模型深度及隐含层节点数。

本文是在提取杂草图像特征的基础上,以DBN作为分类器建立识别模型。由于杂草类别只有6类,所用DBN结构简单,无需用到dropout算法。由于输入向量维度为101维,且样本总数为928,形成928个101维的样本空间。其中最少类样本丁香蓼与最大类样本鳢肠的样本数之比为1∶2.7,属于平衡样本的范畴[43],因此不会降低本文中所用各分类器的性能。

图4 杂草的局部二进制模式特征

由于DBN网络模型深度对模型识别精度影响很大,网络深度过大容易陷入局部最优,网络深度过小易造成表达能力不足。结合样本数量和输入输出特征维度[28-31],在2种不同的DBN模型深度的基础上,即单隐含层和双隐含层的DBN网络结构模型对DBN隐含层节点数选择方法进行研究,2种DBN网络结构如图5所示。

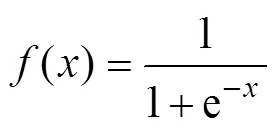

DBN网络结构主要包括输入层、隐含层和输出层,其中隐含层数目决定DBN网络的深度,为表述的简洁性,下文中DBN网络结构可简化为[输入层节点数,隐含层节点数,输出层节点数]。由于输入样本特征有101维,将输入层节点数设置为101;最后一层为杂草类别数量,所以输出层节点数量设置为6。为获得最终分类结果,在最后一层RBM中加入sigmoid函数进行回归,作为最终结果输出层。

sigmoid函数为:

2 试验与结果分析

整个测试过程操作系统为windows10,开发软件为MATLAB 2017b。计算机内存8 GB,搭载Intel@Core(TM) i7-7700HQCPU @ CPU 2.80GHz ×8处理器。

2.1 特征选择

本文采用多种算法提取杂草图像特征,包括:采用颜色矩算法提取颜色分量的一阶矩、二阶矩及三阶矩,共计15个颜色特征;采用灰度共生矩阵和LBP算法提取图像16个灰度共生矩阵和59个LBP特征;提取了圆形度、细长比、凹凸度和固靠度4种常用的几何特征以及7个Hu不变矩特征;并将所有特征进行融合,为下一步训练和测试提供良好的试验数据。

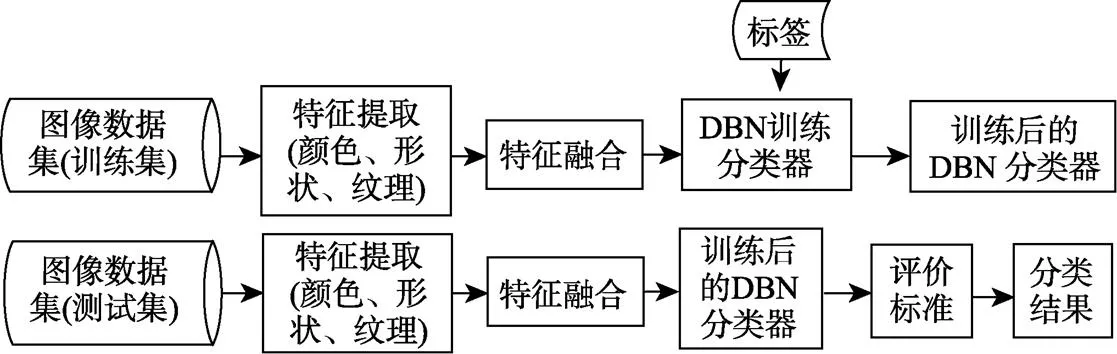

2.2 杂草识别流程

采用70%的稻田杂草图像样本作为训练集,剩余的样本作为测试集,算法流程如图6所示。

图6 杂草识别算法流程图

具体步骤如下:

1)特征表达与融合:对每一幅杂草图像提取其颜色、纹理和形状特征,共101个特征,形成101维的特征向量。

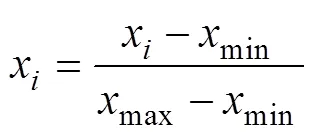

2)归一化处理:为保证不同杂草特征数据的尺度一致性,必须将所有特征值进行归一化处理。

其中x代表特征值元素,min和max代表最小和最大特征值元素。

3)数据分类:从928个101维的样本空间中选择650个作为训练集,其余278个的作为测试集。

4)训练过程:利用文献[44]中所述方法对本文的DBN模型进行训练。

5)测试过程:采用DBN训练过程得到的权重和偏置对测试集进行测试得出分类结果。

2.3 结果与分析

由于DBN隐含层节点参数需要依据经验选择,而隐含层节点数对训练时间和精度影响很大,所以网络节点如选择过小无法满足精度要求;选择过大会导致网络陷入局部最优,同时也给算法带来多余的隐含层节点,这些隐含层节点的数目超过必须所使用的隐含层节点点数,也会增加网络的复杂度[45]。因此,本文在单隐含层和双隐含层的DBN网络结构模型基础上,对DBN隐含层节点数选择方法进行研究。

2.3.1 双隐含层节点数确定

由于双隐含层DBN网络需确定隐含层节点数的层数为2,其中隐含层节点数变化趋势有3种:上升、下降和不变,所以本文选择升值型、降值型和恒值型3种隐含层节点数组合方式对双隐含层DBN网络模型参数进行优化试验。恒值型是指隐含层节点数都相等,升值型是指隐含层节点数的选择随隐含层数而递增,降值型是指隐含层节点数的选择随隐含层数而递减。

迭代次数设置为250次,样本批次为42,学习率为0.001,试验结果取10次运算的平均值。3种隐含层节点数组合方式的DBN模型识别率如表1所示,恒值型和升值型双隐含层的识别率不如降值型,表明节点数为降值型的隐含层模型能够较好学习到原始特征数据的分布式特征。在选择降值型的隐含层节点数时,当隐含层节点数过少(25-12和50-25)或过多(300-150)模型参数得不到充分训练而导致识别率低,当隐含层节点数在一定范围内,模型识别率随降值型隐含层节点数的增加而得到提升。

为确定最优的双隐含层DBN网络隐含层节点参数,根据表1在区间[150,300]内,按固定间隔10依次选择第1层隐含层节点数;第2层隐含层节点数分别按第一层隐含层节点数的1/2、1/4和1/6计算取整数值。通过对不同双隐含层节点数组合进行试验验证,最终得到双隐含层DBN的网络结构为[101,210,55,6]时,模型的识别率最优,达到83.55%。

表1 双隐含层DBN中不同隐藏层节点组合模型的杂草识别率

注:25-25代表隐含层1和隐含层2的节点数。

Note: 25-25 respectively represent nodes number in the first hidden layer and the second hidden layer.

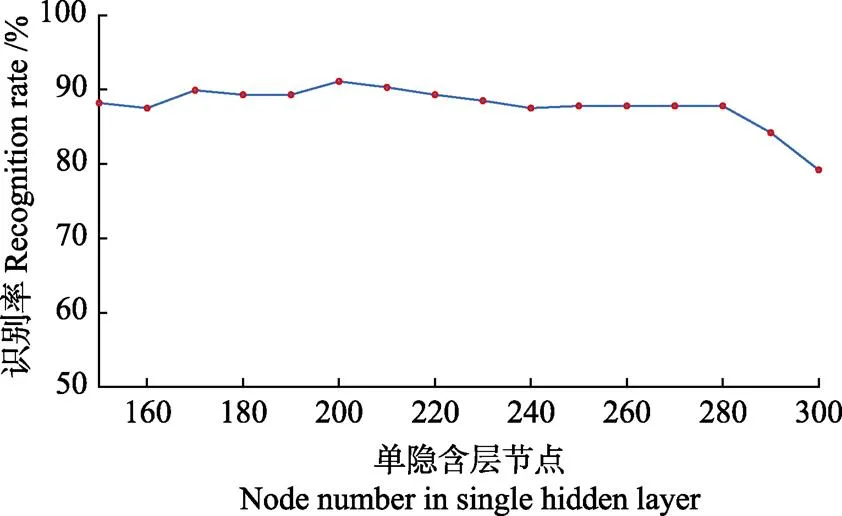

2.3.2 单隐含层节点数确定

由于单隐含层DBN网络需确定隐含层节点数的层数为1,可根据表1选取合理的单隐含层节点数区间[150,300]进行优化试验,节点数按固定间隔10进行选择。如图7所示,通过试验得出单隐含层DBN模型隐含层节点数设置为200时,即DBN网络结构为[101,200,6]时识别率最高,达到91.13%。

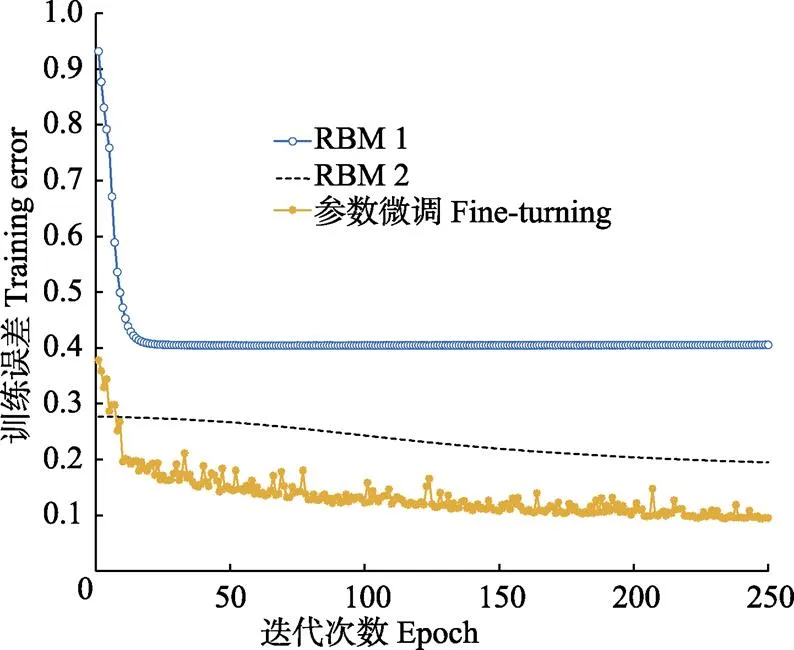

本文单隐含层DBN结构一共由2层RBM叠加而成,如图5a所示,输入层和隐含层构成RBM1,隐含层和输出层构成RBM2。网络每一层RBM的预训练是通过无监督学习来完成,其训练结果作为高一层RBM的输入,最后通过监督学习去调整所有RBM层的网络参数。如图8所示,训练错误率在第一层RBM的前20次迭代训练过程中大幅下降,但是在25次迭代训练后错误率不再变化,RBM内的参数值都趋向稳定;第二层RBM内参数的训练是在第一层RBM参数的基础上进行训练,参数的变化比较平缓,模型趋向于稳定;最后进行一次有监督网络参数微调并进行分类训练,得到最终的训练结果。

图7 不同单隐含层节点数DBN模型识别率

图8 单隐含层DBN的训练误差曲线

由于基于DBN为数据驱动型模型结构[46],针对不同的数据样本与之有相对应的最优网络结构。本文在双隐含层和单隐含层的DBN网络结构基础上,针对本文928个101维的样本空间,其中650个样本作为训练集,其余278个样本作为测试集。分别对其隐含层节点数进行优化。试验结果得出单隐含层DBN网络结构相比于双隐含层DBN网络结构可取得更高的识别率,表明单隐含层DBN网络结构能更好地适应所提取杂草特征样本的数据结构,并能挖掘出本文样本数据的分布特征,取得更高的识别率。因此,下文基于稻田杂草单一特征和融合特征进行DBN建模都采用单隐含层DBN网络结构。

2.4 杂草识别方法比较

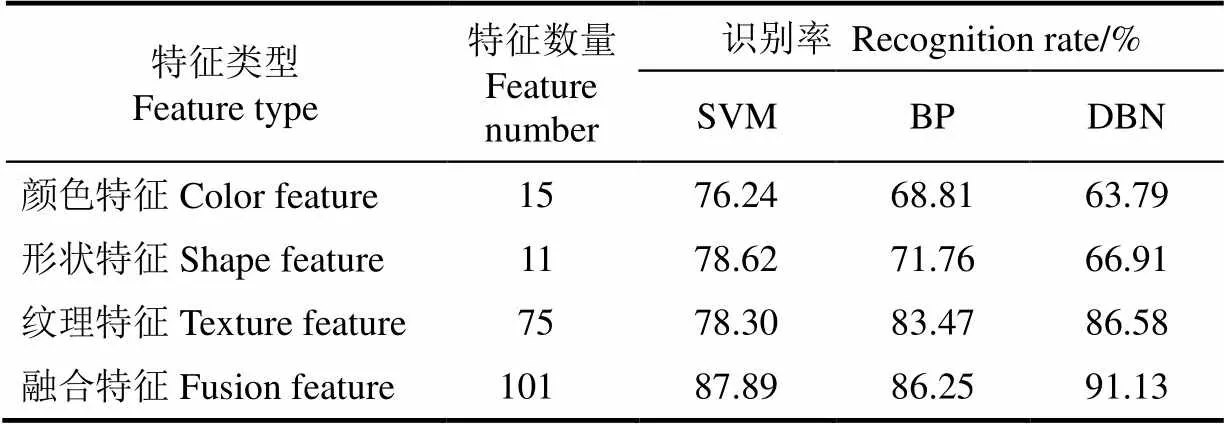

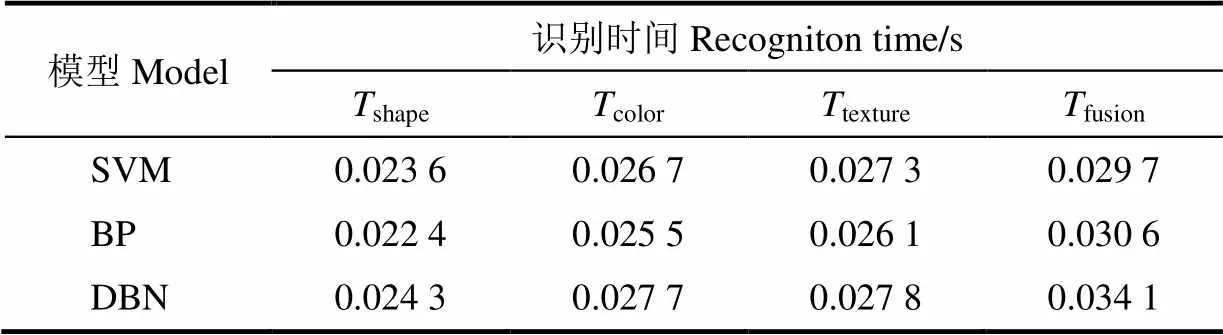

本文提取了稻田杂草图像的颜色、形状和纹理单一特征,并对3种特征进行融合得到融合特征,基于单一特征和融合特征分别构建了SVM、BP人工神经网络[47]和DBN的杂草识别模型。从表2可以看出,基于单一颜色和形状特征的DBN模型的识别率低于SVM模型和BP模型,由于单一颜色和形状特征维度较小,不能体现出DBN模型的特征表达优势;基于单一纹理特征和融合特征的DBN模型识别率高于SVM模型和BP模型,由于DBN为挖掘数据分布式特征的网络结构,可较好适应数据高维结构并挖掘出数据的分布特征,纹理特征和融合特征的特征维度足以有效驱动本文所建的DBN模型,使其对纹理特征和融合特征数据进行特征表达。

表2 基于不同分类器模型和不同特征的杂草识别率

针对278个杂草图像测试样本的形状、颜色、纹理及融合特征,以同一测试样本的运行时间值作为模型的测试时间。由表3可知,针对101维融合特征测试样本的3种模型,SVM模型、BP模型和DBN模型的测试时间分别为0.029 7、0.030 6和0.034 1 s,即SVM+fusion 表3 基于不同分类器模型和不同特征的杂草测试集识别时间 本文根据稻田复杂背景及伴生杂草颜色特点,提出1.1颜色因子灰度化杂草图像,并采用阈值分割及形态学处理得到杂草目标图像;根据杂草种类间的颜色形态等特点选择颜色矩特征、几何特征、Hu不变矩、灰度共生矩阵和LBP纹理特征作为杂草的识别特征。 1)建立了2种不同的DBN网络模型,选择不同节点组合方式对双隐含层DBN模型识别效果进行探究,试验得出单隐含层网络结构比双隐含层网络结构识别率高,且节点数为[101,200,6]的单隐含层网络结构最佳,识别率达91.13%。 2)针对测试样本的形状、颜色、纹理及融合特征,分别构建了SVM、BP和DBN共3种杂草特征识别模型,通过模型准确率和识别时间的比较,基于多特征融合的DBN模型的识别率最高为91.13%,且耗时较其他2种模型相差不大,可满足实时检测的速度要求,所以在实际应用中应优先选择基于多特征融合的DBN模型。 [1] 赵凌,赵春芳,周丽慧,等. 中国水稻生产现状与发展趋势[J]. 江苏农业科学,2015,43(10):105-107. Zhao Ling, Zhao Chunfang, Zhou Lihui, et al. Production status and developing trend of rice in China[J]. Jiangsu Agricultural Sciences, 2015, 43(10): 105-107. (in Chinese with English abstract) [2] Sogaard H T, Lund I, Graglia E. Real-time application of herbicides in seed lines by computer vision and micro-spray system[J]. American Society of Agricultural and Biological Engineers, 2006, 12: 118-127. [3] 马旭,齐龙,梁柏,等.水稻田间机械除草装备与技术研究现状及发展趋势[J]. 农业工程学报,2011,27(6):162-168. Ma Xu, Qi Long, Liang Bai, et al. Present status and prospects of mechanical weeding equipment and technology in paddy field[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2011, 27(6): 162-168. (in Chinese with English abstract) [4] 刘延,刘波,王险峰,等. 中国化学除草问题与对策[J]. 农药,2005,44(7):289-293. Liu Yan, Liu Bo, Wang Xianfeng, et al. Problems and solutions for chemical weed control in China[J]. Chinese Journal of Pesticides, 2005, 44(7): 289-293. (in Chinese with English abstract) [5] Jensen H G, Jacobsen, L B, Pedersen S M, et al. Socioeconomic impact of widespread adoption of precision farming and controlled traffic systems in Denmark[J]. Precision Agriculture, 2012, 13(6):661-677. [6] 范德耀,姚青,杨保军,等. 田间杂草识别与除草技术智能化研究进展[J]. 中国农业科学,2010,43(9):1823-1833. Fan Deyao, Yao Qing, Yang Baojun, et al. Progress in research on intelligentization of field weed recognition and weed control technology[J]. Scientia Agricultura Sinica, 2010, 43(9): 1823-1833. (in Chinese with English abstract) [7] 沈宝国,陈树人,尹建军,等. 基于颜色特征的棉田绿色杂草图像识别方法[J]. 农业工程学报,2009,25(6):163-167.Shen Baoguo, Chen Shuren, Yin Jianjun, et al. Image recognition of green weeds in cotton fields based on color feature[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2009, 25(6): 163-167. (in Chinese with English abstract). [8] 张小龙,谢正春,张念生,等. 豌豆苗期田间杂草识别与变量喷洒控制系统[J]. 农业机械学报,2012,43(11): 220-225. Zhang Xiaolong, Xie Zhengchun, Zhang Niansheng, et al. Weed Recognition from pea seedling images and variable spraying control system[J]. Transactions of the Chinese Society for Agricultural Machinery, 2012, 43(11): 220-225. (in Chinese with English abstract) [9] 韩丁,武佩,张强,等. 基于颜色矩的典型草原牧草特征提取与图像识别[J]. 农业工程学报,2016,32(23):168-175.Han Ding, Wu Pei, Zhang Qiang, et al. Feature extraction and image recognition of typical grassland forage based on color moment[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(23): 168-175. (in Chinese with English abstract) [10] 李先锋,朱伟兴,纪滨,等. 基于图像处理和蚁群优化的形状特征选择与杂草识别[J]. 农业工程学报,2010,26(10):178-182. Li Xianfeng, Zhu Weixing, Ji Bin, et al. Shape feature selection and weed recognition based on image processing and ant colony optimization[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2010, 26(10): 178-182. (in Chinese with English abstract). [11] Herrera P J, Dorado J, Ribeiro Á. A novel approach for weed type classification based on shape descriptors and a fuzzy decision-making method[J]. Sensors, 2014, 14, 15304-15324. [12] Pahikkala T, Kari K, Mattila H, et al. Classification of plant species from images of overlapping leaves[J]. Computers and Electronics in Agriculture, 2015, 118: 186-192. [13] 何东健,乔永亮,李攀,等. 基于SVM-DS多特征融合的杂草识别[J]. 农业机械学报,2013,44(2):182-187. He Dongjian, Qiao Yongliang, Li Pan, et al. Weed recognition based on SVM-DS multi-feature fusion[J]. Transactions of the Chinese Society for Agricultural Machinery, 2013, 44(2): 182-187. (in Chinese with English abstract) [14] 王璨,李志伟. 利用融合高度与单目图像特征的支持向量机模型识别杂草[J]. 农业工程学报,2016,32(15):165-174.Wang Can, Li Zhiwei. Weed recognition using SVM model with fusion height and monocular image features[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactionsof the CSAE), 2016, 32(15): 165-174. (in Chinesewith English abstract). [15] 赵鹏,韦兴竹. 基于多特征融合的田间杂草分类识别研究[J]. 农业机械学报,2014,45(3):275-281. Zhao Peng, Wei Xingzhu. Weed recognition in agricultural field using multiple feature fusions[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(3): 275-281. (in Chinese with English abstract) [16] Ahmed F, Al-Mamun H A, Hossain-Bari A S M, et al. Classification of crops and weeds from digital images: A support vector machine approach[J]. Crop Protection, 2012, 40: 98-104. [17] Suykens J A K, Vandewalle J. Least squares support vector machine classifiers[J]. Neural Processing Letters, 1999, 9(3): 293-300. [18] Freund Y, Schapire R E. Experiments with a new boosting algorithm[C]// Proceedings of the Thirteenth ICML. Washington D.C., USA:IEEE Press, 1996: 148-156. [19] Lin C Y, Tsai C H, Lee C P, et al. Large-scale logistic regression and linear support vector machines using spark [C]//Proc of IEEE International Conference on Big Data. IEEE, 2014: 519-528. [20] Dyrmann M, Karstoft H, Midtiby H S. Plant species classification using deep convolutional neural network[J]. Biosystems Engineering, 2016, 151: 72-80. [21] Lu Yang, Yi Shujuan, Zeng Nianyin. Identification of rice diseases using deep convolutional neural networks[J]. Neurocomputing, 2017 (267): 378-384. [22] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]// Proceedings of the 2012 Advance in Neural Information Processing Systems, NIPS, 2012, 60(2): 1097-1105. [23] Szegedy C, Wei L, Yangqing J, et al. Going deeper with convolutions[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition, CVPR,2015:1-9. [24] He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition, CVPR, 2016: 770-778. [25] 段萌,王功鹏,牛常勇. 基于卷积神经网络的小样本图像识别方法[J]. 计算机工程与设计,2018,39(1):224-229. Duan Meng, Wang Gongpeng, Niu Changyong, et al. Method of small sample size image recognition based on convolution neural network[J]. Computer Engineering and Design, 2018, 39(1): 224-229. (in Chinese with English abstract). [26] 卢冶,陈瑶,李涛,等. 面向边缘计算的嵌入式FPGA卷积神经网络构建方法[J]. 计算机研究与发展,2018,55(3):551-562. Lu Ye, Chen Yao, Li Tao, et al. Convolutional neural network construction method for embedded FPGAs oriented edge computing[J]. Journal of Computer Research and Development, 2018, 55(3): 551-562. (in Chinese with English abstract) [27] Zhou Shusen, Chen Qingcai, Wang Xiaolong. Discriminative deep belief networks for image classification[C]// IEEE 17th International Conference on Image Processing, Hong Kong, 2010: 1561-1564. [28] 黎煊,赵建,高云,等. 基于深度信念网络的猪咳嗽声识别[J]. 农业机械学报,2018,49(03):179-186. Li Xuan, Zhao Jian, Gao Yun, et al. Recognition of pig cough sound based on deep belief nets [J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(3): 179-186. (in Chinese with English abstract) [29] 周兆永,何东健,张海辉,等. 基于深度信念网络的苹果霉心病病害程度无损检测[J]. 食品科学,2017,38(14): 297-303. Zhou Zhaoyong, He Dongjian, Zhang Haihui, et al. Non- destructive detection of moldy core in apple fruit based on deep belief network[J]. Food Science, 2017, 38(14): 297-303. (in Chinese with English abstract) [30] 张善文,张传雷,丁军. 基于改进深度置信网络的大棚冬枣病虫害预测模型[J]. 农业工程学报,2017,33(19):202-208. Zhang Shanwen, Zhang Chuanlei, Ding Jun. Disease and insect pest forecasting model of greenhouse winter jujube based on modified deep belief network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(19): 202-208. (in Chinese with English abstract) [31] 祝志慧,汤勇,洪琪,等. 基于种蛋图像血线特征和深度置信网络的早期鸡胚雌雄识别[J]. 农业工程学报,2018,34(6):197-203. Zhu Zhihui, Tang Yong, Hong Qi, et al. Female and male identification of early chicken embryo based on blood line features of hatching egg image and deep belief networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(6): 197-203. (in Chinese with English abstract) [32] 王璨,武新慧,李志伟. 基于卷积神经网络提取多尺度分层特征识别玉米杂草[J]. 农业工程学报,2018,34(5):144-151. Wang Can, Wu Xinhui, Li Zhiwei. Recognition of maize and weed based on multi-scale hierarchical features extracted by convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(5): 144-151. (in Chinese withEnglish abstract) [33] Otsu N. A threshold selection method from gray-level histogram[J]. IEEE Trans. Syst. Man Cybern, 1979, 9(1): 62-66. [34] Zhang Lei, Lin Fuzong, Zhang Bo. A CBIR method based on color spatial feature[C]// Proceedings of the IEEE Region 10 Conference. IEEE, 1999: 166-169. [35] Wong Y R. Scene matching with invariant moments[J]. Computer Graphics and Image Processing, 1978, 8(1): 16-24. [36] Hu M K. Visual pattern recognition by moment invariants[J]. IRE Transaction Information Theory, 1962, 8(2): 179-187. [37] 赵洋. 基于局部描述子的纹理识别方法及其在叶片识别方面的应用[D]. 合肥:中国科学技术大学,2013. Zhao Yang. Local Descriptor Methods for Texture Classification and Leaves Recognition[D]. Hefei: University of Science and Technology of China, 2013. (in Chinese with English abstract) [38] Haralick R M, Shanmugam K, Dinstein I H. Textural features for image classification[J]. IEEE Transactions on Systems, Man, and Cybernetics, 1973, 3(6): 610-621. [39] Liu L, Fieguth P, Guo Y, et al. Local binary features for texture classification: Taxonomy and experimental study[J]. Pattern Recognition, 2017, 62: 135-160. [40] Gotlieb C C, Kreyszig H E. Texture descriptors based on co-occurrence matrices[J].Computer Vision, Graphics, and Image Processing, 1990, 51: 70-86.. [41] Ojala T, Pietikäinen M, Mäenpää T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J].IEEE Transactions Pattern Analysis & Machine Intelligence, 2002, 24(7): 971-987. [42] Lecun Y, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324. [43] Weiss G M, Provost F. Learningwhen training data are costly: The effect of class distribution on tree induction[J] Journal ofArtificial Intelligence Research, 2003, 19(1): 315-354. [44] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm fordeep belief nets[J]. Neural Comput, 2006, 18(7): 1527-1554. [45] 潘广源,柴伟,乔俊飞. DBN网络的深度确定方法[J]. 控制与决策,2015,30(2):256-260. Pan Guangyuan, Chai Wei, Qiao Junfei. Calculation for depth of deep belief network[J]. Control and Decision, 2015, 30(2): 256-260. (in Chinese with English abstract) [46] 葛强强. 基于深度置信网络的数据驱动故障诊断方法研究[D]. 哈尔滨:哈尔滨工业大学,2016. Ge Qiangqiang. Research on Data-driven Fault Diagnosis Method based on Deep Belief Network[D]. Harbin: Harbin Institute of Technology, 2016. (in Chinese with English abstract) [47] Debabrata M, Surjya K P, Partha S. Back propagation neural network based modeling of multiresponse of an electrical discharge machining process[J]. International Journal of Knowledge-based and Intelligent Engineering Systems, 2007(11): 105-113. Recognition of weeds at seedling stage in paddy fields using multi-feature fusion and deep belief networks Deng Xiangwu1, Qi Long1※, Ma Xu1, Jiang Yu1,2, Chen Xueshen1, Liu Haiyun1, Chen Weifeng1 (1.510642,; 2.510642,) Weed identification was the key to the site-specific weed management in the field. The machine vision method was adopted to realize automatic and rapid detection of weeds. This paper selected 6 weed species in paddy fields, including,,,,, and, which were captured in early growth stages with natural background and variable illumination. A total of 928 images were taken. The,, andwere dicotyledonous weeds which had large heart-shaped opposite leaves, and the other 3 weed species were monocotyledonous weeds which had narrow leaves. The image was 640×480 pixels and only a single seedling of weed was in the scene, and the acquisition format was color images of RGB (red, green, blue). The component with 1.1-was applied to gray level transformation of original RGB images. The OTSU adaptive segmentation method was adopted to realize the image segmentation of grayscale image. The morphological operation was used to fill vacancies in weed images. The noises and small target were eliminated based on area-reconstruction operator. The background was removed by masking algorithm between binary image and original RGB images. The 101-dimensional features were extracted from the foreground image of weed, including color, shape and texture feature. The color feature was composed of the first, second and third moments, the shape feature was composed of geometric features and improved moment invariant features, and the texture feature was composed of gray level co-occurrence matrix and local binary patterns (LBP) feature. The weighting matrix of color, shape and texture feature would be the input parameter after unitary processing. A three-step method for model updating consisting of model structure tuning, model parameter updating and model validation was presented in this article. Firstly, the deep belief networks (DBNs) of double hidden layers and single hidden layer were established. Secondly, the influence of the 3 types of constant, rising and descending nodes of double hidden layers in DBN was analyzed. The experimental result showed that the descending nodes of double hidden layers in DBN could learn the distributed characteristics of the original characteristic data better than the other node types of double hidden layers. Finally, the testing optimization parameters of double hidden layers and single hidden layer were obtained by experiment. The recognition rate of double hidden layers of DBN was 83.55% when the number of nodes stood at 101-210-55-6, and the recognition rate of single hidden layer of DBN was 91.13% when the number of nodes stood at 101-200-6. The DBN structure of single hidden layer was better able to excavate the distribution rule of weed features than DBN with double hidden layer. The single color, shape, texture and fusion feature were used to construct 3 types of weed classification models, which were support vector machine (SVM), BP (back propagation) neural network and DBN. In the experiment, the recogniton rate of DBN model with single color and shape feature was lower than that of the SVM and BP neural network model. The dimensions of color and shape feature were relatively small, which could not reflect the advantage of characteristic representation with DBN. On the other hand, the recognition of DBN model with single texture and fusion feature was more accurate than that of the SVM and BP neural network model, and the recognition rate of DBN model reached 86.58% and 91.13% with single texture and fusion feature, respectively. The results demonstrate that the method put forward in the paper can improve the classification accuracy of weeds with the complex background and variable illumination in paddy fields. machine vision; image processing; weed classification; deep belief networks (DBN); multi-feature fusion; feature extraction 10.11975/j.issn.1002-6819.2018.14.021 TP391.41 A 1002-6819(2018)-14-0165-08 2018-03-28 2018-05-30 国家自然科学基金(51575195);现代农业产业技术体系建设专项资金(CARS-01-43);广东省自然科学基金(2015A030313402);广州市科技计划项目(201803020021) 邓向武,男,博士生,主要从事图像处理与机器学习研究。Email:dengxiangwu123456@163.com 齐 龙,男,研究员,博士生导师,主要从事图像处理与图像识别研究。Email:qilong@scau.edu.cn 邓向武,齐 龙,马 旭,蒋 郁,陈学深,刘海云,陈伟烽. 基于多特征融合和深度置信网络的稻田苗期杂草识别[J]. 农业工程学报,2018,34(14):165-172. doi:10.11975/j.issn.1002-6819.2018.14.021 http://www.tcsae.org Deng Xiangwu, Qi Long, Ma Xu, Jiang Yu, Chen Xueshen, Liu Haiyun, Chen Weifeng. Recognition of weeds at seedling stage in paddy fields using multi-feature fusion and deep belief networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(14): 165-172. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2018.14.021 http://www.tcsae.org

3 结 论