基于立体视觉的水下三维测量系统研究

张洪龙 陈 涛 庄培钦 周志盛 宋 展 焦国华 乔 宇

1(中国科学院深圳先进技术研究院 深圳市虚拟现实与人机交互重点实验室 深圳 518055)

2(中国科学院大学深圳先进技术学院 深圳 518055)

1 引 言

作为海洋研究的一项基础技术,水下视觉测量技术已经得到众多研究者的关注。国外的研究者较早展开了水下测量方面的研究,国内起步稍晚,但也取得了丰硕的研究成果。如中国研制的“蛟龙号”深潜机器人、中国科学院沈阳自动化研究所的水下机器人、加拿大的 Sea-wolf3水下机器人和日本的“海沟号”水下机器人等,这些水下设备无一例外地搭载了视觉设备,并构建视觉测量系统。

目前使用的水下探测技术主要有水声学和水光学两大类。其中,水光学中水下视觉技术发展晚于其他水下探测技术,但由于其低成本、高精度、高分辨率等优良特点受到研究者的青睐。国内外学者对此展开了深入的探索和研究。光在水下有独特的传播特性,海水对 0.47~0.58μm 波段内蓝绿光的衰减比其他短波长的光衰减要小得多[1]。光波在水中会被吸收,也会发生散射,因此光波在水中的衰减相当快,且衰减程度和传播距离呈指数关系。由于水下环境复杂,存在水对光的散射和吸收、水体自身的流动、水中的悬浮颗粒以及各种浮游生物等因素的干扰,水下光源会衰减直至消失,这是水下成像需要考虑并解决的关键问题之一。光在不同水质的传播特性对成像品质有较大影响。很多学者研究了不同水质(如泳池、水族箱、近海海水等)中相机的成像情况,结论是在浑浊度低、照明度适中的环境下,视觉测量能够取得更高的精度[2-4]。

本文针对水下三维测量的需求,搭建了水下双目立体视觉系统,对水下光线散射、折射、吸收等问题展开讨论,并对在空气、池塘、近海等不同环境中的相机成像、双目相机标定、系统测量等问题进行了研究。实验结果表明,在水下环境中,系统成像距离高达 8m,有效测量范围为0.5~4.5m,测量误差小于 2cm。实验验证了成像模型、立体标定、测量模型等方法的可靠性,水下测量结果符合预期的技术指标。

2 相关研究进展

针对水质的差异、水上成像与水下成像的区别,水下视觉测量主要从图像增强、相机标定、畸变模型等方面着手对现有水上测量模型进行了改进。视觉测量完全依赖于图像质量的高低,图像复原成了图像预处理的首选操作。Sanchez-Ferreira 等[5-7]研究中首先进行图像复原,然后再进行后续标定、匹配、测量等操作并得到了预期的测量结果。

相机标定是视觉测量中的关键步骤之一,水下视觉测量的标定需要考虑光在水下的传播特性。Li 等[8]基于张氏标定法[9],结合 Jean-Yves Bouguet 灭点标定方法[10],建立了综合考虑径向畸变和切向畸变的水下相机非线性数学模型,获取了更高精度的参数和平均误差更小的重投影误差。由于水的流动性较强,流动过程中的水可能导致图像运动模糊、光路变化等问题,从而得到错误的测量结果。Pang 等[11]针对静态水池和动态水流环境分别采用不同的标定方法,在两种状态下均得到了有效的标定参数和测量结果,但是水流变化多端,无法预测,因此面对不同运动状态下的水流采用不同的标定方法适用场景有限。随着研究的深入,研究成果也逐步落地,越来越多基于双目视觉的水下三维重建、水下跟踪定位、水下目标检测识别等应用层出不穷。Massot-Campos 等[12]对比了结构光和双目立体视觉在水下环境下的三维重建,也有研究者将双目视觉应用于水下洞穴、水底地形的探测和三维重建[13,14]。

潜水、捕鱼、测绘等水下活动日渐频繁,水下目标实时跟踪监控的应用也日趋成熟,如潜水人员位姿监测、鱼群监测、珊瑚礁监测等。Xu等[15]建立基于混合高斯模型的目标识别模型,提取目标图像中的特征点进行匹配,从而获得目标的位置和朝向。Chavez 等[16]将双目视觉应用于水下环境中场景或物体的三维点云,并结合LSTM-RNN 监测算法实时监测潜水人员姿态,确保潜水人员生命安全。

水下机器人广泛应用于水下测绘、海洋资源勘探、海洋生物探测等方面,而自主水下机器人则需要更多外部信息辅助自身的定位、导航、运动控制。Carrasco 等[17]使用双目视觉构建了SLAM 系统,并且取得了优于 IMU 和 GPS 的定位、导航和控制效果。水下机器人的伺服控制大多依赖于视觉定位,研究者将双目视觉技术应用于水下机器人的研制,目的是获取水下目标的位置、姿态,控制机械臂对目标进行抓取[18-21]。

Bruno 等[22]将双目视觉和结构光技术结合,构建了用于水下近场三维重建的测量系统(如珊瑚礁监控、水下遗址建模);并且研究了不同浑浊度的水下环境中的重建问题。调研结果表明,结构光能有效克服高浑浊水质中的强散射、强吸收问题,获得高质量的三维重建结果。

综上所述,基于双目视觉的水上视觉测量技术基础研究涉及范围较广。由于双目测量具有准确、高效的特点,双目测量技术已经应用到水下三维重建、水下目标检测、水下定位导航等各个方面。尽管水下双目视觉得到了广泛而又深入的研究,但由于水下成像特性导致图像质量下降、模型退化的问题还没有得到完全解决。

3 双目立体视觉模型

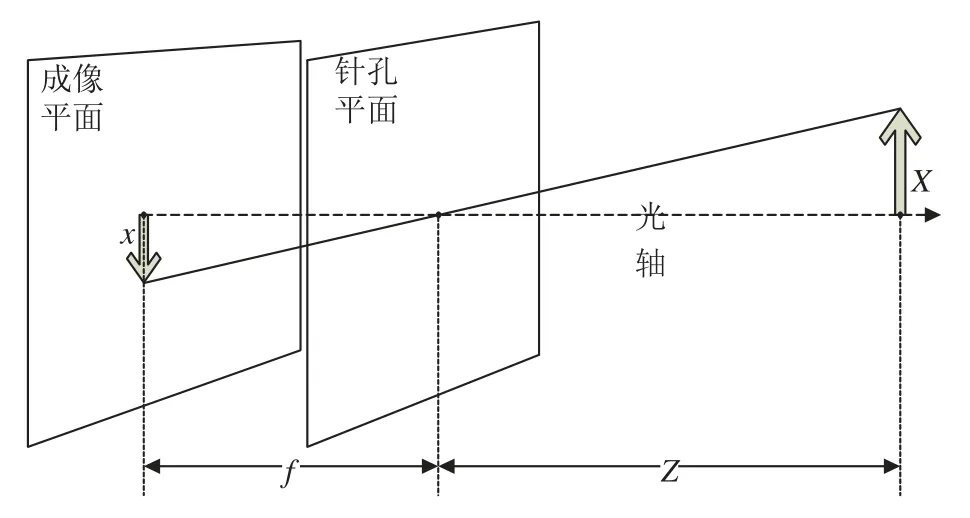

相机通常使用针孔相机模型表征相机的成像过程。如图1所示,使用带有小孔的板遮挡在成像平面与物体之间,屏幕上会形成物的倒像。其中,像的大小会随遮挡板的前后移动而变化。针孔相机模型表达为:

其中,f 为小孔到成像平面的距离;Z 为相机到物体的距离;X 为物体的长度;x 为成像平面上物体的长度。

图1 针孔相机模型Fig.1Pin-hold camera model

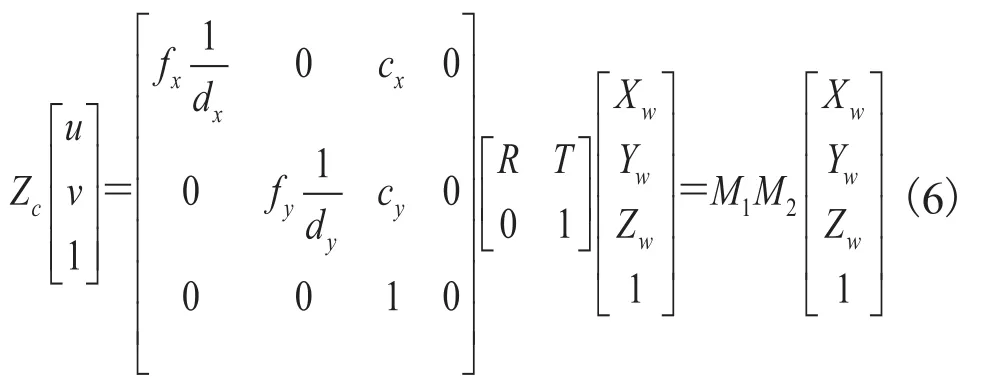

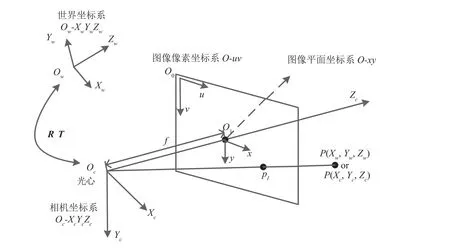

为了更好地描述物体三维信息到图像的转换过程,采用如图2所示的世界坐标系、相机坐标系、图像像素坐标系和图像物理坐标系来简化复杂的转换过程。其中,世界坐标系是自由确定的三维空间坐标系。在实际应用中,世界坐标系通常与相机坐标系一致。相机坐标系中 Xc和 Yc平行于成像平面,Zc与成像平面垂直。图像像素坐标系是以图像本身左上角为原点的一个平面坐标系,uv 值分别代表像素坐标值,即像素所在图像中的行数和列数,单位是像素。图像物理坐标系是以相机光轴和成像平面垂直相交的点为原点的平面坐标系,xy 轴(单位是毫米)分别与像素坐标系的 uv 轴平行。

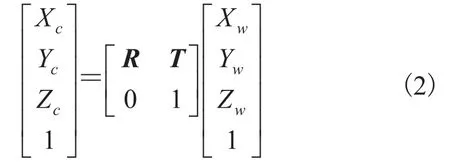

实现世界坐标系到图像像素坐标系的转换就是建立空间三维点到图像二维点之间的联系。世界坐标系上的一点 P(Xw,Yw,Zw) 转换到相机坐标系上的点 P(Xc,Yc,Zc) 可通过坐标系旋转和平移实现,转换模型如公式(2)所示。

其中,R 为一个 3×3的旋转矩阵;T 为平移向量;0=[0 0 0]。

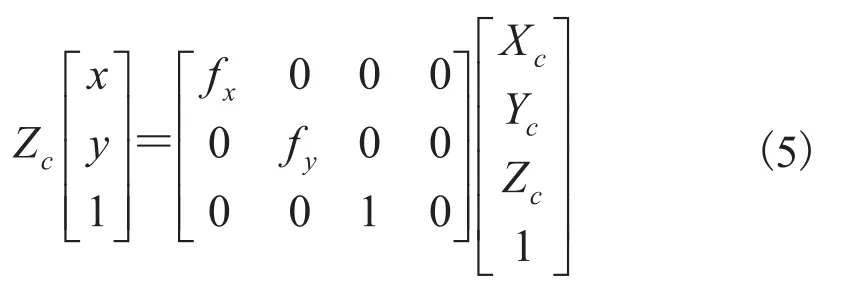

相机坐标系上一点 Pc(Xc,Yc,Zc) 可通过针孔模型变换到图像坐标系上一点 pI(x,y)。其中,x、y 的计算方式分别如公式(3)、(4)所示。

使用齐次坐标系和矩阵可以表示为:

其中,fx、fy为相机的等效焦距。综上所有变换,从世界坐标系中一点 P(Xw,Yw,Zw) 到图像坐标系中一点 p(u,v) 的坐标转换关系可表示为:

其中,M1为相机内参数(fx,fy,cx,cy,dx,dy),dx、dy分别表示 x 和 y 方向上单个像素的物理长度;M2为相机外参数,包含参数旋转矩阵 R 和平移向量 T。

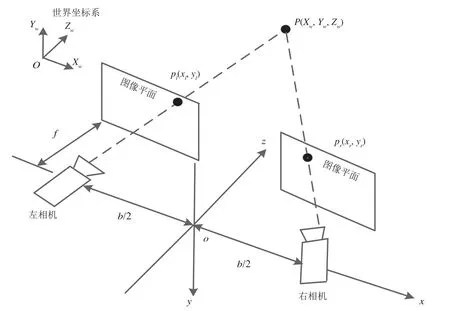

立体视觉中理想的相机排列关系是成像平面前向对准,光轴平行。图3为立体视觉模型,两个相机固定在同一轴线上,相机的基线距离为b。f 表示相机焦距;P(Xw,Yw,Zw) 表示场景中的一点;pl(xl,yl) 表示 P 投影到左相机图像上的点;pr(xr,yr) 表示 P 投影到右相机图像上的点。图像立体校正之后可得 yl=yr,(xl-xr) 就是 P 点在左、右图像上的视差。

图2 坐标系之间的转换Fig.2Transformation between coordinate system

图3 立体视觉模型Fig.3Stereo vision model

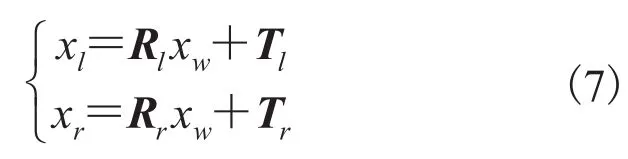

在立体视觉模型中,除了标定获取每个相机的内外参数,还需要获取两个相机之间的位置关系。在单个相机的标定过程中,可以获得左、右相机与世界坐标系之间转换关系(外参数)。左相机的外参数为旋转矩阵 Rl和平移向量 Tl,假设左相机的外参数为旋转矩阵 Rr和平移向量 Tr。因此,假设世界坐标系中一个点 P 在 x 轴上的坐标是 xw,xl和 xr分别表示点 P 在左、右相机坐标系 X 轴上的坐标,可以得到:

由此,左、右相机的位置关系可以通过 R0和 T0表达为:

4 水下双目立体世界系统水下成像分析

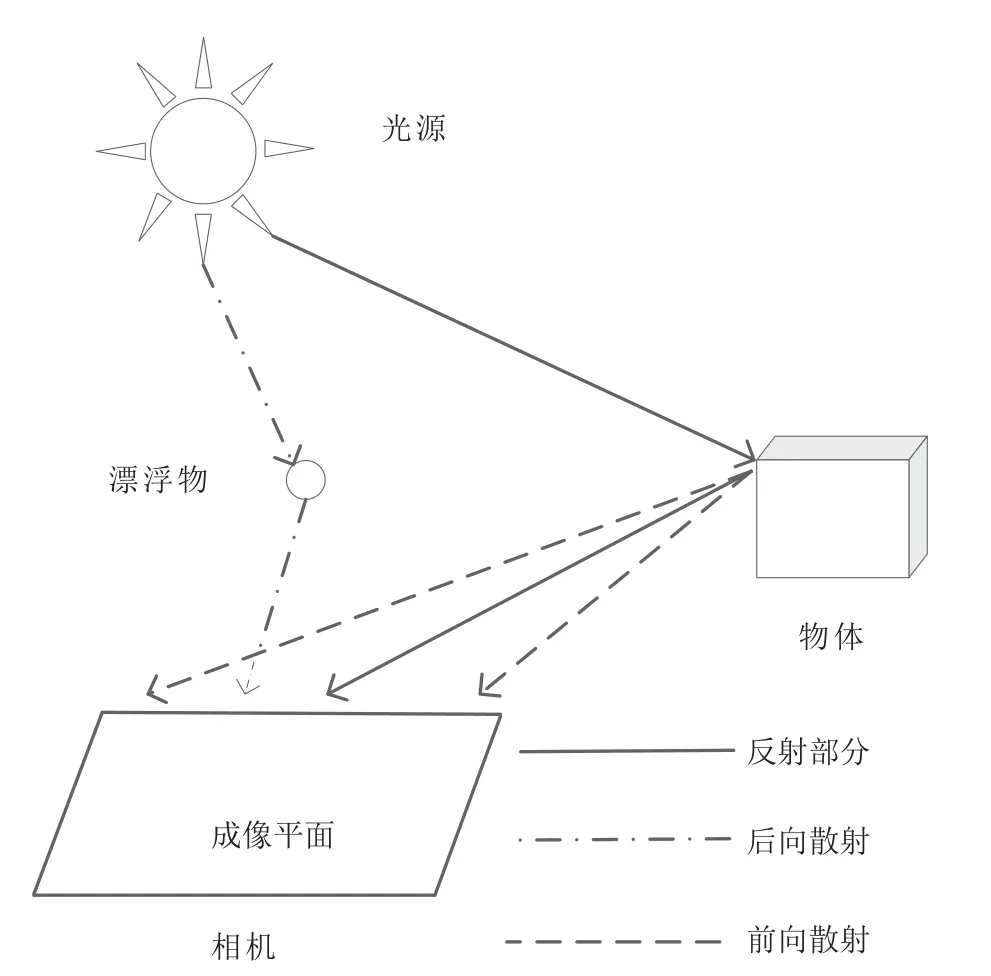

光在水下传播与空气传播存在差异,Mcglamery[23]和 Jaffe[24]对水下成像做了细致的研究。图4所示为 Jaffe[24]文中提出的水下环境中的光线传播模型,提出了水下图像光量由直接反射光、前向散射光和后向散射光三种光分量叠加生成的观点。其中,直接反射光经过物体对光线的反射和水的吸收后到达成像平面的光分量;前向散射光是物体反射后的光经过水中悬浮物和水的吸收后到达成像平面的光分量;后向散射光是光源发出的光经过水中悬浮物和水的吸收到达成像平面的光分量。

图4 水下环境中的光线传播[24]Fig.4Light propagation in underwater environment[24]

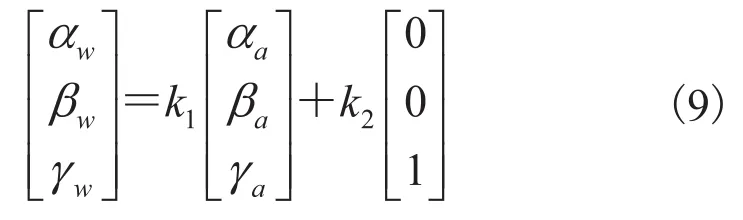

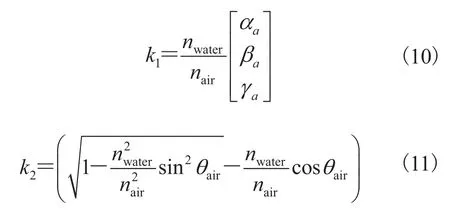

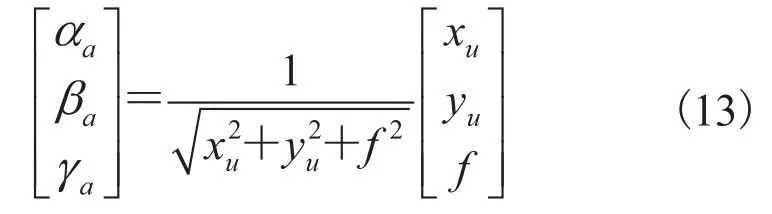

在水下使用相机时,将相机放置在密封防水罩中,由于防水罩与水、防水罩与空气传输介质差异,光线从水中进入防水罩时会发生折射,光线从防水罩进入空气中时也会发生折射。由于光线在防水罩处发生两次折射,且防水罩厚度较薄(可忽略不计),因此将水中的成像过程简化为如图5所示。其中,防水罩所在平面与相机成像平面平行,世界坐标系下一点P(Xw,Yw,Zw) 反射的光线与防水罩相交于点 O(xr,yr,zr),光线在 O点发生折射,通过镜头最后在成像平面 p(u,v) 点成像。假设防水罩表面与成像平面平行,防水罩到相机镜头的距离为 d,相机焦距为 f,(αw,βw,γw)T和(αa,βa,γa)T分别为入射光线发生折射前后的方向向量,分别为光线在空气、水中与光轴的夹角,如果折射平面与相机光轴垂直,那么光轴在相机坐标系下的方向向量为(0,0,1)T。

光线折射前、后方向向量之间的关系表示为:

其中,k1和 k2可根据 Snell 定律和角度转换关系[25]求得。

因此,将(10)、(11)代入(9)整理简化后,光线折射前后光线方向向量之间的关系表示为:

假设(xu,yu)T是成像点在相机坐标系下的二维物理坐标,入射光线发生折射后的方向向量可表示为:

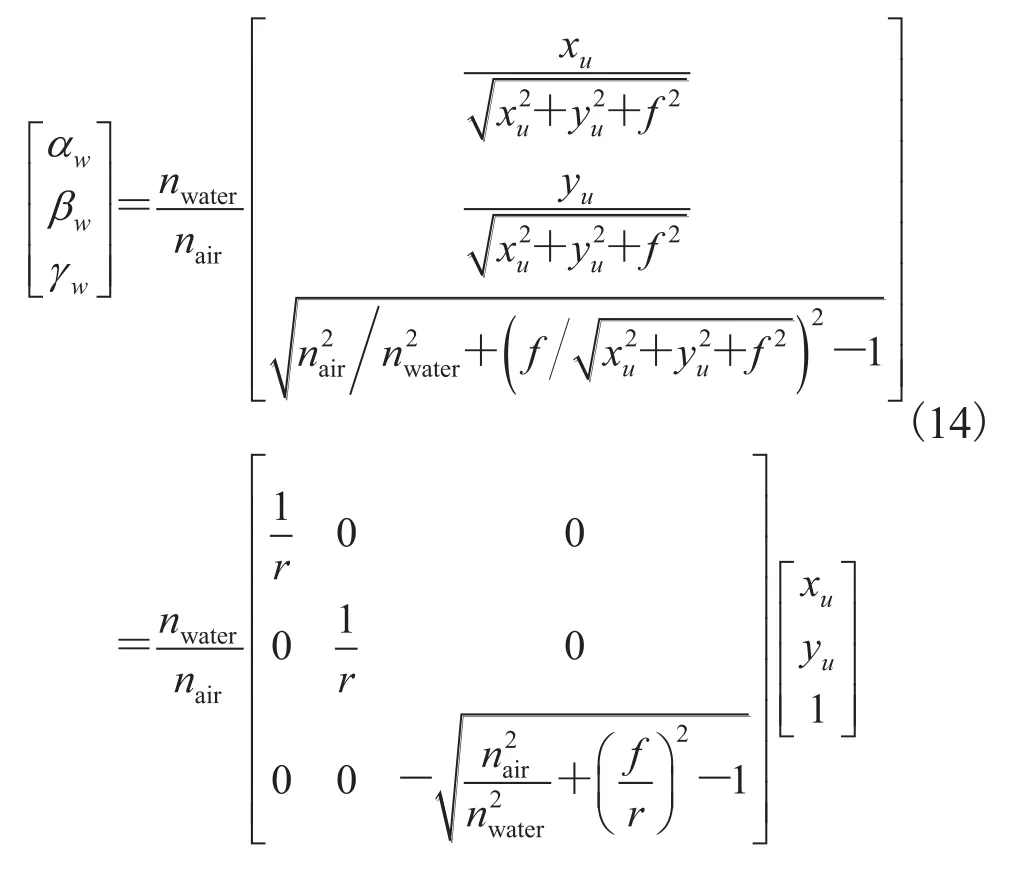

由此入射光线折射前的方向向量,与成像点二维物理坐标之间的关系为:

物体在相机坐标系下的三维坐标可表示为:

其中,(xr,yr,zr)T表示入射光线与折射平面的交点。在相机坐标系下的坐标为:

其中,d 为防水罩到相机镜头的距离。

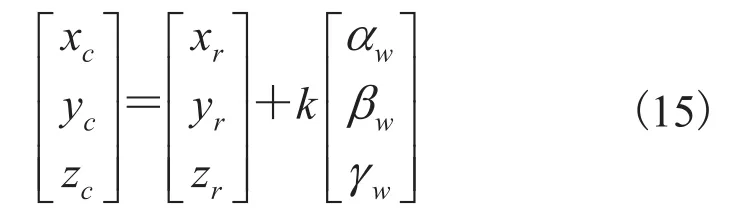

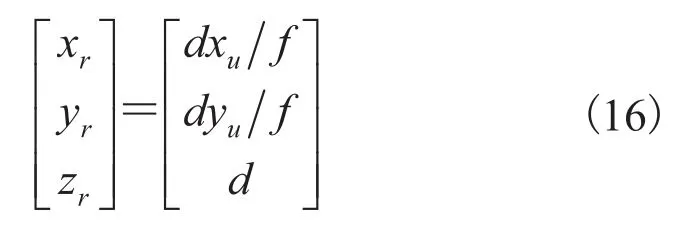

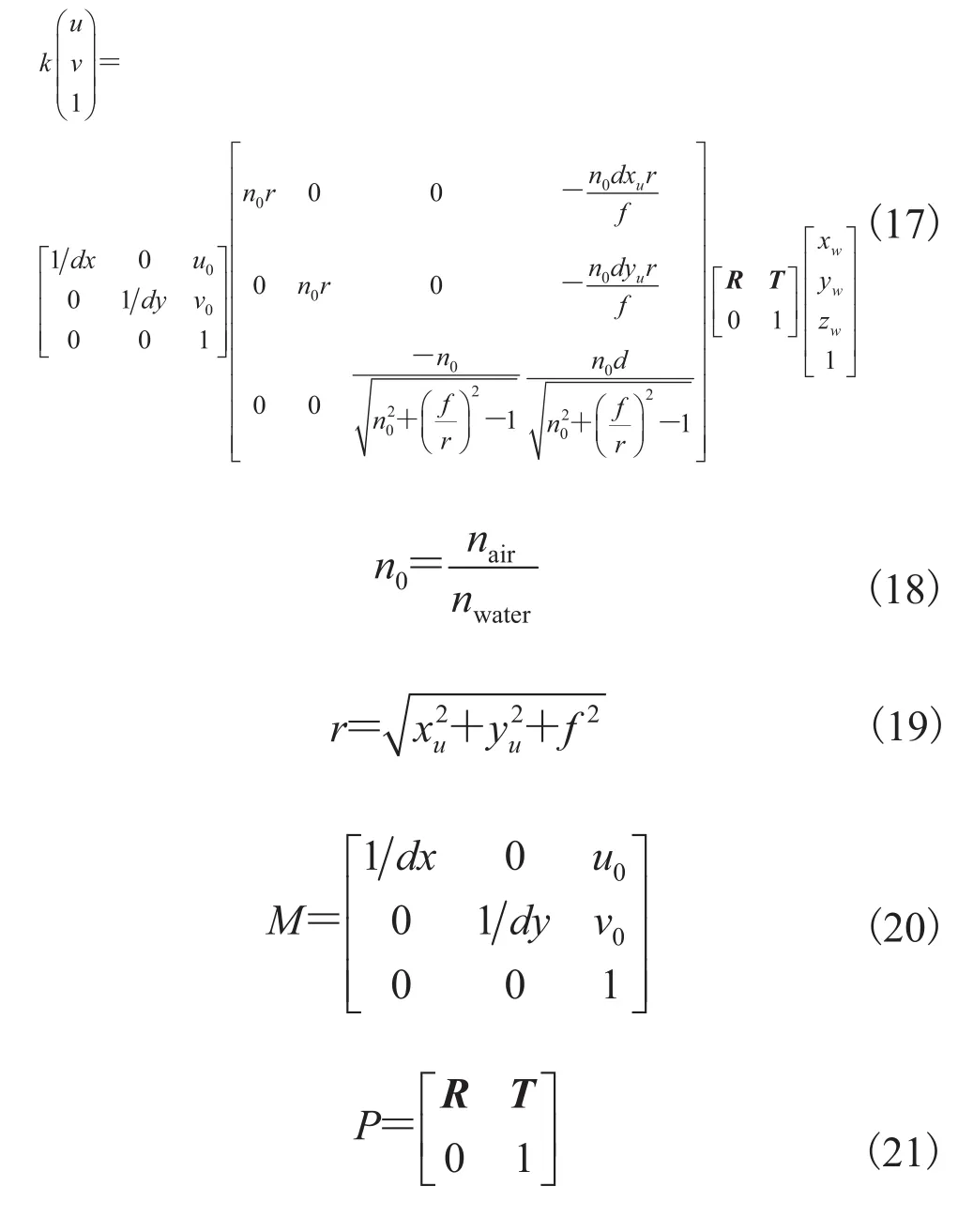

通过联立公式(12)~(16)可得公式(17),即加了防水罩的相机在水下拍摄的成像过程,光线传播从水介质到玻璃防水罩介质发生一次折射,从玻璃防水罩到空气介质中发生一次折射。由于防水罩较薄,且在玻璃防水罩上发生两次折射,所以玻璃防水罩的折射影响可以忽略。

5 水下双目成像实验系统

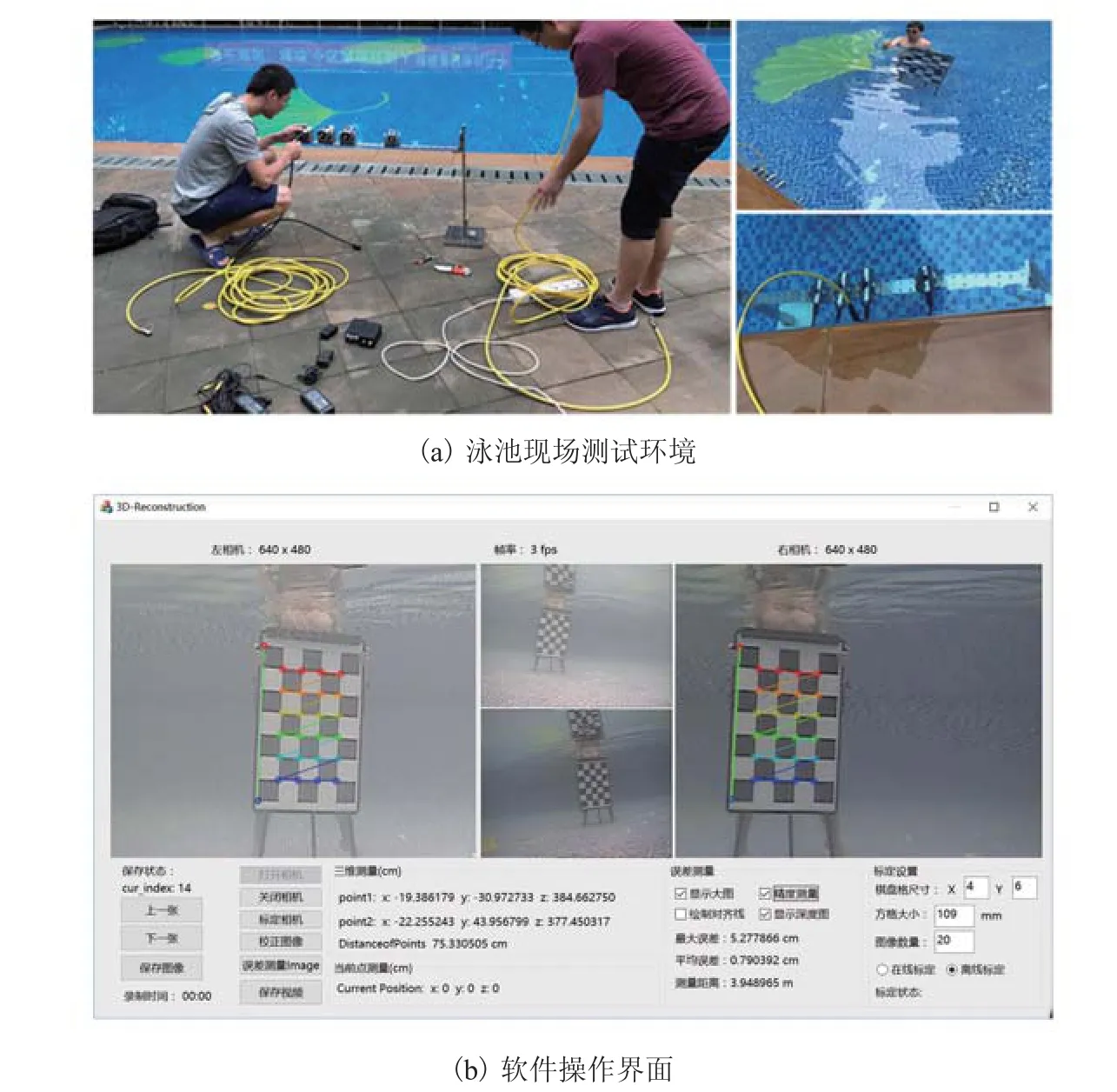

实验中采用 SV-16HR 水下彩色相机、Easier CAP USB 图像采集卡、LED 补光灯、信号传输线缆、电源转换器、固定支架等设备搭建双目测量系统,实验装置实物组成如图6所示。其中,相机工作电压为 5V;LED 补光灯工作电压为 12V;图像采集卡的工作电压为 5V,图像分辨率为 640×480像素,采集帧率为 30帧/秒;信号传输线缆长 10m;电源转换器提供 12V 电压输出。图7为本系统在泳池中测试的现场情况。

图6 实验装置组成部分Fig.6Experimental facility parts

图8为水下相机在 4种不同环境中采集的图像。分别为实验室(无水环境)、泳池、池塘、近海海水 4种不同环境下目标物体距离相机约为 1m 时的成像情况。

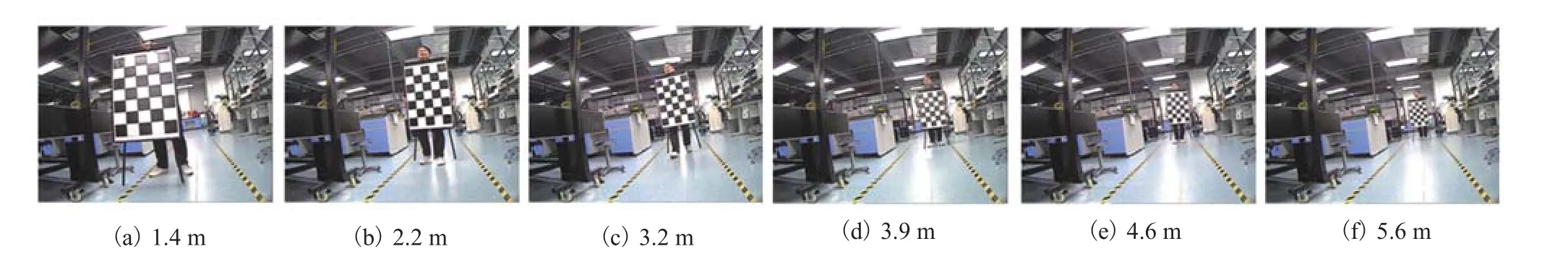

由于水质问题引起的成像差异显而易见,池塘和近海海水水质太差,目标成像距离较短,立体视觉测量相关实验没有完成。图9和图10分别为水上(实验室)和水下(泳池)环境中测量目标距相机不同距离的成像结果。

6 水下双目系统测量实验

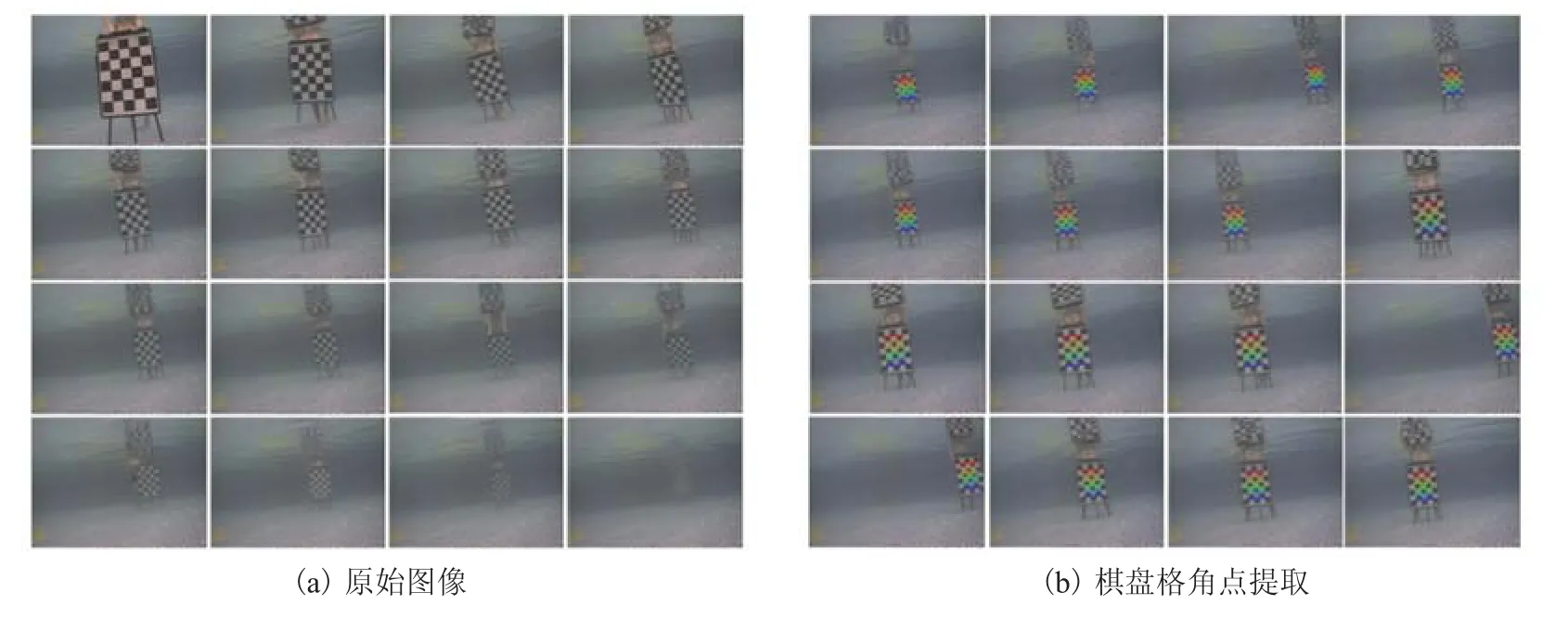

采用 6×4(10.9cm)尺寸的棋盘格标定板对相机的内外参数进行标定。由于池塘和近海海水中成像效果不佳,在此仅提供实验室和泳池中的相机标定实验结果。

图7 泳池现场测试情况Fig.7Measurement experiment in the pool

图8 不同水质中的成像情况Fig.8Images in the different underwater environment

图9 水下测量目标在不同距离处的成像结果Fig.9Imaging results of underwater target at the different distance

图10 水上测量目标在不同距离处的成像结果Fig.10Imaging results of lab’s target at the different distance

6.1 系统标定实验结果

使用立体视觉测量装置采集棋盘格在相机前方不同角度、不同倾斜度的图像共 20幅,而后通过本文第 2部分介绍的模型进行计算,得到两个相机与每幅图像上棋盘格之间的位置关系,从而确定两个相机之间的位置关系,最终确定立体视觉测量系统的内外参数。整个标定过程包括原始图像采集、棋盘格角点提取、单目标定、立体标定等步骤。图11(a)为在泳池中采集的 16幅不同的标定板图像,图11(b)为 16幅标定板图像的角点提取结果。图12(a)、(b)分别为实验室采集的 16幅标定板图像及其角点提取结果。

图11 水下原始图像与棋盘格角点提取(右相机)Fig.11Underwater original images and corner extraction results(right camera)

图12 水上原始图像与棋盘格角点提取(右相机)Fig.12Lab’s target original images and corner extraction results(right camera)

表1中所呈现的数据是两种环境中获得的相机标定结果。水上标定得到的参数与水下标定得到的参数存在较大差异,由此可知,直接使用水上标定的参数进行水下测量是不可行的。从标定结果中选取相机的内外参数应用于图像畸变校正和立体校正,校正结果如图13所示。图13(a)、(b)分别为水上和水下环境中的校正图像。为了方便观察,图像中添加了对齐线,如图13中所标注的 pl、pr为同一目标位置分别在左、右校正图像上的成像点,pl、pr位于左、右校正图像的同一条对齐线上。

表1 相机标定结果Table 1Result of camera calibration

6.2 系统测量误差评估结果

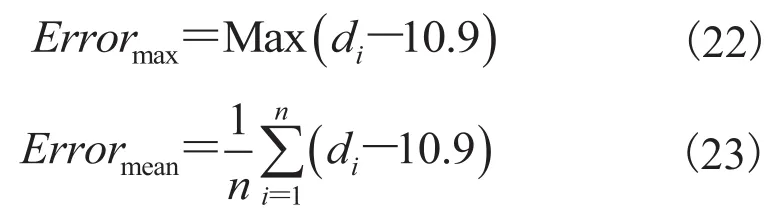

本文采用的误差测量方法是,先测量标定板n 个角点的空间位置,然后计算相邻两个角点之间的距离 di,相邻角点之间的实际距离为 10.9cm(即棋盘格单个方格的边长),分别通过公式(22)、(23)计算最大误差和平均误差。

在测量装置前方,以不同位置、不同角度和不同距离放置棋盘格标定板,测量棋盘格标定板上每个角点的空间位置,并计算测量误差。图14为在水下、水上环境中得到的测量误差。从误差测量结果中可以得到,当测量距离小于 3.8m时,测量误差小于 1cm;当测量距离为 3.8~4.5m时,测量误差小于 2cm;当测量距离为 5m 时,系统的最大误差已经大于 2cm。随着测量距离的增大,误差迅速增大,且水上测量误差上升趋势比水下测量误差更明显。由于本系统水下相机所采集的图像分辨率仅为 640×480像素,在测量距离增加的情况下,标定板在图像中的成像区域减少,标定板角点提取难度加大,角点误提取导致角点误匹配的数量增加,从而导致随着测量距离的增加,测量误差迅速增加。水上和水下环境中的误差测量曲线相差不大,说明水下成像理论的加入以及水下标定方法的加持,使水下双目视觉系统达到了与水上测量可媲美的测量结果,从而表明本文方法的有效性。结果表明,本系统在误差小于 2cm 的情况下,有效测量范围是0.5~4.5m。

图13 立体校正图Fig.13Stereo rectified image pair

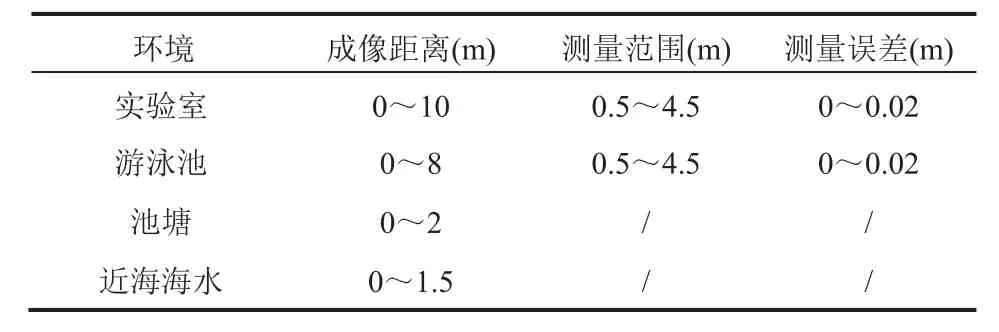

由上述成像实验、标定实验和误差测量实验得到了双目测量系统的成像距离、标定参数、有效测量距离和测量误差,结果如表 2所示。由于池塘和近海海水成像距离受限,其测量范围和测量误差未能进行正常测量。在保证测量误差不大于 2cm 的情况下,双目测量系统的测量指标如表 2所示。

图14 误差测量结果Fig.14Analysis of measurement error

表2 本系统在各环境下的测量指标Table 2Measurement performance of the system

6.3 系统实物测量结果

6.3.1 六角螺丝刀长度测量

如图15(a)所示,六角螺丝刀实际长度为17.2cm。如图15(b)所示,在泳池中距离相机3.2m 处,测量的六角螺丝刀长度为 17.5cm,与实际长度相差 0.3cm。如图15(c)所示,在水上(实验室)距离相机 1.1m 处,测量的六角螺丝刀长度为 17.9cm,与实际长度相差 0.7cm。水下测量结果与水上测量结果相差 0.4cm。

6.3.2 标定板测量

如图16(a)所示,标定板距离相机 2.4m处,五个方格的长度测量结果为 54.9cm,与方格实际长度(54.5cm)相差 0.4cm。如图16(b)所示,在水上(实验室)标定板距离相机 2.9m 处,五个方格的长度测量结果为 55.9cm,与实际长度相差 1.4cm。水下测量结果与水上测量结果相差 1cm。

图15 六角螺丝刀长度测量结果Fig.15Measurement result of the length of hexagonal screwdriver

图16 标定板长度测量结果Fig.16Measurement result of the length of the checkerboard

6.3.3 泳圈测量

图17(a)为泡沫游泳圈内径和外径的实际距离:外径为 60cm,内径为 39cm。如图17(b)所示,泡沫游泳圈在水下距离相机 4.4m 处,泳圈外径测量结果是 59.78cm,与其实际长度相差0.22cm。

6.4 实验结果分析

6.3节中所展示的六角螺丝刀、标定板测量实验结果表明,在测量误差允许的范围内,本系统在水上和水下均能获得准确的测量结果;而根据泳圈的水下测量结果与泳圈实际长度进行对比,测量误差仅 0.22cm,进一步验证了本系统水下测量结果的可靠性。

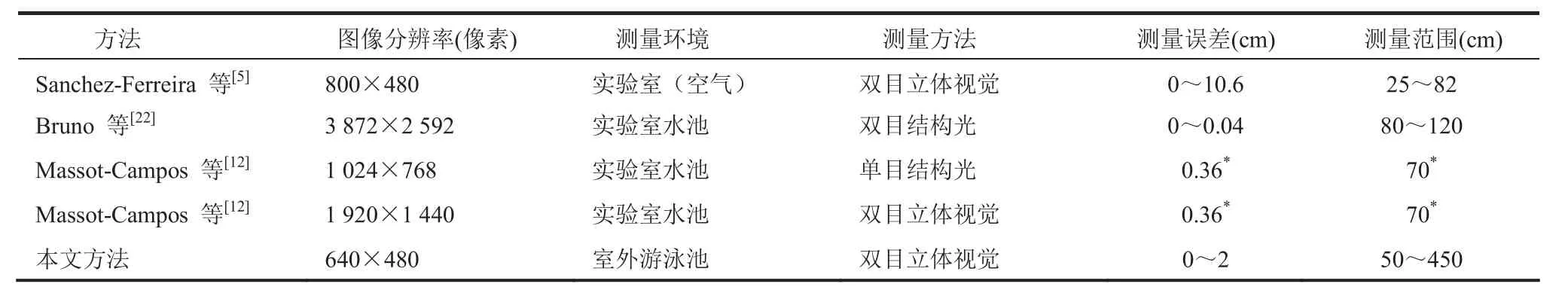

虽然水下测量相关工作已有不少的研究成果,但这些工作使用不同的相机,在不同的测试环境下,采用不同的测量原理,对水下物体进行三维测量或者三维重建。由于实际实验过程中的差异,不同工作呈现的测量效果差异较大。表 3展示了一些具有代表性的水下三维测量工作,Sanchez-Ferreira 等[5]使用的相机分辨率为800×480像素,在实验室环境中进行实验,实验结果中多数测量点的误差在 0.6cm 左右,由于相机视场受限,某些测量点的误差达到了 10cm。Bruno 等[22]使用高分辨(3872×2592像素)相机搭建双目视觉系统,并使用结构光作为图像匹配特征,在实验室水池中(3m×2m×0.7m)使用不同水质的水进行物体三维重建实验。结果显示,在空气中的重建结果最佳,随着水质浑浊度的增加,结构光在水中被散射和吸收的光分量增加,三维重建得到的点云越来越稀疏。这表明,结构光在水下环境中的散射和吸收会增加基于结构光的三维重建方法的局限性。Massot-Campos等[12]结合了单目结构光方法与双目立体视觉方法:双目视觉设备是 PGR Bumblebee 2立体相机,该设备由两个 1024×768像素的彩色相机组成,单目结构光设备由一个激光投射器和一个1920×1440像素的相机组成。在 4m×3m×2m的水池中进行了实验,分别使用两套设备对同一场景进行三维重建,并对重建出来的两组点云进行配准。通过对比发现,双目设备能够获取更多、更全面的点云,但是缺少细节;而单目结构光设备能够获取更为精确的细节部分,但只能获取有限数量的点云且缺少物体表面的颜色。

图17 泡沫游泳圈外径测量结果Fig.17Measurement result of the external diameter of the buoy

表3 与其他方法的对比Table 3Comparison with related work

综上,基于双目结构光测量原理的系统测量误差较小,但由于结构光在水下环境中的散射和吸收导致其测量范围受限;基于传统双目结构光的系统测量误差较大,但测量范围较广。本文采用的水下标定与折射补偿相结合的标定方法,不受结构光投射范围受限的影响,从而大大降低了双目立体视觉系统的测量误差,增大了系统的有效测量范围。

7 总结与展望

本文介绍了一种水下几何测量的方法,搭建了一套水下立体视觉测量系统,水上、水下两种环境均可使用。相机水上成像距离 10m,水下成像距离 8m,测量范围为 0.5~4.5m,测量误差小于 2cm。对不同的水质环境进行了对比实验,并采用不同的图像预处理方法克服了水下光源不足、光照不均匀、水质恶劣等问题。最终得到了在不同水质下均能良好工作的三维测量系统,具有较高的实用价值。本文从水下成像出发,以传统双目视觉测量技术为基础,对水下双目测量技术进行探索,探讨了水下与水上标定的差异,是对水下视觉测量技术的一次有益探索。在误差允许的情况下,水上与水下测量实验都达到了预期目标。尽管实验结果满足了当前需求,但在系统搭建和实验过程中暴露了很多亟待解决的问题。未来研究中,将着手并解决以下几个问题:提高成像品质、改进相机模型、减少立体匹配误差、去除噪声干扰引起的标定误差、弱化标定过程中人为抖动引起的图像模糊。另外,因现提供的三维信息仅提供指定点的测量结果,将考虑对相机可视范围内的物体做完整的三维重建,并将该技术扩展到水下设备三维建模、水下地形测绘、水下机器人导航等应用领域。

参 考 文 献

[1]Zhang ZY,Zhou SH.Analysis of key technology and the applications of underwater target detection by LASER [J].Journal of Xidian University(Nature Science),2001,28(6): 797-801.

[2]Cabarle LE,Sybingco E,Dadios E.Underwater distance ranging implemented through a stereo vision system [C]//International Conference on Humanoid,Nanotechnology,Information Technology,Communication and Control,Environment and Management,2016: 1-6.

[3]Lin YH,Shou KP,Huang LJ.The initial study of LLS-based binocular stereo-vision system on underwater 3D image reconstruction in the laboratory [J].Journal of Marine Science and Technology,2017,22(3): 1-20.

[4]Shen J,Sun HY,Wang HB,et al.A binocular vision system for underwater target detection [J].Applied Mechanics and Materials,2013,347-350: 883-890.

[5]Sanchez-Ferreira C,Mori JY,Farias MCQ,et al.A real-time stereo vision system for distance measurement and underwater image restoration[J].Journal of the Brazilian Society of Mechanical Science and Engineering,2016,38(7): 1-11.

[6]Sanchez-Ferreira C,Mori JY,Llanos CH,et al.Development of a stereo vision measurement architecture for an underwater robot [C]//The IEEE 4th Latin American Symposium on Circuits and Systems,2013: 1-4.

[7]Kumar NP,Mukundappa BL,Ramakanth Kumar P.Design & development of autonomous system to build 3D model underwater objects using stereo vision technique [J].International Journal of Advances in Engineering and Technology,2011,1(4): 1-4.

[8]Li GL,Huang WY,Liu QS,et al.Improved Zhang’s calibration method and experiments for underwater binocular stereo-vision [J].Acta Optica Sinica,2014,34(12): 219-224.

[9]Zhang ZZ.A flexible new technique for camera calibration [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2000,22(11):1330-1334.

[10]Bouguet JY,Perina P.Camera calibration from points and lines in dual-space geometry [C]//European Conference on Computer Vision,1998: 2-6.

[11]Pang YJ,Wang D,Huang H,et al.Research on underwater binocular camera calibration and distortion analysis in current disturbance [J].Applied Mechanics and Materials,2014,548-549:688-692.

[12]Massot-Campos M,Oliver-Codina G,Kemal H,et al.Structured light and stereo vision for underwater 3D reconstruction [C]//Oceans 2015-Genova,2015.[13]Weidner N,Rahman S,Li AQ,et al.Underwater cave mapping using stereo vision [C]//IEEE International Conference on Robotics and Automation,2017: 5709-5715.

[14]Wu YL,Rui N,He B.3D reconstruction model of underwater environment in stereo vision system [C]//Oceans 2013-San Diego,2014: 1-4.

[15]Xu J,Chen X,Song X,et al.Target recognition and location based on binocular vision system of UUV[C]//The 34th Chinese Control Conference(CCC),2015: 3959-3963.

[16]Chavez AG,Mueller CA,Birk A,et al.Stereo-vison based diver pose estimation using LSTM recurrent neural networks for AUV navigation guidance [C]//Oceans 2017-Aderdeen,2017: 1-7.

[17]Carrasco PLN,Bonin-Font F,Massot-Campos M,et al.Stereo-vision graph-SLAM for robust navigation of the AUV SPARUS II [C]//IFAC Workshop on Navigaation,2015: 200-205.

[18]Hallset JO.A vision system for an autonomous underwater vehicle [C]//The 11th IAPR International Conference on Pattern Recognition,1992: 320-323.

[19]Ishibashi S.The stereo vision system for an underwater vehicle [C]//Oceans 2009-Europe,2009: 1-6.

[20]Rizzini DL,Kallasi F,Aleotti J,et al.Integration of a stereo vision system into autonomous underwater vehicle for pipe manipulation tasks [J].Computers and Electrical Engineering,2016,58(C): 560-571.

[21]Chen YJ,Zhu KW,Yao-Zheng GE,et al.Binocular based locating system for underwater [J].Journal of Mechanical and Electrical Engineering,2011,28(5): 567-573.

[22]Bruno F,Bianco G,Muzzupappa M,et al.Experimentation of structured light and stereo vision for underwater 3D reconstruction [J].Isprs Journal of Photogrammetry and Remote Sensing,2011,66(4): 508-518.

[23]Mcglamery BL.A computer model for underwater camera systems [C]//International Society for Optics and Photonics,1980: 221-231.

[24]Jaffe JS.Computer modeling and the design of optimal underwater imaging systems [J].IEEE Journal of Oceanic Engineering,1990,15(2): 101-111.

[25]Gooch JW.Snell’s law [M]//Encyclopedic Dictionary of Polymers.Springer New York,2011:673-673.