基于LBP-HSV模型及改进SIFT算法的行人再识别算法

,,

(南京理工大学 自动化学院,南京 210094)

0 引言

行人再识别技术主要用于视频监控领域,用以检测某个目标是否出现在非重叠视域多摄像机监控视频中[1]。目前的行人再识别方法主要分为两类:基于特征描述法[2-4]和基于机器学习法[5-6]。在基于特征描述法中,设计具有区分性、稳定性和对光照、视角、姿态等具有一定鲁棒性的描述特征,再利用这些特征来度量两幅行人图像的相似性。文献[2]提出的SDALF方法将人体分割成头部、躯干、和腿部,利用加权HSV直方图、最大稳定颜色区域和重复纹理块3种特征进行组合识别,识别性能较好,但描述符的计算量大、复杂度高、存储开销大。基于机器学习法是通过学习行人再识别模型的优化参数,或从训练数据中学习有效的特征分类来降低不同行人图像间的相似度[7]。文献[5]用支持向量机学习中层语义属性的判断,并确定各属性的权重,形成以属性为中心基于部分特征的再识别模型。但由于该方法训练时需要手动标记属性,且属性分类较多,训练复杂度较大,在只有少量样本时存在过拟合问题,故只适用于样本种类丰富的情况。

为有效应对目标样本少、背景、光照、视角变化等情况,提高算法的准确性和识别速率,本文在上述方法的启发下,提出结合LBP-HSV模型预识别与改进SIFT特征点匹配的算法。首先使用LBP-HSV颜色模型对测试图像进行预识别处理,筛选出目标相似区域,缩小识别范围。然后提取该区域的SIFT特征点,并使用改进的HOG特征描述特征点,以改进SIFT特征点特征向量的描述方式。通过对不同情形下的图像进行试验,对比、验证本文所提算法的有效性。

1 基于LBP特征和HSV模型的相似区域识别

1.1 LBP特征

LBP特征是一种表述灰度图像某像素点灰度值与周围像素点灰度值大小关系的二进制描述,Ojala[8]等人为了使LBP算子适应不同的纹理特征,将3×3邻域扩展到任意邻域,并用半径为R,采样点个数为P的圆形邻域取代正方形邻域,且对于没有完全落在像素点位置上的灰度值采用双线性插值法进行计算,LBP算子如图1。

本文取R=2,P=16,LBP值记为LBP16,2。通过对得到的LBP值进行循环移位,取最小值作为LBP特征值,这样使LBP具有旋转不变性,计算方法如式(1)。

LBPP,R=minROR(LBPP,R,k)|k=0,1,2,…,P-1

(1)

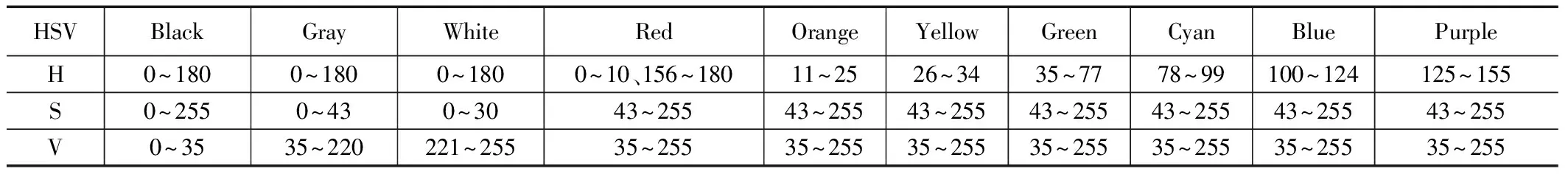

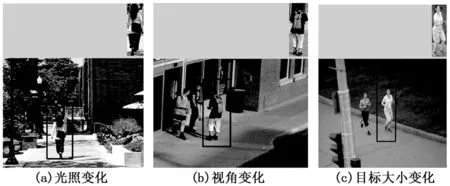

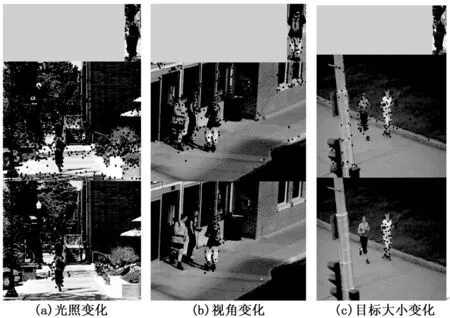

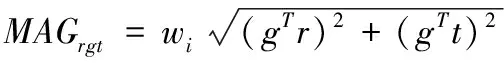

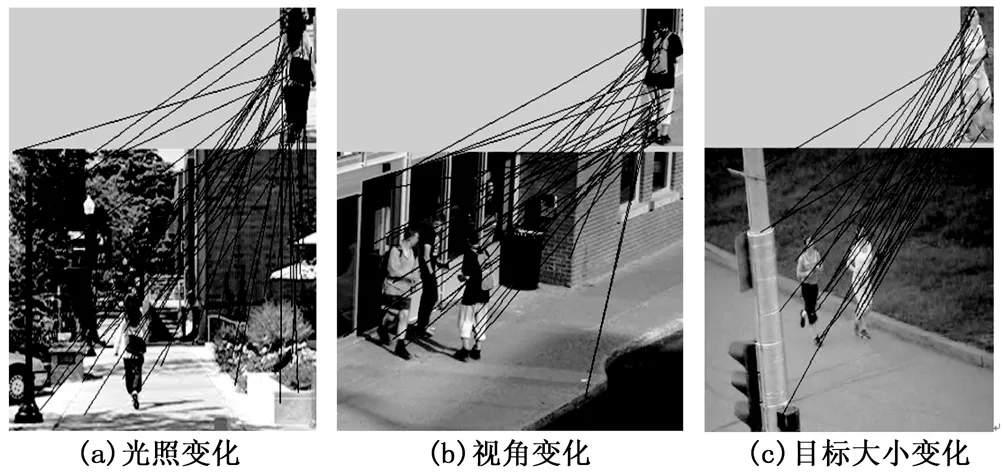

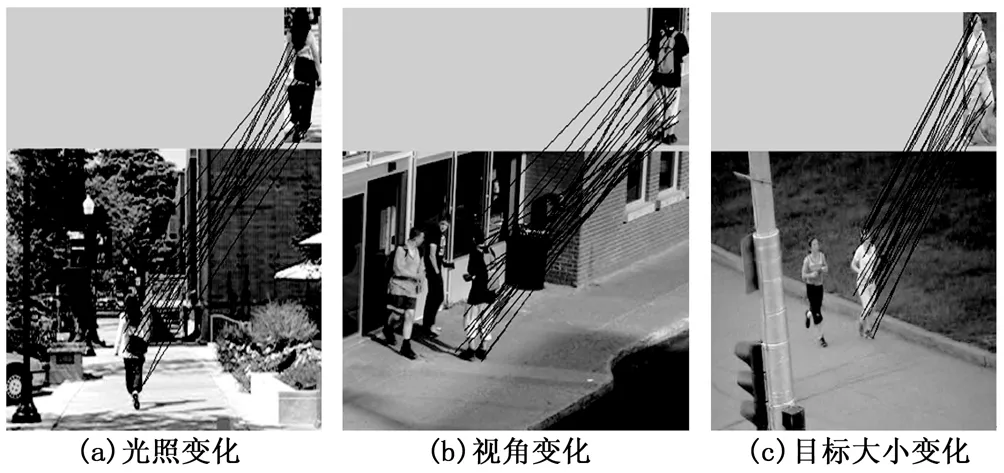

式(1)中,ROR(x,k)表示对P位二进制数x进行向右循环移位k次(|k| 表1 HSV空间颜色量化策略 图1 几种LBP算子 HSV是A.R.Smith在1978年根据颜色的直观特性创建的一种颜色空间,它根据色彩的色调H、饱和度S和亮度V三个基本特征确定颜色[9]。 本文在文献[9-10]提出将HSV颜色空间的颜色量化为黑、灰、白、红、橙、黄、绿、青、蓝和紫10个等级的基础上,扩大了红色的色度范围,改进的HSV颜色空间量化策略见表1。 由经验可知,人体在竖直方向上,上身占30%左右,腿部占50%左右。考虑行人的衣着、背包、运动姿态及背景等因素,本文仅提取行人上身和大腿的主要颜色和次要颜色进行预识别。选定上身的识别区域(图2的A区域),占图像横向的20%~80%,纵向的20%~50%;选定大腿的识别区域(图2的B区域)占图像横向的25%~75%,纵向的50%~70%。具体区域划分如图2。提取HSV颜色的方法为:遍历待识别区域图像的每个像素点,计算各像素点的H、S、V分量,根据表1的量化策略,将像素点判定为Ci(Ci代表颜色量化后的10个等级,i=1,2……,10),计算Ci的总个数,数量最多的颜色即为区域的主颜色,其次为次颜色。 图2 行人上身、大腿识别区域 目标相似区域识别即利用目标图片,在测试图片中筛选出目标可能存在的大致区域。本文提出的基于LBP特征和HSV模型的目标相似区域识别步骤如下: 1)提取目标图像的LBP特征,用与目标图像同大小的矩形窗,以一定步长循环遍历测试图像,计算各矩形块的LBP特征,比较其LBP直方图与目标图像LBP直方图的相似度,记为S(i),i=1,2,3,…(i为矩形块个数); 2)计算S(i)的最小值,记为Smin,标记满足条件S(i)≤Smin*TS的矩形块(TS为阈值),包含满足上述条件矩形块的最小矩形即为LBP特征直方图识别出的相似区域,记为RLBP; 3)利用改进的HSV模型提取目标图像A、B区域的主、次颜色,且用与目标图像同大小的矩形窗,以一定步长循环遍历RLBP,分别提取各块A、B区域的主、次颜色; 4)判断上述目标图像和RLBP内各块A、B区域主、次颜色的关系,若对应区域的主、次颜色有交集,则标记该矩形块为相似矩形块; 5)包含上述所有相似矩形块的最小矩形即为相似区域。图3为三种情形下的行人目标相似区域识别结果。 图3 相似区域识别结果 SIFT算法[11]由David G.Lowe首次提出,其核心是尺度空间不变理论,本文使用SIFT算法进行图像关键点的提取,步骤如下: 1)尺度空间的表示。 定义图像的尺度空间为一个尺度可变的高斯函数G(x,y,σ)与原图像I(x,y)的卷积,表示如下: L(x,y,σ)=G(x,y,σ)*I(x,y) (2) 为能有效检测尺度空间中的关键点,David G.Lowe提出了高斯差分尺度空间(DOG空间),它由不同尺度的高斯差分核和图像卷积得到,表达式如下: D(x,y,σ)=(G(x,y,kσ)-G(x,y,kσ))*I(x,y)= L(x,y,kσ)-L(x,y,σ) (3) 2)关键点的提取。 图4 SIFT关键点提取结果 表2 三种情形下图像SIFT特征点个数 由表2可以看出,添加LBP-HSV预识别后,测试图像提取的特征点数量较原图均减少了65%以上,尤其是在背景复杂的情况下,减少了近90%。特征点的减少降低了后续特征点匹配的复杂度。 传统的SIFT关键点描述向量维数太高,高达128维,大大影响了关键点的匹配速度。为提高SIFT算法的实时性,很多学者[12-13]尝试用主成分分析(PCA)法对SIFT描述向量进行降维,但降维在构造关键点描述向量时的计算量甚至超过了标准SIFT算法,大大抵消了降维带来的速度提高。 HOG(梯度方向直方图)特征是Dalal[14]等人提出的一种用于行人检测的特征,具有很好的几何和光学不变性,且计算效率高。该特征通常用来描述图像块的特征,本文对HOG特征进行改进,并提出使用它来描述关键点的特征向量,步骤如下: 1)以SIFT关键点c(xc,yc)为中心,采用圆形区域作为关键点邻域,将该邻域等间隔划分成4个同心圆,划分过后的邻域如图5所示。 2)按式(4)计算加权HOG梯度幅值MAGrgt。当圆形区域旋转θ角度时,关键点邻域圆环上点p(xp,yp)的梯度由g变为g′,按式(5)、(6)对梯度进行RGT(Radial Gradient Transform)变换得到RGT梯度(gTr,gTt)、(g′Tr′,g′Tt′),由文献[15]知,(g′Tr′,g′Tt′)=(gTr,gTt),如图6所示。r和t为两个正交的单位向量,r表示p点切向方向的单位向量,t表示p点径向方向的单位向量,Rθ表示旋转θ角的旋转矩阵,wi为权重系数; 图6 RGT变换示意图 (4) (5) r=Rπ/2t (6) 3)对邻域的4个同心圆,分别求出9个方向(0°,40°,80°,120°,160°,200°,240°,280°,320°)的HOG梯度值,作为关键点特征向量,这样,最终得到关键点的HOG特征描述子即为4×9=36维向量,记为XHOG(x,y); 按式(7)计算点A的特征向量XA(x1,x2,…,xn)与点B的特征向量Y(y1,y2,…,yn)间的加权欧式距离。 (7) 最近邻匹配策略为:针对目标图像中的关键点A,在待识别图像中找出与之距离最近的关键点B和次近的关键点C,若两距离比值小于阈值t,即: (8) 则认为点A与点B匹配。 论文以VS2010 + OpenCV2.4.9为开发工具,采用SIFT算法与文中所述算法,分别对三种不同情形下的图像进行了目标再识别实验,图7~图9分别为各类算法的识别效果。从图7可以看出,仅用SIFT算法特征点匹配效果较差,尤其是在复杂背景下,准确率偏低。从图8、图9可以看出,添加预识别处理以后,准确率大大提高,且环境适应性增强。 三种情形下预识别+SIFT算法与本文算法的匹配性能比较结果如表3所示。 由表3可知,当图像中的行人目标存在姿态、光照、视角、大小等变化时,本文提出的特征向量描述方法与SIFT算法特征向量描述方法相比,准确率相当,而运算时间均减少了约60%~70%,匹配速度更快。 表3 算法匹配性能比较 图7 SIFT算法识别结果 图8 预识别+SIFT算法识别结果 图9 本文算法识别结果 为了提高视频监控中行人再识别的准确率,本文提出结合LBP-HSV模型与改进SIFT算法的行人再识别算法。采用LBP-HSV模型进行预识别处理,缩小了目标可能的范围,降低了目标匹配的复杂度,提高了匹配准确率;采用圆形邻域作为特征点邻域,提出使用改进的HOG特征来描述SIFT特征点的特征向量,提高了匹配速度。需要说明的是,实验中的预识别环节耗时均在5秒左右,对于实时性要求较高的应用,算法还需作进一步完善。 参考文献: [1] 齐美彬, 檀胜顺, 王运侠,等. 基于多特征子空间与核学习的行人再识别[J]. 自动化学报, 2016, 42(2):299-308. [2] Farenzena M, Bazzani L, Perina A, et al. Person re-Identification by symmetry-driven accumulation of local features[A]. Proc. of IEEE Conference on Computer Vision and Pattern Recognition [C]. 2010, 2360-2367. [3] Ma B, Su Y, Jurie F. BiCov: a novel image for person re-identification and face verification[A]. Proceedings of the British Machine Vision Conference[C]. Guildford, UK: BMVA Press, 2012: 1-11. [DOI: 10.5244/ C. 26. 57]. [4] 范彩霞, 朱 虹, 蔺广逢,等. 多特征融合的人体目标再识别[J]. 中国图象图形学报, 2013,18 (6): 711-717. [5] Layne R, Hospedales T M, Gong S. Person re-identification by attributes[A]. Proceedings of the British Machine Vision Conference[C]. Surrey, UK: BMVA Press, 2012: 2(3): 1-9. [DOI: 10.5244/ C. 26. 24] [6] Zhao R, Ouyang W, Wang X. Unsupervised salience learning for person re-identification[A]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition[C]. Portland: IEEE Press, 2013: 3586-3593. [DOI: 10.1109/ CVPR. 2013. 460] [7] 陈 莹, 霍中花. 多方向显著性权值学习的行人再识别[J]. 中国图象图形学报, 2015, 20 (12): 1674-1683. [8] Ojala T, Pietikainen M, Maenpaa M. Multire solution gray-scale and rotation invariant texture classification width local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987. [9] 彭志勇, 常发亮, 刘洪彬,等. 基于HSV模型和特征点匹配的行人重识别算法[J]. 光电子·激光, 2015(8): 1575-1582. [10] OpenCV—HSV color model and ranges of color components [EB/OL]. [2014-04-09]. http:// blog. csdn. net/ wanggsx918/ article/ details/ 23272669, 2014-04-09. [11] 黄登山, 王晓楠. 基于Canny和Hillbert- Huang变换的改进的SIFT算法研究[J]. 西北工业大学学报, 2015 (6): 962-965. [12] Ke Y, Sukthankar R. PCA—SIFTI a More Distinctive Representation for Local Image Descriptors[A].Proceedings of IEEE Conference on Computer Vision and Pattern Recognition[C]. Washington D C, 2004, 2: 506-513. [13] Mikolajczyk K, Schmid C. A performance evaluation of local descriptors[J]. IEEE Transactions on Pattern Analysis and MachineIntelligence, 2005, 27(10): 1615-1630. [14] Dalal N, Triggs B. Histograms of Oriented Gradients for Human Detection[A]. Computer Vision and Pattern Recognition, 2005. CVPR 2005. IEEE Computer Society Conference on[C]. IEEE, 2005:886-893. [15] 汤 彪, 左峥嵘, 李 明. 基于旋转不变HOG特征的图像匹配算法[J]. 2013.

1.2 HSV模型

1.3 目标相似区域识别

2 基于改进SIFT特征点匹配的行人再识别

2.1 SIFT算法特征点提取

2.2 改进的SIFT关键点特征描述

2.3 特征点匹配

3 实验结果及分析

4 结论