基于正弦激励的WASD神经网络的上证指数预测

马 川, 廖柏林, 周 俊, 周元玲, 毛凯文

0 引言

证券市场是一个充满魅力的市场,每位投资者都想从证券交易中获取高额利润.但是,证券市场是一个典型的具有随机性、时变、波动性较大的非线性系统,难以建立精确的数学模型.多年来,人们一直在寻找有效方法以实现对证券市场的精确预测[1-3].许多学者采用传统回归分析和时间序列方法对证券市场进行了预测和分析,通过证券价格的历史时间序列挖掘其变化趋势[4-7].然而这些传统方法并不能描述实际证券市场的非线性情况,其预测结果也不理想.20世纪80年代以来,神经网络算法得到了快速发展和广泛应用[8-11].由于神经网络具有自组织、自学习能力,不需要考虑数学模型的内部结构,可以对非线性系统进行无限逼近和拟合,为证券市场预测和分析的深入研究开拓了新的空间[12-13].常有的神经网络预测方法有BP神经网络、SVM和小波网络等.但由于每种网络模型本身的问题,使得其效果不佳.权值与结构直接确定(WASD)的神经网络作为一种新型的前向神经网络,通过伪逆直接确定网络权值,减少了迭代过程,避免了训练速度慢、过拟合、局部极值等缺陷,具有训练速度快,全局最优和泛化能力优异等特点[14-18].针对上证指数预测问题,本文提出了一种多输入单输出、正弦激励的WASD神经网络模型,并对该模型的权值和结构确定方法进行了理论分析.最后,我们利用1991年12月20日至2016年10月12日的数据对WASD神经网络进行训练,并对其后10天的上证指数进行预测.将本文预测结果与现有的BP神经网络和SVM神经网络的预测结果进行对比,结果显示本文所提的正弦激励的WASD神经网络具有更好的预测性能.

1 正弦激励的WASD神经网络模型

本文采用的WASD神经网络是一种三层前向神经网络,其模型如图1所示.使用单极性正弦函数作为激励函数,输入层神经元阀值为0,输入层神经元到隐含层神经元的连接权值w∈[χ1,ζ1]和隐含层神经元的阀值β∈[χ2,ζ2],χ1,ζ1,χ2,ζ2 取值可相同也可不相同.在输入层神经元到隐含层神经元连接权值确定的条件下,隐含层神经元到输出层神经元连接权值通过伪逆直接一步算出.

图1 正弦激励的WASD神经网络模型

1.1 权值直接确定方法

输入层神经元到隐含层神经元的权值和隐含层的阀值通过随机确定,其随机范围常通过试错法确定.第n个输入在第m个隐含层的输出为hm,n,hm,n通过以下公式计算

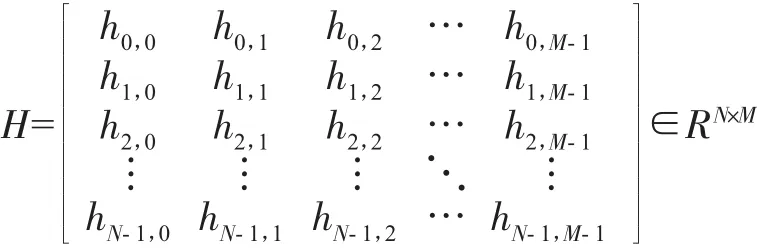

所有的输入通过公式(1)计算得到矩阵H,如下

其中N为样本数,M为隐含层神经元数.

隐含层到输出层神经元的连接权值μ可以通过公式(2)一步直接确定

其中H+为矩阵H的伪逆,δ为学习目标样本所构成的列向量.

1.2 结构直接确定方法

本文设定误差为E,其确定方式如式(3)

其中δn为第n天上证指数开盘的实际值,μm为第m隐层神经元到输出层的连接权值.

为了提高神经网络的稳定性和防止过拟合现象的发生,我们在引入加权误差Etol,在神经网络学习同时进行内部校验,并按照式(3)计算得到学习误差Etra以及内部校验误差Evol.通过(4)式计算出加权误差Etol

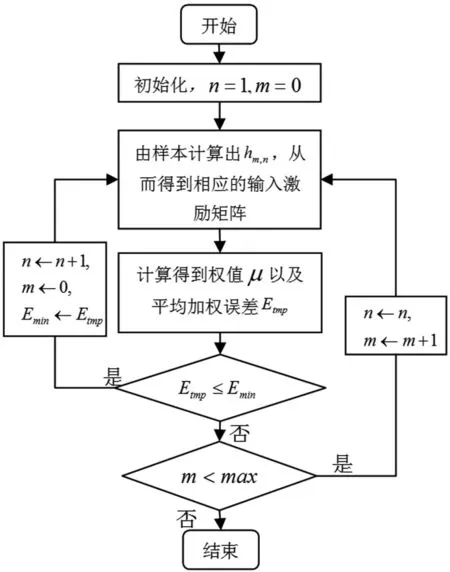

图2 权值与结构确定算法流程图

并将加权误差Etol用于后续神经网络最优结构的确定.其中,α为用于学习的样本数在整个训练样本中所占的比例.

对于网络的结构,我们使用边增边删原则.以加权误差Etol为增删神经元标准,并设定最大的重置次数max.先逐个增加隐含层神经元,当Etol不再下降时,重置新增的神经元(即重新给定该神经元的阀值以及输入层到隐含层的连接权值),如果更换次数达到max(设定的最大重置次数)次仍不能使Etol下降,则停止,此即为最优的WASD神经网络预测结构.具体流程图如图2所示.

2 上证指数预测实验

本文采用了1990.12.20-2016.10.12期间内6 312个交易日每日上证综合指数的6种指标(开盘价、收盘价、最高价、最低价、成交量和成交金额)用于训练,并对2016年10月12日后面10个工作日的上证指数进行预测(本文数据来源于http://quotes.money.163.com/trade/lsjysj_zhishu_000001.html).其中我们设置训练中的最大重置次数max=10、100、1000,用于讨论max的设定对网络预测精度和稳定性的影响.然后我们在常采用的6种指标的基础上进行加减指标来确定哪些指标是最有使用价值的指标,使正弦激励的WASD神经网络的性能发挥到极致.

将原始数据进行归一化,使得数据分布在[-1,1]区间内,取消各维度数量级差别,避免应输入输出数量级差异太大而造成网络预测误差较大和网络的不稳定性.在使用时,将数据进行反归一化.

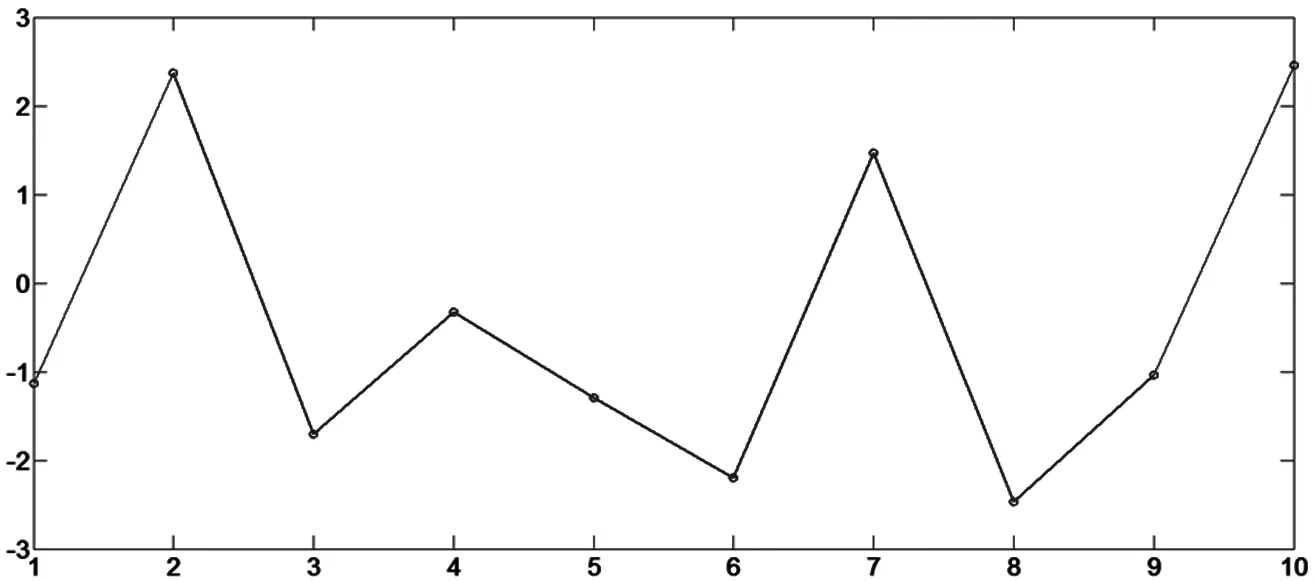

本文将训练数据中前5 812个数据用来学习,后500个用来内部校验(即α=5812/6312).在训练时,按照(3)式和(4)式同时计算出学习误差、校验误差和加权误差.我们以加权误差为判断标准,每次增加一个神经元,直到加权误差增大时重置该隐含层神经元.待重置次数大于预先设定的重置次数max式,仍然大于前面的误差时,训练结束.在整个训练中,各误差随着隐含层神经元个数的增加而变化情况展示在图3中.图中,我们展现的是最大重置次数max=1000时的情况,可以观察到通过逐个添加隐藏层神经元,加权误差先下降,然后开始上升,在转折点(即,隐含层神经元个数等于28个)处即为正弦激励的WASD神经网络的最优结构.因此,最优结构为隐含层神经元个数等于28个.

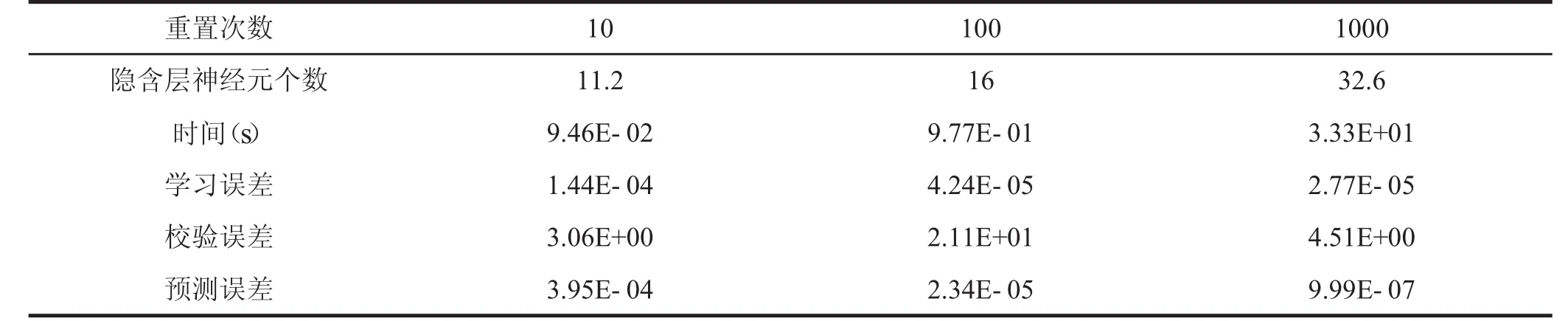

在实验时,我们发现最大重置次数的设置对我们预测的精度和稳定性有很大的影响.为此,我们对其进行了探讨.我们将最大重置次数max分别设置为10次、100次和1 000次进行实验,同时对后面的10天进行了预测,并按(3)式计算出它们的误差.为了避免偶然误差,我们对每类实验重复进行了5次,并记录了相关实验数据,由于篇幅有限,本文将5次数据进行了平均处理,其数据见表1.

图3 隐含层神经元个数和各误差的关系

表1 WASD神经网络性能和重置次数的关系

图4 正弦激励的WASD神经网络的预测结果

从表1我们可以得出:随着重置次数的增加,隐含层神经元的个数也随之增加,而预测误差呈数量级的减小.由此也可得出,前面随机设置的w和β这两个参数对网络性能的影响也在减小.但值得指出的是,重置次数增加,训练时间也将增加,为此我们需根据实际需要合理选择重置次数,本文采用的重置次数max=1000.图4为采用6种指标作为输入,正弦激励的WASD神经网络对上证指数的预测结果.

从图4可以看出预测结果与实际值基本重合,由此可知预测结果非常准确.为了更直观的看出预测结果与实际值的差异,我们定义预测的绝对误差为

Actual_E=yn-δn(5)

其中yn为第n天的预测值.我们将这10天的绝对误差展示在图5中.从图5可以看出正弦激励的WASD神经网络预测的绝对误差Actual_E在3以内,进一步说明了本文所提神经网络的预测精度非常高.

对上证指数的预测时所用的输入变量一般使用开盘价、收盘价、最高价、最低价、成交量和成交金额这6个指标.但是,上证指数的指标不仅仅只有6种,实际上共有9种数据.为了验证和避免因训练时使用的输入变量个数和类型的不准确而造成预测结果的不精确,我们在常规6种数据的基础上进行了增删.然后分别进行了实验,为了减少和避免偶然误差,我们对每类实验重复进行了5次.由于篇幅限,我们在对数据进行了平均处理,并将结果展示在表2中.

通过表2,我们可以发现不同的输入类型,其预测精度和训练时间都不同.预测精度最高的为输入类型1和2,而最差的为输入类型6.此外,输入类型1的训练时间最短.这也表明了本文所采用的数据输入类型的正确性.

图5 正弦激励的WASD神经网络预测的实际误差

表2 WASD神经网络性能和不同输入类型的关系

图6 正弦激励的WASD、BP和SVM预测的实际误差对比结果

为了进一步说明正弦激励的WASD神经网络在上证指数预测中的优势,我们将其与BP神经网络和SVM两种传统预测方法进行了对比.为了更加直观的展示,我们给出它们预测的实际误差图,如图6所示.

从图6可以看出,相比BP和SVM神经网络,正弦激励的WASD神经网络预测的绝对误差最小,也即其具有最好的预测精度.

3 结论

WASD神经网络是一种新型前向神经网络,通过权值与结构直接确定,减少了复杂的迭代过程.计算机数值实验结果表明:构建的正弦函数激励的WASD神经网络能有效地实现其最优权值与最优结构的自确定,且此神经网络在上证指数应用中具有十分优越的拟合.另外,本文通过对比正弦函数激励的WASD神经网络与BP和SVM在上证指数预测应用上的性能差异,证实了正弦函数激励的WASD神经网络在非线性程度增加时具备更为优越的学习性能,这也展现了正弦函数激励的WASD神经网络在数据挖掘等方面的应用潜力和前景.

[1]胡杉杉,党佳瑞,蓝柏雄.中国证券市场的可预测性研究[J].财经科学,2001(3):35-39.

[2]杨一文,刘贵忠.基于神经网络的多变量时间序列预测及其在股市中的应用[J].信息与控制,2001,30(5):413-417.

[3]周广旭.一种新的时间序列分析算法及其在股票预测中的应用[J].计算机应用,2005,25(9):2179-2184.

[4]顾嘉运,刘晋飞,陈明.基于SVM的大样本数据回归预测改进算法[J].计算机工程,2014,40(1):161-166.

[5]谭显胜,周铁军.BP算法改进方法的研究进展[J].怀化学院学报,2006,25(2):126-130.

[6]南敬昌,田娜.基于改进粒子群算法的模糊小波神经网络建模[J].计算机工程与应用:2017,5(33):120-123.

[7]李军,黄杰.基于自组织映射神经网络的局部自回归方法在网络流量预测中的应用 [J].信息与控制,2016,45(1):120-128.

[8]钟海全,李颖川,刘永辉,等.基于BP神经网络的多相管流模型优选及应用分析[J].中国科技论文在线,2008,(11):873-878.

[9]田亚鹏,鞠斌山.基于遗传算法改进BP神经网络的页岩气产量递减预测模型[J].中国科技论文,2016,11(15):1710-1715.

[10]黄宏运,吴礼斌,李诗争.BP神经网络在股票指数预测中的应用[J].通化师范学院学报,2016,37(10):32-34.

[11]汪思成,肖林,严慧玲.基于不同误差函数的神经网络求解线性方程组[J].吉首大学学报(自然科学版),2016,37(6):26-28.

[12]陈海英.基于支持向量机的上证指数预测和分析[J].计算机仿真,2013,30(1):297-300.

[13]Liao BL,Zhang Y N,Jin L.Taylor O(h3)discretization of ZNN models for dynamic equality-constrained quadratic programming with application to manipu-lators [J].IEEE Transactions on Neural Networks and Learning Systems,2016,27(2):225-237.

[14]Li S,Li Y M.Nonlinearly activated neural network for solving time-varying complex Sylvester equation[J].IEEE Transactions on Cybernetics,2013,44(8):1397-1407.

[15]Jin L,Zhang Y N,Li S.Integration-enhanced Zhang neural network for real-time-varying matrix inversion in the presence of various kinds of noises[J].IEEE transactions on neural networks and learning systems,2016,27(12):2615-2627.

[16]Zhang Y N,Guo D S,Luo Z Y,et al.CP-activated WASD neuronet approach to Asian population predic-tion with abundant experimental verification [J].Neu-rocomputing:2016,198:48-57.

[17]Zhang Y N,Yin Y H,Guo D S,et al.Cross-validation based weights and structure determination of Cheby-shev-polynomial neural networks for pattern classifica-tion[J].Pattern Recognition,2014,47(10):3414-3428.

[18]Zhang Y N,Yu X T,Guo D S,et al.Weights and struc-ture determination of multiple-input feed-forward neural network activated by Chebyshev polynomials of class 2 via crossvalidation[J].Neural Computing and Applications,2014,25(7-8):1761-1770.