非下采样轮廓波变换的前视声呐图像融合

张健,卞红雨

(1.哈尔滨工程大学 水声工程学院,黑龙江 哈尔滨 150001; 2.哈尔滨工程大学 水声技术重点实验室,黑龙江 哈尔滨 150001)

非下采样轮廓波变换的前视声呐图像融合

张健1,2,卞红雨1,2

(1.哈尔滨工程大学 水声工程学院,黑龙江 哈尔滨 150001; 2.哈尔滨工程大学 水声技术重点实验室,黑龙江 哈尔滨 150001)

针对前视声呐图像清晰程度不同,局部区域模糊的特点,本文提出一种基于非下采样轮廓波变换的前视声呐图像融合算法。依据图像多尺度分解的理论,对源图像进行非下采样轮廓波变换,得到一系列多尺度子带分解系数;根据图像中清晰目标反射声波能量大、对比度高特点,构建前视声呐图像融合规则,即低频子带采用Gabor能量、高频子带计算局部对比度指导融合规则,提出区域一致性校验准则抑制图像噪声,产生融合图像多尺度子带分解系数,并应用非下采样轮廓波逆变换获得融合图像。声呐图像融合对比实验证明,采用提出方法生成的融合图像在主观视觉和客观指标上均优于其他融合方法。

图像融合; 多尺度分析; 非下采样轮廓波变换; 前视声呐图像; 融合规则; Gabor能量; 局部对比度; 区域一致性校验

Abstract:According to the inherent properties of forward- looking sonar (FLS) images, such as non- uniform clarity and local blurred regions, a novel fusion method based on non- subsampled contourlet transform is proposed for FLS image fusion. Based on the theory of multi- scale analysis, the source images are decomposed into multi- scale coefficients by non- subsampled contourlet transform; the fusion rules are constructed on the fact that the clear objects have high reflection energy and contrast in FLS images, therefore the low- frequency sub- band is fused by the Gabor energy and the high- frequency sub- bands are fused by the local contrast, respectively; the region consistency check is then implemented to suppress the influence of noise; the fusion image is obtained by inverse non- subsampled contourlet transform on the generated fused coefficients. Experiments on FLS image fusion have been conducted to demonstrate the effectiveness and the superiority of the proposed technique using both a subjective evaluation and objective metrics.

Keywords:image fusion; non- subsampled contourlet transform (NSCT); multi- scale analysis; Forward- Looking sonar image; fusion rules; Gabor energy; local contrast; region consistency check

前视声呐图像融合是前视声呐图像配准的进一步处理,是目标分割、目标识别及跟踪等应用的前提。前视成像声呐是探测浑浊水域的有效设备。然而,前视声呐探测过程中,声呐载体与目标相对运动导致的视角变化和水体不规则时变扰动等环境因素同时影响,导致前视声呐图像不同区域,以及序列图像之间清晰度不同。具体表现为:对同一帧声呐图像,局部区域较清晰,图像对比度较高,而其他区域较模糊;对同一探测区域,在某帧声呐图像A中表现较清晰,对比度较高,而在相邻某帧图像B中较模糊;而其他区域在图像B中较清晰,在图像A中较模糊[1-3]。因此,有必要对前视声呐序列图像进行融合处理。融合的目的是充分利用序列声图像互补信息,强化图像各目标信息,使同一场景中各目标均比较清晰。

图像融合主要分为空间域图像融合和变换域图像融合[4]。空间域图像融合直接操作源图像像素灰度实现融合操作。根据源图像灰度空间上的分布,将图像分割为若干子图像,通过一定规则选择子图像作为融合图像相应位置区域,实现图像融合。然而,由于分割方式不易确定,融合图像容易产生“块效应”,即不同子图像区域结合处的视觉差异,严重影响融合图像质量[5]。

近年来,基于多尺度变换图像融合方法逐渐为研究者开发,应用拉普拉斯金字塔(laplacian pyramid, LP)分解和重建图像,并且以指定的融合规则获得图像[6]。同样地,文献[7]使用梯度金字塔(gradient pyramid, GP)实现图像融合,并证明其有效性。随后,二维离散小波变换(discrete wavelet transform, DWT)作为图像多尺度分解和重建工具,应用于图像融合算法[8-10]。与空间域图像融合方法相比,多尺度变换融合方法能够有效地避免“块效应”,这是由于源图像信息可以通过多尺度分解系数体现,从而避免在空间域分割源图像。

传统多尺度变换(multi- scale transform, MST)过程中的采样操作导致源图像分解和重建过程在图像强边缘处产生“伪吉布斯”现象[11]。此外,塔式变换无法有效表示图像方向信息,而DWT只能产生3个固定方向高频子带,不足以充分地表达图像边缘和轮廓中奇异点多方向信息[12]。因此,塔式变换和DWT不足以反映图像细节信息。文献[13]提出轮廓波变换(contourlet transform, CT),CT首先利用LP捕捉图像中奇异点,然后通过方向滤波器组处理,体现多方向信息。于是,CT不仅继承了多尺度分析的特点,并且具有各向异性。然而和传统MST一样,由于采样操作,图像在分解和重建过程中在目标边缘处易产生“伪吉布斯”现象,严重影响融合图像质量。

文献[11]提出非下采样轮廓波变换 (non- subsampled contourlet transform, NSCT),该变换继承了传统多尺度变换的优点,同时避免图像分解和重建过程中的采样操作,有效地抑制了“伪吉布斯”现象。因此,NSCT更适用于图像融合。本文基于多尺度变换图像融合框架,利用NSCT进行图像多尺度分解和重建,针对前视声呐图像特点提出融合规则,实现前视声呐图像融合。

1 基于NSCT的图像融合算法

NSCT由非下采样金字塔滤波器组(non- subsampled pyramid filter banks, NSPFB)和非下采样方向滤波器组(non- subsampled directional filter banks, NSDFB)组成。图像的NSCT多尺度分解过程如图1所示。首先,图像被NSPFB分解为1个低频子带和1个高频子带;然后,重复将每次分解后的低频成分通过NSPFB分解k次,得到k+1个子带图像,包括1个低频子带和k个高频子带;最后,分别将每个高频子带图像经过l级NSDFB处理,在每个高频子带上产生2l个方向子带。NSCT通过NSPFB保证其多尺度分析的特性,利用NSDFB充分地表达图像各向异性信息。由于NSCT在分解过程中避免对图像进行采样操作,能够有效地抑制“伪吉布斯”现象产生。此外,非下采样分解产生的子带图像大小与源图像相同,保证子带图像信息与源图像信息空间位置一致,方便制定图像融合规则[14]。

图1 NSCT图像多尺度分解Fig.1 Image decomposition by NSCT

与其他MST图像融合方法类似,对于两幅源图像A和B,基于NSCT的图像融合算法步骤如下所述:

综上所述,基于NSCT的图像融合算法框架如图2所示。

2 基于NSCT的前视声呐图像融合算法

在基于NSCT多尺度分析的图像融合算法中,图像首先被分解为低频子带和高频子带,再分别建立合适的融合规则,获得融合系数。融合规则是图像融合算法的核心步骤,合理地制定融合规则可以提高融合质量,改善视觉感受。

图2 NSCT图像融合算法框架Fig.2 Framework of image fusion algorithm based on NSCT

一般地,融合系数通过 “选择”或“平均”获得[15]。当源图像在同一像素位置存在显著差异时, 融合过程直接选择源图像分解系数中突出信息,作为融合图像相应位置的分解系数,并放弃非突出信息。当同一像素位置信息相似时,融合过程通过平均或加权平均确定该位置的融合系数。 这样,“选择”有效地保留图像间互补信息,“平均”保证图像内容均匀稳定。综上,多尺度分析图像融合算法根据源图像差异性信息,选择或平均源图像分解系数确定融合规则,获得融合图像。

对于光学图像,其图像灰度均匀,细节特征丰富,噪声干扰小,往往衡量图像局部区域活跃程度,如梯度、空间频率和局部方差等参数作为差异信息,指导融合规则。然而,由于声呐图像亮度非均匀,细节特征不突出且噪声污染严重,导致局部活跃信息受这些因素影响较大,不能准确地体现声呐图像间的差异。因此,应该重点根据声呐图像的特殊性,合理确定图像间差异信息,以此建立适用于声呐图像的融合规则。

2.1 低频子带系数融合规则

由于前视声呐图像本质是目标反射声波能量在空间上的分布,反射能量越大,目标越清晰。而低频子带保留了源图像绝大部分信息,体现图像的能量分布。因此,应该以能量强弱体现前视声呐图像差异性。在此,选择Gabor能量作为衡量源图像差异的参数,建立前视声呐图像低频子带系数融合规则。

Gabor能量可以有效地反映图像中能量分布,良好的抗噪性和相似不变性使其在前视声呐图像处理方面也有较好的效果[16-17]。低频子带系数与Gabor滤波器二维卷积生成不同尺度和方向上的Gabor系数。m尺度n方向的Gabor滤波器gmn(x,y)定义如下:

(1)

Cg(x,y,m,n)=∬L(x′,y′)gmn(x-x′,y-y′)dx′dy′

(2)

式中:L(x,y)为输入矩阵,此处为图像低频子带。计算(x,y)所有尺度和方向上Gabor系数平方和作为(x,y)点Gabor能量Eg(x,y):

(3)

构建基于Gabor能量的低频子带融合规则如下:

LF(x,y)=

(4)

2.2 高频子带系数融合规则

高频子带系数表示图像中的尖锐特征,比如物体的角点,边缘和轮廓等特征。因此,为了保证融合图像细节,高频子带系数融合规则一般采用绝对值最大准则。然而,前视声呐图像受噪声污染严重,绝对值最大准则容易将噪声误认为有用信息,引入融合图像。此外,绝对值最大准则没有考虑高频子带和低频子带系数之间的关系,根据人类视觉系统(human visual system, HVS)特点,观察者对物体的对比度而不是物体本身的尖锐程度更敏感,对比度强的像素点往往包含有用的视觉信息[18]。因此,通过对比度衡量声呐图像高频子带的差异信息,建立融合规则。

图像的对比度R定义如下[19]

(5)

式中:L为局部区域灰度级,LB为图像背景亮度,即低频子带系数,那么ΔL代表高频子带系数。除了对比度强弱,HVS同时对对比度频率和方向变化敏感[20]。那么(x,y)处k尺度l方向上的对比度Rkl(x,y)定义如下[20]

(6)

(7)

(8)

将局部对比度较大的系数作为图像有利信息,选择其为融合系数。

2.3 区域一致性校验准则

基于局部对比度的高频子带融合规则虽然保证视觉信息,但是不能有效地抑制噪声。图像噪声通常是一些随机离散的、孤立的像素点,与它们相邻的像素明显不同。区域一致性校验目的是检验中心像素信息与其邻域信息是否一致。在高频子带系数融合过程中,如果某点的高频系数来自源图像A,而该点邻域(一般取8邻域)系数多数来自源图像B,那么将该点系数替换为源图像B系数;反之亦然。通过一致性校验准则,融合过程可有效抑制来自源图像的噪声。

3 声呐图像融合实验与分析

3.1 评价标准

评价融合效果分为主观评价和客观评价[21]。主观评价通过观察者观察图像评价融合效果,客观评价通过定义指标判断融合性能。由于主、客观评价标准不完全一致,有时主观效果较好的融合结果未必达到较高的客观指标[21]。因此,判定融合效果应该综合主观观察和客观指标。

优秀的融合算法应该充分提取源图像间互补信息,传递到融合图像中,且不产生任何与源图像内容不一致信息[14]。因此,选择以下客观评价标准:

1) 互信息 (mutual information, MI)[22],表示源图像传递到融合图像的信息量,MI越大,融合效果越好。

2)基于边缘相似性度量 (edge based similarity measure, QAB/F)[23],通过边缘信息,衡量融合图像与源图像之间相似程度,QAB/F越大,融合效果越好。

3)峰值信噪比 (peak signal to noise ratio, PSNR)[24],衡量融合图像和源图像内容差异程度,PSNR越大,差异越小,融合效果越好。

3.2 前视声呐图像融合实验

将提出算法分别与3种基于MST融合算法和1种基于空间域融合算法比较,分别为基于LP图像融合算法,融合策略采用绝对值最大准则;基于DWT图像融合算法,融合策略应用均值规则;基于SCBG的图像融合算法[26],该算法是一种基于空间域的融合算法;基于NSCT图像融合算法,融合策略采用SML[25]规则,该规则通过计算图像局部区域的二阶差分反映图像活跃程度,在光学图像融合应用中表现出优异的性能[14]。基于变换域的融合算法均进行4层分解, NSCT方法方向取4或8方向。

图3(a)和3(b)分别是原始声呐图像第38帧和68帧,采用极坐标变换方法[27]配准两帧原始图像。图3(c)和3(d)是原始图像配准后的重合部分,作为融合源图像A和B。源图像A中左侧目标较清晰,右侧目标较模糊,不能区分目标阴影和背景。源图像B左侧目标模糊,右侧目标清晰,目标阴影与背景分明。于是,为了使源图像有利信息互补,对源图像A,B进行图像融合处理,以获得一幅左右目标均清晰的融合图像。

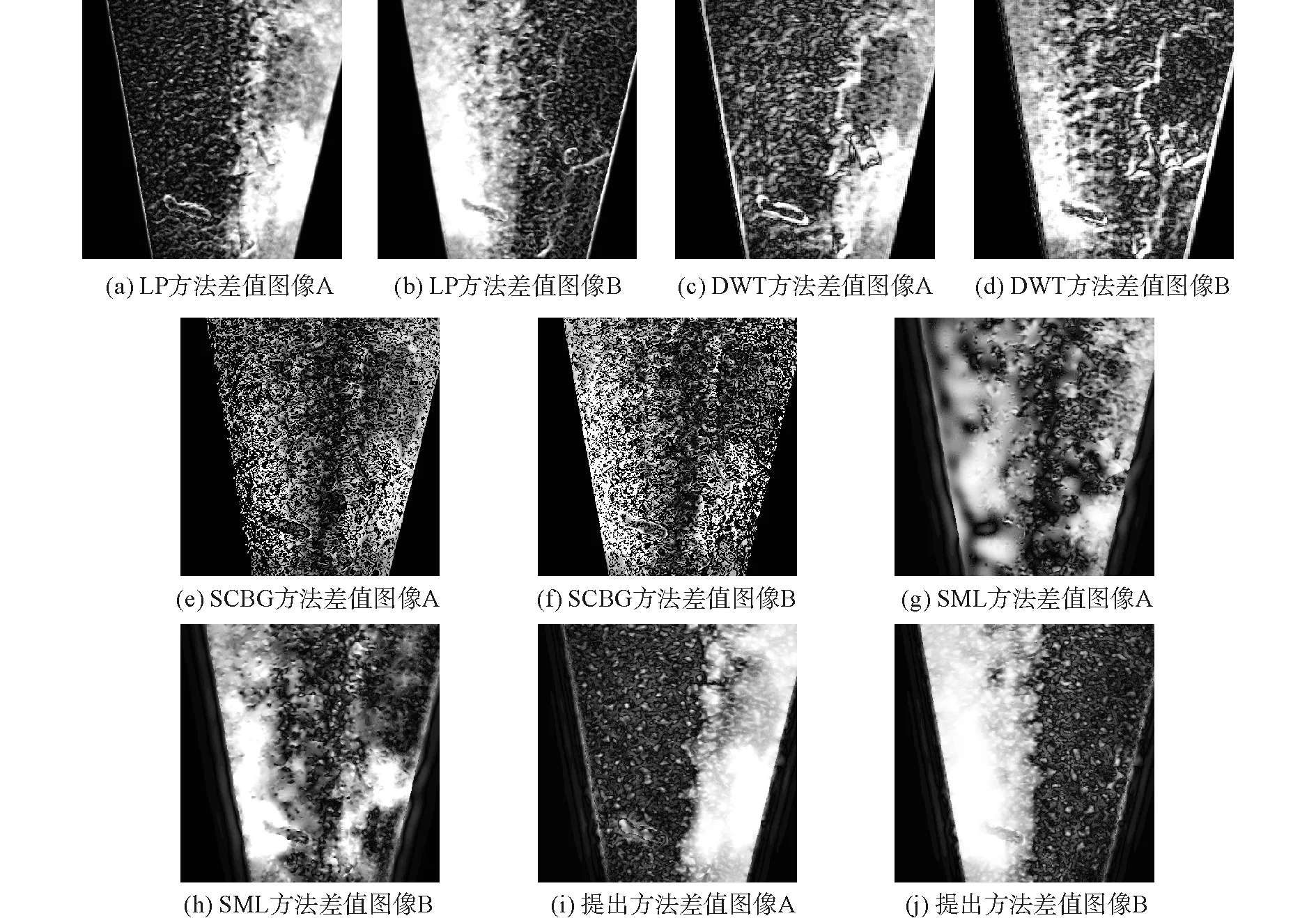

图4是LP、DWT、SCBG、SML和本文提出方法的融合结果,5种方法均在不同程度上实现了源图像有利信息互补。为了主观上更加直观地对比融合方法性能,分别将融合结果与源图像A和B相减,得到对应方法差值图像,如图5所示。结合融合图像和差值图像,即剩余信息,综合评价融合效果。图4(a)和4(b)中,基于LP和DWT的融合方法在目标某些边缘位置和前视声呐图像扇形边界处产生大量额外信息,即“伪吉布斯”现象,在差值图像5(a)~(d)中体现更加明显;在图4(c)中,SCBG融合结果产生明显的“块效应”,严重影响了主观视觉效果;图4(d)和4(e)是基于NSCT多尺度分析的融合结果,既有效地抑制“伪吉布斯”现象,又避免了“块效应”产生,说明NSCT更适合作为图像的多尺度分解工具。进一步对比SML方法和提出方法,图4(e)提出方法较图4(d)中基于SML准则的融合结果背景和目标表面灰度更加均匀,在差值图像中体现更为明显:图5(g)和(h)中,剩余信息较多,表明SML方法不能充分吸收源图像有利信息,导致融合结果背景强度不均匀。这说明局部活跃信息不能有效反映前视声呐图像间的差异性,以此建立的融合规则不适用于前视声呐图像融合。而提出方法的差值图像,图5(i)右侧剩余信息较多,左侧剩余信息几乎为0,图5(j)左侧剩余信息较多,右侧剩余几乎为0。这刚好与源图像A左侧区域清晰,右侧区域模糊,源图像B左侧区域模糊,右侧区域清晰相对应,说明提出的融合规则能够更充分地提取源图像中有利信息,产生良好的视觉效果,更适用于前视声呐图像融合。

图3 原始前视声呐图像和源图像Fig.3 Original FLS images and source images for fusion

图4 不同方法融合结果Fig.4 Fusion results by different methods

表1列出5种方法的客观评价指标。SCBG方法产生了最大的MI指标。这是因为MI是统计图像灰度概率分布相似程度的指标,SCBG方法融合过程直接选取源图像像素灰度,而基于MST方法在图像多尺度分解和重建过程中,不可避免地破坏原始图像灰度,所以基于空间的图像融合方法往往产生高于基于MST图像融合方法的MI指标[28]。但是SCBG方法融合结果主观效果差,并且QAB/F和PSNR指标较低。与LP和DWT融合方法相比,两种基于NSCT多尺度分析的融合结果显著地提高了客观指标。其中,本文提出的方法产生了最大的QAB/F和PSNR指标,并且MI指标仅略小于SCBG方法。客观地说明提出方法的优越性。因此,综合主、客观评价结果,本文提出的融合算法更适合于前视声呐图像融合处理。

图6是原始声呐图像第100帧和130帧重合部分配准结果,作为融合处理的源图像A和B。图6(c)~(g)分别是LP、DWT、SCBG、SML和本文方法的融合结果。表2是融合结果客观指标。综合主观视觉和客观指标,本文提出的融合方法效果优于其他融合方法。

表1 图3融合结果客观评价指标

表2 图6融合结果客观评价指标

图5 不同方法差值图像Fig.5 The difference images by different methods

图6 源图像和不同方法融合结果Fig.6 Source images and fusion results by different methods

4 结论

1)与传统方法相比,该方法能充分地融合源图像有利信息,避免产生伪像,并在一定程度上抑制图像噪声。

2)考虑到人类视觉系统特点,结合对比度大小及方向融合图像,融合结果清晰可靠,有利于人眼观察判决和计算机处理。

由于图像多尺度分解和重建过程不可避免地损失源图像信息,影响融合结果互信息指标,而基于空间域的图像融合方法能产生较大的互信息,今后的工作可以在这方面进行深入研究,有机地结合变换域和空间域图像融合方法优点,以便提出更好的前视声呐图像融合算法。

[1] WAITE A D. Sonar for practising engineers [M].Beijing: Publishing House of Electronics, 2004: 77-80.

[2] AYKIN M D,NEGAHDARIPOR S. On feature extraction and region matching for forward scan sonar imaging [C]//IEEE Oceans Conference, 2012: 1-9.

[3] AYKIN M D, NEGAHDARIPOR S. On feature matching and image registration for two- dimensional forward- scan sonar imaging [J]. Journal of field robotics, 2013, 30 (4): 602-623.

[4] MITIANOUDIS N,STATHAKI T. Optimal contrast correction for ica- based fusion of multimodal images [J]. IEEE sensors journal, 2008, 8 (12): 2016-2026.

[5] DE I,CHANDA B. Multi- focus image fusion using a morphology- based focus measure in a quad- tree structure [J]. Information fusion, 2013, 14 (2): 136-146.

[6] BURT P J, ADELSON E H. The laplacian pyramid as a compact image code [J]. IEEE transactions on communications, 1983, 31 (4): 532-540.

[7] PETROVIC V S,XYDEAS C S. Gradient- based multiresolution image fusion [J]. IEEE transactions on image processing, 2004, 13 (2): 228-237.

[8] YANG Y, HUANG S Y, GAO J F. Multi- focus image fusion using an effective discrete wavelet transform based algorithm [J]. Measurement science review, 2014, 14 (2): 102-108.

[9] KANNAN K, PERUMAL S A,ARULMOZHI K. Area level fusion of multi- focused images using multi- stationary wavelet packet transform [C]// International Journal of Computer Applications, 2010, 2 (1): 88-95.

[10] ZHOU Z Q, LI S,WANG B. Multi- scale weighted gradient- based fusion for multi- focus images [J]. Information fusion, 2014, 20: 60-72.

[11] DA C A L, ZHOU J P, DO M N. The nonsubsampled contourlet transform: theory, design, and applications [J]. IEEE transactions on image processing, 2006, 15 (10): 3089-3101.

[12] YANG Y, TONG S,HUANG S. Log- gabor energy based multimodal medical image fusion in NSCT domain [J]. Computational and mathematical methods in medicine, 2014, Article ID: 835481.

[13] DO M N, VETTERLI M. The contourlet transform: an efficient directional multiresolution image representation [J]. IEEE transactions on image processing, 2005, 14 (12): 2091-2106.

[14] YANG Y, TONG S, HUANG S Y. Multifocus image fusion based on nsct and focused area detection [J]. IEEE sensors journal, 2015, 15 (5): 2824-2838.

[15] 王达,卞红雨. 水下声图像多分辨率融合研究 [J]. 武汉大学学报:信息科学版,2015,40(1):77-82. WANG Da, BIAN Hongyu. Research on multiresolution- based underwater acoustic image fusion [J]. Geomatics and Information Science of Wuhan University, 2015, 40 (1): 77-82.

[16] HE C, ZHENG Y F, AHALT S C. Object tracking using the gabor wavelet transform and the golden section algorithm [J]. IEEE transactions on multimedia, 2002, 4 (4): 528-538.

[17] CHEN J B, GONG Z B,LI H Y. A detection method based on sonar image for underwater pipeline tracker [C]//IEEE Second International Conference on Mechanic Automation and Control Engineering (MACE), 2011: 3766-3769.

[18] ZHANG Q,GUO B L. Multifocus image fusion using the nonsubsampled contourlet transform [J]. Signal processing, 2009, 89 (7): 1334-1346.

[19] TOET A, RUYVEN L J,VALETON J M. Merging thermal and visual images by a contrast pyramid [J]. Optical engineering, 1989, 28 (7): 789-792.

[20] DEVALOIS R L, YUND E W,HEPLER N. The orientation and direction selectivity of cells in macaque visual cortex [J]. Vision research, 1982, 22 (5): 531-544.

[21] LIU Z, BLASCH E,XUE Z Y. Objective assessment of multiresolution image fusion algorithms for context enhancement in night vision: a comparative study [J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34 (1): 94-109.

[22] YANG B,LI S. Pixel- level image fusion with simultaneous orthogonal matching pursuit [J]. Information fusion, 2012, 13 (1): 10-19.

[23] XYDEAS C S,PETROVIC V.Objective image fusion performance measure [J]. Electron letters, 2000, 36 (4): 308-309.

[24] MIAO Q G, SHI C, XU P F. A novel algorithm of image fusion using shearlets [J]. Optical communication, 2011, 284 (6): 1540-1547.

[25] HUANG W, JING Z. Evaluation of focus measures in multi- focus image fusion [J]. Pattern recognition letters, 2007, 28 (4): 493-500.

[26] TIAN J, CHEN L,MA L.Multi- focus image fusion using a bilateral gradient- based sharpness criterion [J]. Optical communication, 2011, 284 (1): 80-87.

[27] MATUNGKA R, ZHENG Y F,EWING R L. Image registration using adaptive polar transform [J]. IEEE transaction on image processing, 2009, 18 (10): 2340-2354.

[28] LI S,YANG B. Hybrid multiresolution method for multisensory multimodal image fusion [J]. IEEE sensors journal, 2010, 10 (9): 1591-1526.

Forward-lookingsonarimagefusionbasedonnon-subsampledcontourlettransform

ZHANG Jian1,2, BIAN Hongyu1,2

(1.College of Underwater Acoustic Engineering, Harbin Engineering University, Harbin 150001, China; 2.Acoustic Science and Technology Laboratory, Harbin Engineering University, Harbin 150001, China)

10.11990/jheu.201606093

http://www.cnki.net/kcms/detail/23.1390.u.20170426.1815.094.html

TN911.73

A

1006- 7043(2017)09- 1373- 07

2016-06-24. < class="emphasis_bold">网络出版日期

日期:2017-04-26.

国家自然科学基金项目(41376102).

张健(1988-), 男, 博士研究生; 卞红雨(1969-), 女, 教授,博士生导师.

卞红雨,E- mail:bianhongyu1116@hrbeu.edu.cn.

本文引用格式:张健,卞红雨. 非下采样轮廓波变换的前视声呐图像融合[J]. 哈尔滨工程大学学报, 2017, 38(9): 1373 -1379.

ZHANG Jian, BIAN Hongyu. Forward- Looking Sonar Image Fusion Based on Non- Subsampled Contourlet Transform[J]. Journal of Harbin Engineering University, 2017, 38(9): 1373-1379.