一种修正的模糊极限学习机

李丽娜 闫德勤 楚永贺

(辽宁师范大学计算机与信息技术学院 辽宁 大连 116081)

一种修正的模糊极限学习机

李丽娜 闫德勤 楚永贺

(辽宁师范大学计算机与信息技术学院 辽宁 大连 116081)

极限学习机ELM(Extreme learning machine)作为一个有竞争力的机器学习算法,以其简单的理论和易于实施的特点吸引了越来越多学者的关注。近来,针对噪音及离群数据,研究人员提出了相关的研究算法,然而如何将ELM更好地应用在含有噪音及离群数据的分类问题中仍是一个重要的研究课题。基于数据的信息关联的技术思想提出一种修正的模糊极限学习机(MFELM)。MFELM的优势在于: 1) MFELM在处理噪音及离群数据的分类问题时能够保持ELM处理正常数据分类问题的良好性能; 2) 适用于ELM的激活函数或核函数同样适用于MFELM模型; 3) 根据不同的需求给每个数据样本分配不同的隶属度,MFELM可以推广到代价敏感学习中。通过使用UCI数据集和普遍应用的人脸数据集进行实验,实验结果表明该提出的算法显著提高了ELM的分类能力并优于其他算法。

极限学习机 不平衡数据 信息关联 特征映射

0 引 言

近来极限学习机[1]ELM吸引了越来越多学者的关注[2-3],ELM在单隐层前馈神经网络SLFNs(Single-hidden layer feedforward networks)[4]的基础上发展而来,可以看作是SLFNs的扩展。不同于传统的神经网络算法,ELM具有三个主要优势:(1) 随机产生隐层节点的输入权值和偏置值,仅有输出权值经过分析确定。根据文献[5]分析指出几乎所有非线性分段连续函数都可以作为激活函数,同时能够满足ELM具有的通用逼近能力。(2) 不仅最小化训练误差并且最小化输出权值,ELM最小化输出权值和支持向量机SVM[6]最大化几何间隔在本质上具有一致性[3]。(3) SVM针对不同的应用就需要有与之对应的模型,不同于SVM算法,ELM针对不同的问题(例如:二分类问题,多分类问题以及回归问题)提供了统一的模型框架。ELM良好的性质使其在实际问题中得到了广泛应用,例如:不平衡数据学习[7],噪音及缺失数据[8-9],人脸识别[10],聚类[11],特征提取[12]等。

虽然ELM在分类和回归问题中得到了广泛应用,然而ELM在处理含有噪音及离群点数据时并没有表现出很好的鲁棒性。在处理分类和回归问题时,每个训练样本对建立的预测模型具有相同的影响,ELM通过最小化训练误差和输出权值建立的预测模型同样适用于噪音及离群数据,在这种情况下将导致输出权值求解不准,出现过拟合的现象,降低ELM的泛化能力。针对噪音及离群点对ELM隐层节点输出矩阵的影响,文献[13]提出一种鲁棒激活函数的极限学习机RAFELM(Robust activation function extreme learning machine),该方法从激活函数的角度在高斯激活函数的基础上进行了改进,该方法的特点是利用角度优化的思想对高斯激活函数进行了改进,增强ELM对噪音及离群点的抗干扰能力,通过在图像数据集上的实验结果表明RAFELM提高了ELM的泛化性能。但RAFELM并没有消除噪音及离群点对ELM算法的影响。针对噪音及离群点对ELM模型的影响,文献[14]和文献[15]利用隶属度的概念,这两种方法的特点是根据不同数据样本对ELM模型的不同影响分配相应的隶属度。文献[14]针对分类问题提出一种模糊极限学习机FELM(Fuzzy extreme learning machine),FELM只是提出了隶属度的概念,并没有给出如何计算隶属度具体的方法。文献[15]针对回归问题提出一种新的模糊极限学习机算法NFELM(New fuzzy extreme learning machine)。NFELM算法具体做法是利用隶属度的思想,根据不同数据样本对ELM模型的不同影响分配一个额外的权值,隶属度表征数据样本对ELM模型的重要程度,隶属度越大表明数据点对ELM模型的影响越大。在噪音及离群数据学习中,对重要的数据分配一个比较大的隶属度,对噪音及离群数据分配一个比较小的隶属度。NFELM算法利用上述方法减弱噪音及离群点对ELM的影响,NFELM通过在人工数据和现实世界的基准数据实验结果表明,NFELM提高了ELM对噪音及离群点的鲁棒性。然而NFELM并没有考虑到ELM特征映射空间对数据的影响,NFELM在数据输入空间计算的隶属度,不能正确反映数据样本与类中心之间的关系,并没有充分发挥ELM的优势。

针对现有ELM算法在处理噪音及离群点存在的问题,提出一种修正的模糊极限学习机(MFELM),MFELM继承了ELM良好的学习能力和泛化能力,与现有的ELM算法相比,MFELM在处理噪音及离群点时具有很好的鲁棒性。为验证所提算法的有效性,实验使用UCI数据集和普遍应用的人脸数据集进行实验,实验结果表明本文提出的算法显著提高了ELM的分类能力并优于其他算法。

值得一提的是,本文在计算样本隶属度时考虑到特征映射空间对数据的影响,从而在特征映射空间计算样本的隶属度而非数据输入空间。实验结果显示在特征映射空间计算隶属度建立的ELM模型的泛化性能优于在数据输入空间计算的隶属度。

1 ELM

对于N个不同的样本(xj,tj),可表示为X=(x1,x2,…,xN)T∈RD×N,其中tj=(tj1,tj2,…,tjm)T∈Rm为对应于样本xj的期望输出向量。网络中含有L个隐层节点,激活函数为g(x):

(1)

其中j=1,2,…,N,ai=(ai1,ai2,…,ain)为连接第i个隐层节点与输入节点的输入权值向量,βi=(βi1,βi2,…,βim)为连接第i个隐层节点与输出节点的输出权值向量,bi为第i个隐层节点的偏置值,ai·xj表示ai和xj的内积。对所有数据样本进行整合,式(1)可以改写为如下形式:

Hβ=T

(2)

其中H是网络隐层节点输出矩阵,β为输出权值矩阵,T为期望输出矩阵:

(3)

(4)

当隐层节点个数和训练样本个数相同时(即L=N)我们可以通过式(2)直接求矩阵H的逆矩阵,得到最优的输出权值矩阵β,但大多情况下隐层节点的个数远小于训练样本的个数(即L< (5) 其中H+为矩阵H的广义逆。 为了提高传统ELM的稳定性和泛化能力,Huang提出了等式优化约束的ELM[16],等式优化约束的ELM的优化式子不仅最小化训练误差ξ同时最小化输出权值β,因此等式优化约束的ELM目标式子可写为: (6) 式(6)中ξi=(ξi1,…,ξ1m)T为对应于样本xi的训练误差向量,C为惩罚参数。利用拉格朗日方法对式(6)转化为无条件最优化问题进行求解可得: (7) 由式(7)可得ELM的输出函数为: (8) 因此ELM算法求解过程可总结步骤如下: 1) 初始化训练样本集; 2) 随机指定网络输入权值ai和偏置值bi,i=1,2,…,L; 3) 通过激活函数计算隐层节点输出矩阵H; 为了克服现有ELM算法在处理噪音及离群点存在的问题,提出一种修正的模糊极限学习机(MFELM)。 2.1 隶属度的定义 本节我们提出一种新的模糊隶属度函数,与文献[15]提出的方法相比,本文所提的方法在消除噪音及离群点对ELM算法的影响方面能够获得更好的效果,同时能够显著提高ELM算法的准确率和泛化能力。 (11) R=max‖φc-φ(Xc)‖ (12) di=‖φ(xi)-φc‖ (13) 上述式(11)和式(12)适用于激活函数已知的情况,当激活函数未知我们可以采用核函数的方法求得R和di: R2= max‖φ(Xc)-φc‖2= max{φ2(Xc)-2φ(Xc)·φc+(φc)2}= (14) 式(14)中Xc为第c类所有样本组成的样本矩阵,xi为第c类第i个样本,nc为第c类数据样本个数,K(xi,xj)为核函数。 φ(xi)2-2φ(xi)·φc+(φc)2= (15) 1) 当激活函数已知的情况下利用式(12)和式(13)定义隶属度: (16) 式中σ>0,为了避免si=0。 2) 当激活函数未知我们采用核函数的方法利用式(14)和式(15)定义隶属度: (17) 式中σ>0,同样为了避免si=0。 在处理分类和回归问题时,数据样本经过激活函数或核函数映射到隐层节点空间然后求解输出权值。文献[14]和文献[15]在数据样本的输入空间求解隶属度,然而数据的几何结构及性质在ELM特征映射空间发生了改变,使得在数据输入空间计算的隶属度不能正确反映数据样本与类中心之间的关系,从而导致输出权值求解不准,本文提出新的隶属度计算方法能有效解决上述问题。本文提出的方法不仅适用于ELM算法同时适用于核ELM算法。 2.2MFELM的优化问题 MFELM的优化模型可表示为: (18) 其中W为输出权值矩阵,ε为训练误差,C为惩罚参数,f(x)为激活函数。 式(18)对应的拉格朗日函数为: tij+εij) (19) 其中wj为第j个输出节点的权值W=[w1,w2,…,wm],依据KKT条件: (20) (21) (22) 其中αi=[αi1,ai2,…,αim]T,α=[α1,a2,…,αN]。 将式(20)和式(21)代入式(22),我们可以得到: (23) 式(23)中S=diag(s1,s2,…,sN)。 由式(20)和式(23)可以得到: (24) 由式(24)MFELM的输出函数为: (25) 给定训练样本X=(x1,x2,…,xN)和训练样本的期望输出矩阵T=(t1,t2,…,tN)∈RD×N,激活函数为f(x),隐层节点数为L,MFELM算法可总结步骤如下: 1) 初始化训练样本集; 2) 随机指定网络输入权值aj和偏置值bj,j=1,2,…,L; 3) 利用式(16)或式(17)计算样本的隶属度si; 4) 通过激活函数计算隐层节点输出矩阵F; 为了证明本文所提算法的有效性,我们将MFELM与ELM、NFELM[15]、RAFELM[13](ELM、NFELM、RAFELM均采用激活函数Sigmoid)进行比较。隐层节点个数设置200,为了实验的公平性,本文实验的ELM及其改进算法均采用相同的惩罚参数C(我们试着寻找最优的惩罚参数C,使ELM及其改进算法取得较好的结果)。所用电脑为惠普工作站,处理器:Intel(R)Xeon(R)CPUE5-1603 0 @2.80GHz,安装内存:8.00GB,系统类型:64位操作系统,版本:Win7。所使用的4个不同人脸库图像如图1所示,不同人脸数据库和UCI数据集属性设置如表1、表2所示。 图1 不同人脸图像的训练集 DatasetsDimSamplessamples/subjectClassesYale10241651115YaleB102424145538ORL10244001040UMIST103045791820 表2 多分类UCI数据集描述 图2-图3中横坐标 “TrainNum”表示每类训练样本个数。实验中我们首先从每类数据样本中随机选取一部分数据作为实验数据集进行实验. 实验结果如图2-图3及表3-表4所示。 图2 不同ELM算法识别曲线 图3 不同ELM算法识别曲线 DatasetELMRAFELMNFELMMFELMMaxAveMaxAveMaxAveMaxAveYale86.6765.6180.0070.6178.3368.2686.6773.86YaleB91.0583.8490.9282.7591.8485.9093.6885.91ORL76.2570.9091.0086.3794.6990.3895.0090.48UMIST96.6789.5965.0060.5995.0089.0996.2589.35 表4 UCI数据集最大和平均识别率比较 图2给出了不同的ELM算法在人脸图像数据集上的识别率曲线。由图2我们可以看出本文所提算法MFELM随着训练样本的增多在总体趋势上识别率曲线优于其他算法的识别率曲线。表2给出了不同ELM算法的具体识别率,在Yale数据集上,MFELM的平均识别率比ELM平均识别率高8.25%,比RAFELM算法的识别率高3.25%,比NFELM算法的识别率高5.6%,在Yale B数据集上,MFELM的平均识别率比ELM平均识别率高2.07%,比RAFELM算法的识别率高3.16%,比NFELM算法的识别率高0.01%,在ORL数据集上,MFELM的平均识别率比ELM平均识别率高19.58%,比RAFELM算法的识别率高4.11%,比NFELM算法的识别率高0.1%,在UMIST数据集上,MFELM的平均识别率比ELM平均识别率低0.24%,比RAFELM算法的识别率高28.76%,比NFELM算法的识别率高0.26%。通过上述MFELM与其他三种ELM算法的具体识别率比较,我们可以看出MFELM算法在人脸图像数据集上表现出良好的性质。为了进一步验证本文所提算法的有效性,我们将不同的ELM算法在标准机器学习(UCI)数据上进行实验。图3给出了不同ELM算法在标准机器学习(UCI)数据上的识别率曲线,由图3我们可以看出MFELM算法的识别率曲线显著高于其他算法的识别率曲线,表4给出了不同ELM算法的具体识别率。通过在人脸图像数据和机器学习数据上的实验结果可以看出MFELM表现出良好的性质。这是由于MFELM算法在计算训练样本的隶属度时考虑到ELM特征映射空间对数据几何结构的改变,从而在数据的特征映射空间计算训练样本的隶属度而非数据输入空间。NFELM考虑到噪音及离群点对ELM模型的影响,从识别率曲线上同样取得了比较好的识别效果,然而NFELM并未意识到ELM特征映射空间对数据几何结构的影响,NFELM的总体识别率低于MFELM的识别率。RAFELM从激活函数的角度对ELM算法进行改进,增强激活函数对噪音及离群点的鲁棒性,但并没有消除噪音及离群点对ELM模型的影响。在UMIST和sat数据集上RAFELM的识别率曲线低于ELM算法的识别率。由图2-图3可以看出NFELM和RAFELM在一些数据集上的识别率低于ELM的识别率,然而本文所提算法在人脸数据集和UCI数据集的识别率曲线明显高于其他算法的识别率曲线。 为了克服现有ELM算法在处理噪音及离群点存在的问题,提出一种修正的模糊极限学习机(MFELM),MFELM算法在计算训练样本的隶属度时考虑到ELM特征映射空间对数据几何结构的改变,从而在数据的特征映射空间计算训练样本的隶属度而非数据输入空间,增强ELM算法在处理噪音及离群数据的鲁棒性。通过将MFELM与ELM,RAFELM,NFELM算法的对比实验表明,本文所提出的方法显著提高了极端学习机的泛化性能。 [1] Huang G B,Zhu Q Y,Siew C K.Extreme learning machine:Theory and applications[J].Neurocomputing,2006,70(1-3):489-501. [2] Tang J,Deng C,Huang G B.Extreme Learning Machine for Multilayer Perceptron[J].IEEE Transactions on Neural Networks & Learning Systems,2015,27(4):809-821. [3] Huang G B,Zhou H,Ding X,et al.Extreme learning machine for regression and multiclass classification[J].IEEE Transactions on Systems Man & Cybernetics Part B Cybernetics A Publication of the IEEE Systems Man & Cybernetics Society,2012,42(2):513-529. [4] Huang G B,Zhu Q Y,Siew C K.Extreme learning machine:a new learning scheme of feedforward neural networks[C]//IEEE International Joint Conference on Neural Networks,2004.Proceedings.IEEE Xplore,2004:985-990 vol.2. [5] Huang G B,Chen L.Enhanced random search based incremental extreme learning machine[J].Neurocomputing,2008,71(16-18):3460-3468. [6] Cortes C,Vapnik V.Support-Vector Networks[J].Machine Learning,1995,20(3):273-297. [7] Zong W,Huang G B,Chen Y.Weighted extreme learning machine for imbalance learning[J].Neurocomputing,2013,101(3):229-242. [8] Yu Q,Miche Y,Eirola E,et al.Regularized extreme learning machine for regression with missing data[J].Neurocomputing,2013,102(2):45-51. [9] Man Z,Lee K,Wang D,et al.Robust Single-Hidden Layer Feedforward Network-Based Pattern Classifier[J].IEEE Transactions on Neural Networks & Learning Systems,2012,23(12):1974-1986. [10] Peng Y,Wang S,Long X,et al.Discriminative graph regularized extreme learning machine and its application to face recognition[J].Neurocomputing,2015,149:340-353. [11] Huang G,Song S,Gupta J N,et al.Semi-supervised and unsupervised extreme learning machines[J].IEEE Transactions on Cybernetics,2014,44(12):1-1. [12] Benoit F,Heeswijk M V,Miche Y,et al.Feature selection for nonlinear models with extreme learning machines[J].Neurocomputing,2013,102(2):111-124. [13] Liu S,Feng L,Xiao Y,et al.Robust activation function and its application:Semi-supervised kernel extreme learning method[J].Neurocomputing,2014,144(1):318-328. [14] Zhang W B,Ji H B.Fuzzy extreme learning machine for classification[J].Electronics Letters,2013,49(7):448-450. [15] Zheng E,Liu J,Lu H,et al.A New Fuzzy Extreme Learning Machine for Regression Problems with Outliers or Noises[M]//Advanced Data Mining and Applications,2013:524-534. [16] Huang G B.An Insight into Extreme Learning Machines:Random Neurons,Random Features and Kernels[J].Cognitive Computation,2014,6(3):376-390. A MODIFIED FUZZY EXTREME LEARNING MACHINE Li Li’na Yan Deqin Chu Yonghe (SchoolofComputerandInformationTechnology,LiaoningNormalUniversity,Dalian116081,Liaoning,China) As a competitive machine learning algorithm, Extreme Learning Machine (ELM) attracts more and more scholars’ attention with its simple theory and easy implementation. Recently, researchers on noise and outlier data have proposed relevant research algorithms. However, how to use ELM better in classification problems with noise and outlier data is still an important research topic. This paper proposes a modified fuzzy extreme learning machine (MFELM) based on the technical idea of information related. The advantages of MFELM are as follows: MFELM can maintain the good performance of ELM processing normal data classification when dealing with the classification of noise and outlier data; the activation or kernel functions for the ELM also apply to the MFELM model; MFELM can be extended to cost-sensitive learning by assigning different memberships to each data sample according to different requirements. Experiments on UCI datasets and universally applied face datasets show that the proposed algorithm improves the classification ability of ELM significantly and is superior to other algorithms. Extreme learning machine Imbalanced data Information related Feature mapping 2016-06-02。国家自然科学基金项目(61373127)。李丽娜,硕士生,主研领域:数据降维,机器学习。闫德勤,教授。楚永贺,硕士生。 TP18 A 10.3969/j.issn.1000-386x.2017.05.041

2 修正的极限学习机

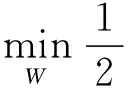

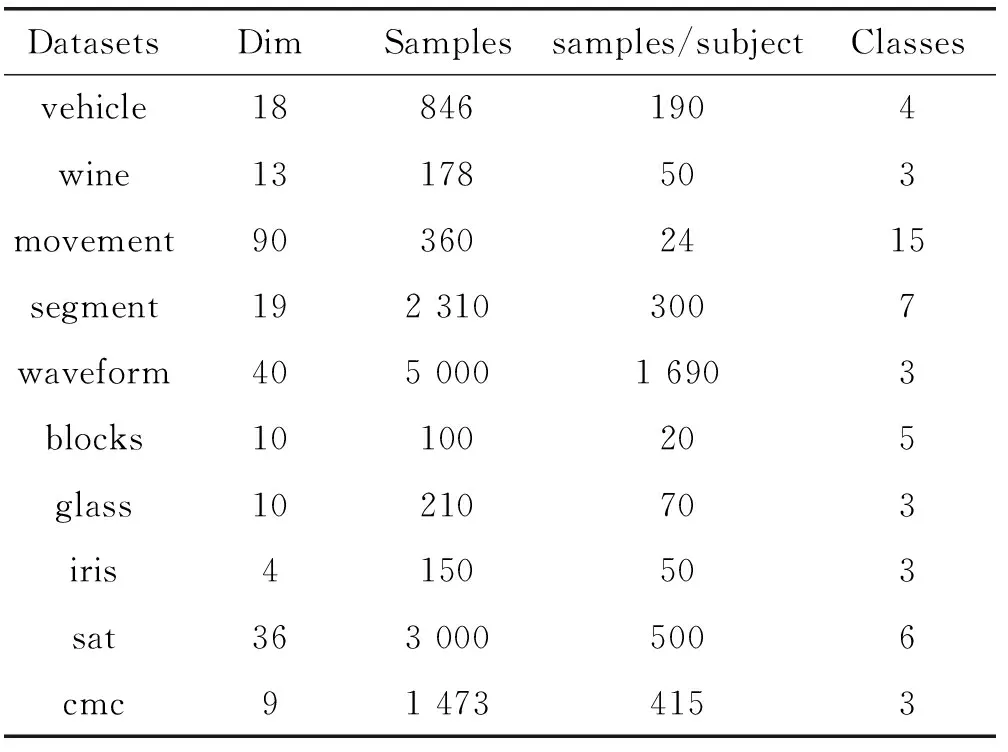

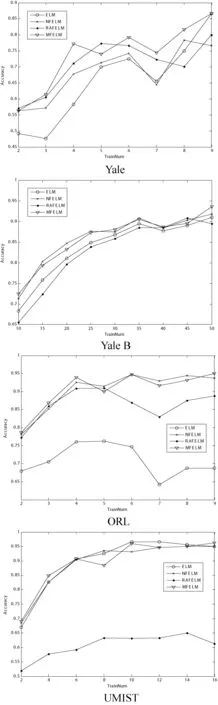

3 实验结果及分析

4 结 语