技术创新风险分析①

陈 凡,徐 旭

(东北大学 科学技术哲学研究中心,沈阳 110169)

技术创新已把人类社会推向一个物质文明的高峰,同时又将人类社会推向一个危机四伏的时代,在当今的社会环境下,技术问题的负面效果可以通过改进技术或新技术来弥补。因此,技术创新就变成理所当然的社会需求,人们所能做的就是不假思索地增添新的技术,而日复一日的技术创新增长模式下,技术系统变得盘根错节。从事物发展的辩证法来分析,技术创新和技术风险一方面是有所相通的,技术风险是刺激人们改善原始技术,更新技术的动力之一;而另一方面,从发展机制的角度讲,技术创新和技术风险是相悖的,技术创新是人们所向往的,而技术风险是人们所规避的。因此在这种情况下,技术在人类的世界中扮演着两种角色,技术既是问题,也是答案。

1 技术创新风险的驱动性

1.1 技术风险的创新驱动

风险自古以来就是推动人类进步的力量。早在古人类时期,面对自然风险(野兽、风暴、食物短缺等)时,身体上的缺陷使得人类无法同其他动物一样依靠自身力量抵御自然灾害,于是技术应运而生,此时的技术创新的主要目的是保证人类生存。随着技术的发展,人们有更大的物质追求,于是在大工业化时代,因人们对技术后果的漠视而造成了技术灾难,出现了诸如伦敦雾霾事件等风险。这其中也包括了技术风险的隐性灾难,例如全球变暖。随着人们对技术了解的深入,人们对技术的看法也从技术乐观论过渡到技术威胁论,人们开始反思技术创新过程中的问题,但当时的技术创新仍如雨后春笋般地出现。那么技术创新和技术风险这两者在历史长河中为什么始终相互依存、结伴同行呢?

我们认为,从技术诞生之初的人猿揖别,技术风险对技术创新就有所推动,这一点表现在三个方面。一是暴力与反暴力的需要,这一点基于人类的生存本能。例如17世纪英国的殖民扩张所造成的连锁反应使得全世界国家争相发展军事技术,甚至“卓越的科学家们有时直接从事军事技术问题的研究”[1],这种间接性的刺激是从社会风险转移到技术中,而军事技术的发展导致了武器技术对人类生命的威胁增加,从技术角度来说就是增加了新的技术风险,为了减少己方伤亡,军事技术的创新研究在当时变得白热化。二是技术的潜在风险促使人们去实践创新来避免其在未来造成巨大危害。相比前者,潜在技术风险并不容易发现,例如基因技术、核技术等复杂技术在空间和时间上的可能性使得这些技术风险更难以把控,为了把该类技术的风险降至最低,人们不断研究最新方法去更新、替代这类技术。三是人类突破自我限制的欲望。例如飞行器、游艇、3D虚拟技术等,人类技术的当下发展目标已经突破了时间限定,以技术代替人类自然功能。Bostrom将基于此目的的创新研究称为后人类研究(posthuman),在后人类研究上分成了对立的两派:超人类主义和生物保守主义。超人类主义认为通过技术创新,技术会为人类带来巨大的价值和优势;而生物保守主义则认为这类的技术创新是一种“去人类化”的研究,因此很多科学家都是坚定的生物保守主义的支持者,包括LeonKass、Wesley Smith等。在人类的进化过程中,技术早已经形成自有的干预机制影响着人类的进化发展,在未来怎样利用技术增强人类生存和发展本领,又不失去原有的人本属性,这个难题仍然是新时期技术创新和技术风险两者关系所面临的新形势。

1.2 技术风险的创新驱动阈值

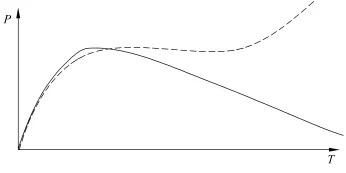

我们需要注意到的是,单从技术风险对创新的推动能力来说,创新能力伴随着技术风险从隐性到显性的呈现过程而增长,直到技术风险被毫无保留地发现,创新能力也达到一个峰值,但是技术风险的危害性是变量,在未来的技术使用过程中随着该变量的增加,技术风险会持续放大,创新能力则是一段时间内人们知识所能达到的值,因此创新能力则趋向削弱(如图1所示)。当然,在一定时期内技术风险也会达到一个稳定状态,这个稳定状态是社会对该技术的风险承受力达到可控程度,而与此相对应的技术开发还没有形成。在这个稳定态形成之前,技术创新和技术风险都是一个开放系统,这个开放系统随着相关科学知识和研究学者的变化而变化。

图1 技术创新能力与技术风险发展趋势

除此之外,技术风险对创新的驱动作用更体现在技术风险下的创新呈现出不同的实现方式,体现在其他的创新模式是一种突现。创造力研究学者Wallas认为创新的产生要经过潜伏和顿悟阶段。柏格森也在研究中指出,生物的进化是一种突现,而技术风险的创造力产生是对以往技术风险的量化积累,创新的产生不能算作是一种突现,因为并没有满足从提出问题到解决问题的闭循环。因此,技术创新不单单是一场技术的革新,同时是一场人与人、人与技术之间的博弈。在这场较量中无时无刻不伴随着技术风险。该风险表现在两个方面:一方面是人类的无序创新带来新的风险;另一方面是技术创新造就的技术复杂性带来新的问题。

2 技术创新风险的无序性

人类的无序创新是指创新的过程中不计后果地推动技术发展,其产生的负面影响之一是技术创新的结果存在着道德缺陷。例如,创造出新的药品能治愈疾病,延长人类寿命,但是新的医疗技术并不是人人平等享受的,那些能享受到这些先进的医疗技术的是拥有社会资源最多的群体,诸如此类的道德问题让人们对技术创新产生排斥。出现在无序创新的另一个负面影响是技术替代了人类的功能。例如,在人工智能发展的过程中机器不仅掌握了人类的信息和喜好,更是改变了社会结构,淘汰了众多人类劳动力,虽然有的学者认为人工智能的发展是对人类劳动力的解放,但是谁也不能否认技术的发展让人们更加担心,是否有一天技术会取代人类。

2.1 人类能力的技术掠夺

当我们阅读新闻的时候,机器会将我们选择的新闻收集成数据,根据大数据来分类推送新闻。也就是说,当下的技术可以自动识别我们的喜好,而我们习惯使用的符号表情也有可能在未来的某一天被机器所识别和掌握,那么作为人类的情绪表达也就被机器所控制了。我们所做的事情和以前日常所做的事没有变化,变化的是机器,技术的发展更贴近人的生活,“智能化”的技术环境让人们享受技术带来的便利同时,极容易出让人们的利益。在世纪之交有两件事情值得人们深思:一是1997年IBM公司所设计的人工智能程序深蓝打败了国际象棋大师卡斯帕洛,在之后的人工智能和人类的数次主要对抗中均未尝败绩,包括2016年3月AlphaGo打败了韩国围棋大师李在石;二是2000年初富士康公司宣布用机器人代替了6万名工人,与此同时沃尔玛公司计划用无人机替代仓库拣货员的工作。这两件事情表明了一个共同的事实,即智能技术正在与人类竞争,甚至在某些方面,创新的技术走在了人类的前列,我们担心的是人与人之间的竞争是有理可循的,因为人类之间的竞争是资源的竞争(如围棋胜利或者工作机会等),但是机器并没有明显的需求意图,那么机器战胜人类只是一种偶然吗?

2.2 创新过程中的利益冲突

在当代,部分资本主义国家是以技术的使用价值为导向来引导创新的,这种创新的目的是增加产出效率,以达到最大价值和引导新机器的诞生,同时最小化甚至避开近期出现的技术问题,利用社会资源给技术使用者一种技术问题都将被新技术所解决的错觉。长此以往,技术使用者对新技术的不确定性和持续性危害的后果产生了忌惮和抵触情绪,这些情绪无形中给技术创新带来了阻力。田松在《科学的技术到底满足了谁的需求》一文中也提到了技术满足的是资本的需求,他指出在技术的发展过程中,技术“……都只是资本增值的副产品”[2],这种利益导向使技术的创新偏向工具理性,忽略了价值理性。对于技术使用者来说,他们恐慌的不仅仅是技术的负面效果,更多的影响是利益和风险分配不均。可以说在技术创新过程中,技术使用者和开发者的关系从未平等。正因为如此,技术利益分配也未平衡过,这种关系的扩大即形成了我们当今的社会。技术虽然没有直接影响社会层级和社会流动,但是在细分领域却侧面影响了社会的种种方面。因此创新过程首先需要解决的并不是技术风险所带来的直接影响,而是社会利益的分配等其他因素。

3 技术创新风险的认知性

我们需要对某些概念做一个界定,以梳理技术风险认知和创新之间的联系。首先是 “技术风险”和“技术危险”的区分。在Luhmann等看来,技术危险是存在于人类生活环境中的威胁人类生存的要素,而技术风险则是对这类要素的认知,Peter Timmerman则指出风险的含义是17世纪60年代由法语过渡到英语的词语,而在意大利语中对风险的概念则出现的更早,其意为“在危险的岩石间择路前进”[3]51,从词源的角度我们可以看出技术风险即包含了对危险的心理认知,而在我国翻译中在技术风险之后加上“认知”二字,是为了和“技术风险”相区分,并突现技术风险对人类思维的影响,同时,在词源中我们也看出,技术风险也暗含创新之意。

其次,在很多学者的研究中出现了“技术风险感知”一词,这里“感知”和“认知”的区别在于前者是技术个体对技术危险信息的感应,而后者是对技术危险的理性分析之后形成的判断机制。从这些区别中我们能看出,在技术创新进程中,人们的技术风险认知是人们是否接受技术创新的重要影响因子。在这一点上,因为社会利益等原因,在技术创新和技术风险的问题上,社会形成两派势力,一是技术受益者,二是技术使用者。

技术受益者需求的是技术使用者忽视技术风险,为了达到这个目的,技术受益者的方法是多种多样的。例如,利用媒介和公信力夸大技术收益,弱化技术风险。这其中不乏有技术专家的作用,在利益驱使下,技术专家的公信力也显得并不可靠。正如Merton所言“那些可以利用其受委托的角色谋取自己利益的专家,因而也最容易遇到可能的利益冲突”[4],技术使用者在社会化的过程中会形成自有的技术风险认知则更是一种感性认知。在形成判断机制的信息累积、思索、决策和考证阶段中,专家的涉及并不多见,在大多数情况下人们依赖的是直觉和经验。MarkCoeckelbergh认为,人们之所以难以接受技术风险是因为我们人类的想象能力:人们会把自己所处的世界认为是“所有可能性都会是最好的”[5]。正因为如此,人类的想象促使人类试图改善生存状况,而在人类的技术风险认知中,人类都是脆弱的,只有通过技术,人类才能弥补这个缺点,甚至如Plessner所言,人类需要技术才能作为人类来生存。

3.1 创新风险的社会放大

创新是一项对科学和技术的突破过程,该过程表现在科技的突现式的创造,“突现是对旧事物的革除或者否定”[6]。既然是对旧事物革除,那革除哪部分是有标准的,这个标准就是经验、科学和道德①根据维贝克的道德物化理论,技术创新物是负载了人们道德诉求的。的衍生物。人们的经验是经年累月的累积,在该过程中会受到来自不同个体的影响,这种影响会形成涟漪效应从而影响技术创新。

技术风险的社会放大理论认为与危险相关的事件会产生公众的技术风险认知相关的行为模式,这种行为模式反过来对社会经济产生次级影响,Renn等认为这种影响比会直接伤害更严重,正如社会学家迪尔凯姆断言的那样,在民族社会里拥有核武器的虚幻“敌人”在很长一段时间内会大程度地增强社会凝聚力,核工业的发展在“二战”之前和之后是不同的,尤其是经过了冷战的“铁幕”,美国和苏联双方几十万平民卷入“和平”的核试验伤害之后,所以,技术创新在技术风险产生之前和之后是不同的,技术风险的社会放大存在于特定的时间范围——技术风险显现之后,这一点是风险学家们并没有注意到的。

技术风险蔓延到意识层次并不是一个理想的状态,人们所处的环境并不相同,相互影响的技术风险认知只会让不同个体对技术的风险评估产生偏差,参与到技术创新中的参与者极容易被影响形成认知氛围。在这种环境中的人们难以从理性的角度思考技术风险,这就是我们所担心的,技术风险认知的蔓延影响了人们的认知观,这种影响比技术风险本身更难以消除。

3.2 创新风险的认知偏差

当代创新活动不仅使得技术日趋复杂,技术环境也变成了复杂系统。Charles Perrow认为风险是复杂系统中多个影响因子相互作用的情况下产生的。例如,当我想要参加一个重要会议,而第二天早上起来发现,车坏了。这个时候,偏偏平时关系最好的邻居不在家,公交公司的运作系统发生故障,要命的是想要预约出租车,但是出租车司机们今天恰好为了某种诉求集体罢工了。这个事件中,“我”和“会议”是一种线性目标关系,为了达到参加会议这个目的,我需要用到这个系统中的任何一个因素,但是当复杂系统中的因素在使用的关键时刻出现问题,包括替代措施,那么作为主体的我所处的系统就会认为其中所有涉及的因素都是存在风险的。在这个例子中我们可以看到,在个体的技术风险认知上存在着下列偏差:(1)事实和伪事实难以区分。例如,遇到上述例子中的个体会认为系统中所有技术都存在风险,而如果有人在某个技术上遇到了挫折,其他替代措施没有出现问题,那这个人会认为某个技术是存在风险的。那么从事实上来讲,该技术是否存在风险呢?(2)技术风险责任主体不清。技术从开发到使用,历经了从设计到操作的过程,造成风险很难判断是设计失误还是操作不当。(3)技术风险评估的错觉。在例子中最直观的一点是,人们根据直觉判断技术风险。个体在难以得到专家经验和大数据等理性支持的条件下,凭借直觉是对技术风险认知的主要途径,所以出现认知错觉变得可预见又难以解决了。这种错误的技术风险认知是不足以支撑人们对技术有足够的信心加入技术创新的活动中,虽然当今人们无法离开技术世界,甚至更确切地说是依赖于技术,但是这些偏差的认知阻碍了技术创新。

4 技术创新风险的定责性

社会是人类启发、创造、适应、同化、摒弃、再创造各种技术的土壤,伴随着社会发展,技术也不停地更迭递进。今天的人们很难想象19世纪以前的人们使用的技术大多数是自己生产的,因此那个时代的人们有足够的能力修理,“甚至凭空创造出他们赖以生存的所有工具和技术”[3]。与19世纪以前不同的是,技术的复杂性和多功能性使得当今技术是许多个体共同创新劳动的结果,技术甚至已经不能由创新的个体单独来解释,甚至遇到技术风险也不能由个人来修复了。换句话说,我们今天使用的新技术几乎找不到确切有关的人或者组织,因此人类的技术控制力下降了。尤其是世界经济走向一体化之后,各国之间的技术合作变得越来越频繁,这样,人们最大化地利用本土化的技术优势使得技术生产的效率大大提升。然而隐藏在其背后的问题则是技术责任难以确定主体,谁也无法对复杂技术产生的问题单方面负责任,例如飞机、航天器、火车等。

在创新实践过程中,大多数时候创新主体由企业或者个人承担,然而技术责任却总是嵌入负责任网络中的,这其中技术风险也需要根据不同主体来界定。近年来在欧洲发起一场针对创新设计阶段的伦理考量,即负责任创新。负责任创新理论认为很多技术问题应该在技术的设计过程中考虑到并解决。例如,在生产纸张的时候把废弃的纸张处理问题考虑进去等。在创新的过程中作为创新的主体不仅要迎合社会需要、参与者的需要,而且要考虑伦理、环境和社会,为了达到这个目的就需要更多的利益相关者(包括社会公众)的参与。

在英文中,利益相关者是“stakeholder”,根据《牛津英语大词典》的解释,stakeholder的原意是赌桌上拿着筹码的人,后引申为利益相关者。从词源上我们可以看出,利益相关者在最早是承担风险的人,那么利益相关者承担的是什么风险呢?

4.1 利益相关者的创新风险界定

首先利益相关者承担的是组织风险。在创新设计阶段来自不同群体的利益相关者所代表的是所在群体的利益诉求,为了实现这个目的,利益相关者代表组织将该诉求加入技术设计当中,我们可以看出这种组织风险转移到技术中也会带来新的问题。例如,近年来新能源汽车的普及使得充电桩的需求上升,然而在城市和高速公路周围却很难看到充电桩,为了填补这个需求,很多城市在周边设计了专门的充电站,然而随着经济下行,很多充电站在投放后却面临着长期亏损的状况。

其次利益相关者承担道德风险。早在20世纪初,很多技术哲学家就提到技术物的创新设计应该存在道德规范,例如技术哲学家拉图尔、阿特胡斯等。最终,荷兰技术哲学家Peter-PaulVerbeek将前者研究整合并建构出一个完整的“道德物化”理论。道德物化的理念是将道德嵌入技术设计中,使技术物不仅拥有常规的使用功能,更能起到规范使用者道德的作用。这种道德物化的理念在近几年应用甚广,不可否认的是该理念也是把本该是社会规范的道德理念转移到技术当中。作为利益相关者的参与,这种道德思想的嵌入如果造成技术危险,是归责于利益相关者还是技术还没有一个合理定责机制。

4.2 创新行为中的风险属性界定

上述所列举的风险都会通过技术设计来转移到技术当中,而且最终都成为技术的潜在风险。因此我们说,创新的过程,即使是负责任创新,也是一种将其他风险转移到技术的过程。

在此我们也要考虑到,负责任创新在当下还面临着诸多亟待解决的问题:公众参与的团体组成应该是什么样的?怎么让政府责任和民主代表之间在共同利益层面达成一致?在设计过程中如果有技术风险难以解决该不该继续创新?这些问题的存在使得创新也面临着复杂的局面。事实上,在负责任创新的行动中,技术风险管理者是必不可少的,因为在利益相关者群体中最中心的问题是技术收益和风险分配问题,而技术风险管理者的主要职责是评估技术风险并分配技术收益,平复在技术评估的过程中所存在的争端。Covello和Merkhoher认为,风险评估是指系统地描述和量化有风险的技术过程、行为或者事件,在技术活动中,包括负责任创新参与的技术活动,不可避免地会导致难以预料的后果,因此,即使是由私有个体来实践技术创新,人们也希望政府为此达到风险可控的结果。为了达到在技术创新的过程中行之有效地评估技术风险,首先需要认识到两点:第一,技术风险是可见的或可计算的;第二,个体的技术风险认知是理性的①该处的理性是指相比较直觉判断而言。。前者依据的是客观因,是可量化的,该风险包含了复杂的数据分析和可能性,因此需要尝试用客观的方式权衡潜在利益和潜在危害;后者的依据则是主观因,其描述的是人们如何看待风险,就像Jasanoff所说,风险的意义在不同文化里是不同的,我们应该考虑到“我们处于什么样的环境下”[7]。在鼓励创新的机制和环境下,主观因素往往是在负责任创新中占主动的。

5 技术创新风险的耦合性

单从技术风险的界定上来看,技术的发展是多功能化和复杂化,增加的技术元素形成的技术功能却并不能达到所有期待价值。例如,手机的众多功能里,用户能利用的只有几种,为了吸引用户,技术开发者增加的功能所达到的只是技术开发者的经济利益,用户却要承担更多的技术风险。为了减少这种风险,人们需要的是减少无用功能,而正因为这样,技术创新如果看作一个发展过程的话,那么技术创新就是一个从问题到问题的区间发展物,创新发展到一定程度无疑会踏入技术风险的领域。

因此,虽然技术创新和技术风险是两个不同的概念,并遵循着不同的发展方向,但是在现实生活中两者又相互转化难以区分。例如,在医疗使用上,人造血液在很多情况下能挽救病人的生命,但是人造血液毕竟是一种技术替代物,在临床中专家们发现人造血液并不具备人体内血液那样的免疫能力。在哲学家们看来,改变人类自身的器官等的技术活动都是危险的,这里需要引入哈贝马斯的观点,他认为生物技术造就了一个状况,即“我是什么和我把自己做成了什么之间的界限消失了”[8],生物技术提高了人类的存活率是以改变自然身体为前提,通过技术将人类一部分改造为机器,这也是哲学家们所担心的。因此,我们需要考虑的是技术的创新是否需要给予一个限定范围。

在技术创新和风险的界定上,有一个至关重要的影响因子,这个影响因子就是价值。在技术中立论学者们看来,技术是将自然物物化为人造物,因此技术并不涉及善恶问题。这个观点受到了很多学者的质疑,他们认为,虽然技术是不涉及善恶,但是技术创新的目的却有所不同。因此,技术创新之所以会变化为技术风险,其中主要原因是工具理性的存在。早在19世纪,德国社会学家MaxWeber提出了合理性概念,他将社会行为分为四类,即目的合理性行为、价值合理性行为、情感行为和传统行为。MaxWeber的工具理性和价值理性是从主体的目的论角度的判断,其中,工具理性是资本目的性,价值理性是道德目的性。因此,想要给技术创新和技术风险划界,就需要把技术创新的工具理性搁置一边,单从道德角度才可以进行区分。我们认为当下的技术创新要基于三点目标:满足大多数人类需要、促进社会发展、不损害自然和人文环境。就上述例子而言,人造血液的出现将人类的死亡率大大降低,又在当前社会发展过程中不损害自然和人文环境,即使在一些哲学家们看来这种创新即是技术风险,但就人类的发展来看,这种技术创新是值得鼓励的。

6 结论

正如Merton所说,文明是“经验知识和科学知识的总体以及在每一个社会中控制人与自然的技术手段的集合所组成”[1],技术专家和企业作为拥有大量科学知识的群体所代表的是社会中的“科学知识”,其他利益相关者则是通过经验来参与到创新活动中,他们代表了文明中的“经验知识”。而技术手段需要这两者的参与,无独有偶的是负责任创新学者和风险学者们都倡导增加普通公众的参与度,正因为如此,增加的利益相关者使得负责任创新的主体责任多元而复杂,创新过程的主体和技术环境的复杂使得在创新活动中,技术风险始终伴随其左右,技术风险既推动技术创新活动,又在社会中形成技术威胁的认知氛围,在一定层面上让技术创新面临重重阻碍。本文梳理了技术创新与风险之间千丝万缕的联系,并尝试通过该研究提出创新的可接受范围,得出了创新活动是其他风险的技术转移这一结论。

[1] R.K.默顿.十七世纪英格兰的科学技术与社会[M].范岱年,等,译.北京:商务印书馆,2007:239-262.

[2] 田松.稻香园新笔之六:科学的技术到底满足了谁的需求[J].博览群书,2008(7):51.

[3] 尼克·皮金,罗杰·E.卡斯帕森,保罗·斯洛维奇.风险的社会放大[M].谭宏凯,译.北京:中国劳动社会保障出版社,2016:51-52.

[4] R.K.默顿.科学社会学[M].鲁旭东,林聚任,译.北京:商务印书馆,2010:676.

[5] Coeckelbergh M.Human Being@Risk:Enhancement,Technology,and the Evaluation of Vulnerability Transformations[M].Berlin:Springer Publishing,2013.

[6] 傅世侠,罗玲玲.创造力方法论[M].北京:中国经济出版社,2000:55.

[7] Jasanoff S.Technologies of humility:Citizen participation in governing science[J].Minerva,2003,41(3):223-244.

[8] Habermas J.The Future of Human Nature[M].Malden:Blackwell Publishing,2003:12.