基于差分定位与光流特征提取的微表情识别

许 刚 赵中原 谈元鹏

(华北电力大学电气与电子工程学院 北京 102206)

基于差分定位与光流特征提取的微表情识别

许 刚 赵中原 谈元鹏

(华北电力大学电气与电子工程学院 北京 102206)

针对现有微表情识别算法中特征提取冗余、处理时间长的问题,提出基于差分定位与光流特征提取的微表情识别方法。首先对人脸的表情敏感部位进行图像序列差分,通过差分投影值划定人脸运动区域,计算运动区域光流分析数据的主成分特征,最后利用支持向量机判断脸部运动单元编号,识别微表情的类别。实验结果表明,该方法较之于传统识别技术在微表情识别效率与准确度上有显著提升。

微表情识别 光流分析 图像差分 主成分分析 面部行为编码系统

0 引 言

不同于普通表情,微表情通常具有表情强度低、表情速度快的特点,持续时间在1/25~1/5秒间。微表情往往反映人真实的情感变化,基于这一特点,微表情研究开始受到诸如医学临床、安全保障、谎言识别、人工智能以及政治心理学等各个方面的专家学者的高度关注[1]。

微表情与传统表情识别一样,特征提取是它的关键环节。微表情自动识别研究初期采用差分[2]、应变模式[3]、Gabor[4]等传统表情识别特征提取算法,然而由于微表情与普通表情在图像细节纹理方面差异很大,传统表情识别技术在微表情识别方面的应用效果并不见佳[5]。Shreve等人将光流分析引入微表情识别[6],能够实现对面部细微变化的捕捉与提取。但是其算法设计复杂、运算量大,所提取的表情特征冗余度较高,缺乏针对性,致使计算处理时间过长,同时非必要特征对后续分类造成干扰。

本文提出了一种基于差分定位与光流特征提取的微表情识别算法,首先借助图像差分划定脸部运动区域;而后对脸部运动区域进行光流分析并通过主成分分析PCA提取局部运动特征;最后借助支持向量机SVM进行微表情分类。实验结果分析表明,算法在识别效率与准确度上都有一定提升,提升了微表情自动识别水平。

1 差分定位

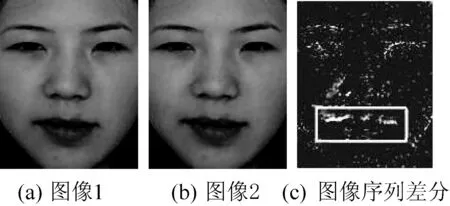

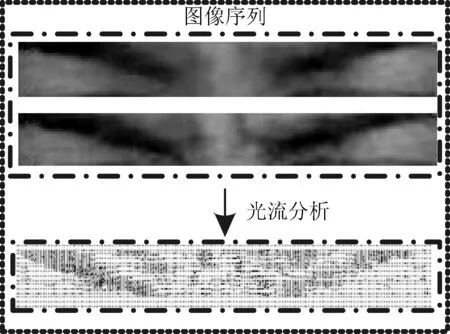

图像差分通过顺序图像灰度值绝对差的求取,突出图像序列中的变化区域。如图1(a)、图1(b)所示的两幅图为一个微表情序列,两幅人脸图像之间的差异很小,单凭肉眼甚至无法分辨。而在图1(c)的图像差分结果中,人物嘴角运动被明显突出。

图1 微表情图像序列与差分

在图像差分的基础上,通过投影阈值的判断实现运动区域定位。算法具体实现过程分为以下四步:

(1) 设Kl(t)∈pl*ql为灰度图像序列l在时刻t的灰度矩阵(pl×ql为图像序列l灰度矩阵大小)。对不同时刻图像序列l灰度矩阵进行差分处理,取差分绝对值,获得:

(1)

(2)

(3)

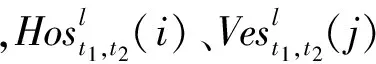

图2 图像差分投影

(3) 显著性阈值判断:在算法训练阶段,对图像序列l的差分投影设定阈值Vel(垂直方向)和Hol(水平方向),阈值设定根据图像各敏感部位的差分平均值自适应变化。在阈值的训练阶段,通过人工处理训练样本确定阈值的基值和一个以差分矩阵平均值为系数的浮动变量。在算法识别阶段,统计达到阈值的投影点数vel、hol,根据投影点数判定图像序列l是否发生运动。

(4) 运动区域定位:如果判定图像序列l发生运动,通过差分投影值进一步划定运动区域。首先对水平方向投影值从左向右扫描,至kl点满足式(4)、式(5):

(4)

(5)

即满足kl点值与其后五点平均值都大于阈值Hol,则令leftl=kl。同理,从投影值右端向左扫描获得横向右终止点rightl,对垂直方向投影值重复上述操作并获得纵向起、止点topl、bottoml,由这四点所对应的横纵轴围成运动区域El(t1,t2)。差分定位算法能够获得准确的图像运动区域,进一步采用光流特征提取算法获得区域运动特征。

2 光流特征提取

2.1 图像序列光流分析

光流法以顺序图像中像素的时空相关性为基础,通过计算物体的运动场获取图像运动特征。针对图像序列El(t1,t2),设图像上的点(x,y)在时刻t的灰度为el(x,y,t),用u(x,y)和v(x,y)表示光流在该点的水平和垂直移动分量:

(6)

经过间隔Δt后对应点为:

el(x+Δx,y+Δy,t+Δt)

(7)

根据图像灰度一致性假设以及相邻点具有相同运动速度的条件,建立光流值求取目标方程:

(9)

2.2 光流数据特征提取

通过光流分析获取的图像运动特征,维数高、数据冗余。PCA变换能够降低数据维度[7],具体处理包括:

(1) 数据训练环节:建立数据空间特征基底。首先,每个训练样本的矩阵数据向量化,即矩阵按列依次排列构成向量。定义cov(xa,xb)为样本a与样本b所生成向量的协方差,则对nu个样本计算协方差矩阵:

(10)

(2) 数据识别环节:基底系数特征提取。将待识别样本数据y向基底空间映射:

(11)

其中i∈[1,s],从而求取数据y映射到各特征基底的对应系数KeyEl(t1,t2)={k1,k2,…,ks},用基底系数作为光流分析的特征值。

3 微表情识别算法流程

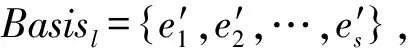

差分定位与光流特征提取算法实现图像运动区域的定位和区域特征的提取,是微表情识别的核心。以此为基础提出的算法流程如图3所示,主要包括四个步骤:图像预处理、敏感部位划分与运动区域定位、光流分析与PCA特征提取、SVM运动单元分类[8]。其中后面三步需要通过训练样本训练设定识别流程中的运动区域阈值、光流数据主成分基底、SVM分类器参数等。

图3 微表情识别算法流程图

微表情识别算法流程具体如下:

在全面清理排查、实施分类处置的同时,省厅进一步完善工作机制,探索土地管理长效机制,包括优化新增计划管理、严格出让管理,强化合同履约管理、规范闲置土地处置等等。

第一步 在图像数据预处理环节,针对输入的不同尺寸RGB彩色人脸图像序列,将图像序列转化为灰度图像并采用双三次插值法对脸部图像序列进行尺寸归一化。

第二步 在敏感部位划分与运动区域定位环节,以尺寸归一化的灰度人脸图像序列为输入,按照面部行为编码系统理论对人脸图像进行划分[9],将人脸图像划分为不同的表情敏感部位。设集合L={1,…,l,…,N},对∀l∈L,表征面部表情敏感部位,如眉毛、嘴唇、嘴角、鼻梁、眼睛等。按照不同的表情敏感部位截取人脸图像区域构成子图像序列,在各子图像序列中进行差分定位处理,从而获得显著性敏感部位的运动区域。这一步骤实现人脸表情位置的准确定位,缩小后续步骤的待处理数据量。

第三步 在光流分析与PCA特征提取环节,以上一步获取的运动区域图像序列为输入,通过尺寸归一化,对归一化图像序列进行光流分析。通过PCA特征提取光流特征:为不同表情敏感部位的运动区域分别建立特征基底,并在识别流程中选择对应基底求取特征值。

第四步 在SVM分类输出环节,提出以运动单元AU编号分类为基础的表情识别。首先判断脸部运动区域的运动形式:通过面部行为编码系统理论为图像序列编码,获得脸部AU编号,并借助表情、AU编号公式推导人物微表情[10]。为每个表情敏感部位设定单独的分类器,将不同表情敏感部位的光流主成分特征作为输入,将与表情敏感部位所涉AU编号一一对应的[0,1]向量作为输出。SVM训练流程中,将训练样本的PCA基底系数与AU编号作为输入;SVM识别流程中,提取脸部单元运动特征,将PCA处理获取的基底系数KeyEl′(t1,t2)作为脸部单位运动特征输入SVM,获得脸部的AU编号,实现微表情分类。

4 实验与分析

4.1 实验数据

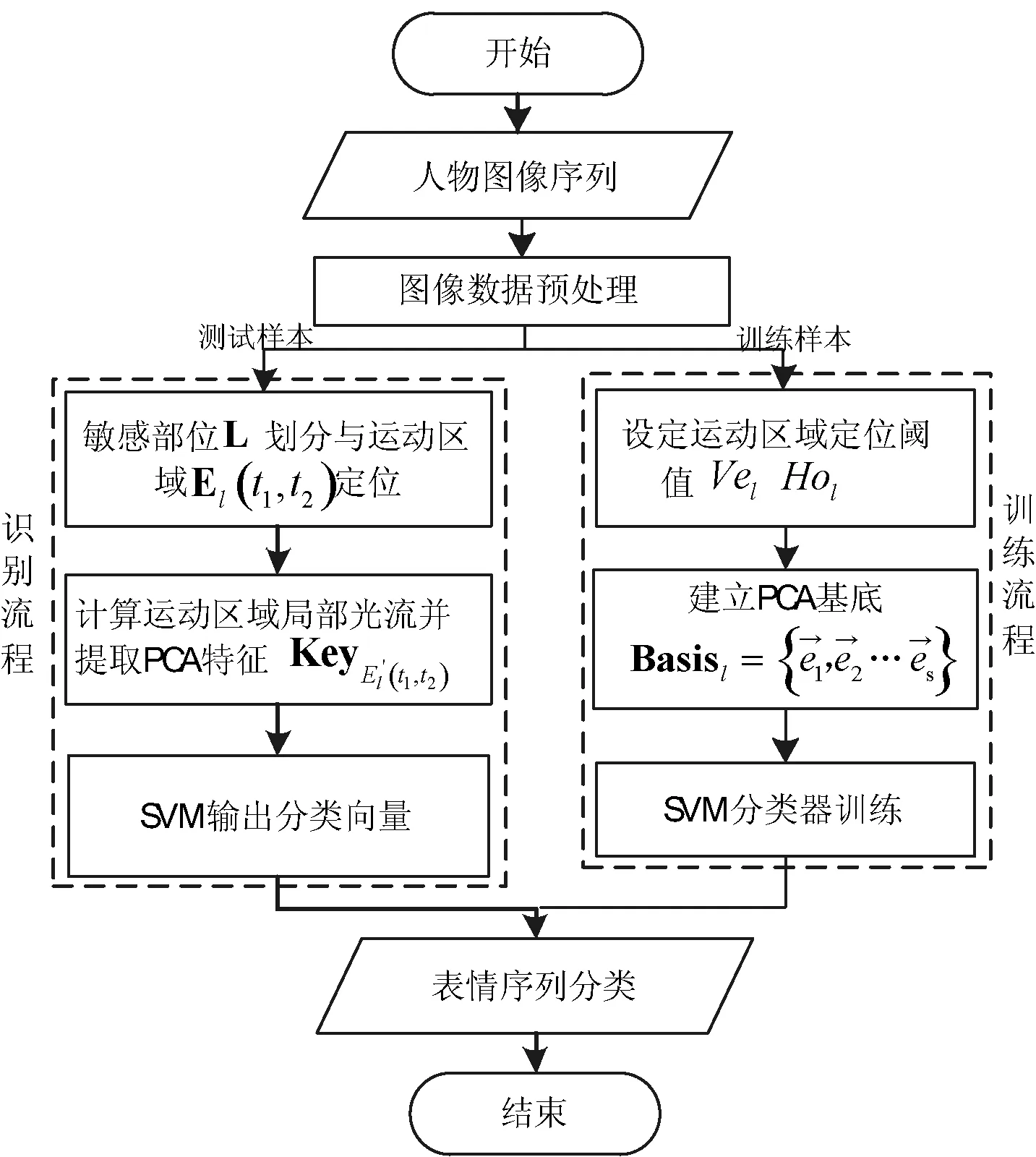

本文实验数据库采用了中国科学院心理研究所建立的微表情数据库CASME[11]。该数据库采用60 fps帧率、1280×720分辨率摄像机记录测试员微表情,对视频剪裁、编码并建立微表情分类数据。本文所有仿真实验均使用Intel(R) Core(TM)2-T9600 CPU @2.80 GHz处理器在MATLAB 2012a环境下进行。根据数据库所含样本及其数量,从数据库中选取五类表情、九类AU编号组合,如表1所示。

表1 实验表情数据分类

表1描述实验数据中各表情类别与运动单元组合的关系及各运动单元编号组合的数量,以Disgust表情为例,其涉及脸部AU编号组合包括AU4与AU9组合、AU9组合,两类编号组合对应样本数量分别为15、15。图4为表1中不同运动单元组合的图像差分,运动单元编号不同,脸部发生运动的区域也有所差异,各AU编号所对应脸部区域如图4中方框所示。

图4 运动单元组合图像差分结果

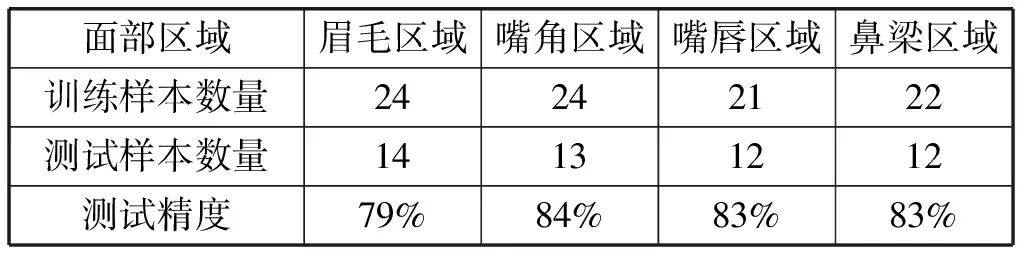

实验中,表情敏感部位包括眉毛、嘴角、嘴唇和鼻梁四个部分,单一人脸部位的运动单元编号数量最多为3,情绪分类数量最多为3。实验选取微表情数据库中人物的无表情帧与微表情帧,通过对两帧数据的处理,提取图像间的运动特征,实现微表情分类。

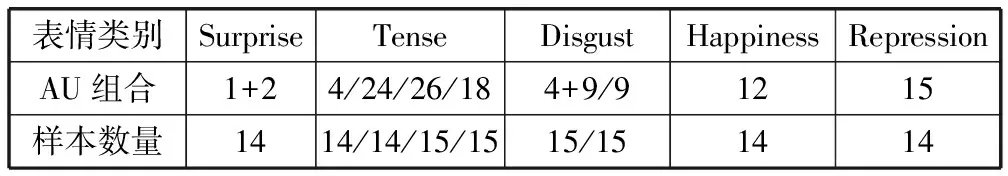

4.2 实验过程

实验流程包括:首先,通过预处理获取尺寸归一的灰度图像序列。其次,在脸部灰度图像划分的各表情敏感部位差分定位。图5(a)方框为眉毛图像的差分定位结果,图5(b)为对应运动区域图像。差分定位算法实现了表情位置的准确选取,缩小待处理数据量。

图5 脸部运动区域定位

然后对脸部运动区域进行光流分析与PCA特征提取。图6为AU4样本眉毛运动区域的光流分析,数据显示这一部位具有向下运动的趋势。

图6 AU4图像光流分析

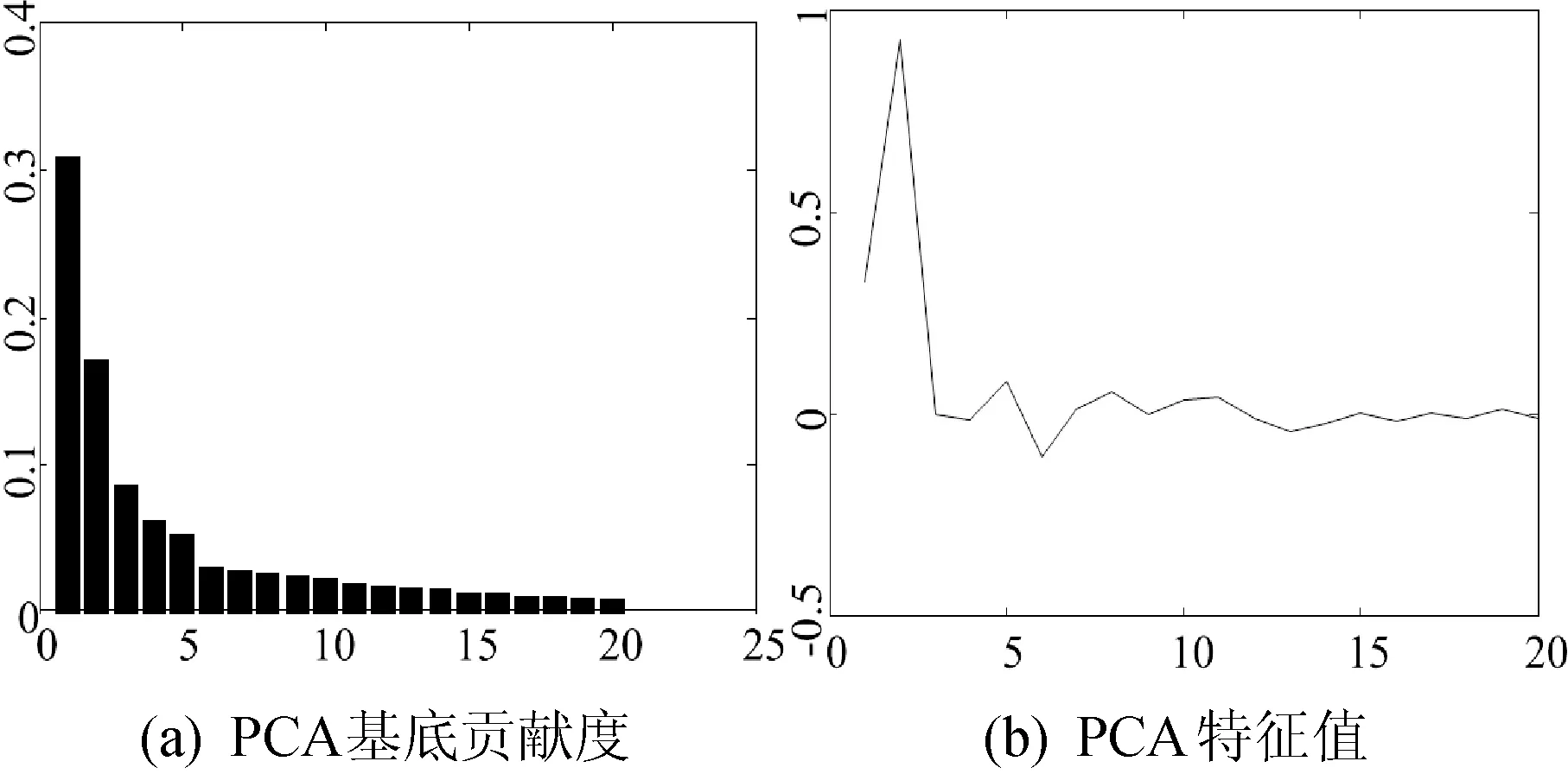

在PCA特征提取中,基底选择特征值大小前20所对应的特征向量。图7(a)为眉毛区域PCA基底的各特征向量贡献度,所选特征向量合计贡献度达95%以上;图7(b)为AU4样本光流分析的PCA特征值。

图7 PCA基底与特征值

将光流分析的PCA特征值作为SVM输入,获得脸部AU编号,通过AU编号表情公式识别微表情[10]。

4.3 实验分析

实验处理中,对不同面部区域分别进行特征提取与SVM分类训练。各区域训练样本、测试样本数量及识别准确率如表2所示,眉毛、嘴角等区域识别率在79%~84%,总体稳定。

表2 实验分区数据

实验同时对比分析另外两种微表情分类方法:(1)差分投影算法:直接将脸部区域图像差分的水平、垂直投影作为特征进行微表情分类;(2)全局光流算法:对整个人脸图像序列直接进行光流分析和特征提取,实现微表情识别。表3为实验结果对比数据。

表3 实验结果对比

其中,差分投影算法计算简单,它与运动区域光流算法一样均通过判断不同脸部区域的运动形式实现表情分类,单个输入区域的最大分类数为3。但算法特征提取不完整,分类效果不好,识别率仅为33%。

运动区域光流算法是全局光流算法的改进。相比后者,前者通过准确定位运动区域,缩小处理范围,提高处理效率,降低分类难度且避免了脸部非重要部位的影响。算法识别率达82%,计算平均时间降至0.291s。

5 结 语

微表情是人类心理活动的下意识动作,反映人物内心的真实变化,它具有表情强度低、表情速度快的特点。据此提出基于差分定位与光流特征提取的微表情识别方法,依据面部行为编码系统理论将人脸划分为不同的表情敏感部位;并对表情敏感部位的图像序列进行差分,从而确定脸部的运动区域并计算其光流分析数据的主成分特征;最后利用支持向量机实现脸部AU编号分类和微表情识别。实验结果表明,在微表情识别效率与准确度上,该方法较之于传统识别技术有显著提升。

[1] 贲晛烨,杨明强,张鹏,等.微表情自动识别综述[J].计算机辅助设计与图形学学报,2014,26(9):1385-1395.

[2] 夏海英,徐鲁辉.基于主动形状模型差分纹理和局部方向模式特征融合的人脸表情识别[J].计算机应用,2015,35(3):783-786,796.

[3] Shreve M,Godavarthy S,Manohar V,et al.Towards macro-and micro-expression spotting in video using strain patterns[C]//Applications of Computer Vision (WACV),2009 Workshop on.IEEE,2009:1-6.

[4] She X B,Wu Q,Fu X L.Effects of the duration of expressions on the recognition of micro expressions [J].Journal of Zhejiang University-SCIENCE B(Biomedicine and Biotechnology),2012,13(3):221-230.

[5] Wu Q,Shen X,Fu X.The machine knows what you are hiding:an automatic micro-expression recognition system [C]//Affective Computing and Intelligent Interaction.Springer Berlin Heidelberg,2011:152-162.

[6] Shreve M,Godavarthy S,Goldgof D,et al.Macro-and micro-expression spotting in long videos using spatio-temporal strain [C]// 2011 IEEE International Conference on Automatic Face and Gesture Recognition and Workshops (FG 2011),2011:51-56.

[7] 徐艳,陈孝威.基于差分图像和PCA主元分析的人脸检测[J].计算机应用与软件,2008,25(8):229-230,273.

[8] 曾梦璐,王晅,石林枫,等.基于 Contourlet-NMF和 SVM 的近红外人脸识别方法[J].计算机应用与软件,2014,31(12):229-232.

[9] Ekman P,Rosenberg E L.What the face reveals:Basic and applied studies of spontaneous expression using the Facial Action Coding System (FACS)[M].New York:Oxford University Press,1997:1-130.

[10] Ekman P.Telling Lies:Clues to Deceit in the Marketplace,Politics,and Marriage (Revised Edition)[M].New York:WW Norton & Company,2009:132-161.

[11] Yan W J,Wu Q,Liu Y J,et al.CASME database:a dataset of spontaneous micro-expressions collected from neutralized faces[C]// 2013 IEEE International Conference and Workshops on Automatic Face and Gesture Recognition (FG),2013:1-7.

MICRO EXPRESSION RECOGNITION BASED ON DIFFERENTIAL POSITIONING AND OPTICAL FLOW FEATURE EXTRACTION

Xu Gang Zhao Zhongyuan Tan Yuanpeng

(SchoolofElectricalandElectronicEngineering,NorthChinaElectricPowerUniversity,Beijing102206,China)

Existing micro expression recognition algorithm has the problems of redundancy in extracting feature and long processing time.In view of this,we proposed a micro expression recognition method which is based on differential positioning and optical flow feature extraction.First,it applies image sequence difference on sensitive parts of facial expression,delimits motion area on face by differential projection value.Then it calculates principal component feature of optical flow analysis data in motion area.Finally,it uses support vector machine to determine the number of facial movement unit and recognises the category of micro expression.Experimental results showed that compared with conventional recognition technology,this algorithm has significant improvement on efficiency and accuracy of micro expression recognition.

Micro expression recognition Optical flow analysis Image difference Principle component analysis Facial action coding system

2015-08-09。中央高校基本科研业务费专项项目(2015XS17)。许刚,教授,主研领域:电子信息技术,模式识别。赵中原,硕士生,谈元鹏,博士生。

TP391.41

A

10.3969/j.issn.1000-386x.2017.01.030