顾及纹理特征的航空影像自适应密集匹配方法

朱 庆,陈崇泰,胡 翰,丁雨淋

1. 西南交通大学地球科学与环境工程学院,四川 成都 611756; 2. 西南交通大学高速铁路运营安全空间信息技术国家地方联合工程实验室,四川 成都 611756; 3. 香港理工大学土地测量与地理资讯学系,香港 999077; 4. 香港中文大学太空与地球信息科学研究所,香港 999077; 5. 深圳市数字城市工程研究中心,广东 深圳 518034

顾及纹理特征的航空影像自适应密集匹配方法

朱 庆1,2,陈崇泰1,5,胡 翰1,3,丁雨淋1,4

1. 西南交通大学地球科学与环境工程学院,四川 成都 611756; 2. 西南交通大学高速铁路运营安全空间信息技术国家地方联合工程实验室,四川 成都 611756; 3. 香港理工大学土地测量与地理资讯学系,香港 999077; 4. 香港中文大学太空与地球信息科学研究所,香港 999077; 5. 深圳市数字城市工程研究中心,广东 深圳 518034

半全局匹配实质是在视差连续性假设下的离散优化方法。为克服视差断裂带影响,依赖一组参数控制视差不一致性。若参数过小,在平面内难以保证视差连续性,产生明显噪声,导致凹凸不平现象;若参数过大,将致使物体表面过于平滑,难以保留视差断裂等重要特征。为克服上述问题,本文提出了一种顾及纹理特征的自适应密集匹配方法:首先,检测影像纹理特征并定量表达纹理丰富性程度;其次,依据纹理丰富程度与视差差异存在正相关的规则知识,实现匹配参数依据纹理信息的自适应选择;最后,采用上述参数进行自适应的半全局匹配。通过ISPRS基准数据集和国产SWDC-5获取的倾斜影像进行试验分析证明,本文方法能够有效减少低纹理区域匹配噪声,同时更有效保留边缘特征。

影像密集匹配;半全局匹配;纹理特征;自适应方法

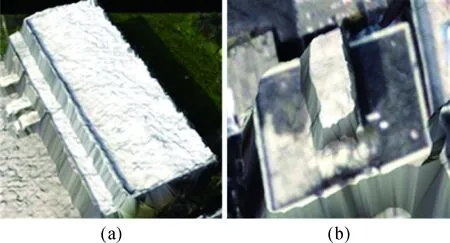

航空影像密集匹配点云,由于其具有色彩、纹理信息,并且点云密度高,已成为三维城市重建的重要数据源[1-2]。特别是随着半全局匹配算法(semi-global matching,SGM)[3]的出现与发展,SGM以其高效、快速的特点,已被广泛用于商用摄影测量软件[4]。然而,影像密集匹配质量受物体遮挡、视差断裂、影像噪声、纹理缺乏以及光照条件不一致等因素影响,在实际应用中,点云粗糙、缺漏、无法保留边缘线等现象明显[5-6],如图1所示。

图1 密集匹配点云噪声及边缘缺失问题Fig.1 Noise and losses of edge problems of point cloud from dense matching

影像密集匹配主要包含4个主要步骤[5]:匹配代价计算、代价聚合、视差计算和视差优化。针对以上步骤,目前主要有两种不同的策略:①局部方法,其视差计算仅依赖于局部信息,因此为提高可靠性通常采用点、线等匹配基元进行多视影像匹配[6-10],其最终结果通常也呈现为准密集匹配(quasidense)点;②全局方法[11-13],在进行核线纠正之后,通过构建合适的能量函数,将密集匹配转化为在视差连续性约束下的离散优化问题,此策略不仅效率更高,且点云密度更大,Middlebury基准测试中性能较为优异的算法[11,13]均属于此类。通常全局优化问题可以通过马尔可夫随机场(Markov random field,MRF)表达,MRF中似然概率(likelihood term)表达匹配代价的损失值,而先验概率(priori term)则表达视差连续性、遮挡等关系的损失值[12]。

事实上,上述MRF模型邻域为二维影像,该优化问题是NP完全的(NP-complete),虽然存在一些近似优化方法,如图割(graph cut,GC)[13]、置信度传播(loopy belief propagation,LBP)[12]等,然而其计算效率仍然较低,对大规模航空影像并不适用。不同于MRF,动态规划则对单一扫描线进行优化,能在多项式时间内达到全局解[5],因此动态规划也被广泛应用于稀疏的特征点、线匹配[14-15]和密集匹配之中[16]。不过正因动态规划算法的一维特性,不同扫描线之间断层现象明显。为克服上述问题,SGM[3]将单一扫描线的动态规划,推广为16方向,从而近似地表达全局关系,并在动态规划之中同时引入视差连续性约束。另一方面,由于SGM算法不需复杂的优化算法,易于硬件实现,随着通用图形处理器(general purpose graphics processing unit,GPGPU)技术的发展,SGM也被广泛应用于GPU实现,相对CPU算法,速率能提高10倍以上[17]。正由于其较高效率,SGM被广泛应用于航空影像,生成密集匹配点云[18-20]。

然而,无论采用MRF或动态规划进行全局优化,都依赖于一系列参数控制连续性约束权重,如GC[13]采用单一参数λ和SGM采用双参数P1和P2[3]。该参数的选择对最终的匹配结果有较大影响:若参数过大,将导致无法保持建筑物边缘等重要断裂线特征;反之,在平滑区域会产生噪声,造成凹凸不平现象。传统方法对一景立体像对均采用相同参数,然而对于航空影像,地物种类错综复杂,视差范围变化较大,同一参数难以适应不同的地物条件,降低匹配点云质量。文献[4]已指出,在密集匹配过程中可顾及影像灰度、纹理信息调整匹配参数,提高对不同地形条件的自适应能力。传统SGM算法[3]的参数P2会随梯度变化改变,而SURE[20]则采用Canny算子检测边缘自适应调整参数。上述自适应方法可一定程度缓解上述问题,但仍对影像灰度噪声敏感。

鉴于单一匹配参数存在的问题,本文提出一种顾及纹理特征的立体影像自适应密集匹配方法。该方法在纹理丰富程度与视差连续性变化存在相关性的知识约束下,首先,通过纹理检测算法定量表达影像纹理特征;其次,利用影像的纹理特性,建立纹理特征与匹配参数之间逐像素的对应关系,实现匹配参数的自适应选择;最后,依据上述影像相关的匹配参数,实现自适应的半全局匹配,同时降低低纹理区域点云噪声并保留边缘断裂特征。

1 方法

1.1 基本原理

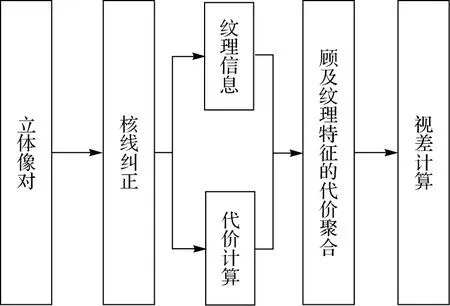

由于SGM已被大量实际应用证明具有优于其他方法的匹配性能[4,18],因此本文也采用SGM算法,并做出相应改进,本文提出方法的整体流程如图2所示。首先生成核线影像对,然后计算匹配代价并提取纹理信息,代价聚合过程中依据纹理信息自适应调整匹配参数,最后生成视差图。

图2 纹理感知SGM算法流程Fig.2 Flow chart of the texture aware SGM algorithm

由于核线关系将同名点约束在同一直线上,因此影像匹配通常定义在视差空间之中,仅优化每个像素的视差值。实际应用中,预先对影像进行水平核线纠正,其整体算法效率较动态核线更高,因此本文预先对影像进行核线纠正处理[21]。在代价计算中,由于census变换也可近似看作是一种单像素的匹配代价,同时具有优异的匹配性能和计算效率,在与单像素代价的对比中也具有优异性能[22],被广泛应用于密集匹配算法当中[23-26],因此本文采用9×7窗口内的census变换作为匹配代价。具体实现中仅需存储对应核线影像的64位census编码,而作为匹配代价的汉明距离[22]则可采用SSE指令实时计算。

SGM采用了多路径动态规划方法,单个方向的聚合公式如下所示[3]

(1)

式中,Lr(p,d)表示像素p沿路径r的匹配代价,d为视差;Lr(p-r,d)表示当前路径r上p的前一个点的匹配代价;P1是前后像素点视差差异为1时的惩罚参数,P2是视差差异大于1时的惩罚参数。同时,P2根据前后像素点的灰度梯度自适应调整,并确保P2>P1。

参数P1、P2的选择对最终匹配结果有较大影响,其大小决定视差图的平滑程度。当参数较大时,视差平滑,但在视差断裂区域无法保留边缘细节;反之若参数过小,匹配代价权重增大,可能因影像噪声导致视差粗糙。由于地物错综复杂,仅依靠梯度自适应调整参数难以顾及复杂的视差变化,因此本文通过分析核线影像的纹理信息,使参数P1、P2随纹理信息自适应调整:在纹理缺乏区域施加较大视差连续性约束;而在纹理丰富区域,保留更大的匹配代价权重,以保留边缘信息。

1.2 纹理信息提取方法

纹理特指影像上色调变化的频率,实质上也可反映影像的细部特征[27]。纹理感知的自适应密集匹配方法的根本前提是,影像色调、灰度信息变化频率与对应视差图的变化频率存在正比例关系。低纹理对应变化频率较低区域,因此可采用较大平滑性约束。反之,纹理丰富区域,则需采用较小平滑性约束,以保留边缘结构处的视差突变。

为定量表达上述色调变化的频率大小,可采用不同方向、不同尺度的滤波器[27],影像信息熵[28]等方法检测。自适应密集匹配算法均利用物体边缘(contour)会产生视差断裂的先验知识,因此在物体边缘处调整连续性约束参数(P1,P2)大小。已有方法通常仅利用梯度信息获取物体边缘,然而此类方法在细小边缘也会产生较强的边缘响应强度[27]。为克服上述问题,并顾及计算效率,借鉴梯度幅度相似性的纹理检测方法[29],本文直接采用局部规则窗口内水平和竖直两方向的梯度绝对值之和与标准差表达纹理丰富程度。前者实质为边缘检测算子,不同之处在于低通滤波的均值处理;后者性质和纹理基元(texton)[27]类似,可一定程度上减小细小边缘的响应强度。综上所述,本文纹理信息采用式(2)确定

(2)

图3列出了两个典型区域的影像采用梯度、Canny算子和本文方法检测出的影像纹理特征。图3中红色矩形表示未检测出的有效边缘区域,而黄色方框表示过度分割区域。如图所示,梯度对噪声十分敏感,在平面区域也能产生较大的梯度值,如图3(b)所示;Canny仅可检测二值化边缘,而无法定量描述像素的纹理信息,同时算法本身受到2个参数影响,采用固定的参数在不同区域容易出现边缘缺失和冗余边缘的现象,如图3(c)所示。与此不同,本文方法定量表达纹理丰富程度,并且该值相比于梯度和Canny更为平滑,不易受到噪声的影响,如图3(d)所示。

1.3 顾及纹理特征的自适应密集匹配

图4列出了影像纹理信息与视差图的对应关系,从该图可见,在屋顶、地面等区域通常视差较为一致,对应的纹理强度也相对较弱;而房屋边缘、微小物体、植被等区域,视差通常存在剧烈突变,而对应的边缘区域纹理信息也较为强烈。同时,SGM的惩罚参数P1、P2与相邻像素间的视差变化频率存在反比例关系,即低纹理区域需要较大的参数加强视差平滑性约束,而高纹理区域需要较小的参数来保留边缘结构处的视差突变。因此,本文根据纹理信息自适应调整惩罚参数,对纹理属性不同的像素施加不同程度的平滑约束,以此能够正确反映现实世界中物体实际深度变化。

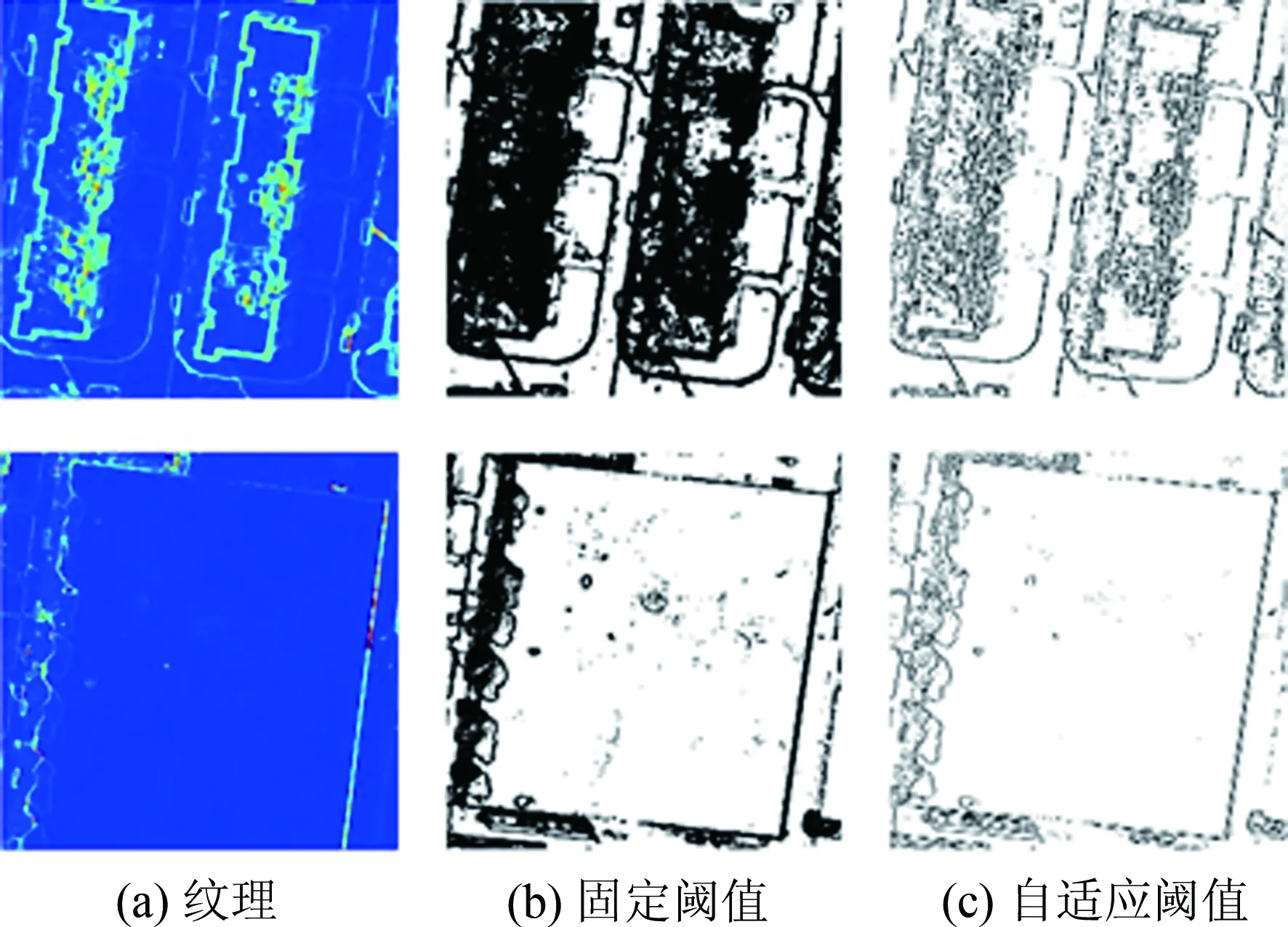

一种简单的自适应调整策略是获得影像纹理特征值范围后,采用线性内插逐像素计算惩罚参数。这种方法理论上能够反映纹理和惩罚参数的对应关系,但实际上存在以下缺点:①线性内插需要额外的内存记录与影像同等尺寸的参数矩阵;②需额外的内插与存取操作;③内插可能会造成低纹理大参数和高纹理小参数等错误的对应关系。针对线性内插的这些缺点,本文借鉴SURE的二值化策略[20],对纹理信息采用二值化处理,单个像素仅需要一个字节标识纹理属性,高低纹理区域分别对应固定的惩罚参数。不同于固定阈值二值化处理方式,本文采用一种自适应二值化处理方法[30],利用局部邻域高斯加权和方法计算局部阈值

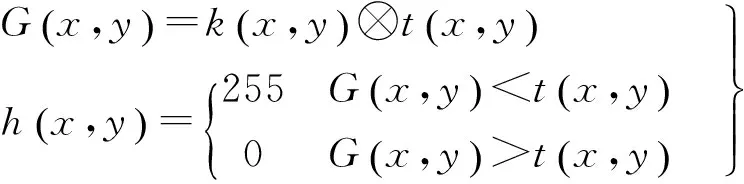

(3)

式中,k(x,y)是高斯卷积核;t(x,y)是纹理信息;G(x,y)是高斯滤波后的纹理结果,作为像素(x,y)纹理属性划分的局部阈值;h(x,y)是自适应阈值处理后的二值纹理影像,0代表像素(x,y)属于低纹理区域,255则表示该像素属于高纹理区域。

图5比较了固定阈值和自适应阈值的纹理二值化结果。由图5可知,固定阈值结果(图5(b))在屋顶低纹理区域检测结果不理想。其原因为纹理检测使用的是基于窗口的方法,靠近边缘的像素在自身窗口内仍保持高频率的色调变化,使固定阈值难以区分边缘和邻近的像素。而自适应阈值二值化(c)使每个像素阈值局部自适应,检测边缘更细,保留更多低纹理区域,有效地控制了视差断裂范围。

在代价聚合阶段,根据前后两点的纹理属性重新确定惩罚参数。具体而言,若当前像素p和聚合方向上前一像素p-r都属于低纹理区域,则选取较大的惩罚参数保证视差连续;若p和p-r都属于高纹理区域或者纹理属性不同,这时候传递给当前像素的视差信息不再可靠,应该选取较小的惩罚参数允许视差突变,具体公式如下

(4)

2 试验分析

2.1 试验数据

为验证本文算法有效性,采用不同区域、不同相机类型影像测试,如图6所示,表1列出试验区域主要信息,其中分辨率一栏括号中内容为侧视影像分辨率范围。

表1 试验区域数据信息

金阳区域倾斜影像:采用SWDC-5获取5组相机影像数据,包含一个下视相机和4个45°角倾斜相机。影像为8位深度的彩色RGB影像,像幅大小为8176×6132像素,航高约为600 m,设计航向重叠度为60%,旁向重叠度为50%,下视相机和侧视相机焦距分别为50 mm和80 mm,在此配置之下,下视地面分辨率约为8 cm,侧视地面分辨率范围约为8~16 cm。

苏黎世区域倾斜影像:采用Leica RCD-30 Oblique获取5组相机影像数据,包含一个下视相机和4个35°角倾斜相机。影像为16位深度的彩色RGB影像,像幅大小为9000×6732像素,航高约为520 m,设计航向重叠度为70%,旁向重叠度为50%,下视相机和侧视相机焦距均为53 mm,下视地面分辨率为 6 cm,侧视地面分辨率范围为6~13 cm。

斯图加特区域下视影像:采用Z/Ⅰ DMCII相机获取影像数据,影像为16位深度的近红外伪彩色影像,像幅大小为7680×13 824,航高约为500 m,设计航向重叠度和旁向重叠度均为60%,相机焦距为120 mm,地面分辨率为8 cm。

慕尼黑区域下视影像:采用DMC Ⅱ 230相机获取影像数据,选取16位深度的彩色RGB影像,像幅大小为15 552×14 144像素,航高约为515 m,设计航向重叠度和旁向重叠度均为80%,相机焦距为91 mm,地面分辨率约为10 cm。

2.2 对比与分析

试验第1部分比较了不同大小参数和自适应参数得到的试验结果,匹配参数如表2所示,大小参数匹配的算法采用原始的自适应梯度SGM。试验结果如图7至图10所示,其中图(a)为试验区域示意图,蓝色方框标识道路或者屋顶等低纹理区域,红色方框标识建筑物边缘等高纹理区域;图(b)为小参数密集匹配点云结果;图(c)为大参数密集匹配点云结果;图(d)为本文算法获得的点云结果;图(e)为低纹理区域小参数匹配和本文算法结果剖面图;图(f)为高纹理区域大参数和本文算法结构的剖面图。其中图(e)和图(f)坐标轴横轴为剖面对比区域的长度,纵轴为区域上点坐标的Z值,单位均为米。

表2 试验参数

下视影像中道路和屋顶等低纹理区域,深度变化较缓,但在侧视影像中,这些区域深度有明显变化。将侧视影像经核线重采样纠正到水平像平面后,这些区域会产生多个内插像素,相邻像素深度变化仍然保持缓慢,因此自适应参数理论上也可顾及侧视影像。如图7(b)所示,在蓝框标识的低纹理区域内,小参数结果点云不够平顺,起伏较为明显;自适应梯度SGM在这些低纹理区域仅增大P2,并未改变P1大小,平滑性约束不强。由于这些平面区域的纹理较弱,本文算法在匹配阶段选取较大的P1和P2,加强视差平滑性约束,如图7(d)所示,对应区域点云相对平坦。

如图8(c)所示,在红框标识的建筑物边缘区域,大参数视差结果过于平滑,深度变化缓慢,使边缘像素深度计算错误,易产生噪声,且建筑物丢失直角特征。由于边缘纹理较为丰富,本文算法在匹配阶段选取较小的P1和P2,在边缘处允许深度突变,如图8(d)所示,相同区域可很好地保留直角特征,同时在平缓区域抑制了噪声。若采用较小参数,在平面区域会导致点云粗糙或误匹配,如图9(e)所示,而自适应参数能正确施加较大平滑性约束,标记出误匹配点。

试验的第2部分定性比较了本文自适应参数SGM与SURE密集匹配结果,匹配参数均使用默认值,采用金阳区域下视影像作为试验数据,对比结果由图11给出。SURE采用的tSGM是对自适应梯度SGM的改良,通过Canny算子检测边缘,并在边缘处减小参数P2,从而达到保留边缘特征的目的;通过动态调整像素的视差搜索范围使得平面区域点云更加平滑[20]。从图11中可以看出,SURE算法的匹配点云结果在道路区域点云缺漏现象明显,如红框所示,此现象是由于SURE匹配时对道路区域平滑性约束不够强,易产生可靠性不高的点以及噪声点,在双向匹配一致性检查时被剔除,造成点云缺漏;另一方面,由于边缘未被完整检测,导致某些边缘的平滑约束仍然较大,造成匹配错误,个别建筑物边角缺失,如黄框所示。而本文提出的自适应参数得到的结果在道路区域更为完整,也保留了更多的建筑物边角特征,整体上优于SURE生成的点云。

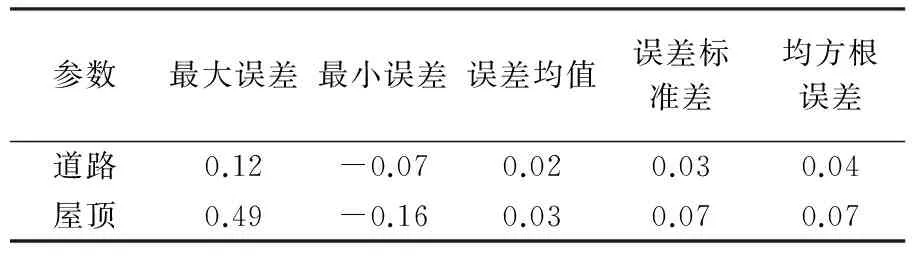

本文试验第3部分,为定量验证本文方法的可靠性和有效性,选用质量较好的LiDAR点云与自适应密集匹配点云进行对比,同时比较密集匹配点云与25 cm格网分辨率DSM间差距,其中机载LiDAR和DSM均来源于ISPRS基准测试[31]。图12显示具体对照结果,其中,图12(a)、(c)显示所选取对比区域,图12(b)、(d)分别为对应区域剖面图,横轴为沿剖线方向长度,纵轴为三维坐标Z值,单位均为米。如图12所示,在道路区域,本文算法点云结果更接近于LiDAR点云,两者起伏情况相近;在建筑物边缘区域,直角特征基本吻合。图13定量描述密集匹配点云与DSM间差异,其中图13(a)、(c)为所选对比区域,图13(b)、(d)为密集匹配点云与DSM间差异。由表3可见,两者的差异并不明显,特别是在道路等低纹理区域,差异仅有厘米级,仅在纹理复杂区域,存在误差较大的个别点,但总体上点云与DSM仍十分一致,进一步证明了本文算法的正确性。

表3 斯图加特密集匹配点云和DSM数据对比 Tab.3 Comparison between dense matching and DSM m

本文定量比较了原始自适应梯度SGM,顾及纹理的SGM和LiDAR点云数据[31]间差异。图14(a)为试验区域点云结果,图14(b)、(c)分别为原始自适应梯度和顾及纹理SGM的密集匹配结果与LiDAR点云的M3C2(multiscale model to model cloud comparison)距离[32]的直方图统计结果,其中图表标题列出误差统计的均值与标准差。如图14所示,传统方法精度与本文方法精度差异并不明显,其原因为LiDAR点云相对于密集匹配点云较为稀疏,致使图14(b)、(c)直方图形状整体上较为相似。进一步统计直方图的均值和方差,可见密集匹配点云和LiDAR点云差异不明显,同时两种方法精度十分接近。事实上该精度值主要与平差结果相关,然而该统计结果也从另一个侧面说明本文方法的可行性。本文方法并不致力于提高SGM的匹配精度,主要目的为降低平坦区域噪声,并减少视差断裂处的缺漏情况,如上述定性分析所示。

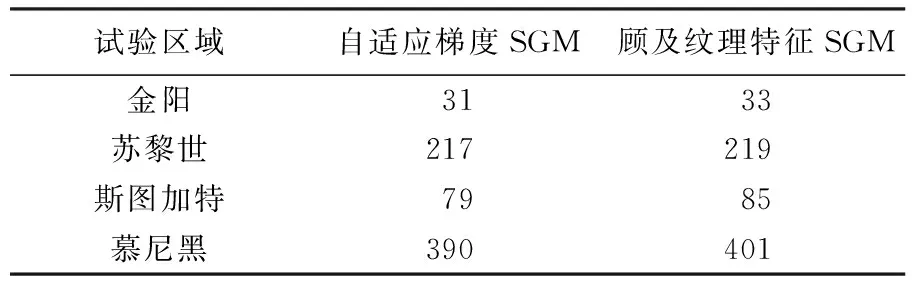

2.3 效率分析

本次试验设备为戴尔Precision M6700工作站,处理器为Intel(R) Core(TM) i7-3720QM 2.60 GHz,内存为8 GB;开发环境为Visual Studio 2013,使用C++编程实现SGM算法。由于内存限制,影像需要分块处理,且对各分块采用OpenMP并行加速处理。表4为本文算法与原始自适应梯度SGM算法的效率对比。在代价聚合阶段,使用SIMD(single instruction multiple data)指令加速处理[33]。

表4 效率对比

3 结 论

本文在半全局匹配算法的基础上,提出了一种纹理感知的自适应参数算法:检测并定量描述影像的纹理信息,根据纹理信息自适应计算逐像素的惩罚参数,并自适应选择参数匹配。试验表明,本文提出的算法在低纹理区域点云结果更为平坦,同时能更好保留建筑物边缘的直角特征。由于没有破坏算法的基本框架和数据结构,保留了其使用SIMD技术加速计算的能力。采用ISPRS的基准测试数据集以及实际应用生产中的SWDC-5倾斜摄影系统获取的影像进行试验验证表明,本文方法能显著提高密集匹配点云在低纹理区域的质量,同时在视差断裂处保留物体的直角边缘特征。

图3 不同方法检测出的纹理特征Fig.3 Texture feature from various methods

图4 影像纹理与视差的对应关系Fig.4 Relationship between texture and disparity

图5 纹理信息二值化结果对比Fig.5 Texture binarization results comparison

图6 试验区域影像Fig.6 Experiment images

图7 金阳倾斜影像对比Fig.7 Comparison for Jinyang images

图8 苏黎世倾斜影像对比Fig.8 Comparison for Zürich images

图9 斯图加特影像对比Fig.9 Comparison for Stuttgart images

图10 慕尼黑下视影像对比Fig.10 Comparison for München images

图11 SURE与本文方法点云结果对比Fig.11 Comparison between SURE and proposed method

图12 斯图加特密集匹配点云和LiDAR点云对比Fig.12 Comparison between dense matching and LiDAR

图13 斯特加特密集匹配点云和DSM对比Fig.13 Comparison between dense matching and DSM

图14 自适应梯度与顾及纹理SGM对比Fig.14 Comparison between adaptive gradient SGM and SGM concerned with texture feature

[1] LEBERL F,IRSCHARA A,POCK T, et al.Point Clouds: LiDAR Versus 3D Vision[J]. Photogrammetric Engineering & Remote Sensing, 2010, 76(10): 1123-1134.

[2] HAALA N. The Landscape of Dense Image Matching Algorithms[C]∥Photogrammetric Week 2013. Stuttgart, Germany: [s.n.], 2013.

[3] HIRSCHMULLER H.Stereo Processing by Semiglobal Matching and Mutual Information[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2008, 30(2): 328-341.

[4] REMONDINO F, SPERA M G, NOCERINO E, et al. State of the Art in High Density Image Matching[J]. The Photogrammetric Record, 2014, 29(146): 144-166.

[5] SCHARSTEIN D, SZELISKI R. A Taxonomy and Evaluation of Dense Two-frame Stereo Correspondence Algorithms[J]. International Journal of Computer Vision, 2002, 47(1-3): 7-42.

[6] 王竞雪, 朱庆, 王伟玺. 多匹配基元集成的多视影像密集匹配方法[J]. 测绘学报, 2013, 42(5): 691-698. WANG Jingxue, ZHU Qing, WANG Weixi. A Dense Matching Algorithm of Multi-view Image Based on the Integrated Multiple Matching Primitives[J]. Acta Geodaetica et Cartographica Sinica, 2013, 42(5): 691-698.

[7] VU H H, LABATUT P, PONS J P,et al.High Accuracy and Visibility-consistent Dense Multiview Stereo[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(5): 889-901.

[8] 杨化超, 姚国标, 王永波. 基于SIFT的宽基线立体影像密集匹配[J]. 测绘学报, 2011, 40(5): 537-543. YANG Huachao, YAO Guobiao, WANG Yongbo. Dense Matching for Wide Base-line Stereo Images Based on SIFT[J]. Acta Geodaetica et Cartographica Sinica, 2011, 40(5): 537-543.

[9] HOSNI A, BlEYER M, GELAUTZ M. Secrets of Adaptive Support Weight Techniques for Local Stereo Matching[J]. Computer Vision and Image Understanding, 2013, 117(6): 620-632.

[10] YANG Qingxiong. A Non-local Cost Aggregation Method for Stereo Matching[C]∥Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI: IEEE, 2012: 1402-1409.

[11] YANG Qingxiong. Stereo Matching Using Tree Filtering[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(4): 834-846.

[12] SUN Jian, SHUM H Y, ZHENG Nanning. Stereo Matching Using Belief Propagation[M]∥HEYDEN A, SPARR G, NIELSEN M, et al. Computer Vision—ECCV 2002. Berlin: Springer, 2002: 510-524.

[13] KOLMOGOROV V, ZABIH R. Computing Visual Correspondence with Occlusions Using Graph Cuts[D]. Ithaca: Cornell University, 2001.

[14] 郑肇葆. 数字影像匹配的动态规划方法[J]. 测绘学报, 1989, 18(2): 100-107. ZHENG Zhaobao. Image Matching Method via Dynamic Programming[J]. Acta Geodaetica et Cartographica Sinica, 1989, 18(2): 100-107.

[15] 张祖勋, 张剑清, 吴晓良. 跨接法概念之扩展及整体影象匹配[J]. 武汉测绘科技大学学报, 1991, 16(3): 1-11. CHANG Zhuxun, CHANG Jianqing, WU Xiaoliang. Develeping of Bridging Mode and Global Image Matching[J]. Journal of Wuhan Technical University of Surveying and Mapping, 1991, 16(3): 1-11.

[16] BIRCHFIELD S, TOMASI C. Depth Discontinuities by Pixel-to-pixel Stereo[J]. International Journal of Computer Vision, 1999, 35(3): 269-293.

[17] BANZ C, BLUME H, PIRSCH P. Real-time Semi-global Matching Disparity Estimation on the GPU[C]∥Proceedings of the IEEE International Conference on Computer Vision Workshops. Barcelona, Spain: IEEE, 2011: 514-521.

[18] ALOBEID A, JACOBSEN K, HEIPKE C. Comparison of Matching Algorithms for DSM Generation in Urban Areas from IKONOS Imagery[J]. Photogrammetric Engineering & Remote Sensing, 2010, 76(9): 1041-1050.

[19] CAVEGN S,HAALA N,NEBIKER S,et al.Benchmarking High Density Image Matching for Oblique Airborne Imagery[J]. International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, 2014, XL-3(3): 45-52.

[20] ROTHERMEL M,WENZEL K,FRITSCH D,et al.SURE: Photogrammetric Surface Reconstruction from Imagery[C]∥Proceedings of LC3D Workshop. Berlin: [s.n.], 2012.

[21] FUSIELLO A, TRUCCO E, VERRI A. A Compact Algorithm for Rectification of Stereo Pairs[J]. Machine Vision and Applications, 2000, 12(1): 16-22.

[22] HIRSCHMULLER H, SCHARSTEIN D. Evaluation of Stereo Matching Costs on Images with Radiometric Differences[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(9): 1582-1599.

[23] HIRSCHMULLER H, BUDER M, Ernst I. Memory Efficient Semi-global Matching[C]∥ISPRS Annals of Photogrammetry,Remote Sensing and Spatial Information Sciences.Melbourne,Australia:ISPRS,2012,I-3: 371-376.

[24] HUMENBERGER M, ZINNER C, KUBINGER W. Performance Evaluation of a Census-based Stereo Matching Algorithm on Embedded and Multi-core Hardware[C]∥Proceedings of 6th International Symposium on Image and Signal Processing and Analysis. Salzburg: IEEE, 2009: 388-393.

[25] RANFTL R, GEHRIG S, POCK T, et al. Pushing the Limits of Stereo Using Variational Stereo Estimation[C]∥Proceedings of 2012 IEEE Intelligent Vehicles Symposium. Alcala de Henares: IEEE, 2012: 401-407.

[26] MEI Xing, SUN Xun, ZHOU Mingcai, et al. On Building an Accurate Stereo Matching System on Graphics Hardware[C]∥Proceedings of the IEEE International Conference on Computer Vision Workshops. Barcelona, Spain: IEEE, 2011: 467-474.

[27] MALIK J, BELONGIE S, LEUNG T, et al. Contour and Texture Analysis for Image Segmentation[J]. International Journal of Computer Vision, 2001, 43(1): 7-27.

[28] ZHU Qing, WAN Neng, WU Bo. A Filtering Strategy for Interest Point Detecting to Improve Repeatability and Information Content[J]. Photogrammetric Engineering & Remote Sensing, 2007, 73(5): 547-553.

[29] XUE Wufeng, ZHANG Lei, MOU Xuanqin, et al. Gradient Magnitude Similarity Deviation: A Highly Efficient Perceptual Image Quality Index[J]. IEEE Transactions on Image Processing, 2014, 23(2): 684-695.

[30] SZELISKI R. Computer Vision: Algorithms and Applications[M]. London: Springer-Verlag, 2011: 2601-2605.

[31] ROTTENSTEINER F, SOHN G, GERKE M, et al. Results of the ISPRS Benchmark on Urban Object Detection and 3D Building Reconstruction[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 93: 256-271.

[32] LAGUE D, BRODU N, LEROUX J. Accurate 3D Comparison of Complex Topography with Terrestrial Laser Scanner: Application to the RANGITIKEI Canyon (N-Z)[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2013, 82: 10-26.

[33] CONTE G,TOMMESANI S, ZANICHELLI F. The Long and Winding Road to High-performance Image Processing with MMX/SSE[C]∥Proceedings of the 5th IEEE International Workshop on Computer Architectures for Machine Perception. Padova: IEEE, 2000: 302-310.

(责任编辑:张艳玲)

An Adaptive Dense Matching Method for Airborne Images Using Texture Information

ZHU Qing1,2,CHEN Chongtai1,5,HU Han1,3,DING Yulin1,4

1. Faculty of Geosciences and Environmental Engineering,Southwest Jiaotong University,Chengdu 611756,China; 2. State-Province Joint Engineering Laboratory of Spatial Information Technology of High-speed Rail Safety,Southwest Jiaotong University,Chengdu 611756,China; 3. Department of Land Surveying and Geo-information,Hong Kong 999077,China; 4. Institute of Space and Earth Information Science,Hong Kong 999077,China; 5. Shenzhen Research Center of Digital City Engineering,Shenzhen 518034,China

Semi-global matching (SGM) is essentially a discrete optimization for the disparity value of each pixel, under the assumption of disparity continuities. SGM overcomes the influence of the disparity discontinuities by a set of parameters. Using smaller parameters, the continuity constraint is weakened, which will cause significant noises in planar and textureless areas, reflected as the fluctuations on the final surface reconstruction. On the other hands, larger parameters will impose too much constraints on continuities, which may lead to losses of sharp features. To address this problem, this paper proposes an adaptive dense stereo matching methods for airborne images using with texture information. Firstly, the texture is quantified, and under the assumption that disparity variation is directly proportional to the texture information, the adaptive parameters are gauged accordingly. Second, SGM is adopted to optimize the discrete disparities using the adaptively tuned parameters. Experimental evaluations using the ISPRS benchmark dataset and images obtained by the SWDC-5 have revealed that the proposed method will significantly improve the visual qualities of the point clouds.

dense image matching;semi-global matching;texture feature;adaptive method Foundation support: The National Natural Science Foundation of China (Nos.41501421;41631174;61602392); The Foundation of Key Laboratory for Geo-Environmental Monitoring of Coastal Zone of the National Administration of Surveying, Mapping and Geoinformation; Open Research Fund of State Key Laboratory of Information Engineering in Surveying, Mapping and Remote Sensing (No.15I01)

ZHU Qing(1966—),male,PhD,Professor,PhD supervisor,majors in dynamic GIS and VGE.

HU Han

朱庆,陈崇泰,胡翰,等.顾及纹理特征的航空影像自适应密集匹配方法[J].测绘学报,2017,46(1):62-72.

10.11947/j.AGCS.2017.20150608. ZHU Qing,CHEN Chongtai,HU Han,et al.An Adaptive Dense Matching Method for Airborne Images Using Texture Information[J]. Acta Geodaetica et Cartographica Sinica,2017,46(1):62-72. DOI:10.11947/j.AGCS.2017.20150608.

P231

A

1001-1595(2017)01-0062-11

国家自然科学基金(41501421;41631174;61602392);空间信息智能感知与服务深圳市重点实验室(深圳大学)开放基金;测绘遥感信息工程国家重点实验室(武汉大学)基金(15I01)

2015-12-01

朱庆(1966—),男,博士,教授,博士生导师,研究方向为多维动态GIS与虚拟地理环境。

E-mail: zhuq66@263.net

胡翰

E-mail: huhan19880715@163.com

修回日期: 2016-12-08