基于三元组卷积神经网络的图像检索

蔡芷茵,高 炜,俞祝良,黄金洪,刘 浩,李宏海

(1.华南理工大学 自动化科学与工程学院, 广东 广州 510641;2.北京交通信息中心, 北京 100161;3.交通运输部公路科学研究院 智能交通研究中心, 北京 100088)

基于三元组卷积神经网络的图像检索

蔡芷茵1,高 炜1,俞祝良1,黄金洪1,刘 浩2,李宏海3

(1.华南理工大学 自动化科学与工程学院, 广东 广州 510641;2.北京交通信息中心, 北京 100161;3.交通运输部公路科学研究院 智能交通研究中心, 北京 100088)

针对图像检索中图像间相似度和训练集带标签样本不足问题,提出一种改进的三元组卷积神经网络的图像检索算法。采用基于三元组卷积神经网络,在相似数据集上进行网络训练,为图像检索项目提取更好的特征。 实验结果表明,该算法在相似数据集上进行重训练,有助于提高基于内容的图像检索任务的性能。

基于内容的图像检索;卷积神经网络;相似度度量;特征表达

在基于内容的图像检索(Content-Based Image Retrieval, CBIR)任务中,提取有效样本特征的模型尤为重要[1, 2]。随着深度学习在机器学习领域的逐渐流行,应用卷积神经网络(Convolutional Neural Networks, CNN)已经成为图像分类和图像检索的一种重要方法[3]。

检索是基于图像内容而非词汇描述的,在复杂的CBIR任务中,低层次视觉特征和高层次人类感知之间存在语义鸿沟[4, 5],采用人工神经网络模型提取特征通常不能取得满意的效果[6]。已有的CBIR方法主要基于颜色特征[7]和纹理特征[8]等低层次的特征[4, 9],不能获得令人满意的结果。当训练样本数量不足以训练大规模复杂网络时,便会出现灾难性的过拟合现象,即网络在训练集上表现出良好的性能而在测试集中效果很糟糕。虽然有时获取大量图像并不困难,但是对其做标记也要花费更多的人力物力。

针对上述问题,本文拟采用三元组卷积神经网络(Triplet Convolutional Neural Network, Tri- CNN),在不同类样本被判定为比同类样本更相似时给予惩罚。利用几个相似的大规模数据集进行网络训练,并对现有的带标签数据进行数据扩充,以期提高CBIR任务的性能。

1 三元组卷积神经网络

三元组卷积神经网络(Triplet Convolutional Neural Networks, Tri- CNN)算法主要包括两个阶段:(1) 与相似度度量相结合,采用深度CNN结构[10]及余弦相似度[11],训练一个深度CNN模型;(2) 利用与被检索数据集相似的数据集训练网络,以获取更有效的特征表达并提高检索性能。

1.1 相似度度量

采用余弦相似度来度量样本间的相似度,其表达式为

(1)

其中x,y代表两个样本特征。

在检索任务中,计算查询样本与被检索数据库中所有样本间的相似度,被检索数据库中与查询样本特征相似度最高的样本即为应返回给用户的目标样本。

1.2 三元组卷积神经网络

CNN由输入层、卷积层、池化层、全连接层和输出层等5个部分组成。每个CNN包含5个卷积层和3个全连接层。

第一层是输入层,原图像随机平移和水平镜像变换并截取227×227图像块,把主成分中随机倍数的RGB像素值添加到数据集的每张图片中。

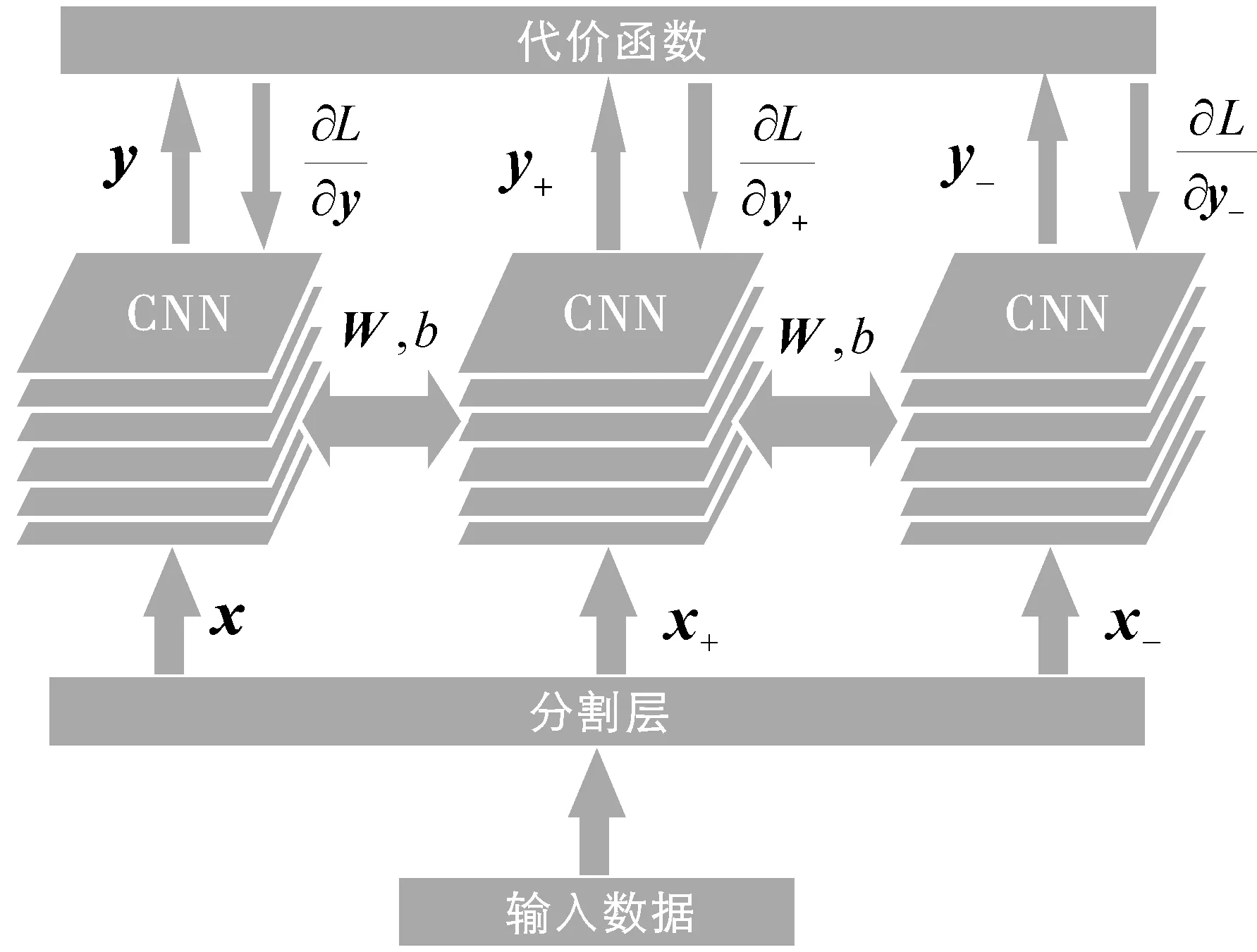

输入层之后是5个卷积层。第1个和第2个卷积层之后均有1个响应归一化层和最大池化层。第3个和第4个卷积层之后不含池化层及归一化层。第5个卷积层之后是一个最大池化层。5个卷积层之后有3个全连接层,其中前两个包含4 096个神经元,最后一个包含1 000个神经元。网络结构如图1所示。

图1 三元组卷积神经网络结构

在Tri-CNN中,将整流线性单元(Rectified Linear Units, ReLU)f(x)=max(0,x)作为非线性激活函数[12]。在ReLU-6层和ReLU-7层之后,分别加入drop-out操作,在训练阶段随机将半数神经元连接权重置为0,使学习获得更强鲁棒性的特征[13]。在输入层和第1个卷积层之间加入1个分割层。在每次训练中,将1张预先选定的图像、1张与其同类的图像(用“+”标记)和1张不同类的图像(用“-”标记)作为整体输入网络。经过分割层后,3张图像被分别输入到3个网络中。如图1所示,3个网络在所有卷积层和全连接层上共享权值和偏置。

将式(1)定义的余弦相似度作为相似度度量,可重写为[11]

则代价函数为

L((x,x+,x-);γ;S)=max{0,γ-S(y,y+)+

S(y,y-)}。

(2)

其中γ是阈值参数,(x,x+,x-)是输入的三元组,x+和x属于同类别,x-属于不同类别。(y,y+,y-)是三元组的特征。则

考虑到每次训练采用多个样本,梯度计算可表示为

2 实验结果及分析

实验中CBIR任务的数据集是Fabric数据集, 在Fabric数据集中,每个类别只有两张图片,其中1张放入查询数据库,另1张则放入被检索数据库。因此,对于查询图片来说,被检索数据库中仅有1张图片与之匹配。分别计算搜索图片与被检索数据库中的每张图片的相似度,并按照相似度从大到小的顺序排列。设定按照相似度排列的前N张图片为检索结果,如果匹配的图片在检索结果中,则检索成功(top-N为1),否则失败(top-N为0)。实验将采用top-1,top-5,top-10,top-100指标来衡量Tri-CNN应用CBIR任务的效果。所有实验均使用E5-2670 2.60GHzCPU的计算机实现。

2.1 数据集描述

(1)预训练深度模型

ImageNet数据集[14]中的图片样本是从网上采集后人工标记的。ImageNet大规模视觉识别挑战赛

(ImageNetLarge-ScaleVisualRecognitionChallenge,ILSVRC)当中所用的数据集正是ImageNet数据集的子集,子集有1 000类的图像,包含约120万张训练集图片,5万张验证集图片以及15万张测试集图片。实验所用的预训练深度模型来源于ILSVRC2012训练。

(2)再训练的数据集

为了对比不同数据集再训练的效果,分别用ImageNet数据集、ALOT数据集、Cloth132数据集3种类型的数据集再训练Tri-CNN。

ALOT数据集[15]是含有 2.5 万张 250 类的带标签图片的大规模纹理数据集。数据集中包含木质纤维、糖、羊毛毛毯和精白米等类型的纹理图片。因此,ALOT数据集和Fabric数据集是相似数据集。

Cloth132数据集含有132类布料图片,而每类图片只有2张,因此数据集含有264张图片。虽然Cloth132数据集非常小,但它和Fabric数据集是同类数据集。

(3)CBIR任务的数据集

CBIR任务的数据集是Fabric数据集,它含有1 000类的带标签高分辨率图片,每类2张,共计2 000张图片。所有布料图片均由布料公司采集及人工分类标记。

由于每类含有2张相似的布料图片,把其中一张放入查询数据库,另一张则放入被检索数据库,则查询数据库和被检索数据库均含有1 000张图片。实验数据集图像样例如图2所示。

图2 实验数据集图像样例

2.2 参数选取

将再训练模型的学习率η设为0.001,用ALOT数据集[15]再训练Tri-CNN。再训练过程中,从0.15到0.75范围内选取不同的阈值参数γ进行实验。

实验结果如图3所示。

图3 Fabric数据集上不同的阈值参数对检索性能的影响

由于γ=0.25在top-1, top-5, top-15指标下都有较好效果,而且在top-10指标下效果也不错,所以选取0.25为代价函数的阈值参数。运用预训练深度模型再训练深度卷积神经网络,迭代一次仅需90 s。

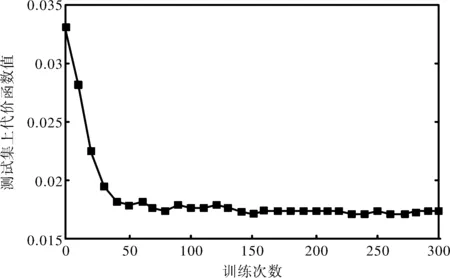

再训练Tri-CNN过程中,在ALOT数据集进行训练,在Fabric数据集进行测试。迭代0次到300次时测试集的代价函数值如图4所示。

图4 再训练模型时测试集上代价函数值

由图4可知,再训练模型测试集的代价函数值在

迭代1次到50次的时候快速下降,在迭代50次到70次时下降趋于缓慢。迭代70次到100次时,代价函数值已经基本不变。迭代超过100次以后,代价函数值在一个小幅度内波动。因此,再训练Tri-CNN时选择迭代70次,将会耗费大概105 min。

2.3 基于再训练Tri-CNN的CBIR任务

分别利用ImageNet数据集、Cloth132数据集、ALOT数据集3个不同的数据集再训练Tri-CNN。ImageNet数据集是大规模数据集,它与CBIR任务的数据集是两种不同类型的数据集;Cloth132数据集跟Fabric数据集是同种类型的数据集,但是非常小;ALOT数据集是大规模数据集,同时它也是CBIR任务的数据集的相似数据集。实验结果如表1所示。

与预训练深度模型所得的结果相比,这3种数据集再训练Tri-CNN均可提高CBIR任务的性能。对于图像检索任务来说,再训练Tri-CNN可获取更有效的特征。如表1所示,用ALOT数据集再训练的效果最好,用Cloth132数据集次之,用ImageNet数据集结果最差。因此,用CBIR任务的数据集的同类数据集或相似数据集再训练Tri-CNN可以得到更好的结果。然而,与CBIR任务的数据集同类的Cloth132数据集由于太小,没有大到足以让再训练Tri-CNN时可以从中学习到有效特征,所以没能实现最好的结果。反而,用大规模的相似数据集——ALOT数据集来再训练可以获得最好的效果。因此,用相似数据集再训练Tri-CNN可以提升CBIR任务的性能。

表1 Fabric数据集上采用不同模型的检索性能

3 结语

应用Tri-CNN,将CNN与相似度度量结合起来用于特征提取,提高了图像检索的性能,说明CNN可提取到高层次的语义特征;而将相似度纳入网路训练目标更符合检索任务的要求,可获得更佳的性能。对检索数据集相似的大规模相似数据集进行网络训练,并将网络用于检索任务的特征提取,在检索性能上取得较大提升。实验结果表明,当特定检索任务数据集样本数量不足以训练大规模网络时,在预训练网络的基础上用相似大规模数据集进行再训练,可明显提高检索性能。

[1] 刘颖, 范九伦. 基于内容的图像检索技术综述[J]. 西安邮电学院学报, 2012,17(2):1-8. DOI:10.13682/j.issn.2095-6533.2012.02.022.

[2] 刘颖, 黄源, 高梓铭. 刑侦图像检索中的特征提取及相似性度量[J]. 西安邮电大学学报, 2014,19(6):11-16. DOI: 10.13682/j.issn.2095-6533.2014.06.003.

[3] LI D. A tutorial survey of architectures, algorithms, and applications for deep learning[J/OL]. APSIPA Transactions on Signal & Information Processing, 2014,3(e2):1-29[2016-07-20].http://www.researchgate.net/publication/270806577_A_tutorial_survey_of_architectures_algorithms_and_applications_for_deep_learning__ERRATUM. DOI: 10.1017/ATSIP.2014.4.

[4] SMEULDERS A W M, WORRING M, SANTINI S, et al. Content-based image retrieval at the end of the early years[J/OL]. IEEE Trans. Pattern Anal. Machine Intell., 2000,22(12):1349-1380[2016-07-20]. http://dx.doi.org/10.1109/34.895972.

[5] RAFIEE G, DLAY S S, WOO W L. A review of content-based image retrieval[C/OL]//2010 7th International Symposium on Communication Systems Networks and Digital Signal Processing (CSNDSP), UK:IEEE,2010, 1(4):775-779[2016-07-20]. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5580313.

[6] WAN J, WANG D, HOI S C H, et al. Deep learning for content-based image retrieval: a comprehensive study[C/OL]// MM '14 Proceedings of the 22nd ACM international conference on Multimedia, New York, NY, USA :ACM, 2014: 157-166[2016-07-20]. http://dx.doi.org/10.1145/2647868.2654948.

[7] MANJUNATH B S, MA W Y. Texture features for browsing and retrieval of image data[J/OL]. IEEE Trans. Pattern Anal. Machine Intell, 1996,18(8):837-842[2016-07-20]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=531803.

[8] LEW M S, SEBE N, DJERABA C, et al. Content-based multimedia information retrieval: State of the art and challenges[J/OL]. Acm Transactions on Multimedia Computing Communications & Applications, 2006,2(1):1-19[2016-07-28]. http://dx.doi.org/10.1145/1126004.1126005.

[9] JAIN A K, VAILAYA A. Image retrieval using color and shape[J/OL]. Pattern Recogn, 1996,29(8):1233-1244[2016-07-28]. http://www.researchgate.net/publication/222471476_Image_retrieval_using_color_and_shape. DOI: 10.1016/0031-3203(95)00160-3.

[10] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J/OL]. Advances in Neural Information Processing Systems, 2012,25(2):2012[2016-07-28]. http://www.researchgate.net/publication/267960550_ImageNet_Classification_with_Deep_Convolutional_Neural_Networks.

[11] WU P, HOI S C H, XIA H, et al. Online multimodal deep similarity learning with application to image retrieval[C/OL]// MM '13 Proceedings of the 21st ACM international conference on Multimedi , New York, NY, USA:ACM,2013:153-162[2016-07-28]. http://dx.doi.org/10.1145/2502081.2502112.

[12] HARA K, SAITO D, SHOUNO H. Analysis of function of rectified linear unit used in deep learning[C/OL]// 2015 International Joint Conference on Neural Networks (IJCNN),[s.l.]:IEEE, 2015:1-8[2016-07-28]http://dx.doi.org/10.1109/IJCNN.2015.7280578.

[13] HINTON G E, SRIVASTAVA N, KRIZHEVSKY A, et al. Improving neural networks by preventing co-adaptation of feature detectors[J/OL]. Computer Science, 2012,3(4):212-223[2016-07-28]. http://www.oalib.com/paper/4059375.

[14] DENG J, DONG W, SOCHER R, et al. ImageNet: A large-scale hierarchical image database[C/OL]//IEEE Conference on Computer Vision and Pattern Recognition, 2009, Miami, FL, USA:IEEE,2009: 248-255[2016-07-28]. http://dx.doi.org/10.1109/CVPR.2009.5206848.

[15] BURGHOUTS, GERTJAN J, GEUSEBROEK, et al. Material-specific adaptation of color invariant features[J]. Pattern Recognition Letters., 2009,30(3):306-313[2016-07-28].http://dx.doi.org/10.1016/j.patrec.2008.10.005.

[责任编辑:祝剑]

Content-based Image retrieval based on triplet convolutional neural networks

CAI Zhiyin1, GAO Wei1, YU Zhuliang1, HUANG Jinhong1,LIU Hao2, LI Honghai3

(1.School of Automation Science and Engineering, South China University of Technology, Guangzhou 510641, China;2. Beijing Transportation Information Center, Beijing 100161, China;3. Intelligent Transportation Research Center, Research Institute of Highway Ministry of Transport, Beijing 100088, China)

Considering of the similar metric between images and the lack of labeled images in training dataset in content-based image retrieval (CBIR) tasks, Triplet Convolutional Neural Networks (Tri-CNN) are proposed to retrain the network on dataset in similar domain. Our experiments demonstrate that the improved structure of CNN which combines traditional deep convolutional neural networks and similarity metric, can improve the performance of CBIR tasks.

content-based image retrieval, convolutional neural networks, similarity metric, featurerepresentations

10.13682/j.issn.2095-6533.2016.06.012

2016-09-22

交通运输部科技计划资助项目(2015419223070)

蔡芷茵(1993-),女,硕士研究生,研究方向为模式识别与图像处理。E-mail: cai.zhiyin@mail.scut.edu.cn 高炜(1993-),男,硕士研究生,研究方向为模拟识别与图像处理。E-mail: augao@mail.scut.edu.cn

TP391.41

A

2095-6533(2016)06-0060-05