基于信息融合的网页文本聚类距离选择方法

张少宏,李继巧,罗嘉怡,谢冬青,王 婧

(1.广州大学计算机科学与教育软件学院,广东 广州 510006;2.广州图书馆,广东 广州 510623)

基于信息融合的网页文本聚类距离选择方法

张少宏1,李继巧1,罗嘉怡1,谢冬青1,王 婧2

(1.广州大学计算机科学与教育软件学院,广东 广州 510006;2.广州图书馆,广东 广州 510623)

在当前信息化的年代里,文本数据在高速的增长,人们获取有用的信息犹如大海捞针.文本聚类作为文本挖掘的基础技术,发挥了很重要的作用.由于缺乏预先定义的类和类标号的训练实例,如何选择合适的数据相似度是文本聚类的关键问题.文章为此提出一种新的衡量文本相似度的方法Adaptive Metric Selection(AMS).文章通过抓取网页内容,为聚类提供数据来源,分词和向量化是必要的转化,利用特征提取的方法获取特征项,并用Isomap进行降维,最后利用自适应选择方法AMS对数据进行相似度衡量再进行聚类分析.实验结果表明,AMS明显优于从多种相似度独立进行聚类的平均结果.

数据挖掘;特征提取;聚类融合

本文针对聚类知识提取和聚类评价的若干问题进行研究,讨论如何在尽可能包含聚类先验知识的情况下抽象出聚类知识,并从知识中寻找尽可能多的聚类结构信息,用一种自适应度量方法

在无监督学习中,由于缺乏已知类别的样本数据,数据的相似度衡量方法历来备受重视并得到深入的研究.在监督学习中,学习的目标是学习者从输入到输出的映射关系,其中输出的正确值已经由指导者提供.然而,在无监督学习中,却没有这样的指导者.另一方面,在无监督聚类应用中基于集成的技术已经吸引许多计算机领域的精英团体的高度兴趣[1-18].

具体而言,无监督集成框架,通常被称为聚类融合或一致聚类[1,4],能根据多个不同的独立聚类结果生成一个一致的结果.独立聚类结果能通过不同的透视方法,例如,通过不同的数据样本子集[3-4],不同的数据特征子集[2-3]或不同的聚类算法[1,19]得到.一旦独立分区创建,可以用于互协矩阵的方法[1,3,5]或者以图分割方法[1-2]推导出一致聚类结果.在第一类聚类融合的方法,重组矩阵是根据各个独立的分区,这些独立分区的第(i,J)个矩阵标志项中,第i个数据点和第J个数据点是否属于分区内的同一集合来生成的.然后,把所有的重组矩阵总结起来得出一个一致矩阵.这样一来这个矩阵能充当一个成对的相似矩阵,一个一致的结果能用恰当的聚类算法或图像分割算法被提取.特别地,每一个一致矩阵的项都是所有重组矩阵的相应的项的均值.这样一个一致矩阵能被看对比其他相似度度量方法独立进行聚类的平均结果,进而评价聚类的好坏.

1 数据预处理

1.1 网页抓取

笔者使用网络爬虫技术抓取5种类型的网页,分别是教育类(edu)、财经类(finance)、健康类(health)、体育类(sports)和军事类(war),每个类别300篇文章,存到.txt文件中.因为计算机并不具备人脑的理解能力.在对文本进行预处理时,需要对文本内容进行分词处理,去除停用词,将其表示成计算机能够理解和计算的模型.

1.2 分词处理

与英文不同,在中文文本中,词与词之间没有用空格来分隔,界限不明显,导致计算机的处理存在较大难度.因此,需要将中文句子拆分为一个个单独的词.

笔者使用ICTCLAS分词系统(又名NLPIR汉语分词系统)对文本进行处理.其基本思想是:对句子进行原子切分,然后进行较为粗糙的N-最短路径切分,找到前N个较为符合要求的切分结果,生成二元分词表,最后得到分词结果[20].

分词前后的对照见图1和图2.

图1 分词前的例子Fig.1 Example before the split

1.3 去除停用词

停用词是指词频过高且没有实质意义的词,或词频很低且不能代表文本主题的词[21].一般地,过滤停用词可以构造停用词表,通过跟读入的文本分词进行对比,若该词在停用词表出现就去除.而且,为了后续程序容易处理,词与词之间采用空行来分隔.

1.4 计算TF-IDF

传统的数据均以结构化的形式而被处理,因此,在满足复杂性能够接受的情况下,需要合理的标示文本.

TF-IDF是在1988年由SALTON提出的实现单词权重最为有效的方法.其中,TF称为词频;IDF是逆文档频率,其大小与一个词的常见程度成反比:如果一个词越常见,则权重越小[22].将这2个值相乘,就得到了一个词的TF-IDF值.

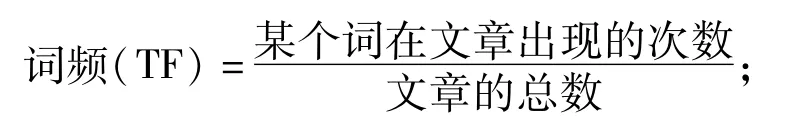

(1)计算词频(TF)

(2)计算逆文档频率(IDF)

逆文档频率(IDF)=

(3)计算TF-IDF

IF-IDF=词频(IF)×逆文档频率(IDF).

1.5 特征选择方法

对特征集中的所有特征计算评分值,得到一个评估分值(又称权值),对其从大到小排序,提取预定数目的最优特征作为提取结果的特征子集,称为特征提取[23].在文本聚类中几种常见的文本监督特征算法包括MI、IG、CHI和WLLR.

假设整个文档集中有N篇文档,其中M篇是教育类的,以下有4个观察值可以使用,即类别和文档数的4种组合(见表1).

表1 类别和文档的组合Table 1 The combination of categories and document

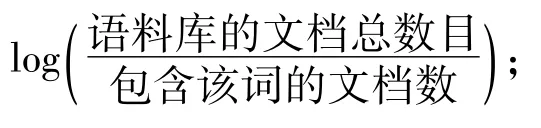

1.5.1 互信息法MI(Mutual Information)

互信息法用于衡量特征词与文档类别直接的信息量.它是根据特征词条t与类别C之间的相关程度来度量特征词条与类别的相关度的,在某个特定的类别中出现的频率高,而在其他的类别中出现的频率较低的词条与该类别的互信息值较大[24].

计算公式:

它不仅能够反映2个变量之间的线性相关性,而且能够反映变量之间的非线性相关性[24].

1.5.2 信息增益法IG(Information Gain)

在信息增益中,衡量标准是看特征能够为分类系统带来多少信息,带来的信息越多,特征就越重要[25].假如有一个特征t,整个系统中某些文本有t和整个系统中没有t时的信息量是不同的,而前后的相差部分就是特征t的信息量,即信息增益.

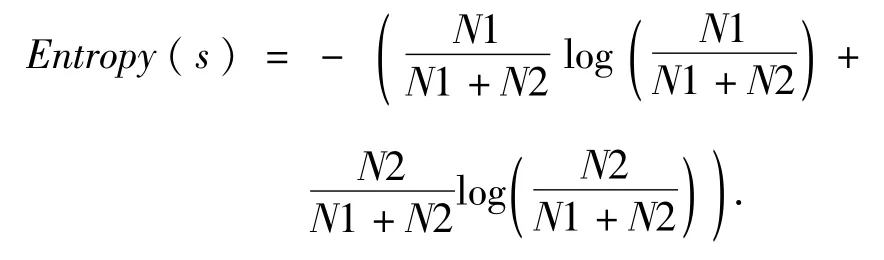

它表示的是包含所有特征时系统的信息量,也叫熵.计算公式:

其中,N1表示正类文档数,数值等于A+C,N2表示负类文档数,数值等于B+D.N1+N2表示总文档数N.

系统中不包含t的信息量,叫做条件熵.

归纳起来,每个词的信息增益计算为

信息增益的缺点在于,它只考虑到特征对系统的贡献,而没有关注到具体的类别[26].虽然能够获得整个文档集中的特征词,但是不能区分不同类别间的特征词的权重.

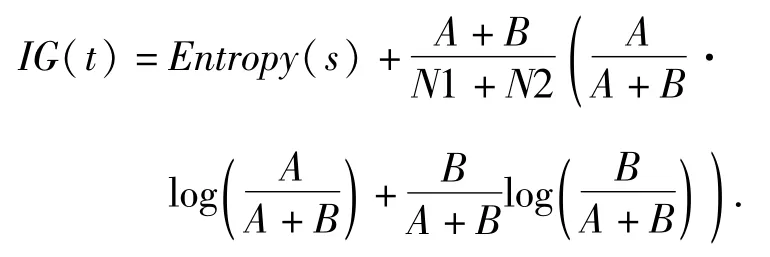

1.5.3 卡方检验CHI(Chi-square)

卡方检验的主要思想:根据实际值与理论值的偏差来确定理论是否正确[27].偏离程度决定卡方值的大小,卡方值越大,越不符合,偏差越小,卡方值就越小,越趋于符合,若量值完全相等时,卡方值就为0,表明理论值完全符合.计算公式:

而不足在于“低频词缺陷”,即不管在文档中出现的次数,而单纯考虑是否出现.

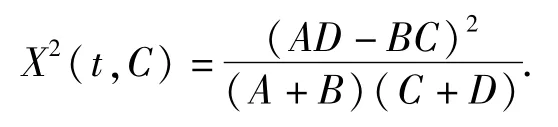

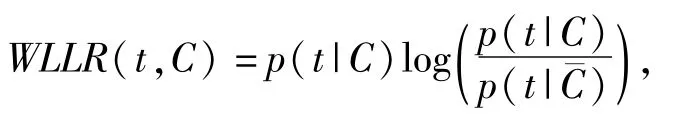

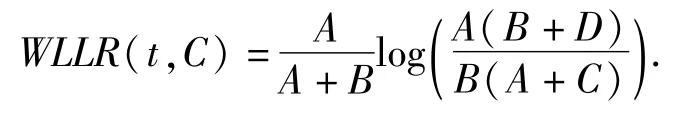

1.5.4 加权对数概率比WLLR(Weighted Log Likelihood Ration)WLLR特征选择方法的定义如下:

其中,p(t|C)表示文档中出现特征词t时属于类C的概率,p(t|C¯)表示特征词t不属于C类的概率.

计算公式:

总之,这些特征选择方法各有优缺.一般而言,CHI、IG的性能明显优于MI;而CHI、IG 2者之间的性能大体相当,都能够过滤掉80%以上的特征项.

2 基于一致近似性的聚类自适应评价指标选择

2.1 传统的聚类分析方法

聚类就是给出一堆原始数据,根据数据对象之间的相似度将数据分成相应的类或簇,类或簇是数据对象的集合.同一个类或簇中的对象应该具有很高的相似度,而不同簇中的对象则高度相异[28].

传统的聚类方法主要分成5大类:划分方法、层次方法、基于密度的方法、基于网格的方法和基于模型的方法[29].

划分方法中,最著名和最常用的划分方法是k均值(又叫k-means算法),k中心点和它们的变种[30].

层次聚类方法将数据对象组成一棵聚类树,将这棵树进行层次的分解.根据层次分解是以自底向上(合并)还是自顶向下(分裂)方式,层次聚类方法可以进一步分为凝聚的和分裂的.一般分为2种类型:凝聚层次聚类和分裂层次聚类[30].

基于密度的聚类方法以数据集在空间分布上的稠密程度为依据进行聚类,无需预先设定簇的数量,因此,特别适合于对未知内容的数据集进行聚类.密度聚类方法可以发现任意形状的簇,克服了那些基于对象之间距离的聚类算法只能发现球状簇的缺点,并且可以过滤孤立点数据或离群点这些“噪声”[30].

2.2 文本相似度衡量

与分类不同的是,聚类是根据一定的相似性定义来划分数据的,因此,需要考虑到聚类时所采用的相似性度量.

本文表示文本的形式是基于向量空间模型的,即一个向量代表一个文档,特征词的权重作为向量的元素.将文档表示成向量空间模型的形式,有利于对文本进行相似度的衡量.

首先,本文的对象是一篇篇.txt文档,也就是比较1 500*1 500个对象的相似度.相似度的衡量通常有2种度量方式:距离度量和相似度度量.

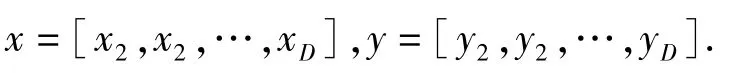

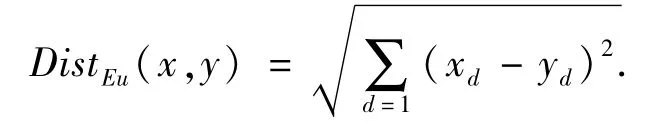

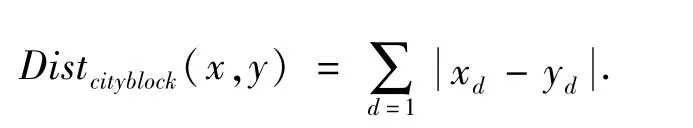

假设要比较数据点集x和y的差异,它们都包含了D个维的特征,即

距离度量用于衡量个体在空间上存在的距离,越远说明个体间的差异越大.常用方法是欧几里得距离和曼哈顿距离.

(1)欧几里得距离.它衡量的是多维空间中各个点之间的绝对距离[31],公式为

(2)曼哈顿距离.是将多个维度上的距离进行求和后的结果[31].

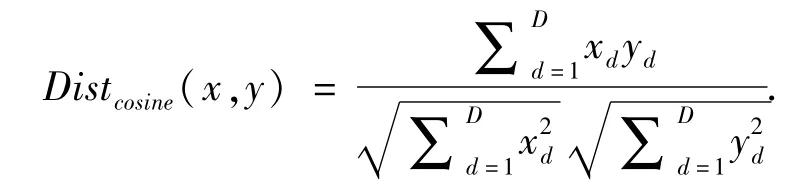

相似度度量,不同于距离度量,它的值越小代表个体间差异越大,越不相似[32].常用的是向量空间余弦相似度和相关距离.

(3)向量空间余弦相似度.它利用向量空间中2个向量夹角的余弦值作为衡量2个个体间的差异大小,相比于距离度量,它更加注重2个向量在方向上的差异,而不是在距离或长度上[33].

(4)相关距离.相关系数ρxy是衡量x与y相关程度的一种方法.相关系数的绝对值越大,表明x与y相关度越高.相关距离的定义则为

2.3 自适应选择方法文本相似度衡量

笔者利用了一种新的相似度衡量方法,叫做Adaptive Metric Selection(AMS),来比较文本的相似度.它是基于划分方法k均值算法的基础上的,采用了一致密切关系来衡量聚类算法的自适应指标选择问题.

k均值算法的基本步骤:给出n个数据对象,从中任意选取k个对象,每个对象都作为一个簇的初始聚类中心.对剩余的n-k个对象,分配到离它最近(最相似)的簇中.然后重新计算每个(有变化)簇的均值(中心对象),更新聚类中心.这个过程不断重复,直到准则函数收敛或者到达某个终止条件[34].

以下给出k均值过程的概述:

算法:k均值

输入:①k:簇的数目;②D:包含n个对象的数据集

输出:k个簇的集合方法:①从D中任意选择k个对象作为初始

簇中心;

②repeat根据簇中对象的均值,将每个对象(再)指派到最相似的簇;

更新簇均值,计算每个簇中对象的均值;

③until簇中心不再发生变化对于各种不同的数据集都使用统一的度量指标是不太合理的.因此在本文中使用一种称为自适应指标的聚类融合方法AMS.

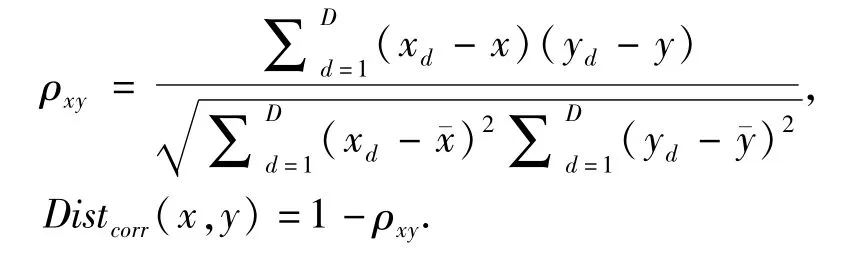

给出一个拥有N个数据点{x1,x2,…,xN}的数据集X,把数据集X分成K个互不相交的簇{A1,A2,…,Ak},一个N×N的Co-association Matrix(M),即互协矩阵,它的构造公式如下所示:

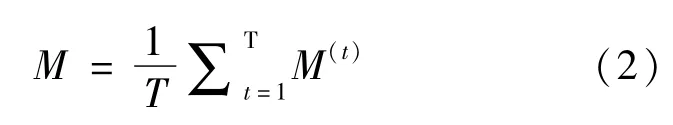

利用多个已经被计算出来的N×N的互协矩阵M,求出它们的均值,构造出相应的Consensus Matrix(M),即一致矩阵.

图3 一致矩阵的构造流程图Fig.3 The flow chart of the structure of the consistent matrix

利用降维后的数据,经过k均值算法得到5个簇,使得1 500篇文章都被分到5个类别中的任意一个.利用这些聚类类别,通过转化把向量矢量转变为矩阵的形式,得到互协矩阵Mv,最后求出互协矩阵的均值融合成一个一致矩阵这个Μ在整个实验中起到一个参考矩阵的作用.

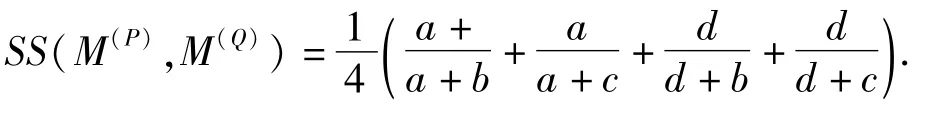

先算出4个待用参数a,b,c,d.

然后利用4个参数计算出SS.

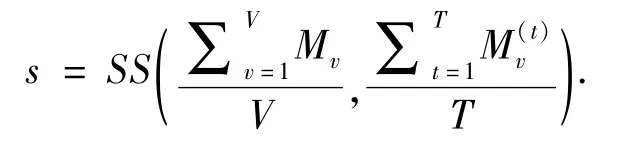

自适应度量选择AMS权值是由以下所有实验各指标中的一致矩阵和互协矩阵Mv之间计算出一致性的.如下所示:

根据自适应度量选择权值从高到低排序出一个指标列表.用公式(3)选出AMS的最好结果并保存下来.

式中表示A(t*)是SS函数中,会产生最大输出的那个参数t.比如有一个函数f(t),t可能的取值范围是{0,1,2},f(t=0)=29,f(t=1)=31,f(t=3)=2.那么y=argmax f(t)=1,也就是t等于1时,f(t)有最大的值.

3 AMS算法的实验开展

3.1 AMS实验前期准备工作

实验环境在MyEclipse10,Matlab7.0环境下进行,实验语料位抓取1 500篇网页正文文本.

(1)数据集:5个特征方法分别经过Isomap降维算法降维后,分别得到1 500*20的矩阵.

(3)k均值的评价指标:4种相似度衡量方法,即①欧几里得距离;②曼哈顿(或城市块)距离;③向量空间余弦相似度;④相关距离.

(4)评估方法:在聚类中,常用作为聚类效果评估的2种指标:①调整后的芮氏指标Adjusted Rand Index(ARI);②标准化互信息Normalized Mutual Information(NMI).

3.2 实验结果及分析

3.2.1 文本样本数据在5种不同文本特征衡量方法下的相似度

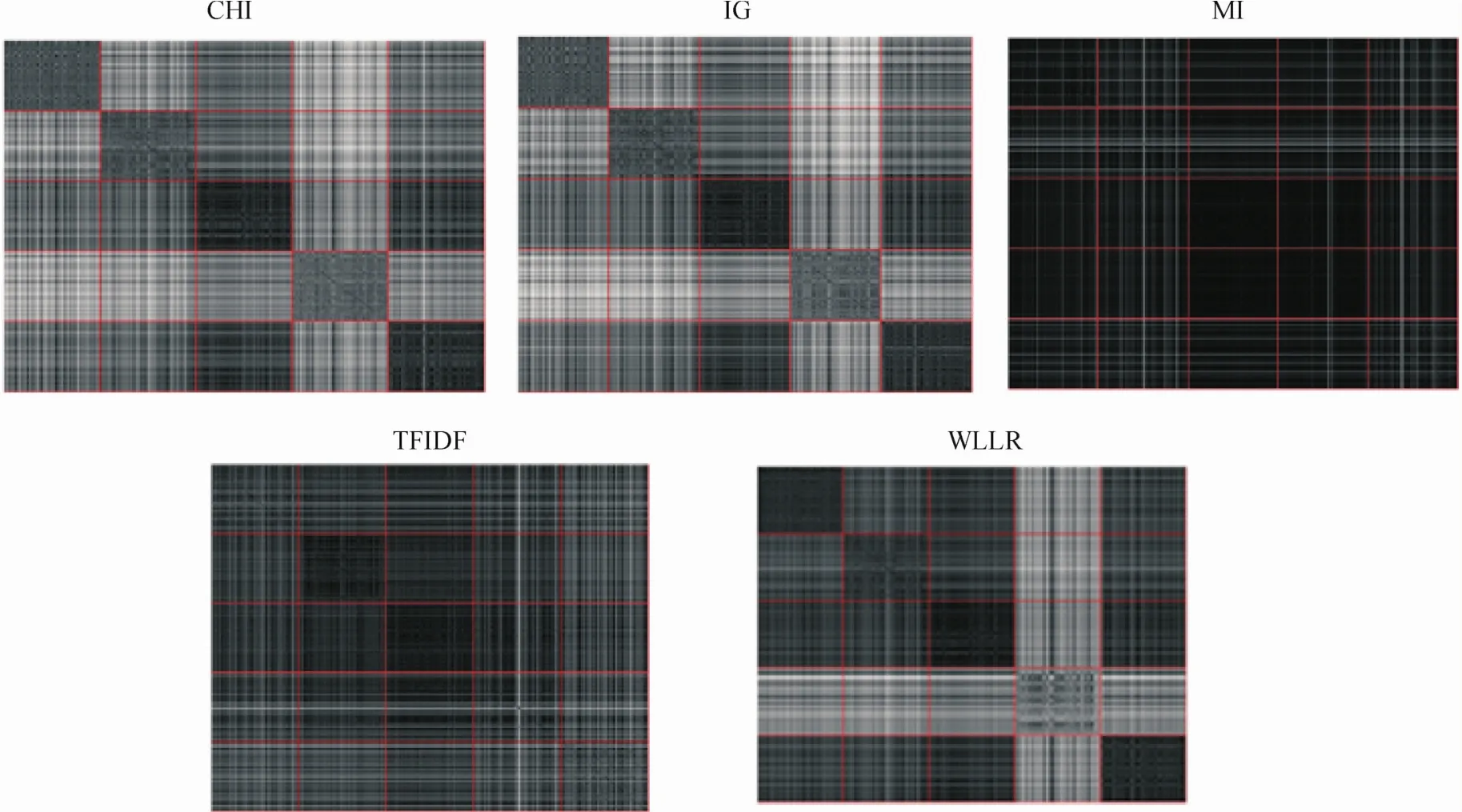

对5种文本特征选择方法画出对应的1 500 *1 500的相似矩阵(见图4),以观察它们的聚类性能.第i行第J列的交叉点表示第i个网页和第J个网页的相似程度,而每个方格代表一个类别.比如第1行第4个方格表示第1类(教育类)和第4类(体育类)的相似度.

图4 文本样本数据在5种不同文本特征衡量方法下的相似度矩阵Fig.4 The similarity matrix of text sample data in 5 different text features

通常,相同的类别之间应该尽可能相似(灰度越深),而不同类别之间则越不相似越好(灰度越淡).反映在上面几幅图中就是,相同类别对应的是大矩阵中向下对角线的5个小矩阵;不同的类别对应的是非向下对角线的其它20个小矩阵.理想情况是,相同类别下的小矩阵越黑越好,表示类别间文本越相似.然而事实并没有达到预期的结果.图4中,WLLR中的第4类明显和所有5个类的相似度很低(包括自身).这表明,单一的特征选择方法还是存在较大的缺陷.

3.2.2 文本样本数据在5种不同文本特征衡量方法下的相似度

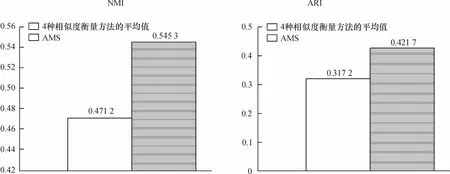

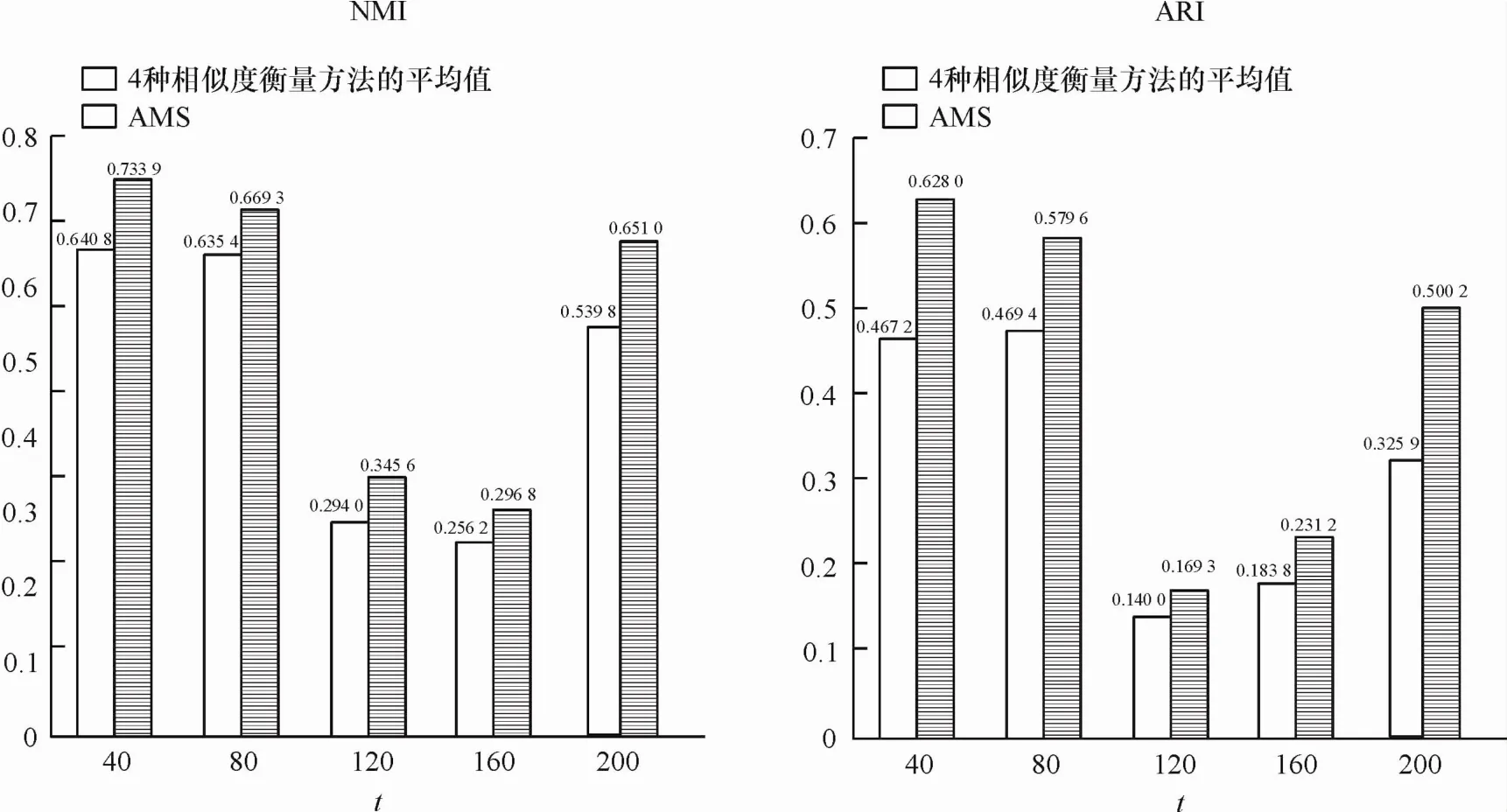

笔者使用2个评价指标NMI和ARI比较自适应选择度量方法AMS和单独使用4种不同相似度衡量方法(欧几里得距离、曼哈顿距离、向量空间余弦相似度和相关距离)进行聚类后的性能,如图5所示.图5中的2个子图中,纵坐标分别表示对应的2种不同聚类性能衡量标准NMI和ARI.从图5可见,使用AMS选择自适应的文本相似度衡量后的聚类效果明显优于单独使用4种不同的相似度衡量方法.笔者也使用实验验证参数选择对AMS算法的影响.AMS只依赖一个参数,即聚类个数T.验证T在不同选择情况下AMS的性能:T=40,80,120,160,200.在图6中比较使用AMS选择自适应的文本相似度衡量方法和单独使用4种不同相似度衡量方法的平均结果的性能.图6中的2个子图中,横坐标表示选择不同的聚类个数T=40,80,120,160,200,纵坐标分别表示对应的2种不同聚类性能衡量标准NMI和ARI.从图6可见,AMS选择的自适应文本相似度衡量方法在不同T的情况下都优于比较对象.

图5 AMS和4种相似度衡量方法的平均值在文本相似度衡量方面的差异Fig.5 Performance comparison between AMS and the average of four individual similarity measures

图6 在不同聚类个数T下基于AMS选择的相似度和单独选择相似度衡量方法的平均值的聚类性能比较Fig.6 Performance comparison between AMS and the average of four individual similarity measures with different numbers of clustering solutions t

结合图5和图6发现,不论是整体结果分析,还是细分T,自适应选择度量方法AMS的聚类效果都超过了4种相似度衡量方法的平均值.这也从侧面反映了使用不同的评估方法对判定结果的重要性.

笔者提出的方法是把多个聚类解决方案作为参考信息并且使用SS方法来进行评估以达成一致性.得益于从一个聚类融合的一致密切关系,自适应选择方法AMS获得显著的改进,明显高于4种相似度衡量方法的平均水平.而且,AMS只需要依赖一个参数——聚类融合解决方案数T.这也大大简化实验的工作量.另外,通过图6可以观察到,对于不同的聚类融合解决方案数T,本文提出的方法均明显高于4种相似度衡量方法的平均水平,这说明本文的方法有较好的鲁棒性,并不依赖于具体参数.

4 结 论

对网页文本聚类问题,本文提出基于信息融合的自适应指标选择方法Adaptive Metric Selection(AMS),并对比了4种距离/相似度方法和AMS在衡量文本相似度方面的差异.在衡量文本相似度中,自适应指标选择AMS相对于4种距离/相似度度量有着比较好的聚类效果.

[1] STREHL A,GHOSH J.Cluster ensembles-a knowledge reuse framework for combining multiple partitions[J].J Mach Learn Res,2002,3:583-617.

[2] FERN X Z,BRODLEY C E.Solving cluster ensemble problems by bipartite graph partitioning[C]∥Proceed 21 Intern Conf Mach Learn,2004:69.

[3] FERN X,LIN W.Cluster ensemble selection[C]∥Proc SIAM Int Conf Data Min(SDM),2008:787-797.

[4] MONTI S,TAMAYO P,MESIROV J,et al.Consensus clustering:a resampling-based method for class discovery and visualization of gene expression microarray data[J].Mach Learn,2003,52(1):91-118.

[5] FRED A,JAIN A K.Combining multiple clusterings using evidence accumulation[J].IEEE Trans Pattern Anal Mach Intell,2005,27(6):835-850.

[6] KUNCHEVA L I,VETROV D.Evaluation of stability of k-means cluster ensembles with respect to random initialization[J].IEEE Trans Pattern Anal Mach Intell,2006,28(11):1798-1808.

[7] AYAD H,KAMEL M S.Cumulative voting consensus method for partitions with variable number of clusters[J].IEEE Trans Pattern Anal Mach Intell,2008,30(1):160-173.

[8] AZIMI J,FERN X.Adaptive cluster ensemble selection[C]//Proceed 21st Intern Jont Confer Artif Intell,2009:992-997.

[9] WU O,HU W,MAYBANK S J,et al.Efficient clustering aggregation based on data fragments[J].IEEE Trans Syst,Man,Cybern B,Cybern,2012,42(3):913-926.

[10]IAM-ON N,BOONGOEN T,GARRETT S.Lce:A link-based cluster ensemble method for improved gene expression data analysis[J].Bioin-Format,2010,26(12):1513-1519.

[11]IAM-ON N,BOONGOEN T,GARRETT S,et al.A link-based approach to the cluster ensemble problem[J].IEEE Trans Pattern Anal Mach Intell,2011,33(12):2396-2409.

[12]WANG T.Ca-tree:A hierarchical structure for efficient and scalable coassociation-based cluster ensembles[J].IEEE Trans Syst Man Cybern B Cybern,2011,41(3):686-698.

[13]ZHANG S,WONG H S.Arimp:A generalized adjusted rand index for cluster ensembles[C]∥Istanbul,Turkey 20th Internat Conf Pattern Recog(ICPR 2010),2010:778-781.

[14]ZHANG S,WONG H S,SHEN Y.Generalized adjusted rand indices for cluster ensembles[J].Pattern Recog,2012,45(6):2214-2226.

[15]ZHANG S,WONG H,SHEN Y,et al.A new unsupervised feature ranking method for gene expression data based on consensus affinity[J].IEEE/ACM Trans Comput Biol Bioinf,2012,9(4):1257-1263.

[16]ZHANG S,WONG H S,SHEN W J,et al.Aors:Affinity-based outlier ranking score[C]∥Neural Netw(IJCNN),2014 Intern Joint Conf IEEE,2014:1020-1027.

[17]TOPCHY A P,JAIN A K,PUNCH W F.Clustering ensembles:Models of consensus and weak partitions[J].IEEE Trans Pattern Anal Mach Intell,2005,27(12):1866-1881.

[18]YU Z,WONG H,WANG H.Graph-based consensus clustering for class discovery from gene expression data[J].Bioinformatics,2007,23(21):2888.

[19]GIONIS A,MANNILA H,TSAPARAS P.Clustering aggregation[J].ACM Trans Knowl Disc Data(TKDD),2007,1(1):4.

[20]刘群,张华平,俞鸿魁,等.基于层叠隐马模型的汉语词法分析[J].计算机研究与发展,2004(8):1421-1429.LIU Q,ZHANG H P,YU H K,et al.Based on layered hidden Markov model of Chinese lexical analysis[J].Comput Res Devel,2004(8):1421-1429.

[21]刘七.基于Web文本内容的信息过滤系统的研究与设计[D].南京:南京理工大学,2004.LIU Q.Research and design of information filtering system based on Web text content[D].Nanjing:Nanjing University of Science and Technology,2004.

[22]卢志翔,蒙丽莉.文本分类中特征项权重算法的改进[J].柳州师专学报,2011(4):128-131.LU Z X,MENG L L.The improvement of feature weight algorithm in text classification[J].J Liuzhou Teach Coll,2011(4):128-131.

[23]杨帆,孙强.从Web网页上获取一价事件常识的方法[J].科学技术与工程,2010(25):6300-6304.YANG F,SUN Q.A method for obtaining knowledge from the Web Webpage event[J].Sci Tech Eng,2010(25):6300-6304.

[24]邓彩凤.中文文本分类中互信息特征选择方法研究[D].重庆:西南大学,2011.DENG C F.Research on feature selection method in Chinese Text Categorization[D].Chongqing:Southwestern University,2011.

[25]彭湘华.基于相关性的癌症特征选择及分类算法研究[D].长沙:湖南大学,2012.PENG X H.Research on correlation based feature selection and classification algorithm for cancer[D].Changsha:Hunan University,2012.

[26]田伟.XML文档分类方法的研究及其应用[D].沈阳:大连理工大学,2009.TIAN W.Research and application of XML document classification method[D].Shenyang:Dalian University of Technology,2009.

[27]王垚尧.基于机器学习的经济行业分类方法研究[D].哈尔滨:哈尔滨工业大学,2011.WANG Y Y.Research based on classification method of economic sectors based on machine learning[D].Harbin:Harbin Institute of Technology,2011.

[28]韩家炜.数据挖掘概念与技术[M].北京:机械工业出版社,2001.HAN J W.Concept and technology of data mining[M].Beijing:Machinery Industry Press,2001.

[29]毛国君.数据挖掘原理与算法[M].北京:清华大学出版社,2005.MAO G J.Principle and algorithm of data mining[M].Beijing:Tsinghua University Press,2005.

[30]TENENBAUM J B,DE SILVA V,LANGFORD J C.A global geometric framework for nonlinear dimensionality reduction[J].Science,2000,290(5500):2319-2323.

[31]马永军,方廷健.基于支持向量机和距离度量的纹理分类[J].中国图像图形学报,2002,7(11):1151-1155.MA Y J,FANG T J.Texture classification based on support vector machine and distance measurement[J].Chin J Imag Graph,2002,7(11):1151-1155.

[32]刘宝生,闫莉萍,周东华.几种经典相似性度量的比较研究[J].计算机应用技术,2006(11):1-3.LIU B S,YAN L P,ZHOU D H.Comparison of several classical similarity measures[J].Comput Appl Tech,2006(11):1-3.

[33]MONTI S,TAMAYO P,MESIROV J,et al.Consensus clustering:A resampling-based method for class discovery and visualization of gene expression microarray data[J].Mach Learn,2003,52(1):91-118.

[34]FERN X,LIN W.Cluster ensemble selection[C]∥Proc SIAM Int Conf Data Min(SDM),2008:787-797.

M etric selection for web text clustering based on information ensembles

ZHANG Shao-hong1,LI Ji-qiao1,LUO Jia-yi1,XIE Dong-qing1,WANG Jing2

(1.School of Computer Science and Educational Software,Guangzhou University,Guangzhou 510006,China;2.Guangzhou Library,Guangzhou 510623,China)

In the current information age,text data grows at a high speed,and it is very hard for people to get useful information from huge data,which is like looking for a needle in a haystack.As the basic method in text mining,text clustering plays a very important role.Without predefined training set,it is one of the most important questions in text mining to select the suitable metric for different text data.Thus,in this thesis,we propose one novel Adaptive Metric Selection(AMS)method.The pipeline of our working includes:①crawling the webpage content to prepare the data source for clustering;②transforming the content to separate words and then to a vector form;③Extracting features;④Reducing dimension using Isomap;and⑤Using an adaptive selection method AMS to evaluate data similarity.K means is used as the basic clustering algorithm,and we use two popular clustering quality measures to evaluate the final results:①Adjusted Rand Index(ARI),and②Normalized Mutual Information(NMI).Simulation results show the effectiveness of our proposed methods compared to the averaged results of different metrics.

data mining;feature extraction;clustering ensembles

TP 181

A

1671-4229(2016)01-0080-10做是一个相似矩阵,并且,这样一个最终的聚类结果能用任意能直接在距离矩阵或相似矩阵上运算的聚类算法获得.基于包含Single Link(SL),Average Link(AL)or Complete Link(CL)的凝聚层次聚类算法的聚类融合方法就是有代表性热门方法.第二类聚类融合方法生成一种基于样本、集合、分区之间的关联的代表性图像,其中这种关联是源于独立聚类结果.在这一类方法中,典型的结果包括Cluster-based Similarity Partitioning Algorithm(CSPA)[19],Meta-CLustering Algorithm(MCLA)[19]和Hybrid Bipartite Graph Formulation algorithm(HBGF)[19].聚类融合方法生成更多较独立聚类结果更稳定且精确的结果.一般需要处理2种相似度衡量:①样本数据之间的相似度衡量方法,通常称为相似度或者距离.样本相似度或距离的选择,会直接影响无监督学习算法的学习结果.②无监督学习得到的样本类别和样本类别参考值之间的相似度,通常成为聚类质量的衡量方法.聚类质量衡量方法的选择,是正确衡量聚类结果的基础.

【责任编辑:陈 钢】

2015-12-21;

2015-12-30

张少宏(1969-),男,副教授,博士.E-mail:zimzsh@qq.com