一种去除虚假边缘的任意视点绘制方法

吕梦春,张晓林

(中国科学院 上海微系统与信息技术研究所,上海 200050)

一种去除虚假边缘的任意视点绘制方法

吕梦春,张晓林

(中国科学院 上海微系统与信息技术研究所,上海 200050)

基于深度图的视点渲染(DIBR)是支撑3D视频服务的一种重要技术。为了解决任意视点绘制结果中常出现的虚假边缘问题,本文在前向映射过程中采用了一种深度图不连续区域检测的算法,且在后向映射过程为了节省计算成本仅对必要的像素点集处理,并对alpha融合后的图像进行纹理修复,获得了高质量的视点绘制结果。实验证明,在微软提供的多视点数据集上测试得到PSNR和SSIM指标都优于DIBR标准参考方法的处理结果。

视点渲染;深度图;DIBR;多视点

裸眼3D电视技术[1]将成为下一代视频技术的重点。为了能达到裸眼自由观看的目的,自由视点技术(FTV)应运而生。显然,单纯采用多视点拍摄的方式(MVV),不仅占用内存太多,传输时也需要高带宽。基于深度图的视点渲染技术[2-4](DIBR)一方面能在视点间流畅的完成新视点绘制,也另一方面能节省带宽和内存,是目前国际上公认的自由视点3D电视视频信息传输的解决方案。

DIBR方法要求多视点深度图和纹理图图像对作为其3D数据表示。深度图表示了3D场景的表面结构信息和每个像素点到实际物体之间的距离信息。这种数据能直接从深度摄像机获取或者以立体匹配[5]的方式从纹理图像对推算出来。当前基于深度图的视点渲染技术存在的问题主要有视点映射之后像素坐标取整造成的误差、被遮挡物体重现后的空洞填补、前景和背景交接处的虚假边缘等。相关研究表明,对映射后的深度图进行双边滤波器处理[6]的方法会给整幅图像造成模糊,而利用深度信息进行纹理填补的算法[7-10]在填补过程中要花费较多计算成本来修复深度图,此外,利用显著性信息[11]的纹理填补方式也在一定程度上能填好重现(disocclusion)区域。

文中分析了前景和背景交界处的虚假边缘产生的原因,并采用了一种深度图预处理的方式即基于深度图不连续区域检测的方法来解决此问题,搭建了整个视点绘制框架,最后从主观视觉和客观评价两方面验证了本方法的有效性。

1 系统概览

整个DIBR框架主要包括5部分:多视点图像对获取,深度图预处理[12],视点转换,图像融合以及纹理图修复[13-14]。获取的多视点图像对通常作为参考视点来重建虚拟视点的纹理图和深度图。文中选取自由设定的视点左右两边的相机作为参考视点,目的是绘制出虚拟视点高质量的纹理图,其基本流程图如图1所示。视点转换过程中尽管采用了Z-Buffer的方式选择靠近相机的像素信息,在前景物体上仍出现较为严重的虚假边缘。去除虚假边缘的图像后处理方式如膨胀腐蚀等稳定性不高,本文对深度图进行预处理,即检测深度图不连续区域。检测的区域在前向视点转换过程中有选择性的被略过,尽管此时造成了较大的空洞,但是保证了映射后前景物体边缘信息的准确性。在反向映射时,即逆向视点转换过程中,为了节省计算成本仅映射中值滤波后深度值有改变的像素点纹理信息。重现区域属于背景信息,在图像融合过程中左右两路视频背景相互补偿使得虚拟视点重现区域纹理有可靠的恢复。此时还有一部分信息不完整,可采用纹理图修复的方式进行填补,最终绘制出高质量的虚拟视点纹理图。

图1 DIBR视点绘制流程图

2 任意视点绘制

2.1 视点转换关系

视点转化关系,即三维空间映射关系是整个基于深度图的视点绘制(DIBR)框架的基石,包括前向映射和反向映射两种。从参考视点到虚拟视点的转换称为前向映射,而从虚拟视点返回参考视点则是反向映射。

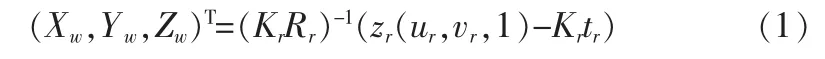

当相机坐标系和世界坐标系重合时可认为旋转矩阵Rr为3×3的单位矩阵而平移矩阵tr为零向量。而内参矩阵Kr代表相机结构信息。已知参考视点像素p(ur,vr)和其对应深度图上的深度值zr,通过公式(1)能计算得到空间中对应三维点的坐标P(Xw,Yw,Zw)。

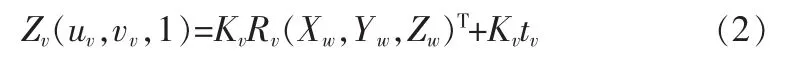

设定好虚拟相机的位姿以后,获取其相对参考相机的旋转矩阵Rv和平移矩阵tv,就能将点空间点P重新投影到虚拟视点平面上并通过公式(2)得到每一个像素的坐标(uv,vv)。其中Kv为虚拟相机的内参。

这种像素级点对应的映射方式实现了视点转换,保持了场景中物体的纹理信息一致性。在前向视点转换实际过程中需要根据该像素是否属于深度不连续区域来判断是否执行空间映射。

2.2 深度图区域检测

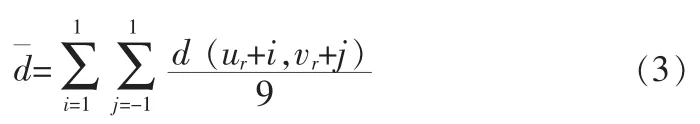

在深度图像中,可认为局部区域的深度值差异较小时该区域属于同一块前景或背景区域。而当局部深度值差异明显时可以认为该像素点处在前景和背景交界处。通过设定深度区域阈值,可检测出参考视点深度图中的不连续区域。具体计算方式如下:d(ur,vr)为深度图上某一点的坐标,在其3×3邻域内以公式(3)计算区域深度均值,并得到两值的差Δd=-d(ur,vr)。当Δd大于阈值Thred时则认为该点属于不连续区域。通常Thred根据整幅深度图的深度值设定,这里选为10。

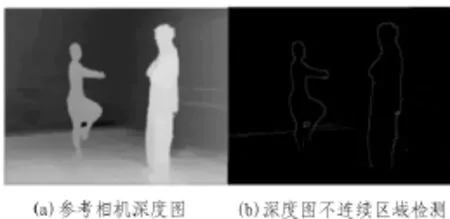

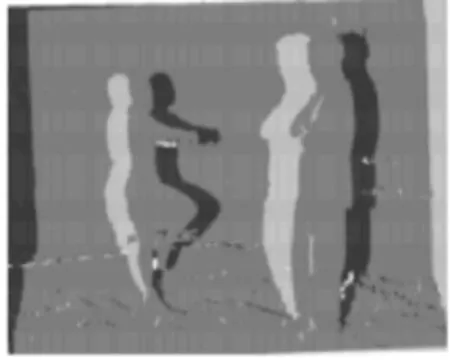

深度不连续区域如图2(b)中白线所示,在前向映射时,那些深度不连续区域被略过,仅映射深度连续区域的像素点集。当虚拟视点中某一坐标有多个深度值的像素点对应时,采用Z-Buffer技术仅选取深度值最小的像素点。这时获取到虚拟视点的纹理图和深度图会有很多空缺。由于参考视点纹理图信息是完整的,中值滤波后的虚拟视点深度图能应用在反向映射过程中,填补了纹理图中前景和背景区域内部的单像素宽度的缝隙。为了节省计算量,反向映射时仅对深度图中深度值有改变的点集进行反向恢复纹理信息,图3中白色部分标记了这个点集。

图2 深度不连续区域检测示意图

图3 中值滤波中深度值有改变的点集

2.3 图像融合

绘制中间视点时,该视点有左右两路参考视点的信息。因为在左右视点中有互补的背景区域,即从左边往中间视点映射时,虚拟视点前景靠左边空缺区域较大,该部分能被右边的视点看得并融合到最终视点上,对于右边往中间视点映射时则同理。

图4 区域标记

图4 中用4种不同颜色区分了融合图像区域的不同像素信息来源,其中浅白色代表只来自右边视点的像素信息,深色代表只来自左边视点的像素信息,灰色则代表左右两视点都有的像素信息,白色代表空缺的像素信息。

对于左右参考视点都能提供信息的像素点,其像素值采用alpha融合方式获得。两个参考相机与虚拟相机平移向量距离分别为dl和dr,其中图像融合系数α由dl/dl+dr决定。

2.4 融合区域填补

因为左右两边绘制的视点融合以后所剩下的空缺比较少,文中采用基于样本块纹理综合的图像修复技术Criminisi算法[14]对这些区域的纹理信息进行修复。

图5 Criminisi填补算法示意图

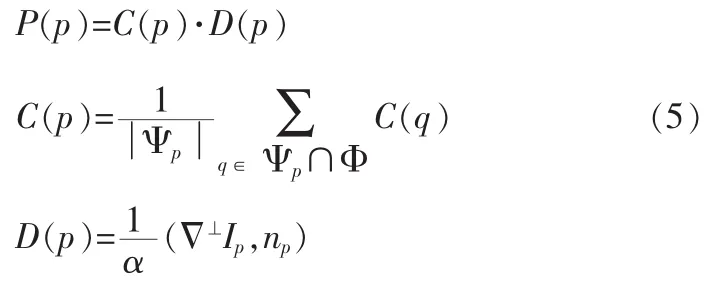

图5 整个区域为图像I,其中Ω代表需要填充的空缺区域Φ=I-Ω,而原始数据区域。δΩ是空缺区域的边缘,Ψp是中心像素为p的目标区域匹配块,包含了原始数据区域和空缺区域。相关研究表明填补顺序对保持物体边缘结果信息有重要作用,Criminisi算法使用了置信项C(p)和数据项D(p)的乘积来代表填补顺序的先验P(p)。置信项C(p)表示当前块

的可信度,而数据项D(p)代表当前像素点的等照度方向。以优先级确定像素点p以后,使用块匹配的方式找到与以p为中心块P最相近的块Q。其相似性准则为SAD,取值越小代表越相近,并用块Q填补块P。每进行一次填补之后更新填补顺序的先验P(p),然后迭代匹配至空缺像素都被填补完整。

3 实验结果和分析

文中在Matlab环境下编写代码,在MSR提供的Ballet和Breakdancers多视点序列[15]上验证了算法的有效性。该数据集图像分辨率为1024×768,获取帧率为15 fps,共提供了100帧的图像数据和8个相机的参数。

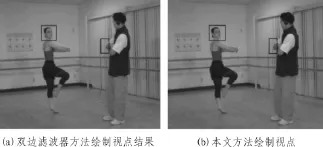

Y.Mori的双边滤波器处理算法是DIBR的标准参考方法,在结果比较中作为参照来说明本方法的有效性。以Ballet序列第56帧视点绘制结果来看,本文结果图6(b)中前景的边缘是单一的,去除了双边滤波器方法中虚假边缘。

图6 绘制结果在主观视觉上的比较

图7 PSNR结果比较

如图7所示,左右两图分别是在Ballet和Breakdancers序列上对100帧图像计算真实视点和虚拟视点图像的PSNR值得到的曲线,PSNR值越高表明两张图像越相似。其中由x连接的曲线代表本文算法结果,比Y.Mori的双边滤波器处理算法结果即由o连接而成的曲线绘制质量高,Ballet序列上平均提升了1.99 dB,而在Breakdancers序列上平均提升了0.86 dB。

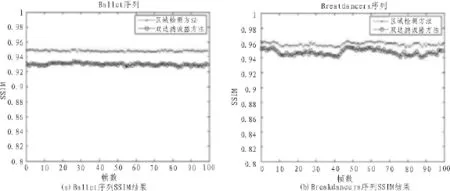

文中也依据准则SSIM[16-17]计算了真实视点和虚拟视点图像间的结构相似性,其值接近1代表结构保存得完整。图8显示出本文算法在这种标准下也优于基于双边滤波器的算法。

4 结论

文中分析了前景和背景交界处虚假边缘的问题,确认该问题是映射过程中边缘处的景深处理不当造成的,并搭建了整个绘制框架用深度图预处理的方式基本解决了这个问题,通过本方法的处理,使多视点图像可以让观众在主观上感觉到了观看质量的提升,并且在MSR的图像序列上验证了该算法的鲁棒性,有效的避免了最终绘制视点中前景边缘处的虚假边缘。

图8 SSIM结果比较

[1]Fehn C.Depth-image-based rendering(DIBR),compression and transmission for a new approach on 3D-TV[J].Proceedings of SPIE-The International Society for Optical Engineering,2004(5291):93-104.

[2]Kauff P,Atzpadin N,Fehn C,et al.Depth map creation and image-based rendering for advanced 3DTV services providing interoperability and scalability[J].Signal Processing Image Communication,2007,22(2):217-234.

[3]Kang S B.A survey of image-based rendering techniques[J].Videometrics Spie,1997(3641):2-16.

[4]Szeliski R S,Salesin D,Schödl A.Video-based rendering: IET,US 6636220 B1[P].2003.

[5]Scharstein D,Szeliski R.A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[C]//Stereo and Multi-Baseline Vision,2001.(SMBV 2001).Proceedings.IEEE Workshop on.IEEE,2001:131-140.

[6]Mori Y,Fukushima N,Yendo T,et al.View generation with 3D warping using depth information for FTV[J].Signal Processing Image Communication,2009,24(S1-2):65-72.

[7]Daribo I,Pesquet-Popescu B.Depth-aided image inpainting for novel view synthesis[C]//Multimedia Signal Processing(MMSP),2010 IEEE International Workshop on.IEEE,2010:167-170.

[8]Oh K J,Yea S,Ho Y S.Hole filling method using depth based in-painting for view synthesis in free viewpoint television and 3-D video[C]//Picture Coding Symposium.

[9]Yang X,Liu J,Sun J,et al.DIBR based view synthesis for free-viewpoint television[C]//Proceedings of the 3DTV Conference,The True Vision-Capture,Transmission and Display of 3D Video(3DTV-CON),2011:1-4.

[10]Do L,Zinger S,Morvan Y,et al.Quality improving techniques for free-viewpoint DIBR[J].Proceedings of SPIEThe International Society for Optical Engineering,2009(7524):1-4.

[11]Macchiavello B,Dorea C,Hung E M,et al.Low-saliency prior for disocclusion hole filling in DIBR-synthesized images[C]//Acoustics,Speech and Signal Processing(ICASSP),2014 IEEE International Conference on.IEEE,2014: 579-583.

[12]Zinger S,Do L,With P H N D.Free-viewpoint depth image based rendering.[J].Journal of Visual Communication& Image Representation,2010,21(S5-6):533-541.

[13]Alexandru Telea.An image inpainting technique based on the fast marching method[J].Journal of Graphics Tools,2004,9(1):23-34.

[14]Antonio C,Patrick P,Kentaro T.Region filling and object removal by exemplar-based image inpainting.[J].IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society,2004,13(9):1200-1212.

[15]Zitnick C L,Kang S B,Uyttendaele M,et al.High-quality video view interpolation using a layered representation[J].Acm Transactions on Graphics,2004,23(3):600-608.

[16]Zhou W,Alan Conrad B,Hamid Rahim S,et al.Image quality assessment:from error visibility to structural similarity[J].IEEE Transactions on Image Processing,2004,13(4):600-612.

[17]艾超,胡方明.消除脉冲噪声的改进自适应滤波算法[J].电子科技,电子科技,2013(2):5-9.

A method of ghost contour removal for Free-viewpoint

LV Meng-chun,ZHANG Xiao-lin

(Chinese Academy of Sciences Shanghai Institute of Microsystem and Information Technology,Shanghai 200050,China)

Depth ImageBased Rendering(DIBR)technique has been recognized as the most important technique to provide 3d video services.In order to remove the ghost contours in the final rendered view,this paper proposed a depth-based discontinuous region detection algorithm in the forward warping process,and then process the changed pixels in the inverse warping,finally inpaint the alpha blended view to obtain high-quality virtual view.Experiments show that the results of PSNR and SSIM metrics outperform that of the standard reference method on the multi-view dataset provided by Microsoft Research.

view rendering;depth map;DIBR;multi-view

TN919.82

A

1674-6236(2016)15-0187-04

2016-01-08 稿件编号:201601049

上海张江国家资助创新示范区专项发展资金(ZJ2015-ZD-001)

吕梦春(1990—),男,湖北武汉人,硕士研究生。研究方向:图像处理、3D视频。