基于图像特征激励的自适应PCNN红外与可见光图像融合方法*

莫 毅,郭 蓉

(1.广西工业职业技术学院,南宁530001;2.四川理工学院自动化与电子信息学院,四川自贡643000)

基于图像特征激励的自适应PCNN红外与可见光图像融合方法*

莫毅1*,郭蓉2

(1.广西工业职业技术学院,南宁530001;2.四川理工学院自动化与电子信息学院,四川自贡643000)

为了弥补传统图像融合技术存在的对比度较低以及细节处理不全面的缺陷,针对红外和可见光图像融合算法进行了研究。主要研究了利用MATLAB软件实现对红外和可见光图像的处理和融合,采用对应像素取大值、取小值、平均值,区域能量、区域对比度比较的融合方法,并且对融合结果图像使用信息熵、标准差等评价指标进行了分析比较。结果表明,融合结果图像既保留了可见光图像的清晰的轮廓信息,同时也显示了目标物体的表面温度分布情况。

图像融合;非下采样Contourlet变换;脉冲耦合神经网络;性能评价

随着科学技术的不断发展,红外成像技术亦得到了较快的发展,国内外学者对于此类的图像采集、成像技术的融合进行了大量广泛的研究[1],文献基于小波成像算法对采集的图片进行各种不同分辨率的图像性质以图像采集的部分局部性质进行了分析。但是小波算法对所采集的图像只能是进行三维操作-在x、y、z轴的方向上进行图像信息采集并对其进行变换,因此,小波变换并不能全面的表达出图像的所有特征信息,小波变换在融合变换图像的过程中,不可避免的存在一定的图像匹配误差,对图像融合精度造成较大的影响。

Do M N等人[2]在前人研究的基础上,在二维平面上建立了一种新的图像识别融合方法-Contourlet变换CT(Contourlet Transform),在CT中,由于拉普拉斯金字塔变换和方向滤波器都存在下采样操作,这就造成了CT算法对所采集的图像进行平移时具有时变性,这就使得平移前后的图像出现差异,会产生吉布斯现象,使得所采集的图像严重失真。为解决CT的不足,Cunha A L等采用à-Trous算法的思想,通过综合非下采样的塔式分解理论。建立了NSCT图像融合算法。NSCT除了具有CT融合算法的多尺度以及多测度方向的优势外,还具有融合图像平移稳定性,即在平移图像时不发生改变,这些优点均能提高在图像融合过程中的稳定性。

随着生物神经学的研究和发展,Hodgkin[3]与Huxley开始研究神经元电化学特性。Johnson[4-6]阐述了PCNN的周期波动现象及在图像处理中具有旋转、可伸缩、扭曲、强度不变性。通过对Eckhorn提出的模型进行改进,就形成脉冲耦合神经网络(PCNN)模型。为了更进一步提高性能,必须降低计算复杂度,即要减少神经元连接数。Ekblad U和KinserJ M提出了交叉皮层模型ICM(Intersecting Cortical Model)提高图像处理的速度。

为了将NSCT和PCNN算法的优点最大化发挥出来,使得在图像融合过程中,图像信息处理得更加科学合理,失真率大幅下降,本文基于NSCT算法提出一种脉冲耦合神经网络(PCNN)算法,此种算法将红外成像技术与可见光成像技术完美融合,大大提高了图像融合过程中图像的转换质量。

1 算法原理

1.1非下采样Contourlet变换

Contourlet变换[7]就是由LP和DFB两部分结合而成的,是一种双重迭代滤波器组结构,它可以把图像在多尺度上分解为许多方向子带,如图1所示。从滤波器角度上来看,Contourlet变换先由LP分解为低频子带和高频子带。其中低频子带是由原始图像经过二维低通滤波和隔行隔列下采样产生的;低频子带经过上采样和低通滤波后形成与原始图像尺寸相同的低频分量,原始图像减去这个低频分量后形成高频子带。高频子带再经过方向滤波器组分解为2i个方向子带(i为任意正整数)。对低频子带重复上述过程可实现图像的多分辨率多方向分解。在实现Contourlet变换时,LP的分解滤波器组和重构滤波器组为二维可分离双正交滤波器组,它们的带宽均大于π/2。

图1 Contourlet分解的示意图

1.2PCNN模型

小波变换方法针对性都很强,根据不同情况采用不同的融合规则[8]。基于神经网络方法对输入不同类型的图像得到的融合结果不会有很大差别,且其融合规则往往简单易行,故基于神经网络的融合算法适应性要更好一些。因此将具有生物学背景的PCNN神经网络应用到图像融合中。

图2PCNN模型

(1)对每一幅图像分别进行两层小波提升分解,提取图像的近似细节、水平、垂直、对角方向的小波系数矩阵。

(2)对低频和高频子图像分别采用改进的PCNN网络,PCNN网络大小与相应子图像大小相同,每个PCNN内的所有神经元均采用8邻域连接方式。

(3)将来自图像A和B的子图像分别输入相应的PCNN网络,并按照如下步骤进行融合处理:初始化。设和分别表示第k对子图像中像素(i,j)的灰度值,将其归一化到0~1范围内,令内部链接输入矩阵、内部行为矩阵和阈值矩阵的初值分别为:,此时,所有神经元都处于熄火状态:,Nmax为最大迭代次数,点火时刻记录矩阵。

重复步骤(2)和步骤(3)直到,此时网络迭代运行停止。

2 融合方法

2.1图像融合规则

在图像融合中,融合规则[9-13]的选取对融合图像的质量有着重要的影响,对于多分辨率图像融合规则和基于区域的融合规则。

(1)基于像素选取的融合规则,在将原图像分解成不同分辨率图像的基础上,选取绝对值最大的像素值(或系数)作为融合后的像素值(或系数)。这是基于在不同分辨率图像中,具有较大值的像素(或系数)包含更多的图像信息。

(2)考虑分解层内各图像(若存在多个图像)及分解层间的相关性的像素选取融合规则。在应用小波变换进行图像融合时,根据人类视觉系统对局部对比度敏感的特性,采用了基于对比度的像素选取融合规则。

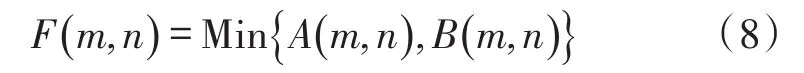

(3)基于像素的融合选取仅是以单个像素作为融合对象,它并未考虑图像相邻像素间的相关性,因此融合结果不是很理想。考虑图像相邻像素间的相关性,出现了基于区域特性选择的加权平均融合规则,将像素值(或系数)的融合选取与其所在的局部区域联系起来。

(4)在选取窗口区域中较大的像素值(或系数)作为融合后像素值(或系数)的同时,还考虑了窗口区域像素(或系数)的相关性,通过计算输入原图像相应窗口区域中像素绝对值相比较大的个数,决定融合像素的选取。基于窗口区域的融合规则由于考虑相邻像素的相关性,因此减少了融合像素的错误选取,融合效果得到提高。

(5)基于区域的融合规则,将图像中每个像素均看作区域或边缘的一部分,并用区域和边界等图像信息来指导融合选取。采用这种融合规则所得到的融合效果较好,但此规则相对其他融合规则要复杂。对于复杂的图像,此规则不易于实现。

2.2图像融合方法

图像融合方法[14]是不对参加融合的各源图像进行任何图像变换或分解,直接以原图像为研究对象,运用各种融合规则进行图像融合,也可以称作简单的多传感器图像融合方法。该方法是早期的图像融合方法,由于其原理简单易懂,计算量小,也是目前应用最多的图像融合方法,同时在多尺度分解的图像融合方法中的一些尺度上其融合规则往往借鉴简单的图像融合方法。它的基本原理是直接对各源图中的各对应像素分别进行灰度选大、灰度选小、灰度加权平均等简单处理后融合成一幅新的图像。图3描绘出了基于像素的图像融合方法。

图3 基于像素的融合规则

2.2.1像素灰度值选大图像融合方法

以两幅图像融合为例说明图像融合过程及融合方法。对于3个或多个源图像融合的情形,可以类推。设参加融合的两个原图像分别为A、B,图像大小为M×N,经融合后得到的融合图像为F,那么对A、B两个源图像的像素灰度值选大图像融合方法可表示为:

式中:m为图像中像素的行号,n=1,2,…,m;n为图像中像素的列号,n=1,2,…,n。

这种融合方法只是简单地选择参加融合的原图像中灰度值大的像素作为融后的像素,对参加融合的像素进行灰度增强,因此该融合方法的实用场合非常有限。

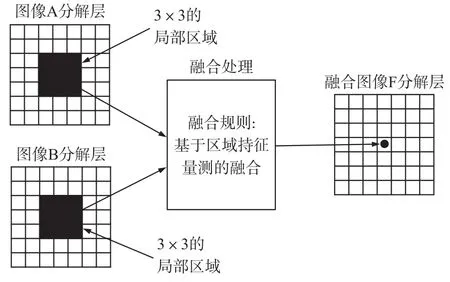

2.2.2像素灰度值选小图像融合方法基于像素的灰度值选小图像融合方法可表示为:

式中:m为图像中像素的行号,n=1,2,…,m;n为图像中像素的列号,n=1,2,…,n。

这种融合方法只是简单地选择参加融合地原图像中灰度值小的像素作为融合后的像素,与像素灰度值选大融合方法一样,该融合方法的实用场合也很有限。

2.2.3对应像素取平均值融合方法

基于对应像素取平均值的图像融合方法可表示为:

式中:m为图像中像素的行号,n=1,2,…,m;n为图像中像素的列号,n=1,2,…,n。

即在融合处理时,将图像A和B中对应位置(m,n)处像素的灰度值相加,取灰度值的平均值作为融合图像F在位置(m,n)出的像素。这种融合方法相对简单,融合后的图像可靠性不高。

2.2.4对应像素取加权平均值融合方法加权平均融合过程可以表示为:

式中:m为图像中像素的行号,n=1,2,…,m;n为图像中像素的列号,n=1,2,…,n;ω1为加权系数1;ω2为加权系数2;通常,ω1+ω2=1。

图像灰度值的平均可看作灰度值加权的特例(ω1=ω2=0.5)。多数情况下,这种加权平均融合的方法中,参加融合的图像提供的冗余信息,通过这种融合可以提高检测的可靠性。

2.2.5基于区域能量比较的融合方法

区域能量是指以图像A和图像B中对应位置(m,n)处像素的灰度值为中心,将图像矩阵分割成为很多小的矩阵(本文中分割为3×3的矩阵)和,再将分割后的矩阵求其元素的平方和为:

区域能量取大的图像融合:

图4 基于区域的融合示意图

区域能量取小的图像融合:

式中,X表示大小为M×N的区域,X(i,j)表示区域X中像素点(i,j)的灰度值,X表示区域。

基于区域能量融合后的图像包含更多的图像信息。

2.2.6基于区域对比度比较的融合方法

一般地,图像对比度C定义为:

式中,L表示图像局部亮度(即局部灰度),LB表示图像的局部背景亮度(相当于局部低频分量),则LH=L-LB相当于局部高频分量。基于图像对比度的概念,定义图像中各像素的清晰度如下:

式中,N(x,y)为以像素(x,y)为中心定义的矩形窗口(一般较小,本文为3×3像素)。CI( )x,y越大,说明原图像I中像素(x,y)所在局部区域对比度越大,清晰度越高。

根据各像素的清晰度量测,可以近似确定哪些像素是属于图像中的清晰度域,哪些像素是属于图像中的模糊区域,融合过程就是图像中属于清晰区域的像素的图像变换系数进行组合。基于区域对比度比较的融合图像过程定义如下:

考虑到相邻像素的相关性,以下情况出现的可能性较小:组合后某图像变换系数来自于图像IA变换后的系数而其相邻像素组合后的系数大多数来自于图像IB变换后的系数,反之亦然,所以要对组合后的图像变换系数进行一致性检验以保证某像素组合后的图像变换系数与其相邻像素组合后的系数大多数来自于同一幅图像经图像变换后的系数。人眼的视觉系统,对于图像的对比度变化十分敏感,而且,根据生理学研究成果,对于黑白图像,人眼视觉系统实际上是对图像的局部对比度敏感,局部对比度的变化反映了图像内各个对象的差异。同时,对比度的定义包含了图像的高频信息及其相对于背景的强度。鉴于此,采用基于对比度的判据可以获得更加符合生理视觉的效果。

3 实验结果与分析

3.1图像融合方法性能评价

在说明客观评价法之前先假设一些基本参数。设经过严格配准的源图像为A和B,其图像函数分别为A(x,y)、B(x,y)。图像A和B具有相同的灰度级(假设都是256级灰度图像),设图像的总的灰度级为L。由源图像经过融合得到的融合图像为F,其图像函数为F(x,y)。所有图像的大小都是一样的。设图像的行数和列数分别为M和N,则图像的大小为M×N。

下面详细介绍图像的客观评价法[15]:

3.1.1信息熵E

图像的熵值是衡量图像信息丰富程度的一个重要指标,熵值的大小表示图像所包含的平均信息量的多少。对于一幅单独的图像,可以认为其各像素的灰度值是相互独立的样本,则这幅图像的灰度分布为。 pi为灰度值等于i的像素数与图像总像素数之比,L为图像的总的灰度级。融合前后的图像的信息量必然会发生变化,计算信息熵可以客观地评价图像在融合前后信息量的变化。根据Shannon信息论的原理,一幅图像的信息熵为:

式中:H表示像素的熵,L表示图像的总的灰度级数,pi表示灰度值为i的像素数Ni与图像总像素N之比。

3.1.2平均梯度G¯

平均梯度可敏感地反映图像对微小细节反差表达的能力,可用来评价图像的清晰程度,同时还反映出图像中微小细节反差和纹理变换特征。设F是大小为M×N的图像,F在位置(i,j)处的灰度值为F(i,j),平均梯度计算方法如下:

3.1.3标准差

标准差反映了图像灰度相对于灰度平均值的离散情况,在某种程度上,标准差也可用来评价图像反差的大小。若标准差大,则图像灰度级分布分散,图像的反差大,可以看出更多的信息。标准差小,图像反差小,对比度不大,色调单一均匀,看不出太多的信息。标准差定义为:

式中,μ为图像的均值,F(i,j)为图像F在(i,j)处的灰度值,图像大小为M×N。

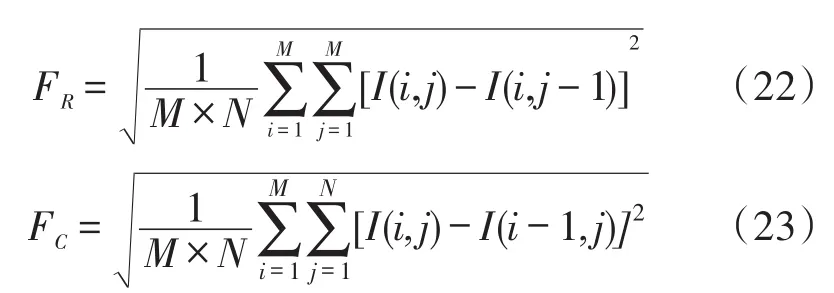

3.1.4空间频率

空间频率反映了一幅图像空间域的总体活跃程度,空间频率越大,图像越清晰。其公式为:

式中:FR为图像的行频率,FC为图像的列频率,且

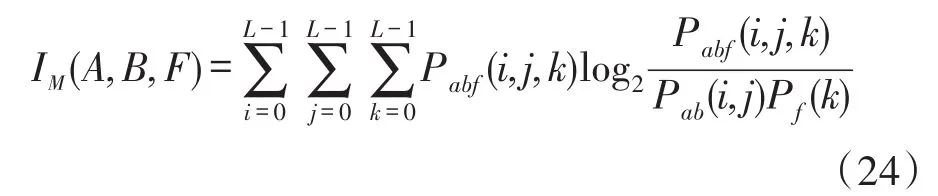

3.1.5互信息量(也称相关熵)

互信息量也是信息论中的一个重要概念。互信息量越大,说明融合图像从原始图像中提取的信息越多,融合效果越好。图像A,B,F间的互信息量IM(A,B,F)定义如下:

式中,Pab(i,j)为待融合图像A,B之间的联合灰度分布,Pabf(i,j,k)为待融合图像A,B和融合图像F 3幅图像之间的联合灰度分布。

以上我们介绍了评价图像融合质量的常用指标。它们是从不同的侧面刻画图像融合后的效果。具体到每个指标,其融合图像质量的评价准则如下:

(1)融合图像的熵越大,可以认为融合图像的信息量增加,融合图像所含的信息越丰富,融合质量越好;

(2)一般来说,平均梯度G¯越大,层次越多,表示图像越清晰;

(3)交叉熵可用来度量两幅图像间地差异,交叉熵越小,表示图像间地差异越小;

(4)联合熵EU的值越大,则图像所包含的信息越丰富,因此可以用它来评价融合图像信息增加程度;

(5)标准差大,则图像灰度级分布分散,图像的反差大,可以看出更多的信息,标准差小,图像反差小,对比度不大,色调单一均匀,看不出太多的信息;

(6)QAB/F指标越大说明融合图像保留的源图像边缘信息越多,融合性能越好。

Matlab[16]是图像处理的一项重要工具,其封装了一系列算法函数,提高了图像处理速度和效率。因此,本文图像处理过程中,使用Matlab工具箱进行进行图像融合。

本文共使用一组可见光与红外图像,分别通过对应像素取大值和取小值、对应像素取平均值和加权平均值、基于区域的能量和对比度融合方法实现图像融合,其实验结果如下,并且根据上一节的评价方法对融合图像进行了客观的融合质量评价,详见表1。

表1 融合结果图像评价

由融合结果图像和表1可以看出基于区域能量的融合方法优于对应像素的融合方法。基于区域能量取大的融合方法所得到的图像质量最好,信息熵、标准差、平均梯度、空间频率的值最大,融合图像所含的信息丰富,图像清晰。

对应像素融合的方法中,对应像素取平均值的方法融合的结果图像质量最差,包含的信息不够丰富,图像模糊。对应像素取加权平均值的方法标准差最小,色调单一均匀,看不出太多的信息。像素值取大和像素值取小法所得到的融合图像,它们对图像的整体把握不好,要么图像整体暗淡,要么整体就偏亮,且边缘信息比较模糊,对比度较低。

基于区域对比度的融合方法所得到的图像模糊,信息熵小,分析编写程序和算法可能是在计算过程中灰度值超出了0~255的范围,也可能是计算的高频分量值过小,对比度值异常过大,接近于无穷大,导致了图像局部偏亮或者局部暗淡,融合图像质量不够好。

将以上实验结果中的融合图像与原可见光图像和红外图像作对比,不难看出,融合结果图像既有可见光图像中的边缘特征,同时也反映了红外图像中目标物体或者场景的温度分布信息,实现了可将光图像特点与红外图像特征的有效结合,能更全面并且准确地表达目标物体或者场景所包含的信息,能够很好地实现目标识别和监测等实际应用。

4 结束语

图像融合是指综合两个和多个源图像的信息,以获取对同一场景或同一目标的更为精确、更为全面、更为可靠的图像。融合后的图像应该更符合人或者机器的视觉特性,更有利于对源图像的进一步分析、理解以及目标检测、识别或跟踪。图像融合充分利用了多个被融合图像中包含的冗余信息和互补信息,同时又不同于一般意义上的图像增强,它是计算机视觉、图像理解领域的一项新技术。

本文的研究内容主要是基于像素级图像的融合方法。涉及图像融合的概念、图像融合的目的和意义、图像融合的应用、图像融合的常用方法及评价标准。通过利用Matlab图像处理软件,对可见光和红外图像进行图像融合仿真实验,并对融合质量进行了客观的评价。

[1]李俊山,杨威.红外图像处理、分析与融合[M].北京:科学出版社,2009:100-105.

[2]Pajares G,Manuel De La Cruz J.A Wavelet-Based Image Fusion Tutorial[J].Pattern Recognition,2004,37(9):1855-1872.

[3]Do M N,Vetterli M.The Contourlet Transform:An Efficient Directional Multiresolution Image Representation[J].IEEE Transactions on Image Processing,2005,14(12):2091-2106.

[4]郭雷.图像融合[M].北京:电子工业出版社,2008:45-57.

[5]Monica Subashini M,Sahoo S K.Pulse Coupled Neural Networks and Its Applications[J].Expert Systems with Applications,2014,41(8):3965-3974.

[6]George,Ampropoulos A L,Li Yifeng.Electro-Optical and SAR Image Fusion for Improvements on Target Feature Estimation,Applications of Photonic Technology SPIE,2002,4833(5):214-225.

[7]Intelligence Fusion Pushed.Auiation Week and Space Technology,1979,29:205-211.

[8]Daily M I,Farr T,Elachi C.Geologic Interpretation from Composited Radar and Lands at Imagery,Photogrammetric Engineering and Remote Sensing,1979,45:1109-1116.

[9]Laner D T,Todd W J.Land Cover Mapping with Merged Landsat RBV and MSS Stereoscopic Images[C]//Proc of the ASP Fall Technical Conference,San Franciso,1981:680-689.

[10]Cliche G,Bonn F,Teillet P T.Intergration of the SPOT Pan,Channel into its Multispectral Mode for Image Sharpness Enhancement[J].Photogrammetric Engineering and Remote Sensing,1985,51:311-316.

[11]童明强.红外图像与可见光图像融合的研究[D].天津:天津理工大学,2005:1-59.

[12]覃征,鲍夏民,李爱国.数字图像融合[M].西安:西安交通大学出版社,2004:73-77.

[13]陈秀新,邢素霞.图像/视频检索与图像融合[M].北京:机械工业出版社,2011.

[14]张兆礼,赵春晖,梅晓丹.现代图像处理技术及Matlab实现[M].北京:人民邮电版社2001:123-134.

[15]胡良梅,何科峰.图像融合质量评价方法的研究[J].电子学报,2004,32:32-34.

[16]余成波.数字图像处理及MATLAB实现[M].重庆:重庆大学出版社,2010:241-244.

莫毅(1981-),男,广西壮族自治区西乡塘区,汉硕士研究生,讲师/工程师,研究方向为智能化机器人工作系统。

Multi-Scale Fusion of Infrared and Visible Images Based on PCNN*

MO Yi1*,GUO Rong2

(1.Guangxi Institute of Industry Technology,Nanning 530001,China;2.Sichuan University of Science and Engineering College of automation and electronic informationand Communication Engineering Department of Sichuan,Zigong Sichuan 643000,China)

In order to improve the contrast of fusion image and preserve more image details.This thesis is aimed at studying a fused method about infrared image and visual image.This paper is focusing on using MATLAB software to achieve the integration of infrared image and visual image.Moreover,using maximal or minimal pixel selection,pixel average,regional energy,regional contrast.The fusion image using information entropy,standard deviation evaluation index analysis.The results show that it not only remains the shape information of the visual image,but also displays the temperature distribution of objects from the infrared image.

image fusion;nonsubsampled contourlettransform;pulse coupled neuralnetwork;performance evaluation

TP751

A

1005-9490(2016)05-1237-07

项目来源:2015年度广西高校科学技术研究项目:桂工业院研(KY2015YB444)

2015-11-05修改日期:2016-06-08

EEACC:6430H10.3969/j.issn.1005-9490.2016.05.042