仿人面部表情机器人头部机构方案设计

卢孔笔,柯显信,尚宇峰

(上海大学机电工程与自动化学院,上海 200072)

仿人面部表情机器人头部机构方案设计

卢孔笔,柯显信,尚宇峰

(上海大学机电工程与自动化学院,上海 200072)

为了赋予表情机器人更丰富的面部表情,并最终实现与人之间更和谐的交互,在对人类基本表情的形成与肌肉运动进行分析的基础上,提出了一种仿人面部表情机器人头部的机械结构设计方案,为后续研究提供了硬件平台支持.并对该机器人头部机构,包括眉毛、眼睑、眼球、能实现咀嚼动作的下颚以及颈部等的工作原理进行了详细说明,对多种方案的选择作了对比.最后,确定了表情机器人头部的机构设计方案.

仿人面部表情机器人;情感;表情;人机交互;机构设计

在智能机器人产业发展战略上,中国已经把服务机器人等项目确定为国家“863”计划的重点.智能机器人从外观上已远远脱离了最初的工业机器人所具有的形状和局限,其功能和智能程度大大增强,更加满足各种不同应用环境的需求,从而为机器人技术的研发开辟出更加广阔的发展空间,其中仿人面部表情机器人的研究也是当前智能机器人研究热点之一.可以预见,智能机器人将会走进千家万户,因此赋予机器人情感,与之进行生动的情感交互变得尤为重要.而人的情感又主要是由面部表情进行表达的.因此对于仿人表情机器人的研究对于实现和谐的人机交互有着十分重要的意义,而其中机器人的硬件平台的搭建则是基础性的一步.

哈尔滨工业大学最早开始了对仿人表情机器人的研究.1996年,哈尔滨工业大学的仿生仿人机器人及其智能运动控制研究室以1∶1的设计比例,研究出了以孙中山为原型的仿人头像演讲机器人,该机器人具有弹性皮肤、面部器官及头颈部、双臂动作,能够起立、坐下、进行演讲;并于2003年开始进行仿人头像机器人H&Frobot的研究(从H&Frobot-Ⅰ到H&Frobot-Ⅲ),研究主要面向面部表情再现及语音口形协调等[1];2012年,该研究室研究出了具有智能表情,并具有嗅觉、视觉、力觉、温度感知、语音口形等多感知机能的集成化仿人全身机器人GOROBOT-Ⅲ.北京科技大学的王志良教授在1999年首次提出了人工心理的概念,即利用已有的人工智能的理论和实践基础,结合心理学、神经科学、计算机科学等新方法,进行全面的人工机器(计算机、模型算法等)实现[2].

在国外,对于仿人机器人的研究所取得的成果显著.日本大阪大学石黑浩教授和Kokoro公司工程师研发的一款名为“Geminoid F”的仿人机器人,能实现60多种表情,具有极高的仿人相似度[3];此外日本早稻田大学的WE-4是目前感官器官最为齐全的机器人,具有视觉、听觉、触觉、嗅觉等[4];日本东京理科大学的SAYA通过19个运动控制单元控制机器人脸部硅胶皮肤[5];意大利比萨大学的FACE通过HEFES软件控制电机做出适当的反应来模拟表情,并实现不同表情的混合[6];美国麻省理工学院的Kismet利用激励、价和态这3个坐标轴构成情感空间模型,且该情感空间被分割成代表特定情感状态的区域[7].

1 表情形成的面部特征分析

如果想让机器人实现类似人类的6种基本表情,则必须对人类的6种基本面部表情进行分析[8].

(1)惊讶情绪的面部特征:①额肌充分收缩,双眉大幅提升;②上眼提肌收缩,与额肌共同作用,眼睛睁大,露出虹膜上缘的眼白;③嘴巴不自觉张开.

(2)厌恶情绪的面部特征:①皱眉肌收缩,双眉紧皱;②眼轮匝肌强烈收缩,紧闭双眼,同时造成双眉下压;③提升唇肌和上唇鼻翼肌收缩,提升上唇,同时在鼻翼两侧挤压形成鼻唇沟;④颏肌收缩,将下唇向上强力推起,使双唇紧闭,下巴同时向上收起,表面皮肤形成褶皱,下唇与下巴上的肌肉隆起之间形成深沟;⑤降口角肌收缩,将嘴角向下拉,与提上唇肌的作用形成制衡,嘴角两侧形成括号形纹路.

(3)愤怒情绪的面部特征:①双眉下压、紧皱;②上眼睑提升剧烈,下眼睑紧绷,称为怒视;③嘴用力张大,上唇绷紧拉伸,露出牙齿作为攻击武器;④下巴降低,真正的攻击行为,没有抬着头,抬着下巴;⑤鼻翼提升,不但露出上齿的威胁形态,而且鼻孔还会扩展,用于保持呼吸道的通畅.

(4)恐惧情绪的面部特征:①眉头上扬,眉形整体在内侧1/3处扭曲向上;②上眼睑向上提升,露出更多的虹膜上缘;③提上唇肌轻微收缩,上唇提起,略微露出上齿;④颈阔肌轻微收缩,将嘴角向两侧拉开,使嘴的水平宽度较平时的松弛状态更大.

(5)悲伤情绪的面部特征:①嘴部没有明显变化,轻微收缩,形成不悦嘴形;②眼睛状态正常,可能略有增大;③眉毛不会下压,眉头轻微上扬,眉间轻微扭曲.

(6)愉悦情绪的面部特征:①眉毛保持松弛时的自然拱形,前额平滑;②双眼紧闭,下眼睑凸起、提升,下方会出现沟纹,眼角内侧产生皱纹,外侧产生鱼尾纹;③嘴角向上,向两侧提升,脸颊隆起,提升到最高位置,呈最圆状态;④上唇提升,露出大部分上齿,下颚打开,表面变得平滑,并露出少量下齿;⑤下巴展开,皮肤平滑,自嘴角到下巴颏,形成笑容特有的沟纹,与鼻唇沟一气贯通.

图1为6种基本表情及相对应的面部形态特征.

图1 基本表情及对应的面部形态特征Fig.1 Basic facial expressions and corresponding morphological characteristics

在多数情况下,人的面部所呈现的表情特征基本上是对称的,但为使机器人能够表达出更多样更细腻的表情特征,本研究提及的设计方案对机器人脸部的特征(如左右眼球、左右眉毛等)均采取独立驱动的方式,并在对人类的面部表情特征进行了分析之后,提出了机器人头部机械结构的设计方案.

2 机器人头部机械结构设计

2.1 眼部及眉毛机构设计

如果要实现人类与机器人的视觉交互,就必须给机器人安装“眼睛”.眼睛是心灵的窗户,人类正是通过眼睛感知客观世界90%以上的信息.人类眼球近似球形,成年时正常眼球的前后径为24 mm.垂直径直径较水平径略小.眼球向前方平视时,通常会突出于外侧框缘12~14 mm,两眼间相差不超过2 mm[9].如图2所示,眼球的运动是3对眼外肌(上、下直肌,内、外直肌,上、下斜肌)控制的,它们的协调活动使眼球可以绕着x、y、z轴转动,从而使眼睛灵活地注视不同方位.如内直肌和外直肌收缩,眼球向左右方向转动;上直肌和下直肌收缩,眼球向上下方向转动;上斜肌和下斜肌收缩,眼球沿视轴转动[10].一般情况下,眼球沿视轴的运动难以被人察觉,故现有的研究大多舍弃这个动作,如中东技术大学的i-RoK[11]、开源机器人i-Cub[12]等,该方案既不影响交互效果,又简化了机械结构.

此外,眼球运动形式可分为3类[13]:①同向运动:左右眼具有相同的运动方式.包括扫视运动和平滑追踪运动,前者即人在自由的观察环境下,眼睛快速地在目标点间转移,后者即人眼在跟踪物体运动时,使双眼平滑地跟随目标运动.②异向运动:左右眼具有不同的运动方式.包括集合运动和散开运动,前者即目标物由远及近,双眼视轴相互集合的运动,后者恰好相反.此外,眼球运动还包括前庭动眼反射和视动反射.

图2 眼部肌肉构造Fig.2 Muscle structure of eyes

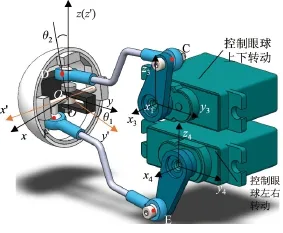

由以上分析可知,要实现上述的眼球运动,左右眼必须相互独立.而且由于包括眉毛、眼睑、眼球在内的眼部运动器官相对较为集中,运动较为复杂,因此对机械结构的设计提出了很高要求.正由于机械运动形式复杂,设计空间狭小,故在此采用了空间连杆机构来实现眼睑和眼球运动的设计方案(图3为眼部机构图).空间连杆机构的构建布置灵活,运动副和运动副的排列具有多样性,合理安排杆件可以显著提高空间利用率,使结构更加可靠;另外,如果空间连杆机构灵活可靠,则可以避免由于制造安装误差而引起的运动不灵活甚至卡住的现象[14].空间连杆机构中的空间RSSR机构,即含有两个相邻球面副的空间四杆机构的应用最为广泛,故在此均采用空间RSSR机构.

图3 眼部机构Fig.3 Eyes mechanism

眼睑位于眼眶前部,覆盖于眼球表面,分上睑和下睑.在如图3所示的眼部机构图中,上下眼睑均采用空间RSSR连杆机构,在舵机臂和眼睑固定架的回转中心上分别建立坐标系x1y1z1和坐标系x2y2z2.A、B两点为连杆AB两端的球铰中心,舵机臂由舵机驱动绕z1轴转动,从而带动连杆推动眼睑固定架绕x2轴转动,以此实现上眼睑的上翻和下合.下眼睑也与此类似.

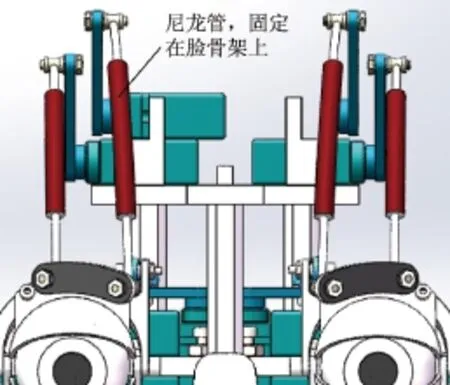

日本早稻田大学所研发的Kobian机器人的眉毛机构,是通过驱动脸壳内的磁铁来带动脸壳外的眉毛磁性运动单元的[15],该方案设计巧妙,但是难以应用在具有皮肤的仿人机器人上.本研究提出了一种弹性钢丝推拉机构(见图4),每一边的眉毛均包括两个自由度,由两根穿过固定在脸骨架上的尼龙管的弹性钢丝分别推拉眉毛固定板上的运动单元.这种弹性钢丝推拉机构结构新颖,易于实现,且对设计精度要求不高,尼龙管的固定位置需要反复进行试验矫正,以获得最能让人接受的眉毛动作.

图4 眉毛机构Fig.4 Eyelid mechanism

图5 眼球机构Fig.5 Eyeball mechanism

2.2 下颚机构设计

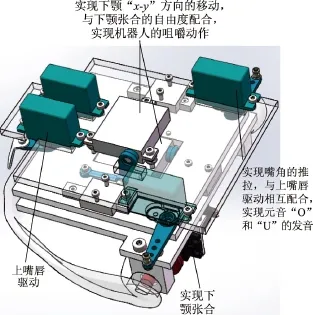

机器人的下颚结构具有7个自由度,其中上嘴唇和嘴角驱动共有4个自由度,下颚的“xy”方向移动2个自由度,以及下颚的张合1个自由度(见图6).上嘴唇和嘴角的运动相互协调,可以实现机器人元音“O”和“U”的发音(此二元音实现的嘴形相对复杂,其他元音较易实现).中间两个舵机通过曲柄滑块机构实现下颚“x-y”方向的移动,与下颚张合动作相协调,可以实现机器人的咀嚼运动.该7自由度的下颚机构将在后续的人机语音交互上发挥主要作用,使机器人能实现逼真生动的口形和下颚动作的变化.

2.3 颈部机构

现有的机器人颈部机构的设计方案大多采用串联机构,如儿童机器人iCub[12]、哈尔滨工业大学的“H&Frobot”[16]等,或是仿人颈部弹簧机构,如日本的SAYA机器人[5]等.为使机器人颈部具有更好的仿人效果,本研究最初的颈部设计采用弹簧机构(见图7).该机构的构思是通过采用7层颈椎节来模拟人类7块颈椎骨,并用球铰链模拟人类椎间盘,颈椎节间通过球铰链以及3根弹簧相连接,而顶层颈椎节则由固定在底座上的电机通过3根钢丝牵引,并且带动中间6层颈椎节,从而实现所需的低头、仰头、左右侧屈等颈部运动.该方案具有很高的拟人性,却难以建立机构的运动学方程,实现精确控制.

图6 下颚机构Fig.6 Jaw mechanism

图7 弹簧颈部机构Fig.7 Spring-type neck mechanism

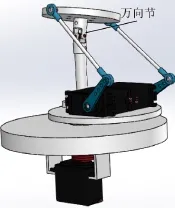

由于难以精确控制弹簧机构,本研究最后采用了空间连杆并联机构(见图8).并联机构与串联机构相比,具有承载能力强、刚度高等优点,其误差为杆件误差的平均值,且零部件数目也大幅减少[17].在如图7所示的颈部机构中,两个电机相互协调,通过空间连杆驱动万向节的两个自由度的转动,实现机器人头部的低头、抬头与左右侧屈,下面的舵机则驱动头部左右转动.

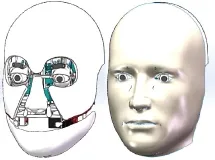

在完成机器人头部的每个环节的机械设计方案后,把每个局部机构进行组合,并进行干涉检验.如果发生干涉,则返回局部设计进行修改,因此机器人头部的设计是一个自下而上、自上而下的双向设计,需要循环往复的矫正.图9为机器人装上脸骨架和皮肤的效果图.

图8 并联颈部机构Fig.8 Parallel neck mechanism

图9 机器人总装图及覆盖皮肤后效果Fig.9 Diagrams of assembly drawing and rendering with skin

机器人头部总共有22个自由度,其自由度分配如表1所示.

表1 机器人头部自由度分配Table 1 Distribution of dofs of robot

3 结束语

本研究从对人类表情的面部形态特征的分析出发,总结了在不同表情下人体面部各部位包括眉毛、眼睑、眼球、下颚、颈部等的运动状态,从而制定了机器人头部机械设计方案.同时,把设计过程中欲采用的多种方案进行了对比,分析了各自的优缺点,然后选择出最合适和最易实现的方案.

在完成仿人表情机器人硬件平台的搭建之后,将开始进行表情机器人情感模型和控制算法的研究,使机器人实现6种基本表情、混合表情和其他特殊表情的再现,以及实现机器人眼脖协调控制和更深层次的人机交互.

[1]吴伟国,宋策,孟庆梅.仿人头像机器人“H&Frobot-Ⅲ”语音及口形系统研制与实验[J].机械设计, 2008,25(1):15-19.

[2]王志良,解仑.我国人工心理与人工情感研究现状与进展[J].中国科学基金,2013(1):14-17.

[3]BECKER-ASANO C,ISHIGURO H.Evaluating facial displays of emotion for the android robot Geminoid F[C]//IEEE Workshop on Affective Computational Intelligence(WACI).2011:1-8.

[4]MIWA H,OKUCHI T,TAKANOBU H.Development of a new human-like head robot WE-4[C]// IEEE/RSJ International Conference on Intelligent Robots and Systems.2002:2443-2448.

[5]HASHIMOTO T,HITRAMATSU S,TSUJI T.Development of the face robot SAYA for rich facial expressions[C]//SICE-ICASE International Joint Conference.2006:5423-5428.

[6]MAZZEI D,LAZZERI N,HANSON D,et al.HEFES:an hybrid engine for facial expressions synthesis to control human-like androids and avatars[C]//2012 4th IEEE RAS&EMBS International Conference on BioRob.2012:195-200.

[7]BREAZEAL C.Designing sociable robots[M].Cambridge:MIT Press,2004:165-167.

[8]姜振宇.表情的真相[M].香港:商务印书馆,2012.

[9]李瑶,杨男.眼科学速记[M].北京:中国医药科技出版社,2010.

[10]冯志成.眼动人机交互[M].苏州:苏州大学出版社,2010.

[11]OLCUCUOGLU O,KOKU A,KONUKSEVEN E.i-RoK:a human like robotic head[C]//7th IEEERAS International Conference on Humanoid Robots(IROS).2007:442-446.

[12]BEIRA R,LOPES M,PRAGMA M,et al.Design of the robot-cub(iCub)head[C]//Proceedings of IEEE International Conference on Robotics and Automation(ICRA).2006:94-100.

[13]邹海荣,龚振邦,罗均.仿生眼的研究现状与发展趋势[J].机器人,2005,27(5):469-474.

[14]苗鸿宾,乔峰丽.空间RSSR机构运动分析的研究[J].机械设计与制造,2008(2):7-9.

[15]KISHI T,OTANI T,ENDO N,et al.Development of expressive robotic head for bipedal humanoid robot[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS). 2007:4584-4589.

[16]WU W G,MEN Q M,WANG Y.Development of the humanoid head portrait robot system with flexible face and expression[C]//Proceedings of the 2004 IEEE International Conference on Robotics and Biomimetics.2004:756-762.

[17]彭忠琦.并联机构的发展及应用[J].光机电信息,2011,28(12):45-50.

本文彩色版可登陆本刊网站查询:http://www.journal.shu.edu.cn

Mechanical scheme design of a humanoid facial expressions robot

LU Kongbi,KE Xianxin,SHANG Yufeng

(School of Mechatronics Engineering and Automation,Shanghai University,Shanghai 200072,China)

To give richer facial expressions to humanoid countenance robot therefore achieve more harmonious interaction with people,a mechanical design of humanoid expressions is proposed by analyzing the generation of basic expressions and muscle movements, providing a hardware platform support for further study.The robot head consists of the mechanisms of eyebrows,eyelids,eyeballs,and neck,as well as the mechanism of jaw for mastication movement.Their working principles are described in detail,and several design choices are compared.The choice of mechanical design is finally made,and the required further research is specified.

humanoid countenance robot;affection;expression;human-robot interaction;mechanical design

TP 242.6

A

1007-2861(2016)04-0432-08

10.3969/j.issn.1007-2861.2014.04.011

2014-09-11

国家自然科学基金资助项目(61273325);国家重大科学仪器设备开发专项项目(2012YQ150087)

柯显信(1973—),男,副教授,博士后,研究方向为仿人机器人和人机情感交互等. E-mail:xxke@staff.shu.edu.cn