基于跨连卷积神经网络的性别分类模型

张婷 李玉鑑 胡海鹤 张亚红

基于跨连卷积神经网络的性别分类模型

张婷1李玉鑑1胡海鹤1张亚红1

为提高性别分类准确率,在传统卷积神经网络(Convolutional neural network,CNN)的基础上,提出一个跨连卷积神经网络(Cross-connected CNN,CCNN)模型.该模型是一个9层的网络结构,包含输入层、6个由卷积层和池化层交错构成的隐含层、全连接层和输出层,其中允许第2个池化层跨过两个层直接与全连接层相连接.在10个人脸数据集上的性别分类实验结果表明,跨连卷积网络的准确率均不低于传统卷积网络.

性别分类,卷积神经网络,跨连卷积神经网络,跨层连接

引用格式张婷,李玉鑑,胡海鹤,张亚红.基于跨连卷积神经网络的性别分类模型.自动化学报,2016,42(6):858-865

人脸性别分类是一个二分类问题,通过人脸图像信息自动发现和分析人脸性别属性.它被广泛应用在以客户为中心的广告、视觉监控、智能用户界面和人口统计等领域.

作为一种传统方法,全连接网络在多年前已被应用于人脸性别分类.Golomb等[1]通过训练一个两层的全连接网络SEX-NET(Sex network),对大小为30×30的人脸图像进行性别分类.这是第一次将神经网络应用于性别分类.Brunelli等[2]使用HyperBF网络进行性别分类.首先使用两个径向基函数(Radial basis function,RBF)网络提取人脸特征,分别用于提取男性和女性人脸特征,然后采用提取的特征进行性别分类.Tamura等[3]探索了神经网络在不同分辨率图像上的性别分类,通过采用一个三层的反向传播网络对不同分辨率(分辨率的范围从32×32到8×8)的人脸图像进行性别分类.该网络在30幅大小为8×8的低分辨率测试人脸图像上获得了93%的准确率.Jiao等[4]提出使用极限学习机进行人脸性别分类,取得了较好的分类准确率.以上使用全连接神经网络进行人脸性别分类的方法没有考虑到图像的二维信息,忽略了图像中像素间的二维相关性,因此,分类准确率也不够高. 2014年,Verma等[5]使用一个6层的卷积神经网络(Convolutional neural network,CNN)进行人脸性别分类,获得了更高的准确率.自深度学习出现以来[6],相比传统的手工特征提取方法[7],CNN表现出优越的特征提取能力[8],因而在字符识别[9]、人脸识别[10]、人脸跟踪[11]、交通标志识别[12]、手写体数字分类[13]、目标检测[14-16]、目标识别[17]等领域都获得了广泛应用.

生物学研究表明,在一幅给定的自然图像中,人类视觉系统能够从整幅图像中找到最感兴趣的区域和物体,并进而利用细节特征进行目标识别[18].这说明,综合利用高层次特征和低层次特征,对改善视觉系统的识别性能是有利的[19].以此为出发点,本文在传统卷积神经网络的基础上,通过引入跨层连接的思想,提出一个具有9层结构的跨连卷积神经网络模型,目的是为了有效地融合低层次特征和高层次特征,以构造性能更好的分类器.

将跨连卷积神经网络应用于人脸性别分类的优点在于,在对人脸图像进行分类时,既考虑了高层次特征,又考虑了低层次特征,从而可能获得比传统卷积神经网络更高的准确率.在本文的跨连卷积神经网络中,虽然跨层连接的思想借鉴了DeepID网络[20],但二者并不完全相同.在DeepID网络中,跨层是将最后一个池化层与全连接层进行连接,跨层连接的权值是可以学习和调整的;而在本文的网络中,跨层是将某一隐含层直接拷贝连接到全连接层的部分输入,跨层连接的权值是固定的,无需调整和学习.

1 跨连卷积神经网络

1.1卷积神经网络

卷积神经网络最初是受视觉神经机制的启发针对二维形状的识别而设计的一种多层感知器,在平移情况下具有高度不变性.1962年,Hubel等通过对猫视觉皮层细胞的研究,提出了感受野(Receptive field)的概念[21],1983年,日本学者Fukushima等基于感受野概念提出的神经认知机(Neocognitron)模型[22],被认为是第一个实现的卷积神经网络.

实际上,传统卷积神经网络是一种特殊的深层前向神经网络模型,其结构一般由输入层、多个交替的卷积层和池化层、全连接层及输出层组成[23].输入层通常是一个矩阵,比如一幅图像.从前馈网络的角度来看,卷积层和池化层可以看作是特殊的隐含层,而除输出层外的全连接层都是普通的隐含层.

在卷积神经网络中,有四种基本的运算,依次定义为:内卷积、外卷积、下采样和上采样.

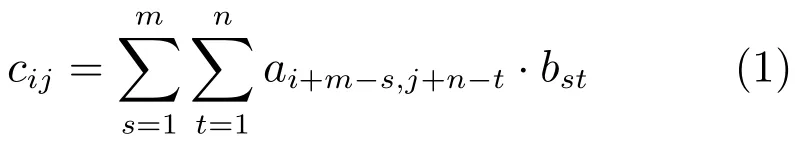

假设A和B为矩阵,大小分别为M×N和m×n,且M ≥m,N≥n,则它们的内卷积的所有元素定义为:

式中,1≤i≤M-m+1,1≤j≤N-n+1.

它们的外卷积定义为:

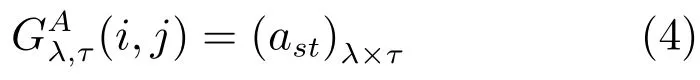

如果对矩阵A进行不重叠的分块,设每块的大小恰为λ×τ,第ij块用矩阵来表示,则其构造如下:

式中,(i-1)×λ+1≤s≤i×λ,(j-1)×τ+1≤ t≤j×τ.的下采样定义为:

用大小为λ×τ的不重叠块对矩阵A的下采样定义为:

对矩阵A进行倍数为λ×τ的不重叠上采样定义为:

式中1λ×τ是一个元素全为1的矩阵,⊗代表克罗内克积.

1.2跨连卷积神经网络

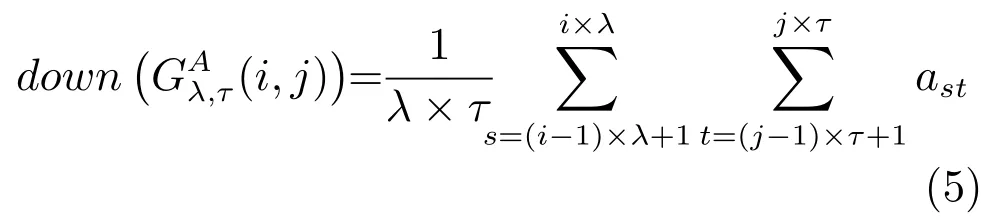

传统卷积神经网络的一个缺点是难以有效地利用低层次特征与高层次特征进行融合去构造性能更好的分类器.针对该问题,本文通过引入跨层连接的思想,提出了一个跨连卷积神经网络(Crossconnected convolutional neural network,CCNN),用于建立人脸性别分类模型.该模型包含1个输入层x、3个卷积层(h1,h3,h5)、3个池化层(h2,h4,h6)、1个全连接层h7和1个输出层o,如图1所示.注意,该网络首先以一幅图像为输入,然后使用3个交错的卷积层和池化层提取图像的特征,最后将2个池化层(h4和h6)提取的特征直接传递给全连接层进行融合处理并进行分类.输出层有2个节点,代表输入图像所属的类别.不难看出,在该网络中,从池化层h4到全连接层h7之间的连接跨过了2层,称为跨层连接.此时,全连接层的节点数是第4个隐含层和第6个隐含层节点数之和,即nh7=nh4+nh6,其中nh4、nh6和nh7分别表示第4、6、7个隐含层的节点数.表1给出了CCNN模型具体描述,包含每层的类型(Type)、卷积核大小(Patch size)、步长 (Stride)和每层输出的大小(Output size).

图1 跨连卷积神经网络结构示意图Fig.1 The crossed-connected convolutional neural network

表1 CCNN的网络描述Table 1 Description of the CCNN

1.3跨连卷积神经网络的学习过程

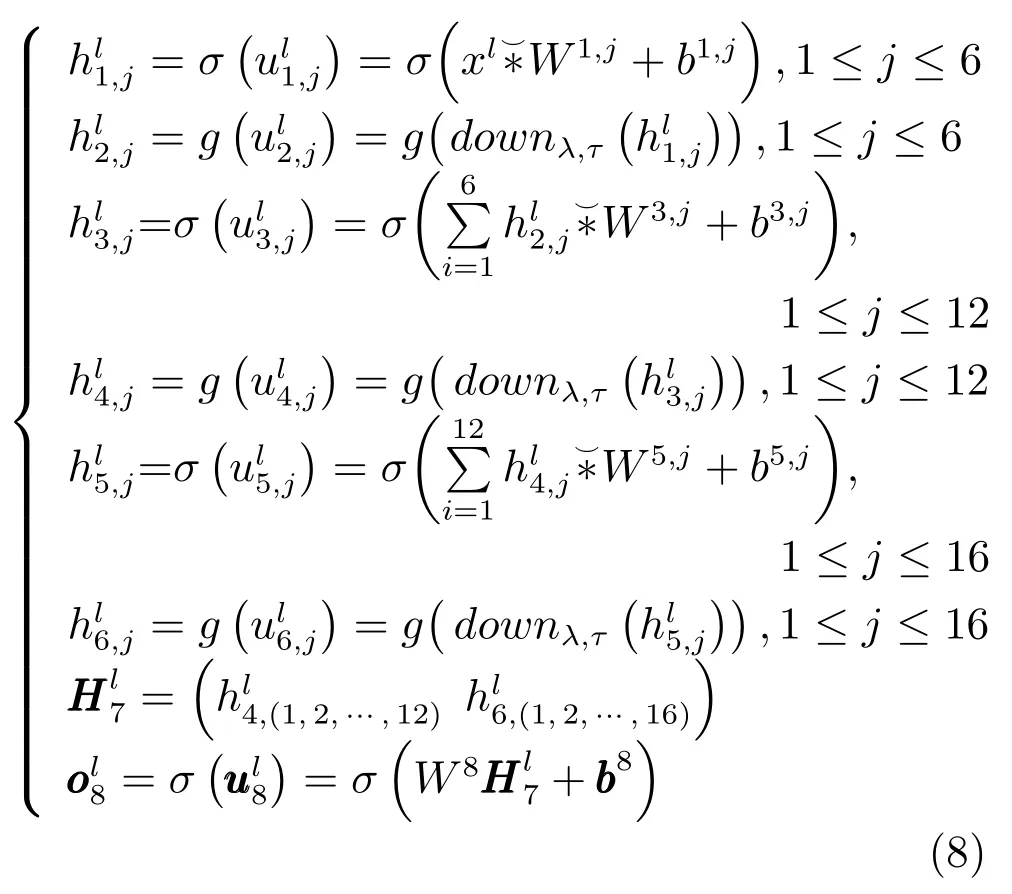

对于第l个样本xl,CCNN的计算过程为:

式中,函数 σ(x)=1/(1+e-x),g(x)=x,downλ,τ(·)表示下采样函数,滑动窗口的大小为λ×τ,同式(6).W1,j和b1,j分别表示第1个隐含层的第j个卷积核和偏置,表示第1个隐含层的第j个卷积面(1≤j≤6);表示第2个隐含层的第j个池化面(1≤j≤6);W3,j和b3,j分别表示第3个隐含层的第j个卷积核和偏置,表示第3个隐含层的第j个卷积面(1≤j≤12);表示第4个隐含层的第j个池化面(1≤j≤12);W5,j和b5,j分别表示第5个隐含层的第j个卷积核和偏置,表示第5个隐含层的第j个卷积面(1≤j≤16);表示第6个隐含层的第j个池化面(1≤j≤16);表示第7个隐含层的输出值;W8和 b8分别表示输出层的权值和偏置,表示输出层的输出值.

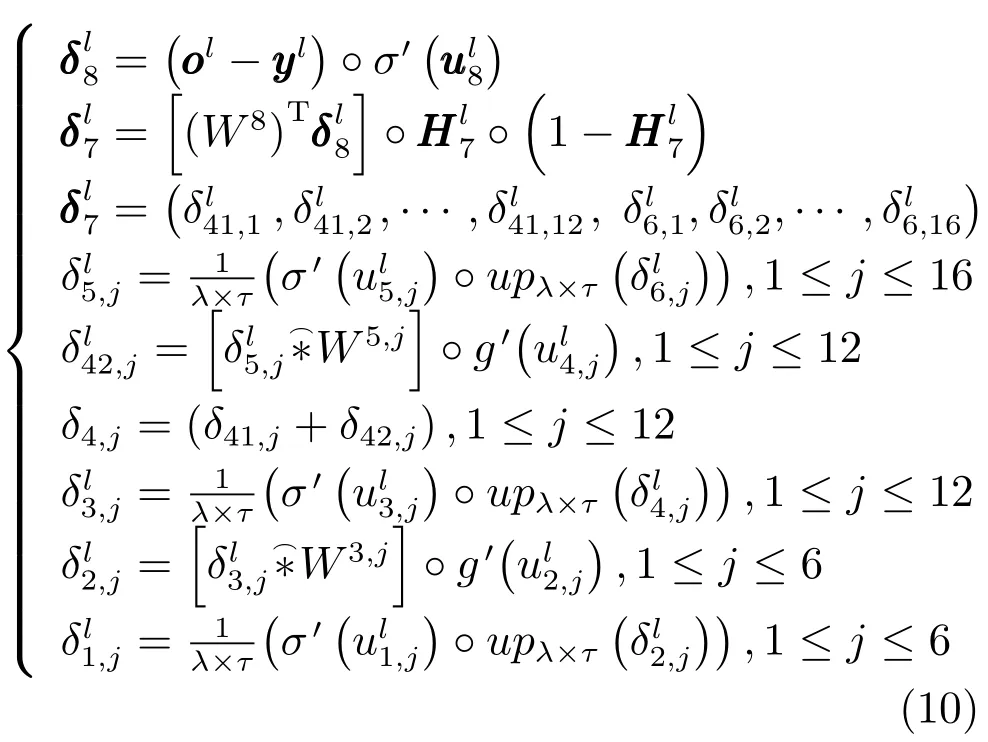

参照CNN的学习过程,本文提出了训练CCNN的反向传播算法(Cross-connected convolutional neural network-Back propagation,CCNNBP)(详见算法1),用于学习网络参数. 假设共有N 个训练样本(1≤l≤N),网络的输入是,期望输出是,实际输出是,优化的目标函数是全部样本的均方误差:

CCNN-BP首先需要计算出网络中每一层的反馈传递误差δk(1≤k≤8).这里需要特别注意的是第4个隐含层的反馈传递误差δ4,j(1≤j≤12),因为该层同时与第5个隐含层h5和第7个隐含层h7相连,因此该层的反馈传递误差为两部分之和.其余各层的反馈传递误差的计算方式与CNN的计算方式相同,因此,CCNN中每一层的反馈传递误差矩阵为:

式中,符号◦表示矩阵(或者向量)对应元素相乘,upλ×τ(·)表示上采样函数,同式(7).分别表示输出层和第7个隐含层的反馈传递误差,(1≤j≤16)表示第6个隐含层第j个池化面的反馈传递误差,(1≤j≤16)表示第5个隐含层第j个卷积面的反馈传递误差,δ41,j(1≤j≤12)表示第7个隐含层传给第4个隐含层第j个池化面的反馈传递误差,(1≤j≤12)表示第5个隐含层传给第4个隐含层第j个池化面的反馈传递误差,(1≤j≤12)表示第4个隐含层第j个池化面总的反馈传递误差,(1≤j≤12)表示第3个隐含层第j个卷积面的反馈传递误差,(1≤j≤6)表示第2个隐含层第j个池化面的反馈传递误差,(1≤j≤6)表示第1个隐含层第j个卷积面的反馈传递误差.

在获得每一层的反馈传递误差之后,CCNN-BP就可以计算关于权值和偏置的偏导数,如下:

最后,CCNN-BP利用梯度下降法更新网络的权值和偏置.

算法1.CCNN-BP

Input:训练集S={(xl,yl),1≤l≤N},网络结构,最大迭代次数.

1:随机初始化所有的权值和偏置;

2:for epoch=1 to maxepoch do;

3:for l=1 to N do;

4:计算每个样本的实际输出;

6:计算网络中权值和偏置的偏导数;

7:使用梯度下降法更新所有权值和偏置;

8:End for

9:End for

Output:网络的权值和偏置.

2 实验结果与分析

为验证CCNN的性能,本文将其与CNN的性别分类性能进行了比较.实验共采用10个人脸数据集,分别为:UMIST(University of Manchester Institute of Science and Technology)数据集[24]、ORL(Olivetti Research Laboratory)数据集、Georgia Tech数据集[25]、FERET(Face recognition technology)数据集、Extended Yale B数据集[26]、AR(Aleix Martinez and Robort Benavente)数据集[27]、Faces94数据集、LFW(Labeled faces in the wild)数据集[28]、MORPH(Cranio faciallongitudinal morphological face)数据集和Celeb-Faces+ 数据集[29].所有实验均在 i7-3770 CPU 3.40GHz 8.00GB内存的Dell台式机上使用Matlab R2010a运行完成.

CNN的层数及参数设置与CCNN相同,即,3个卷积层(h1,h3,h5)的卷积核的大小分别为5×5、5×5和2×2,池化因子的大小为2×2. CNN和CCNN的学习率都设置为0.1.此外,CNN 和CCNN在7个数据集(UMIST数据集、ORL数据集、Georgia Tech数据集、FERET数据集、Extended Yale B数据集、AR数据集、Faces94数据集)上的最大迭代次数为30,在3个数据集(LFW数据集、MORPH数据集、CelebFaces+数据集)上的最大迭代次数为200.

表2 实验数据集的训练集和测试集信息描述Table 2 Number of training samples and testing samples of the experiments

2.1实验数据集简介

在实验采用的10个数据集中,UMIST数据集、ORL数据集、FERET数据集、Extended Yale B数据集和AR数据集的图像为灰度图像,Faces94数据集、Georgia Tech数据集、LFW数据集、MORPH数据集、CelebFaces+数据集的图像为彩色图像.为了便于处理,本文将彩色图像均转变为灰度图像,并统一把图像大小归一化为32×32,把像素值归一化到[0,1].

图2给出了各个数据集的示例图像.表2给出了这些数据集的训练集及测试集的情况,其中7个数据集(UMIST、ORL、Georgia Tech、Extended Yale B、AR、Faces94、MORPH)使用数据集中的全部图片,3个数据集(FERET、LFW、CelebFaces+)使用数据集中的部分图片.此外,本文在实验中用到的训练集和测试集都没有交集,即同一个人的人脸图像不能同时出现在训练集和测试集中.

图2 10个数据集中的示例人脸图像Fig.2 Examples of face images in ten datasets

2.2CCNN与CNN的人脸性别分类比较

本文采用CCNN 与CNN 模型在10个人脸数据集上的性别分类实验结果总结在表3中.从中不难看出:CCNN在UMIST、Georgia Tech、FERET、Extended Yale B、Faces94、LFW、MORPH和CeleFaces+这8个数据集上的分类准确率均高于CNN,而在ORL和AR上与CNN相同.与CNN相比,CCNN在UMIST和LFW数据集上的分类准确率分别提高了2.71%和0.86%.这可能是因为CCNN可以直接使用两个池化层提取到的特征去分类,而CNN直接使用一个池化层提取到的特征去分类,导致CCNN在融合不同尺度的信息时能够更加准确地反映图像信息,从而获得了更好的分类性能.

表3 CNN和CCNN在10个数据集上的分类准确率(%)Table 3 Classification accuracies of CNN and CCNN in ten datasets(%)

2.3CCNN与CNN在男性和女性图像集合中的分类比较

为比较CCNN和CNN分别在男性和女性图像集合中的分类效果,本文在 Georgia Tech、Extended Yale B、Faces94和LFW 这4个数据集上进行了实验,结果如表4所示.从表4可以看出,CCNN对男性、女性和双性混合的分类准确率均不低于CNN.CCNN在Faces94数据集上对男性、女性和双性混合的分类准确率分别为100%、94.70%和97.5%,与CNN相比分别提高了1.52%、0.26%和0.89%.此外,CCNN和CNN对男性的分类准确率高于女性.在Georgia Tech数据集上,CNN和CCNN对男性的分类准确率都为99.49%,而对女性的分类准确率分别为95.71%和96.07%.这可能是因为在数据集中女性人脸图像明显少于男性人脸图像,导致女性人脸图像没有得到充分的训练造成的.

表4 CNN和CCNN在4个数据集上的分类准确率(%)Table 4 Classification accuracies of CNN and CCNN in four datasets(%)

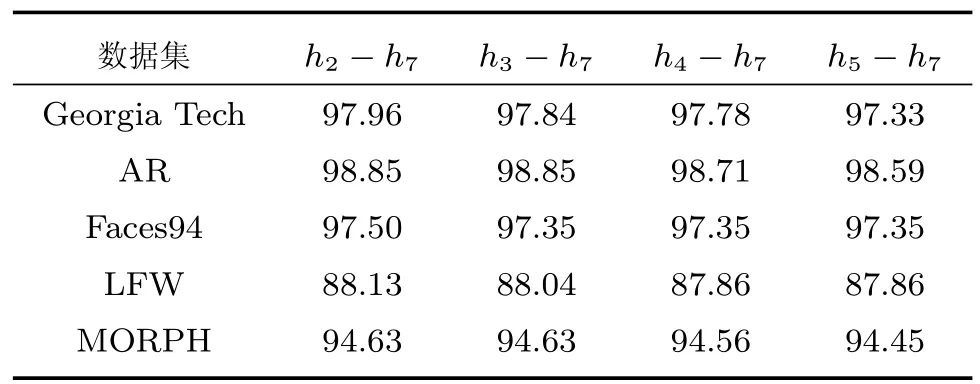

2.4不同跨连方式对CCNN性能的影响

为探索不同的跨连方式对CCNN的性能产生的影响,本文在Georgia Tech、AR、Faces94、LFW 和MORPH五个数据集上进行了实验,实验结果如表5所示.其中,h2-h7表示使用第2个隐含层与全连接层连接时的分类准确率,h3-h7表示使用第3个隐含层与全连接层连接时的分类结果,h4-h7表示使用第4个隐含层与全连接层连接时的分类结果,h5-h7表示使用第5个隐含层与全连接层的连接时的分类结果.

表5 CCNN在不同跨连方式的分类准确率(%)Table 5 Classification accuracies of the CCNN with different cross-connections(%)

从表5可以看出,不同的跨连方式对CCNN的性能具有一定的影响.整体来看,使用低层的隐含层与全连接层连接时,CCNN的分类准确率不低于其之后的隐含层与全连接层连接时的分类准确率.例如,CCNN在Georgia Tech数据集上使用4种不同的跨连方式获得的分类准确率分别为97.96%、97.84%、97.78%和97.33%,使用第2个隐含层(h2)与全连接层连接时的分类准确率(97.96%)不低于其之后的隐含层(h3,h4,h5)与全连接时的分类准确率(分别为97.84%,97.78%,97.33%).

3 结论

本文在传统卷积神经网络的基础上,提出了一个用于性别分类的跨连卷积网络模型CCNN.该模型能够通过跨层连接融合两个隐含层的图像特征,从而更加准确地反映图像信息,并获得更好的性别分类性能.实验结果表明,其分类准确率在10个人脸数据集上的分类准确率不低于CNN.此外,不同的跨连方式对CCNN的性能具有一定的影响,通常使用低层的隐含层与全连接层跨层连接时,CCNN的分类准确率不低于其之后的隐含层与全连接层连接时的分类准确率.

References

1 Golomb B A,Lawrence D T,Sejnowksi T J.SEXNET:a neural network identifies sex from human faces.In:Proceedings of Advances in Neural Information Processing Systems (NIPS).Colorado,USA:Morgan Kaufmann Publishers Inc.,1991.572-579

2 Brunelli R,Poggio T.HyberBF networks for gender classification.In:Proceedings of the 1992 DARPA Image Understanding Workshop.Detroit,USA,1992.311-314

3 Tamura S,Kawai H,Mitsumoto H.Male/female identification from 8×6 very low resolution face images by neural network.Pattern Recognition,1996,29(2):331-335

4 Jiao Y B,Yang J C,Fang Z J,Xie S J,Park D S.Comparing studies of learning methods for human face gender recognition.In:Proceedings of the 7th Chinese Conference on Biometric Recognition(CCBR).Guangzhou,China:Springer,2012.67-74

5 Verma A,Vig L.Using convolutional neural networks to discover cogntively validated features for gender classification.In:Proceedings of the 2014 International Conference on Soft Computing and Machine Intelligence(SCMI).New Delhi,India:IEEE,2014.33-37

6 Hinton G E,Salakhutdinov R R.Reducing the dimensionality of data with neural networks.Science,2006,313(5786):504-507

7 Wei Wei-Bo,Hong Dan-Feng,Pan Zhen-Kuan,Wu Xin. Blurred palmprint recognition algorithm based on region feature map.Acta Automatica Sinica,2015,41(2):386-395(魏伟波,洪丹枫,潘振宽,吴鑫.基于区域特征映射的模糊掌纹识别方法.自动化学报,2015,41(2):386-395)

8 Tivive F H C,Bouzerdoum A.A gender recognition system using shunting inhibitory convolutional neural networks.In:Proceedings of the 2006 IEEE International Joint Conference on Neural Networks(IJCNN).Vancouver,BC:IEEE,2006.5336-5341

9 Ciresan D C,Meier U,Gambardella L M,Schmidhuber J. Convolutional neural network committees for handwritten character classification.In:Proceedings of the 2011 International Conference on Document Analysis and Recognition. Beijing,China:IEEE,2011.1135-1139

10 Khalajzadeh H,Mansouri M,Teshnehlab M.Face recognition using convolutional neural network and simple logistic classifier.In:Proceedings of the 17th Online World Conference on Soft Computing in Industrial Applications.Switzerland:Springer International Publishing,2014.197-207

11 Fan J,Xu W,Wu Y,Gong Y H.Human tracking using convolutional neural networks.IEEE Transactions on Neural Networks,2010,21(10):1610-1623

12 Jin J Q,Fu K,Zhang C S.Traffic sign recognition with hinge loss trained convolutional neural networks.IEEE Transactions on Intelligent Transportation Systems,2014,15(5):1991-2000

13 Xu C Y,Lu C Y,Liang X D,Gao J B,Zheng W,Wang T J,Yan S C.Multi-loss regularized deep neural network.IEEE Transactions on Circuits and Systems for Video Technology,DOI:10.1109/TCSVT.2015.2477937

14 Krizhevsky A,Sutshever I,Hinton G E.ImageNet classification with deep convolutional neural networks.In:Proceedings of Advances in Neural Information Processing Systems (NIPS).Lake Tahoe,USA:Curran Associates,Inc.,2012. 4-13

15 Szegedy C,Liu W,Jia Y Q,Sermanet P,Reed S,Anguelov D,Erhan D,Vanhoucke V,Rabinovich A.Going deeper with convolutions.arXiv:1409.4842,2014.

16 He K M,Zhang X Y,Ren S Q,Sun J.Deep residual learning for image recognition.arXiv:1512.03385,2015.

17 Sui Ting-Ting,Wang Xiao-Feng.Convolutional neural network with candidate location and multi-feature fusion.Acta Automatica Sinica,2016,42(6):875-882(随婷婷,王晓峰.一种基于CLMF的深度卷积神经网络模型.自动化学报,2016,42(6):875-882)

18 Zhong S H,Liu Y,Ren F F,Zhang J H,Ren T W.Video saliency detection via dynamic consistent spatio-temporal attention modelling.In:Proceedings of the 2013 AAAI Conference on Artificial Intelligence.Bellevue,USA:AAAI,2013.1063-1069

19 Qi Mei-Bin,Tan Sheng-Shun,Wang Yun-Xia,Liu Hao,Jiang Jian-Guo.Multi-feature subspace and kernel learning for person re-identification.Acta Automatica Sinica,2016,42(2):299-308(齐美彬,檀胜顺,王运侠,刘皓,蒋建国.基于多特征子空间与核学习的行人再识别.自动化学报,2016,42(2):299-308)

20 Sun Y,Wang X G,Tang X O.Deep learning face representation from predicting 10000 classes.In:Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Columbus,OH:IEEE.2014. 1891-1898

21 Hubel D H,Wiesel T N.Receptive fields,binocular interaction and functional architecture in the cat′s visual cortex. Journal of Physiology,1962,160(1):106-154

22 Fukushima K,Miyake S,Ito T.Neocognitron:a neural network model for a mechanism of visual pattern recognition.IEEE Transactions on Systems,Man,and Cybernetics,1983,SMC-13(5):826-834

23 LeCun Y,Bottou L,Bengio Y,Haffner P.Gradient-based learning applied to document recognition.Proceedings of the IEEE,1998,86(11):2278-2324

24 GrahamDB,AllinsonNM.Characterisingvirtual eigensignatures for general purpose face recognition.Face Recognition:from Theory to Applications.Berlin Heidelberg:Springer-Verlag,1998.446-456

25 Chen L,Man H,Nefian A V.Face recognition based on multi-class mapping of Fisher scores.Pattern Recognition,2005,38(6):799-811

26 Lee K C,Ho J,Kriegman D J.Acquiring linear subspaces for face recognition under variable lighting.IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(5):684-698

27 Maetinez A M,Kak A C.PCA versus LDA.IEEE Transactions on Pattern Analysis and Machine Intelligence,2001,23(2):228-233

28 Huang G B,Ramesh M,Berg T,Learned-Miller E.Labeled Faces in the Wild:a Database for Studying Face Recognition in Unconstrained Environment,Technical Report 07-49,University of Massachusetts,Amherst,USA,2007.

29 Liu Z W,Luo P,Wang X G,Tang X O.Deep learning face attributes in the wild.In:Proceedings of the 2015 International Conference on Computer Vision(ICCV).Santiago,Chile:IEEE,2015.3730-3738

张 婷北京工业大学计算机学院博士研究生.主要研究方向为模式识别,深度学习,大数据分析.本文通信作者.

E-mail:zhangting08@emails.bjut.edu. cn

(ZHANG TingPh.D.candidate at the Computer School,Beijing University of Technology.Her research interest covers pattern recognition,deep learning,and big data analysis.Corresponding author of this paper.)

李玉鑑北京工业大学计算机学院教授.主要研究方向为模式识别,图像处理,机器学习,数据挖掘.

E-mail:liyujian@bjut.edu.cn

(LI Yu-JianProfessor at the ComputerSchool,BeijingUniversityof Technology.His research interest covers pattern recognition,image processing,machine learning,and data mining.)

胡海鹤北京工业大学计算机学院博士后.主要研究方向为模式识别,机器学习,红外技术.

E-mail:huhaihe@bjut.edu.cn

(HUHai-HePostdoctor at the Computer School,Beijing University of Technology.Her research interest covers pattern recognition,machine learning,and infrared technology.)

张亚红北京工业大学计算机学院博士研究生.主要研究方向为模式识别,数据挖掘,大数据分析.

E-mail:plahpu@163.com

(ZHANG Ya-HongPh.D.candidate at the Computer School,Beijing University of Technology.Her research interest covers pattern recognition,data mining,and big data analysis.)

A Gender Classification Model Based on Cross-connected Convolutional Neural Networks

ZHANG Ting1LI Yu-Jian1HU Hai-He1ZHANG Ya-Hong1

To improve gender classification accuracy,we propose a cross-connected convolutional neural network(CCNN)based on traditional convolutional neural networks(CNN).The proposed model is a 9-layer structure composed of an input layer,six hidden layers(i.e.,three convolutional layers alternating with three pooling layers),a fully-connected layer and an output layer,where the second pooling layer is allowed to directly connect to the fully-connected layer across two layers.Experimental results in ten face datasets show that our model can achieve gender classification accuracies not lower than those of the convolutional neural networks.

Gender classification,convolutional neural network(CNN),cross-connected convolutional neural network (CCNN),cross-layer connection

10.16383/j.aas.2016.c150658

Zhang Ting,Li Yu-Jian,Hu Hai-He,Zhang Ya-Hong.A gender classification model based on cross-connected convolutional neural networks.Acta Automatica Sinica,2016,42(6):858-865

2015-10-16录用日期2016-04-01

Manuscript received October 16,2015;accepted April 1,2016

国家自然科学基金 (61175004),高等学校博士学科点专项科研基金(20121103110029),北京市博士后工作资助项目(2015ZZ-24:Q6007011201501)资助

Supported by National Natural Science Foundation of China (61175004),Specialized Research Fund for the Doctoral Program of Higher Education of China(20121103110029),and Project Funding of Postdoctor in Beijing(2015ZZ-24:Q6007011201501)

本文责任编委柯登峰

Recommended by Associate Editor KE Deng-Feng

1.北京工业大学计算机学院北京100124

1.Computer School,Beijing University of Technology,Beijing 100124