基于中心对称局部相似数量模型的均值漂移目标跟踪

刘威, 赵文杰, 李成, 李婷, 谭海峰, 马扬铭

(1.空军航空大学航空航天情报系,长春 130022; 2.解放军73608部队,南京 210000)

基于中心对称局部相似数量模型的均值漂移目标跟踪

刘威1, 赵文杰1, 李成1, 李婷1, 谭海峰1, 马扬铭2

(1.空军航空大学航空航天情报系,长春130022; 2.解放军73608部队,南京210000)

摘要:为实现对运动目标的实时跟踪,提出中心对称局部相似数量(center symmetric-local similarity number,CS-LSN)这一新的局部显著度纹理描述算子,并将其引入到目标表征模型。该算子通过分析中心像素及其8邻域像素之间的大小关系,在局部相似数量(local similarity number,LSN)纹理算子的基础上,针对其无法区分同一局部显著度下的不同纹理结构的问题,增加以中心像素为对称点的局部梯度信息,提取出候选目标区域中具有CS-LSN主要模式的真实目标像素,有效地抑制了背景像素的影响并减少了后续目标表征模型的计算量; 利用真实目标像素的CS-LSN纹理特征和色度特征构建直方图,完成目标表征; 进而将其嵌入到均值漂移(mean shift,MS)框架完成跟踪。实验结果表明,该方法在目标与背景相似、部分遮挡、光照变化及物体形变等情况下均能完成鲁棒跟踪,目标大小为29像素×25像素时,处理速度约为25帧/s,可满足实时应用的需求。

关键词:目标跟踪; 纹理特征; 中心对称局部相似数量(CS-LSN); 均值漂移(MS)

0引言

运动目标跟踪在军事制导、航空侦察、视觉导航等领域有着广泛的应用[1]。目标表征模型及对应的目标搜索方法一直是目标跟踪领域的研究热点。鉴于目标跟踪对实时性有较高要求,在众多的目标跟踪方法中,基于均值漂移(mean shift,MS)跟踪框架[2]的方法以其简单高效的特点得到了广泛的研究和应用[3-5]; 而有效的目标表征方法则对MS搜索匹配的效率和准确性起着至关重要的作用。传统MS跟踪算法常采用颜色特征,当光照发生变化时就容易跟踪失败; 现有的改进主要是引入多特征(如边缘特征角点特征等[6]),但提取多特征的同时也加大了算法的复杂度。局部二值模式(local binary patterns, LBP)纹理特征及其改进型纹理分析[7]不受光照影响,具有旋转不变性和灰度不变性等优点,在目标跟踪领域得到了广泛运用。Ning等[8]提出了均匀LBP(uniform LBP)纹理模式,并结合颜色特征来表征目标; 张涛等[9]基于局部三值模式(local ternary patterns,LTP)和肤色特征提出一种人脸跟踪算法; 张炯等[10]以对立色LBP模型为研究对象,并用其作为目标表征模型,提高了MS的跟踪性能,但改进型的LBP纹理模式也大大增加了算法的计算量。近年来,对视觉显著度的研究逐步升温[11-12],受此启发,Tavakoli等[13]等在原始LBP的基础上,提出了一种简化模型——局部相似数量(local similarity number,LSN)这一纹理描述子,以邻域内相似像素的数量作为中心像素的局部显著度; 在此基础上,张红颖等[14]提出了局部三值数量(local ternary number,LTN)纹理模式,用二维向量来代替LSN中的一维描述,并结合色度信息完成目标跟踪。

LSN算子由于在同一局部显著度下还包含不同纹理结构,无法较好地处理目标与背景纹理相似的情况。本文受文献[15]的启发,利用以中心像素为对称点的局部梯度信息,提出了中心对称局部相似数量(center symmetric-local similarity number,CS-LSN)模型这一新的局部显著度纹理描述算子; 进而生成CS-LSN掩模,提取出候选目标区域中具有CS-LSN的5种主要模式的关键像素。利用CS-LSN掩模能更充分地提取出目标框中的真实目标信息,有效抑制背景像素的影响,并减少后续目标表征模型中的计算量; 最后将抗光照能力强的色度信息融入到MS框架,完成目标跟踪。

1局部显著度纹理描述算子

1.1LSN纹理描述算子

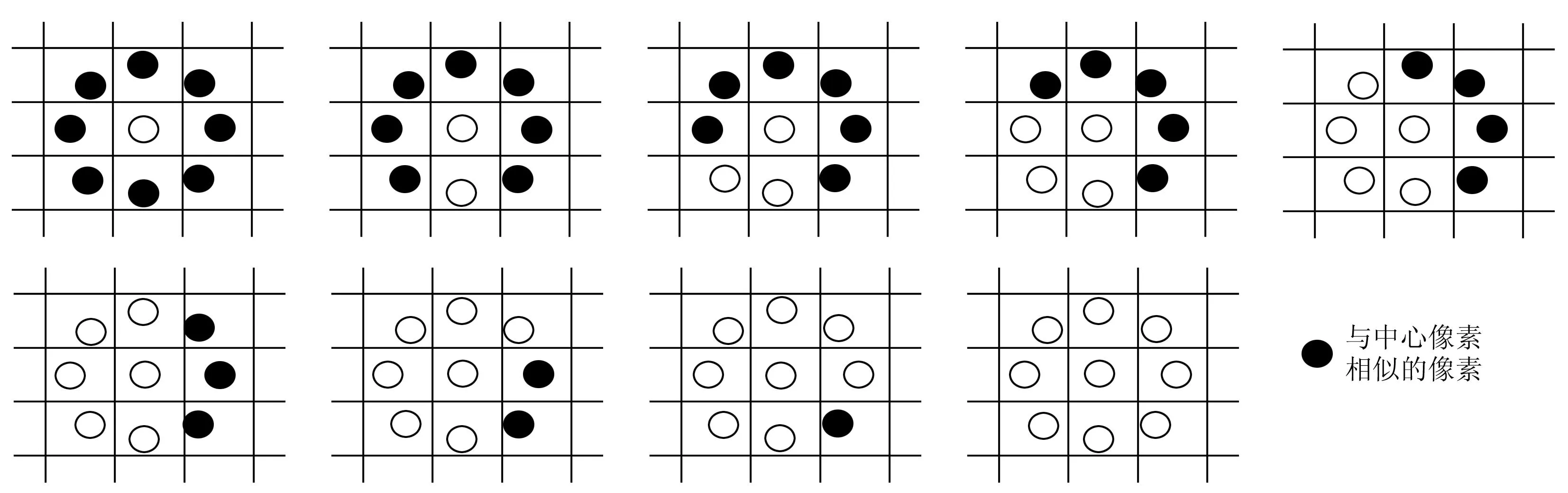

LSN是一种点样本估计纹理描述算子,不考虑邻域内像素与中心像素之间的结构信息,直接利用与中心像素值相似的像素数量描述中心像素的局部显著度,即

(1)

(2)

图1 9种局部显著度

1.2CS-LSN纹理描述算子

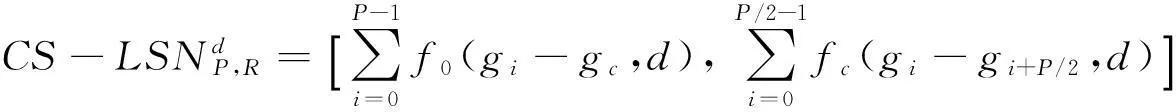

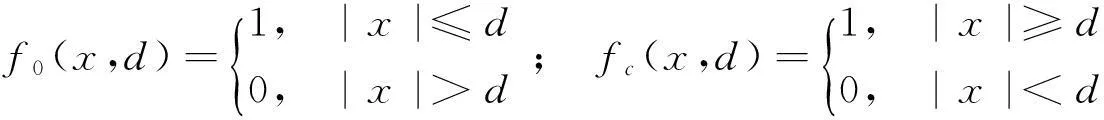

从图1可以看出,同一局部显著度下也可能包含不同的纹理结构,当目标与背景纹理相近时,LSN将无法很好地描述目标。为此,本文在LSN算子的简单高效基础上加以拓展,加入以中心像素为对称点的局部梯度信息,提出CS-LSN这一新的局部显著度纹理描述算子。该算子通过计算以中心像素为对称点的4组邻域像素点的亮度差,并结合原始LSN算子形成一组二维向量,即

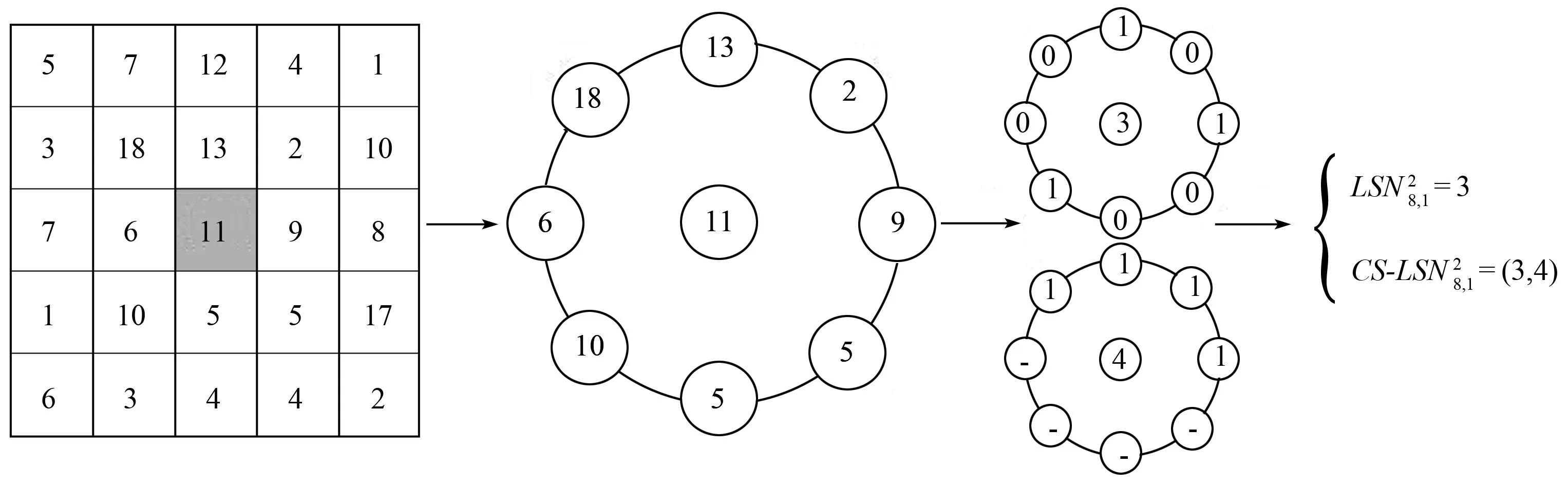

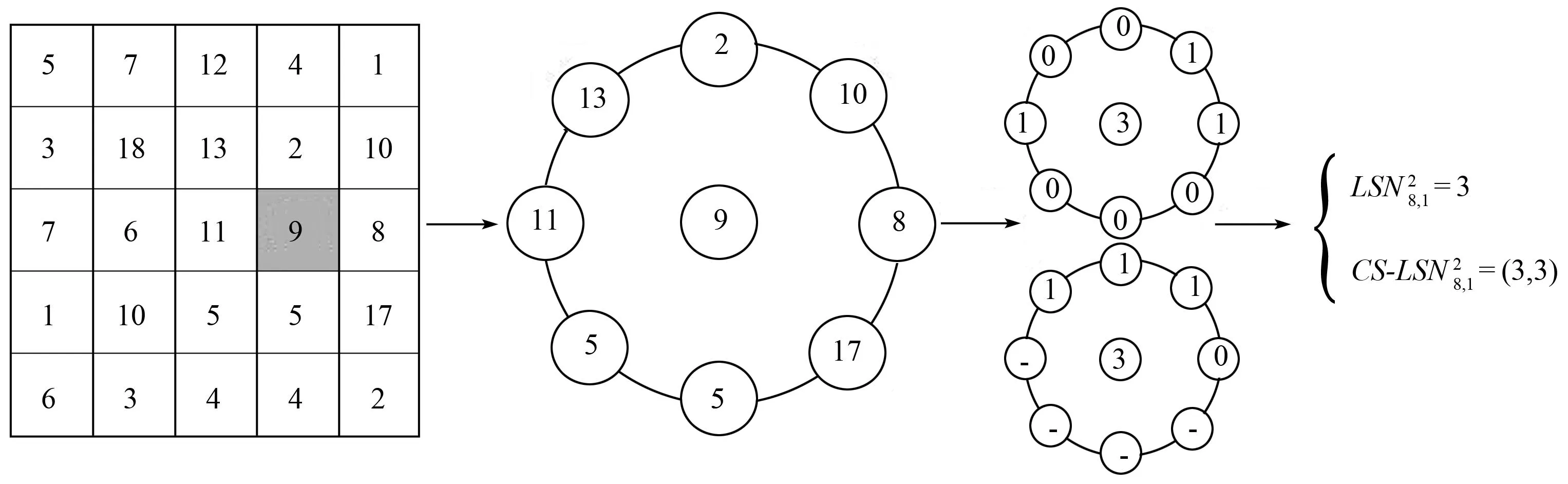

(3)

式中:gc为中心像素值;gi为邻域像素值;d为允许差异值;

(4)

本文以P=8,R=1,d=2(即邻域像素与中心像素差值小于2时判定为相似)为例来说明CS-LSN算子的生成过程。图2示出2组中心像素的LSN和CS-LSN算子的计算过程(图中第3列的中心位置是8邻域像素中被判定为1的个数)。可以看出,2组示例具有不同的纹理结构,但LSN算子计算得到的局部显著度都是3; 而CS-LSN算子通过计算以中心像素为对称点的局部梯度信息,形成一个二维向量描述,由式(3)得到的示例1和示例2分别为(3,4)和(3,3),这就很好地区分开不同的纹理结构。将CS-LSN算子引入MS跟踪框架,可以提高目标表征模型的抗干扰能力; 此外,CS-LSN算子计算中心像素之间的差值关系时,不受场景中光照变化的影响,且对尺度和旋转变化也有较好的适应性。

(a) 示例1

(b) 示例2

2基于 CS-LSN的目标跟踪算法

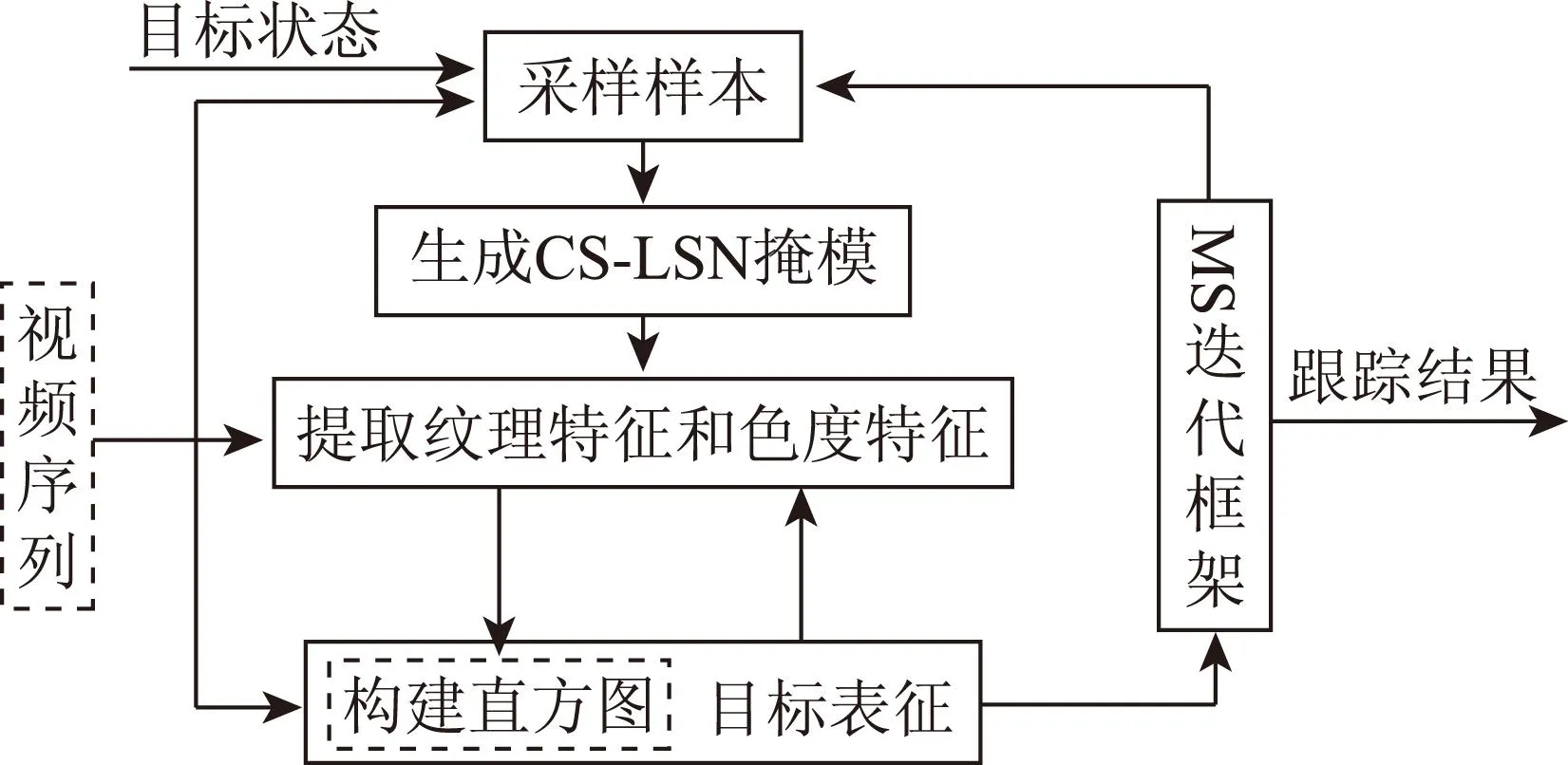

本文利用CS-LSN掩模提取真实目标像素的CS-LSN纹理特征和色度特征,构建直方图,完成目标表征; 进而将其嵌入到MS框架中,完成目标跟踪。算法框架如图3所示。

图3 本文算法框架

2.1基于CS-LSN掩模的目标表征

文献[13]对图1中9种局部显著度进行分析,以保留角点、边缘、线等具有较高区分能力的真实目标像素为出发点,生成LSN掩模。为此,本文定义CS-LSN掩模为

(5)

利用1组运动员头像中的头部为跟踪目标,分别给出了采用文献[8]提出的LBP掩模和本文提出的CS-LSN掩模提取目标像素的结果(图4)。

(a) 原始目标块

(b) LBP掩模提取目标像素

(c) CS-LSN掩模提取目标像素

从图4可以看出,目标与背景颜色存在一定的相似性,直接将原始目标块中的所有像素形成颜色直方图进行MS迭代,将会发生局部收敛导致跟踪漂移的情况; 如果能尽量减少目标区域中背景像素的影响,则能使跟踪器更好地收敛到真实目标上。图4(b)中LBP掩模能较好提取出真实目标像素,但同时也丢失了大量的真实目标像素。图4(c)表明,本文提出的CS-LSN掩模能更好地保留目标的完整性,并有效地抑制了背景像素。

由于HSV彩色空间中的色度(H)分量受光照影响不大,本文拟将其作为目标的颜色特征度量,量化成16个色度区间,且只提取用式(5)所示的CS-LSN掩模提取到的目标像素的色度信息,从而减少了对非真实目标像素的计算。而决定纹理特征度量的CS-LSN掩模决定的二维向量各有5种取值(同样只对CS-LSN掩模提取到的目标像素进行计算),因此,本文的多特征目标表征模型为16×5×5维直方图。

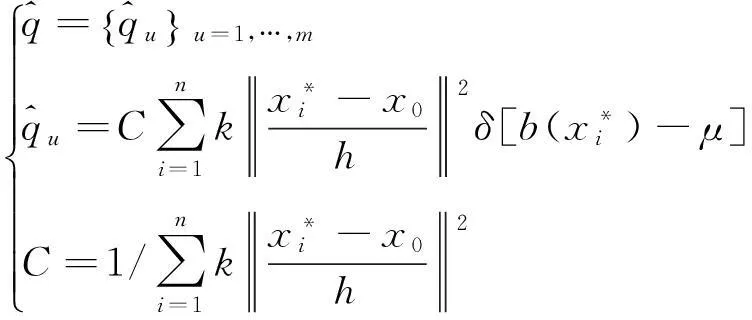

2.2MS跟踪框架

(6)

同理可计算候选目标区域的各特征空间量化值pu(y),其中y为中心坐标。然后通过MS迭代进行目标定位,文献[2]证明从现有中心到新的中心可利用以下迭代式,即

(7)

式中:g(x)=-k′(x);y1为迭代得到的目标中心位置;xi为第i个像素所在位置;wi为xi所在位置的权重;pu(y)为当前目标中心位置的各特征空间量化值。

2.3目标跟踪算法描述

结合2.1节中的目标表征方法和2.2节中的MS跟踪框架,确定本文的目标跟踪算法步骤如下:

2)同理计算候选目标区域模型pu(y0),y0为区域中心;

3)根据得到的pu(y0)计算候选目标区域权重,并代入式(7)进行迭代,得到新的候选目标中心;

5)读取下一景图像,转向步骤2)。

3实验与结果分析

本文选用不同场景下的3组测试视频,将本文算法与文献[8](基于LBP模型)和文献[13](基于LSN模型)中的跟踪算法进行对比分析,以验证本文算法的优越性。实验平台采用Intel Core(TM)2 Duo CPU主频2.5 GHz的PC机,利用OpenCV2.4.9在VS2010上进行调试,进行算法准确性和实时性分析。

3.1评估标准

实验采用文献中常见的3个评估标准对算法的性能进行测试。

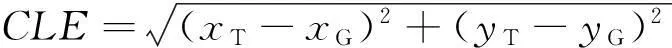

1)平均跟踪误差(center location error,CLE)。定义为

(8)

式中: (xT,yT)为跟踪结果的中心位置; (xG,yG)为目标的真实位置。取每组测试视频序列前200帧(由于前2种算法在200帧后可能会出现目标完全丢失的情况)的中心位置误差平均值作为评估标准。

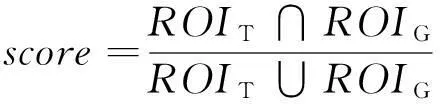

2)跟踪成功率(success rate,SR)。定义每一帧跟踪结果的得分为

(9)

式中:ROIT为跟踪结果区域;ROIG为目标真实区域(人工标注)。若score>0.5,则认为跟踪结果是正确的。

3)算法跟踪速度。以单位时间处理的帧数(帧/s)为评估标准。

4)平均迭代次数。因为本文算法采用了Mean Shift迭代框架,为验证用2.1节中CS-LSN掩模提取目标真实像素的有效性,本文将各算法的平均迭代次数也作为评估标准。

3.2结果分析

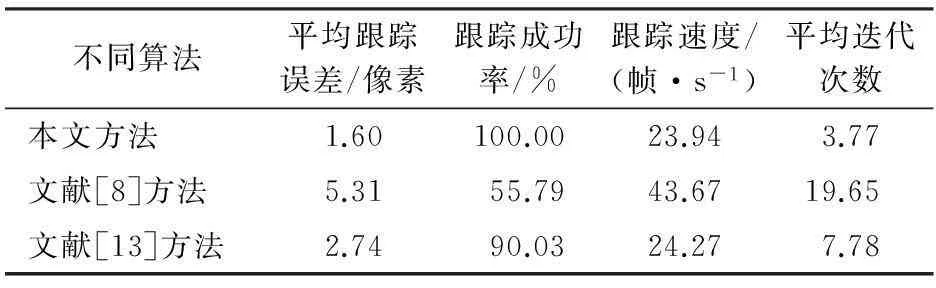

3.2.1实验1

为验证算法的抗背景干扰能力,选用文献[16]中的机场小车视频(共365帧)进行实验。实验的任务是跟踪大小为29像素×25像素的中间那辆白色小车,跟踪目标较小,颜色信息单一,纹理结构较平坦,与背景中的前后2辆车极为相似。图5分别给出了3种算法的部分跟踪结果(分别为第50,100,243,253和300帧)。

(a) 基于LBP模型[8]

(b) 基于LSN模型[13]

(c) 基于CS-LSN模型

从图5可以看出,在第243帧时,文献[8]的方法已严重漂移; 文献[13]的方法也出现了漂移情况,但在253帧时重新搜索到目标; 本文算法则能稳定地完成跟踪任务。这是因为本文提出的CS-LSN掩模能较好地去除目标框中的背景像素信息,所提取的纹理信息能够较好地表征目标。表1给出了3种方法跟踪性能的定量分析结果。可以看出,尽管本文方法的跟踪速度较其他2种算法有所降低,但跟踪成功率能够达到100%,且23.94帧/s的跟踪速度基本能够满足实时处理的需求。同时,用本文的CS-LSN掩模提取目标真实像素过程中,减少了背景像素的干扰,使得MS迭代次数比其他2种算法都低。

表1 实验1中不同算法的跟踪性能

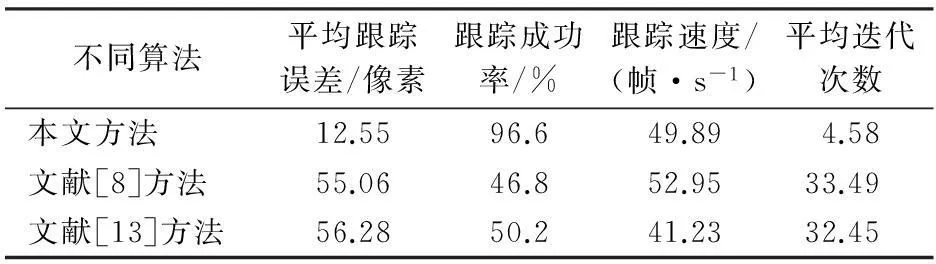

3.2.2实验2

为验证算法的抗遮挡能力,选用文献[17]中的小车视频序列(共610帧)进行实验。目标大小为108像素×53像素,视频序列中多次出现遮挡(第185—245帧出现了长时间遮挡,第345—365帧和第450—465帧出现了短时遮挡)。图6分别给出了3种算法的部分跟踪结果(分别为第25,206,247,352和364帧)。

(a) 基于LBP模型[8]

(b) 基于LSN模型[13]

(c) 基于CS-LSN模型

从图6可以看出,文献[8]的LBP模型无法准确地描述目标在第25帧出现的跟踪漂移; 而文献[13]的方法在第247帧时目标被遮挡后不能再搜索到目标; 本文方法用CS-LSN算子提取的纹理特征具有较高的目标表征能力,在目标被长时及短时遮挡后,依然能够继续锁定目标,出现了如图6(c)的鲁棒跟踪效果,表现出了一定的抗遮挡能力。表2给出了3种方法跟踪性能的定量分析结果。

表2 实验2中不同算法的跟踪性能

从表2可以看出,本文算法的跟踪速度与其他2种算法相当,但跟踪成功率较其他2种算法分别提高了65.9%和59.67%。由于CS-LSN掩模抑制了候选目标框中的大量背景像素,使得目标跟踪速度得到了提升,达到40.48帧/s。

3.2.3实验3

为验证算法抗光照变化和物体形变能力,选用David标准测试视频[18](共250帧)。目标大小为73像素×70像素,视频序列中光照由弱到强,人脸在第170帧发生转动时目标形变较大。图7分别给出了3种算法的部分跟踪结果(分别为第5,31,117,170和200帧)。可以看出,当背景中光照发生变化时,3种方法在第31帧均出现目标漂移,但本文方法很快将目标重新定位; 在第170帧时,文献[8]和[13]的方法均完全跟踪到了错误的目标,而本文的CS-LSN算子采用二维向量来表征目标真实像素,因此能较好区分目标与背景的纹理结构,表现出了良好的抗光照变化能力。3种方法跟踪性能的定量分析结果见表3。

(a) 基于LBP模型[8]

(b) 基于LSN模型[13]

(c) 基于CS-LSN模型

表3 实验3中不同算法的跟踪性能

从表3可以看出,本文算法的处理速度与其他2种算法相当,但跟踪成功率较其他2种算法分别提高了49.8%和46.4%。人脸在第170帧发生转动时形变较大,导致跟踪结果出现了较大偏移,从而使本文方法的平均跟踪误差达到了12.55像素。

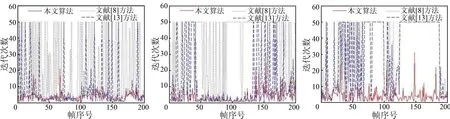

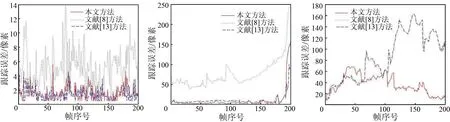

最后,给出3组实验的迭代次数曲线(图8)和跟踪误差曲线(图9)。

从图8可以看出,本文方法在3组视频中的迭代次数基本稳定在2~5次,在不同场景中表现出较强的鲁棒性,体现了用本文CS-LSN掩模提取目标真实像素的高效性以及CS-LSN纹理特征较强的目标表征能力。

(a) 实验1 (b) 实验2(c) 实验3

图83组实验的单帧迭代次数曲线

Fig.8Iterating times of single frame in three experiments

(a) 实验1 (b) 实验2(c) 实验3

图93组实验的单帧跟踪误差曲线

Fig.9Single frame’s tracking error of three experiments

从图9中可以看出,本文方法在实验1中跟踪效果最好,中心位置误差基本保持在4像素以内。在实验2中,由于在第190帧以后目标被部分遮挡,导致本文方法的跟踪误差偏大; 但当目标重新出现在场景中时,本文算法依然能够准确定位到目标。在实验3中,当目标尺度发生变化时,本文方法出现跟踪误差偏大的情况,但随后跟踪误差依然稳定在20像素以内; 而其他2种算法则完全丢失了目标。

4结论

1)本文从提高目标表征能力的角度提升目标跟踪性能,提出了一种新的纹理描述算子——中心对称局部相似数量(CS-LSN)模型。该算子能区分同一局部显著度下的不同纹理结构,且通过CS-LSN掩模能较好地剔除目标框中的背景像素,保留真实目标像素; 通过计算真实目标像素位置的CS-LSN掩模纹理特征和色度特征,代入MS框架完成跟踪。

2)实验结果表明,本文方法在目标与背景相似、部分遮挡、光照变化及物体形变等情况下,都能完成鲁棒跟踪; 不同场景下跟踪成功率保持在95%以上,目标大小为29像素×25像素时处理速度约为24帧/s。

3)但当目标被严重遮挡以及目标尺度发生突变时,本文方法出现了跟踪误差变大的情况。为此,下一步研究将结合遮挡判断机制以及目标尺度自适应变化机制对本文方法进行改进。

参考文献(References):

[1]Maggio E,Cavallaro A.Video Tracking: Theory and Practice[M].London,UK:Queen Mary University of London,2012.

[2]Comaniciu D,Ramesh V,Meer P.Kernel-based object tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2003,25(5):564-577.

[3]杨欣,费树岷,李刚,等.基于复杂特征融合的改进mean shift目标跟踪[J].控制与决策,2014,29(7):1297-1300.

Yang X,Fei S M,Li G,et al.Improved mean shift tracking algorithm based on complicated feature fusion[J].Control and Decision,2014,29(7):1297-1300.

[4]Vojir T,Noskova J,Matas J.Robust scale-adaptive mean-shift for tracking[J].Pattern Recognition Letters,2014,49:250-258.

[5]Li S X,Wu O,Zhu C F,et al.Visual object tracking using spatial context information and global tracking skills[J].Computer Vision and Image Understanding,2014,125:1-15.

[6]董文会,常发亮,李天平.融合颜色直方图及SIFT特征的自适应分块目标跟踪方法[J].电子与信息学报,2013,35(4):770-776.

Dong W H,Chang F L,Li T P.Adaptive fragments-based target tracking method fusing color histogram and SIFT features[J].Journal of Electronics and Information Technology,2013,35(4):770-776.

[7]Maenpaa T,Pietikainen M.Texture analysis with local binary patterns[M]//Handbook of Pattern Recognition and Computer Vision.USA:World Scientific Pub.Co.Inc,2005:197-216.

[8]Ning J F,Zhang L,Zhang D,et al.Robust object tracking using joint color-texture histogram[J].International Journal of Pattern Recognition and Artificial Intelligence,2009,23(7):1245-1263.

[9]张涛,蔡灿辉.基于多特征Mean Shift的人脸跟踪算法[J].电子与信息学报,2009,31(8):1816-1820.

Zhang T,Cai C H.A face tracking algorithm based on multiple feature mean shift[J].Journal of Electronics & Information Technology,2009,31(8):1816-1820.

[10]张炯,宁记峰,颜永丰,等.对立色LBP模型的目标跟踪[J].中国图象图形学报,2012,17(11):1418-1424.

Zhang J,Ning J F,Yan Y F,et al.Object tracking with opponent color LBP model[J].Journal of Image and Graphics,2012,17(11):1418-1424.

[11]Borji A,Itti L.State-of-the-art in visual attention modeling[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(1):185-207.

[12]黎万义,王鹏,乔红.引入视觉注意机制的目标跟踪方法综述[J].自动化学报,2014,40(4):561-576.

Li W Y,Wang P,Qiao H.A survey of visual attention based methods for object tracking[J].Acta Automatica Sinica,2014,40(4):561-576.

[13]Tavakoli H R,Moin M S,Heikkila J.Local similarity number and its application to object tracking[J].International Journal of Advanced Robotic Systems,2013,10:184.

[14]张红颖,胡正.融合局部三值数量和色度信息的均值漂移跟踪[J].电子与信息学报,2014,36(3):624-630.

Zhang H Y,Hu Z.Mean Shift tracking method combing local ternary number with hue information[J].Journal of Electronics and Information Technology,2014,36(3):624-630.

[15]Heikkila M,Pietikainen M,Schnid C.Description of interest regions with local binary patterns[J].Pattern Recognition,2009,42(3),425-436.

[16]陈东成,朱明,高文,等.在线加权多示例学习实时目标跟踪[J].光学精密工程,2014,22(6):1661-1667.

Chen D C,Zhu M,Gao W,et al.Real-time object tracking via online weighted multiple instance learning[J].Optics and Precision Engineering,2014,22(6):1661-1667.

[17]Kalal Z,Mikolajczyk K,Matas J.Tracking-learning-detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(7):1409-1422.

[18]Babenko B,Yang M H,Belongie S.Robust object tracking with online multiple instance learning[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(8):1619-1632.

(责任编辑: 刘心季)

Mean shift object tracking based on center symmetric-local similarity number model

LIU Wei1, ZHAO Wenjie1, LI Cheng1, LI Ting1, TAN Haifeng1, MA Yangming2

(1. Department of Aerospace Intelligence, Aviation University of Air Force, Changchun 130022, China;2.PLA73608Troop,Nanjing210000,China)

Abstract:In order to complete the task of real-time object tracking, this paper proposes a new local texture description operator, which is called center symmetric-local similarity number(CS-LSN). The operator analyzed the center pixel and its eight neighborhood pixels, on the basis of the local similarity number (LSN); as the texture operator fails to distinguish the same local saliency of different texture structures, the authors added the local gradient information using the center pixel as the symmetric point, extracted the key pixels which correspond only to the five major patterns of the CS-LSN in the target candidate region, effectively restrained the influence of the background pixels and reduced the computation in the target representation model, and then represented target by CS-LSN texture feature and the chromaticity in the true target pixel, which was embedded into the mean shift(MS) tracking framework. The experimental results show that the proposed method can continuously track the target when the background and the color are similar under the condition of changing illumination and in the occlusion cases. The processing speed can reach 25 frames or so per second when the object is 29 pixel×25 pixel, so it can satisfy the demand of real-time application.

Keywords:object tracking; texture feature; center symmetric-local similarity number(CS-LSN); mean shift (MS)

doi:10.6046/gtzyyg.2016.03.07

收稿日期:2015-04-03;

修订日期:2015-05-04

中图法分类号:TP 751.1; TP 391

文献标志码:A

文章编号:1001-070X(2016)03-0037-09

第一作者简介:刘威(1991-),男,硕士研究生,主要研究方向为计算机视觉及目标跟踪。Email: 1224337250@qq.com。

引用格式: 刘威,赵文杰,李成,等.基于中心对称局部相似数量模型的均值漂移目标跟踪[J].国土资源遥感,2016,28(3):37-45.(Liu W,Zhao W J,Li C,et al.Mean shift object tracking based on center symmetric-local similarity number model[J].Remote Sensing for Land and Resources,2016,28(3):37-45.)