基于动态模板匹配的移动机器人目标识别*

彭玉青,李 木,高晴晴,张媛媛(河北工业大学计算机科学与软件学院,天津300401)

基于动态模板匹配的移动机器人目标识别*

彭玉青*,李木,高晴晴,张媛媛

(河北工业大学计算机科学与软件学院,天津300401)

摘要:将视觉显著性与基于动态模板匹配的目标识别方法相结合,提出了一种适用于未知环境下的移动机器人目标识别方法。具体而言,首先设计了基于分布式控制的移动机器人视觉系统,提高了视频处理效率;之后利用基于背景先验的显著性检测方法对图像进行预处理,排除了相对次要的背景区域;最后对处理后的图像进行动态模板匹配,提高了目标识别的准确率。实验结果表明,该方法能够满足移动机器人在目标识别过程中对图像处理的实时性和准确性的要求,具有良好的有效性。

关键词:移动机器人;目标识别;模板匹配;视觉显著性;分布式控制

在利用移动机器人进行侦察、探测和导航时,由于目标及场景的动态变化、遮挡、相似物干扰或光线剧烈变化等复杂因素,未知环境下的移动机器人目标识别已经成为一项极具挑战性的任务[1-2]。根据文献[3-10]的介绍,移动机器人目标匹配算法大体上可分为四类:第1类是模板匹配算法[3-5],此方法根据模板逐点扫描待检测图像,计算图像各点同模板的匹配度,据此完成目标识别;第2类是区域匹配算法[6-7],此方法把目标图像分成若干区域,通过获取各区域与原始目标之间的相关性来进行识别;第3类是特征匹配算法[8-9],此方法不考虑目标图像的整体特性,仅通过一些个体特征来进行识别;第四类是概率模型匹配算法[10],该方法将基于贝叶斯规则的概率模型引入到匹配算法中,从而完成对目标物体的识别。虽然这些匹配算法在各自的文章中都得到较好实现,但在对实时性要求严格的移动机器人目标识别中,如何提高匹配速度仍是一个难点。

针对传统匹配算法中存在的计算量大、实时性差等问题,本文在引入视觉显著性的基础上将移动机器人目标识别分成预处理图像和动态模板匹配两个阶段:①利用基于背景先验知识的显著性检测方法对图像进行预处理。此方法通过两种背景先验知识来获取图像的显著区域,其处理速度快,使机器人在大量图像信息中迅速地筛选出感兴物体,从而降低了信息处理的计算量,非常适用于移动机器人实时性目标识别。②利用动态模版匹配算法进行目标物体识别。由于目标物体的成像大小随着机器人的运动不断变化,如果仅根据预知的目标物体图像进行模板匹配,很容易导致识别失败。因此,我们利用采集得到的图像动态生成与之相匹配的目标图像,然后使用所生成的目标图像作为模板进行匹配,提高了移动机器人目标识别的准确率。

1 分布式视觉系统

分布式控制系统(Distributed Control System)是多智能体技术在移动机器人研究领域的重要应用[11]。在移动机器人视觉系统中引入分布式控制,不但降低了控制系统的复杂度,提高了视频信息的处理速度,还有效的减轻了移动机器人自身负重。

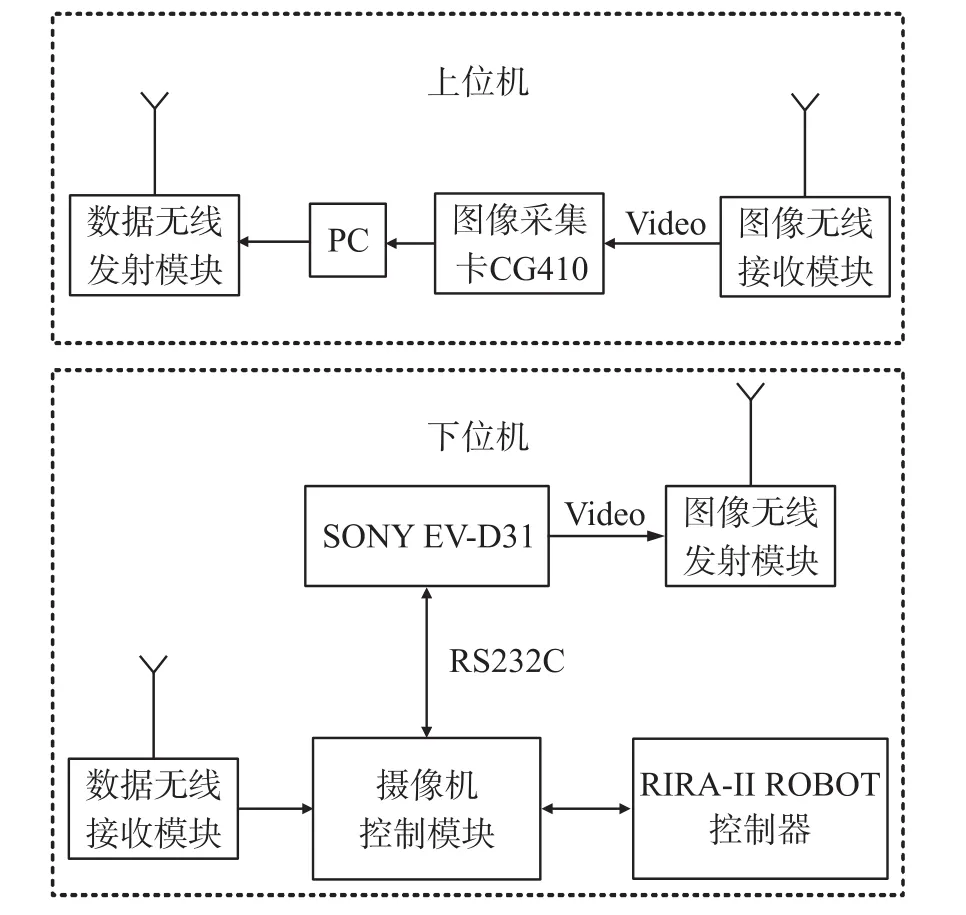

RIRA-II移动机器人采用上下位机分布式视觉系统。上位系统由个人计算机(PC)、图像无线接收模块、数据无线发送模块和图像采集卡组成,主要用来完成图像处理、显示及目标识别等功能;下位系统由EV-D31摄像机、图像无线发射模块、数据无线接收模块、摄像机控制模块和RIRA-II移动机器人组成,主要用来完成摄像机控制及图像采集。RIRA-II移动机器人分布式视觉系统如图1所示。

图1 RIRA-II移动机器人分布式视觉系统

其中移动机器人控制器选用高性能微处理器AT89S52,机器人可通过摄像机控制模块实现对摄像机云台的实时控制及云台位姿参数的实时获取,当摄像机采集到图像信息后,会经图像无线发射模块传至上位机,由上位机完成相关图像处理,处理完的结果通过数据无线发射模块传至下位机,最终实现移动机器人对目标的识别。EV-D31摄像机安装于RIRA-II移动机器人的前背部,摄像机云台纵轴线与机器人重心所在的纵轴线重合。RIRA-II移动机器人外观见图2。

图2 RIRA-II移动机器人外观图

2 背景先验的显著性检测

视觉注意机制[12]使人类可以在短时间内寻找到视野中的显著性区域,有效的压缩完成复杂视觉认知任务所需的计算量。因此,如果将基于视觉注意机制的显著性检测方法引入到移动机器人图像处理中,则可以有效的提高机器人目标识别效率。

2.1背景先验理论

传统的显著性检测方法往往直观或隐含的使用对比先验(contrast prior)理论,但仅依据图像的对比度来进行显著性检测存在着一定的局限性[13]。对于移动机器人运动过程中所拍摄的图像,其背景往往分散杂乱,如果能预先排除部分背景,则有助于更好的突出显著性区域。因此我们采用两种基于背景先验的理论[14]:①边界先验(boundary prior)源自摄影构图的基本规则,也就是大多数摄影师都不会把显著性目标放在图像边缘。换句话说,图像边界处大多为背景区域。这种边界先验比以前使用的中心先验(center prior)即“图像中心最重要”更具有普遍性,因为显著性目标可以偏离中心(三分之一规则),但很少触及图像边界。②连通性先验(connectivity prior)源自现实世界中背景图像的外观特征,即背景区域通常大而均匀。换句话说,在背景区域大多数像素块可以很容易地彼此连接,但是这种连接只限于相似物体本身。例如,天空和海洋容易连接到一起,而天空和草地之间则不容易连接。

2.2显著性检测算法

基于以上两种背景先验知识,本文在移动机器人目标识别中使用显著性检测算法对图像进行预处理,具体步骤如下:

①SLIC超像素分割

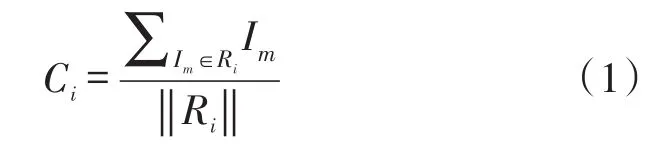

由于移动机器人的工作环境比较复杂,其拍摄到的图像往往包含着一些不必要的信息,使用超像素分割可以在保留目标物体边缘信息的同时消除背景区域中不必要的噪声和纹理细节;另外移动机器人对实时性要求较高,如果直接对图像的每个像素进行处理,其运算量会非常大,而使用超像素分割后只需以像素块为单位处理,大大降低了图像处理的复杂度。在已知的超像素分割算法中,SLIC算法运算速度快,可以产生大小均匀形状规则的超像素[15],因此本文采用此算法对图像进行预处理分割。定义每个超像素Ri的平均像素Ci为:

式中,Im为超像素Ri中每个像素点的像素。为超像素Ri中像素点的个数。

②计算超像素显著性在文献[14]中,Wei等人定义某一超像素的显著性为与背景区域中超像素的最短距离,但使用这种方法可能产生漏检现象,即忽略某些重要目标。在文献[16]中,若定义某一超像素的显著性为与背景区域中所有超像素的距离和,可能会产生误检现象,即把某些不重要的背景区域当作目标。

根据先验知识,我们已经知道超像素Ri在图像中的位置信息对其是否引起人们的注意有很大影响。当超像素距离图像中心较近时,则很容易引起人们注意;而距离图像中心较远时,人们往往会忽视它的存在。因此我们定义一个修正系数g(i):

式中,(x,y)是超像素Ri的中心坐标;(x0,y0)是图像的中心坐标;δx和δy是对应的控制参数,它们的值与图像尺寸成正比。最后,定义超像素Ri的显著性为:

式中,Cj(j=1,2,…,k)是边界超像素Rj的平均像素。D(Ci,Cj)是超像素Ri与超像素Rj的像素距离,这里采用欧氏距离来对其进行计算。

③显著性目标接触边界的处理办法

本文以两种背景先验理论进行显著性检测,但有时目标物体可能触及图像边缘,此时算法的检测性能会有所降低。由于移动机器人拍摄图像的特殊性,可以很轻易的避免这种情况。当目标物体接触图像边界时,我们通过上位机调整摄像头位资参数,使目标区域脱离图像边缘,因此大大减少了显著性检测的误差。

综上所述,本文在图像预处理阶段所使用的方法更具有优势,对比文献[17]中使用区域生成法对移动机器人采集的图像进行预处理,虽然区域生长算法也能提供良好的边界信息和分割结果,并通过进一步设定阈值排除图像中面积过大的背景和面积过小的噪声,但其计算代价大,对图像中的阴影处理效果不是很好。而本文中引入一种基于背景先验的显著性检测方法,把研究重点放到了图像背景上,通过这个预处理阶段,排除了图像中相对次要的背景区域。算法容易实现、处理速度快,可以较好的保留显著性区域的边缘,适用于同时需求精度与速度的移动机器人目标识别。

3 动态模板匹配

模板匹配是数字图像处理的重要组成部分之一,其成熟稳定、分类能力好、识别精度高,现已被广泛用于移动机器人目标物体识别。

3.1模板匹配算法简介

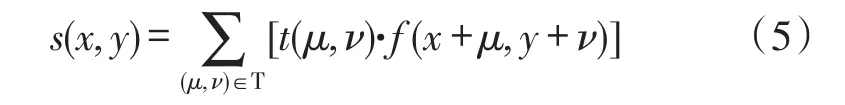

模版匹配技术是指根据已知模式(模版图)到另一幅图(搜索图)中寻找相应模式的处理方法。最简单的模版匹配方法是基于灰度值的模板匹配。假设模板由一副图像t(x,y)以及相应的感兴区域T指定,由模板匹配概念可知,我们需沿图像中所有点移动模板并在每个位置计算相似度S。因此,相似度S是一个函数,函数中的参数包括模板中各点的灰度值t(x,y)以及模板感兴区域中的灰度值f(x+μ,y+ν),然后基于这些灰度值计算一个标量值作为相似度量S(x,y),其等式为:

综上所述,若仅依靠基于灰度值的模板匹配算法进行目标识别则存在计算量大、复杂度高等缺陷,但模板匹配算法仍具有简单易行、匹配精度高等优势。

3.2动态模板匹配算法

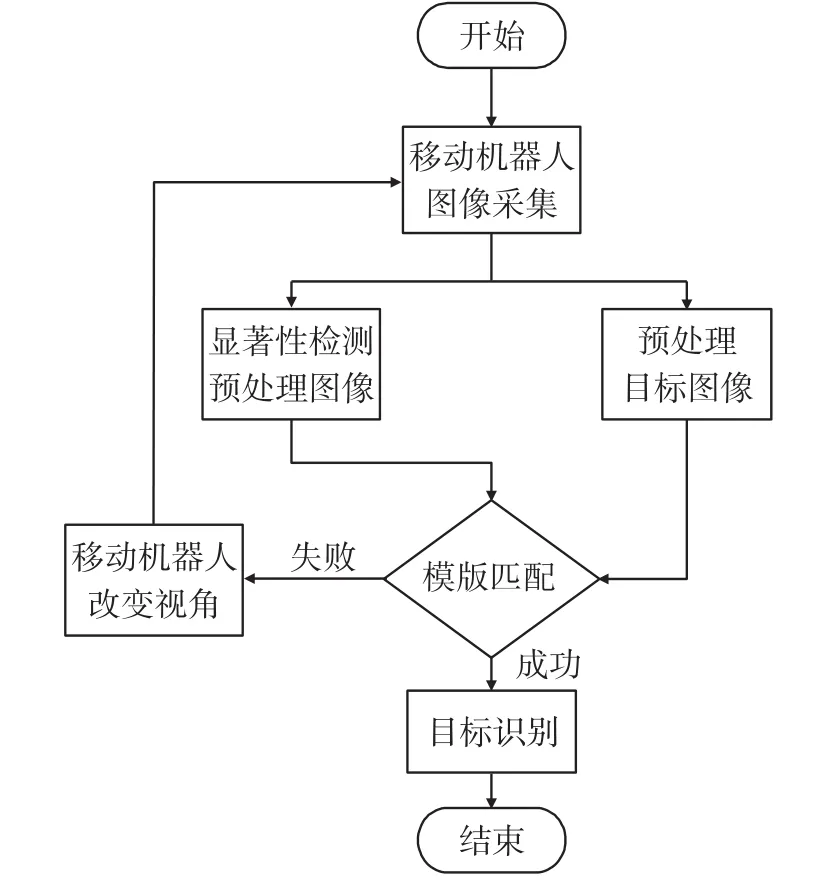

现实环境下,移动机器人是在运动过程中进行目标搜索的,所以机器人与目标之间距离会不断发生变化,从而导致目标物的成像大小也不断改变[16]。在这种情况下,如果根据预知的目标物体图像进行模板匹配,则很容易导致识别失败。因此,我们提出了一种动态模板匹配方法。与常规的模板匹配方法不同,我们在移动机器人搜索目标的过程中,根据当前采集的图像动态生成与其相匹配的目标图像,然后对所生成的目标物体图像进行处理,最后用其作为模板与预处理的显著图像进行匹配,其流程如图3所示。

图3 动态模板匹配流程

下面简述本文方法的主要过程:

①图像预处理阶段:使用基于背景先验的显著性检测方法对移动机器人采集到的图像进行预处理,得到图像显著性区域。此时显著性图像为一张灰度图,若图像中某区域的灰度值大于设定阈值,则认为这部分区域为目标图像的备选区域;反之,若某区域的灰度值小于设定阈值,则认为这部分是干扰区域,应当排除。

②动态模板生成:选定目标物体,并对目标物体图像进行预处理,包括灰度化、图像平滑、对比度拉伸、去噪、二值化等。之后依次根据显著图中各备选区域的长宽比例将预处理的目标物体图像拉伸到此比例,然后将拉伸后的图像作为动态模板。

③动态模板匹配阶段:使用相关匹配法从预处理得到的显著图中挑选出相似度最大的区域,如果这个相似度大于某个设定的阈值,则将此区域作为目标物体所在区域;如果没有发现目标,则改变机器人视角,继续对目标物体进行搜索。动态模板匹配的相似度量如式(5)所示:

式中,f(x+μ,y+ν)是搜索图像中模板感兴区域的各点的灰度值,t(μ,ν)是模板中各点的灰度值。

4 仿真实验与分析

为了验证上述方法的有效性,在实验室环境下使用RIRA-II移动机器人对目标物体进行识别。采用SONY EV-D31彩色摄像机获取移动机器人周边环境,输出NTSC制式视频信号;视频采集卡为大恒CG410,图像采集频率为30 frame/s,分辨率最大为640像素×480像素×32 bit;移动机器人上位机处理器是Intel P4 3.0G,操作系统是Windows XP。

在实验过程中,本文所已提出的方法同时满足了移动机器人目标识别的准确性与实时性。具体的实现过程如下:

①取移动机器人在某一时间点所拍摄的一帧图像,并通过机载图像无线发射模块传送至上位PC机。移动机器人拍摄的图像如图4所示,从图4可以看出移动机器人所处的实验室环境比较复杂,满足非结构化环境的设定。

图4 移动机器人拍摄的原图像

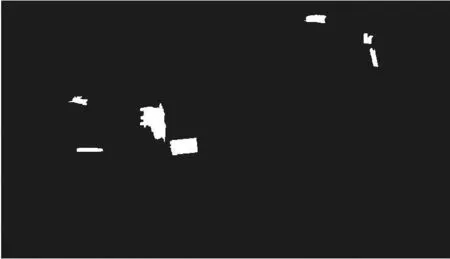

②使用基于背景先验的显著性检测方法对图像进行预处理。具体的,首先使用SLIC算法获得图像中每个超像素Ri的平均像素Ci,其规则符合式(1);之后根据超像素Ri在图像中的位置定义修正系数g(i),其规则符合式(2);最后求得每个超像素Ri的显著性Saliency(Ri),其规则符合式(3)。原图像预处理后的视觉显著性图像如图5所示。

图5 原图像处理后的显著性图像

从图5可以看出基于背景先验的显著性检测方法减少了图像中复杂背景区域的干扰,突出了显著性目标,缩减了动态模板匹配阶段的搜索量,提高移动机器人目标识别速率。

③设定某个接近255的整数值为阈值,由于在步骤②中得到的显著性图像为灰度图,且越显著的超像素块越接近白色,据此对显著图进行初步筛选:若图像中某区域的灰度值大于设定阈值,则认为这部分是目标图像的备选区域;反之,若某区域的灰度值小于设定阈值,则认为这部分是干扰区域,应当排除。显著图在经过初步筛选后的备选区域图像如图6所示,可以看出图中只留下了有可能成为目标物体的备选区域,为模板匹配阶段打下了基础。

图6 显著性图像处理后的备选区域图像

④预先确定移动机器人搜索过程中的目标物体图像(本次实验中为红旗,如图7(a)所示),对目标物体图像进行灰度化、图像平滑、去噪、二值化等预处理过程,得到的预处理模板图像如图7(b)所示。之后,依次根据显著图处理后各备选区域的长宽比例将预处理的目标物体图像拉伸到此比例,然后将拉伸后的图像作为动态模板。

图7 动态模板匹配目标识别结果

⑤以拉伸后的目标图像为模板,以显著性图像为搜索图,利用相关模版匹配法挑选相似度最大的区域。若匹配相似度s(x,y)大于设定阈值,则目标识别成功,得到的实验结果如图7(c)所示;反之,则目标识别不成功,移动机器人改变视角后跳转至步骤①。

在背景复杂多变的实验室环境下,本文所提出的方法利用视觉显著性有效排除了相对次要的背景区域,为移动机器人动态模板匹配做好了基础,减少了目标识别所需的时间。同时利用移动机器人所拍摄的图像动态生成目标图像,提高了未知环境下目标识别的准确率,最后使用相关模板匹配法在显著图中成功识别了目标物体。实验结果表明,视觉显著性与动态模板匹配相结合的方法可以有效克服传统模板匹配算法复杂度高等缺点。

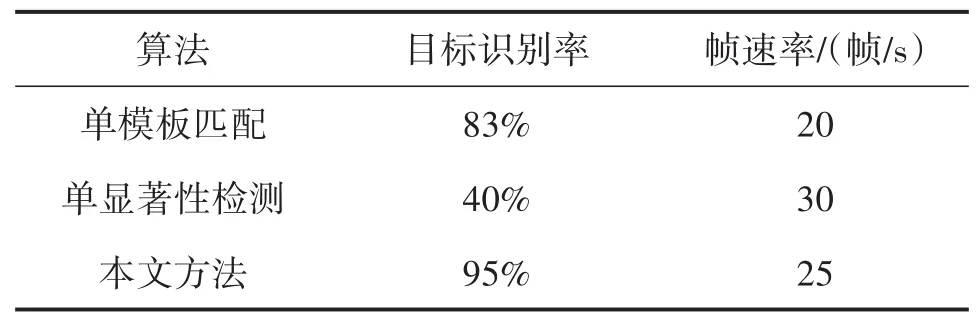

文献[18]中使用Gabor滤波器提取目标特征,当目标特征较少时,处理速度快,但目标识别率低;当目标特征较多时,目标识别率高,但处理速度慢,如何权衡处理速度和目标识别率显得尤为重要。因此,我们选取移动机器人处于不同光照、阴影下拍摄的500张图像进行目标识别,表1比较了在不同方法下的识别结果。从表中可以看出,单模板匹配识别效果较好,但处理速度只能达到20帧/秒,不足以满足移动机器人实时目标识别;单显著性检测的处理速度最快可达到30帧/秒,但只能消除图像中不必要的背景区域,识别率很低;而本文提出的方法有效的结合视觉显著性与模板匹配算法的优点,在满足移动机器人实时性要求的同时提高了目标识别的准确率。

表1 不同方法的比较结果表

由表1可知,虽然本文所提出的方法只有95%的识别率和25帧/秒的识别速度,但由于图像采集卡的采样速度、上位机的处理速度等客观因素都会影响到移动机器人目标识别的速率,另外由于目标物体受到光照、遮挡、阴影等因素的干扰,也有可能降低目标识别的准确率。因此,可以认为本实验中目标识别的准确率在合理范围之内,所提出的方法具有一定的实用价值。

5 结语

针对移动机器人的非结构化工作环境,本文提出了一种视觉显著性与动态模板匹配相融合的目标识别算法,有效的克服了传统模板匹配算法计算量大、实时性差等问题。在机器人的硬件设计上采用了分布式视觉系统,降低了系统的复杂程度,缩短了图像处理时间。在机器人的软件设计上将基于背景的显著性检测方法引入图像处理,通过模拟人类特有的视觉注意机制获取图像的显著区域,并将得到的显著图用于后期的动态模板匹配,提高了目标识别的速率与准确率。实验结果表明,该方法能够控制移动机器人在复杂多变的室内环境下识别目标源,具有实时实现的有效性,有一定的实用价值。

参考文献:

[1]Yin X,Noguchi N,Choi J. Development of a Target Recognition and Following System for a Field Robot[J]. Computers & Elec⁃tronics in Agriculture,2013,98(7):17-24.

[2]马如远,金明亮,刘继忠,等.移动机器人环境视觉小波稀疏压缩传感和识别[J].传感技术学报,2012,25(4):519-523.

[3]Shin B,Park S,Ju J. Fast and Robust Template Matching Algo⁃rithm in Noisy Image[C]//ICCAS 2007:Proceeding of the 2007 IEEE Conference on Control,Automation and Systems. IEEE,2007:6 -9.

[4]Yang L,Zhang X,Ren J. Precision Detection of CCD Splicing Based on Template Matching Algorithm[C]//Proceeding of the 2011 IEEE Conference on Computing,Control and Industrial En⁃gineering.(CCIE). 2011:224-227.

[5]张青涛,杨学友,刘涛,等.基于快速模板匹配的智能视觉传感器设计[J].传感技术学报,2010,26(8):1039-1044.

[6]Hariharakrishnan K,Schonfeld D. Fast Object Tracking Using Adaptive Block Matching[J]. IEEE Transactions on Multimedia,2005,7(5):853-859.

[7]Ma R,Yun J,Zhuang X. Study on Pulse Noise Removal Method for Motion Picture Using Block Matching[J]. International Journal of Digital Content Technology & Its Applications,2012,6:299-306.

[8]Ozaki R,Satoh Y,Iwata K,et al. Template Matching by the Statis⁃tical Reach Feature Method[J]. Electronics & Communications in Japan,2013,96(11):54-69.

[9]顾鑫,李喆,王华,等.基于粒子滤波后验概率分布的多特征融合跟踪[J].传感技术学报,2014,27(12):1676-1680.Isard M. Condensation-Conditional Density Propagation for Visual Tracking [J]. International Journal of Computer Vision,1998,29(1):5-28.

[10]彭玉青,李木,张媛媛.基于改进模糊算法的移动机器人避障[J].计算机应用,2015,35(2):2256-2260.

[11]黎万义,王鹏,乔红.引入视觉注意机制的目标跟踪方法综述[J].自动化学报,2014,40(4):561-576.

[12]张学武,徐立中,石爱业,等.基于视觉仿生机理的成像目标检测和识别方法及感知计算[J].传感技术学报,2010,23(12):1736-1743.

[13]Wei Y,Wen F,Zhu W,et al,Geodesic Saliency Using Back⁃ground Priors[C]//Proceeding of the European Conference on Computer Vision(ECCV). Berlin:Springer-Verlag,2012:29-42.

[14]Achanta R,Shaji A,Smith K,et al. SLIC Superpixels Compared to State-of-the-Art Superpixel Methods[J]. IEEE Transactions on Pat⁃tern Analysis & Machine Intelligence,2012,34(11):2274-2282.

[15]Zhang Y,Han J,Guo L. Salient Region Detection Using Back⁃ground Priors[J]. Optik,2014,125(19):5872-5877.

[16]肖潇,方勇纯,贺锋,等.未知环境下移动机器人自主搜索技术研究[J].机器人,2007,29(3):224-229.

[17]戚玮玮,栾新,宋大雷,等.一种鲁棒的基于全景视觉的足球机器人目标识别方法[J].中国海洋大学学报(自然科学版),2011,41(6):109-114.

彭玉青(1969-),女,湖南永顺人,教授,CCF会员(E200035449M),主要研究方向为智能信息处理、计算机视觉;

高晴晴(1989-),女,河北廊坊人,硕士研究生,主要研究方向为:深度学习、人工神经网络;

李木(1989-),男,河北石家庄人,硕士研究生,主要研究方向为为智能机器人、机器人视觉sweetlm@163.com;

张媛媛(1992-),女,河北保定人,主要研究方向为机器人遥操作、虚拟现实。

Reliability Block Diagram Analysis on Pressure Test System of Oil-Well*

HAO Xingang1,2,LI Xin’e1,2*,CUI Chunsheng1,2,XIAO Wencong1,2

(1.National Key Laboratory of Electronic Measurement Technology,North University of China,Taiyuan 030051,China;

2

.Education Ministry Key Laboratory of Instrumentation Science and Dynamic Measurement,North University of China,Taiyuan 030051,China)

Abstract:The Oil-Well down-hole pressure test system has been widely used for testing the perforation fracturing dynamic pressure date,but its reliability research is in a state of emptiness. Aiming at this problem,analyze reliabil⁃ity of test system through the reliability block diagram(RBD)technology. The reliability block diagram modelwases⁃tablished bythoroughly analysis the structure and logic function relation-ships of test system. On this basis,the fail⁃ure rate of componentsmay cause system faultwere separately analyzed and calculated according to the components stress analysis method,finally the failure rate and mean time between failures(MTBF)of test system were calculat⁃ed. The research results provides a theoretical basis for the reliability evaluation of the test system.

Key words:measurement instrument;failure rate;reliability block diagram;system reliability theory;perforation fracturing;pressure test

doi:EEACC:0170N;721010.3969/j.issn.1004-1699.2016.01.012

收稿日期:2015-08-28修改日期:2015-10-08

中图分类号:TP24

文献标识码:A

文章编号:1004-1699(2016)01-0058-06

项目来源:天津市自然科学基金项目(13JCYBJC15400)