基于SCM和CST的红外与可见光图像融合算法

王 聪,钱 晨,孙 伟,韦 玮

基于SCM和CST的红外与可见光图像融合算法

王 聪1,钱 晨1,孙 伟2,韦 玮1

(1. 南京邮电大学 光电工程学院,江苏 南京 210023;2. 北京交通大学 信息科学研究所,北京 100044)

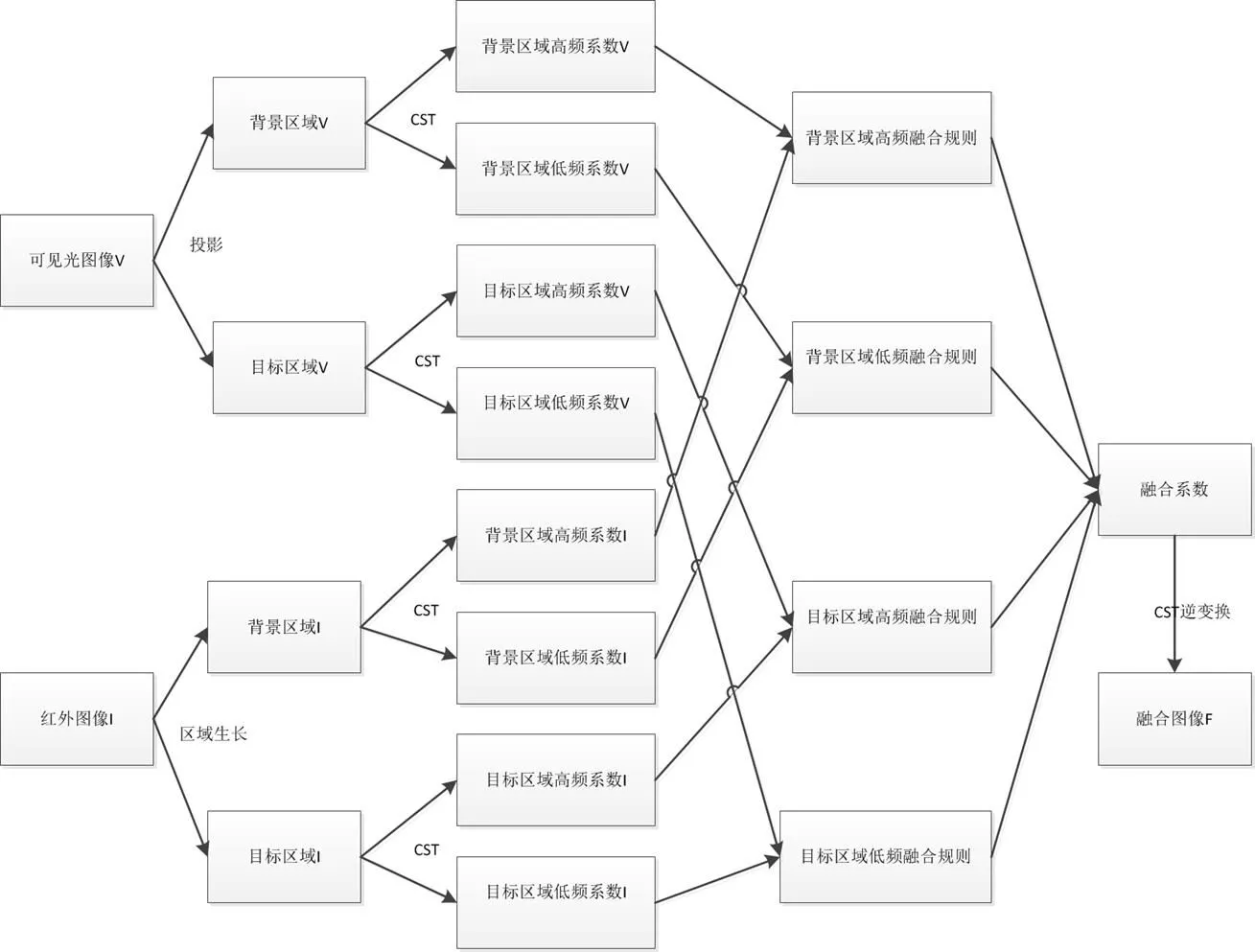

针对红外与可见光图像的成像特点及目前红外与可见光图像融合中融合图像信息量不足的问题,结合复剪切波变换(Complex Shearlet transform,CST)及脉冲发放皮层模型(Spiking cortical model,SCM)的优点,本文提出了一种新的红外与可见光图像融合算法。首先,利用红外图像目标与背景灰度的显著差异,通过区域生长方法从红外图像提取目标区域;然后用CST对源图像进行分解,对源图像的目标区域和背景区域系数分别采用不同的融合规则进行融合,其中背景区域的高频子带系数利用SCM进行选择;最后,经过CST逆变换重构融合图像。研究结果表明,与其它的红外与可见光图像融合算法相比,本方法在视觉效果和客观评价指标上都得到了提升。

图像融合;红外图像;可见光图像;目标提取;CST;SCM

0 引言

无论是军事还是民用方面,红外与可见光图像都是最常用的两类图像。可见光图像可以很好地显示整个应用场景的全貌,更好地描述目标周围的实际环境,从为执行者提供更好的导向,但是可见光图像对隐藏的目标很难进行有效地展示。而红外图像虽然对场景的亮度变化不敏感,却可以根据应用场景的温度进行成像,具有识别伪装的能力,可以有效地应对光照、天气、遮挡因素等的影响[1],从而能够很好地对目标进行指示。从两者的特点可以看到,红外与可见光图像具有很好的信息互补性,可以将两者进行融合,从而有效地扩展成像系统目标探测能力,提高成像系统的目标指向特点,在航空、遥感、国防等诸多领域具有重要的应用价值[2]。

目前,红外图像与可见光图像的融合方法主要可以分为两类:空域算法和频域算法。空域算法主要包括加权平均法[3]等;变换域算法主要有基于小波变换的图像融合算法[4-5]、基于轮廓波变换(Contourlet transform,CT)图像融合算法[6-8]、基于剪切波变换(Shearlet transform,ST)的图像融合算法[9]等。由于CT具有很好的视觉感知性,因此基于CT的图像融合算法是目前流行的一类算法。但是,CT在进行方向分解时需要进行下采样操作,因而CT不具备移不变性,这导致基于CT的图像融合算法往往会在图像融合过程中引入伪吉布斯现象[10]。非下采样轮廓波变换(Non-subsampled Contourlet transform,NSCT)[8]作为CT的改进形式,虽然能够克服伪吉布斯现象,但是由于进行了非下采样操作,所以NSCT的运算速度较慢。为此,Guo和Labate通过具有合成膨胀的仿射系统构造了一种接近最优的图像稀疏表示方法:ST[11]。ST不仅数学结构简单,并且方向表示性能更好,但ST的离散化过程是通过下采样策略实现,因而也不具备移不变性。因此,文献[12-13]利用双树复小波变换结合剪切滤波器提出了CST。CST不仅具有移不变性,可克服ST的Gibbs效应,而且增强了ST的方向选择性,具有更优越的图像处理性能,能够很好地满足后续各种处理的要求。

同时,红外与可见光图像融合算法的好坏还取决于融合规则的选择。基于区域或目标的融合规则是将特征级融合和像素级融合相结合,使用分割的方法将感兴趣的区域图像划分为不同的区域,并根据不同区域的特点指导像素级融合,与其他的方法相比,这种基于区域或目标的融合规则能获得更好的融合效果[14]。SCM是一种模拟猫、猴等动物的大脑视觉皮层细胞对视觉信号的处理机制而产生的一类新型神经网络模型,与脉冲耦合神经网络(Pulse coupled neural network,PCNN)相比,计算更方便,性能更明显,因此在图像处理中得到了广泛的应用[15]。为了更好地利用两者的特点,本文首先利用通过区域生长方法从红外图像提取目标区域,然后将源图像分为目标区域和背景区域分别进行CST分解,对目标和背景区域系数分别采用不同的融合规则进行融合,其中背景区域的高频子带系数利用SCM进行选择。最后,经过CST逆变换重构融合图像。

1 复剪切波变换

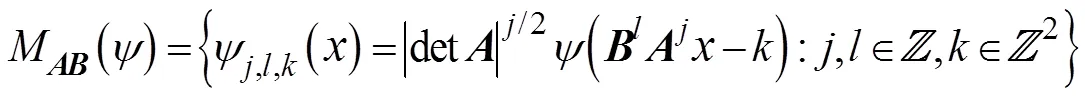

剪切波可以通过经典仿射系统理论把几何与多分辨分析结合起来构造得到[12-13]。当维数=2时,剪切波变换系统为:

剪切波的离散化过程主要分两步[12-13]:多尺度分解和方向分解。标准的剪切波先通过拉普拉斯变换进行尺度分解,再通过剪切波进行方向分解。由于拉普拉斯变换不具有移不变性,因此标准的剪切波变换也不具有移不变性。而CST则通过利用具有移不变性的双树复小波变换代替拉普拉斯变换进行尺度分解,从而使整个变换具有移不变性[12-13]。将CST运用到多源图像融合领域,能够为融合后的图像提供更多的有用信息。因此本文将CST运用于红外图像与可见光图像的融合中,提出基于CST的红外与可见光图像融合方法。

2 区域生长算法

区域生长的基本思想是将具有相似性质的像素集合起来构成区域。由于红外成像是热辐射成像,而一般目标和背景具有较大的温差,所以根据红外成像的特点,目标区域具有较高的温度可以很容易被捕捉得到,并且同一目标的温差一般都是均匀且稳定的,因此,温度相近的部分通常被认为是同一目标或背景。本文采用区域生长的方法提取红外图像中的目标[16]。

区域生长的基本思想是将具有相似性质的像素集合起来构成区域。本文采用区域生长的方法提取红外图像中的目标[16]。区域生长法的具体步骤如下[16]:

1)选择或确定一组能正确代表所需区域的种子像素(本文选取最亮的点为种子)。

2)确定在生长过程中能将相邻相素包含进来的准则,本文采用基于区域灰度差的区域生长准则提取目标。

3)确定让生长过程停止的条件或规则,生长过程的停止是通过设定门限来实现的,当不再有像素满足加入这个区域准则时,区域生长停止。

图1是本文通过区域增长法提取目标的实验结果。

3 脉冲发放皮层模型

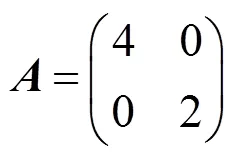

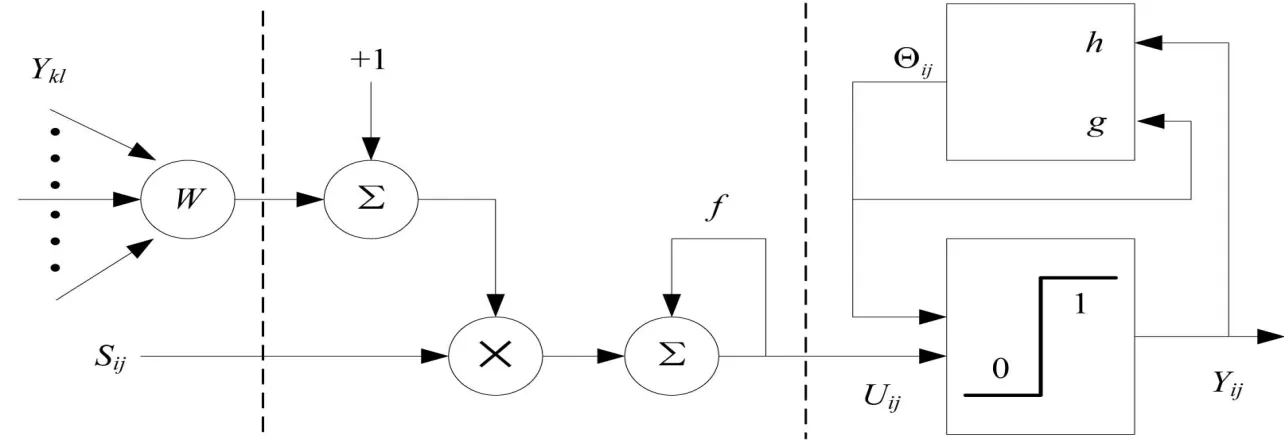

在SCM中,每个神经元由3部分组成:输入和连接域,调制产生器和脉冲发生器,如图2所示。在以下表达式中,和指的是图像中的像素位置;和是指其相邻像素的位置;表示当前迭代次数。

连接域和调制产生器的关系为下式:

(a)红外图像

(b)目标图像

图2 SCM模型示意图

式中:U()表示内部活性;是U()的衰减系数。S是外部激励;为权重卷积矩阵,是神经元之间的连接权重;Y(-1)是上一次的输出脉冲。公式(3)中确定模型的点火事件。Y()依赖于内部的活动项U()和阈值E():

神经元的动态阈值E()定义为:

E()=gE(-1)+hY(-1) (4)

式中:和分别是衰减和阈值放大系数。

SCM网络未被激活时,神经元的内部活动项能量为0,此后,随着迭代次数的增多,内部活动项能量逐步增大,每当其大于动态阈值时,即发放脉冲、输出点火状态,设T()为经过次迭代后神经元的点火次数,则有:

T()=T(-1)+Y() (5)

SCM网络中的神经元通过局部耦合构成一个全局互连的神经网络。耦合连接的SCM网络是相似性集群发送同步脉冲的。利用这一特性,本文将点火次数的多少作为融合规则进行图像融合。

4 图像融合过程

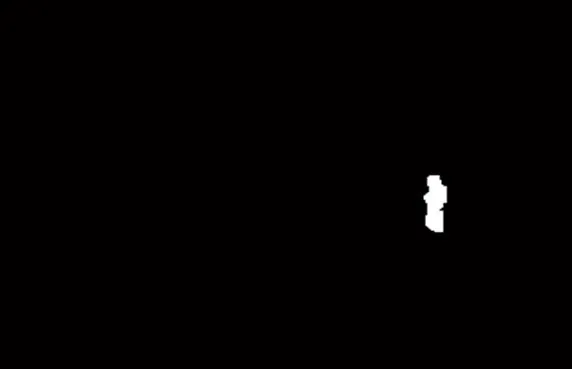

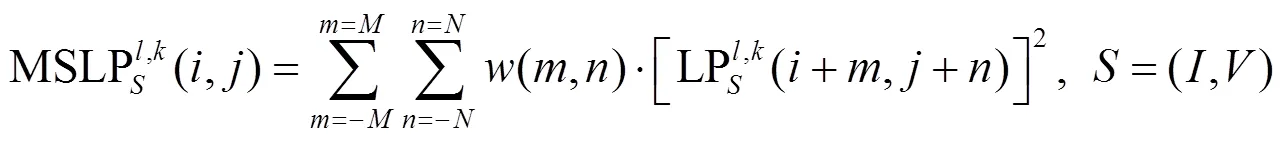

图像融合流程如图3所示。具体步骤如下:

1)对红外图像运用区域生长法进行目标提取,得到目标区域和背景区域,并将区域投影到可见光图像上。

2)分别对红外图像和可见光图像进行CST分解,得到多尺度分解系数{C,k(,), C,k(,)}(=,;=,),其中,C,k(,)和C,k(,)分别表示红外(或可见光)图像尺度方向上(,)像素处的低频和高频子带系数。

3)对不同区域的低频和高频子带系数分别使用不同的融合策略,获得融合后的系数{C,k(,), C,k(,)}(=,),其中,C,k(,)和C,k(,)分别表示融和图像目标(或背景)区域尺度方向上(,)像素处的低频子带系数和高频子带系数。

4)对融合后的系数进行CST逆变换,重构融合图像。

4.1 目标区域融合规则

为了保证红外图像的热目标信息能够最大限度地加入到融合图像,目标区域直接选取红外图像的分解系数作为融合系数。

C,k(,)=C,k(,),C,k(,)=C,k(,),(,)Î(6)

4.2 背景区域融合规则

4.2.1 背景区域低频融合规则

可见光图像的低频系数包含了大量的背景细节信息,所以选取可见光图像的低频系数作为融合图像的低频系数:

C,k(,)=C,k(,),(,)Î(7)

4.2.2 背景区域高频融合规则

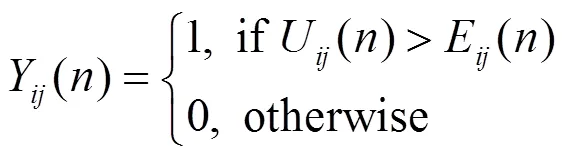

在高频子带的处理中,CST的高频子带系数代表了图像的细节分量。本文采用上述SCM算法选择高频子带系数。由于文献[17]证明拉普拉斯能量和(MSLP)可以很好的反映图像的边缘特征信息,因此本文采用MSLP作为SCM的输入。MSLP定义为:

其中:

式中:step代表像素间的可变间距,本文取step=1;C,k(,)表示红外(或可见光)图像在尺度方向上(,)像素上的NSST系数;(,)表示LP,k(+,+)所对应的系数权值矩阵;MSLP,k(,)表示红外(或可见光)图像在尺度方向上(,)处的CST系数对应的改进的拉普拉斯能量和。

然后计算每个高频系数的点火次数:

T,j,k()=T,j,k(1)+Y,j,k() (10)

当SCM迭代次后,由式(10)可以得到由DM,k(,)表示的点火频率映射图:

根据式(11)即可确定融合图像背景区域的高频系数。通过对上面得到的融合系数做CST逆变换,即可重构得到基于目标提取和CST的融合图像。

5 仿真验证

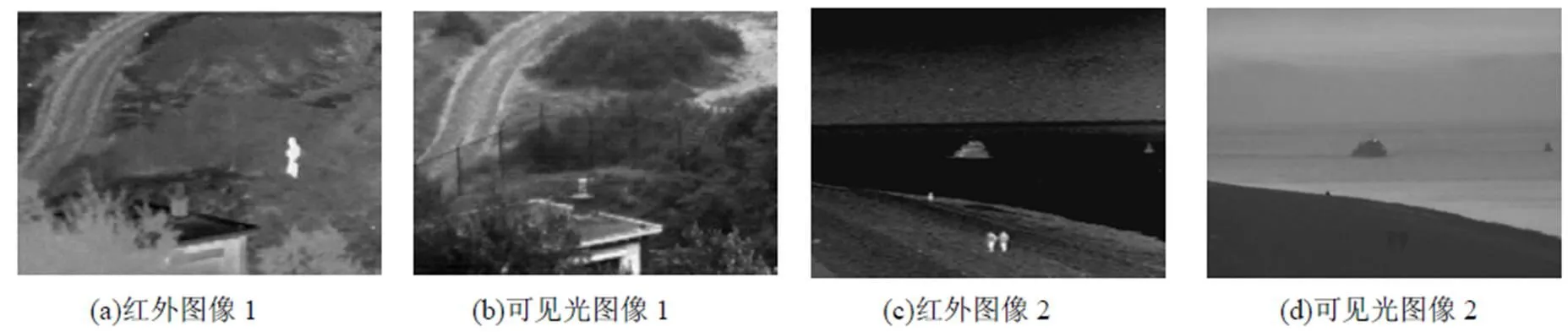

本文的试验平台是一台CPU主频为3.4GHz、4G内存的PC,Matlab 2012a的编译环境,为了验证该算法有效性,本节选取两组同一场景的红外与可见光图像进行融合仿真实验,并与基于离散小波变换(DWT)的传统融合算法以及基于平移不变的小波(SIDWT)和PCNN(SIDWT-PCNN)[5]、基于CT和PCNN(CT-PCNN)[6]、基于尖锐频率局部化Contourlet变换和改进拉普拉斯能量和(SFLCT-SML)[7]以及基于NSCT和SF激励的PCNN(NSCT-SFPCNN)[8]的方法进行对比融合试验。如图4所示。基于DWT的传统融合算法采用简单的低频系数取平均、高频系数模值取大的融合规则;DWT算法和SIDWT算法均采用“db4”小波进行4层小波分解;CT、SFLCT、NSCT以及本文的CST分解参数均为2,3,3,4;比较算法其他参数与参考文献相同。SCM参数设置如下:=0.7,=0.8;=[0.1091, 0.1409, 0.1091; 0.1409, 0, 0.1409; 0.1091, 0.1409, 0.1091];迭代次数为=40。

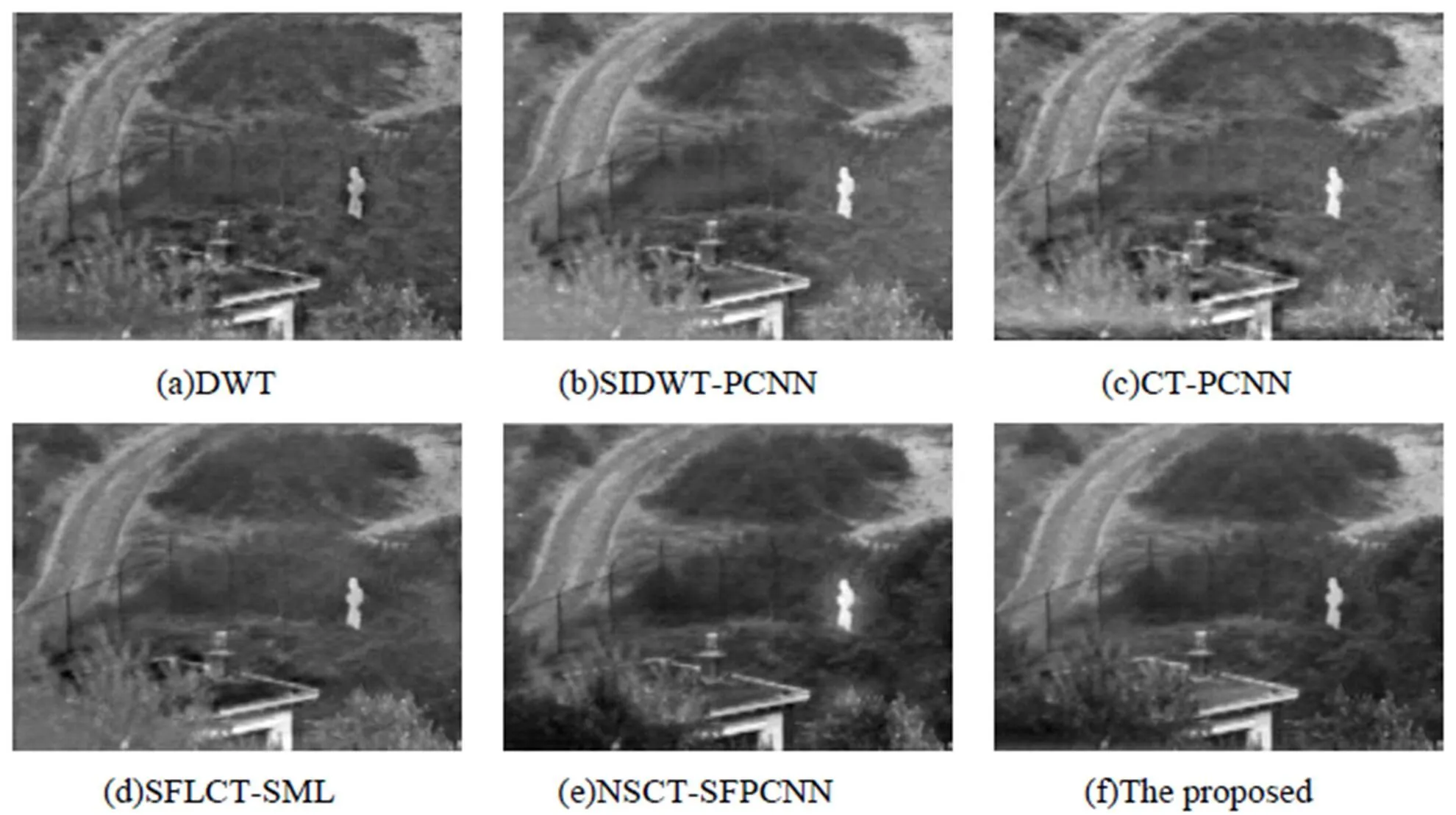

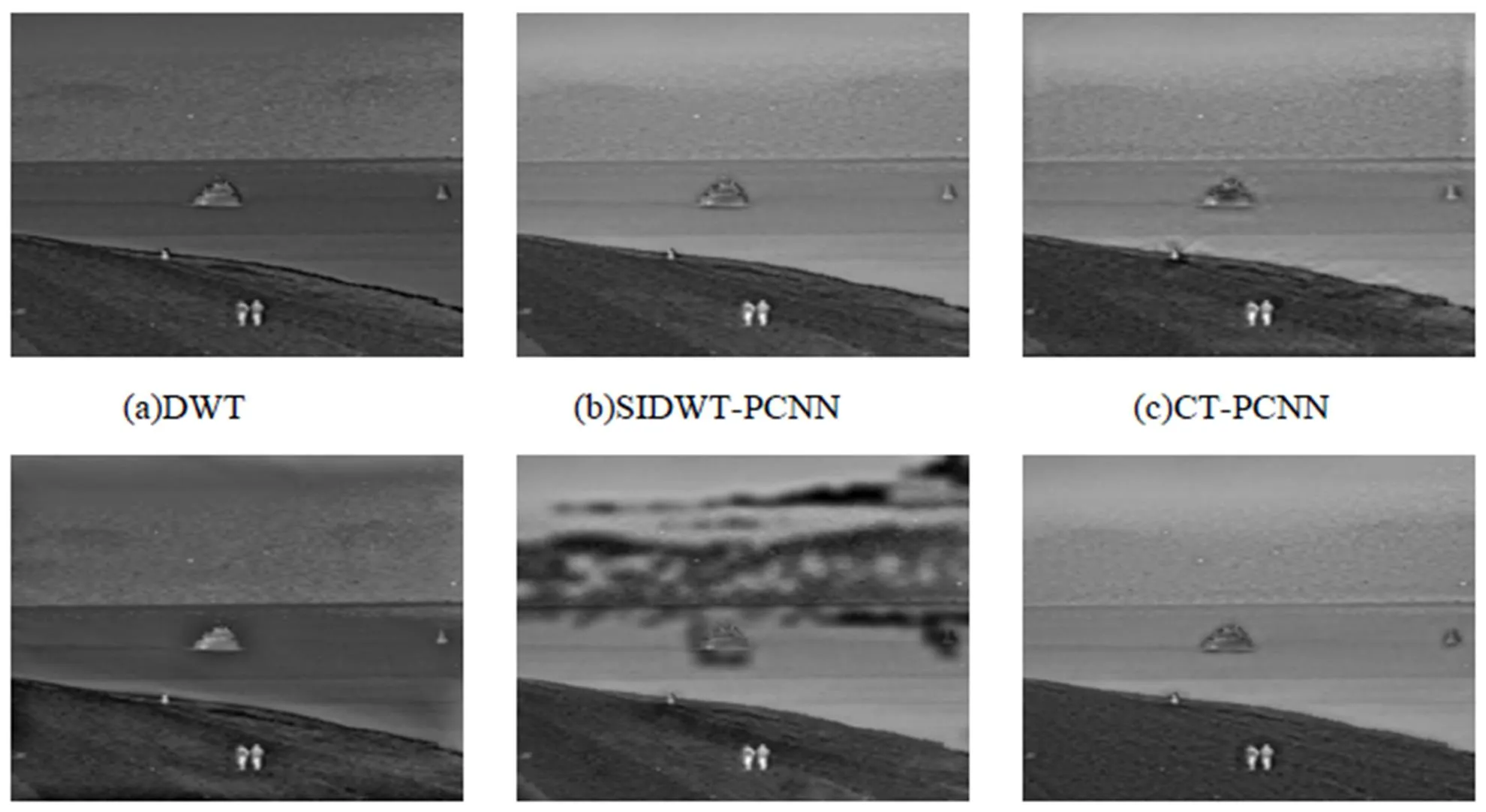

图5与图6所示分别是上述两组源图像采用不同融合方法得到的融合结果。

图3 融合算法框架

Fig. 3 Framework of fusion algorithm

图5表明:融合结果图5(a)、(c)不仅边缘细节相对较模糊,而且还引入了一定程度的“虚影”;图5(e)在红外目标附近引入了明显的“虚影”;图5(b)、(d)、(f)的视觉效果比较接近,它们都很好地融入了红外源图像中的热目标的信息,而且边缘细节清楚,但图5(b)、(d)中可见光源图像中房子周围的树木信息不如图5(f)融合的好,因此图5(f)的融合图像优于参与比较的其他5种方法的融合图像。对于图6,融合结果图6(a)、(b)、(d)的清晰度低于其余3种方法所得的融合图像,图6(e)引入了明显的“虚影”,图6(c)、(f)的视觉效果比较接近,但图6(c)中海与岸连接的边缘细节相对较粗糙,因此图6(f)的融合图像优于参与比较的其他5种方法的融合图像。由此可知,本文提出的融合方法在主观视觉效果上要优于参与比较的其他5种融合方法。

图4 源图像

图5 第1组图像的融合结果

图6 第2组图像的融合结果

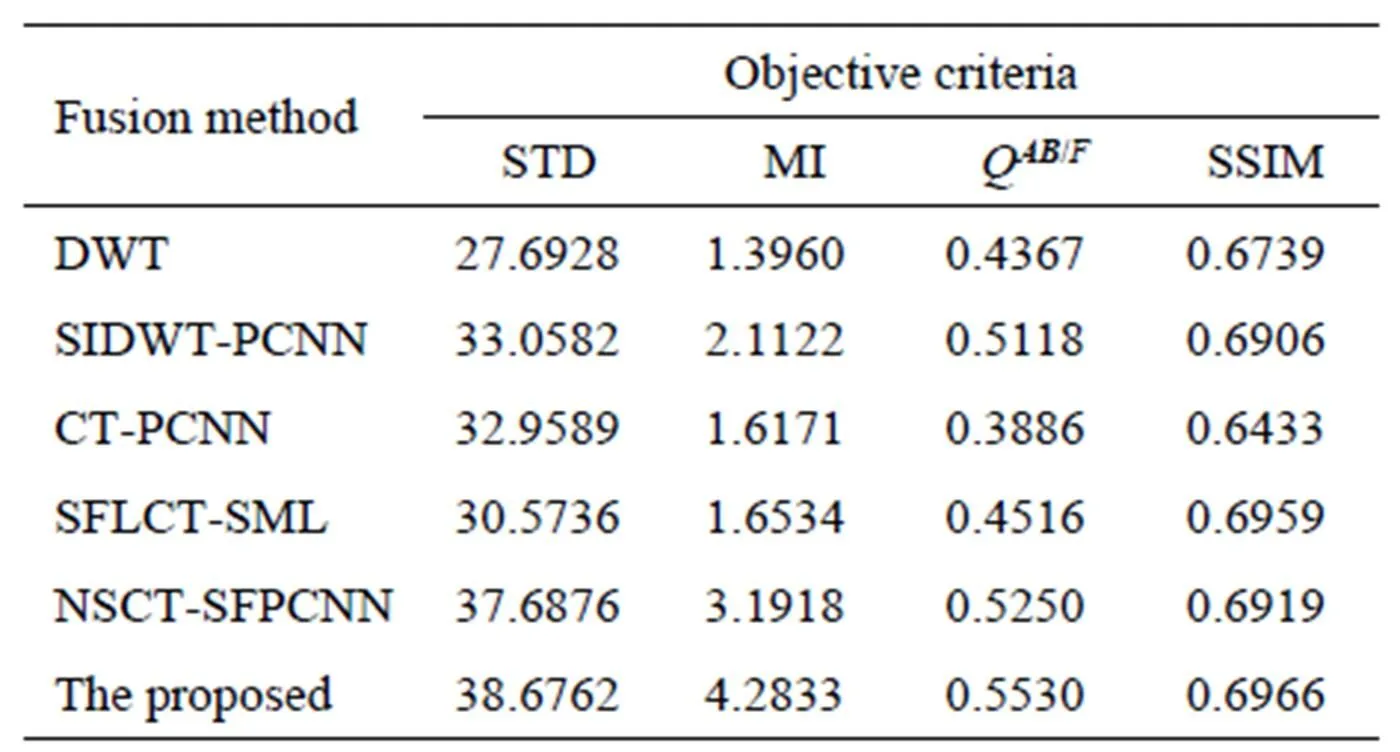

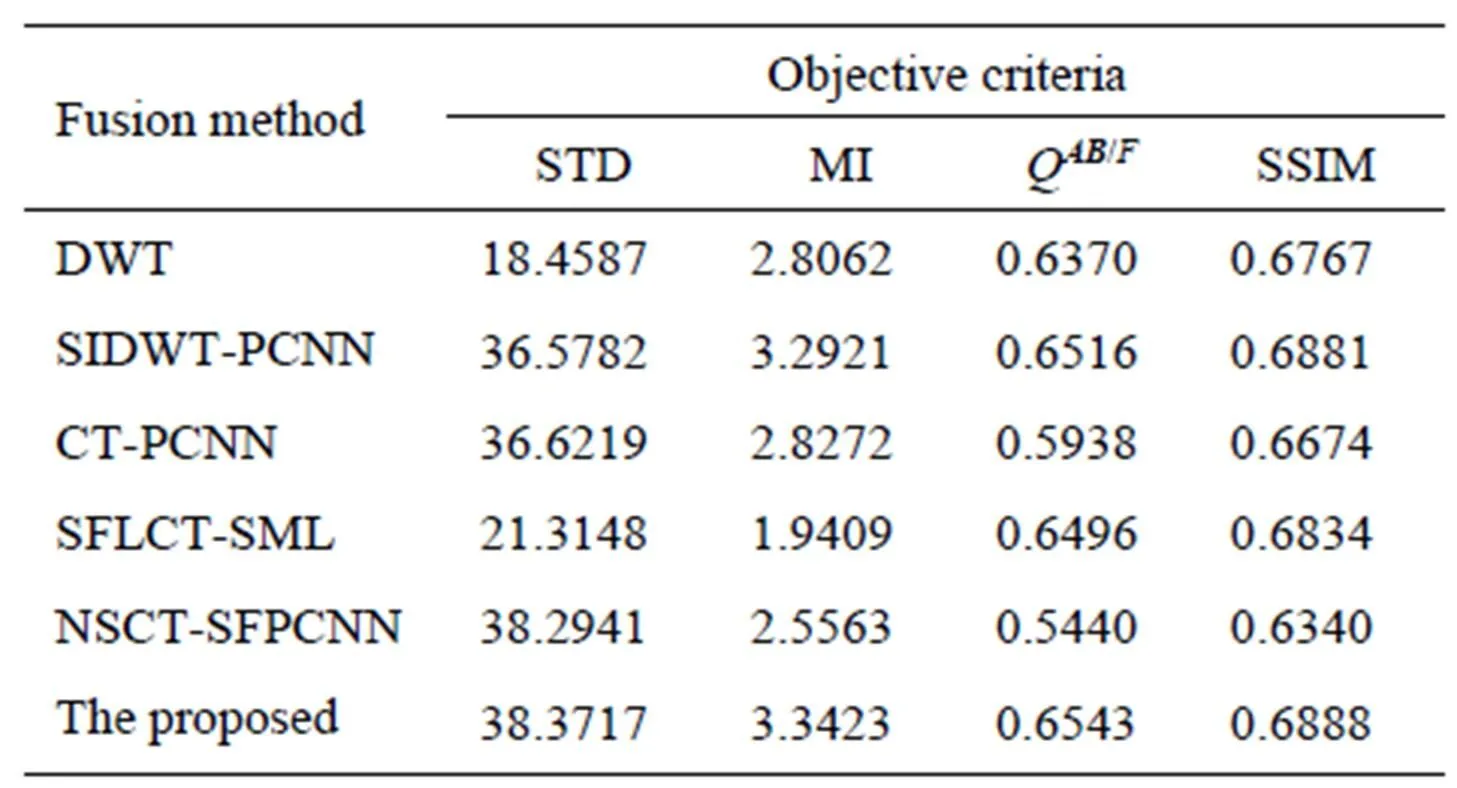

从主观视觉效果来看,本文方法所得的融合图像边缘更清晰、细节和纹理保留更丰富;差值图也说明本文方法对聚焦部分获得了更好的融合。对融合效果的评价,除了从主观视觉效果来定性分析,还可以采用相关的客观评价指标进行定量分析。本文采用标准差(Standard deviation,STD)[18]、互信息(Mutual Information,MI)[18]、Q/F度量[18]和结构相似度(Structural similarity,SSIM)[18]对融合效果进行客观评价。STD反映图像灰度相对平均灰度的离散情况,STD越大,灰度级分布越分散,图像反差越大,融合图像越清晰。MI计算源图像有多少信息转移到了融合结果中,MI越大,说明融合图像中包含了越多的源图像的信息。Q/F衡量有多少边缘信息从源图像转移到了融合图像,Q/F越大,表明融合图像从源图像获得的边缘信息越丰富。SSIM衡量融合图像与源图像的结构相似度,SSIM越大,说明融合图像中与源图像的结构越相似。

表1与表2给出了上述6种融合方法客观评价指标的对比结果。从表1与表2可以看出,对于两组源图像而言,本文算法的指标都是最优的。在表1中,在STD这个指标中,我们的算法比次高的算法NSCT-SFPCNN高出2.56%,这说明本文的算法得到的融合图像的图像反差最大,融合图像更清晰。在MI这个指标中,我们的算法比次高的算法NSCT-SFPCNN高出25.33%,这说明本文的算法得到的融合图像包含了更多的源图像信息。在Q/F这个指标中,我们的算法比次高的算法NSCT-SFPCNN高出5.06%,这说明本文的算法得到的融合图像从源图像获得的边缘信息更丰富。在SSIM这个指标中,我们的算法比次高的算法SFLCT-SML高出0.10%,这说明本文的算法得到的融合图像与源图像的结构更相似。而在表2中,我们的算法比次高的算法那在STD、MI、Q/F和SSIM这4个指标中分别高出了0.20%、1.50%、0.41%和0.10%,同样说明我们的算法具有更好的融合效果。这些主客观评价结果都说明,本文提出的方法能够很好地将源图像中的有用信息提取并注入到融合图像中。因此综合来看本文所提出算法是一种比较好的值得推广的图像融合算法。

6 结论

本文提出了一种基于目标提取和SCM的CST域红外与可见光图像融合算法,首先对红外图像做基于区域生长法的目标提取,得到目标区域和背景区域,然后对红外图像和可见光图像分别做基于CST的多尺度分解,分别对位于目标区域和背景区域的低频和高频系数采用不同的融合规则,其中对背景区域的高频子带系数采用MSLP作为SCM输入,利用点火次数进行系数融合;最后,经过CST逆变换重构融合图像。研究表明,与基于小波变换、基于CT、基于SFLCT和基于NSCT的红外与可见光图像融合算法相比,本文方法在视觉效果和客观评价指标上都得到了进一步的提升。

表1 第1组图像不同融合方法客观评价指标对比

Table 1 Objective evaluation of different methods on group 1

表2 第2组图像不同融合方法客观评价指标对比

Table 2 Objective evaluation of different methods on group 2

[1] 高国荣, 刘艳萍. 基于非抽样Shearlet变换的红外与可见光图像融合方法[J]. 农业机械学报, 2014, 45(3): 268-274.

GAO G R, LIU Y P. Infrared and visible light images fusion algorithm based on non-subsampled Shearlet transform[J]., 2014, 45(3): 268-274.

[2] 张素文, 陈娟. 基于非负矩阵分解和红外特征的图像融合方法[J].红外技术, 2008, 90(8): 446-449.

ZHANG S W, CHEN J. A image fusion method based on non-negative matrix factorization and infrared feature[J]., 2008, 90(8): 446-449.

[3] OLIVER R, THOMAS F. Pixel-level image fusion: The case of image sequences[J]., 1998, 33(74): 378-388.

[4] MA H, JIA C Y, LIU S. Multisource image fusion based on wavelet transform[J]., 2005, 11(7): 231-240.

[5] LI W, ZHU X F. A new algorithm of multi-modality medical image fusion based on pulse-coupled neural networks[C]//, Changsha, China: Springer, 2005, 3610: 995-1001.

[6] 方勇, 刘盛鹏. 基于Contourlet变换和改进型脉冲耦合神经网络的图像融合方法[P]. 上海: CN1873693, 2006-12-06.

FANG Y, LIU S P. Infrared image fusion algorithm based on Contourlet transform and improved pulse coupled neural networks: China, 1873693A [P]. 2006-12.

[7] 屈小波, 闫敬文, 杨贵德. 改进拉普拉斯能量和的尖锐频率局部化Contourlet域多聚焦图像融合方法[J]. 光学精密工程, 2009, 17(5): 1203-1212.

QU X B, YAN J W, YANG G D. Sum-modified-Laplacian-based multifocus image fusion method in sharp frequency localized Contourlet transform domain[J]., 2009, 17(5): 1203-1212.

[8] 屈小波, 闫敬文, 肖弘智, 等. 非降采样Contourlet域空间频率激励的PCNN图像融合算法[J]. 自动化学报, 2008, 34(12): 1508-1514.

QU X B, YAN J W, XIAO H Z, et al. Image fusion algorithm based on spatial frequency-motivated pulse coupled neural networks in non-subsampled Contourlet transform domain[J]., 2008, 34(12): 1508-1514.

[9] GENG P, WANG Z Y, ZHANG Z G, et al. Image fusion by pulse couple neural network with Shearlet[J]., 2012, 51(6): 067005-1-067005-7.

[10] DO M N, VETTERLIi M. The contourlet transform: an efficient directional multiresolution image representation[J]., 2005, 14(12): 2091-2106.

[11] GUO K, LABATE D. Optimally sparse multidimensional representation using Shearlets[J]., 2007, 39(1): 298-318.

[12] 刘帅奇, 胡绍海, 肖扬. 基于复Shearlet域的高斯混合模型SAR图像去噪[J]. 航空学报, 2013, 34(1): 173-180.

LIU S Q, HU S H, XIAO Y. SAR image de-noising based on complex shearlet transform domain gaussian mixture model[J]., 2013, 34(1):173-180.

[13] LIU S Q, HU S H, XIAO Y. Image separation using wavelet-complex Shearlet dictionary[J]., 2014, 25(2): 314-321.

[14] 孔韦韦, 雷英杰. 基于NSST域人眼视觉特性的图像融合方法[J].哈尔滨工程大学学报, 2013, 34(6): 777-782.

KONG W W, LEI Y J. Technique for image fusion based on NSST domain and human visual characteristics[J]., 2013, 34(6): 777-782.

[15] LIU S, ZHAO J, SHI M Z. Medical image fusion based on rolling guidance filter and spiking cortical model[J]., 2015, 2015: 1-9.

[16] 桑高丽, 宣士斌, 赵波, 等. 采用目标提取和NSCT的红外与可见光图像融合[J]. 计算机工程与应用, 2013, 49(11): 172-176.

SANG G L, XUAN S B, ZHAO B, et al. Fusion algorithm for infrared and visible light images using object extraction and NSCT[J]., 2013, 49(11): 172-176.

[17] 王志慧, 赵保军, 沈庭芝. 基于MMPN和可调节链接强度的图像融合[J]. 电子学报, 2010, 38(5): 1162-1166.

WANG Z H, ZHAO B J, SHEN T Z. Image fusion based on MMPN and adjustable linking strength[J]., 2010, 38(5): 1162-1166.

[18] 孙伟. 剪切波变换在图像融合中的应用研究[D]. 北京: 北京交通大学.

SUN W. Research on Application of Shearlet Transform in Image Fusion[D]. Beijing: Beijing Jiaotong University, 2015.

Infrared and Visible Images Fusion Based on SCM and CST

WANG Cong1,QIAN Chen1,SUN Wei2,WEI Wei1

(1.College of Optoelectronic Engineering,Nanjing University of Posts and Telecommunications, Nanjing 210023, China;2. Institute of Information Science, Beijing Jiaotong University, Beijing 100044, China)

The imaging characteristics of the infrared and visual images and the insufficient information content of the fused images considered and the benefits of complex Shearlet transform(CST) and spiking cortical model(SCM)combined with, a new kind of infrared and visual image fusion algorithm is proposed. First, the object distilled from infrared image are segmented by region growing method. Then, CST is utilized for multiscale decomposition of the source images, and the object regions and background region are fused by different rules. The high frequency sub-band coefficients of background region are selected by using the SCM, and finally the fused image is reconstructed by the inverse CST. Experimental results demonstrate that the proposed fusion algorithm outperforms other fusion algorithms in terms of visual appearance and objective evaluation criteria.

image fusion,infrared image,visible image,object extraction,CST,SCM

TN911.73,TN911.6

A

1001-8891(2016)05-0396-07

2015-12-07;

2016-01-07.

王聪(1990-),男,江苏宿迁人,研究生,主研可见光通信系统及图像融合算法。E-mail:15895888221@163.com。

韦玮(1960-),女,博士生导师,主研新型激光、光纤材料与器件等。E-mail:weiwei@njupt.edu.cn。