融合深度信息的雾霾情况下显著性目标提取

刘 坤,张晓怿,陈宁纪,苏秀苹

(河北工业大学 控制科学与工程学院,天津 300130)

0 引言

根据公安部道路交通事故统计报告,我国每年大约10%的交通事故直接与雾霾等恶劣天气有关.由于雾霾天气下空气中浑浊介质增多,导致行车过程中能见度低、视野不清、尤其是路面上的车辆和行人等重要的显著性目标轮廓模糊不清,不利于驾驶员对前方道路环境做出正确的观察与判断.视觉显著性目标检测是近些年来的研究热点,通过模拟人类的视觉注意力机制,显著性目标检测能够对有限的信息加工资源进行分配与选择,可以快速找到需要关注的目标,降低视觉信息处理量[1].目前关于显著性目标的检测已经取得了大量的研究成果,并在图像分割和图像压缩等领域中取得了广泛的应用[2-4].应用于智能交通领域时,通过对路面上的显著性目标进行检测可以辅助驾驶员进行判断与决策,例如及时发现路面上的车辆和行人等显著目标,以降低交通事故的发生率.

雾霾天气造成的低分辨率、低对比度导致被关注目标的边缘、轮廓、颜色,纹理等重要的图像特征无法准确提取,给显著性目标检测带来了很大的困难.尽管目前已有很多学者针对降低雾霾等大气介质对图像的影响进行了研究,但现有的去雾算法存在以下几方面问题[5-6],使其难以应用于雾霾天气下的显著性目标检测问题中:1)去雾算法的复杂度:现有的去雾算法主要是针对单幅图像的去雾问题进行研究,算法的复杂度问题一直是该领域中的难题,复杂度过高使目标检测的实时性很难保证;2)图像颜色的失真:大部分去雾算法在附加各种假设条件的情况下调整图像亮度,使用假设条件的不同导致其去雾效果各有差异,很多算法由于集中在可见度的增强而并没有从物理上恢复原始景物的光线,导致去雾后的图像存在颜色的失真和光环效应,进一步地导致目标的边缘和轮廓等视觉特征无法准确提取.

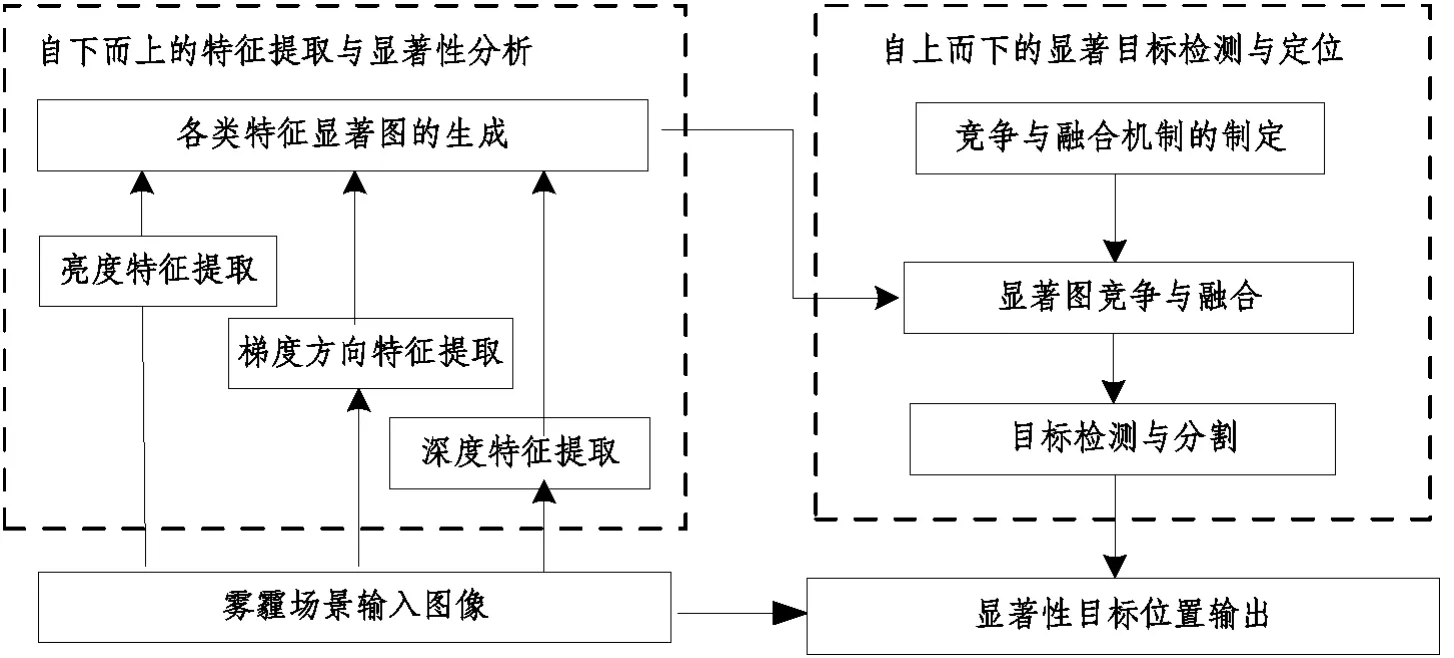

在视觉注意力模型的计算过程中,特征提取是由视觉刺激到视觉信息处理的关键步骤,它将图像中的内容转化为定量的可计算信息描述形式,特征的质量直接影响显著目标提取的准确度.在最具代表性的Itti显著性模型中[1],提取了颜色、亮度和梯度方向等不同类型的视觉特征,通过中央-周边操作算子得到相应的显著图,特征融合之后确定显著区域的位置和范围.雾霾天气下利用传统的特征提取方法难以保证显著性目标的准确检测.这里,本文改进了传统的Itti模型中的梯度方向显著图的计算方法;同时,引入了雾霾场景的深度信息作为重要的显著性特征.实验结果表明,场景的深度信息及目标之间的空间位置关系可以有效地提高显著性目标检测的准确率.本文算法的总体框架如图1所示.

图1 本文算法总体框架Fig.1 The framework of our algorithm

1 多通道显著特征提取

1.1 亮度差异显著图

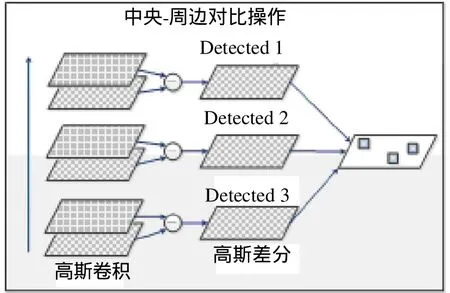

人眼对亮度的感知是最基本的视觉信息,即使是对其他信息和特征的感应在很大程度上也是根据亮度而来的.因此,本文首先计算待检测图像的亮度显著图.具体步骤是对待检测图像的亮度图建立不同尺度下的金字塔表示结构,然后进行中央-周边亮度对比操作来提取亮度特征的显著图.通过中央与周边亮度的对比操作,可以突出图像中亮度与周围相比更加显著的部分.亮度显著图的计算过程如图2所示.

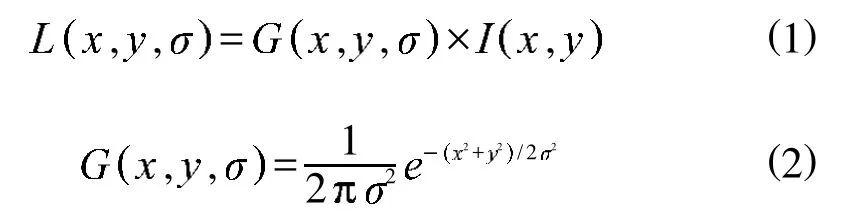

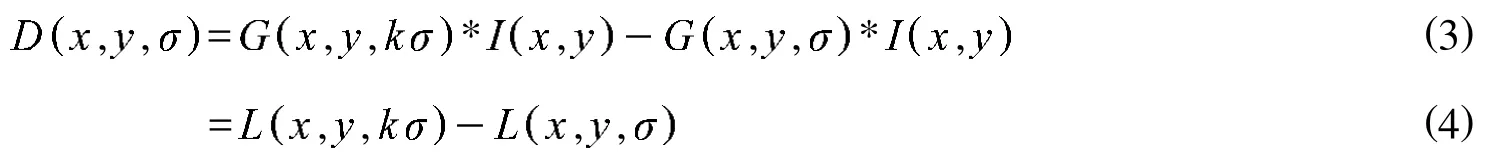

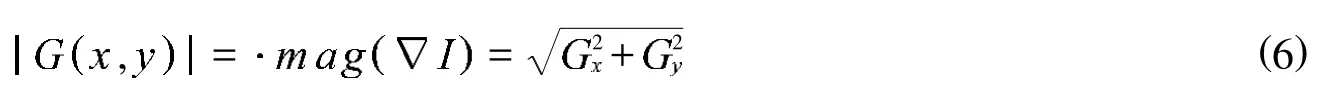

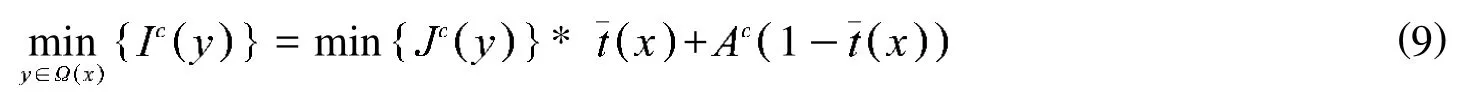

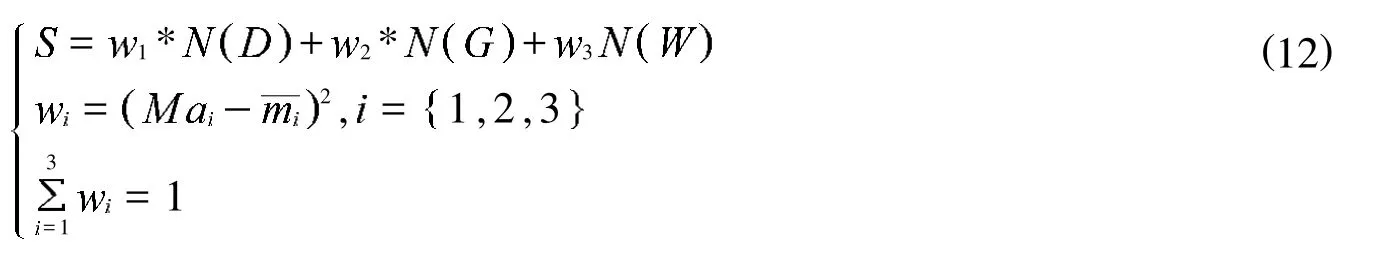

首先,对待检测图像的亮度图建立不同尺度下的金字塔结构表示.由于高斯卷积核是实现尺度变换的唯一线性核,因此将待检测的亮度图像的尺度空间定义为原始图像的高斯卷积,卷积后得到拉普拉斯函数

图2 亮度差异显著图的计算Fig.2 computation of illumination difference saliencymap

1.2 梯度方向显著图

关于视觉注意力机制的研究表明,视觉系统的神经元细胞对于固定角度的图像信号有明显的响应效果,传统的方向映射图中通过构造Gabor滤波器来描述图像信号在多个特定方向上的朝向性,算法的计算复杂度较高.为了提高算法的效率,本文提出了一种新的梯度方向显著图,主要度量图像在水平与垂直方向上的梯度大小,并基于此进行梯度方向显著图的提取.假设为输入图像,在处的水平和垂直方向上梯度定义为以下矢量

在实际计算过程中,为了进一步提高算法的效率,本文利用模板卷积估计图像在水平方向和垂直方向的梯度,同时梯度的幅值大小利用式 (7)近似代替.

通过分析可以发现,梯度的幅度反映了在特定方向上像素亮度变化的情况.而且,将图像梯度的幅值图作为有向梯度显著图,其中的局部差分操作在一定程度上可以凸显出原始场景的亮度分布和变化情况.

1.3 深度特征显著图

本文根据暗原色先验原理[7]对雾霾场景中的深度信息进行提取,该原理是通过对大量的清晰图像与雾霾图像的亮度进行统计对比后发现的先验规律:在绝大多数非天空的局部区域里,总会存在某些像素其颜色通道之一的数值接近零.利用此先验信息可以对雾霾场景中的透射率进行提取,场景透射率的估计与场景的深度信息存在正比例关系,因此可以间接提取目标场景的深度信息.关于雾霾情况下目标场景的成像过程,研究人员已经提出了很多关于大气介质散射的模型,其中最为著名的大气散射模型[8]描述关系如式 (8)所示.该散射模型主要包括衰减模型和环境光模型,衰减模型描述了光从场景点传播到观测点的过程;环境光模型描述了周围环境中的各种光经过大气粒子散射后对观测到的光强的影响.

其中:I代表观测图像的亮度;J代表场景的辐射度;A是全局大气光;t用来描述光线通过媒介投射到相机程中没有被散射的部分.方程中右边第一项叫做直接衰减项,描述的是景物光线在透射媒介中经衰减后的部分;第二项是大气光成分,它是由大气散射引起的,会导致景物颜色的漂移.通过分析大气散射介质作用下的成像模型可以发现,雾霾情况下成像得到的目标亮度值主要与目标本身的颜色和亮度、雾霾介质的浓度以及目标与到摄像机的距离有关.在相同的雾霾介质浓度下,目标在图像中亮度值改变的多少与它到相机的距离成反比,也就是说,通过对雾霾情况下物体颜色和亮度的观测和统计,反过来可以间接获得目标场景距离相机的深度信息.

这里假设大气光A是给定的,且在局部范围内的透射率是一个常数,表示,对方程式 ( 8)的两边取最小化操作,可以得到

根据暗原色原理的先验信息,其方程表示如下

进而可以得到对图像中场景的透射率估计结果如式 (11)所示.

由于目标场景透射率与场景的深度信息存在正比例关系,因此通过统计归一化后的雾霾图像中的暗原色通道可以得到对图像场景的深度信息估计结果.对于雾霾图像中的天空区域,这里假设大气光在天空部分的亮度为常数,因此,通过检测图像中亮度为恒常的图像区域判定天空区域的位置,并将其深度信息置为无穷远.

2 显著图融合与目标检测

自底向上地提取了图像中的深度信息、亮度差异和梯度方向并计算显著图之后,为了获得与任务相关的目标位置信息,需要制定一种自上而下的显著图融合机制,将不同特征之间的显著图进行竞争与融合,同时使得所有特征显著图中孤立的、显著的极值点不会因为其他的特征合并而消失.传统的显著图融合主要是利用Itti的静态权重求和法,即给不同类型的特征显著图分配一个固定的权重系数,然后进行线性加权形成融合之后的显著图.但是,这样的假设不符合人眼的视觉处理机制,同时简单的加权会抑制有效特征的效果.为此,本文利用一种新的竞争与融合机制,针对每个待检测图像根据其不同显著图的特性动态分配权重,然后再对所有的显著图进行合并.

首先定义归一化操作算子N(.) ,将所有特征显著图归一化到同一个动态区间内,本文采用最简单有效的最大归一化方法,将显著图的亮度归一化到[0,Ma].然后将基于不同特征得到的显著图进行非线性融合,融合中权系数的确定方法如公式 (12)所示.

其中:D,G,W分别表示亮度显著图、梯度方向显著图和纹理特征显著图; 为最终合成的显著图.N(.)表示对图像的规范化操作.其中Mai为不同特征显著图中的全局极大值为除去全局极大值之后的所有局部极大值的平均值.经过这样的运算之后,具有显著性的极大值的图像就会被加强,不具有显著性极大值的图像就会被抑制.

通过对待检测图像的深度、亮度差异和梯度方向进行特征提取与显著图计算与融合之后,获得了显著性目标的候选区域.为了进一步获得准确的感兴趣目标的位置信息,本文采用最大类间差方法进行显著性目标的检测与定位.具体做法是根据待检测图像的灰度特性将图像分成背景和目标两部分,背景与目标之间的类间方差越大,说明构成图像的两部分差别越大.当部分目标错分为背景或部分背景错分为目标都会导致两部分差别变小.因此,类间方差最大的分割意味着使目标与背景错分概率最小.定义t为前景与背景的分割阈值,假设前景点数占图像的比例为0,平均灰度为0;背景点数占图像比例为1;平均灰度为1,则图像的总平均灰度为u=w0×u0+w1×u1.从图像中的最小灰度值到最大灰度值进行遍历,当t使得g=w0× w1×(u0-u12最大时,即为进行目标检测与分割的最佳阈值.

图3 基于不同特征的显著图生成及目标检测Fig.3 saliencymap based on different featuresand objectdetection

3 实验结果

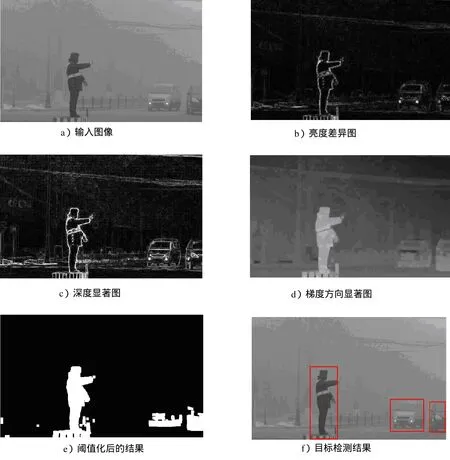

为了验证本文算法的有效性,这里在雾霾天气下采集的大量交通路面视频中进行测试,针对图像中路面上的行人等显著性目标进行了检测.通过对图像计算亮度差异显著图、梯度方向显著图和深度显著图,将其合成最终的显著图后利用最大类间差法得到的自适应阈值对其进行二值化处理,显著图中大于或等于阈值的像素点构成了初始的显著区域;而小于阈值的像素点构成了初始的背景区域.为了提高分割的准确率,两个准则被用于去除二值图中的“噪声”区域:一些初始的显著区域面积相当小,而一些初始的显著区域离大部分区域在空间位置上较远,这两类区域被重新设置为初始的背景区域,最终得到的区域为显著性目标的检测结果.图3中给出了显著性目标的检测结果,其中 a)为输入的原始图像,b)为输入图像的亮度差异显著图,c)为通过暗原色原理提取的场景深度特征显著图,d)为输入图像的梯度方向显著图,e)为进行自适应阈值化之后的二值化结果,f)为最终的显著性目标检测的位置结果.

为了进一步验证本文检测算法的统计特性,先对目标检测的结果做如下定义:如果行人区域被正确检测,则称为真正类TP(Truepositive);如果非行人区域被识别为行人,称之为假正类FP(Falsepositive);如果行人区域被认为是非行人即为假负类FN(False negative);如果非行人区域被认为是非行人,则称之为真负类TN(True negative).进一步地,定义目标检测的查准率(Precision)与查全率(Recall)如式 (13)和式 (14)所示

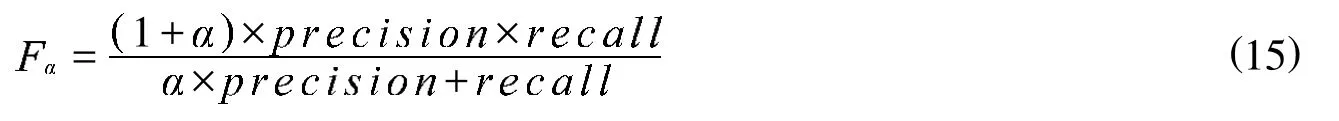

通过对雾霾图像提取基于不同特征的显著图并进行合成之后,利用自适应的阈值对显著性目标分割与检测,再利用人工标注的结果对这些分割结果计算查全率、查准率以及F-measure,F-measure定义为

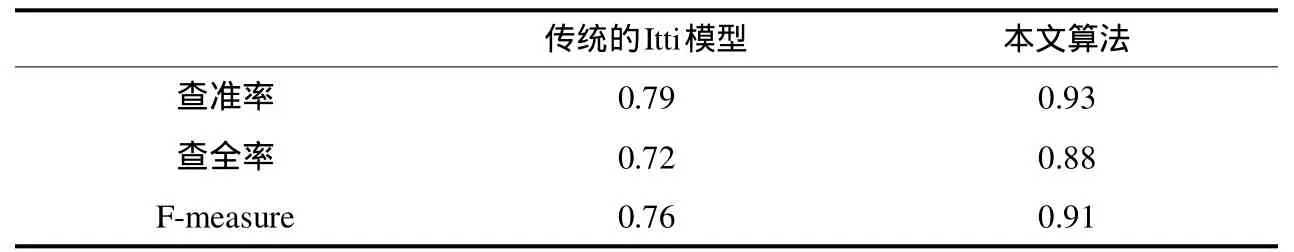

考虑到查准率更重要一些,这里设a=0.3,用以增加查准率在计算F-measure时的权重.表1中给出了本文方法与传统Itti模型进行显著性目标检测时在查全率、查准率以及F-measure指标和计算效率几个方面的对比,从表1中可以看出本文算法的检测效果与计算效率均优于传统的算法.

表1 本文算法与传统的Itti模型的对比Tab.1 Comparison ofouralgorithm w ith Ittimodel

4 结论与展望

本文提出了一种融合了深度信息的视觉显著性目标检测算法,其中考虑了雾霾图像中场景的深度信息以及目标之间的空间位置关系,同时还改进了传统的显著性模型中的梯度方向显著图的计算方法.实验结果表明,本文提出的算法可以在雾霾天气下可靠地检测出交通路面上的车辆和行人等显著性目标,同时还提高了传统显著性目标检测算法的计算效率,具有较广泛的应用前景.

[1]IttiL,KochC.Featurecombinationstrategies forsaliency-based visualattention systems[J].JournalofElectronic Imaging,2001,10(1):161-169.

[2]Zhang Zhuo,Fan XinNan.A Novel Method of Visual Attention for Targets Detection[C]//International Conference on Precision Mechanical Instrumentsand MeasurementTechnology,2013,347-350.

[3]Guo C,Zhang L.A Novel Multiresolution Spatiotemporal Saliency Detection Model and Its Applications in Image and Video Compression[J].IEEE Trans.Image Processing,2010,19(1):185-198.

[4]余映.视觉注意计算模型设计及其应用研究 [D].上海:复旦大学,2010.

[5]ChengM M,Zhang G Z,M itraN J.Globalcontrastbased salientregion detection[C]//ProceedingsofComputerVisionand Pattern Recognition.Los A lam itos:IEEEComputer Society Press,2011:409-416.

[6]Shwartz S,NamerE,SchechnerY Y.Blind hazeseparation.[C]//Proceedingsof IEEEConferenceon ComputerVisionand Pattern Recognition.Washington,DC: IEEEComputer Society,2006: 1984-1991.

[7]HeK,Sun J,Tang X.Single ImageHazeRemovalUsingDark ChannelPrior[J].IEEETrans.Pattern AnalysisandMachine Intelligence,2011,33(12):2341-2353.

[8]Narsimhan G,Nayar SK.Vision and theatmosphere[J].International Journalof Computer Vision,2002,48(3):233-254.