一种新颖的智能发电控制策略

陈鑫,余涛,席磊,邱轩宇,张孝顺

(1.广东电网公司韶关供电局,广东 韶关 512026;2.华南理工大学电力学院,广东 广州 510640)

一种新颖的智能发电控制策略

陈鑫1,余涛2,席磊2,邱轩宇2,张孝顺2

(1.广东电网公司韶关供电局,广东 韶关 512026;2.华南理工大学电力学院,广东 广州 510640)

本文提出了一种新颖的智能发电控制策略以解决新能源接入所带来强随机电网环境下的互联电网自动发电控制。各区域电网包含电网实时状态输入智能体﹑分布式协调算法智能体和控制输出智能体。分布式相关均衡Q(λ)学习被集成到控制智能体中作为主要的协调控制方法。此外,本文还详细讨论了JADE技术智能体的通信﹑行为和动作的作用机理。该平台已通过南方电网四省实时频率偏差模型证实能实现AGC区域的协调控制,尤其是当某区域电网控制误差ACE不能完全消除时。多智能体控制模块可以嵌入不同的控制算法并能评估其控制性能,这表明该平台具有很好的可扩展性﹑灵活性和高效性。

自动发电控制;多智能体系统;Q学习;相关均衡;随机最优控制

0 引言

现代电网已发展成为在电力市场机制基础上的多控制区域的互联系统,自动发电控制(Automatic Generation Control, AGC)作为互联电网实现功率和频率控制的主要手段,其控制效果直接影响着电网品质。由于电力系统运行点随日﹑月﹑季﹑年的不断变化,基于传统控制算法的固定增益控制器难以满足日益复杂的电力系统对控制性能的要求。也即当某一区域的控制器在某一时段无法为零化其控制误差时,系统频率和联络线功率交换将无法稳定运行[1]。因此,适应性和灵活性更强的智能算法被引入AGC控制器的设计以解决多区域互联系统的协作控制问题。然而,国内外并没有统一标准的AGC智能仿真平台以实现互联电网多控制区域的协作控制和有效评估智能算法的控制效果。

电力系统仿真平台如PSD﹑MATLAB/ Power System Toolbox等其循环运算效率低﹑封装性不好,对未来复杂多区域强随机环境下的AGC不能很好的实现实时仿真控制;如RTDS又因其价格昂贵,维护费用大,一般的研究人员或研究机构根本无法承担;同时,以上仿真平台的自定义能力都较弱,各区域之间通信语言并没有形成统一的规范,难以嵌入用户自定义较强的智能算法。因此,本文引入多智能体技术以开发多区域互联系统AGC的协调控制平台。

多智能体(Multi-Agent, MA)技术是当前IT领域发展最快的方向之一[2-5],在电力系统中的应用目前已取得大量的研究成果[6-8]。由此而衍生的多智能体系统(MAS)是指在一定的环境下,由一群具有不同或者类似功能的智能体(Agent),在交互的环境中完成一个或多个功能目标的系统[9-10]。MAS可以快速方便地求解分布式问题,其扩展性强[11-14]。因此MAS在微电网协作优化控制以及互联电网故障诊断等方面都有所应用[15-16]。然而,有关MAS的多数文章仅借助其概念并未进行深层智能化的应用,都未涉及Agent的自主学习和相互动态博弈的应用研究。

为此,本文提出了基于JADE技术开发新型多智能体动态博弈的AGC控制平台,并实时模拟由于新能源接入而带来的电网强随机环境下的自动发电控制。该平台由频率响应模型模块﹑实时数据传输模块和多智能体控制模块三部分组成。每个控制区域包含区域电网实时状态智能体﹑算法实现智能体和控制输出智能体。分布式相关均衡Q(λ)学习被集成到控制智能体中作为主要的协调控制方法,避免由于某一区域不能单独实现频率偏差的调整而陷入频率偏差过大的状态。本平台在南方电网四省区域详细动态全过程频率偏差模型上进行了仿真研究,侧证了本平台扩展性强﹑灵活性和高效性。

1 多智能体仿真平台JADE

1.1 JADE的概述

JADE是基于Java的一个多智能体应用程序开发平台。JADE遵循FIPA规范,能实现多智能体系统间的互操作。JADE的目标是通过遵循可理解的系统服务和主体集的规范来简化智能体系统的开发过程。JADE agent开发平台提供了智能体最基本的服务和基础设施:①智能体生命周期管理和移动性;②白页服务和黄页服务;③点对点信息传输服务;④智能体安全性管理;⑤智能体多任务调度等。

1.2 JADE深层开发技术

JADE是一套免费开源的多Agent系统开发框架,提供了Agent赖以生存的运行时环境。Agent在JADE中是作为一种自治的具有合作能力﹑通信能力的实体,外部不能获得Agent的引用,即不能直接存取Agent的属性,也不能直接指定Agent的行为。创建Agent的具体任务只能由容器(Container)来完成,返回的结果也只是封装后的Agent。JADE为Agent的任务定义了一种Behaviour类,Behaviour中可以规定Agent执行时应遵循的不同协议,如合同网(FIPAContractNet)等,来实现其交互合作能力。

1.2.1 智能体的行为

为支持Agent内部并行活动的高效执行,JADE引入了Behaviour的概念。一个Behaviour就代表了智能体能够执行的任务。在JADE中,行为必须从其父类jade.core.behaviours.Behaviour派生。Behaviour类有很多子类,分别对应着不同类型的behaviours,如Simple Behaviour表示简单行为,Composite Behaviour表示组合行为等。

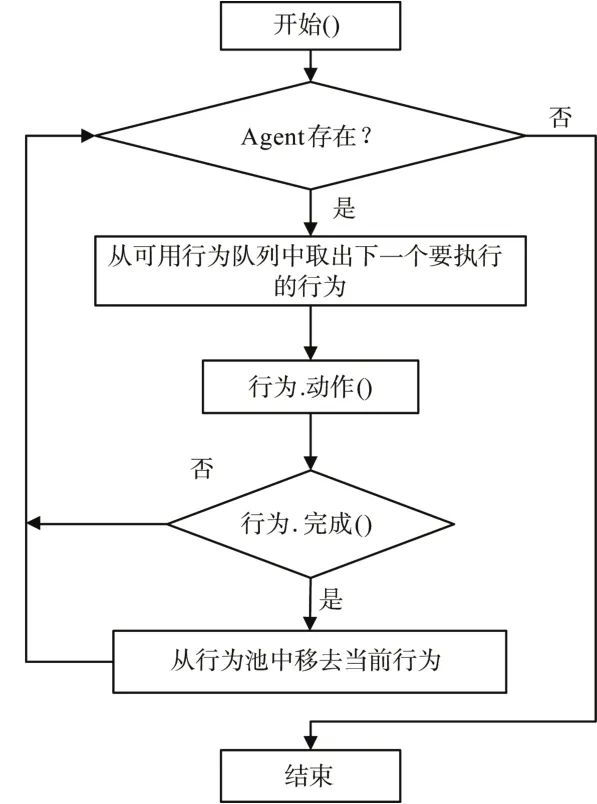

为了使智能体具有某种行为,编程人员必须利用Agent类的addBehaviour方法向智能体中显示的加入。行为可以在任何时候加入到智能体中。每个从Behaviour派生的行为类必须实现action和done方法。Action方法定义了一系列智能体执行的操作,而done方法表明行为是否结束完毕。如果done方法返回的值为真,那表示这个行为已经执行完毕,可以从智能体的行为池删除。图1表明了智能体行为的执行流程。

图1 Agent行为执行流程图Fig.1 Agent behavior execution flow

1.2.2 智能体之间的通信

通信能力是JADE中智能体具有的最重要的特征之一。通信过程中所采用的通信模式为异步消息传递。也就是说,每个智能体都有一个消息队列即mailbox,如果其他智能体需要与其通信时,JADE runtime就把相应消息投递到其mailbox中。当mailbox中出现消息时,相应的智能体被通知,再由该智能体调用Behaviour类中的action()方法对消息作出响应。

智能体之间的通信是通过ACL(Agent Communication Language)语言进行的,ACL是由FIPA制定的智能体互操作国际标准。ACL消息格式主要包括消息发送方﹑消息接收方﹑通信原语以及消息内容。在JADE中,消息是由jade.lang.acl.ACMessage类对象表示。通信的消息由多个字段组成,主要的字段有:Sender字段﹑Receivers列表﹑Performative字段﹑Content字段﹑Language字段﹑Ontology字段等。

发送﹑接受消息:如果要向其它Agent发送消息,Agent首先需建立一个ACLMessage对象,并设置适当的属性值,最后调用Agent.Send()方法来发送信息。接收消息时,Agent可以用receive()方法从其消息队列中取出消息。这种方法返回队列中的第一条消息并从队列中将其删除,或者返回Null。

1.2.3 ONTOLOGY

Ontology即本体,这个概念最初起源于哲学领域,用于研究客观事物的存在的本质。而在信息技术飞速发展的今天,本体的概念早已由哲学领域延伸到人工智能﹑信息系统﹑知识系统等其他各个领域。在人工智能领域,Ontology定义为“给出构成相关领域词汇的基本术语和关系,以及利用这些术语和关系来构成的规定这些词汇外延的规则”。

Agent间的通信内容有多种的消息内容,因此为Agent间所交换的信息内容定义自己的词汇和语义就显得很有必要。因此,通过定义一个Ontology来用于Agent间的通信。

使用Ontology保证了JADE的Agent可以同其他异质Agent系统进行互操作。利用Ontology进行Agent之间的通信可以实现以下几种通信:1)Agent A请求Agent B执行某项特殊的任务;2)Agent A询问Agent B某一命题是否为真;3)实现Concept接口。

2 AGC多智能体动态博弈平台开发

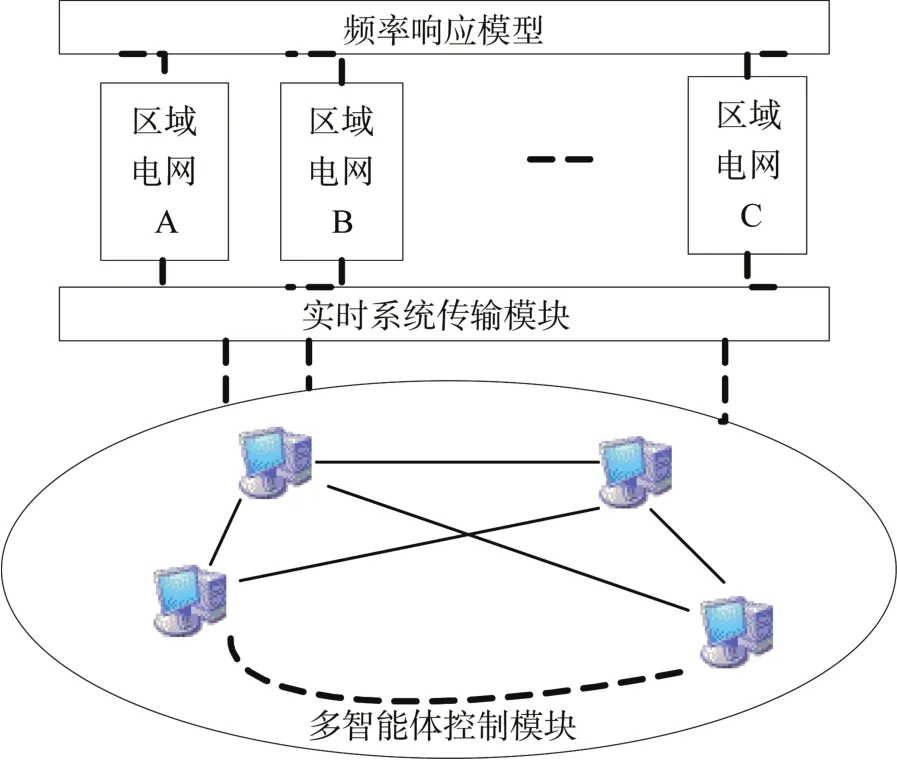

智能体是能感应环境变化并自主寻优运行的软件实体,智能体之间通过交互协作而完成某项特定任务。多智能体研究重点在于结合实际应用系统,具体研究任务分解﹑协作模型﹑协作控制策略以及多智能体学习方法。本文所开发的AGC多智能体动态博弈平台分为三个部分:负荷频率偏差模型﹑实时数据传输模块和多智能体控制算法实现模块,如图2所示。本文仅多智能体控制算法实现模块进行详细叙述。

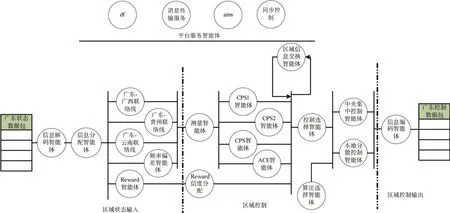

多智能体控制模块包含平台服务智能体﹑电网状态输入/控制输出智能体和分布式协调算法智能体,如图3所示。

图2 AGC多智能体控制平台Fig.2 AGC control platform for multi-agent

图3 多智能体控制模块Fig.3 Multi-agent control module

2.1 平台服务智能体

FIPA定义了平台应提供的若干服务,包括智能体管理系统ams,目录服务df和消息传输服务。本文为实时控制平台,因此加入同步控制智能体以记录本次循环控制的时间。JADE平台实体化后总是自动生成这四类智能体,为本平台的智能体创建﹑运行与销毁提供各类服务。

智能体ams主要负责智能体的命名﹑定位和控制服务。每个智能体必须在ams中注册得到一个有效﹑唯一的标志AID,用于智能体生命周期的管理。

智能体df也是智能体平台必须的部分,主要提供平台内的黄页服务,例如对其它控制单元可视状态的查询﹑统计查询信息等。

消息传输服务是默认的跨平台的智能体消息传输机制,提供了不同智能体之间的ACL消息交互机制。在消息传输机制中,ACC是消息传输的通道,MTP是不同ACC之间的消息交互协议。

同步智能体记录了平台当前运行的时间,并根据各智能体的消息处理时间定量计算各智能体的有效同步时间。各智能体的计算结果仅在同步时段内有效。如某类智能体在同步时段内不能完成指定任务,则启动此类备用智能体继续任务。

2.2 状态输入/控制输出智能体

此类智能体是保证区域控制智能体正常运行的前提。状态输入智能体主要包括接收﹑解码来自区域电网的实时状态信号﹑时段信号等,并负责分配给各智能体所需要的状态信号;控制输出智能体负责信号编码,并打包发送给各电网区域。区间内智能体主要是数据的接收﹑发送与数据备份。

此类智能体实现机制较为简单,在给智能体注册后,即可添加行为TickerBehaviour执行周期性数据收发备份工作。时间间隔等同于AGC时间执行间隔,一般为3-5秒。

2.3 分布式协调算法智能体

在多智能体控制模块的分布式智能算法中,测量智能体的数据输入为该区域的联络线功率偏差与频率偏差,输出为此区域的控制误差(Area Control Error, ACE)值和滚动CPS(Control Performance Standards) 平均值。区域信息交换智能体则负责接收来自其它区域电网的状态信号和控制信号和发送本区域的状态控制信号给其它需要区域。随后,各区域的ACE与CPS值传输到控制选择智能体,此智能体决定采用集中式AGC控制器还是分散式AGC控制器。

选择的原则为各区域状态动作的信息是否齐备和集中AGC智能体是否正常工作,如都是则选择集中AGC智能体,输出为各个区域的及时均衡动作值;否则选择分散AGC智能体,如果数据齐全,各分散AGC控制器分配各自计算的均衡动作并互不影响;如果数据不全,各分散控制器调入数据不齐全区域的上一次正常数据再行计算均衡动作值并分配动作。整个互联电网有且仅有一个集中AGC控制器,而测量智能体和分散AGC控制器在每一区域电网均有一个。

Reward信度分配智能体是对上一步联合动作下电网反馈的奖励进行重新评估。评估的原则为:1)扣除上一步扰动的结果;2)扣除联络线的波动对奖励的影响。算法选择智能体决定采用智能算法的编号,平台可供选择算法有强化学习标准Q﹑Q(λ)算法和多智能体相关均衡算法DCE Q(λ)和斯泰格贝格均衡算法Asymmetric Q(λ)。这里仅对测量智能体和动作区间的模糊化作简要介绍。算法描述请参阅相关文献[17]。

测量智能体负责控制算法所需要数据状态数据的测量。本文采用北美电力可靠性协会(NERC)于1999年正式推出联络线功率偏差与系统频率偏差模式下互联电网AGC的控制性能标准(CPS)来确定区域ACE与CPS值[18]。

区域控制偏差ACE定义为:

式中:分别为联络线实际潮流值与期望潮流值;B为频率偏差系数;﹑分别为系统实际频率值与期望频率值。

CPS1要求某i区域电网在考核时间段内(例如10min)满足

式中:Bi为控制区域i的频率偏差系数;为互联电网对全年1分钟频率平均偏差均方根的控制目标值;n为该考核时段的分钟数。这一时段CPS1指标的统计公式为:

CPS2要求某i区域电网在考核时间段内(10min) ACE平均值的绝对值控制在某误差以内:

2.4 强化学习算法一般结构

本平台主要是在AGC控制器中嵌入强化学习算法以解决传统固定增益控制器所不能解决的问题:电力系统运行点随季节的变化﹑电网结构的复杂等而不能进行有效的控制。不论是单智能体算法还是多智能体算法,其算法都有如下基本形式:

式中V﹑Q分别为输入信号所处状态﹑状态-动作的值函数,f1为根据Q值确定V值的函数,f2为根据Q值确定最优策略 π*(s)的函数,R为立即奖励值,γ为奖励折扣值,P为概率转移矩阵。

本平台中,强化学习引入智能体控制器以实现区域电网AGC控制。AGC智能控制器抽象如下:在每一离散时刻k=1, 2…,每一个控制器观测当前系统所处状态s∈S,根据自身最优策略采取一最优动作,其后环境反馈给智能体一个奖励值评估采取的最优动作,根据奖励值修正最优策略,依次循环。奖励值可以根据控制目标设定,本文采取CPS指标评估控制效果,可以选取其10-min滚动平均值作为控制器奖励函数的状态反馈输入。

2.5 资格迹的选取

AGC不同于简单的博弈论对策游戏,其控制过程复杂。由于火电机组大滞后环节等二次调频过程的奖励通常具有延时回报问题。因此具有多步回溯功能的资格迹需要被引入至强化学习算法中以解决时间信度分配问题。资格迹(Eligibility Trace)详细记录各联合动作策略发生的频率,并依此对各动作策略的迭代Q值进行更新,常用的资格迹算法有四种:TD(λ)﹑SARSA(λ)﹑Watkin's Q(λ)和Peng's Q(λ)。

TD(λ)和SARSA(λ)是比较简单的两种资格迹,分别记录控制器过去访问过的状态﹑状态-动作区间。由于算法简单,且整合容易,这两种资格迹常用在计算量需求不大的场合。

Watkin's Q(λ)算法是单智能体强化学习中最常用的算法,主要思想是迭代Q值的更新一直向前追溯直至非贪婪动作策略的采用。因此,在预学习阶段中此算法由于探索(explore)的必要必定大量采用非贪婪策略,资格迹常常频繁被切断。其改进算法即为Peng's Q(λ),这一改进也付出了计算量翻倍的代价。

本平台提供四种资格迹可供选择,在选择中需要根据算法实际情况和系统实际运行确定选取的资格迹,有效保证延时奖励的正确分配。

3 南方电网应用研究

南方电网(China Southern Grid, CSG)由广东电网﹑广西电网﹑云南电网﹑贵州电网和海南电网五省构成,属于交直流混合输电系统,于2005年采用CPS控制标准。由于海南电网所占份额很少,且仅有一条外线相连于广东电网,故本平台仅考虑四区域互联电网。控制器调度端AGC总指令控制周期为4s,L10广东电网取288MW,广西电网取75MW,贵州电网和云南电网分别取81MW和78MW。ε10和ε1分别取0.042和0.052。仿真过程中,电网外部环境描述为强随机环境,采用白噪声进行测试,其设定过程参见文献[19]。

3.1 AGC控制器设计

本实例中AGC控制器采用算法为相关均衡CE-Q学习,由于计算量较大,采用较简单的资格迹SARSA(λ)。

3.2 CE-Q算法简介

CE-Q(Correlated Equilibrium-Q learning)是一种基于值函数迭代的在线学习和动态优化技术。相关均衡策略的线性约束描述为对所有智能体i﹑所有动作ai﹑a-i∈Ai(π(ai)>0)式(5)均成立:

满足式(5)的相关均衡策略随着智能体的增多而增多。由此CE-Q状态值函数和最优均衡策略函数分别定义为:

式中πst为给定的最优均衡策略。

相关均衡物理含义为,在各区域电网当前状态下,根据各子值函数,确定最优均衡点以最大化利于各个区域电网ACE的变小和CPS值的提升。它赋予每一联合动作对以一定的概率,每一不为零概率的动作对其Q值均较大。各个不为零概率的动作对组成了最优均衡策略。

奖励函数选用ACE的瞬时方差,也即现状态ACE值与上一步ACE值的差。研究发现,这一奖励函数能很好的立即识别最优动作和次优动作,有效加快收敛速度和收敛性能。

3.3 实时控制效果

3.3.1 预学习阶段

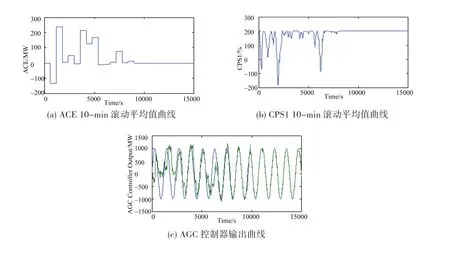

强化学习AGC控制器要进行在线控制,必须要在详细的模型中离线学习达到最优策略方可进行在线控制。预学习过程采用典型正弦扰动,其广东电网预学习过程如图4所示,可以看出在经过大约9000秒学习之后,ACE为0,CPS1值达到200且之后AGC控制器输出平滑没有毛刺,能完全追踪负荷的变化,说明最优策略的学习已经完成,可以投入在线运行。

图4 典型预学习过程Fig.4 Typical pre-learning process

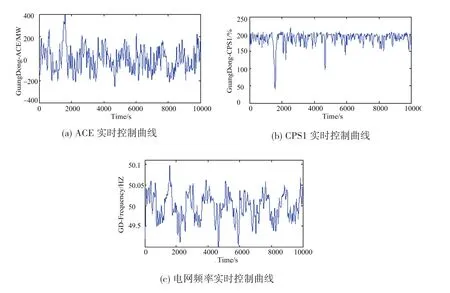

3.3.2 在线实时控制

在上诉预学习完成后,保存各个Q值和lookup表格,投入到南方电网四省区域电网的AGC实时在线控制中。广东电网实时控制效果参见图5,可见本平台ACE控制在允许范围以内,CPS1控制接近200,频率偏差控制在0.1Hz以内。可见,本平台能很好的实现多智能体AGC仿真控制。

4 总结

本文提出了基于JADE多智能体技术的AGC控制平台以评估智能算法控制性能和解决未来自动发电控制过程所面临的强随机环境。该平台的优点在于能够准确抽象并快速模拟多智能体系统的AGC控制,通过变换系统的参数和加载不同的控制算法,既可以在同种控制方法下对其他因素的影响进行对比,又可以对不同控制算法之间进行横向比较和评测。本文加载了具有相关均衡思想的CEQ控制算法实现南方电网各省之间的AGC协作控制,避免由于某一区域不能单独实现频率偏差的调整而陷入频率偏差过大的状态,并取得良好的控制效果。此平台可为未来复杂互联多区域的控制协作算法的研究提供更多公正而可靠的评测,为设计和提升算法性能提供研究基础。同时,该平台的建立也为未来复杂多区域强随机互联系统的AGC控制手段的升级提供了一条走向实际应用的思路。

图5 广东电网实时控制效果图Fig.5 Real-time control renderings of Guangdong Power Grid

[1] 席磊, 张孝顺, 程乐峰, 等.基于 JADE 多智能体动态博弈的自动发电控制仿真平台研究[J].新型工业化, 2014, 4(11):5-18.L XI, X S ZHANG, L F CHENG, et al.Research on Multi-agent simulation Platform for AGC based on JADE[J].The Journal of New Industrialization, 2014, 4(11):5-18.

[2] 胡兆光, 方燕平.智能工程及其在电力发展战略研究中的应用[J].中国电机工程学报, 2000, 20(3):45-49.Z G Hu, Y P Fang.Intelligent engineering and its application to power development strategy study[J].Proceedings of the CSEE, 2000, 20(3):45-49.

[3] 杨煜普, 李晓萌, 许晓鸣.多智能体协作技术综述[J].信息与控制, 2001, 30(4):337-342.Y P Yang, X M Li, X M Xu.A survey of technology of multi-agent cooperation[J].Information and Control, 2001, 30(4):337-342.

[4] 刘金琨, 尔联洁.多智能体技术应用综述[J].控制与决策, 2001, 16(2):133-140.J K Liu, L J Er.Overview of application of multi-agent technology[J].Control and Decision, 2001, 16(2):133-140.

[5] 付明玉, 吴宝奇, 张晓霜.基于反步滑模控制的动力定位船铺管循迹建模与分析[J].新型工业化, 2014, 4(3):17-22.FU Mingyu, WU Baoqi, Zhang Xiaoshuang.Modeling and analysis of trajectory tracking for DP vessel pipelaying based on backstepping sliding mode method [J].The Journal of New Industrialization, 2014, 4(3):17-22.

[6] 刘红进, 袁斌, 戴宏伟, 等.多代理系统及其在电力系统中的应用[J].电力系统自动化, 2001 (10):45-52.H J LIU, B YUAN, H W DAI, et al.Multi-agent system and its application in power systems[J].Automation of Electric Power Systems, 2001, 25(19):45-48.

[7] 束洪春, 唐岚, 董俊.多Agent 技术在电力系统中的应用展望[J].电网技术, 2005, 29(6) :27- 31.H C Shu, L Tang, J Dong.A survey on application of multi-agent system in power system[J].Power System Technology, 2005, 29(6):27-31.

[8] 罗凯明, 李兴源, 李雪.多代理技术在电力系统中的应用[J].国际电力, 2004, 8 ( 3) :38- 43.K M Luo, X Y Li, X Li.Applications of Muti-Ag Technology in Power Systems[J].International Electric Power for China, 2004, 8(3):38-43.

[9] Franklin S, Graesser A.Is It an Agent, or just a Program? A Taxonomy for Autonomous Agents [A] .Proceedings of the Third International Work shop on Agent Theories, Architectures and Languages[C].Budapest (Hungary) :Springer- Verlag, 1996:21- 35.

[10] 周小利, 王宏强, 程永强, 等.宽带MIMO雷达角度估计的统计分辨力[J].新型工业化, 2014, 4(4):9-16.ZHOU Xiaoli, WANG Hongqiang, CHENG Yongqiang, et al.Statistical Resolution Limit of Angle Estimation for Wideband MIMO Radar [J].The Journal of New Industrialization, 2014, 4(4):9-16.

[11] Leseure M J, Brookes N J.A support tool for knowledge management activities[C].Management of Innovation and Technology, ICMIT 2000.Proceedings of the 2000 IEEE International Conference on, Volume:2.12-15 Nov.2000:696-701.

[12] Chin-Bin Wang, Yuh-Min Chen, Yuh-Zen Chen, A distributed knowledge model for collaborative engineering knowledge management in allied concurrent engineering [C].Engineering Management Conference, 2002 IEEE International, 2002, 2(8):701-707.

[13] 刘晓东, 黄万伟, 吴云洁, 等.弹性弹体被动﹑主动和复合控制及其适用性分析[J].新型工业化, 2014, 4(5):11-19.Liu Xiaodong, Huang Wanwei, Wu Yunjie, et al.Passive, Active and Compound Control for Elastic Missile and Applicability Analysis[J].The Journal of New Industrialization, 2014, 4(5):11-19.

[14] 常志远.基于自适应EWMA 算法t 控制图检测能力的研究[J].新型工业化, 2014, 4(6):15-21.CHANG Zhiyuan.Research on detection capability of t control chart based on adaptive EWMA algorithm[J].The Journal of New Industrialization, 2014, 4(6):15-21.

[15] Aris L D, Nikos D.Operation of a multi agent System for micro-grid control[J].IEEE Transaction on Power Systems, 2005, 20(3):1447-1455.

[16] 赵伟, 白晓民, 丁剑, 等.基于协同式专家系统及多智能体技术的电网故障诊断方法[J].中国电机工程学报, 2006, 26(20):1-8.

[17] W Zhao, X M Bai, J Ding, et al.A New Fault Diagnosis Approach of Power Grid Based on Cooperative Expert System and Multiagent Technology [J].Proceedings of the CSEE, 2006, 26(20):1-8.

[18] Daneshfar F, Bevrani H.Load-frequency control:a GA-based multi-agent reinforcement learning[J].IET Proc.of Gener.Transm.Distrib., 2010, 4(1):13-26.

[19] Jaleeli N, Vanslyck L S.NERC's new control performance standards[J].IEEE Trans.On Power System, 1999, 14(3):1091-1099.

[20] 余涛, 周斌, 陈家荣.基于Q学习的互联电网动态最优CPS控制[J].中国电机工程学报, 2009, 29(19):13-19.Yu Tao, Zhou Bin.Q-learning based dynamic optimal CPS control methodology for interconnected power systems[J].Proceedings of the CSEE, 2009, 29(19):13-19.

A Novel Policy for Smart Generation Control

CHEN Xin1, YU Tao2, XI Lei2, QIU Xuanyu2, ZHANG Xiaoshun2

(1.Shaoguan Power Supply Bureau, Shaoguan 512026, China; 2.School of Electric Power, South China University of Technology, Guangzhou 510640, China)

A novel policy is proposed in this paper to deal with smart generation control under strong random grid environment considering emerging renewable energy sources.Every control area contains input grid status agents, synergetic algorithm implementation agents, and output controller agents.Decentralized correlated equilibrium Q(λ) learning was integrated in control agent as the main synergetic control method.Besides, the mechanism of agent communication, behavior and action of this platform are discussed in details.It has been proved that this platform applied to China Southern Power Grid could achieve coordination control between automatic generation control areas, especially when one of the areas could not drive its area control error to zero.Different control algorithms can be embedded into control agent and its control performance can be evaluated, which demonstrates the effectiveness, scalability and flexibility of this platform.

AGC; MAS; correlated Q learning; correlated equilibrium; stochastic optimal control

陈鑫,余涛,席磊,等.一种新颖的智能发电控制策略[J].新型工业化,2015,5(5):40-48

10.3969/j.issn.2095-6649.2015.05.06

:CHEN Xin, YU Tao, XI Lei, et al.A Novel Policy for Smart Generation Controll [J].The Journal of New Industrialization, 2015, 5(5)∶ 40‒48.

国家自然科学基金(51177051,51477055),国家重点基础研究发展计划(973计划)(2013CB228205),广东省绿色能源技术重点实验室资助项目(2008A060301002)

陈鑫(1982-),男,学士,主要研究方向:电力系统运行控制工作;余涛(1974-),男,教授,博士生导师,博士研究生,主要研究方向:复杂电力系统的非线性控制理论和仿真研究;席磊(1982-),男,博士研究生,主要研究方向:电力系统优化运行与控制的研究;邱轩宇(1990-),男,硕士研究生,主要研究方向:电力系统优化运行与控制的研究;张孝顺(1990-),男,博士研究生,主要研究方向:强化学习算法在电力系统优化的研究与应用。