基于词袋模型的脑肿瘤MR图像分割方法

赵建奇,黄美艳,冯前进,陈武凡

(南方医科大学生物医学工程学院,广东广州510515)

0 引 言

核磁共振成像(magnetic resonance imaging,MRI)由于具有非侵入性,无辐射伤害,高分辨率等优点,尤其适用于脑部肿瘤的诊断,已成为脑肿瘤诊断中最常用的影像检查方法。但在现阶段,脑肿瘤的分割一般由有经验的医生手工进行,耗费时间较长同时容易引入人为误差,因而MR脑肿瘤图像的自动分割成为当前的研究热点[1]。MR脑肿瘤图像自动分割的困难主要在于:①脑组织本身结构复杂,包含多种组织,且各组织灰度分布存在交叠;②不同个体间组织结构差异较大,即使是同一个体,随着时间的推移,也会产生一些变化。脑组织结构的这些复杂特点,使得目前还没有一种方法可以通用地解决脑肿瘤MR图像的分割问题。目前代表性的方法包括图谱法(Atlasbased)[2,3]、图割法(graph cut)[4-7]、模糊聚类(fuzzy clustering)[8,9]、活动轮廓模型(active contour models,ACMs)[10,11]、基于分类器的方法[12-14]等,本文采用的方法就是基于分类器的分割方法。

基于分类器的脑肿瘤分割方法将分割问题看作像素点的分类问题。在基于分类器的分割方法中,图像特征具有的辨别能力的强弱直接影响着分割结果的好坏,如何提取有效的特征是分类器算法面临的关键问题。针对传统灰度特征辨别力不强缺乏空间信息,以及传统纹理特征概括性较弱的不足,我们引入词袋模型(bag of words,BoW)[15,16]并配合滑动窗口来提取像素点的特征。词袋模型将图像看作视觉单词的集合,由于视觉单词即对相似的特征具有代表性又对不同的特征具有区分性,因而将词典对像素点的表达作为特征可以提升特征的辨别能力。在相关文献中,还未见将词袋模型应用于脑肿瘤MR图像分割的相关报道。

1 基于词袋模型的脑肿瘤MR图像分割方法

1.1 方法概述

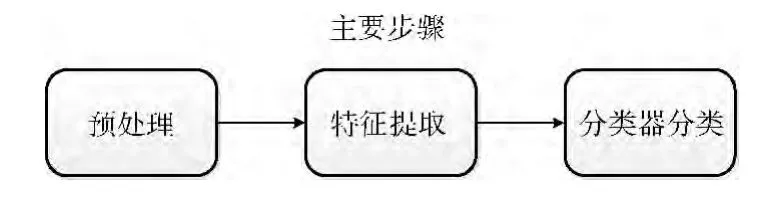

本文方法在MR图像的T1增强图像上实现,主要分为预处理、特征提取和分类器分类3个步骤。如图1所示,首先对数据集中的所有图像进行预处理,接着对训练集中的图像按照肿瘤区域与背景区域的分类分别提取图像块特征并进行K-means聚类,构建联合词典。然后利用滑动窗口提取由词典对像素点的表达构成的特征。最后将特征送入分类器进行训练,利用训练好的分类器对测试集中的待分割图像逐一像素点进行分类从而完成分割。

图1 利用词袋模型进行图像分割的流程

1.2 预处理

图像的预处理阶段主要包括脑组织提取和灰度归一化。为去除头骨等非脑组织对脑肿瘤分割的干扰,本文利用BET算法对实验数据进行去脑壳处理。实验中采用BET算法团队开发的FSL(FMRIB software library,http://fsl.fmrib.ox.ac.uk)工具包,调整参数使去脑壳效果达到最优。为去除成像因素(参数设置、不同设备等)影响造成的图像灰度差异,本文对实验数据进行灰度归一化处理。对每一幅去脑壳后的图像,选取灰度值范围上5%和95%的值作为最小值和最大值,利用min-max方法将灰度归一化为0-100。

1.3 特征提取

本文提取像素点特征的基本过程如图2所示。图像上某一点S的特征由其滑动窗口内的邻域像素点特征来表达。在滑动窗口中,首先依据一定的步长选取像素点S邻域内的相邻像素点,然后采集相邻像素点的图像块特征并与视觉词典相比较,为其分配最相近的视觉单词作为邻域像素点的特征,最后统计滑动窗口中的视觉单词,得到像素点S的特征。

1.3.1 构建视觉词典

首先我们利用训练集图像构建视觉词典。本文采用密集采样的方法选取采样点,采用灰度图像块特征作为特征描述子。对病灶区域和背景区域两类区域内的每个采样点提取其特征描述子,记为fk,区域内所有的特征描述子组成该区域的特征集F,则有其中c∈{0,1},当c=0时F为病灶区域的特征集,当c=1时F为背景区域的特征集,n为区域内采样点的个数。图像块大小对分割结果的影响将在后面的实验1中讨论。

图2 提取像素点特征的基本过程

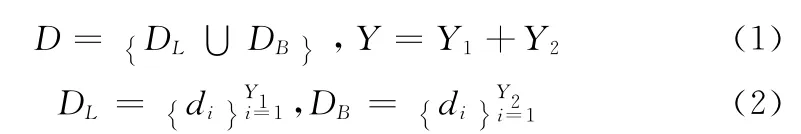

在得到两类区域的特征集之后我们用K-means聚类法对两类特征集进行分类聚类。一般的词袋模型方法中词典由训练集样本直接聚类得到,在像素点分类的过程中,全局词典容易导致不同类别的像素点被分配给同一视觉单词,使得视觉单词缺乏辨别能力,词典对像素点的表达能力下降。为了克服这一缺点,本文采用分类聚类的方法,分别生成病灶区域词典和背景区域词典,再将两个词典组合起来生成联合词典。经过分类聚类,使不同类别的视觉单词尽可能的分开,从而使联合词典可以为特征提供相对空间位置信息,提高了词典对像素点的表达能力。

设视觉词典D=[d1,d2,…,di,…dY]的大小为Y,其中di为词典中第i个视觉单词。词典D由生成于肿瘤区域的大小为Y1的词典DL与生成于背景区域的大小为Y2的词典DB共同组成,即

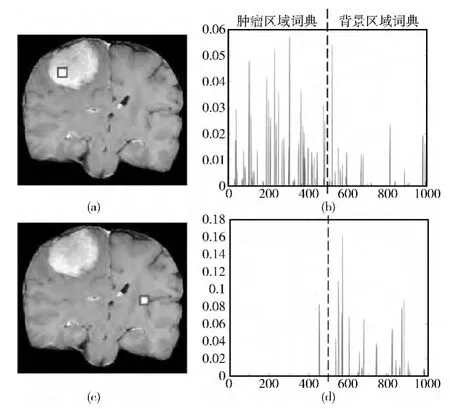

图3分别给出了一般的词袋模型中的全局词典以及由本文的分类聚类方法构建的联合词典,从图3中我们可以看出,使用分类聚类方法得到的联合词典中来自肿瘤区域的单词与来自背景区域的单词之间有比较明显的分界。

图3 全局词典与联合词典的比较,两词典大小都为676

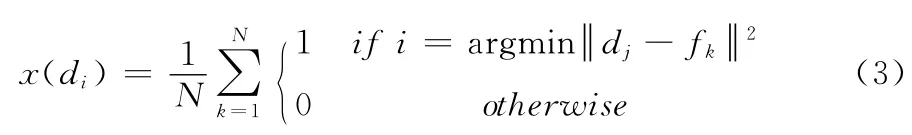

图4为联合词典对不同区域内的像素点的表达,从图4中我们可以看出,在大小为1000的联合词典中,0-500为肿瘤区域词典,500-1000为背景区域词典,来自肿瘤区域的像素点的特征大部分集中在肿瘤区域词典中,来自背景区域像素点的特征则大部分集中在背景区域词典中。聚类数即词典大小对分割结果的影响将在后面的实验2中讨论。

图4 联合词典对不同区域像素点的表达

1.3.2 提取像素点的特征

在得到视觉词典之后,我们就要使用词典对像素点进行表达,即从某幅训练图像中提取以某个像素点为中心的图像块特征,依据特征的相似程度为其分配视觉单词作为该像素点的特征。本文采用硬分配的编码方式,即每个像素点唯一对应词典中一个最相近的视觉单词。但由于上一步骤中特征描述子的选择为灰度图像块特征,其给像素点的表达过程带来了不便,即图像块的大小难以确定。当选择较小的图像块时,信息少辨别能力弱,词典中可选的相近单词多,词典对像素点的表达能力差;当选择较大的图像块时又会导致词典中找不到相近的单词,词典的表达能力也受到限制。因此,为了提高词典的表达能力,我们采用滑动窗口对像素点进行表达。

在滑动窗口中,目标像素点的特征由其滑动窗口内的邻域像素点特征来表达。首先设置较大的滑动窗口,然后选取目标像素点邻域内的相距一定步长的像素点,采集其图像块特征,这里选择较小的图像块,接着与视觉词典相比较为邻域像素点分配视觉单词,最后统计滑动窗口中的视觉单词,从而得到目标像素点的特征。为了计算方便,本文先将所有的图像转换为码字图。在滑动窗口模型中,图像上的一个像素点可表示为下式

式中:i,j——代表单词位置的码字,N=h*h——窗口中特征描述子的数量,h——窗口的大小,fk——窗口范围内的一个特征描述子。图5(a)为训练集中的一副图像;图5(c)为图5(a)经过转换之后的码字图;图5(b)、图5(d)为特征提取过程中从目标像素点滑动窗口中截取的一部分;图5(e)为采用滑动窗口得到的目标像素点的特征。由图5(d)图可以看出,利用词典对像素点进行表达已经能够较好的将肿瘤区域与背景区域分割开来。

1.4 分类器分类

本文方法中,我们采用逻辑回归分类器对脑部肿瘤组织与背景组织两类目标进行分类。逻辑回归分类器是一种常用的机器学习方法,用于估计某种事物的可能性。

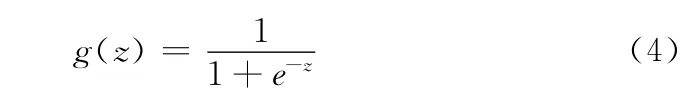

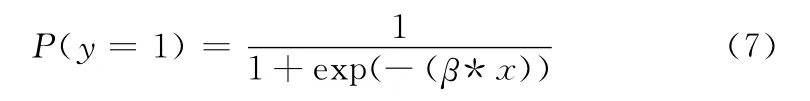

逻辑函数(又被称为sigmoid函数)的形式如下

由于逻辑函数的定义域是(-∞,+∞),而值域为(0,1),因此逻辑回归分类器适合于对两类目标进行分类。在分类过程中,选取一个合适的阈值,函数值大于阈值就被认为是目标,小于阈值就被认为是背景。

在训练阶段,当有某一样本特征输入时,样本函数可表示为

图5 利用码字图表达目标像素点

式中:β(β0,β1,…,βM)——逻辑回归系数,x(x1,x2,…xM)——某样本数据的特征,维度——M。

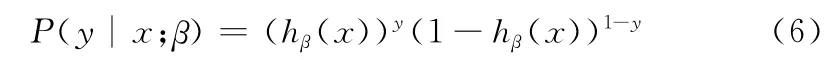

它的概率估计可表示为

对其似然函数做最大似然估计得到最合适的β值,通过训练就可以得到这样一组权值β(β0,β1,…,βM)。将上面得到的由词典表达构成的像素点的特征,连同病灶与背景两类标记送入逻辑回归分类器中,通过训练得到权重系数β。

在分类阶段,利用相同大小的滑动窗口遍历测试图像,由词典的表达得到每个像素点的特征,给出一个像素点的一组特征x(xi,…,xY),其中Y代表词典大小,则该点是肿瘤组织的可能性为

阈值选为0.5,如该像素点得到的可能性大于阈值就被认为是肿瘤组织,即完成了分割。

2 分割结果及讨论

2.1 数据集

本文使用的实验数据共160例MR脑肿瘤T1增强图像,其中脑膜瘤90例,垂体瘤70例,病灶区域由经验丰富的医师手工勾画得到。随机抽取80例作为训练图像,其中脑膜瘤47例垂体瘤33例,剩下的80例作为测试图像。

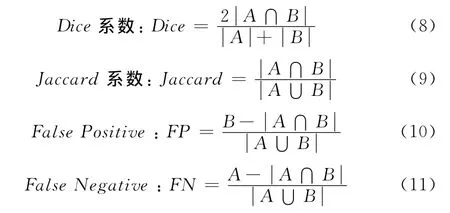

2.2 评价标准

我们采用常用的4个指标来比较算法自动分割结果与医师手工勾画结果,它们分别是

式中:A——本文方法的结果,B——医师手工勾画的结果。

2.3 参数选择

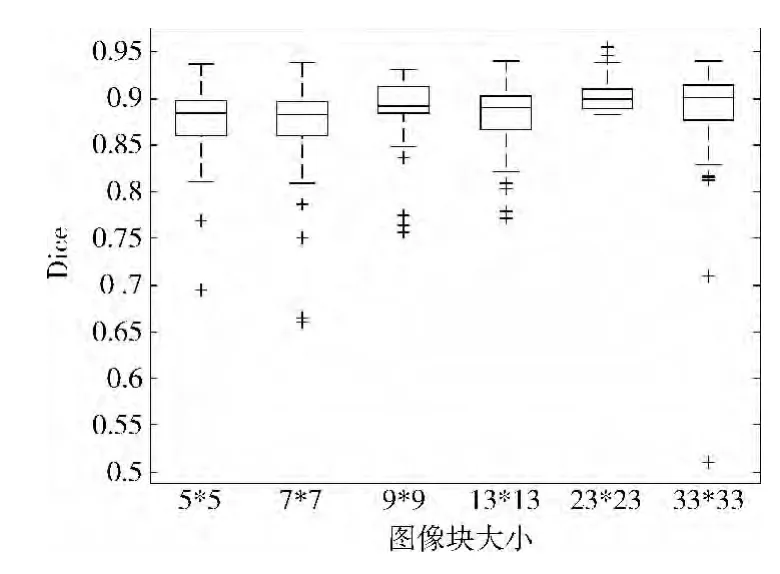

实验1:图像块大小对分割结果的影响

为了评估图像块大小对分割结果的影响,词典大小设为1000,滑动窗口大小设为16。图6中横轴代表不同大小的图像块,纵轴代表Dice系数。由实验结果可以看出,随着图像块的不断增大,分割的精度也越来越高。因为随着图像块的增大会有更丰富的信息来表达该像素点,从而提高了特征的辨别能力。但随着图像块的增大,程序的运行时间也成倍增长,因而需要在分割精度与处理时间两者之间取得平衡。

图6 图像块大小对分割结果的影响

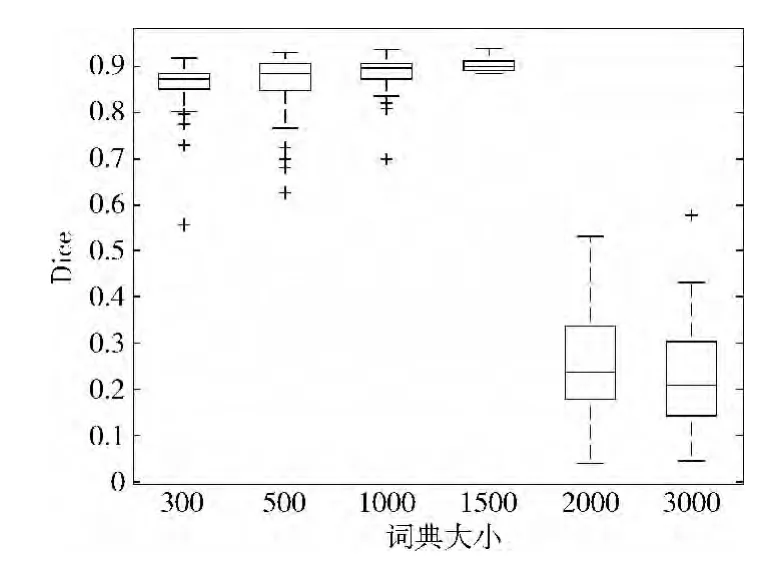

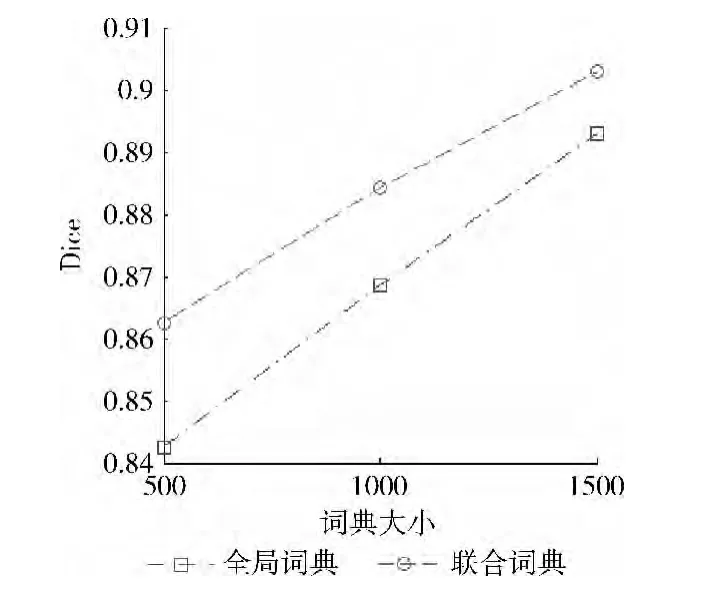

实验2:词典大小对分割结果的影响

为了评估词典大小对分割结果的影响,图像块大小设为15*15,滑动窗口大小设为16。图7中横轴代表不同容量的联合词典,纵轴代表Dice系数。由实验结果可以看出,当词典容量较小时,分割精度较低。因为此时的视觉单词数目较少,导致不同特征的像素点被归为相同的一类,即词典不足以充分表达像素点。随着词典容量的增大,分割精度也逐渐提高。因为随着视觉单词的数目越来越充足,词典对像素点的表达能力也越来越强。但词典容量并不是越大越好,从图7中我们可以看出,当词典容量增大到2000、3000的时候,分割精度急剧下降。这是因为当词典容量过大时,视觉单词由于过度分散导致概括性能下降,本应被归为一类的相似的像素点会被归为不同的类别,导致分割精度下降。在该实验设置条件下,当词典容量大小为1500时,分割的效果最好。

图7 词典大小对分割结果的影响

2.4 结果

实验3:联合词典与全局词典的比较

联合词典与全局词典由相同的特征集通过K-means聚类得到,分别使用词典大小为500、1000、1500的联合词典与全局词典进行分割。如图8所示实验结果可以看出,联合词典的性能要优于全局词典。但随着词典容量的增大,联合词典的优势在逐渐变小。

图8 分别利用联合词典与全局词典的分割结果比较

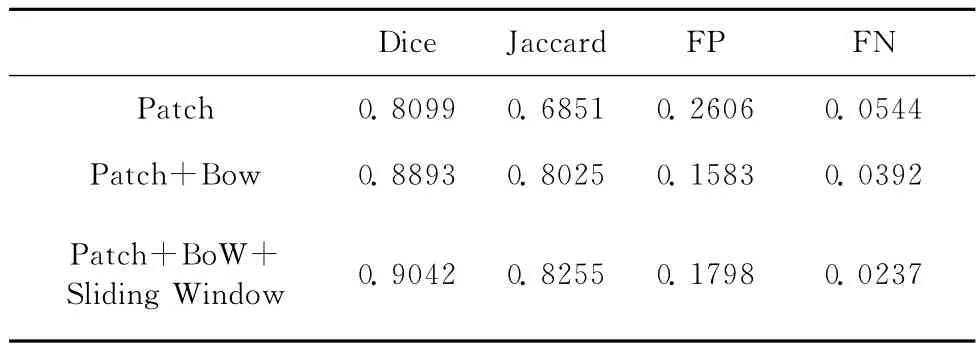

实验4:本文方法与传统方法的比较

经过参数选择的实验,我们选择图像块大小为23*23,滑动窗口大小为16,词典大小为1500进行实验。共使用3种方法进行分割,一是直接使用图像块特征进行分割;二是将图像块特征与词袋模型结合之后进行分割;三是将图像块特征、词袋模型、滑动窗口三者结合起来进行分割。分割结果见表1。从分割结果可以看出,单纯的使用图像块特征,分割的正确率较低;加入词袋模型之后,分割的正确率有了明显提高;利用滑动窗口提取像素点特征,分割的正确率又有了进一步的提高。部分分割结果如图9所示。可以看出,我们的分割结果同医生手动分割的结果比较接近,表明了本文方法的有效性。

表1 本文分割结果与传统方法结果的评价

图9 本文方法分割结果与医生手工分割结果的比较

3 结束语

本文提出了一种利用词袋模型配合滑动窗口提取像素点特征的脑肿瘤MR图像分割方法,通过引入词袋模型,建立分类的视觉词典,应用滑动窗口等手段提取像素点的基于词典表达的特征,对应用词袋模型的图像分割方法进行了优化。实验结果表明,本文方法的分割精度较高且具有效性。今后的工作主要是实验新的有效特征以及分类性能更好的分类器。

[1]ZHANG Nan,YANG Wenming,LIAO Qingmin.The brain tumor segmentation algorithms for MRI images[C]//Chinese Society of Biomedical Engineering's 30th Anniversary Conference Chinese Society of Biomedical Engineering Academic Con-ference Youth Excellent Papers.Beijing:Chinese Society of Biomedical Engineering,2010(in Chinese).[张楠,杨文明,廖庆敏.MRI图像脑肿瘤分割算法概述[C]//中国生物医学工程学会成立30周年纪念大会暨中国生物医学工程学会学术大会青年优秀论文.北京:中国生物医学工程学会,2010.]

[2]Gooya A,Biros G,Davatzikos C.Deformable registration of glioma images using EM algorithm and diffusion reaction modeling[J].IEEE Transactions on Medical Imaging,2011,30(2),375-390.

[3]Menze BH,Van Leemput,K Lashkari.A generative model for brain tumor segmentation in multi-modal images[C]//Medical Image Computing and Computer-Assisted Intervention,2010:151-159.

[4]Feng Q,Li S,Yang W,et al.Tumor segmentation using the learned distance metric[C]//IEEE International Symposium on Biomedical Imaging,2011:1958-1961.

[5]Wu Y,Yang W,Jiang J,et al.Semi-automatic segmentation of brain tumors using population and individual information[J].Journal of Digital Imaging,2013,26(4):786-796.

[6]LI Shuanqiang,FENG Qianjin.Liver tumor segmentation using graph cuts based on CUDA[J].Chinese Journal of Biomedical Engineering,2010,29(5):641-647(in Chinese).[李拴强,冯前进.统一计算设备架构并行图割算法用于肝脏肿瘤图像分割[J].中国生物医学工程学报,2010,29(5):641-647.]

[7]LI Shuanqiang,FENG Qianjin,CHEN Wufan,et al.A graph cuts-based interactive method for segmentation of magnetic resonance images of meningioma[J].Journal of Southern Medical University,2011,31(7):1164-1168(in Chinese).[李拴强,冯前进,陈武凡,等.一种基于图割的交互式脑膜瘤核磁共振图像分割方法[J].南方医科大学学报,2011,31(7):1164-1168.]

[8]Khotanlou H,Colliot O,Atif J,et al.3D brain tumor segmentation in MRI using fuzzy classification,symmetry analysis and spatially constrained deformable models[J].Fuzzy Sets and Systems,2009,160(10):1457-1473.

[9]Thomas H,Yi-Min L,Chun-Chih L.Automatic segmentation of meningioma from non-contrasted brain MRI integrating fuzzy clustering and region growing[J].BMC Medical Informatics and Decision Making,2011,11(1):1472-6947.

[10]Dubey R,Hanmandlu M,Gupta S,et al.Semi-automatic segmentation of MRI brain tumor[J].ICGST-GVIP Journal,2009,9(4):33-40.

[11]Taheri S,Ong SH,Chong V.Threshold-based 3D tumor segmentation using level set(TSL)[C]//IEEE Workshop on Applications of Computer Vision,2007.

[12]Gao L,Yang W,Liao Z.Segmentation of ultrasonic breast tumors based on homogeneous patch[J].Medical Physics,2012,39(6):3299-3318.

[13]Li W,Liao S,Feng Q,et al.Learning image context for segmentation of the prostate in CT-guided radiotherapy[J].Physics in Medicine and Biology,2012,57(5):1283-1308.

[14]Yang W,Feng Q,Yu M,et al.Content-based retrieval of brain tumor in contrast-enhanced MRI images using tumor margin information and learned distance metric[J].Medical Physics,2012,39(11):6929-6942.

[15]Huang M,Yang W,Yu M,et al.Retrieval of brain tumors with region-specific bag-of-visual-words representations in contrast-enhanced MRI images[J].Computational and Mathematical Methods in Medicine,2012,2012:280538.

[16]Yang W,Lu Z,Yu M,et al.Content-based retrieval of focal liver lesions using bag-of-visual-words representations of single-and multiphase contrast-enhanced CT images[J].Journal of Digital Imaging,2012,25(6):708-719.