红外与可见光图像自相似性特征的描述与匹配

李俊山,朱英宏,2朱艺娟,苏光伟

(1.第二炮兵工程大学402室,陕西 西安710025;2.武警福建总队厦门支队,福建 厦门361000;3.武警福建总队漳州支队,福建漳州363100;4.武警工程大学电子技术系网络与信息安全武警部队重点实验室,陕西西安710086)

1 引言

相对于单一传感器,多传感器采集的信息具有更高的冗余性、互补性、可靠性。因此,基于多传感器的图像匹配、配准、融合技术成为计算机视觉的研究热点。作为常见的传感器,可见光传感器获取的图像具有高信噪比、细节信息丰富等优点;由于红外线具有穿透能力强、辐射吸收范围大、低可视性的特点,红外传感器获取的图像具有抗干扰能力强、全天候工作的优点。因此,基于红外与可见光匹配技术具有重要意义,且被广泛应用于计算机视觉、抢险救灾、反恐安防、军事应用等领域。

近年来,大量学者致力于图像匹配技术的研究,提出了多种算法,文献[1]~[3]均对此进行了详细的分析和综述。由于成像机制不同,红外与可见光图像存在的差异主要体现在:①相同场景的红外与可见光图像灰度差异较大;②红外图像表现纹理信息较可见光图像弱;③红外图像较可见光图像具有对比度低、图像模糊的特点。因此,常见的基于特征点匹配算法,如尺度不变特征变换(scale invariant feature transform,SIFT)[4]、局部二值模式(local binary pattern,LBP)[5]、SURF(speeded-up robust features)[6]等算法在红外与可见光图像的表现也差强人意。

2007 年,Shechtman 和 Irani[7]提出了一种基于自相似性(Self-Similarities)的目标识别算法,该算法分别对模板和目标图像进行平方差之和(sum of square differences,SSD)运算,并以此构造相关表面,再采用搜索策略实现目标识别。该算法能够在背景和目标灰度出现较大差异、目标出现变形的情况下实现目标识别。该算法提出之后,很多学者对其进行研究与改进,提出一些基于Self-Similarities的目标识别算法[8-9]。

鉴于自相似性算法在背景和目标灰度与模板出现较大差异的情况下,仍然能够实现目标识别的优良特性。本文将对其进行改进,使其应用于基于特征点的红外与可见光图像匹配算法。

2 基于平方和的图像预处理

由于成像机制不同,红外与可见光图像表现形式各有特点,红外图像具有对比度低、噪声高的特点,而可见光图像具有对比度高、细节表现能力强的特点。如何有效地提高两种图像的相似度,是基于特征匹配算法的重要基础。因此,本文对图像I(x,y)中的每个像素点pp构造一个5×5子区域。

通过计算pp与子区域中各像素点灰度值的平方和(sum of square,SS)可得pp的SS值,计算方法如下:

则图像I(x,y)中各个像素点经过SS计算之后,可得最后的预处理结果SSI,如图1所示。

由图1可以看出,由于红外图像具有高噪声、低对比度的特点,因此,本文采用的5×5子区域分别对红外与可见光图像进行平方和运算,可有效抑制噪声且提高对比度;同时,本文进行的SS运算可弱化可见光图像对细小纹理的表现能力,一定程度上提高两种图像的相似度。为从两种图像中提取具有较高可重复率的特征点提供了必要的前提。

3 基于多尺度FAST-9的特征点提取

在对红外与可见光图像进行SS预处理之后,需对两种图像进行特征点提取。2006年,Rasten等[10]人提出了一种FAST-9角点检测算法,基本思想是通过对比中心点与其由16个像素点组成的Brenham圆环的灰度值,当中心点灰度值恒大于或恒小于圆环上连续的9个像素点灰度值时,该中心点即为角点。与上文提及的算法相比,FAST-9算法具有抗噪声能力强、可重复率高、检测速度快和检测数量大的优点[10]。然而,FAST-9为单尺度角点检测算法。

因此,本文利用高斯函数G(x,y,σ)对预处理后的图像SSI(x,y)进行卷积,建立高斯尺度空间,其计算如下:

其中,SSI,σ(x,y)为图像 SSI(x,y)的尺度空间;×为卷积操作;σ为尺度因子,σ的取值定义如下:

其中,o为每组的标号,o={0,1,2};S为每一组中图像的总层数;S=3,s为每一层的标号,s={1,2,3}。

由此构造了一个3组3层的高斯金字塔,并在每个高斯金字塔图层进行FAST-9角点提取,使提取的角点具有尺度属性。采用p(x,y,σp)表示角点,其中 x,y为角点坐标,σp为角点所在的尺度空间。

4 基于相关平面的特征点描述子

4.1 特征点主方向构成

经多尺度FAST-9算法提取的角点即为本文的特征点。为使所构造的描述子具有旋转不变性,需为特征点确定主方向。在 SSI,σ(x,y)尺度空间上,选取给定特征点p(x,y,σp)的半径为R=21个像素点的圆形邻域,并将该圆形邻域均分为36等份,统计36个扇形区域SS值的直方图,该直方图的峰值所在方向即为特征点的主方向。若存在大于该峰值80%的方向,则增加一个相同的特征点,将该方向定义为新增特征点的主方向,以此提高特征匹配时的鲁棒性。

4.2 基于相关平面的特征点描述

在构造特征点描述子时,为保证生成的描述子具有旋转不变性,对于任意给定特征点p(x,y,σp)选取相应的 41 ×41 矩形邻域 SSp,σ(x,y),假设特征点主方向为gL,沿gL方向顺时针旋转90°的方向为g⊥,建立新的坐标系,如图2所示。

图2 特征点主方向

在提取特征点邻域之后,需对特征点邻域进一步的处理,以构造特征点描述子。

首先,求取矩形邻域各像素点与特征点p(x,y,σp)的SS值之差,即为求取原始图像I(x,y)的平方差之和(sum of square differences,SSD),可得 SSp,σ(x,y)的平方差之和的图像 SSDp,σ(x,y)。

然后,将矩形邻域 SSDp,σ(x,y)进行归一化,通过公式(5)将其转化为相关平面(Correlation Surface)CSp,σ(x,y):

其中,var(p)是以特征点为中心,半径为1个像素点的邻域中SSD最大值。特征点邻域的相关平面如图3(b)所示。

最后,以新建立的坐标系为基础,将相关平面CSp,σ(x,y)划分为 100 个部分,其中将角度均分为20部分,距离均分为5部分,如图3(c)所示。然后选取相关平面在这每个部分的最大值作为该部分的特征值,以此构造出100维的特征点子邻域的自相似性描述子。再将描述子进行归一化得到最终描述子des(p)。

图3给出了一组红外与可见光图像特征点邻域的相关平面与自相似性描述子的对比图。从图中可以看出,虽然两种图像原图的灰度差异较大,但是经过SSD运算之后,生成的相关平面已有一定的相似性,再通过特征统计、描述子归一化处理之后,两种图像特征点邻域生成的描述子具有更高的相似度。

4.3 剔除不良描述子

通过上述相关平面理论构造的描述子,可能存在不良描述子,需对不良描述子进行剔除,以增强匹配的稳定性。本文将不良描述子定义为:不包含足够的结构和纹理信息的描述子(即在100维的描述子中多数特征值都小于某个阈值)。因此,本文采用如下公式作为不良描述子的批判标准。

其中,num(des(p,i))为每个描述子中每一维的特征值小于阈值thre1的个数;num(des(p))为描述子的维数。thre是不良描述子的批判标准,当某描述子的比值大于thre时,即为不良描述子,将该描述子剔除。

4.4 描述子匹配

在剔除不良描述子之后,将采用匹配算法对描述子进行匹配。基于点特征的图像匹配方法已经有大量的研究,本文采用最近邻算法(nearest neighbor,NN)进行配准,具体步骤为:计算描述子的欧式距离,最近邻(NN)和第二近邻(second-nearest neighbor,SCN)的距离之比(NN/SCN)作为相似性度量,设定阈值dist_rate,确定候选匹配点对。

5 实验结果与分析

为了证明本文算法的有效性,本文仿真实验的软硬件环境为CPU Dual-Core 2.5 GHz,内存2 GB,WindowsXP+SP3,Matlab 2010,仿真实验使用的图像分辨率为320×240。

5.1 实验阈值设置

在剔除不良描述子时,需对thre1和thre两个参数进行设置,通过对这两个参数数值的调整,对多组实验结果进行统计,如图4所示。从图4可以看出,thre值在[0.05,0.5]区间由小变大的过程中,无论thre1的取值如何,正确匹配率随之增长,在thre=0.3之后,正确匹配率增长幅度有所放缓。其中,当thre=0.3 时,thre1=0.07 和 thre1=0.08 时均能取得较高的正确匹配率,且thre1=0.08的正确匹配率略高于 thre1=0.07,但是从实验结果可以看出,thre1=0.08具有较高正确匹配率的效果,是以牺牲正确匹配对数为前提的,因此,为了保持较高正确匹配率,保证较多的正确匹配对数,本文采用thre=0.3,thre1=0.07 来剔除不良描述子。

图4 阈值设置

同时,通过对大量的对比实验的结果进行分析,发现将最近邻匹配算法的阈值dist_rate设置为0.65时,可得到较好的匹配效果。

5.2 实验结果分析

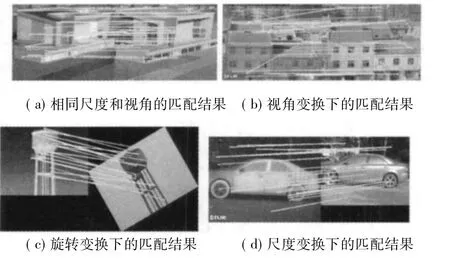

为证明本文算法的有效性,通过大量对比实验,图5给出了一组对比实验结果图。本文将误差在2个像素点以内的匹配点对认为是正确匹配点对。从图5(a)可以看出,虽然存在个别误匹配点,本文算法在相同尺度和相同视角的红外与可见光图像匹配中具有较多的匹配对数及较高的正确匹配率。由于本文在构造描述子时,将角度均分为20等份,距离均分为5等份,使得描述子提取的特征信息具有“中心密集,外围稀疏”的特点,因此,从图5(b)可以看出本文构造的描述子在视角变换下具有一定的鲁棒性。同时,本文算法计算了每个特征点的主方向,并以主方向选取特征点邻域,以此构造的描述子具有旋转不变性,图5(c)给出了本文算法在匹配图像与待匹配图像之间存在30°变换的实验结果,可以看出本文算法具有一定的旋转不变性。在图5(d)中,待匹配图像的分辨率为256×192,由于本文构造了3组3层的高斯金字塔对图像进行特征点提取,使得提取的特征点具有尺度属性,从实验结果可以看出本文算法具有一定的尺度不变性。

图5 本文算法的匹配结果

5.3 对比实验

基于特征点匹配领域,尺度不变特征变换(scale invariant feature transform,SIFT)以其优良的匹配效果,已广泛应用于各个领域。Mikolajczyk[11]对10种基于特征点匹配算法的研究分析,指出SIFT算法的性能最为优异。因此,本文通过SIFT算法对以上4组图像进行匹配运算,结果如表1所示。由于采用的特征点提取算法及描述子构造方法的不同,两种算法匹配对数有所差异,本文将误差在2个像素点以内的匹配认定为正确匹配,采用正确匹配率作为最终评价标准,由表1可以看出,本文算法与SIFT算法相比,具有较高的正确匹配率。

表1 本文算法与SIFT算法的对比实验

6 结论

针对红外与可见光图像匹配的难题,提出了一种基于自相似性的异源图像点特征匹配算法。通过构造多尺度FAST-9角点检测算法进行特征点提取;分析统计特征点邻域的特征信息确定主方向;再对特征点邻域进行相关表面计算,统计并构造自相似性描述子;最后采用最近邻匹配算法进行特征匹配。实验结果表明,本文算法可实现红外与可见光图像在视角、旋转、尺度等变换的有效匹配。与SIFT算法相比,本文算法的正确匹配率较SIFT算法有明显的提高。

[1] Elizabeth A S.Matching methods for causal inference:A review and a look forward[J].Pub Med Central,2010,25(1):1-21.

[2] Stephen JC,Richard D T,Rade D P.Dental colormatching instruments and systems.Review of clinical and research aspects[J].Journal of Dentistry,2010,38(2):2 -16.

[3] Watson B,Yeo L,Friend J.A study on axial and torsional resonant mode matching for a mechanical system with complex non-linear geometries[J].Review of Scientific Instruments,2010,81(6):1 -9.

[4] Lowe D.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91 -110.

[5] Ojala T P,Pietikainen M,Maenpaa T.Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J].IEEE Trans on Pattern Analysis and Machine Intelligence,2002,24(7):971 -987.

[6] Bay H,Tuytelaars T,Van Gool L.SURF:Speeded up robust features[C]//Proceedings of the 9thEuropean Conference on Computer Vision,Graz,Austria,ECCV,2006:404-417.

[7] E Shechtman,M Irani.Matching local self-similarities across images and videos[C]//Proceedings of the Conference on Computer Vision and Pattern Recognition,Weizmann,IEEE,2007:1 -8.

[8] Ken C,James P,Andrew Z.Efficient retrieval of deformable shape classes using local self-similarities[C]//Proceedings of the 12thInternational Conference on Computer Vision Workshops,Oxford,IEEE,2009:264 -271.

[9] Selen A,et al.Wave interference for pattern description[J].Lecture Notes in Computer Science,2011,6493:41-54.

[10] Rosten E,Drummond T.Machine learning for high-speed corner detection[J].Proceedings of the European Conference on Computer Vision,2006:430 -443.

[11] Mikolajczyk K,Schmid C.A performance evaluation of local descriptors[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(10):1615 -1630.