空间遥操作技术地面验证平台

王雪竹,李洪谊 ,王越超 ,阳方平 ,陈 鹏,余 飞,李贵祥

(1中国科学院沈阳自动化研究所机器人学国家重点实验室,沈阳110016;2中国科学院研究生院,北京100101)

1 引言

随着科技的不断进步,太空探测活动越来越频繁,任务越来越复杂。受限于恶劣的太空环境,很多空间任务不能由航天员直接完成。空间遥操作能够代替航天员为空间站等太空设备提供维修、更换部件等服务,以及进行科学实验,在空间探索方面具有巨大的应用前景。

上世纪90年代以来,美国、日本、加拿大和欧洲纷纷展开空间机器人的遥操作技术研究。1993年德国DLR实验室的空间机器人技术试验系统ROTEX搭载“哥伦比亚”号航天飞机进入太空,操作者在视觉反馈和地面预测仿真辅助下使用6自由度控制球对具有多传感器的空间机器人进行遥操作,系统分别在航天员遥操作模式和地面遥操作模式下完成插拔轨道可更换单元(ORU)、捕获自由漂浮物等任务[1]。1997年日本NASDA发射装载空间机器人的ETS-VII实验卫星,进行了一系列遥操作试验,文献[2]构建一个稳定的双边控制器,试验验证了7s通信时延下使用直接双边控制完成遥操作任务的可行性,以及力反馈对遥操作的重要性。文献[3]为解决通信时延,提出一种基于模型的混合力和运动命令的遥操作系统,该系统对建模误差具有鲁棒性,并使用视觉反馈和虚拟预测显示辅助操作者。2005年德国在国际空间站上安装了ROKVISS空间机器人技术试验系统,在不同控制模式进行遥操作试验,旨在验证模块化机器人以及遥现技术在太空维护和修理中的可行性[4]。

我国不少著名院校和科研院所于上世纪90年代开始先后开展了遥操作机器人技术的研究,一些研究机构计划于1996年开始将遥操作技术列为关键技术加以研究。在目前没有真实空间遥操作系统的情况下,各科研单位均采取搭建地面验证平台的方法对遥操作技术方案进行探索和验证[5]。

空间遥操作面临的最大问题是星地链路间的大通信时延带来的系统稳定性、透明度变差。目前小时延条件下遥操作系统的稳定性和透明度易达到良好效果,但抖动大时延条件下仍有待进一步的研究。针对特定遥操作任务的特殊性能要求如何实现也很值得探索。本文搭建空间遥操作技术地面验证平台,设计双边PD控制算法以保证系统稳定性,采用3D虚拟现实技术,综合视觉反馈、力反馈方法提高系统透明度,在抖动大时延条件下为空间遥操作提供一套可行的技术方案。

图1 遥操作系统平台示意图

2 系统结构

搭建的空间遥操作技术地面验证平台如图1所示,图中左边是主端,即地面控制中心,由上位机、力反馈手柄、控制面板、虚拟现实界面和图像显示界面组成。右边是从端,即空间实验中心,由上位机、机器人及其控制器、目标任务板、六维力传感器和相机组成。主从端之间通过网络进行通信。

2.1 从端(空间试验中心)

2.1.1机器人分系统

使用ABB公司生产IRB120机器人作为从手。IRB120是六轴工业机器人,其工作范围为580mm,各项性能指标满足试验系统要求。配套的IRC5控制器用于给机器人供电并直接控制机器人各关节电机,该控制器连接一个示教器作为人机交互界面,可以用来手动或编程操作机器人。

系统使用从端上位机控制机器人分系统。上位机和控制器之间可以通过串行通道和以太网进行通信,为了便于系统扩展,采用以太网进行连接。ABB公司提供了软件开发包PC SDK,用于在上位机中开发适合自己需求的控制器接口。借助该软件开发包可实现以下功能:搜索网络,查找所在局域网内的所有机器人控制器;读写控制器内部程序的变量;读取机器人机械单元状态,包括机器人末端位置姿态、各关节转角等;读写机器人IO单元状态;开始、停止控制器内部程序模块;创建、保存、载入、重命名和删除控制器内部文件;发送、接收控制器信息;等等。

在机器人末端安装一个气动手爪作为夹持器,将手爪的信号线连接至控制器内的IO模块,即可通过控制IO模块的输出来控制手爪的开合。

2.1.2任务板

机器人作业可分为自由运动(无约束运动)和接触作业,接触作业可分解为抓取、插孔、施加压力、表面滑动等基本动作。为测试遥操作系统的操作性能,设计试验用的目标任务板。任务板包含三个任务模块:插孔任务模块,滑槽任务模块和斜坡跟踪任务模块,可基本满足各种试验需求。

2.1.3力觉测量分系统

采集机器人作业时的力觉信息并传送给主端操作者,可以获得更好的操作性能,尤其是在接触作业中。使用ATI公司生产的六维力传感器来测量机器人和环境的接触力。六维传感器可以采集三个方向的力和力矩信息。

力传感器系统由传感部件、接口电源盒和PCI卡构成。其中,传感部件将力和力矩信息转换为应变模拟信号,PCI卡将模拟信号转换为数字信号提供给上位机,接口电源盒为二者提供电源和通信连接。

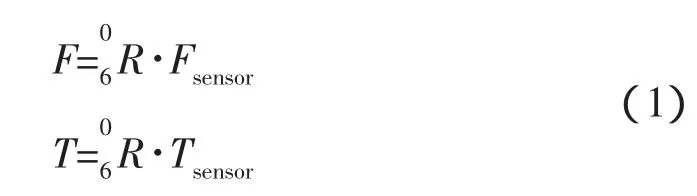

由于六维力传感器安装在机器人末端(第6轴)上,因而测得的力和力矩信息是在机器人末端坐标系下的数据。而在实际应用中,使用手柄控制机器人末端的位置和姿态角,其中位置是相对于机器人基坐标系的数据,姿态角是相对于末端基准坐标系的数据(末端基准坐标系以机器人末端位置为原点,平行于机器人基坐标系),因此需要将末端坐标系下的力和力矩信息变换至末端基准坐标系再反馈给操作者。运用机器人运动学分析计算得到机器人末端坐标系相对于基坐标系的旋转矩阵,即为末端坐标系相对于末端基准坐标系的旋转矩阵。于是得到力和力矩计算公式:

式中,F和T为末端基准坐标系下的力和力矩,Fsensor和Tsensor为传感器测得的力和力矩。

2.1.4视觉测量分系统

在机器人周围安装环境相机,采集现场图像并通过网络发往主端,给操作者提供视觉信息。

在机器人末端安装手眼相机,相机朝向与末端工具指向保持一致。在任务板旁边固定有标志器,用于配合手眼相机定位。当标志器在手眼相机视野内时,可通过图像处理将标志器信息提取出来,计算得到手眼相机当前的位姿数据,包括相对位置和相对姿态。相对位置为标志器坐标系原点在相机测量坐标系中的三维坐标,用(x,y,z)表示,相对姿态为标志器坐标系相对于相机测量坐标系的欧拉角(按ZY-X 顺序变换),用(α,β,γ)表示,则标志器坐标系相对于相机测量坐标系的变换矩阵为:

式中,s是sin的简写,c是cos的简写。

利用该手眼相机的图像信息和位姿数据,可以在主端辅助人的操作,在从端用来实时得到任务目标相对于机器人末端的位姿,引导机器人自主完成任务。

2.2 主端(地面控制中心)

2.2.1操作台

操作台由两个作为系统主手的操作手柄和一个控制面板组成。

操作手柄用于读取人手(手柄)位置信息来控制机器人运动。将机器人和环境的接触力通过手柄传递给操作者能够提高遥操作系统的透明度,因此使用带力反馈的手柄Falcon和Omega3。从端机器人具有六个自由度,而Falcon和Omega3均为三自由度力反馈手柄,因此将机器人末端的位置姿态进行分解,位置用(x,y,z)表示,姿态用欧拉角(α,β,γ)表示,然后用两个手柄分别控制位置和姿态,从而控制六自由度机器人运动。手柄和主端上位机之间通过USB口连接,调用相应SDK进行编程即可读取人手位置和生成反馈力。

控制面板上有若干按键开关,用于设置主端和从端的位置、姿态角的比例,控制自动/手动切换等。控制面板内部的单片机不断扫描面板上各开关的状态,并以一定频率发送给上位机,由上位机进行处理。

2.2.2视觉显示分系统

视觉显示分系统包括视频图像显示界面和虚拟现实界面。

视频图像显示界面在主端屏幕上显示从端相机拍摄的图像信息,给操作者视觉反馈。系统中模拟了空间遥操作主从端通信的时延,设主端至从端时延为T1,从端至主端时延为T2,则主端得到的图像和数据是从端对主端(T1+T2)时间之前指令的响应。通信时延使得从端的运动状况不能及时反馈到主端,给操作者带来直觉错误和操作错觉,因此仅靠视频图像反馈难以达到良好的操作性能,需要虚拟现实作为补充。

虚拟现实技术基于从端环境模型和机器人模型,根据主端的当前操作预测并显示从端未来的运动状况,给出从端机器人的伪实时响应,能够显著提高系统的透明度。然而普通的虚拟现实技术提供2D图像,操作者难以精确判定物体的深度,同时观看多个角度2D图像对操作者负担较大。而3D显示技术可以提供具有景深的图像,提高观察准确度[6],因此使用3D显示技术进行虚拟现实显示。

采用偏振三维技术搭建3D投影,将虚拟现实技术生成的3D图像信号同时输出到两台性能参数完全相同的投影机中,通过装在投影机镜头前方的偏振镜片进行水平和垂直方向上的滤光,实现图像分离,再通过偏光眼镜从左右眼分别观看水平和垂直方向上的影像,在人眼中形成影像叠加,通过双眼的会聚功能实现3D视觉效果。

3 软件设计

3.1 主从端程序架构

在搭建系统平台的基础上编写相关控制程序,如图2所示。主端控制程序在主端上位机上运行,其任务是接收手柄和控制面板的输入,经遥操作算法处理后发给从端和虚拟现实分系统,并将从端反馈的力信息经算法处理后发给手柄。从端控制程序在从端上位机上运行,其任务是接收主端通过网络发送的操作指令,经遥操作算法处理后发给机器人控制器,并将从端的力信息和机器人状态信息反馈给主端;当收到主端自动运行命令时,则接收手眼相机传来的位姿信息,依此信息指示机器人运动。在主从端的网络通信中,使用缓冲区延迟数据发送,人为模拟抖动大时延。

图2 控制程序框图

3.2 遥操作算法

为了克服主从端之间通信时延对操作性能的影响,采用双边控制,即主端将操作者的运动指令发给从端,控制从手运动,同时从端将从手与环境的作用力反馈给主端,给操作者临场感。研究证明双边控制系统能够比非双边控制系统更快更好地完成遥操作任务[2]。但在该系统中,主从端位于一个闭环回路,二者之间的通信时延会严重影响系统稳定性和透明度。因此采用双边PD控制算法,在双边控制系统的主端和从端各加入一个比例微分(PD)控制器,使用双端口网络的绝对稳定性判据选择控制器参数以保证系统稳定性。

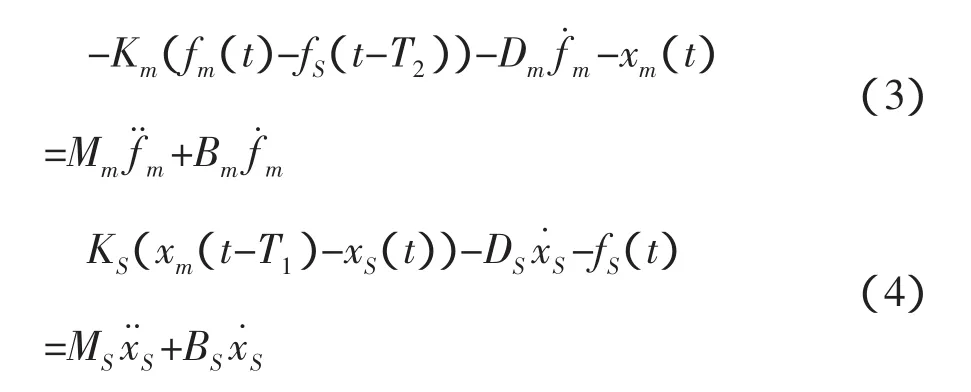

据此设计通信时延环节的模型如下:

式中,x和xS分别为主、从端的位置,fm是手柄反馈给操作者的力,fS是从手和环境之间的作用力,Km和KS分别为主、从端的位置增益,Dm和DS分别为主、从端的阻尼增益,T1和T2是通信时延,Mm和MS分别为主、从端的广义质量系数,Bm和BS分别为主、从端的广义阻尼系数。

由式(3)和式(4)可以得到双端口网络模型如下:

式中,Vm和VS分别为主、从端的速度,

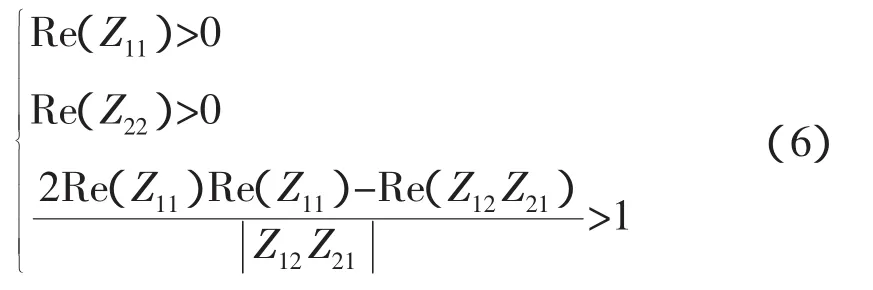

式(5)所示的双端口网络系统的稳定性可由绝对稳定性条件(如式(6)所示)判断。因此,选取适当的参数使其满足式(6)即可保证遥操作系统的稳定性。

4 试验

4.1 仿真试验

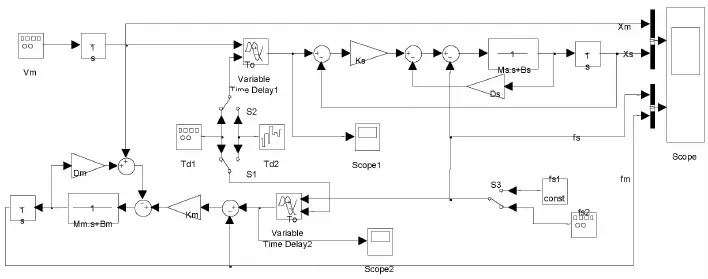

选择适当参数构建如式(3)和式(4)所示的双边PD控制系统,使满足式(6)绝对稳定性条件,其中T1和T2均为1.5s~3s的变时延。构建仿真试验结构框图如图3所示。

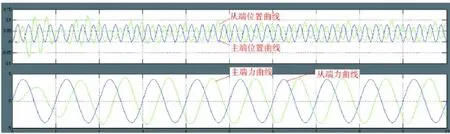

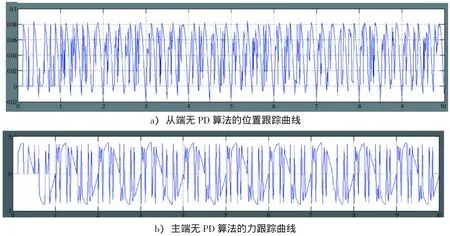

双边PD控制系统下的主从端位置、力仿真曲线如图4所示,图中蓝色曲线为期望曲线,绿色曲线为跟踪曲线。主从端不加PD算法时的位置、力仿真曲线如图5所示。由此可以得到如下结论:

1)该算法能保证时延系统的稳定性,并且对于大时延及抖动的情况下,系统也能稳定。

2)在抖动时延的条件下,如果主、从端不加算法,力和位置信号很杂乱,存在严重的抖动,可操作性差。添加算法之后,跟踪效果得到显著改善,说明算法的有效性。

4.2 系统试验

按照图3所示方案进行系统试验,系统回路时延为3s~5s变时延。x、y、z三个方向的主从端的位置曲线、力曲线分别如图6、图7所示。可以看出系统是稳定的,位置和力都能较好的跟随。图中主从端曲线形状并未完全重合是因为实际试验中主从端的速度和力并不是按照1∶1进行跟随,而是通过控制面板按键调节主从端速度和力的比例关系,以适应作业任务需求。大比例便于机器人在较大空间内自由活动,小比例便于在接触作业时精确控制机器人运动。

使用该验证平台顺利完成了滑槽、斜坡、插孔等试验任务,试验照片如图8所示。在虚拟现实图像和视频图像的辅助下,操作者通常可在接触孔附近平面后10s内完成插孔任务,插孔圆棒和孔的配合间隙为0.5mm。完成各项任务时最大接触力小于80N,机器人末端在接触面上缓慢滑动时不会被弹开,操作手感良好。

图3 双边PD算法仿真框图

图4 双边PD算法下主从端位置、力曲线

图5 无双边PD算法下主从端位置、力曲线

图6 主从端位置曲线

图7 主从端力曲线

图8 试验照片

5 结论

本文针对地空大通信时延下的空间遥操作问题,搭建一个带有视觉反馈、力反馈和3D虚拟现实显示的空间遥操作技术地面验证平台,为遥操作算法提供测试平台。在该平台基础上,设计双边PD控制算法,实现抖动大时延下系统的稳定。经仿真和系统试验验证,该系统可提供良好的控制性能,操作者在3s~5s变时延条件下顺利完成自由运动、插孔、斜坡跟踪和槽内滑动等遥操作任务,验证了空间遥操作技术方案的可行性。

[1]Hirzinger,G.,et al.Sensor-Based Space Robotics-Rotex and Its Telerobotic Features [J].Ieee Transactionson Roboticsand Automation,1993,9(5):649-663.

[2]Imaida,T.,et al.Ground-space bilateral teleoperation of ETS-VII robot arm by direct bilateral coupling under 7-s time delay condition[J].Ieee Transactions on Robotics and Automation,2004,20(3):499-511.

[3]Yoon,W.K.,et al.Model-based space robot teleoperation of ETSVII manipulator[J].Ieee Transactions on Robotics and Automation,2004,20(3):602-612.

[4]Preusche, C.,et al.Robotics component verification on ISS ROKVISS-Preliminary results for telepresence[J].2006 IEEE/RSJ International Conference on Intelligent Robots and Systems,Vols 1-12,2006:4595-4601.

[5]李滋堤,等.基于人工势场的空间遥操作共享控制[J].清华大学学报(自然科学版),2010,(10):1728-1732+1737.

[6]Fung,W.K.,et al.A case study of 3D stereoscopic vs.2D monoscopic tele-reality in real-time dexterous teleoperation[J].2005 IEEE/RSJ International Conference on Intelligent Robots and Systems,Vols 1-4,2005:2175-2180.