融合颜色和梯度方向直方图的粒子滤波跟踪算法

毛晓波,朱东伟,陈铁军

(郑州大学电气工程学院,河南郑州450001)

0 引言

视频目标跟踪是计算机视觉领域的一个备受关注的前沿问题,在安全监控、军事侦察、精确制导、机器人导航等领域有着广泛的应用.视频目标跟踪是在连续的图像序列中精确地定位目标的位置、速度、姿态等状态[1].目标跟踪的困难主要集中在目标颜色和形状的变化、目标所在环境光线的变化、目标被遮挡及运动无规律等方面.设计一个快速鲁棒的目标跟踪算法依然具有挑战性.目前的目标跟踪算法大体上分为两类:确定性跟踪方法和概率性跟踪方法.确定性的跟踪方法是通过寻找目标的最优匹配来实现跟踪,如均值漂移算法[2](Mean Shift,MS);概率性跟踪方法是将目标转换为贝叶斯滤波框架下预测目标状态的迭代过程,如卡尔曼滤波[3](Kalman Filter,KF)、粒子滤波[4](Particle Filter,PF)等.

1 粒子滤波

粒子滤波是一种基于递推贝叶斯理论和蒙特卡罗模拟的滤波方法.它的基本思想是用一些带权值的随机采样点(粒子)来表示系统状态的后验概率密度函数,以样本均值代替积分运算,从而获得状态最小方差估计的过程.当样本数目足够多时,这种估计等同于后验概率密度.

贝叶斯递推处理过程分为预测和更新2个阶段.预测阶段是利用系统模型预测状态的先验概率密度;更新阶段是用最新的观察数据进行修正,得到后验概率密度[7].Bayes 公式为

式中:p( xk|xk-1)由运动模型定义;p( yk|xk)由观察模型定义.

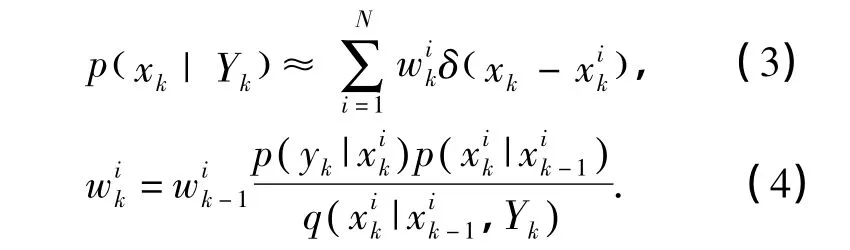

递推迭代关系式(1)和(2)构成了最优贝叶斯估计的解.由于式(1)中积分运算很难实现,不可能进行精确分析,所以利用蒙特卡罗仿真来模拟递推贝叶斯估计.同时考虑到直接从后验概率抽样的困难,粒子滤波算法从一个比较容易采样的重要性分布函数 q( xk|xk-1,Yk)中抽取N个样本,通过式(1)和式(2)对粒子进行位置和权值更新,得到k时刻状态的后验概率密度和权值更新公式[8-10]:

对于重要性函数的选择,将重要性函数选为状态转移模型[11],即 q(xk|xk-1,Yk)=p(xk|xk-1).则粒子权值更新公式变为:

2 目标特征的提取

视频跟踪的目标特征主要包括:颜色特征、轮廓特征、纹理特征、梯度方向特征等.笔者将颜色特征和梯度方向特征进行融合生成综合直方图特征.

2.1 颜色直方图特征

颜色直方图特征在平面旋转和部分遮挡的情况下变化不大,很适合描述目标,是一个被广泛采用的特征.为了减少跟踪过程中光照变化的影响,笔者采用HSV颜色模型.HSV颜色模型的3个分量相互独立:H和S分量分别表示色调和饱和度,对光照不敏感;而V分量表示亮度分量,对光照非常敏感,所以只对H和S分量根据量化级数加以量化建立直方图.为了增加颜色直方图描述的鲁棒性,加入表示空间信息的核函数计算加权直方图:使位于目标中央的区域有较高的权值;而边缘区域有可能包含背景,贡献小故分配较小的权值.对H和S分量的每个通道分配量化级为8,那么颜色直方图的量化级数为m=8×8.假设目标状态以 X=(x,y)为中心,h=(hx,hy)为半径,目标区域内像素的位置为Xi=(xi,yi),则目标区域内的归一化颜色直方图[12]为

层次加权分析法缺点有,评价的主观臆断性及其过程的随机性,从而使得结果的可信度降低。此外,当判断因素较多时,常常会因为层次分解和赋值的不一致而出现判断矩阵不一致的现象。

式中:δ是Delta函数;函数b(Xi)是位于Xi处的像素在直方图上颜色等级索引的映像;u为直方图中颜色等级索引;k(·)为权值核函数;n为目标区域内像素总数.

2.2 梯度方向直方图特征

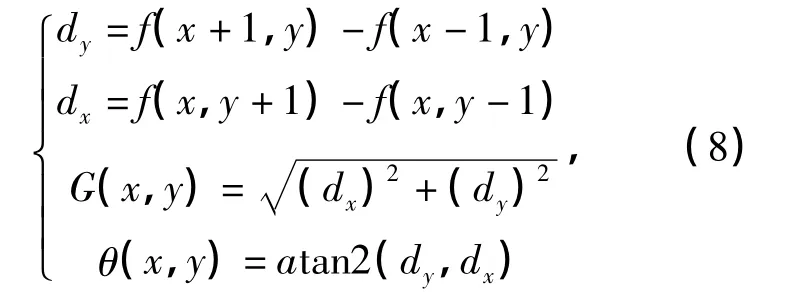

笔者根据HSV颜色模型中的亮度分量V对目标区域建立一个简化了的梯度方向直方图,来描述该区域的空间位置信息.建立梯度方向直方图,首先计算区域内所有像素点f(x,y)的垂直方向和水平方向相邻点的差,然后计算各个像素点的梯度 G(x,y)和方向 θ(x,y),如图 1 所示.计算公式为[13]:

图1 梯度方向向量Fig.1 Gradient direction vector

式中:θ(x,y)的范围为[-π,π],最后统计各个方向上的梯度幅值,形成梯度方向直方图.笔者将[-π,π]量化为8级,即每0.25π 一个间隔.则目标区域内归一化的梯度方向直方图为

2.3 综合直方图特征

融合了m位颜色直方图和n位梯度方向直方图的m×n位归一化的综合直方图定义为

通过式(10)得到的综合直方图不仅包含了目标的颜色特征,还融合了目标的结构信息,能够更加准确地对目标进行描述.

2.4 相似性度量

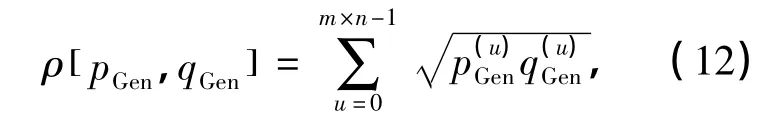

当计算出目标区域和目标候选区域的综合直方图分布时,采用Bhattacharyya距离[14]来衡量两个分布的相似程度.假设目标模板的m×n位综合直方图分布为候选目标的综合直方图分布为 pGen=则两者之间的相似程度可以表示为

式中:ρ[ pGen,qGen]即为Bhattacharyya系数

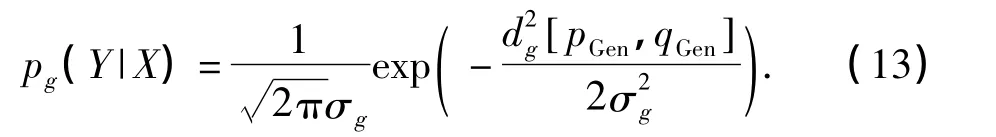

得到两种分布之间的Bhattacharyya距离后,设计如下的观察似然函数:

3 基于综合直方图的粒子滤波

3.1 状态转移概率模型

在视频跟踪中,用状态转移概率模型来描述相邻两帧图像上目标的运动.一个合适的模型可以精确地描述目标的运动状态,提高跟踪的可靠性.笔者采用常速模型来描述其运动规律,并用一矩形来表示目标的轮廓.目标状态表示为X=和hy为目标矩形的长和宽,状态转移概率模型为

式中:Wt是系统噪声,是跟踪过程中的不确定因素,用来描述状态转移模型与目标运动真实模型之间的差异.

3.2 综合直方图粒子滤波跟踪算法

初始化:在初始帧,通过手动选择感兴趣区域,并计算该区域的综合直方图特征,完成目标模板的初始化.通过加高斯噪声的方式产生N个粒子各个粒子的初始权重均为

重要性采样:读入下一帧的图像,将上一时刻的粒子状态通过式(14)进行传递,得到新的粒子.

权值更新:分别通过式(6)和式(9)计算每个粒子的颜色直方图和梯度方向直方图,并通过式(10)计算出每个粒子的综合直方图,然后通过式(13)计算每个粒子状态对应的观察似然函数值(Y|X),最后通过式(5)计算每一个粒子的权值并归一化权值

若序列未结束,转重要性采样,否则,结束.

4 实验结果及分析

为了验证该算法的有效性,利用多组视频进行了测试.利用H通道和S通道建立颜色直方图,且每个通道均量化为16个灰度级.梯度方向直方图量化为8级.与笔者算法进行对比的基于颜色的粒子滤波目标跟踪,颜色直方图采用RGB颜色模型,且每个通道量化为16级.实验图像大小为320×240,粒子数目为100,σ2g=0.01.在实验中,电脑配置为 Pentium(R)4 CPU,1G内存,Windows XP操作系统,算法通过VC++6.0开发平台和开源的计算机视觉库OpenCV编写实现.

图2为室内环境下两种跟踪算法对人体目标跟踪的对比情况,选取了第137帧,第150帧,第158帧,第162帧图片.通过对比发现,基于传统颜色的粒子滤波算法,由于没有考虑目标颜色与背景相似的情况,导致跟踪的效果不理想,目标从第150帧已经出现了偏移,到第158帧时偏移在继续增大,到第162帧时矩形框与目标已经完全分离,跟踪失败.笔者算法在使用颜色信息的同时,将具备一定目标结构信息的梯度方向直方图特征也加以提取,从而在受到相似背景颜色的影响时,可以通过梯度直方图特征对目标进行准确跟踪.

图3为高速公路上对汽车的跟踪,选取了第330帧,第343帧,第349帧和第354帧图片.在跟踪过程中会受到其他车辆的影响,并且目标颜色与路面颜色相似,在利用颜色跟踪的同时,利用梯度方向信息区别目标与背景之间的结构差异,跟踪不会出现较大偏移,能够较准确地跟踪到目标.而传统的跟踪算法在跟踪过程中由于受到背景的干扰,容易造成比较大的偏差,显然在跟踪精度上笔者算法优于传统的粒子滤波算法.

图4给出了笔者算法和文献[7]算法的跟踪结果对比.该序列中包含了遮挡、相似颜色的背景干扰,选择了第845帧,第855帧,第858帧和第859帧图片.从图中可以看出,由于笔者算法使用的综合直方图特征能够更加准确地表征目标,所以在目标处于部分遮挡并且相似背景的情况下,可以较准确地跟踪目标;当遮挡结束后能够恢复准确跟踪,具有较强的鲁棒性.文献[7]只是将两种特征简单的加权相加,在一定程度上并不能准确表征目标,因此跟踪的效果不理想.

5 结论

笔者提出了一种基于综合直方图的粒子滤波视频目标跟踪算法,融合颜色直方图和梯度方向直方图,形成综合的直方图特征,增强了对目标的空间结构信息描述.使得似然函数对目标的描述更加充分.实验结果表明,该算法优于基于颜色的粒子滤波算法,能够在复杂背景或者严重遮挡的情况下对目标进行准确跟踪,具有较强的鲁棒性.

[1]王欢,王江涛,任明武,等.一种鲁棒的多特征融合目标跟踪新算法[J].中国图象图形学报.2009,14(3):489-495.

[2]KATJA N,ESTHER K M,LUC V G.An adaptive color-based filter[J].Image Vision Computing,2003,21(1):99-110.

[3]WENG S K,KUO CM,TU S K.Video object tracking using adaptive Kalman filter[J].Journal of Visual Communication and Image Representation,2006,17(6):1190-1208.

[4]GORDON N J,SALMOND D J,SMITHA F M.Novel approach to nonlinear/non-Gaussian Bayesian estimation [J].IEE Proc.Radar and Signal Processing,1993,140(2):107-113.

[5]曾伟,朱桂斌,陈杰,等.多特征融合的鲁棒粒子滤波跟踪算法[J].计算机应用.2010,30(3):644-645.

[6]DALAL N,TRIGGS B.Histograms of oriented gradients for human detection[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition.San Diego:IEEE Computer Society Press,2005:886-893.

[7]陈善静,杨华,曾凯,等.基于多特征融合的粒子滤波算法研究[J].计算机工程.2011,7(4):178-180.

[8]沈玉娟,王健.基于粒子滤波跟踪方法研究[J].仪表技术,2010(3):55-57.

[9]杨小军,潘泉,王睿,等.粒子滤波进展与展望.控制理论与应用[J].2006,23(2):261-265.

[10]张诗桂,朱立新,赵义正.粒子滤波算法研究现状与发展趋势[J].电子信息对抗技术.2010,25(5):8-15.

[11]胡仕强,敬忠良.粒子滤波原理及其应用[M].北京:科学出版社.2010.

[12]NUMMIARO K,VAN G L.An adaptive color-based particle filter[J].Image and Viaion Computing,2003,21(1):99-110.

[13]LOWE D.Distinctive image features from scale-invariant keypoints[J].Journal of Computer Vision,2004,60(2):91-110.

[14]THACKER N,AHERNA F,ROCKETT P.The bhattacharyya metric an absolute similarity measure for frequency coded data[J].Kybernetika,1997,34(4):363-368.