实时红外目标跟踪方法

孙 宁, 王寿峰, 白俊奇, 赵春光

(中国电子科技集团公司第28研究所,南京 210007)

0 引言

红外目标跟踪是红外探测系统实时、持续、精确提供目标方位、俯仰以及图像相关信息的前提条件。由于红外图像具有高帧频的优点,相邻两帧中的目标在形态、位置、灰度等特征上差异较小,根据已知目标信息,利用图像特征相关匹配技术可以在当前图像内对目标进行定位,形成对目标的连续跟踪。

在可见光波段,图像目标匹配跟踪的算法已经发展得相当成熟,有许多典型算法,例如灰度相关匹配算法[1-3],主要思想就是在当前帧中寻找与上一帧中目标区域灰度相关性最大的区域;基于Mean-Shift(均值漂移)[4-5]的目标跟踪算法,其利用图像的颜色信息构建直方图作为目标模板描述,选择合适的核函数以及相似性度量函数使得目标周围邻域内相似性度量曲面为平滑的凸曲面,然后用Mean-Shift算法快速找到极值点来确定目标在当前帧中的位置。其他的还有主动轮廓线跟踪[6]、光流法跟踪[7]等。

红外探测系统接收外界的红外辐射,通过光电转换形成红外图像。与电视摄像机获取的可见光图像相比,红外图像只有强度信息没有彩色信息,红外图像中目标的边缘和细节比较模糊等。因此,目前电视视频跟踪中的很多成熟、优良的算法都很难直接应用到红外图像目标跟踪上去,需要针对红外图像跟踪的特点进行改进。本文针对红外图像的特点,基于特征匹配跟踪的思想,采用局部二元模式(Local Binary Pattern,LBP)[8]算子提取图像的灰度纹理特征作为图像模板匹配的依据。

本文算法中首先对红外图像进行增强处理,锐化图像的边缘和细节。采用LBP算子提取图像的多尺度LBP编码直方图作为图像特征向量,根据卡方统计方法度量模板图像和样本图像的相似度,逐像素取样本图像扫描整个波门区域,与模板图像相似度最高的样本图像为图像匹配结果。为了适应跟踪过程中目标发生尺度形变,本文算法设计了3种尺寸的模板,并根据图像特征匹配后求得的目标大小选取相应尺寸的模板。将每帧图像特征匹配得出的位置信息输入Kalman滤波器进行跟踪状态的估计和维持,结合图像特征匹配的相似度信息对模板图像进行更新,并对下一帧跟踪波门的中心位置进行预测,以适应目标位置快速变化、局部遮挡和短暂消失等情况。

1 基于LBP算子的图像特征匹配

1.1 局部二元模式算子

局部二元模式(Local Binary Pattern,LBP)算子是一种有效的局部纹理描述算子,由Ojala最早提出,它可以对灰度图像中局部邻域的纹理信息进行度量和提取。近10年来,LBP算子已经广泛地应用于纹理分类[9]、图像检索[10]、人脸图像分析[11]等领域。基本的LBP算子是一个固定大小为3×3的矩形块,共对应于9个灰度值。将一阶邻域和二阶领域的8个灰度值与中心灰度值相比较,大于等于中心灰度值的子块由1表示,反之则由0表示,根据顺时针方向读出的8个二进制值作为该3×3方块的LBP编码值,如图1所示。

图1 LBP算子编码示意图Fig.1 The LBP operator

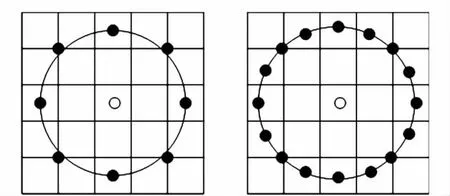

为了改善最初的LBP算子存在的无法提取大尺度结构的纹理特征的局限,使用不同数量的邻近子块以及不同尺寸的矩形块为LBP算子的一种主要扩展[9]。图2所示是两个扩展的LBP算子的例子。

图2 尺度为(8,2)和(16,2)的扩展LBP算子Fig.2 Extended LBP:the circular(8,2)and(16,2)neighborhood

其中,(P,R)表示在半径为R的圆周上存在P个抽样点。不同大小的窗口、不同个数的点数提取不同特征描述的局部纹理的能力也不一样,描述局部纹理的内容也不一样。

另一种对LBP算子的扩展称为“均匀模式(Uniform Pattern)”。这个时候每个窗口的LBP的数值不是绝对的二进制码的最终结果,而是计算每个窗口中二进制码中码元的变化情况,不同的变化情况代表了不同的局部特征。数学描述为

其中

式中,上标riu2是一个采用“均匀模式”的标记。Timo Ahonen[12]经过研究表明,均匀模式可以有效地描述出图像中大部分的纹理特征,并大大减小特征的数量。

使用LBP算子提取图像特征,一般是取一定大小的子块,统计每个子块的LBP编码得到LBP直方图,最终用来匹配的特征就是整幅图在一定大小子块划分条件下的联合直方图,如图3所示。

图3 图像的LBP直方图表示Fig.3 The LBP histogram of image

1.2 图像特征提取

由于跟踪时目标大小多样,距离远近不同。为了应对图像中目标的尺度变化,综合考虑计算复杂度和适应性,算法设计了3种尺度的特征提取窗及相应的窗口子块划分方法。以成像分辨率为320×240的红外图像为例,3种特征提取窗的尺度分别为64×64、35×35和16×16。3种特征提取窗的子块划分具体如下所述。

1)64×64的特征提取窗(记为A),如图4a所示。划分为17个子块,16个16×16的子块(记为,i=1,…,16)和1个32×32的子块(为中心阴影部分,记为A32)。中采用(表示采用半径为1,采样点为8的均匀模式LBP算子,该模式下,可用10个特征值就能表征绝大部分的灰度纹理特征),算子进行灰度纹理特征提取;A32中采用L(表示采用半径为 2,采样点为16的均匀模式LBP算子,该模式下,可用18个特征值就能表征绝大部分的灰度纹理特征)。两种算子,所得的联合直方图为17×10+18=188维的图像特征向量。

2)32×32的特征提取窗(记为B),如图4b所示。划分为10个子块,9个15×15的子块(记为B15i,i=1,…,9)和1个30×30的子块(为中心阴影部分,记为B30)。中采用算子进行灰度纹理特征提取,B30中采用两种算子,所得的联合直方图为10×10+18=118维的图像特征向量。

3)16×16的特征提取窗(记为C),如图4c所示。划分为5个子块,5个8×8的子块(记为,i=1,…,5),采用算子进行灰度纹理特征提取,所得的联合直方图为5×10=50维的图像特征向量。

图4 3种尺度的特征提取窗Fig.4 Windows of different scale for feature extraction

以上3种划分方法在提取目标灰度纹理特征的同时,保留了这种特征的空间相关性。同时,通过对子块赋予不同权值的方式,体现不同位置子块对于目标特征体现的重要性,例如中心阴影子块的权值就要大于周边子块的权值。

1.3 图像特征匹配

进行图像特征提取时,将特征提取窗逐像素扫描整个波门区域,每个像素对应一幅样本图像及一个图像特征向量,与模板图像的特征向量进行相似性度量,最相似者所在位置为图像匹配结果。此处,相似度度量方法采用加权卡方距离,表达式为

式中:S,M分别表示两个LBP直方图;ωj为子窗口j对应的权重。

2 运动状态滤波及模板更新

2.1 Kalman 滤波

如果目标出现遮挡、短暂消失及快速机动时,1小节所述的基于灰度纹理特征的图像特征匹配方法可能失效。由于目标运动的连续性和规律性,本文算法中采用Kalman滤波对目标的运动参数进行维护和估计,对下一帧目标的位置K(x,y)进行预测,与图像特征匹配相结合,提高跟踪的有效性和稳定性。Kalman滤波作为一种成熟的运动状态估计工具,已被广泛地应用于各种目标跟踪领域,原理详见文献[13]。

2.2 模板更新

在目标跟踪的整个过程中,目标的模板图像必须根据目标的尺寸变化、图像特征匹配的相似性及目标的运动状态等因素进行更新。

目标尺寸的计算:在第一帧人工指定目标时,使用区域生长法[14]分割目标,求得目标尺寸和质心位置,以此确定对应的模板图像和特征提取窗;跟踪过程中的每帧以图像特征匹配位置M(x,y)为种子点,利用区域生长法计算目标尺寸P(l,w)和目标质心位置G(x,y)。

在已知 M(x,y)、K(x,y)、G(x,y)、P(l,w)和等参数及预设图像特征匹配相似度高低两个阈值的情况下,本文算法模板更新策略如下所述。

3 算法的硬件实现

本文算法主要可以分为图像增强、图像特征提取、Kalman滤波及模板更新几个步骤。其中,主要的计算量集中在第2小节所述的基于LBP算子的图像特征匹配中。以320×240的图像为例,波门大小为160×120,若以A窗逐像素扫描整个波门区域,则需要进行17×97×57=93993次算子和 97 × 57=5529 次算子的特征提取,计算量巨大。然而,由2.1小节可以看出,基于LBP算子的特征提取运算规则简单,并且特征提取窗的划分固定,不存在先后次序,适合并行处理。

由上分析,将图像信号接入、图像增强和图像特征提取放在FPGA器件中处理,余下的Kalman滤波、区域生长和模板更新等步骤以及通讯功能则由DSP来完成。根据上述需求设计了以DSP+FPGA为核心处理器的图像处理板,板卡上的主要芯片有AD公司的TigerSharc TS101 DSP和Altra公司的EP2S60 FPGA,其结构如图5所示。

图5 图像处理板硬件结构Fig.5 The hardware architecture of image processing board

由于FPGA器件完成图像增强和图像特征提取的计算时延为纳秒级的门延迟,Kalman滤波、区域生长和模板更新等步骤在DSP中的计算时间远小于20 ms。因此,工程化实现后的本文算法可以满足使用凝视型红外热像仪进行目标跟踪时50 Hz帧频的处理需求。

4 实验结果及分析

实验采用两组外场采集的红外序列图像,分别使用本文算法和Mean-Shift算法对两段视频进行目标跟踪实验。第一组视频的内容是民航飞机由近处向远离红外热像仪的方向飞行,该段视频中目标的尺寸由大变小、目标的灰度由强变弱,主要测试跟踪算法对目标尺寸变化的适应性。图6所示是整段视频中的第9帧,第311帧,第1760帧和第4250帧。

图6 第一组视频的实验结果Fig.6 The experimental result of the first group of videos

图6 a为本文算法的跟踪结果。其中:第9帧图目标的大小尺寸为52×16,采用的是特征提取窗A;在第311帧时,目标尺寸变化为28×22,算法自动将特征提取窗更新为B;在第1760帧时,目标尺寸为7×4,特征提取窗已经更新为C。从结果可以看出,由于本文算法使用了3种大小的特征窗,并且根据每帧跟踪结果进行实时调整,因此可以适应目标尺寸的大幅变化。Mean-Shift算法由于核函数的带宽固定,缺乏应对目标尺寸变化的机制,当目标尺寸和波门大小差别不大时(通常为目标面积≥(波门面积)/9),跟踪可以保持稳定进行。当目标尺寸远小于核函数的带宽时(例如,第1760帧,目标尺寸7,约为带宽64的10%),极易受到噪声、杂波等干扰而丢失目标,如图6b所示。

第二组视频的内容是民航飞机被近处的障碍部分遮挡,主要测试跟踪算法在目标异常状态下的鲁棒性。图7所示是整段视频中的第827帧,第1131帧,第1206帧和第1310帧。

图7 第二组视频的实验结果Fig.7 The experimental result of the second group of videos

本文算法中使用了Kalman滤波对目标的运动参数进行维护和预测,结合模板更新策略,在图像特征匹配发生异常时(视频的第1150帧,目标完全被障碍物遮挡)使用预测的位置来代替图像匹配的结果,保证跟踪在目标异常时仍然可以稳定进行。Mean-Shift算法只考虑帧间的相关性,当某一帧匹配发生错误后(从第1150帧开始,Mean-Shift算法的匹配位置就开始收敛到障碍物上),无法再找到正确的位置。如图,当目标穿过障碍后,Mean-Shift算法由于取到了错误的模板,无法再去匹配目标,而是一直停留在障碍上。

由两组视频可以看出:1)由于加入了多尺度模板更新机制,本文算法对目标的尺度变化不敏感,能在跟踪过程中适应目标尺寸的大幅变化;2)本文算法具备较强的抗干扰能力,在目标发生异常时仍能保持跟踪的正常进行。

5 结论

本文提出了一种实时红外图像目标跟踪算法。算法以多尺度LBP算子提取目标的联合直方图作为图像特征进行匹配,结合Kalman滤波和多尺度模板更新,使得算法在目标尺寸大幅变化,目标部分遮挡、短暂消失等情况下仍能保持正常稳定跟踪。针对本文算法的特点,设计了专用图像处理板,并介绍了本文算法在该平台上的硬件实现方法。最后,使用本文算法和Mean-Shift算法在两组实录的红外序列图像上进行了实验,结果验证了本文算法的有效性。

[1] BAKER E S,DE GROAT R D.A correlation-based subspace tracking algorithm[J].IEEE Transactions on Signal Processing,1998,46(11):3112-3116.

[2] 郭伟,赵亦工,谢振华.一种改进的红外图像归一化互相关匹配算法[J].光子学报,2009,38(1):189-193.

[3] 陈沈轶,钱徽,吴铮,等.模板图像匹配中互相关的一种快速算法[J].传感器技术学报,2007,20(6):1326-1329.

[4] COMANICIU D,RAMESH V,MEER P.Kernel-based object tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2003,25(5):564-577.

[5] 刘晔,胡绍海,李向军.海平面红外目标的检测和跟踪技术[J].计算机仿真,2011,28(1):289-293.

[6] 石文君,王登位,徐海全,等.复杂动态背景下的红外运动多目标跟踪与检测[J].光电工程,2009,37(1):40-54.

[7] BIMBO A D,NESI P,SANZ J L C.Optical flow computation using extended constraints[J].IEEE Transactions on Image Processing,1996,5(5):720-739.

[8] MCEACHEN J C,DUNCAN J S.Shape-based tracking of naturally occurring annuli in image sequences[C]//Computer Vision and Pattern Recognition,IEEE Computer Society,New York City,1993:613-614.

[9] OJALA T,PIETIKÄINEN M,HARWOOD D.A comparative study of texture measures with classification based on feature distributions[J].Pattern Recognition,1996,29:51-59.

[10] OJALA T,PIETIKÄINEN M,MÄENPÄÄ T.Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J].IEEE Transactions on PAMI,2002,24(7):971-987.

[11] LEW M S.Next-generation web searches for visual content[J].IEEE Computer,2000,33(11):46-53.

[12] AHONEN T,HADID A,PIETIKÄINEN M.Face recognition with local binary patterns[C]//ECCV 2004 Proceedings,Lecture Notes in Computer Science 3021,Springer,2004:469-481.

[13] 周宏仁,敬忠良,王培德.机动目标跟踪[M].北京:国防工业出版社,1991:134-176.

[14] GONZALEZ R C,WOODS R E.数字图像处理[M].2版.北京:电子工业出版社,2005:496-498.