一种图像的感兴趣区域提取方法

于 明,邳艳芹

(河北工业大学 信息工程学院,天津 300401)

在视觉上,人们总是能迅速地把目光集中在自己感兴趣的方面[1]。随着图像处理技术的发展,感兴趣区域的提取是近期图像处理技术发展的热点,在图像处理中把计算资源用于处理感兴趣区域,会提高图像处理的效率。感兴趣区域(ROI)检测将人类的视觉注意机制引入到图像分析过程中,对于提高现有图像分析系统的工作效率有着积极的作用[2],同时在视频压缩及检索领域也得到了应用。

感兴趣区域(ROI)是图像中可能引起人眼视觉关注的区域。视觉关注是人类视觉系统捕获场景中有意义部分的一种机制,通过对视觉关注的分析能提取图像中的感兴趣区域。视觉选择性注意机制包括两种,一是从下至上的注意(数据驱动的注意模型),是与任务无关且不受意识控制的,是基于视觉输入景象的显著性计算的,属于低级认知的过程。目前另一个是自上而下的注意 (任务驱动的注意模型),与人的主观意识有关且受意识控制[3]。其中最具影响力的当属Itti和Koch等人提出的Saliency模型[1],利用人的视觉感受野、侧抑制神经网络模拟了人的视觉注意力机制。但是该模型最终的显著区域的范围是固定的形状,并且存在着漏检测和检测顺序不合乎人类视觉注意特征的情况。

1 视觉显著图的生成

1.1 早期视觉特征提取

想要全面准确的描述一幅图像,就要针对其各个方面的视觉属性选择多种简单图像特征。文中基于Itti模型[4-5]的基本方法来提取图像的颜色、亮度和方向3个低层特征来获得图像各个特征的特征图。

1)亮度特征图的提取

设 r(t),g(t)和 b(t)分别表示原始图像中的红色、绿色和蓝色通道,其中t表示图像的尺度,将原始图像的尺度设置为0,则亮度特征图的计算方法如式(1)所示。

2)方向特征图的提取

神经还原论中提到,视皮层细胞可以看做是一个线性空间滤波器,而二维的Gabor函数刚好有效的描述了哺乳动物视皮层简单细胞感受野的刨面。

由于Gabor函数有很好的方向选择性,能很好的描述视觉皮层中具有方向选择性的简单细胞的感受野。因此用滤波器对I进行卷积以提取方向特征,采用二维Gabor滤波器,取Gabor滤波器 (0,π/4,π/2,3π/4)4 个方向的输出作为图像的方向特征图。

1.2 兴趣图(显著图)的生成

低层特征提取后,关键问题是计算特征兴趣图。本文对亮度特征图4个方向分量共5个分量特征图采用非线性尺度空间表示,中央图像对应高分辨率下的尺度,外围图像对应低分辨率下的尺度,通过感受野和整合野的中央-外围的计算策略计算特征兴趣图。

1)亮度特征兴趣图(显著图)

Itti模型认为高分辨率图像代表感受野的中央区域,低分辨率图像代表感受野的周边区域,通过跨尺度计算不同分辨率图像之间的差值来提取特征图。

根据亮度对比度产生亮度显著图,亮度特征计算如下:

其中c是非线性尺度空间中表示的高分辨率的尺度因子,s是对应的低分辨率下的尺度,通过高分辨率图像中的像素减低分辨率图像中的对应像素来实现。

2)颜色特征兴趣图(显著图)

显著区域即为变化强烈的区域,也就是频谱中的高频成分。由于Itti模型在提取颜色特征时可能会出现显著区域反转现象,因此,可以通过过滤掉图像中的低频部分,提取图像中的高频部分来作为图像的显著区域。

这里采用 Achanta等人[6]提出的频域调和(Frequencytuned)的显著性检测方法。先将颜色变化到均匀的CIELab颜色空间,再对变换后的图像进行高斯低通滤波,最后求原图与滤波后的图像的差的平方即为颜色的显著图记为C(x,y):

其中,Iu为像素值的算术平均,Iwhc为原始图像经过高斯模糊得到的。

3)方向特征兴趣图(显著图)

通过局部方向对比度计算方向特征显著图,将方向特征图 O(c,s,θ)编码成一组:

1.3 多个兴趣图的合并策略

由于全局加强法没有考虑到自然图像中的信噪比问题,并且视皮层的神经元是局部互连的,寻找全局极大在生物学上也是不合理的。因此本文采用局部迭代法对不同机理产生特征图进行合并。具体做法是:

首先将各特征图的特征值归一化到同一个范围,其次引入高斯差分函数(DOG),最后将归一化的特征值与高斯差分函数进行卷积。图1描述了局部迭代法的工作流程。

图1 局部迭代法流程Fig.1 Local iteration process

局部迭代法是中央自激励、范围内抑制的结构,很好的促进了相邻显著点之间的局部竞争。迭代次数是根据实验经验人为设定的,一般是到特征图中大多数位置的特征值收敛且接近于0时就停止迭代过程。

高斯差分函数就是中央自激励、邻域范围内抑制的结构;从生物学的角度来讲,与人眼主视皮层的中央自激励、邻域范围内抑制的神经元间的侧连接组织方式相似,具有生物学上的合理性[8]。这种结构促成相邻显著点之间的局部竞争。由该方法产生的兴趣图更接近稀疏分布,目标之外的部分被很好的抑制。局部迭代法对其他非显著目标部分产生强烈抑制的特点,表明了该策略在对噪声有良好的鲁棒性。

2 感兴趣区域的提取

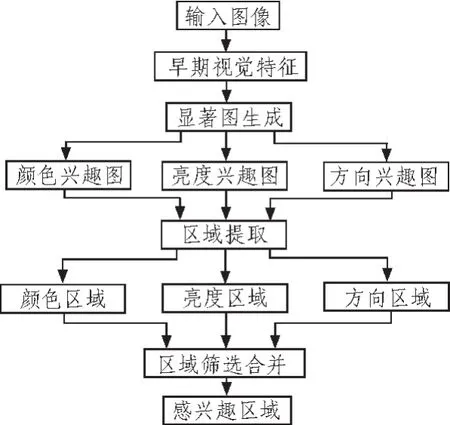

如何确定感兴趣区域的范围,又该如何排除干扰,使区域的选择更精确,基于前文显著图的获取,利用综合自动阈值分割和种子点的区域生长方法分别对各个显著图进行区域提取进而得到各自的兴趣区域,在根据判决准则对各个区域进行筛选合并,从而得到最后的感兴趣区域:具体步骤如下:

1)保留前文生成的亮度、颜色和方向的显著图I,C,O。

2)利用最优直方图方法从合并的兴趣图生成阈值Hs。

3)根据Hs分别对底层特征显著图进行阈值分割。

4)用保留的最佳尺度的注视点[Xi,Yi],i∈(I,C,O)为种子点,然后通过逐个对分割后的显著图进行区域生长的方法得到各自的兴趣区域 R,i∈(I,C,O)。

5)定义兴趣区域面积 Sregion=|max(x)-min(x)|×|max(y)-min(y)|,(x,y)∈R 如果 Sregion>65%Smap,则该区域被删除。 其中Smap为兴趣图的面积。

6)将保留的感兴趣区域进行合并,得到最终的感兴趣区域。

感兴趣区域提取方法的流程如图2所示。

图2 感兴趣区域提取模型Fig.2 Region of interest extraction model

该方法与阈值分割技术和种子点的区域生长技术相结合,近似的估算了显著图目标的尺寸。经过对多幅兴趣图的处理后发现,当兴趣区域面积过大时表明该显著图的显著点分布过于平坦和均匀,显著图会给最终显著图和兴趣图的合并带来干扰,影响到最终兴趣区域范围的精度。因此我们选择用显著图面积的65%来作为筛选指数。

该模型的工作流程叙述如下:首先对输入的原始图像进行处理生成显著图,然后根据生成的显著图产生各自的显著区域。由于输入的图像特征不同,因此所得到颜色、亮度、和方向显著区域对显著图的合并贡献不同。比如颜色显著图的显著性较强,对合并的贡献就较大;然而方向显著图的显著性却分布较为均匀,对合并的贡献就较小而且还会带来干扰。

3 实验结果和分析

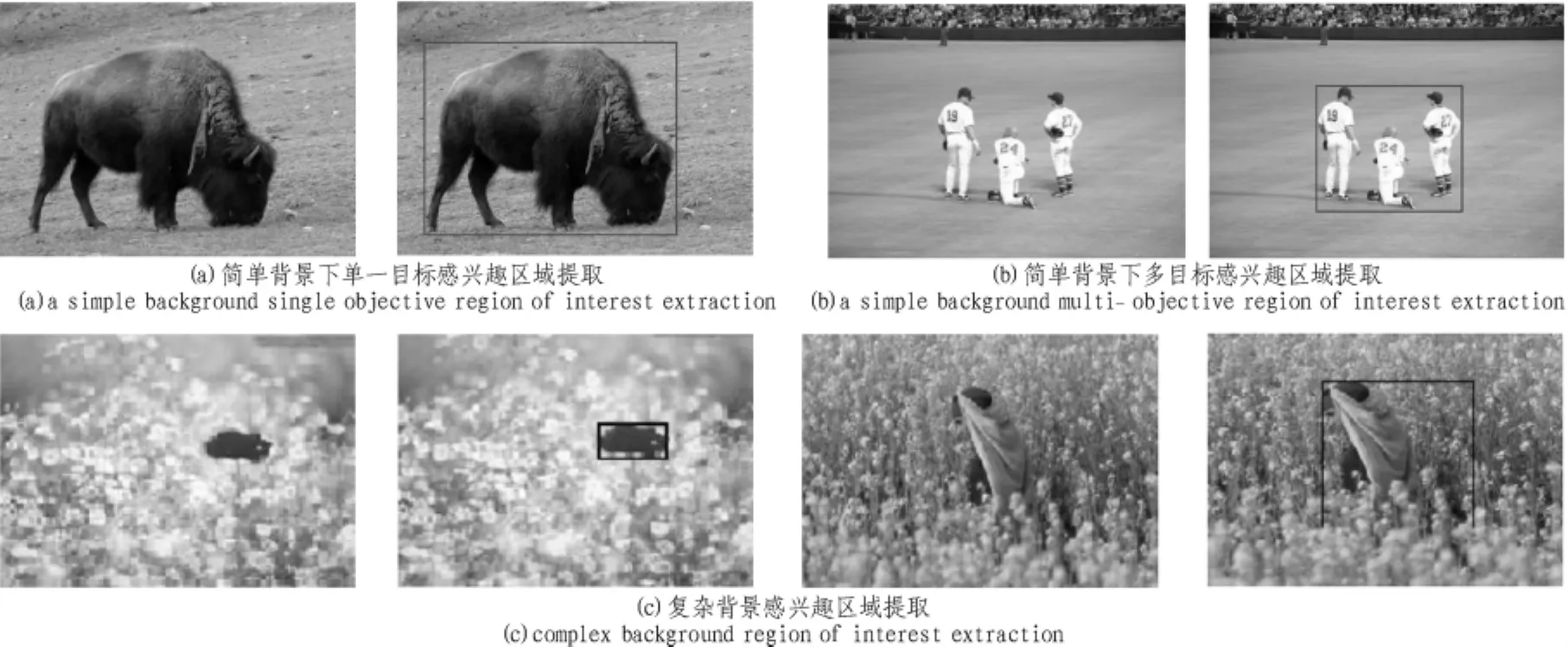

为了验证本文方法的正确性和有效性,在Intel Pentium 1.6 GHz、内存 1 GB 的微机上,利用 Matlab 7.6.0(R2008a)分别对简单背景单一目标、简单背景复杂目标和复杂背景的多幅自然图像进行了实验。如图3所示,该方法生成的可变区域包含了视觉上最为显著的目标,比较准确的提取了符合人类视觉感知[8]的感兴趣区域。

图3 感兴趣区域提取的结果展示图Fig.3 Results of extraction region of interest map

4 结 论

本文在基于经典的Itti模型[10]基础上,采用了局部迭代的特征合并策略并在此基础上综合自动阈值分割和种子点的区域生长方法实现了感兴趣区域的提取方法。该方法很好的实现了感兴趣区域的提取,通过实验表明其检测顺序和结果比较符合人类视觉感知,具有良好的鲁棒性和实时性。

[1]王国营,梁春迎.一种图像显著区域的提取方法[J].计算机应用,2010,30(6):1619-1621.

WANG Guo-ying,LIANG Chun-ying.Extraction of salient regions in image[J].Joumal of Computer Applications,2010,30(6):1619-1621.

[2]张菁,沈兰荪,高静静.基于视觉注意机制的感兴趣区检测[J].光子学报,2009,38(6):1561-1565.

ZHANG Jing,SHEN Lan-sun,GAO Jing-jing. Extraction of interests region based on visual attention mechanism[J].Acta Photonica Sinica,2009,38(6):1561-1565.

[3]韦灵丽,李翠彬.基于视觉选择性注意机制的目标检测的研究[J].计算机与现代化,2010,180(8):92-97.

WEI Ling-li,LI Cui-bin.Object dectection based on visual selection attention mechanism[J].Computer and Modernization,2010,180(8):92-97

[4]Itti L,Kouch C.Computational modeling of visual attention[J].Nature Reviews Neuroscience,2001,2(3):194-230.

[5]IttiL,Kouch C.Feature combination strategies for saliency-based visual attention systems[J].Journal of Electronic Imaging,2001,10(1):161-169.

[6]Aehanta R,Hemami S,Estrada F,et al.Frequeney-tuned salient region deteetion[C]//InProeeedings of IEEE Conferenee on Computer Vision and Pattern Reeognition(CVPR2009),2009:1597-1604.

[7]HU Yi-qun,XIE Xing,MA Wei-ying.Salient region detection using weighted feature maps based on the human visualattention model [C]//Advances in Multimedia Information Processing.Heidelberg:Springer,2004:993-1000.

[8]Weliky M,Kander K,Fitzpatrick D,et al.Patterns of excitation and inhibition evoked by horizontal connections in visual cortex share a common relationship to orientation columns[J].Neuron,1995,15(3):541-552.

[9]张卓,张学武,梁瑞宇,等.基于视觉感知的船闸监控系统研究与实现[J].现代电子技术,2009(22):135-138.

ZHANG Zhuo,ZHANG Xue-wu,LIANG Rui-yu,etal.Research and Implementation ofShip-lock Monitoring System Based on SVM and Visual Perception[J].Modern Electronics Technique,2009(22):135-138.

[10]吴月娥,边后琴.尺度与特征引导视觉选择性注意机制模型[J].现代电子技术,2009(22):84-87.

WU Yue-e,BIAN Hou-qin.Model of visual selective attention mechanism deployed by scale and features[J].Modern Electronics Technique,2009(22):84-87.