基于随机特征子空间的半监督情感分类方法研究

苏 艳,居胜峰,王中卿,李寿山,周国栋

(苏州大学 自然语言处理实验室,江苏 苏州 215006)

1 引言

随着www的高速发展,互联网上产生了大量对于人物、事件、产品等进行评论的文本信息。为了处理和分析这些海量的评论信息,情感分析(sentiment analysis)正渐渐发展成为自然语言处理中一项越来越受关注的研究课题[1-3]。目前情感分类的主流研究方法—基于机器学习的方法,大致可以分为三种类型: 无监督学习、监督学习和半监督学习。尽管监督学习方法在情感分类中取得了非常好的效果[4-5],但是监督学习依赖大量的标注样本,而获得大量标注样本的成本代价很高;无监督学习虽然不需要标注样本,但分类效果与监督学习相比还存在一定差距[6-7]。相对而言,半监督学习方法,一种结合少量标注样本和大量未标注样本进行学习的方法[8-10],是前面两种方法的一种折衷。该方法既能有效地减少标注样本带来的开销,又可以避免完全没有标注样本带来的分类效果损失。因此,半监督学习渐渐受到广大研究者的密切关注。

众所周知,协同训练(Co-training)是由Blum和Mitchell[11]提出的一种非常有效的半监督学习方法。该方法的成功运用需满足两个条件: (1)样本可以由两个冗余的条件独立视图表示;(2)每一个视图都能从训练样本中学习到一个强分类器。例如,在网页分类中,网页的正文信息构成一个视图,而网页中超链接信息构成另一个视图[11]。然而,不同于网页文本,普通情感评论文本并没有天然存在的多个视图。考虑到情感文本中特征数量非常庞大,本文首先利用随机特征子空间生成的方式将文本特征空间分为多个部分作为多个视图;然后基于协同训练在每个视图中挑选置信度高的未标注样本;最后利用这些挑选出的样本更新训练模型,文中称这种方式为基于随机特征子空间生成的协同训练。

基于随机特征子空间生成的协同训练存在以下问题。由于每个视图是随机产生的,很可能存在一个视图不包含对分类有帮助的特征,从而导致该视图无法构建一个强分类器(不能满足上述的第二个条件)。为了解决上述问题,本文提出了一种新的基于动态随机特征子空间生成的协同训练,即在每一个迭代过程都产生一组不同的特征子空间。相对于静态方式(仅产生一次特征子空间),动态方式可以避免产生的子空间没有足够分类能力*我们相信在动态产生过程中,存在某个子空间构建的分类器分类能力不强的情况,但是这种情况不可能始终发生,所以最终的协同训练过程还是能够成功进行。。实验结果表明此方法明显优于静态子空间产生方式及其他半监督学习方法。另外,在已有的协同训练算法的研究中通常将特征空间分为两个子空间[9-10],然而这并不一定是最佳的划分方式,因此本文还探索了特征子空间的划分数目问题,实验表明特征空间分为四部分时能够获得最好的分类性能。

本文结构组织如下: 第二节介绍情感分类的相关研究工作;第三节提出基于随机特征子空间的动态的半监督情感分类方法;第四节给出实验结果及分析;第五节给出结论,并对下一步工作进行展望。

2 相关工作

2.1 基于无监督学习和监督学习的情感分类方法研究

情感分类方法主要分为无监督学习和监督学习方法。其中,无监督学习方法是指不借助任何标注样本来构建分类模型。已有的无监督学习方法一般借助于一些已标注的情感词(又称种子词)。例如,Turney[12]通过计算文档中单词和种子词(“excellent”,“poor”)之间的点互信息(PMI)来计算整个文档的情感倾向。Kennedy和Inkpen[13]在种子集合上使用情感词计数的方式(term-counting)获得情感倾向。Zagibalov和Carroll[14]也采用了类似的分类算法,但是在情感种子词的选择上提出了一种更有效的方式。然而,由于无监督学习不借助任何标注样本,所以在分类性能方面与监督的方法还存在较大差距,在很多场合难以满足实际需求。

监督的学习方法是指通过训练大量标注样本来构建分类模型,近年来也取得了一定的进展。最早由Pang et al.[5]将监督学习引入情感分类任务中,而后续的大量研究工作都致力于通过各种途径来改善基于监督学习情感分类的性能。例如,主观句识别[15]、寻求更佳的文本特征[16]、使用文档局部特征信息[17]等。相对无监督学习,基于监督学习的性能通常较好,但是监督学习需要有充足的标注样本。由于情感分类是一个领域相关问题,在实际应用中,特别是牵涉到多个领域时,样本的标注工作会变得非常费时费力。因此监督学习方法在满足实际需求方面也存在不足。

2.2 基于半监督学习的情感分类方法研究

近几年来,基于半监督学习的情感分类越来越受到重视。基于半监督学习的情感分类是通过结合少量标注样本和大量未标注样本来构建分类模型。Wan[9]将两种不同语言(英语和汉语)作为两个不同的视图,采用协同训练方法进行半监督情感分类;Li et al.[10]则是把评价语句分为个人视图(Personal View)和非个人视图(Impersonal View)并同样采用协同训练方法进行半监督情感分类。Zhou et al.[18]则提出基于贝叶斯置信网络的主动学习和半监督学习方法用于情感分类任务。虽然本文的方法也是基于协同训练,但是,相对于Wan[9]和Li et al.[10]中的视图产生方式,我们提出的基于随机特征子空间产生视图的方式实现起来更加简单和直观,并且很容易移植到其他语言的情感分类任务(语言独立性)。

除了上面的几篇密切相关的研究工作以外,半监督的情感分类方法还存在一种特殊的实现方式, 少量标注样本结合情感词典的方法。例如,Sindhwani和Melville[19]提出了基于二部图的半监督学习方法同时实现了篇章级和词语级的情感分类;Li et al.[20]则基于限制性非负矩阵分解(Constrained Non-negative Tri-factorization)的方法实现了这种方式的半监督学习情感分类任务。值得指出的是,本文仅考虑存在少量标注样本的情况,并未加入任何情感词典资源。

3 动态生成特征子空间的半监督情感分类方法

3.1 随机特征子空间生成

3.2 基于动态随机特征子空间生成的协同训练算法

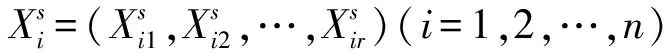

本文将每一个特征子空间作为文本的一个表示视图,于是多个特征子空间可以对应多个文本表示的不同视图。有了这些视图,就可以应用协同训练算法进行半监督学习。具体来讲,首先将标注和未标注样本的所有特征分为m个子空间,然后使用每一个子空间特征和训练样本一同训练一个子空间分类器,然后在协同训练(co-training)算法中分别使用上面产生的分类器选择置信度高的样本作为自动标注样本,以迭代的方式更新训练集。若在整个协同训练过程中每个子空间都是固定不变,则称这种方式为基于静态随机子空间生成的协同训练。在引言部分已经提出,这种静态的方式在产生的子空间分类器分类能力不足的情况下会使整个学习过程失败。因此,本文提出一种新的基于动态随机子空间生成的协同训练算法。它与静态子空间生成方式不同的是,在协同训练的每次迭代中动态生成两个子空间分类器。这种方式有着明显的优势: 由于在情感分类中有用的特征并不多,所以很有可能一个子空间分类器不包含这些有用的特征,造成这个子空间分类能力不足,而动态子空间生成的方法可以避免这个问题(即使失败也仅仅是部分迭代,不会是整个过程的失败)。图1详细介绍了基于动态特征子空间生成的协同训练算法流程。

图1 基于动态特征子空间生成的协同训练算法

值得指出的是,动态特征子空间生成是每次迭代过程都重新生成子空间,而静态的方法只生成一次子空间,整个协同训练过程中一直用这组子空间。两种方法不同之处体现在步骤S2),只要把步骤S2)移到循环之前,动态方法即变成了静态方法。

在已有的协同训练算法的研究中,通常将特征空间分为两个子空间[9-10]。然而,在情感分类中,由于特征维度非常高,将特征空间分为两个子空间(即:m=2)不一定是最佳的划分方式,因此究竟将特征空间分为几部分是一个很值得研究的问题。在后续的实验环节,我们将对在情感分类中特征子空间划分的数目(m)进行详细地比较研究。

4 实验结果与分析

4.1 实验设置

实验数据来自Blitzer et al.[22]收集的多领域情感语料*http://www.seas.upenn.edu/~mdredze/datasets/sentiment/,包括四个领域: Book,DVD,Electronic,Kitchen。每个领域包含1 000篇正类和1 000篇负类评论。本实验使用MALLET机器学习工具包*http://mallet.cs.umass.edu/中的最大熵分类器,分类算法的所有参数都设置为默认值。分类选取词的一元特征(unigram)作为特征,并使用它们的布尔权重作为文本向量里面的特征值。具体实验时,选择10%样本作为初始标注样本,80%样本作为未标注样本,剩下的10%样本作为测试样本。考虑到随机特征子空间生成的随机性问题,对于每一个实验我们取五次实验结果的平均值作为最终结果。

4.2 基于动态/静态随机子空间生成的协同训练的比较实验

在本小节中,将针对协同训练中动态生成子空

间和静态生成子空间方法进行比较研究。除此之外,还实现了一些其他常见的半监督学习算法进行比较研究。这些方法包括:

1)Baseline: 对未标注样本不做任何处理,直接使用标注样本训练分类模型;

2)Self-training: 利用整个特征空间构建分类器,并用它迭代加入置信度最高的样本扩充标注样本集合;

3)Personal/ImpersonalLearning: 将每篇文章的句子分为两个视图: 个人视图(personal view)和非个人视图(impersonal view)主要参考Li et al.[10]实现;

4)StaticCo-training: 基于静态随机子空间生成的协同训练算法,设置m=2,即分成两个特征子空间;

5)DynamicCo-training: 基于动态随机子空间生成的协同训练算法,设置m=2,即分成两个特征子空间。该方法就是本文提出的方法。

在实现以上算法过程中,置信度的大小是通过最大熵分类器提供的分类结果即样本属于每个类别的后验概率的大小来决定的。

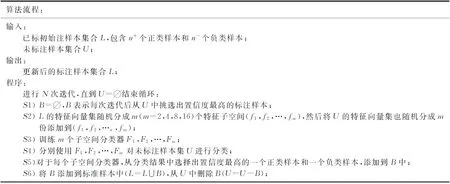

图2给出了不同半监督学习方法的性能比较。从图中可以看出,基于特征子空间的半监督学习方法要远远好于Baseline和Self-training。基于动态子空间生成的协同训练要明显优于静态的方式,四个领域平均提高幅度达2.6%。同时,本文提出的动态方法已经超过现有的最好方法—基于Personal/Impersonal的半监督情感分类方法[10],尤其是在DVD和Electronic领域,提高的幅度达到了1.6%和3.8%。我们的方法相对Baseline在四个领域都有一定幅度的提高,但由于Book和DVD领域本身的样本信息噪音就比较大(存在大篇幅的介绍剧情)导致分类困难,所以获得的分类效果并没有其他两个领域高。

图2 不同半监督分类方法情感分类性能比较

随着未标注样本的添加,Self-training自动标记中标错的样本会不断累积错误,其负作用越来越大。而在我们的方法中两个特征子空间能相互补充有帮助的信息,更能充分利用对分类有帮助的特征,从而更新训练模型。Personal/Impersonal的方法需要满足特定条件,但该方法与静态产生视图方式存在同样的缺陷。即由于在情感分类中有用的特征并不多,所以很有可能一个子空间分类器不包含这些有用的特征,造成这个子空间分类能力不足。实验结果表明动态子空间生成的方法可以避免这个问题,从而取得更好的分类性能。

4.2.1 不同特征子空间数目时动态/静态方法的比较实验

本实验详细比较在不同特征子空间数目时候,动态和静态分类方法的性能。我们选择特征空间数目,m=2,4,8,16。表1给出相应的结果。实验结果表明,将特征被划分为不同数目子空间时,基于动态子空间生成的协同训练均要明显优于静态的方式。

表1 不同特征子空间数目时动态/静态方法分类性能比较

4.2.2 特征子空间数目的比较实验

本实验将讨论比较研究协同训练中特征子空间划分个数m的问题,划分为几个子空间能取得最佳分类性能。从4.2.1的实验发现,基于动态子空间生成的协同训练明显优于基于静态子空间生成的协同训练,所以选用动态子空间生成的协同训练进行下面的实验。为了清楚起见,我们选择m=2,4,8,16四种情况进行比较实验。

图3 基于不同特征子空间数目的动态多视图半监督情感分类性能比较

从图3可以看出,当m=4时也即把特征空间分为四部分时能够获得最好的分类性能。随着m的进一步增加,每个子空间中包含的特征逐步减少,从而导致子空间分类器的性能下降。例如,当m=16时,协同训练的分类效果明显下降,比m=4时平均下降了3.2%。另外,当m=4时,协同训练方法比Personal/Impersonal方法平均提高了4.5%

5 结语

本文提出一种基于随机特征子空间的半监督情感分类方法,此方法在迭代过程中采用动态的方式生成特征子空间,能取得更佳的情感分类性能。实验结果表明这种方法明显优于其他主流的半监督情感分类方法,同时实验结果显示将特征空间分成四个视图时能够获得最佳性能。

本文实验中,所使用的特征是词的一元特征(unigram),在下一步工作中,我们将尝试把词的二元特征(bigram)、依存关系特征、语义角色等特征用到半监督情感分类中,用以提高分类的性能。另外,还可以尝试将基于动态特征子空间的半监督学习方法用到其他自然语言处理任务中。

[1] 黄萱菁, 赵军. 中文文本情感分析[J]. 中国计算机学会通讯, 2008, 4(2).

[2] 赵军, 许洪波, 黄萱菁, 等. 中文倾向性分析评测技术报告[A]. 第一届中文倾向性分析评测会议, 2008.

[3] 刘鸿宇, 赵妍妍, 秦兵, 等. 评价对象抽取及其倾向性分析[J]. 中文信息学报, 2010, 24(1):84-88.

[4] 唐慧丰, 谭松波, 程学旗. 基于监督学习的中文情感分类技术比较研究[J]. 中文信息学报, 2007, 6(2).

[5] Pang B., L. Lee, S. Vaithyanathan. Thumbs up? Sentiment Classification using Machine Learning Techniques. [C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing (EMNLP-02). 2002.

[6] Zagibalov T.,J. Carroll. Automatic Seed Word Selection for Unsupervised Sentiment Classification of Chinese Test. [C]//Proceedings of the 22nd International Conference on Computational Linguistics (COLING-08). 2008.

[7] Yarowsky D. Unsupervised Word Sense Disambiguation Rivaling Supervised Methods[C]//Proceedings of Annual Meeting on Association for Computational Linguistics(ACL-05). 1995.

[8] Dasgupta S.,V. Ng. Mine the Easy, Classify the Hard: A Semi-Supervised Approach to Automatic Sentiment Classification[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-09). 2009.

[9] Wan X. Co-Training for Cross-Lingual Sentiment Classification[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-09). 2009.

[10] Li S., C. Huang, G. Zhou, et al. Employing Personal/Impersonal Views in Supervised and Semi-supervised Sentiment Classification[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-10). 2010.

[11] Blum A., T. Mitchell. Combining Labeled and Unlabeled Data with Co-training[C]//Proceedings of the 11th Annual Conference on Computational Learning Theory (COLT-98).1998.

[12] Turney P. Thumbs up or Thumbs down? Semantic Orientation Applied to Unsupervised Classification of Reviews[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-02). 2002.

[13] Kennedy A., D. Inkpen. Sentiment Classification of Movie Reviews using Contextual Valence Shifters[J]. Computational Intelligence, 2006,22(2), 110-125.

[14] Zagibalov T., J. Carroll. Automatic Seed Word Selection for Unsupervised Sentiment Classification of Chinese Test[C]//Proceedings of the 22nd International Conference on Computational Linguistics (COLING-08). 2008.

[15] Pang B., L. Lee. A Sentimental Education: Sentiment Analysis using Subjectivity Summarization based on Minimum Cuts[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-04). 2004.

[16] Riloff E., S. Patwardhan, J. Wiebe. Feature Subsumption for Opinion Analysis[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing (EMNLP-06). 2006.

[17] McDonald R., K. Hannan, T. Neylon, et al. Structured Models for Fine-to-coarse Sentiment Analysis[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-07). 2007.

[18] Zhou S., Q. Chen, X. Wang. Active Deep Networks for Semi-Supervised Sentiment Classification[C]//Proceedings of the 23rd International Conference on Computational Linguistics(COLING-10). 2010.

[19] Sindhwani V., P. Melville. Document-Word Co-regularization for Semi-supervised Sentiment Analysis. [C]//Proceedings of 8th IEEE International Conference on Data Mining (ICDM-08). 2008.

[20] Li T., Y. Zhang, V. Sindhwani. A Non-negative Matrix Tri-factorization Approach to Sentiment Classification with Lexical Prior Knowledge[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-09). 2009.

[21] Ho T. The Random Subspace Method for Constructing Decision Forests[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(8), 832-844.

[22] Blitzer J., M. Dredze, F. Pereira. Biographies, Bollywood, Boom-boxes and Blenders: Domain Adaptation for Sentiment Classification[C]//Proceedings of Annual Meeting on Association for Computational Linguistics (ACL-07). 2007.