基于YOLOv8算法改进模型检测梢斑螟虫蛀树木

关键词:梢斑螟; YOLOv8s;识别;检测;准确率;不同场景;C2f-GAM; DyHead

中图分类号:S763. 49 文献标识码:A DOI:10. 7525/j. issn. 1006-8023.2025.01. 010

0引言

当前,林业病虫害面临诸多严峻挑战。其中一个主要问题是病虫害的频发和扩散,这对森林生态系统和经济造成了重大影响。气候变化导致的环境条件变化,如温度升高和降水模式变化,使得一些病虫害的生存环境更加有利,其活动季节也可能延长,这进一步加剧了病虫害的发生频率和范围。此外,全球化和国际贸易的增加,也带来了病虫害跨境传播的风险,增加了对林业生态系统的威胁。管理林业病虫害的复杂性还体现在防控手段的有限性和成本效益问题上,尤其是针对新型病虫害的防治研究相对滞后,导致在面对新威胁时应对不足。因此,综合利用现代技术手段、加强跨区域、跨国界的合作,以及深入研究和推广有效的病虫害防控策略,将是解决当前林业病虫害难题的关键路径。传统计算机图像识别技术面临多种问题,这些问题不仅影响技术的应用广度和深度,也需要不断地研究与创新来推动技术的进步和应用的可持续发展[1-3]。随着计算机视觉技术的快速发展,深度学习方法显著提高了图像识别的效率和准确性,同时弥补了传统方法的不足[4-7]。这种先进的目标检测技术已被广泛应用于林业有害生物的识别,为该领域提供了有效的技术支持[8-10]。

在农林业领域中,深度学习方法在害虫研究方面取得了多项重要进展。例如,孙鹏等[11]提出了结合目标检测网络和注意力机制的方法,用于大豆害虫的识别。佘颢等[12]对目标检测单发多框探测器(single shot multibox detector,SSD)模型进行了改进,采用特征金字塔替代多尺度特征映射,提升了模型对于小目标的检测性能。张博等[13]对YOLOv3模型进行空间金字塔池化改进,开发用于农作物害虫识别的算法,增强了模型的检测和泛化能力。陈娟等[14]利用残差网络和边缘检测算法,强化模型对于园林害虫的识别效果。Jiao等[15]提出了名为AFRCNN的目标检测网络。在该网络的构建过程中,先是精心设计了特征融合模块,借助这一模块从害虫相关信息里提取出有效的特征。随后,引入了基于融合特征图的无锚区域建议网络(AFRPN),利用该网络来确定可能存在虫害的具体位置。最后,把无锚区域建议网络(AFRPN)和Faster R-CNN 进行融合,进而设计出一个全新的目标检测网络AFRCNN。以解决在识别昆虫中存在小目标的问题,提高模型对于小目标害虫的识别精准率。Liu等[16]提出一种PestNet端到端的目标检测网络,用于大规模实际检测林业害虫的监测任务。Li等[17]设计了粗网和细网的目标检测模型,用于实现对于害虫的高效识别。孙丽萍等[18]通过对YOLOv5目标检测模型进行改进,用于各种害虫的图像特征提取以及识别工作,有利于农林业病虫害的防治。Liu等[19]提出了改进的YOLOv3目标检测算法,通过实景拍摄番茄叶片虫害图片构建数据集并进行检测,通过边界框维度聚类和多尺度训练优化了模型的检测效率。

本研究采用YOLOv8s目标检测模型对于梢斑螟虫蛀树木进行检测与识别工作,并对YOLOv8s模型进行改进,提升对于梢斑螟虫蛀树木特征的识别效率,弥补在林业病虫害检测领域对于梢斑螟虫蛀树木的空白。

1YOLOv8目标检测模型

YOLO算法一种目标检测技术,由Redmon等[20]提出,该算法在单个网络中实现了目标检测的任务,经过多次更新和改进,YOLOv8s 具有速度快和高精度的优点,并且已经在PyTorch 中实现。与其他YOLOv8 目标检测模型相比,YOLOv8s 在梢斑螟图像数据集当中拥有较好的检测精准度和较为更快的检测速度。因此,选择YOLOv8s 目标检测算法作为基线模型来解决梢斑螟虫蛀树木数据集的检测问题,将有助于提升林业病虫害的防治效率。

1. 1YOLOv8原理

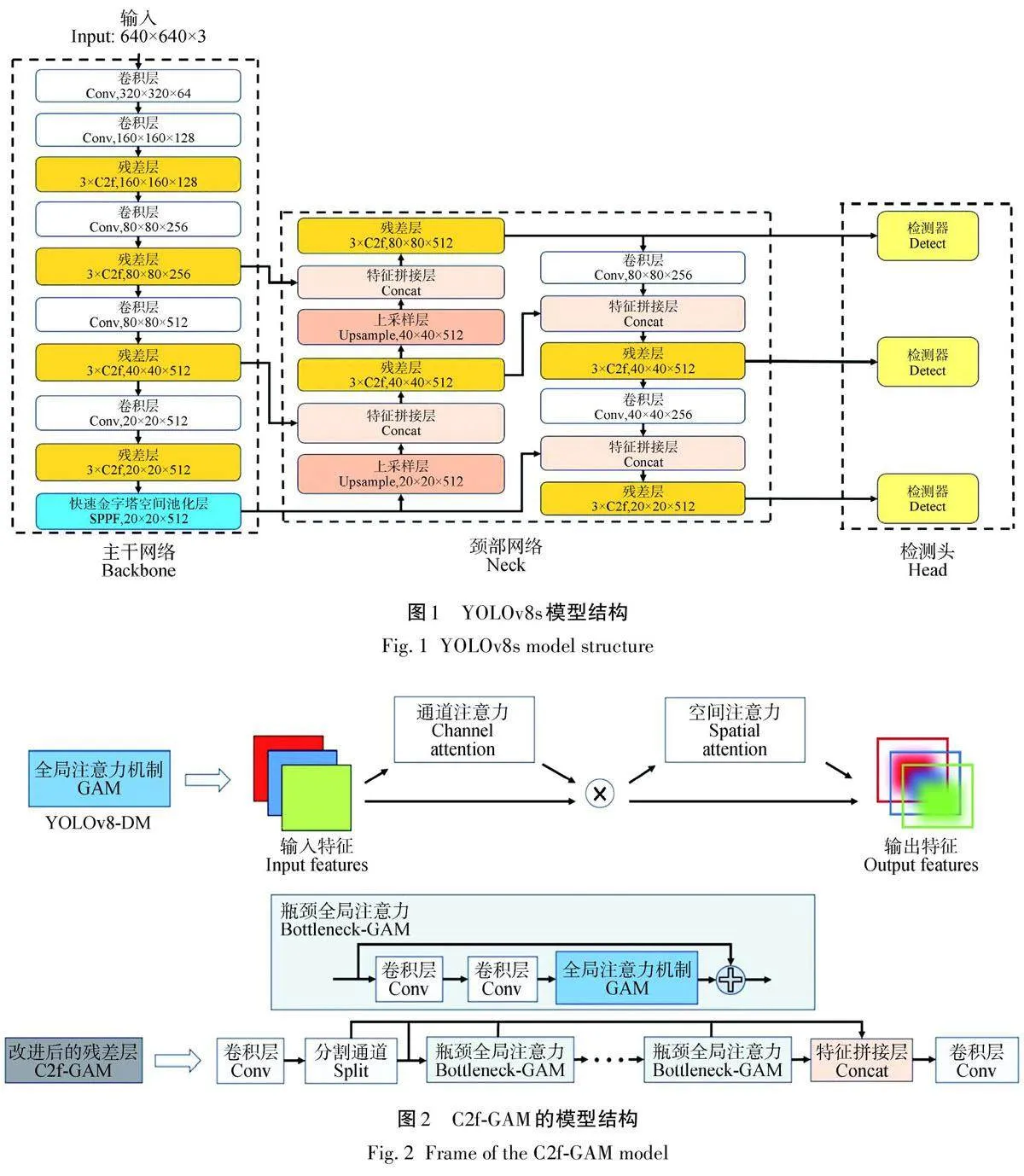

YOLOv8 是由Ultralytics 团队开发的基于深度学习的实时目标检测算法,旨在提供高效、准确和易于使用的解决方案。该算法采用单阶段检测器架构,整合了轻量级骨干网络和高效的检测头部,实现了快速的目标检测和定位。YOLOv8可以根据需求进行定制和扩展,使得模型能够更有效地应对复杂场景下的梢斑螟虫蛀树木检测任务,提高了整体的性能表现和实用价值,如图1所示。YOLOv8的主干类似于YOLOv5的主干,不同点是将C3换成了C2f,以及将第一个Conv层设置为kernel size等于3,stride为2。而C2f相比于C3在YOLOv8中使网络更加轻量并且可以获取更加丰富的梯度流,另一方面,YOLOv8的主干采用快速空间金字塔池化(spatialpyramid pooling-fast,SPPF),通过将空间金字塔池化(spatial pyramid pooling,SPP)进行修改,在保证检测能力的同时,减少计算量,提高计算效率,接下来,将输入信息的结果进行张量拼接。颈部网络采用了PANet,这一结构整合了不同层次的图像特征。PANet按照自顶向下的顺序,聚合了各个CSP网络顶部的特征输出,并在预测阶段使用了CIOU Loss+DFL 的回归损失形式。DFL(distribution focal loss)通过将框的位置建模成通用分布,帮助网络更快速地聚焦于目标周围的特征,增强这些特征的权重。DFL(式中记为DFL)的公式为

DFL通过交叉熵优化最接近标签y 的左右2个位置的概率分布,使网络快速集中在目标位置附近。其学习到的分布理论上接近真实浮点坐标,并使用线性插值权重来处理整数坐标距离。

1. 2改进YOLOv8s算法

本研究对YOLOv8s网络进行改进,增强其处理复杂的视觉场景能力。通过增强特征的全局感知能力和通道之间的动态关系,这些模块使得网络能够更好地适应各种复杂的场景变化,从而提高了模型在现实世界中的适应性和鲁棒性。

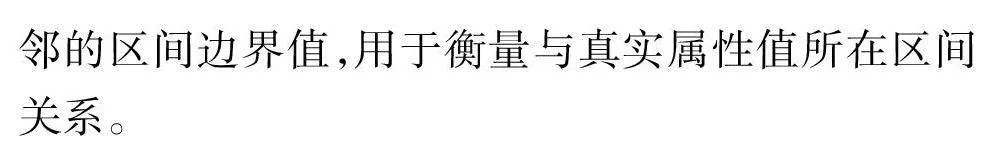

1. 2. 1引入C2f-GAM

C2f-GAM模块将全局注意力机制(GAM)与C2f整合在网络架构中。全局注意力机制是一种整合全局信息的强大工具,可使神经网络掌握输入数据中的总体结构和上下文线索。另一方面,C2f是一种深度卷积神经网络,由CSP(跨阶段部分)结构和Darknet53网络组成[21],旨在通过一系列卷积层和池化层逐步提取图像中的低级、中级和高级特征,专为物体检测任务而设计,C2f-GAM模块的示意图如图2所示。

向C2f-GAM模块发送特征信息后,将进行一系列操作。首先,输入特征“x”通过卷积层进行转换,以促进通道扩展。随后,生成的特征被分成2部分:一部分直接进入2个Bottleneck-GAM 模块,而另一部分则被保留下来。通过卷积和激活函数等操作,这些特征将在Bottleneck-GAM模块中进一步学习和提取。然后,对合并的特征进行全局平均池化,即对每个通道的特征进行平均,得出一个单一的全局特征值。最后,利用GAM的通道关注机制来计算每个通道的关注权重。利用这些注意力权重来权衡合并后的特征,处理后的特征随后与原始特征融合,并通过卷积层进行传播,以实现通道转换。值得注意的是,在主干网络中,有2 个C2f 被替换为C2f-GAM,以增强模型的检测能力。

1.2.2引入动态注意力检测头

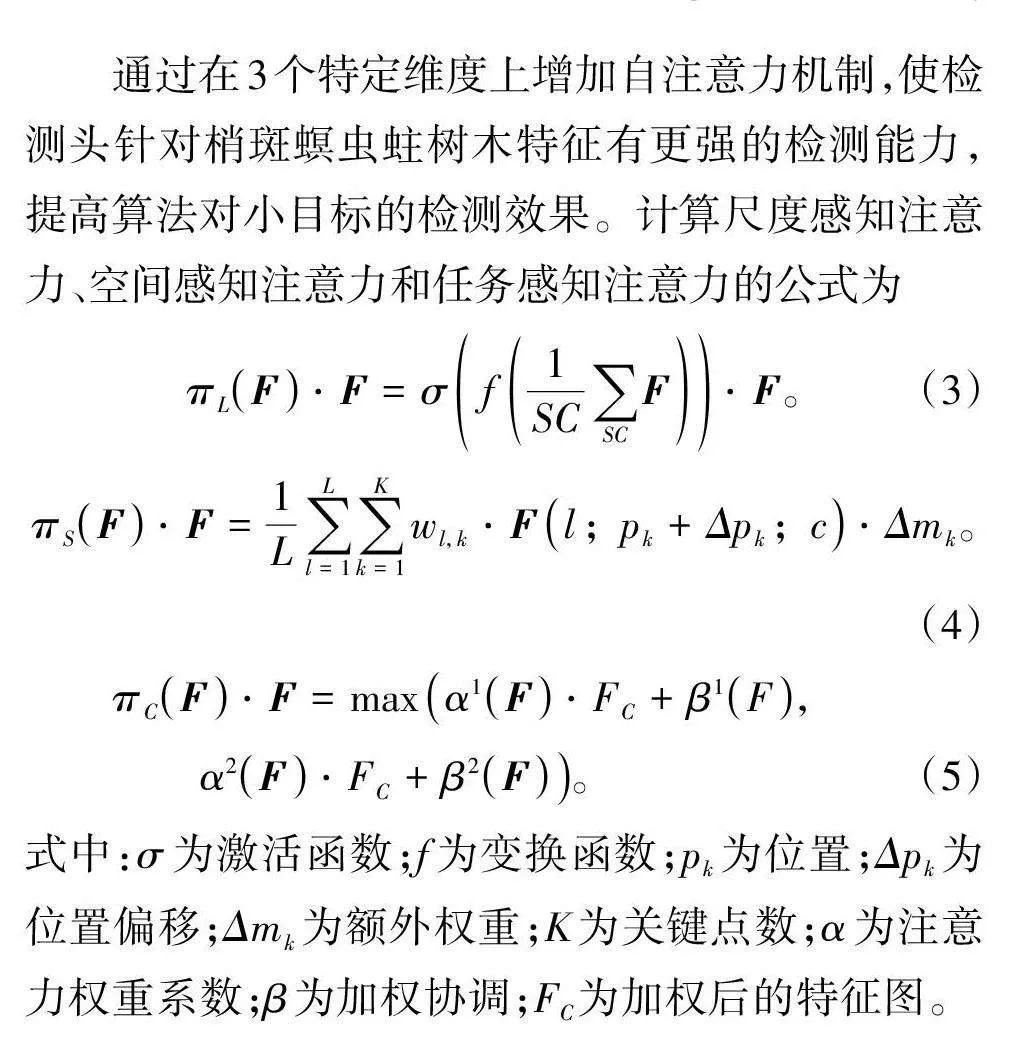

使用DyHead(dynamic detection head)[22]对网络检测器进行替换。首先,其允许动态地调整感受野的大小,这有助于网络更好地适应不同尺度的目标,从小到大的物体都能更有效地检测;其次,Dy‐Head促进了多尺度特征的融合,提高了网络对于不同大小目标的检测性能,此外,其还有助于抑制虚警,减少了对背景区域的误检,从而提高了检测的精度;最后,DyHead的动态性质增强了网络的鲁棒性,使其能够更好地处理复杂场景和各种挑战性情况,从较浅的特征图融合而来的特征图具有更强大的语义信息和准确的位置信息。图3 显示了Dy‐Head的工作原理。在YOLOv8s模型中,骨干网络通过横向、空间和通道3 个维度(L、S、C)输出。YOLOv8s模型的检测头被改进为能够进行规模感知的动态检测头(DyHead),其注意力函数计算公式为

引入尺度感知注意力,根据不同尺度的语义重要性进行动态特征融合。采用线性函数f(·),近似于1×1 卷积层,并结合hard-sigmoid 函数σ(x)=max(0,min(1,x+12))。空间感知注意力模块基于特征融合,关注空间位置与特征层次的一致性判别区域。利用可变形卷积实现注意力学习的稀疏化,聚合同一空间位置的跨层次特征。任务感知注意力模块动态开启和关闭,以支持不同任务需求。

2结果与分析

2. 1改进YOLOv8s目标识别模型

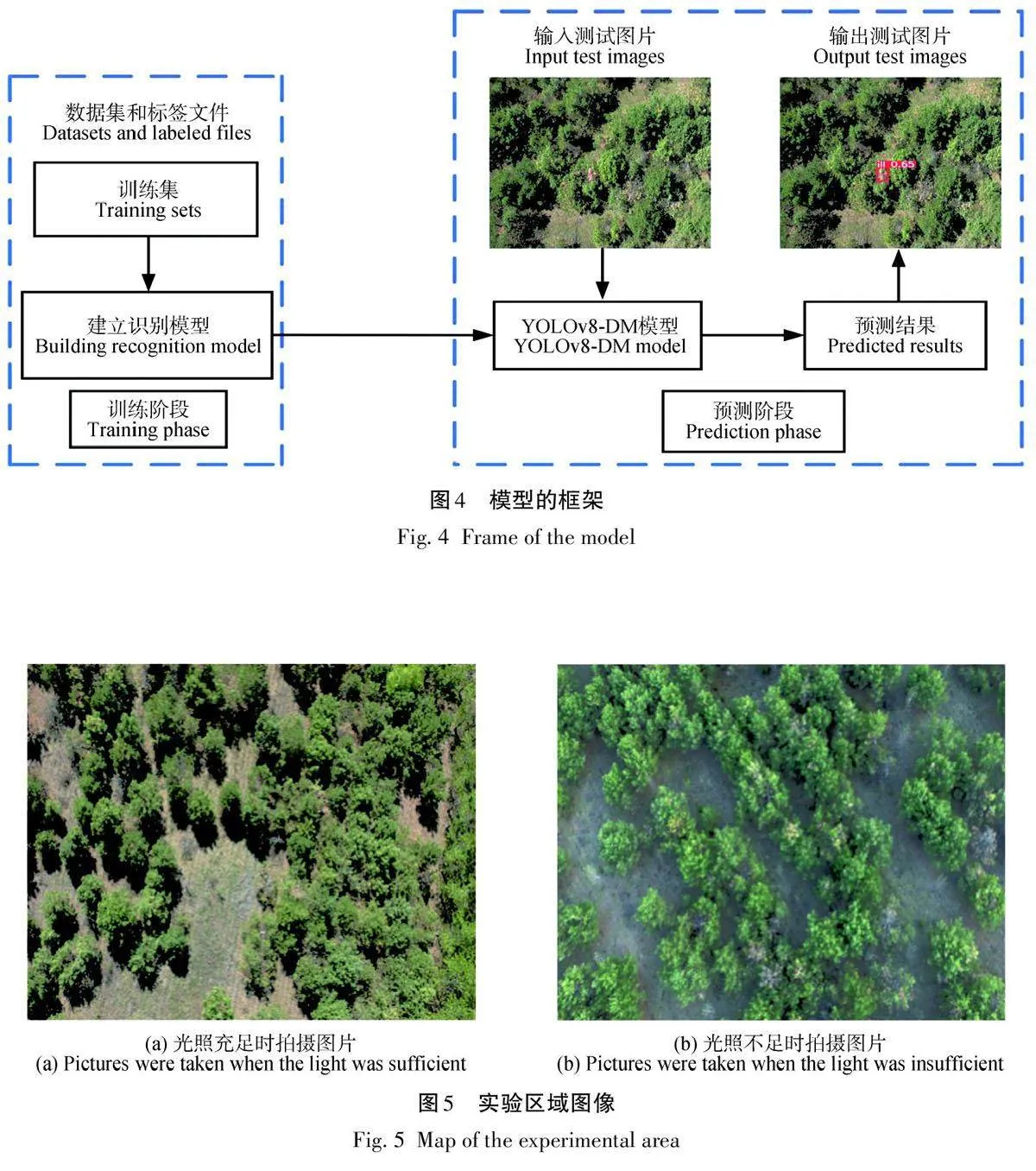

该模型在工作流程中分为2个关键阶段:训练和测试,如图4所示。在训练阶段,模型利用大量的训练数据集进行学习和优化,以便能够准确识别和定位梢斑螟虫蛀树木的图像特征。这一过程中,模型逐渐调整内部参数和权重,以最大化对害虫的检测准确性和鲁棒性。而在测试阶段,经过训练的模型被应用于实际图像中,用于检测和识别输入图像中可能存在的梢斑螟虫蛀树木特征。模型会对每个检测到的虫蛀树木位置进行预测得分处理,并将这些预测结果直观地呈现在输出图像上。这种可视化展示有助于用户理解模型的检测能力和结果,同时为进一步的分析和决策提供支持。通过这种训练和测试的交替过程,模型不断优化自身,以应对不同环境下的复杂挑战,从而提高对梢斑螟虫蛀树木的检测效果和应用价值。

2.2数据集构建

本研究在黑龙江省齐齐哈尔市新江实验林场利用无人机拍摄4638张照片,展示了不同地区和光照条件下梢斑螟虫蛀树木的详细情况。为了准确标定每张照片中的虫蛀树木,使用标记工具labelimg,通过矩形框选出目标,并为每个框选的虫蛀树木标注了相应的类别信息,这些标记数据以txt格式保存。

为了确保训练出的模型能够在不同场景下有效运行,按照7∶2∶1的比例将数据集分为训练集、测试集和验证集。这一步骤是为了在训练过程中验证模型的性能,并在训练结束后评估其在新数据上的泛化能力,如图5所示。通过这些详细步骤和严格的数据管理,确保了模型在实际应用中能够达到高效准确地检测和识别虫蛀树木。

2. 3评价指标

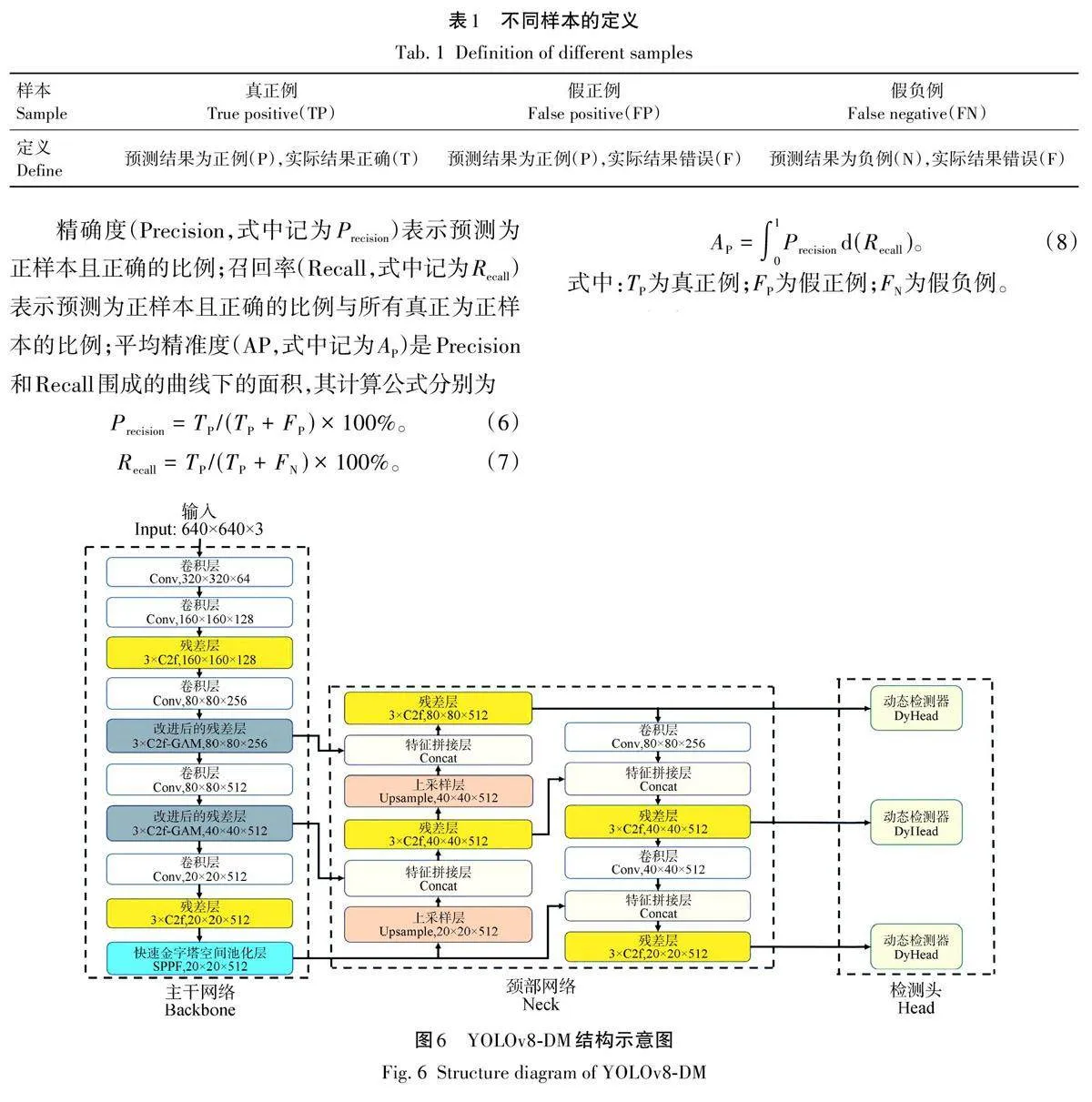

采用精确率(Precision)、召回率(Reccall)和平均精确率(Average Precision)作为主要评价指标,这些主要的评价指标所使用的不同样本的定义见表1。

2. 4YOLOv8-DM算法试验与分析

本研究通过增加动态检测头来提高YOLOv8s对于虫蛀树木的检测精准度。同时采用C2f-GAM关注图像中的局部信息和全部信息来保证下游的任务准确性,如图6所示。

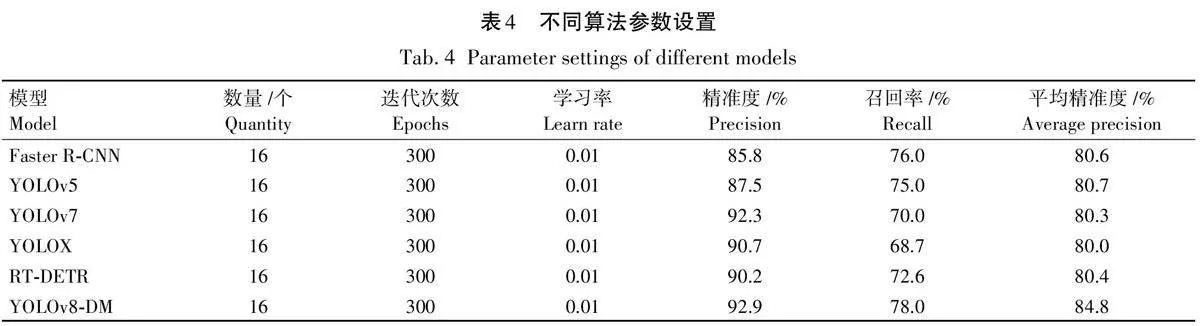

基于YOLOv8s模型的基础上,通过使用不同模块的试验比较,验证了用C2f-GAM代替原C2f的优点,试验结果见表2。由表2 可以看出,采用C2f-GAM代替原YOLOv8s的C2f,检测平均精确度提升了2. 1%。这是因为C2f-GAM通过全局注意力机制能够更好地捕捉和提取在光照不充分环境下的微弱特征,使模型能够更准确地识别目标;通过全局特征关注,可以有效过滤掉不相关的背景信息,集中注意力在目标物体上,从而提高检测的精度;将动态检测头(DyHead)代替原网络中的检测器,平均精确度提升了1. 3%。DyHead能够从不同尺度的特征图中提取和融合信息,使模型在处理不同大小的目标时表现更佳。这种多尺度特征聚合机制使得模型在检测多目标时都能保持较高的准确度。特别是针对梢斑螟虫蛀树木的检测任务,在光照不充分的环境下,目标物体的特征可能不明显。C2f-GAM通过全局注意力机制,可以更好地捕捉和提取这些微弱的特征,使模型能够更准确地识别目标。通过将2种改进方法结合,YOLOv8-DM模型在各种复杂环境下对梢斑螟虫蛀树木特征的检测性能显著提升,平均精准度提高3. 7%。

根据表2数据,YOLOv8-DM在参数量和计算量方面具有明显优势。其参数量为10 862 127,少于YOLOv8s和YOLOv8s+C2f-GAM,提升了检测效率。其计算量为28. 3,虽略高于YOLOv8s和YOLOv8s+DyHead,但保持较好的平衡。结合优异的精确率、召回率和平均精准度,YOLOv8-DM实现了高效计算与出色性能的理想平衡,增强了在光照不充分和背景复杂环境下的检测能力,有效识别梢斑螟虫蛀树木,提升了YOLOv8s模型的整体性能,适用于实际应用。

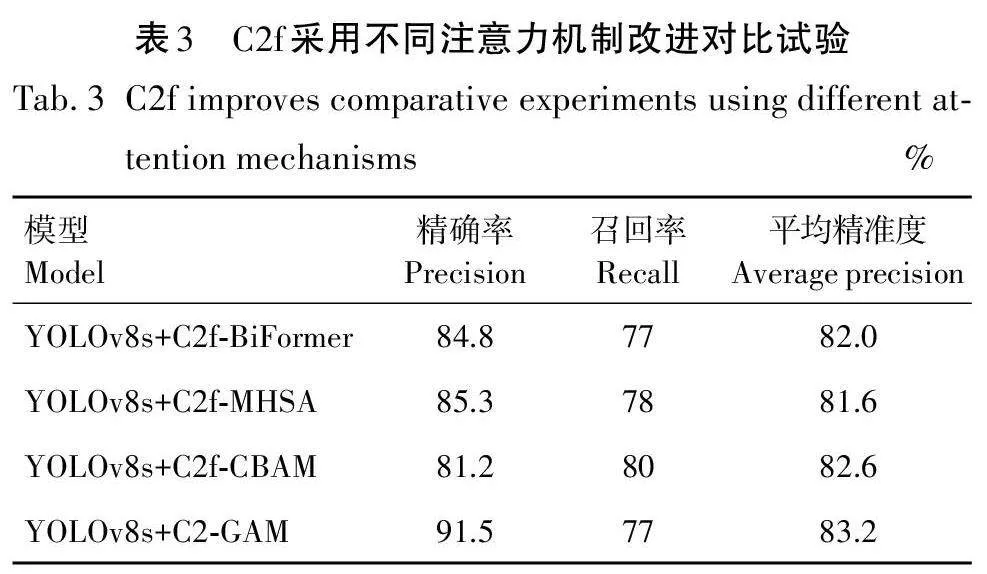

本试验旨在通过替换C2f 中的不同注意力机制,系统地评估这些注意力机制对模型性能提升的有效性。首先,采用多种常见的注意力机制,并将其分别集成到C2f模型中。然后,通过一系列试验,对比不同注意力机制下模型的性能指标。从而为进一步说明C2f-GAM模型在实践中的优势。

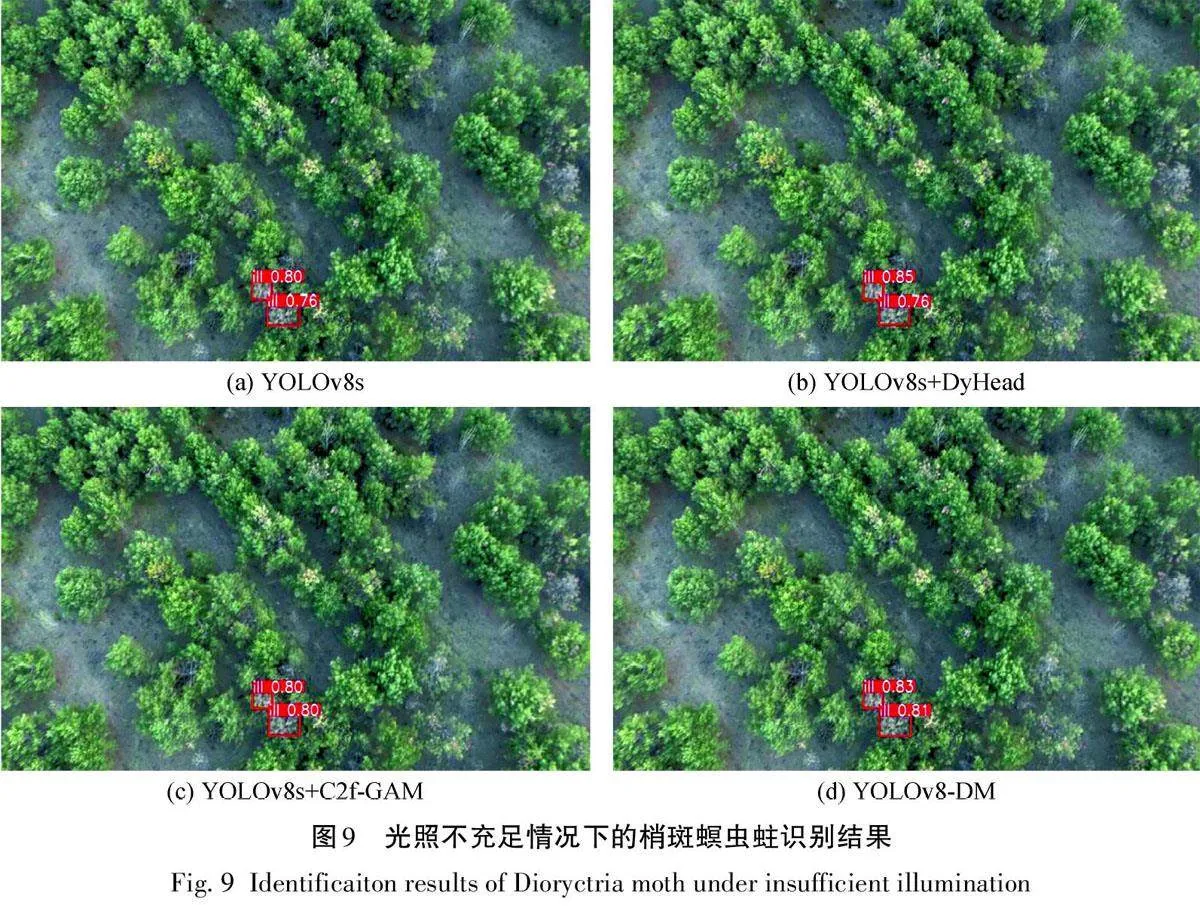

本试验旨在验证C2f-GAM 的有效性。通过替换注意力机制,发现C2f-BiFormer使平均准确度达到82. 0%;C2f-MHSA的设计使平均精准度达81. 6%;C2f-CBAM使平均精准度达82. 6%。而本研究设计的C2f-GAM平均精准度达到83. 2%。根据表3的试验结果,C2f-GAM 在处理图像问题方面表现出色,平均精准度达83. 2%,显著提升了模型检测性能,特别是在应对不同光照条件下的图像处理时表现尤为优异。本研究还通过热力图直观展示了改进后的C2f模型关注点的差异。

图7展示了不同改进C2f模块生成的热力图结果的比较分析。热力图是一种用于生成类激活热图的技术,描绘输入图像对输出预测的贡献分布。在这些热图中,红色更明显和更深的位置表示在输入图像中的相应位置具有更高的响应和对网络的更大贡献。

由图7可知,本研究通过热力图的方式展示不同改进C2f模块在识别梢斑螟虫蛀树木时的关注点位置。试验结果表明,不同改进模块在特征关注方面存在显著差异。YOLOv8s+C2f-BiFormer 在图像特征信息的关注方面存在不足,其对图像中关键特征的识别不够全面。这可能是由于其在聚合特征时存在信息丢失,从而导致对目标特征的关注度不足。相比之下,YOLOv8s+C2f-MHSA能够关注更多的特征信息,表现出更好的特征覆盖能力。该模块通过多头自注意力机制,能够在更大范围内进行特征交互,捕捉到更多的上下文信息。然而,其在处理复杂特征时仍存在一定的局限性,未能完全实现对所有重要特征的关注。YOLOv8s+C2f-CBAM 在图像关注度上有所提升,但依然未能达到最佳的全面性。尽管其通过通道和空间注意力机制,增强了对特征图的关注,但在细节特征上仍存在不足,未能完全覆盖所有关键点。本研究采用的YOLOv8s+C2f-GAM在特征关注度方面表现出色,能够更全面地关注图像中的特征信息,从而提供更准确的识别结果。该模块通过融合全局和局部的特征信息,显著提高了模型对重要特征的响应能力,使其在处理复杂图像时表现尤为出色。

通过对比上述4种改进C2f模块的表现可以看出,YOLOv8s+C2f-GAM在处理复杂图像特征时具有显著优势,这也为梢斑螟虫蛀树木的自动识别提供了更可靠的技术支持。这些发现不仅展示不同改进模块的优劣,还为在相关领域的研究和应用提供了重要的参考依据。通过深入分析各模块的热力图表现,可以更好地理解不同注意力机制对模型性能的影响,从而推动更有效的模型改进和应用创新。

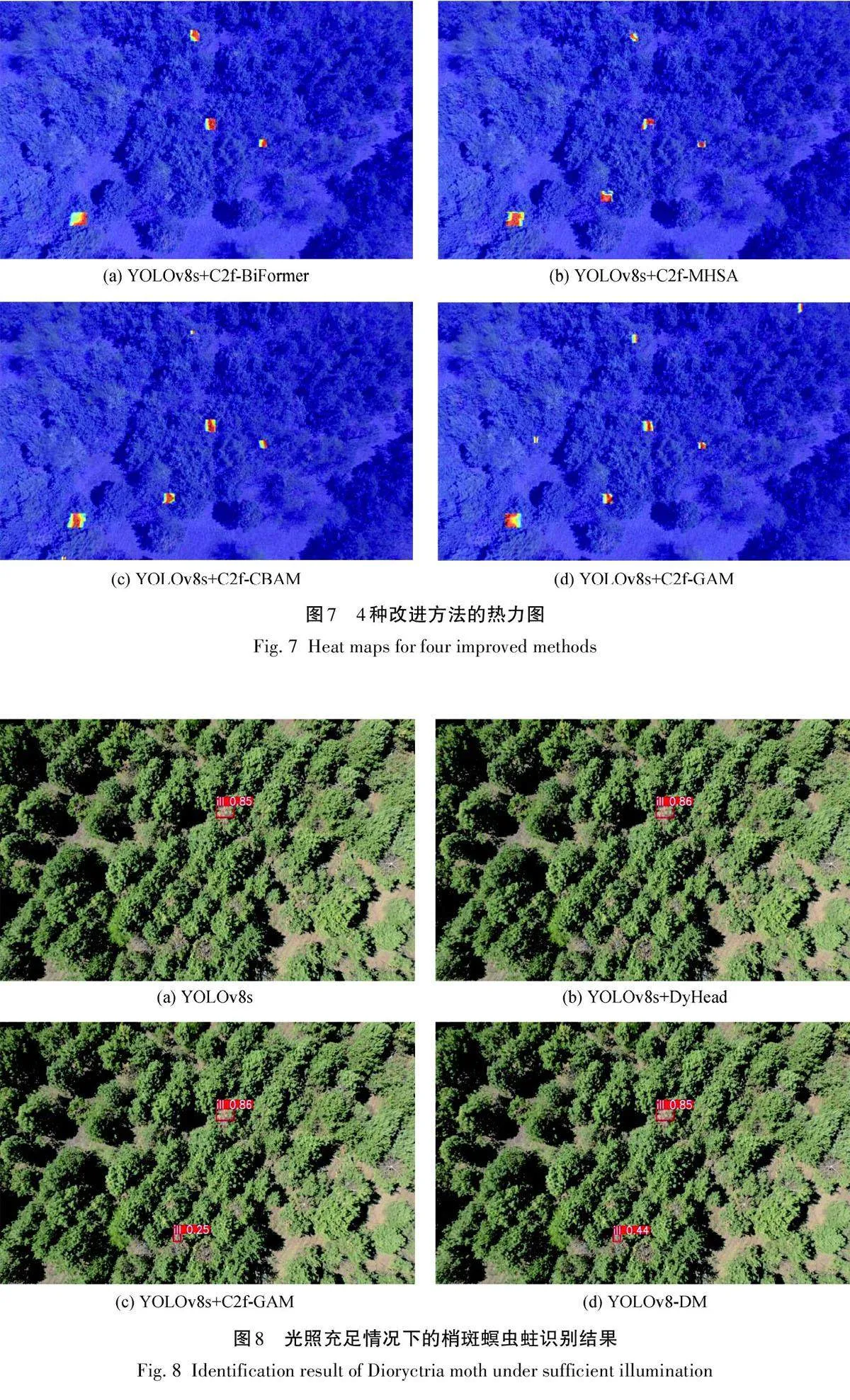

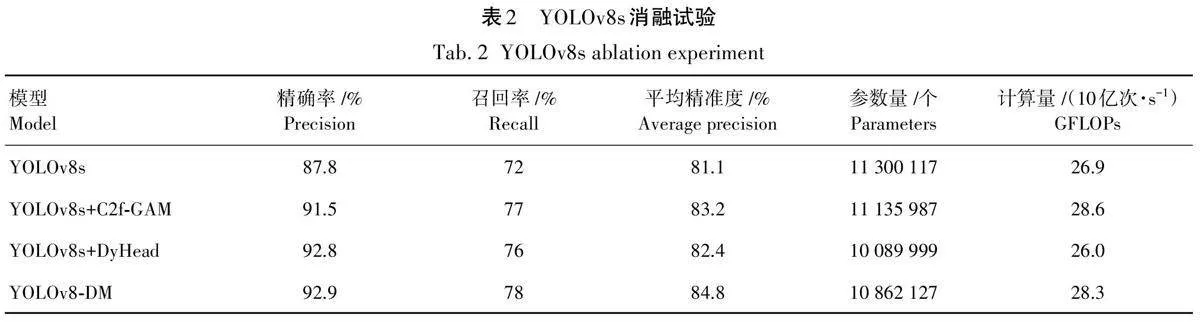

通过改进的YOLOv8-DM可以识别出梢斑螟虫蛀树木在图片中的位置,在光照充足的情况下梢斑螟虫蛀树木识别精准度可以达到80%以上,如图8所示。在光照不充分的情况下通过采用2种改进方式可以让模型识别精准度也在80%及以上,如图9所示。

由图8可知,通过改进的YOLOv8-DM模型可以准确识别梢斑螟虫蛀树木的位置,在光照充足的情况下,该模型的识别精准度可达80%以上,其能有效捕捉目标特征并应对干扰环境。由图9可知,添加C2f-GAM模块后,YOLOv8s模型在光照不足的情况下检测精准度提高至80%,证明了其在复杂背景下的优势。此外,DyHead通过多尺度特征聚合,进一步增强了模型在多目标上的表现,提高了不同光照条件下的鲁棒性和准确性。试验证明,YOLOv8-DM模型在多种光照条件下均能保持高精度检测,使YOLOv8-DM模型在识别梢斑螟虫蛀树木方面达到了更高的平均精准度,有效解决了漏检问题。

2. 5不同算法性能比较

试验使用NVIDIA GeForce RTX 3060 GPU、Py‐Torch:1. 12. 0、CUDAToolkit:11. 6、cuDNN:8. 3. 2。具体的训练参数设置以及不同模型性能详见表4。

本研究对YOLOv8-DM目标检测算法、YOLOv5目标检测算法、YOLOv7 目标检测算法和Faster-RCNN目标检测算法在梢斑螟虫蛀树木测试集上进行了检测和识别,并展示了在不同指标下的详细结果。由表4可以观察到,本研究的YOLOv8-DM算法在精度方面表现出色,具有92. 9%的精确率,同时在召回率方面取得78. 0%,最终实现84. 8%的平均精准度。与其他算法YOLOv7、YOLOv5 和Faster-RCNN相比,该模型显示出更高的精准率、召回率和平均精准度,这意味着YOLOv8-DM 在识别虫蛀树木方面具有更出色的性能。

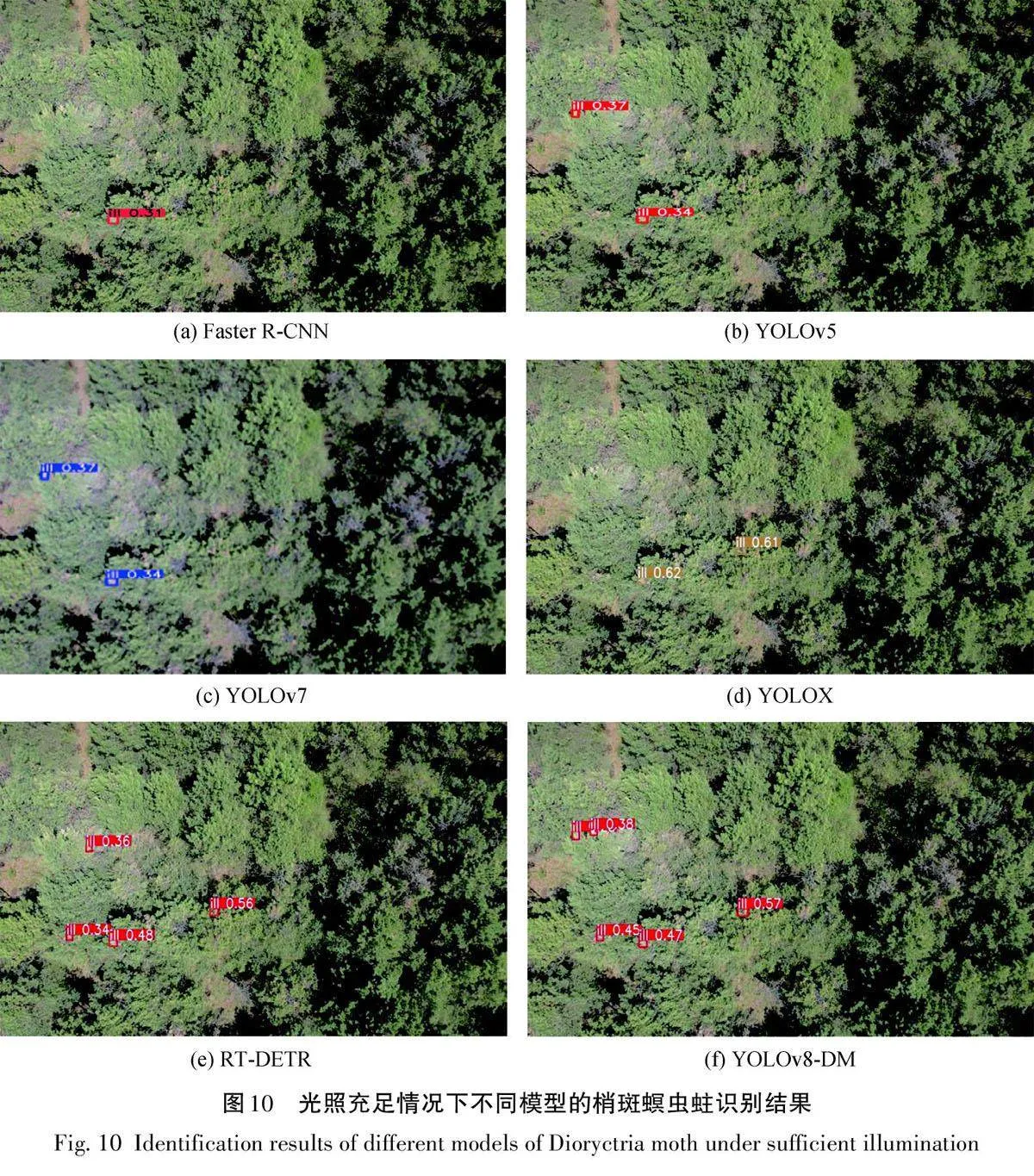

总之,YOLOv8-DM算法的性能在各方面均优于其他算法,这使其非常适合作为梢斑螟虫蛀树木检测与识别的首选算法,为梢斑螟虫蛀树木的检测与识别提供了有力支持,试验结果如图10和图11所示。

本试验采用几种经典的目标检测模型与本研究提出的YOLOv8-DM模型进行对比。经典模型包括Faster R-CNN、YOLOv7、RT-DETR、YOLOX 以及YOLOv5,这些模型在过去的研究中已经被广泛应用和验证。试验结果表明,在多个评估指标上,YOLOv8-DM的表现均超过了对比模型,尤其是在平均精准度(AP)和召回率(Recall)方面,取得了显著的提升。此外,在实际检测任务中,YOLOv8-DM对于漏检问题有了很大的改善。传统模型在面对复杂背景或多目标时,往往会出现漏检的情况,而YOLOv8-DM通过改进的网络结构有效地降低了漏检现象。YOLOv8-DM采用了多尺度特征融合技术,使得模型能够更好地捕捉不同尺度的目标,同时还引入了注意力机制,增强了模型对复杂场景中目标的检测能力。总的来说,本研究提出的YOLOv8-DM不仅在试验室环境下表现优异,在实际应用中也展示出了强大的鲁棒性和可靠性。该模型的创新设计为未来的目标检测研究提供了新的思路和方法,具有重要的理论意义和应用价值。

3结论

本研究引入基于YOLOv8s 算法改进的YOLOv8-DM模型,专用于梢斑螟虫蛀树木的检测与识别任务。通过试验结果验证,YOLOv8-DM模型在准确性和性能方面明显优于Faster R-CNN、YOLOv7、RT-DETR、YOLOX以及YOLOv5算法。未来的研究方向涵盖几个重要的方面:首先,需要扩展梢斑螟虫蛀树木数据集,以进一步提升模型的训练和泛化能力;其次,将深入探索虫蛀树木的检测技术,优化模型以应对更复杂的实际场景,同时,持续优化算法,特别是在提高检测精度和识别能力方面进行探索;最后,研究模型对梢斑螟引起的虫蛀树木图像的识别能力,以增强模型的全面性和适应性。这些努力将有助于推动梢斑螟虫蛀树木检测技术的进一步发展,为林业管理和保护工作提供更为有效的支持。