基于条件随机场和斯塔克尔伯格模型的决策系统研究

【摘" 要】文章依托驾驶模拟器平台,对CarSim、Simulink和VeriStand等软件进行设置,搭建硬件在环仿真平台,使用头部姿态估计网络算法检测头部姿态,采集试验数据。建立基于条件随机场的驾驶意图在线识别系统,对左换道、右换道和车道保持3种驾驶意图进行识别,与隐马尔可夫模型对比,证明该系统能够稳定输出驾驶员的驾驶意图。建立基于斯塔克尔伯格博弈模型的人机共驾决策系统,设立仿真试验场景,验证基于驾驶意图识别的人机共驾决策系统的有效性。

【关键词】驾驶模拟器;条件随机场;驾驶意图识别;斯塔克尔伯格博弈模型

中图分类号:U463.6" " 文献标识码:A" " 文章编号:1003-8639( 2024 )08-0006-06

Research on Decision-making System Based on Conditional Random Fields and Stackelberg Models

ZHANG Heng,CHEN Huanming,LI Xuehan

(College of Mechanical and Electrical Engineering,Automotive Dynamic Simulation Laboratory,

Qingdao University,Qingdao 266071,China)

【Abstract】Based on the driving simulator platform,this paper establishes a hardware-in-the-loop simulation platform using software such as CarSim,Simulink,and Veristand. The head attitude estimation network algorithm is utilized to detect head attitude and collect experimental data. Furthermore,an online recognition system of driving intention based on conditional random field is developed to accurately identify three driving intentions: left lane change,right lane change,and lane keeping. The effectiveness of the system is demonstrated by comparing it with the hidden Markov model in terms of stable output of driver's driving intention. Additionally,a human-machine co-driving decision-making system based on Stackelberg game model is established and its effectiveness is verified through a simulation experiment scenario.

【Key words】driving simulator;conditional random field;riving intention recognition;Stackelberg game model

1" 前言

高级驾驶辅助系统(ADAS)成为解决因人为因素导致交通事故问题的重要技术,并逐渐成为车辆标配系统。现阶段的ADAS仍处于2级驾驶自动化,距离3级驾驶自动化仍有差距。除技术方面的不足外,事故责任的划分也让各大厂商对将自动驾驶汽车投放市场举棋不定,因而未来搭载ADAS系统的汽车仍将在市场中占有较大比例。

目前大部分ADAS系统仍属于自成一环,其探测、决策乃至部分执行都是不考虑驾驶员意图的,会导致部分决策偏离驾驶员的想法乃至完全相反。驾驶员作为交通-驾驶员-车辆的中心环节,其驾驶操作应得到重视。通过识别驾驶员的驾驶意图,能够让其成为机器决策的重要参考,降低人机冲突概率,提高机器决策的正确性,减少驾驶员因机器决策导致的不适感。对于驾驶意图的研究,众多科研人员提出了许多识别方法。算法方面,长短时记忆网[1]、支持向量机[2]、隐马尔可夫[3]、贝斯叶网络[4]、反向传播神经网络[5]和条件随机场[6]等算法在驾驶意图识别方面效果较好,受到广泛应用。此前对驾驶员意图的研究多集中于纵向[7],研究成果较多且实用性高,在此基础上许多学者开始研究更为复杂的横向驾驶员意图。

基于以上问题,本文通过头部姿态和车辆运动数据,基于条件随机场算法,研究驾驶员操作意图,实现驾驶意图识别,并对自车和其他车辆博弈问题进行研究,建立斯塔克尔伯格模型,决策换道时机,对降低驾驶员工作量、ADAS决策偏离导致的不安感、提高驾驶安全性等都具有重要意义。

2" 试验数据采集

2.1" 驾驶模拟器

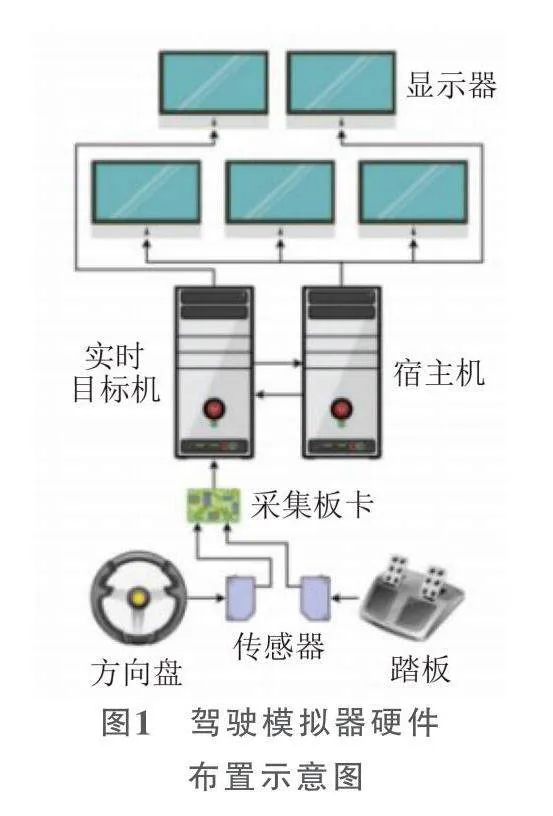

本文需要记录驾驶员在行车过程中的操作数据为驾驶员的意图识别提供试验样本。驾驶员的数据采集可分为两类:实车采集和基于硬件在环仿真的方式采集[8]。在综合考虑硬件设备、数据采集方便性、驾驶员行车安全性等多方面因素,本文选取驾驶模拟器来采集驾驶人的行车试验数据。驾驶模拟器硬件布置示意图如图1所示。

驾驶模拟器可基于宿主机上的仿真软件CarSim搭建试验环境和模拟试验车辆,经由传感器检测得到转向盘和踏板的输出数据,通过VeriStand将传感器的数据由实时目标机传送给宿主机,在CarSim中计算车辆的行驶状态和车辆与道路的交互情况,实现硬件在环仿真。为了尽可能模拟在实车中的驾驶体验,该模拟器由3块显示器组合输出试验场景,让试验人员的视野尽可能与实车相近。由2块显示器展示目标机的状态和控制试验进程,安装摄像头观察记录试验人员的驾驶行为。驾驶模拟器如图2所示。

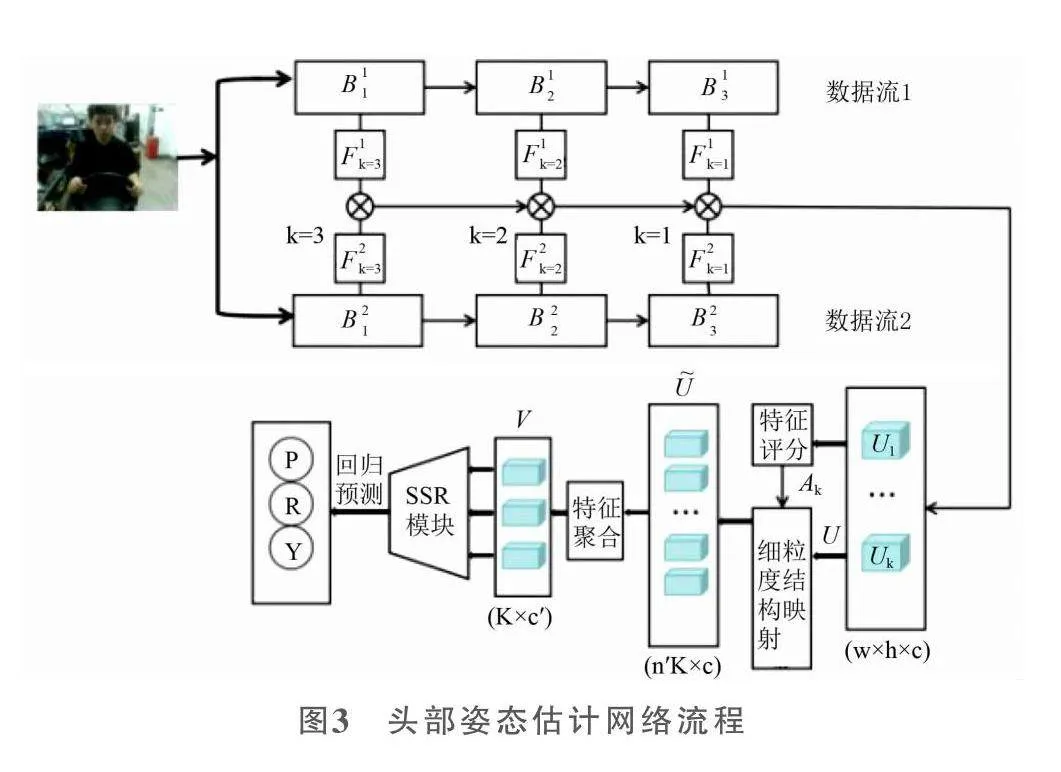

2.2" 头部姿态估计网络

头部姿态估计网络是一种以单张图像就可进行姿态估算,且不需要提供人脸关键点,直接对人脸的姿态进行回归估计的方法[9]。本文以头部姿态估计的理念为基础,把采集到的视频数据进行逐帧计算,得到最终的试验数据。本文使用头部姿态估计网络模块,在框架内实现人脸的姿态估计,头部姿态估计网络流程如图3所示。

2.3" 试验模拟环境

按照道路行车规范的要求,驾驶员在弯道等特殊行车工况下禁止换道,因此本文搭建的试验模拟道路为直线车道。在车辆行驶方向的各车道上,不同位置放置了车速不同的障碍车辆,保证试验数据的随机性和独特性,避免固定障碍带来的换道决策的雷同和单一,更符合实际的驾驶决策。

选择不同年龄阶段的试验人员15名,均保持良好的行车习惯。为了尽可能减少无效试验数据,试验人员均参加了驾驶模拟器的培训。同时,为了保证试验正常进行和提高试验效率,在试验人员进行驾驶模拟时,配备一名操作员进行现场指导并及时保存试验数据。最终测试人员在70~100km/h的速度区间内采集了45组驾驶数据,包含155次有效换道行为,其中77次左换道,78次右换道。

3" 驾驶意图识别模块

3.1" 选取特征参数

在正常行驶状态下,驾驶员的意图主要分为车道保持(LK)、左换道(LCL)和右换道(LCR)3种,选择的特征参数需满足在左右换道和车道保持时取值的区间不同且差别较大。

综合多方面考量,特征参数的选取分为车辆换道意图参数和驾驶员观察意图参数。车辆换道意图参数选择车身横摆角、转向盘转角、转向盘角速率、横向速度和横向加速度来表征车辆的换道行为。驾驶员观察意图参数选择驾驶员头部横摆角来输出驾驶员头部在横向、纵向的相对角度。

3.2" 识别区段划分

区段的划分主要从车辆换道意图参数换道区段和驾驶员观察意图参数换道区段着手。从试验数据中随机取一段包含换道阶段的数据,以车辆质心越过车道线点为中点,向时间轴前后各取400个采样点,采样时间为8s,对比车辆质心点的横坐标与转向盘转角数据,如图4所示。

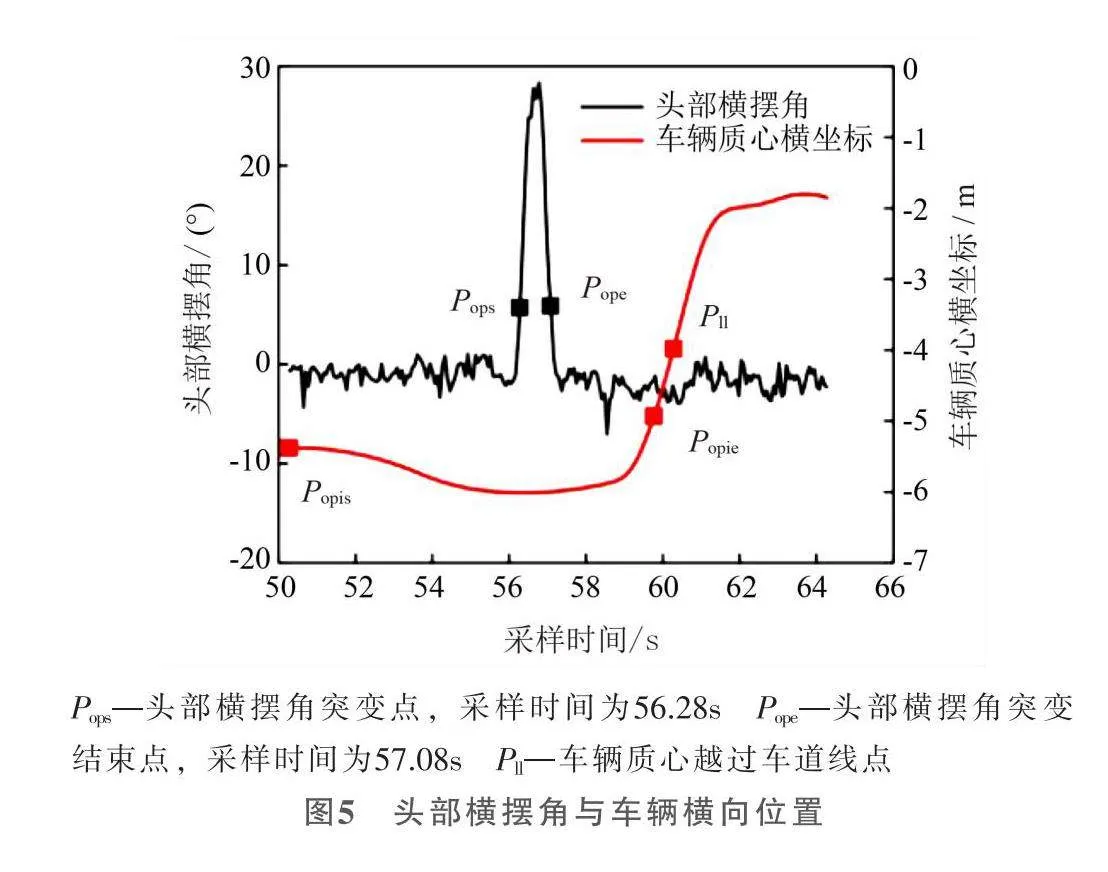

驾驶员会在换道前通过注视两侧后视镜观察临近车道内是否有车辆在换道过程中有可能危及到自车,在该过程中,驾驶员的头部横摆角会发生变化。取图4换道区段中头部横摆角数据,以车辆质心越过车道线点为中点,时间轴向前取1000个采样点,向后取400个采样点,采样时间为14s,如图5所示。

由此,本文确定驾驶员观察意图参数换道区段起始点为车辆质心过车道线前10s,终止点和车辆换道意图参数区段相同,为车辆质心过车道线前0.5s。图5中Popis点—Popie点即为驾驶员观察意图参数识别换道区段。

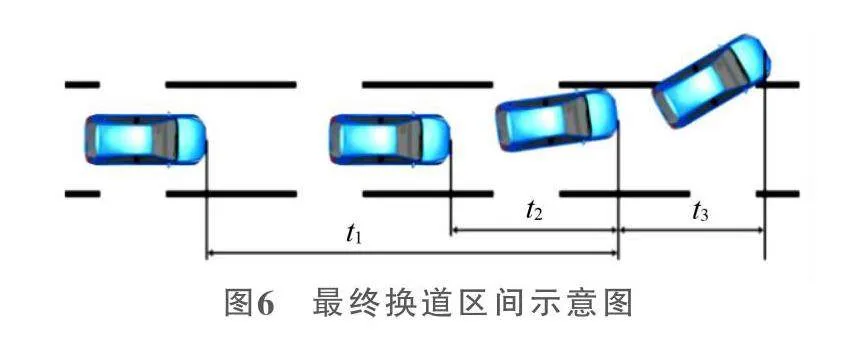

最终换道区间示意图如图6所示。其中t1段为驾驶员观察意图参数区段,长度为9.5s;t2段为车辆换道意图参数区段,长度为3.5s;t3段为从车辆越过车道线到车辆质心过车道线区段,长度为0.5s。

3.3" 条件随机场

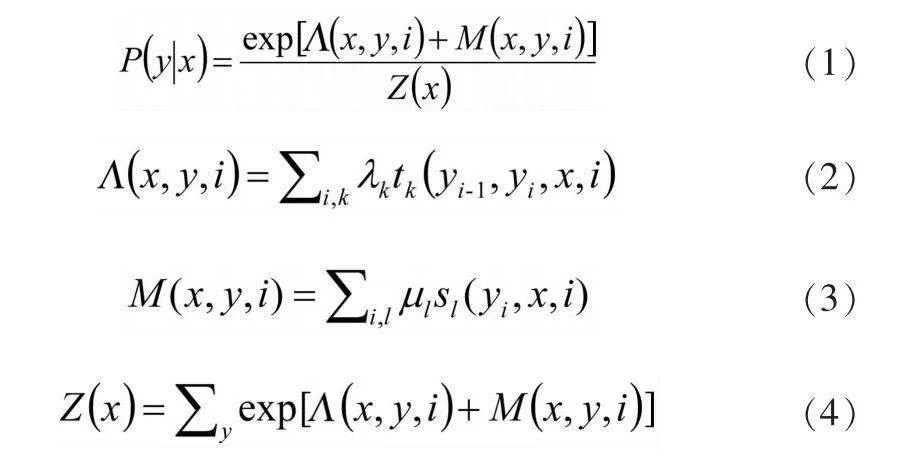

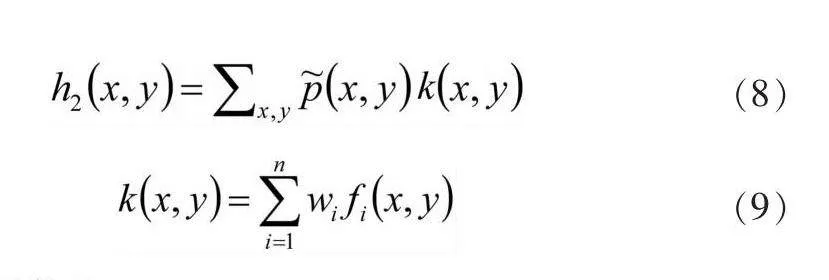

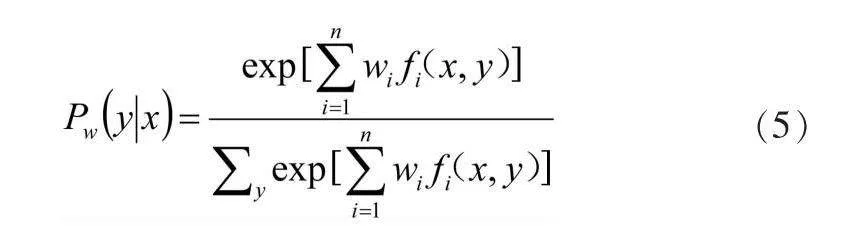

条件随机场(Conditional Random Field,CRF)通过定义特征函数和权重系数来转换成机器可以学习的模型。状态序列y的条件概率为:

式中:Z(x)——归一化因子,是对标签序列所有可能取值求和;tk——转移特征函数;λk——权重系数,依赖于当前节点与前一个节点;sl ——状态特征函数;l——权重系数,只依赖于当前节点。

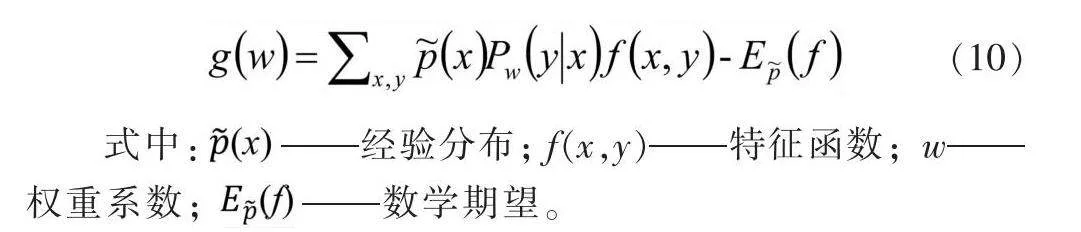

应用BFGS法进行模型学习。对于条件随机场模型:

其学习的优化目标函数为:

其梯度函数为:

式中:" "——经验分布;f(x,y)——特征函数;w——权重系数;" " ——数学期望。

3.4" 模型训练与试验验证

由前文确定换道区间划分方法,并考虑到CRF算法特性,对试验采集到的原始数据进行预处理,将驾驶员观察意图参数和车辆换道意图参数分别提取,以换道点位置为标志分组,并进行数据标记,LCL、LK和LCR分别标记为1、2、3。

前文试验中共采集155次有效换道数据,随机选取60份左换道数据和60份右换道数据作为训练样本,并从未选取的数据中随机挑选20份作为测试样本。为作对比,数据同时导入CRF算法模型和HMM算法模型进行训练。LCL识别结果和概率如图7所示。

图7a中,CRF识别结果与原始数据标记基本一致,而HMM则明显滞后。而图7c中,两者结果和原始数据标记均差别不大,显示出CRF在多参数情况下能有更为优良的识别效果。

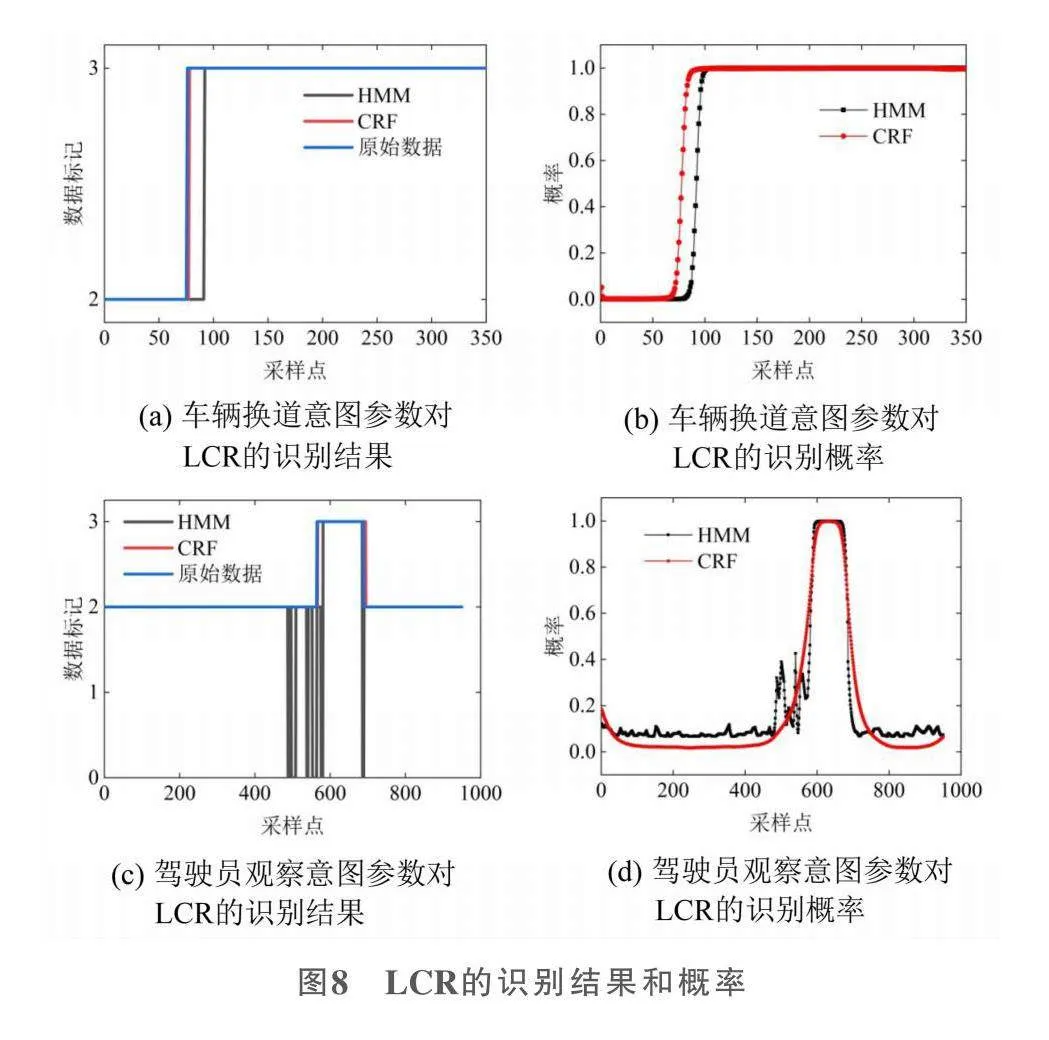

LCR识别结果和概率如图8所示。

LCR的识别结果和LCL基本一致。但图8c中,HMM出现多次识别异常点,有两处长达0.12s,对照图8d,识别概率也发生了较大起伏,而CRF无论识别结果还是概率都比较平稳,表明CRF有更好的识别稳定性。

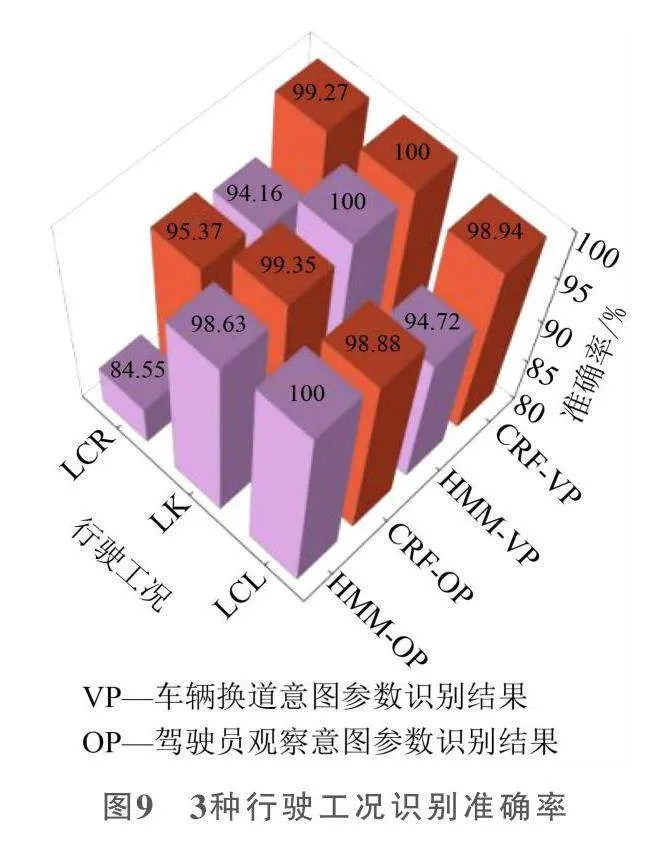

3种行驶工况识别准确率如图9所示。CRF的准确率基本都优于HMM,达到98%以上,能够在车辆质心越过车道线的1.92s前识别驾驶员的换道意图;驾驶员观察意图参数方面,除LCL识别结果外,CRF的识别率相比HMM都具有优势,达到95%以上,能够在车辆质心越过车道线的5.63s前识别驾驶员的换道意图。

借助MATLAB内置计时函数记录两种算法的识别用时,CRF算法的车辆换道意图参数和驾驶员观察意图参数分别为0.0032s和0.0145s,而HMM算法两种意图参数的用时为0.0189s和1.9746s。在对两类参数的识别上,CRF所用时间基本占HMM所用时间的18%以下,在实时性上具有明显的优势。

4" 人机共驾决策系统

4.1" 对旁侧车道车辆碰撞预警

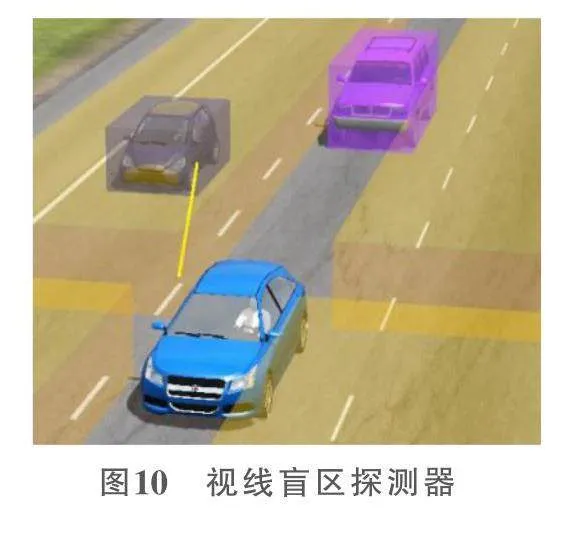

本文在车型C-Class Hatchback2012基础上,在车身加装4个视线盲区探测传感器,探测旁侧车道前后方的车辆,如图10所示。

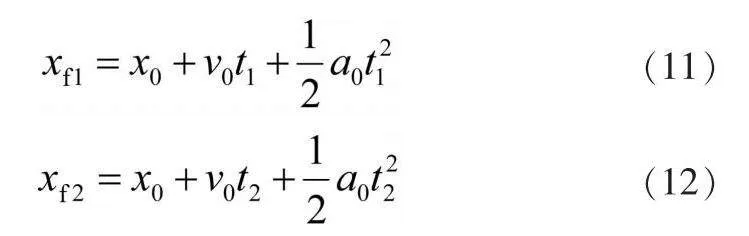

传感器的探测范围为50m,设置输出数据为传感器对探测到车辆的相对位置x0和相对速度v0,并对速度求导,得到车辆的相对加速度a0,利用公式(11)和公式(12)预测车辆的位置。

式中:t1——换道所需时间;t2——安全预留时间,用于防止换道后与车道内车辆距离过近;xf1、xf2——目前的车速和车加速度的情况下,被测车经过t1、t2的时间后与本车的相对位置。本文选择双驾双控人机共驾模式作为换道决策系统的架构进行研究。

4.2" 博弈系统

4.2.1" 斯塔克尔伯格博弈模型

在斯塔克尔伯格模型中,处于主导地位的被称为领导者,而处于较弱一方的被称为跟随者。领导者会首先做出决策,而后跟随者们会根据领导者的决策而决策。与跟随者们不同,领导者会预期到自己的决策对跟随者们的影响,为追求最大收益,领导者会考虑这种影响,在决策时将跟随者的反应函数视为约束条件,此时达到斯塔克尔伯格平衡。

设整体的需求函数为:

(13)

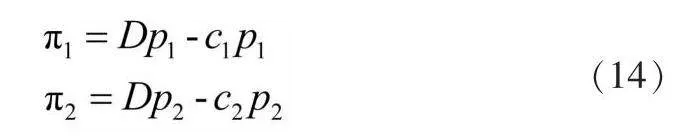

式中:p1和p2——领导者和跟随者的决策。此时,各自的收益分别为:

式中:c1和c2——领导者厂商和跟随者厂商的成本系数。

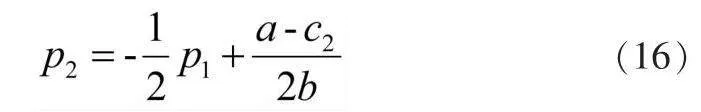

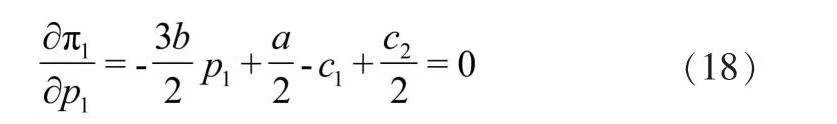

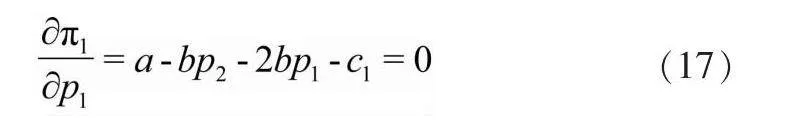

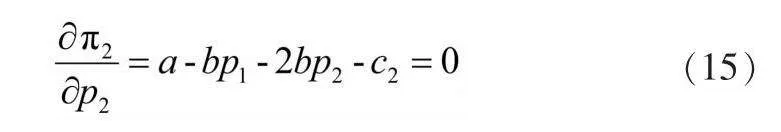

领导者作出决策后,跟随者将考虑领导者的决策做出让自身收益最大化的决策。而其收益最大化的一阶条件是:

即领导者做出决策时,跟随者可以获得最大收益。除此点之外,跟随者的收益会相比更低。可以理解为只要领导者存在,跟随者的最高收益则为定值,无法取得更高的收益。而此时也可得出跟随者的反应函数:

领导者可以根据跟随者的决策做出自己的决策,即该反应函数是领导者决定产量的约束。在跟随者取得最高收益时,领导者能取得收益最大化的一阶条件为:

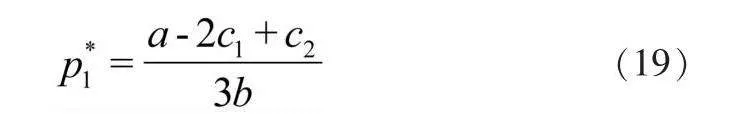

将式(16)带入式(17),得:

此时领导者取得最大收益,其决策为:

将式(19)代入式(16),可得跟随者的决策:

式中:p1*和p2*——领导者厂商和跟随者厂商在达到斯塔克尔伯格平衡时的最佳决策。

4.2.2" 双车博弈收益分析

结合斯塔克尔伯格模型特点,将自车(HV)和换道目标车道内的跟随车辆(FV)分别视为领导者和跟随者,以识别到驾驶员换道意图为博弈开始点,博弈顺序为HV(驾驶员意图)→FV(碰撞预警模块数据)→HV(根据FV数据确定最终收益)。

博弈开始时的道路空间视为总体需求,其随着博弈双方对道路空间的占用而降低,表达形式如下:

式中:Disfin——博弈结束时的道路空间;Disini——博弈开始时的道路空间;xd ——博弈开始时HV与FV的纵向距离;xr——安全预留距离,考虑到驾驶过程中舒适性要求的最大纵向加速度,取值为20m;xl ——HV能够取得的空间;xf ——FV能够取得的空间。

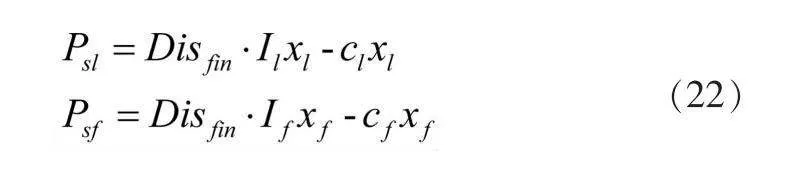

考虑两车信息的差异性,将安全距离收益函数定为如下形式:

(22)

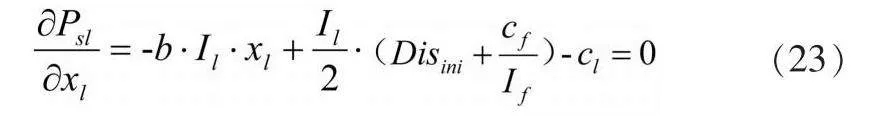

式中:Psl ——HV的安全距离收益函数;Psf ——FV的安全距离收益函数;Il和If ——HV和FV的决心系数;cl和cf ——安全成本系数。

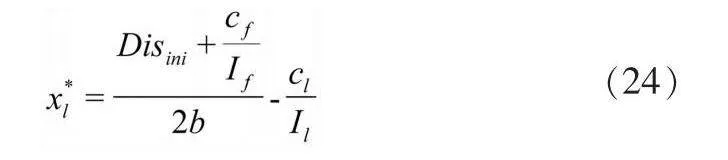

HV取得最大收益时,公式为:

其xl 解即为HV换道后能够获取的安全距离:

(24)

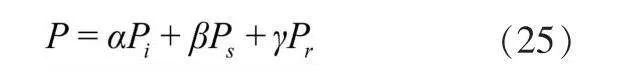

对于HV决定是否换道而言,除安全性外,驾驶员的心理感受和预期以及是否有换道的必要性也是关键的影响因素,由此建立HV换道收益函数:

(25)

式中:α、β和γ——每项的权重,根据场景不同,调整相应取值,匹配不同场景下3种收益的重要性;Pi、Ps和Pr——驾驶意图收益、安全收益和加速空间收益。

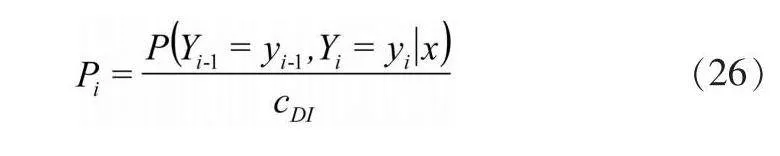

驾驶意图收益函数具体形式如下:

式中:cDI——驾驶员意图稳定系数,取值0.98。

安全收益反映的是换道后能够用于操作的空间大小,其值取决于前文经过斯塔克尔伯格模型博弈后HV能够获取的最大空间,其具体形式如下:

式中:slD ——换道安全限制距离,根据试验数据分析,在单车场景时取值30m。

加速空间收益函数具体形式如下:

当目标车道仅后方有FV时,Pr取值为1;当目标车道前方有FV时,用公式(21)和(22)计算比较HV所在车道前车与目标车道前方FV,FV的xf1和xf2均大于HV所在车道前车时,Pr取值为1,否则为0。

4.3" 场景验证

4.3.1" 后方单车场景

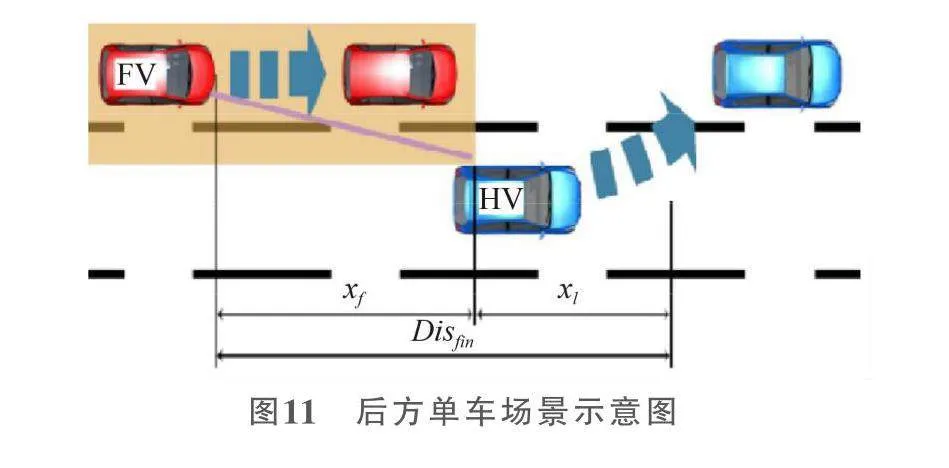

在仅车辆后方有FV时,开始博弈时的道路空间如图11所示。

考虑驾驶意图收益、安全收益和加速空间收益在换道过程中的重要性,取α、β和γ分别为0.3、0.3、0.4。当HV换道收益大于1时,决策换道。从样本中随机挑选一段换道数据,如图12所示。

在Popc点(27.02s)时,通过驾驶员观察意图参数识别到驾驶员换道意图。随后在Ppm点(27.61s)时,HV换道收益大于1,即综合考量驾驶员意图、安全距离和加速空间下适合换道,此时驾驶员换道意图概率为0.99,与FV的相对距离为41.10m;在Pvpc点(29.57s)时,通过车辆换道意图参数识别到驾驶员换道意图,同时开始换道。最后于31.45s车辆质心越过车道线,换道无法终止。整个换道过程中,与FV始终保持安全距离,未发生碰撞。

4.3.2" 前方单车场景

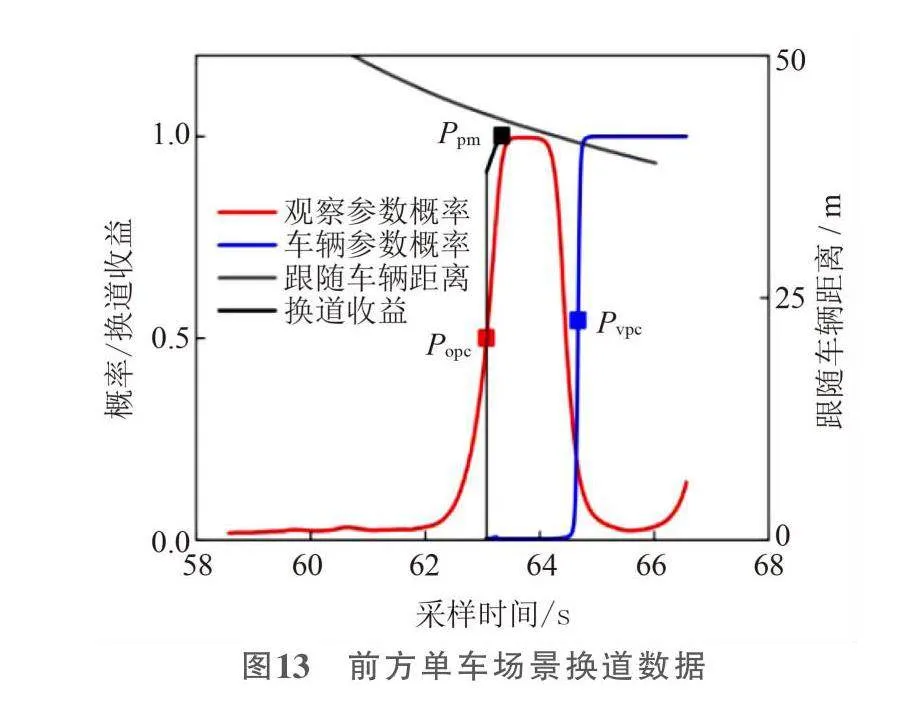

在仅HV前方有FV时,其博弈空间与图11相似,不过跟随车辆在HV前方,显然加速空间是否存在对于换道行为相比后方单车场景更为重要,故取α、β和γ分别为0.2、0.3、0.5。从样本中随机挑选一段换道数据,如图13所示。

在Popc点(63.07s)时,通过驾驶员观察意图参数识别到驾驶员换道意图,随后在Ppm点(63.34s)时,HV换道收益大于1,即综合考虑驾驶员意图、安全距离和加速空间下适合换道,此时驾驶员换道意图概率为0.94,与FV的相对距离为43.39m。在Pvpc点(64.67s)时,通过车辆换道意图参数识别到驾驶员换道意图,同时开始换道。最后于67.06s车辆质心越过车道线,换道无法终止。整个换道过程中,与FV始终保持安全距离,未发生碰撞。

5" 总结

本文以驾驶模拟器为试验平台,采用头部姿态估计网络算法识别头部姿态,搭建硬件在环仿真平台,采集试验数据;建立基于CRF算法的驾驶意图识别模型,能够稳定输出驾驶员的驾驶意图,并验证了该系统能够正确识别驾驶意图;建立基于斯塔克尔伯格博弈模型的人机共驾决策系统,结合驾驶意图收益和加速空间收益进行人机共驾决策,验证了基于驾驶意图识别的人机共驾决策系统的有效性。

参考文献:

[1] Wang S,Zhao X,Yu Q,et al. Identification of driver braking intention based on long short-term memory(LSTM)network[J]. IEEE Access,2020,8(2):180422-180432.

[2] 密俊霞,于会龙,席军强. 基于MLP-SVM的驾驶员换道行为预测[J]. 兵工学报,2022,43(12):3020-3029.

[3] Liu S,Zheng K,Zhao L,et al. A driving intention prediction method based on hidden Markov model for autonomous driving[J]. Computer Communications,2020 (157):143-149.

[4] Song R.Driver intention prediction using model-added Bayesian network[J]. Proceedings of the Institution of Mechanical Engineers,Part D: Journal of Automobile Engineering,2021,235(5):1236-1244.

[5] 郎悦茹. 基于高速公路的驾驶员换道意图识别[J]. 汽车实用技术,2022,47(14):109-112.

[6] 赵岩,陈焕明,王亚伦,等. 基于条件随机场的驾驶行为识别研究[J]. 青岛大学学报(工程技术版),2021,36(1):14-21.

[7] Ju J,Bi L,Feleke A G. Detection of Emergency Braking Intention From Soft Braking and Normal Driving Intentions Using EMG Signals[J]. IEEE Access,2021,9:131637-131647.

[8] 刘志强,吴雪刚,倪捷,等. 基于HMM和SVM级联算法的驾驶意图识别[J]. 汽车工程,2018,40(7):858-864.

[9] Tsun-Yi Yang,Yi-Ting Chen,Yen-Yu Lin,et al. FSA-Net: Learning Fine-Grained Structure Aggregation for Head Pose Estimation From a Single Image[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR). New York:IEEE,2019:1087-1096.

(编辑" 杨凯麟)