人工智能生成内容:可版权性和版权人问题

摘 要:生成式人工智能属于连接主义,具有不可解释性。版权理论中的可版权性和创意/表达两分法本来适用于自然人作者。自然人从创意到表达有可预测性、在创意与表达之间有确定性、从表达到创意有可解释性。人工智能生成内容是应用生成式人工智能技术得到的结果。对于人工智能生成内容,从人类给出创意到生成式人工智能给出表达的过程无法体现创意/表达两分法的可预测性、确定性、可解释性,即创意/表达两分法在人工智能生成内容情况下并不成立。因此,人工智能生成内容并不具有可版权性;人类就不能成为人工智能生成内容的版权人。行为体的概念是人工智能的核心;人工智能旨在构建智能行为体。在人类不能享有人工智能生成内容的版权的情况下,在将可版权性从自然人创作作品拓展到人工智能生成内容情形之后,人工智能行为体在至少具备行为体弱概念的四项特性的条件下就是所生成内容的潜在的版权人。一旦法律主体延伸到人工智能行为体,人工智能行为体就可以确定为人工智能生成内容的版权人。

关键词:人工智能生成内容;生成式人工智能;可版权性;版权人;行为体

中图分类号:D 923 文献标志码:A 文章编号:2096-9783(2024)04⁃0060⁃13

人工智能(Artificial Intelligence,AI)发展日新月异,通过应用生成式人工智能(Generative AI,GenAI)技术所得到的人工智能生成内容(AI Generated Content,AIGC)带来的法律问题层出不穷。本文聚焦AIGC涉及的可版权性问题和版权人问题。首先,给出三方面的预备知识:一是介绍AI两种主要技术路线,即符号主义和连接主义及其在可解释性方面的不同;二是澄清GenAI与AIGC的区别,说明从AI到机器学习、深度学习、GenAI、基础模型、大语言模型(Large Language Model,LLM)、最后到LLM用户接口之间的层次包含关系;三是说明版权理论中自然人创作作品的可版权性和创意/表达两分法原则并给出简明的示意图。其次,讨论AIGC的可版权性问题:在版权理论中引入并给出关于创意/表达两分法的可预测性、确定性、可解释性三个概念的定义,深入阐释自然人创作作品的创意/表达两分法原则,探讨在不同AI技术路线之下的创意/表达两分法和可预测性、确定性、可解释性情况,得出关于AIGC可版权性问题的结论。再次,探索AIGC的版权人问题:介绍AI中agent(行为体)的含义、译名、弱概念和强概念,说明它是AI领域潜在的法律主体,得出在一定条件下关于AIGC潜在的版权人的结论。最后结语中说明,一旦法律主体延伸到AI行为体,它就可以确定为AIGC的版权人。

一、预备知识

(一)AI的技术路线及其可解释性

AI发展历程涉及的两种主要技术路线是符号主义(symbolicism)和连接主义(connectionism)。符号主义也称逻辑主义、功能主义,主张用公理和逻辑体系搭建AI系统;连接主义也称仿生学派、结构主义,主张模仿人类的神经元,用神经网络的连接机制实现AI。下面考察这两种技术路线及其可解释性。AI模型的可解释性(interpretability或explainability),就是用人类可理解的方式来解释AI模型的行为的能力。

应该指出,interpretability / interpretable和explainability / explainable虽然都与机器学习模型的可解释性相关,但它们侧重点不同。前者是模型设计的目标,关注模型的设计和结构,侧重于模型设计时就具备的可解释性,强调模型设计本身的透明度和可理解性;而后者则是提高模型透明度的手段,关注如何为复杂的模型决策提供解释,侧重于对黑箱模型的解释能力,强调对模型决策过程的解释或解释方法的应用。虽然两者都是为了提高模型的透明度和可信度,在实践中可能相互关联,但是实现方式和应用场景有所不同。

1.符号主义AI

人的推理包括逻辑推理和直觉推理,是逻辑推理和直觉推理两者的结合或融合。逻辑推理和直觉推理两者对人的学习都至关重要。符号主义的根本原理就是逻辑推理,逻辑推理的数学理论是数理逻辑。因此,符号主义AI就是基于数理逻辑的AI。符号主义AI不可能实现直觉推理,因而不可能完整实现人的推理。这是它的根本缺陷。因为符号主义AI是基于数理逻辑的,所以它具有可解释性。这里的可解释性侧重于模型设计时就具备的可解释性。

2.连接主义AI

连接主义AI的基本原理是:一个良定义的(well-defined)函数必然可以由一个神经网络来任意逼近。神经网络学习的一个基本假设是:学习的目标是一个良定义的函数。一个神经网络学习过程就是通过大量的已标注实例学习一个神经网络的参数,从而使得该神经网络逼近未知的学习目标,它是一个良定义的函数。连接主义AI就是一个神经网络模型学习。这一学习模型已经取得重要的应用成果,并且正在引领当代机器学习技术的潮流。然而,神经网络学习有若干根本性缺陷,就本文而言,最值得关注的缺陷就是神经网络学习不具有可解释性,即具有不可解释性。这里的可解释性侧重于对黑箱模型的解释能力。而人的学习是具有可解释性的,这就说明神经网络学习跟人学习是不一样的。因为神经网络学习不具有可解释性,所以它在严格科学技术标准要求下的应用是不可信的。

3.符号主义AI与连接主义AI的比较

符号主义AI(符号系统)与连接主义AI(神经系统)的优缺点具有互补性。符号系统(擅长演绎推理)的泛化能力强,具有可解释性,由知识驱动,但不擅长处理非结构化数据,鲁棒性差,推理速度慢;神经系统(擅长归纳学习)擅长处理非结构化数据,鲁棒性强,学习速度快,但泛化能力弱,不具有可解释性,需要大量标注数据。

符号系统善于利用知识,神经系统善于利用数据,而人在做决策时需要知识与数据并存。根据符号系统与神经系统优缺点的互补性,以及人做决策时所需的条件,将两者结合是未来AI发展的主要趋势[1]。

连接主义(神经系统)的不可解释性与本文主题直接相关。

(二)GenAI和AIGC的区别

中文文献中常见“生成式人工智能AIGC”这样的表述。实际上,这样的中英文对照表述是错误的,应该区分GenAI与AIGC。GenAI是指一种AI技术;AIGC是指应用这种技术所得到的结果。二者不应混淆。这一结论可以下面从关于GenAI和AIGC的描述中了解。

1.关于GenAI

GenAI是一种AI技术,可以生成各种类型的内容,包括文本、图像、音频、视频和合成数据。这里的合成数据(synthetic data)是指由人工制造的而不是由真实世界的事件产生的信息,它通过算法创建,用作生产或运营数据的测试数据集的替代品,用于验证数学模型和训练机器学习模型[2]。最近关于GenAI的热议是由新用户界面的简便性推动的,这些界面可以在几秒钟内创建高质量的文本、图像、音频和视频。当然,这项技术并非全新,早在 20 世纪 60 年代的聊天机器人中就已出现GenAI。但是直到 2014 年,随着一种机器学习算法生成式对抗网络(GAN)的引入,GenAI才能够创建出令人信服的真实人物的图像、音频和视频。

GenAI产生如图像、音频和视频之类多模态的新内容的能力,特别是生成语言的能力,吸引了公众的想象力,创造了各种潜在的应用。下面的图1和图2说明从AI到机器学习、深度学习、GenAI、基础模型、LLM、最后到(ChatGPT和Bard之类的)LLM用户接口之间合计七层的层次关系。

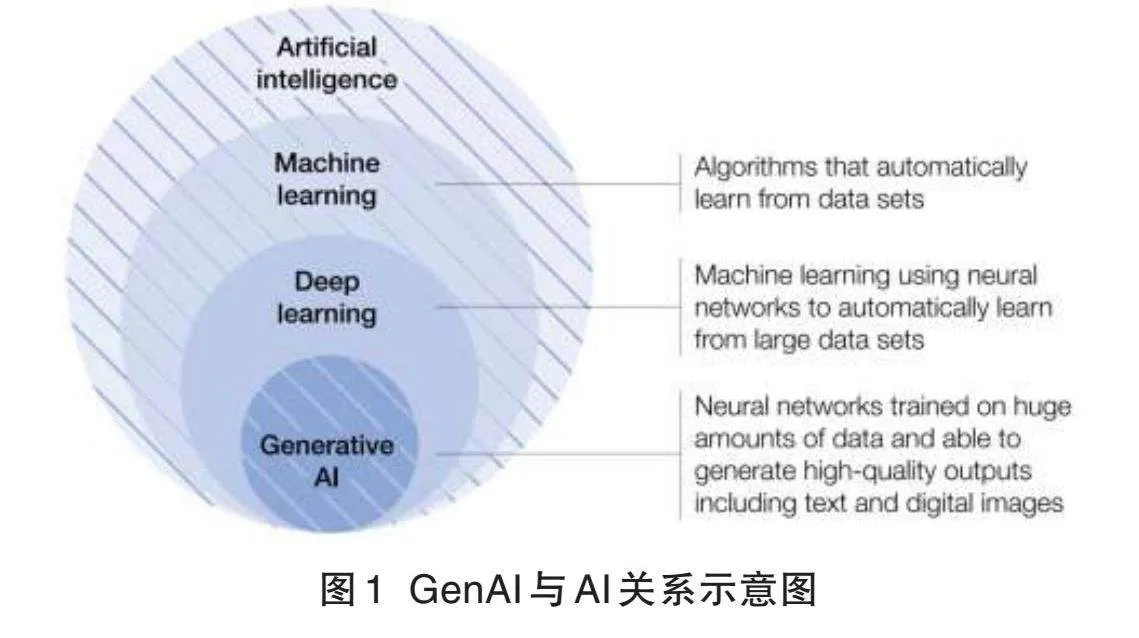

GenAI适用于更广泛的AI领域,如图1所示[3]。

图1中从外向内的四层依次是:(1)AI;(2)机器学习:从数据集中自动学习的算法;(3)深度学习:使用神经网络从大数据集中自动学习的机器学习;(4)GenAI:基于大量数据进行训练并能够生成包括文本和数字图像在内的高质量输出的神经网络。生成内容的模型并不新鲜,在过去十年中一直是研究的主题。然而,ChatGPT于2022年11月的推出则大大提高了公众对该技术的认识和兴趣,并引发可用的GenAI产品市场的加速。除了ChatGPT,其他众所周知的GenAI应用程序,包括Claude、Bard、Bedrock和Dall-E,它们都是LLM。

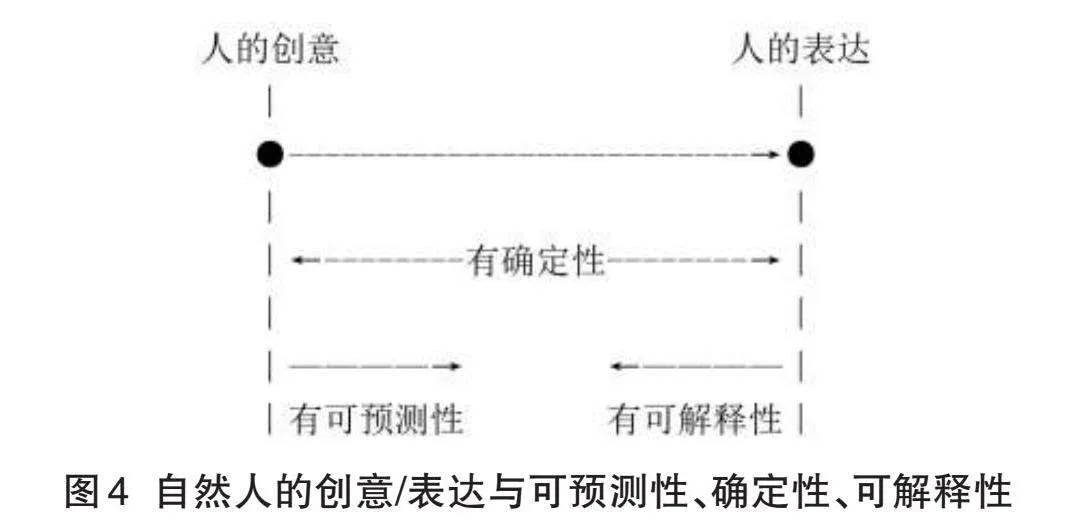

公共LLM的接口适用于GenAI领域,如图2所示[3]。

图2中从外向内的四层依次是:(1)GenAI;(2)基础模型:在大量数据上训练的通用模型;(3)LLM:经过文本训练并能够解释和生成高质量的输出的基础模型;(4)用户接口如ChatGPT和Bard:具有访问LLM的简单用户界面的公共可用服务。这里的基础模型是在超大数据集上训练的大型神经网络,以产生与这些数据集相似的响应。基础模型可能不一定是基于语言的,它们可能是在非文本数据上训练的,如生物化学信息。这里的LLM是专门针对文本和自然语言数据进行训练的基础模型,用于生成高质量的基于文本的输出。基础模型和LLM的用户界面是用户友好的方式,没有技术经验的人可以使用基础模型或LLM。ChatGPT和Bard就是这样的例子。目前,它们大多是通过特定工具的统一资源定位器(URL)访问的,但在不久的将来,它们很可能会嵌入其他消费者软件和工具中。

GenAI是通过使用通常从互联网上获取的大量数据、在数据的基本模式和结构中训练模型而工作的。经过多轮训练,有时只涉及机器,有时涉及人类,该模型能够生成新的内容,类似于训练示例。当用户给出提示或输入时,GenAI会根据从训练数据中学到的知识来评估各种可能反应的可能性。然后,它会选择并呈现适合给定提示的概率最高的回复。从本质上讲,它是利用训练数据为用户的输入选择最合适的回复[3]。

2.关于AIGC

AIGC(人工智能生成内容)也称为AI创造的(created)内容,是PGC(专业生成内容)和 UGC(用户生成内容)的进阶,通俗地讲,是指使用先进的GenAI技术生成的内容,它可以在短时间内自动创建大量内容,而不是由人类作者创建内容;从技术上讲是指给定有助于教授和指导模型完成任务的人工指令、利用GenAI算法生成满足指令的内容。这样的生成过程通常包括两个步骤:从人类指令中提取意图信息,然后根据提取的意图生成内容。

AI内容生成器(content generators)有多种形式。以OpenAI的产品为例,ChatGPT是用于构建会话式AI系统,该系统可以以有意义的方式有效地理解和响应人类的语言输入;DALL-E能在几分钟内从文本描述中创建独特且高质量的图像;Sora是最先进的文本转视频生成模型,代表了AI在视频内容创作领域的一次重大突破,它能根据用户输入的文本描述,生成长达60秒的高质量视频,这些视频不仅视觉质量高,而且与用户的文本提示高度一致。

(三)自然人创作作品的可版权性和创意/表达两分法

1.自然人创作作品的可版权性

版权法赋予版权人权利以控制对于受版权保护的作品的某些使用,同时也赋予用户在未经版权人许可的情况下对这些作品进行某些使用的权利。作品创作完成,版权自动产生,不需要履行任何手续。尽管获得版权非常容易,但它只适用于可版权的(copyrightable)作品。可版权性(copyrightability)即受版权保护性,是作品获得版权保护所需具备的要件。这是在自然人作者意义下的可版权性。AIGC是否具有可版权性则是本文讨论的问题。

以美国版权法为例,版权只保护“固定在任何有形表达媒介中的原创作品”,也就是说,要有资格获得版权保护,作品必须具备下列要件:(1)原创:要获得原创资格,作品必须是独立创作,并且必须“至少有一点”创造力;(2)作者的作品:包括文学作品、音乐作品、绘画、图形和雕塑作品、视听作品和录音,以及许多其他类型的有创造力的作品;(3)固定:作品还必须由作者或在作者授权下“固定在有形的表达媒介中”。

2.自然人创作作品的创意/表达两分法

创意/表达两分法(idea/expression dichotomy)是版权理论的一个重要原则,也称为创意/表达区分(idea/expression distinction)原则,是指版权保护创意的表达但不保护创意本身。该原则本来适用于自然人作者的情形。AIGC能否适用该原则也是本文讨论的问题。

创意/表达两分法的一个例子是必要场景原则(scènes à faire doctrine),就是说当作品的一个元素在特定类型中是惯例时它就是不可保护的,也可以说,它是确保流行场景或情节元素不受版权保护的原则。创意的任何不寻常的实现都可能受到版权保护,但是版权只适用于原创的有创造力的表达,而不适用于基本的场景或惯例。创意/表达两分法的另一个例子是“创意/表达合并”(the merger doctrine)原则,就是说当只有一种或几种可能的方式来表达一个创意时,该表达就不受版权保护,因为该表达的版权一旦赋予某人就会有效地锁定这个创意。

笔者曾经给出如图3所示的创意/表达两分法原则示意图[4]。

图3的图例中的A和B代表某个范畴。在图3中,实际包含版权理论中的六个范畴(作者、创意、表达、作品、内容、形式),可用两句话阐释这六个范畴之间的内在联系:“作者的创意的表达是作品,作品是其内容和形式的有机统一。[4]”

二、AIGC的可版权性问题

科学技术语境和法学语境是两种不同的语境。科学技术专家和法学专家在自己的语境里可以自圆其说,但这两种语境具有不可通约性/不可公度性(incommensurability)。不可通约性由科学哲学家库恩提出[5],可理解为不同学术范式之间无法进行比较。通约/可通约性(commensurability)源自数学中分数加减运算时的通分与约分。如果几个数之间同时存在一个公约数,称为可通约,否则称为不可通约,公约数中最大的即最大公约数。如今学界常引申通约之意,在表述属性或本质相同的两种事物关系时称“两者可以通约”。当然也有引用于描述事物、文化之间的互通性和共同之处。

创意/表达两分法的成立是自然人创作作品的可版权性成立的前提条件。为了解决科学技术语境与法学语境的不可通约性问题,下面分别借鉴管理学、经济学、人工智能科学中可预测性、不确定性、可解释性的定义,在版权理论中引入可预测性、确定性、可解释性三个概念,给出关于创意/表达两分法的可预测性、确定性、可解释性的定义,对创意/表达两分法原则进行深入阐释,进而探讨在不同AI技术路线之下的创意/表达两分法和可预测性、确定性、可解释性情况。

(一)自然人作品创作过程中的可预测性、确定性、可解释性

1.自然人从创意到表达的可预测性

在给出作品创作过程中的可预测性定义时,可以借鉴从术语在线网站1的“可预测性”词条查到的全国科学技术名词审定委员会2018年公布的《管理科学技术名词》在“管理科学技术—运筹与管理—预测理论与方法”项下关于“可预测性”(predictability)的定义,即“根据过去的经验,能在某种范围内对研究对象将来可能发生的变化进行估计、分析和推断的特性。”

因此,自然人的作品创作过程中从创意到表达的可预测性(predictability)是指在作品创作过程中作者根据自己的创意在某种范围内对自己将要给出的表达进行估计、分析、推断的特性。

既然作品是作者创意的表达,那么,已经有创意的作者对其将要给出的(不论是何种形式的)表达事先就存在可预测性;创意/表达两分法体现了自然人从创意指向表达的可预测性;作者的创意与创意的表达之间的关系是可预测的。

2.自然人在创意与表达之间的确定性

可以先给出自然人的作品创作过程中创意与表达之间的不确定性(uncertainty)的定义,进而得出确定性(certainty)的定义。

在给出作品创作过程中的不确定性定义时,可以借鉴从术语在线网站2的“不确定性”词条查到的全国科学技术名词审定委员会2020年公布的《经济学名词》,在“经济学—微观经济学”项下关于“不确定性”(uncertainty)的定义,即“经济主体既不能确定某种经济事件在未来产生的结果,也不能确定经济事件产生各种结果的可能性大小。”

因此,自然人的作品创作过程中创意与表达之间的不确定性,可定义为作者既不能确定某种创意在未来产生的表达,也不能确定创意产生各种表达的可能性大小。由此“不确定性”的定义可得“确定性”的定义。自然人的作品创作过程中创意与表达之间的确定性,是指作者能确定某种创意在未来产生的表达,或者作者能确定创意产生各种表达的可能性大小。

显然,在自然人的创意与表达之间只有确定性而没有不确定性。

3.自然人从表达到创意的可解释性

与AI模型的可解释性相关,可解释的AI(explainable AI, XAI)研究使人类能够理解模型的内部运行逻辑和决策结果,为模型的故障排除和广泛使用提供方便。美国国家标准与技术研究院(NIST)于2021 年 9 月发布关于XAI的四项原则[6] ,即对于那些旨在可解释性或需要可解释性的AI系统,建议遵守下列四项原则:(1)解释(explanation)——系统为输出和/或进程提供或包含随附的证据或理由;(2)有意义(meaningful)——系统提供对预期消费者来说是可以理解的解释;(3)解释准确度(explanation accuracy)——解释正确反映产生输出的原因和/或准确反映系统的进程;(4)知识限度(knowledge limits)——系统只有在其设计的条件下并且当其输出达到足够的置信度时运行。

借鉴XAI的可解释性概念可以定义自然人作品创作过程中从表达到创意的可解释性,就是用给出的表达来解释初始的创意的能力。从XAI的四项原则可以引申出从表达到创意的可解释性的四项要素:(1)解释——对表达提供或包含随附的证据或理由以解释创意;(2)有意义——关于创意的解释对表达的预期受众来说是可以理解的;(3)解释准确度——解释正确反映产生表达的创意;(4)知识限度——从关于创意的解释可以识别出创意的限度。

既然作品是作者的创意的表达,那么,已经得到表达的作者对其本来的创意在事后当然存在可解释性;创意/表达两分法体现了自然人从表达指向创意的可解释性;作者的表达与创意之间的关系是可解释的。

4.自然人作品创作过程中可预测性、确定性、可解释性三者之间的关系

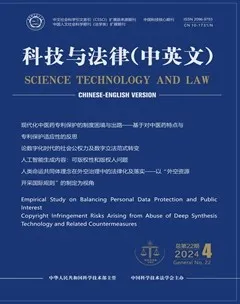

在自然人的作品创作过程中,可预测性是用于事前的、从创意指向表达的、从因到果的、正向的;确定性是用于事中的、在创意与表达之间的、因果之间的、双向的;可解释性是用于事后的、从表达指向创意的、从果到因的、反向的。如图4所示。

作品创作过程中的可预测性、确定性、可解释性三者之间具有一致关系,即可预测性、确定性、可解释性三者是同时成立的。

(二)不同AI技术路线的创意/表达两分法和可预测性、确定性、可解释性

AI被定义为对从环境中接收感知并执行动作的agent(笔者推荐译为“行为体”[7-8])的研究,即AI是设计行为体的科学。行为体被定义为任何通过传感器感知环境并通过执行器作用于该环境的事物,即行为体是在环境中感知和行动的事物[9]。

AI技术路线的可解释性对应于AI行为体运行结果的可预测性;AI技术路线的不可解释性对应于AI行为体运行结果的不可预测性。因此,符号主义AI具有可解释性,对应于符号系统行为体运行结果的可预测性;连接主义AI具有不可解释性,对应于神经系统行为体或混合系统行为体的运行结果的不可预测性。这里的混合系统是指既包含符号主义AI也包含连接主义AI的系统。下面在此基础上进一步分析:

1.符号系统情形的创意/表达两分法和可预测性、确定性、可解释性

符号系统情形的创意/表达两分法可用图5表示。

图5的图例中的A和B代表某个范畴。在图5中,自然人创作作品的创意/表达两分法示意图(图3)中的自然人作者被“符号系统的操作者”替代,作者的创意被“操作者输入(创意)”替代,创意的表达被“符号系统输出(表达)”替代。作品、内容、形式三个范畴没有变化。这里的重要变化在于,将自然人创作作品时自然人自己从创意到表达的过程变更为自然人作为符号系统的操作者进行(代表操作者创意的)输入、然后经过符号系统行为体的处理、得到符号系统的输出(这是对应于输入的创意的表达)。

符号主义AI的可解释性对应于符号系统行为体运行结果的可预测性。

以四色定理的证明为例。四色猜想于1852年提出,在此后的100多年时间内,人类并未证明这一猜想。直到1976年,美国伊利诺斯州立大学的两位数学家K.艾珀和W.哈肯利用当时的高速电子计算机,用了1 200个小时,作了100亿个判断,终于证明四色猜想,从而得到四色定理。据估计,如果这一过程用人工计算,大概需要几十万年。当时发表该研究成果的相关数学杂志的审稿人进行审查时也是通过计算机完成的。

注意到,四色猜想的证明过程和四色定理的审查过程都是通过符号主义的计算机程序实现的。这是符号主义AI的可解释性也就是符号系统行为体生成内容的可预测性的一个典型例子。正因为符号主义AI的运行具有可解释性和可预测性,所以,在四色猜想的证明过程中,我们可以将计算机的证明过程看作是根据人类事先确定的算法进行逻辑推理的过程。只是因为这样的推理过程需要花费太多的人力、太长的时间,所以计算机的处理是在可预测、可解释的情况下完成了全部的证明过程。因此,四色猜想的证明是归功于这两位数学家,他们也就成为证明四色猜想的相关作品的版权人[10]。美国数学学会出版的刊载四色定理证明论文的EVERY PLANAR MAP IS FOUR COLORABLE(《任何平面地图都能用四色染色》)一书的封面如图6所示3,署名作者是K.艾珀和W.哈肯。

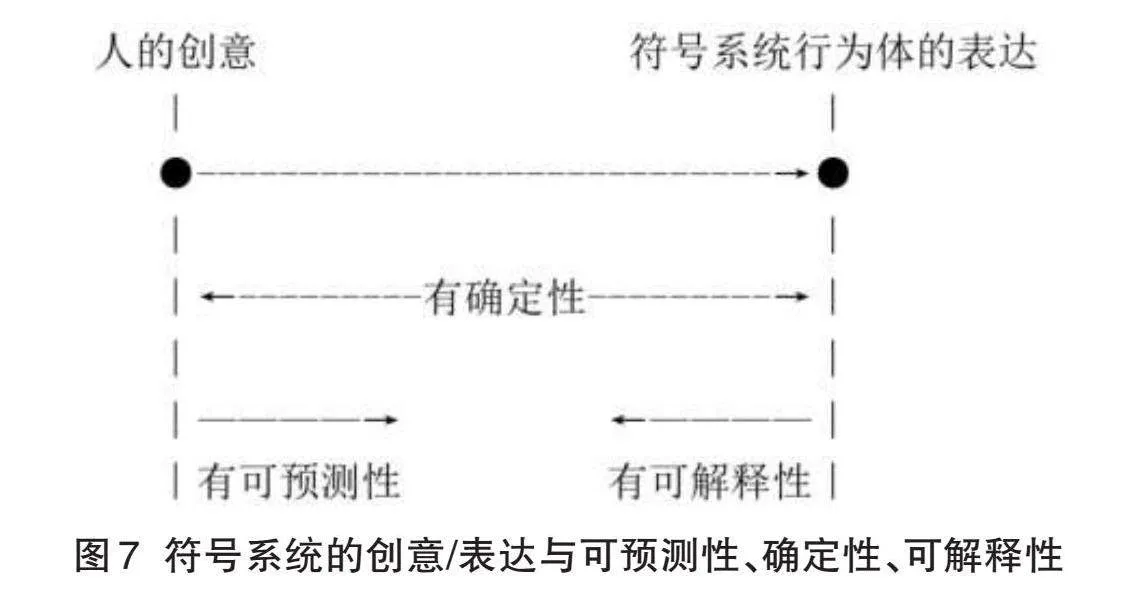

从作品创作过程看,符号系统中的创意/表达的可预测性、确定性、可解释性如图7所示。

当然,图7中的创意是由人类给出的,表达则是由符号系统行为体给出的。

2.神经系统和混合系统情形的创意/表达两分法和不可预测性、不确定性、不可解释性

符号主义AI是经典的图灵计算,以图灵模型定义了什么过程是计算。它有很多限制条件:第一,所有输入的信息必须是现成的,计算之前必须告诉它要输入什么;第二,计算过程中与输入源不能交互;第三,机器必须按照有限的确定性规则运行,在有限的时间内结束等。图灵计算是严格计算机科学意义下的计算,输入输出都是确定的。在不同的机器上计算结果都一样,今天计算与明天计算的结果也一样,所以它解决问题的能力是恒定的。但是,今天的连接主义AI的神经网络在计算过程中则是与外界交互的。因此,一方面它的输入和/或输出是不确定的;另一方面它的计算能力在到达饱和之前是与日俱增的。神经网络不是按照确定的算法实现图灵计算,它的主要功能是“猜测加验证”。猜测和计算是两个不同的概念,基于神经网络的机器更应该称为“猜测机”而不是“计算机”。LLM的本质是基于概率统计的不确定计算,它解决复杂问题的效率大大高于图灵模型[11]。这样就既解释了符号系统为什么具有可解释性/可预测性,也解释了神经系统和混合系统为什么具有不可解释性/不可预测性。

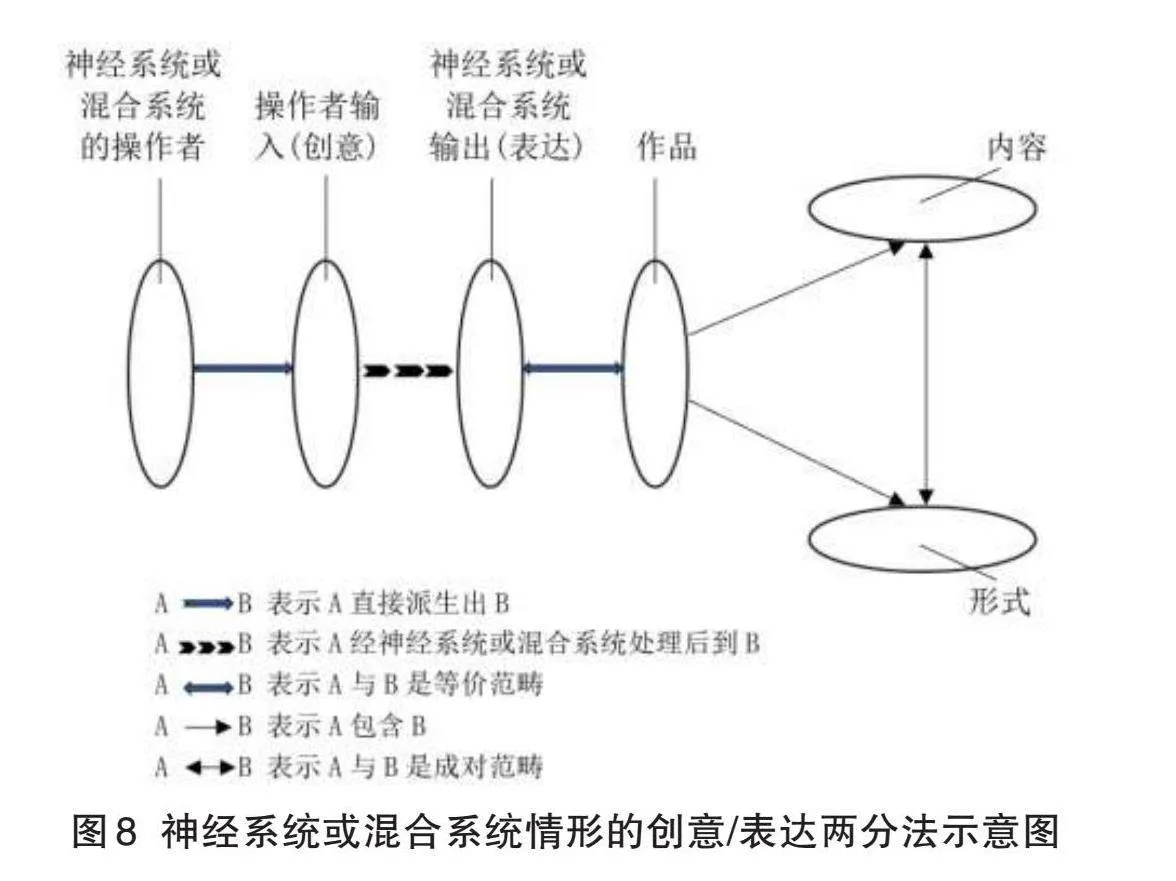

神经系统和混合系统情形的创意/表达两分法可用图8表示。

图8的图例中的A和B代表某个范畴。在图8中,自然人创作作品的创意/表达两分法示意图(图3)中的自然人作者被“神经系统或混合系统的操作者”替代,作者的创意被“操作者输入(创意)”替代,创意的表达被“神经系统或混合系统输出(表达)”替代。作品、内容、形式三个范畴没有变化。这里的重要变化在于,将自然人创作作品时自然人自己从创意到表达的过程变更为自然人作为神经系统或混合系统的操作者进行(代表操作者创意的)输入、然后经过神经系统行为体或混合系统行为体的处理、得到神经系统或混合系统的输出(这是对应于输入的创意的表达)。

连接主义AI的不可解释性对应于神经系统行为体运行结果的不可预测性。

这时的运行结果具有概率性。对于同一个问题,LLM可能给出不同的回答。以“世界上最棒的美食是什么?”这个问题为例,如果我们间隔一分钟,对同一个人就此提问,这个人两次给出的回答应该是相同的;但如果我们分两次问LLM同样的问题,它给出的答案可能会发生变化。如果它认为越南菜最好吃的概率为70%,意大利菜最好吃的概率为30%,那么它相应地会有70%的概率回答越南菜,30%的概率回答意大利菜。这种概率性使LLM在创造性任务中大放异彩。因为创造力就是超越常规可能、跳出思维框架的能力。但是这种概率性也会导致不一致(inconsistency)和幻觉(hallucination)问题。对于依赖事实的任务而言,这就是致命的问题。就本文主题而言,这就导致创意/表达两分法不能适用。

虽然单独的符号主义AI(符号系统)具有可预测性、确定性、可解释性,但是因为混合系统中包含的连接主义AI(神经系统)具有不可预测性、不确定性、不可解释性,所以,混合系统整体也具有不可预测性、不确定性、不可解释性。

从作品创作过程看,神经系统或混合系统中的创意/表达的不可预测性、不确定性、不可解释性如图9所示。

当然,图9中的创意是由人类给出,表达则是由神经系统行为体或混合系统行为体给出。

拉塞尔和诺维格在《人工智能:现代方法》2021年第4版前言中谈及与2010年第3版相比的新变化时写道:“在此之前,我们将AI的目标定义为创建试图最大化预期效用的系统,其中具体的效用信息——目标——是由系统的人类设计者提供的。现在我们不再假设目标是固定不变的并且是AI系统已知的;相反,AI系统可能不确定它所代表的人类的真实目标。它必须学习最大化什么,并且即使在目标不确定的情况下也必须适当地发挥作用。[9]”这一段话正好反映了深度学习作为机器学习中最前沿的领域促进AI技术产生的革命性进展。

(三)AIGC不具有自然人创作作品的可版权性

1.区分AIGC与“人工智能生成物”

AI领域包含机器学习;机器学习领域包含深度学习;深度学习领域包含GenAI。机器学习中包含不同的技术路线, 深度学习是属于连接主义AI的,因此,GenAI也是属于连接主义AI的。GenAI系统不论是由单纯的神经系统构成还是由混合系统构成,都具有不可预测性、不确定性、不可解释性。

过去所称的“人工智能生成物”,通常是指在符号主义AI技术路线下的生成物。现在如果用“人工智能生成物”来统称两种技术路线下的生成物,则需要进一步分为符号主义AI生成物和连接主义AI生成物两种情况进行讨论。这两种不同技术路线下的生成物不能混淆。

对于应用GenAI技术得到的AIGC,从人类给出的创意(即多模态输入)到神经系统行为体或混合系统行为体给出的表达(即多模态输出),从系统的输入到输出之间的创意/表达关系都具有不可预测性、不确定性、不可解释性,无法体现本来适用于自然人的创意/表达两分法的可预测性、确定性、可解释性,换言之,适用于自然人的创意/表达两分法在AIGC情况XFkeTOkPmyUDRoPSafA7QA==下并不成立。

2. AIGC不具有自然人作者意义下的可版权性

以文本生成文本或图像或音频或视频或合成数据的AIGC为例,人类通过LLM的用户接口操作运行LLM,就是人类(以输入提示词、选择各种风格等方式)输入创意但却无法预测输出的表达的过程。在已经得到第一次输出表达的基础上,如果第二次输入创意的微调、得到第二次的输出表达,则仍然是人类输入创意但却无法预测输出的表达;这个微调过程可以持续、不断细化。在这个持续过程中,输出表达与输入创意之间的可预测性、确定性、可解释性关系,在第一次得到输出表达时就已经不成立;在第二次对上一次得到的输出表达进行输入创意的微调时仍然不成立;从第三次到第N次,总是对上一次得到的输出表达进行输入创意的微调,如此持续进行微调,每一次都还是不成立。

这里有一个具体的例子。2024年4月3日,OpenAI 在其官方账号发布了一支完全由其人工智能视频生成器Sora构思生成的 MV(音乐视频)——Worldweight。这个视频伴随着August Kamp的曲目Worldweight,展示了Sora将文本提示翻译成一系列引人注目的多镜头视频片段的独特能力。Kamp说:“我仍记得两年前,那些音符是如何从我的指尖流淌,跃入合成器的键盘。当时外面正下着雨,我感到无比幸运,能够将所有的情感倾注到这首歌中。”“我心中的Worldweight,终于有了具象的视觉效果。[12]”实际上,Kamp事先不可能确定地预测或者表达她心目中的(由现在这个视频所展示的)具象效果。现在这个视频的视觉效果只是事后获她认可的“无数种”可能的表达“之一”。

因为在自然人创作作品情形下创意/表达两分法的成立是自然人创作作品的可版权性成立的前提条件,而适用于自然人的创意/表达两分法在AIGC情况下并不成立,所以,AIGC并不具有自然人作者意义下的可版权性,人类对其通过LLM用户接口进行操作(即给出创意)后运行所得的结果(即所得的表达)就不能享有版权。

这里可以用写高考作文作类比。高考语文试卷的作文题通常都有提示语,提示语的长短不一。试题中的提示语作为表达体现了出题者的创意;每一位考生根据提示语的要求先形成自己的创意,再写出文章作为表达来体现考生的创意。显然,千千万万考生撰写的高考作文的版权归属于每一位考生自己,而不可能归属于作文题的出题者/出题机构。在AIGC的情形,神经系统或混合系统的操作者的创意以输入的提示语作为操作者创意的表达。应用GenAI得到结果即AIGC的过程,相当于考生按照作文题提示语的要求撰写作文的过程。如果AI行为体具有版权主体资格,AIGC的版权就自然归属于AI行为体;只是因为AI行为体尚无版权主体资格,所以AIGC的版权无法归属于AI行为体。但是,如同考生作文的版权不可能归属于出题者/出题机构一样,AIGC的版权无论如何也不应该归属于神经系统或混合系统的操作者。

三、AIGC的版权人问题

(一)AI行为体是AI领域潜在的法律主体

1. agent的含义和AI的定义

在AI的发展历史中一直存在着不同技术路线的激烈竞争。在20世纪80—90年代,IT业界出现关于AI基础的反思辩论,希望寻求新理论、新方法来统合既有的AI理论。这种趋势在20世纪末到21世纪初非常明显,其中最具代表性的是20世纪90年代的两部著作:拉塞尔和诺维格的《人工智能:现代方法》[9]和尼尔森的《人工智能: 新综合》[13]。这两部著作都试图以行为体(agent)为载体,以行为体能力水平的扩展为轴线,把不同的技术路线串联起来,形成统一的AI理论。

行为体(agent)就是采取行动(act)的某种事物。agent来源于拉丁文agere,意思是去做(to do)。虽然所有的计算机程序(computer program)都做某些事情,但是计算机行为体(computer agent)则可以指望做更多:自主操作,感知环境,长期持续,适应变化,创建并追求目标[9]。因此理解和解释agent的关键词是act或to do。

能够通过传感器感知环境并且通过执行器作用于环境的任何事物都是行为体。人类行为体有眼睛、耳朵和其他器官用作传感器,并有手、腿、声道等用作执行器。自动机器(robotic)行为体可能有摄像头和红外测距仪用作传感器,并有各种电机用作执行器。软件行为体接收文件内容、网络数据包和人类输入(键盘/鼠标/触摸屏/语音)作为传感输入,并通过写入文件、发送网络数据包、显示信息或生成声音作用于环境。环境可以是一切——整个宇宙!实际上,这个环境只是在设计行为体时我们关心其状态的那一部分宇宙,即影响行为体的感知并且被行为体的行动所影响的那一部分宇宙[9]。

将已知的AI技术纳入以行为体为线索的共同框架之中,就可以以行为体为中心(agent-centric)的观点,将看似互不相关的一系列主题的汇集统一到行为体的主题之下[13]。以智能行为体(intelligent agent)作为主题概念,将AI定义为对从环境中接收感知信息并执行行动的行为体的研究。每个这样的行为体实现把感知序列映射到行动的功能[9]。行为体概念是AI的核心。AI旨在构建可以展示各方面智能行为的行为体[14]。

2.作为AI研究对象的agent译名的澄清

AI的研究对象是agent。韦氏词典网站4在agent、actor、doer这三个词条下给出了相互关联的共同义项,这个共同义项就是AI中的agent的义项:

(1)agent的义项之一是行动者或行使力量者(one that acts or exerts power);

(2)actor的义项之一是行动者即doer(one that acts:DOER);

(3)doer的义项是主动参与者(one that takes an active part)。

因此,在AI中,在agent = actor = one that acts:doer = doer的前提下,可由actor = doer来译出agent。这样,至少有四种译名即行为体、行为者、行动体、行动者可供选择。注意到,行动哲学的基本共识是行动和行为的区别在于是否有意向性(intentionality)。行动当然是行为;但行为如果没有意向性就不是行动。换言之,从集合论的角度看,如果将行为视为全集,则行动是行为的真子集。给AI中agent赋予意向性,也是AI的目标。如果采用“行为体”或“行为者”而不是“行动体”或“行动者”的译名,则可避免读者误认为AI中agent本身现在就已具备意向性。此外,在“行为体”和“行为者”两个译名的字面上,“行为体”既含“行为”之意也含“(主)体”之意、而“行为者”仅含“行为”之意却无“(主)体”之意,因此,笔者推荐将AI中agent译为“行为体”。

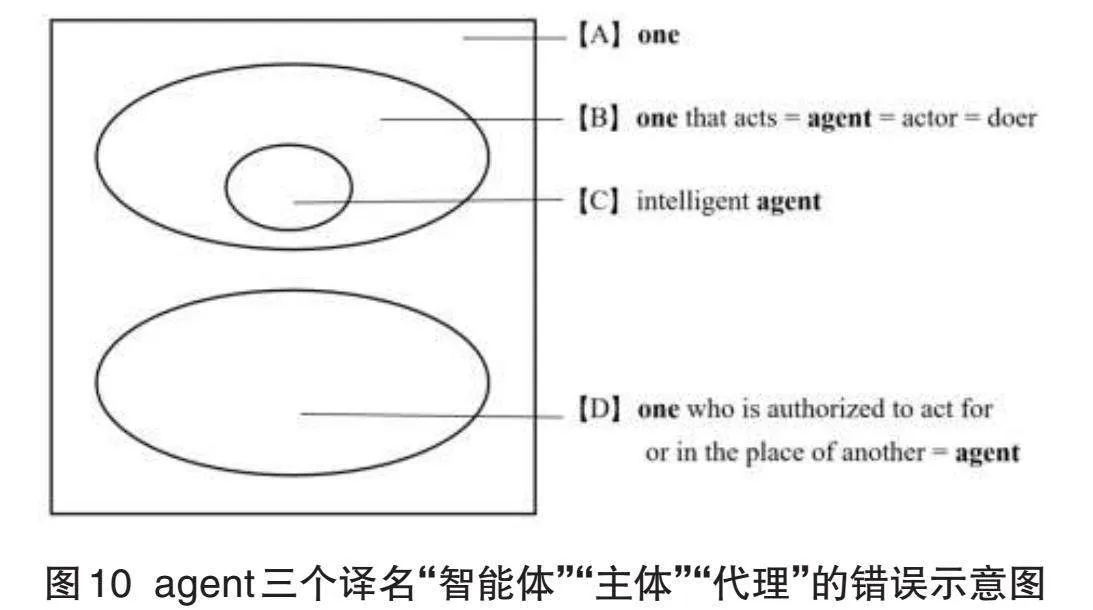

因此,从术语在线网站5的agent词条查到的、由第三届计算机科学技术名词审定委员会(即中国计算机学会计算机术语审定工作委员会)编撰、全国科学技术名词审定委员会于2018年审定公布的《计算机科学技术名词(第3版)》在学科“计算机科学技术—人工智能—多智能体系统”项下给出的agent的三个译名“智能体”“主体”“代理”都是错译。具体说明如图10所示:

(1)译名“智能体”扩大了内涵、缩小了外延:agent本身的各个义项都不含有“智能”(intelligent)的意思,中译时却被无中生有添加“智能”之意。intelligent agent(图10中的集合C)本来是 agent(图10中的集合B)的真子集,却被误以为intelligent agent = agent,即误以为集合B = 集合C。

(2)译名“主体”缩小了内涵、扩大了外延:没有体现AI中agent不可或缺的act或to do之意。one that acts(图10中的集合B)本来是 one(图10中的集合A)的真子集, 却被误以为one that acts = one,即误以为集合B = 集合A。

(3)译名“代理”是选错了义项:“代理”确实是多义项agent的义项之一。在韦氏词典网站6的agent项下可以查到义项“one who is authorized to act for or in the place of another”。但是,AI中agent应该具备行为体的弱概念中的自主性和主动性,应该是施事者/施动者而不是受事者/受动者。“代理”本身是受事者/受动者;“代理”之外必有另外的施事者/施动者。one that acts(图10中的集合B)与one who is authorized to act for or in the place of another(图10中的集合D)本来没有交集,译为“代理”是误以为one that acts = one who is authorized to act for or in the place of another,即误以为集合B = 集合D。

如果将AI中agent译为“行为体”,当它完全实现意向性或者达到智能行为体(intelligent agent)的标准时,那么,在哲学与AI的交叉研究中,就可以循名责实讨论其可能采取的“认识行为”,名正言顺找到相应的“认识主体”;在伦理学与AI的交叉研究中,就可以循名责实讨论其可能采取的“伦理行为”,名正言顺找到相应的“伦理主体”;在法学与AI的交叉研究中,就可以循名责实讨论其可能采取的“法律行为”,名正言顺找到相应的“法律主体”;在哲学社会科学其他学科与AI的交叉研究中,亦复如是。

(二)AIGC潜在的版权人是AI行为体

1. AI行为体的弱概念和强概念

AI行为体(agent)一词通常有弱概念(弱定义)和强概念(强定义)两种用法。在弱概念之下的行为体有下列特性:(1)自主性(autonomy):在行为体操作时没有人类或其他东西的直接干预,行为体对其行动和内部状态有某种控制;(2)社会性(social ability):行为体通过某种形式的行为体通信语言与其他行为体(可能是人类)进行互动;(3)反应性(reactivity):行为体感知其环境并对其中发生的变化及时做出反应,这个环境可能是物理世界、用户通过图形用户界面、一批其他行为体、因特网,或者可以是所有这些的组合;(4)主动性(pro-activeness):行为体并不是简单地对其环境做出行动,他们能够通过自发工作表现出以目标为导向的行为。在强概念之下的行为体对某些研究者尤其是AI领域研究者来说,有着比弱概念更强更明确的含义。这些研究者通常指行为体是一个计算机系统,除了弱概念的上述特性之外,要么是概念化的、要么是使用更常用于人类的概念来实现的。例如,在AI中常用心理现象的概念来描述行为体,如知识、信念、意向和义务。一些AI研究者走得更远,考虑了情感的行为体。为了避免认为这只是毫无意义的拟人化,应该注意,在类似人类的精神状态方面,有很好的理由支持设计和构建行为体。另一种赋予行为体类似人类特性的方式是在视觉上展示它们,也许是通过使用类似卡通的图形图标或有生命的面孔——显然,这样的行为体就那些对人机界面感兴趣的人而言特别重要[14]。所谓“人形机器人”就是一例。

2. AI行为体的工具性的弱概念和强概念

常有论者以AI的工具性(AI只是人类的工具)作为人类应该享有AIGC版权的根据。如果用AI行为体遵从人类意志的程度来定义AI行为体的工具性,那么,以LLM为代表的AI行为体的工具性是随着AI的技术发展而日趋弱化的。这本来也是加强AI安全监管的根本原因。我们可以用既有的“AI行为体”的弱概念和强概念来描述“AI行为体的工具性”的强概念和弱概念。显然,“AI行为体”的弱概念情形对应于“AI行为体的工具性”的强概念情形;“AI行为体”的强概念情形对应于“AI行为体的工具性”的弱概念情形。换言之,AI行为体本身越弱,其遵从人类意志的程度就越强,AI行为体的工具性就越强;AI行为体本身越强,其遵从人类意志的程度就越弱,AI行为体的工具性就越弱。

如果进行AI行为体的工具性在两种技术路线情况下的强弱程度的比较,那么,符号主义AI情况下AI行为体的工具性相对较强,连接主义AI情况下AI行为体的工具性相对较弱。在符号主义AI的技术路线下,从符号系统操作者的输入到符号系统行为体的输出,创意/表达两分法中的可预测性、确定性、可解释性都具备,创意/表达两分法是成立的,所以符号系统行为体的输出具有可版权性,人类(操作者)可以成为符号系统行为体的输出的版权人。在连接主义AI的技术路线下,从神经系统或混合系统操作者的输入到神经系统或混合系统行为体的输出,AIGC对应的是一个由(对应于无穷多种可能性的)无穷多个元素组成的特定集合(该集合的“特定性”由提示词限定),而不是该特定集合中的具体某个元素;而适用于自然人创作作品的创意/表达两分法原则本来应该是由创意对应于特定集合中的具体某个元素。因为在AIGC情况下创意/表达两分法中的可预测性、确定性、可解释性都不具备,创意/表达两分法并不成立,所以神经系统或混合系统行为体的输出不具有可版权性,人类(操作者)就不能成为神经系统或混合系统行为体的输出的版权人。

就AIGC而言,在行为体至少具备弱概念的四项特性的条件下,在将可版权性从自然人创作作品拓展到AIGC情形之后,行为体就是AIGC的潜在的版权人。

四、结语

人类与AI行为体终将统一在 agent 和 agency 的统一概念之下。最近几十年,学界对非人类agency(或物质agency)的研究逐渐成为潮流。对称性地对待人类agent与非人类agent ,也是一种学术观点。因此,可以将agent和agency分别译为“行为体”和“行为力”,这是基于人类与非人类的对称性、避开人类中心论、在中文语境下消解人类agent对非人类agent的首要性的一种扩展处理,既适用于非人类情况(如AI领域及AI相关交叉领域),也适用于指向整个人(脑)的情况。换言之, agent和agency 在所有情况下均可分别译为“行为体”和“行为力”;而在针对整个人(脑)的特例情况下,仍可分别译为“能动者”和“能动性”[8]。有朝一日,AI行为体或可成为法律认可的主体。

AI中的agent与agency之间是不一不异、体用因果的关系。不一不异、体用因果的说法见于《成唯识论》卷二。因为agent是体,agency是用,体用之间,体是体,用是用,所以“不一”;但体是此用之体,用是此体之用,体不离用,用不离体,所以“不异”。再者, agency是因,agent是果,因是因,果是果,所以“不一”;但因是此果之因,果是此因之果,因不离果,果不离因,所以“不异”。agent体现为一种功能——功用与能力。此功能未发生作用、处于潜在状态时,不称为agent而称为agency;其发生作用时,不称为agency而称为agent。agent的种种不同行为都源于agency,是agency的体现。

明斯基有句名言“大脑不过是一台肉机器”(The brain is merely a meat machine)[15]。在AI时代,许许多多原来仅适用于“自然人”的概念,如人、思维、意识、智能、情感、意向、信念、愿望、觉知等,或许都需要针对AI行为体的情况进行拓展。就AIGC的版权问题而言,版权理论中的作者、作品、独创性(原创性)、可版权性、创意/表达两分法等基本概念和原则,同样需要从自然人进一步拓展到AIGC的情形。拓展之后,才可能从基础上解决AIGC带来的问题。

当然,AI行为体要正式成为法律主体、成为AIGC的版权人,就需要人类社会就AI相关法律主体问题达成共识并修改法律。一旦法律主体延伸到AI行为体,AIGC的版权人就可以确定为AI行为体。

参考文献:

[1] 《中国人工智能系列白皮书·人工智能原理》编写组. 中国人工智能系列白皮书·人工智能原理[R]. 北京:中国人工智能学会,2023:11⁃61.

[2] YASAR K, LASKOWSKI N. Definition: Synthetic Data[EB/OL]. (2023-03-01)[2024-03-03]. https://www.techtarget.com/searchcio/definition/synthetic-data

[3] The Central Digital and Data Office. Generative AI framework for HM Government[R]. London: HM Government,2024:13⁃14. (2023-01-18) [2024-03-03]. https://www.gov.uk/government/publications/generative-ai-framework-for-hmg.

[4] 寿步. 计算机软件著作权保护[M]. 北京:清华大学出版社,1997:20.

[5] 托马斯·库恩. 科学革命的结构[M]. 张卜天,译. 北京:北京大学出版社, 2022:52⁃263.

[6] PHILLIPS P, HAHN C, FONTANA P, et al. Four Principles of Explainable Artificial Intelligence[R].(2021-09-29)[2024-03-03]. https://doi.org/10.6028/NIST.IR.8312.

[7] 寿步. 人工智能中agent的中译正名及其法律意义[J]. 科技与法律(中英文),2022(3):1⁃13.

[8] 寿步. 人工智能术语agent的精准译解及其哲学意义[J]. 哲学分析, 2023, 14(3):130⁃143.

[9] RUSSELL S, NORVIG P. Artificial intelligence: a modern approach[M]. New Jersy: Prentice Hall, 4th Ed. 2021.

[10] APPEL K, HAKEN W. Every Planar Map Is Four Colorable[EB/OL].(1976-09-01)[2024-03-03]. https://www.ams.org/journals/bull/1976-82-05/S0002⁃9904⁃1976⁃14122⁃5/S0002⁃9904⁃1976⁃14122⁃5.pdf.

[11] 李国杰. 大力出奇迹的背后是什么?[J]. 中国计算机学会通讯,2024,20(4) :44⁃47.

[12] MORRISON R. OpenAI just released a Sora generated music video— and it's like something out of a fever dream[EB/OL]. (2024-04-03)[2024-04-04]. https://www.tomsguide.com/ai/chatgpt/openai-just-released-a-sora-generated-music-video-and-its-like-something-out-of-a-fever-dream.

[13] NILSSON N J. Artificial intelligence: a new synthesis[M]. San Francisco: Morgan Kaufmann, 1998.

[14] WOOLDRIDGE M, JENNINGS N R. Intelligent agents: theory and practice[J]. The Knowledge Engineering Review, 1995, 10(2) : 115⁃152.

[15] QUO. The Brain Is Merely a Meat Machine[EB/OL]. (2020-05-06)[2024-03-03]. https://quoteinvestigator.com/2020/05/06/machines/.

AI Generated Content: Copyrightability and Copyright Owner Issues

Shou Bu

(University of Science and Technology of China, Intellectual Property Institute, Hefei 230026, China)

Abstract: Connectionist AI is non-explainable. Generative AI (GenAI) is connectionist, so GenAI is non-explainable. The copyrightability and idea/expression dichotomy of copyright theory would have applied to natural person authors. Natural human beings have predictability from idea to expression, certainty between idea and expression, and explainability from expression to idea. AI Generated Content (AIGC) is the result obtained by applying GenAI technology. For AIGC, the process from humans giving ideas to GenAI giving expressions cannot reflect the predictability, certainty, and explainability of the idea/expression dichotomy, that is, the idea/expression dichotomy does not hold in the case of AIGC. Therefore, AIGC does not have copyrightability, and human beings cannot be the copyright owners of AIGC. The concept of AGENT is the core of AI, and AI aims to build intelligent AGENT. In cases where humans cannot copyright AIGC, after extending copyrightability from natural human-created works to the AIGC situation, the AI agents are the potential copyright owners of the generated content under the condition of having at least four properties of the weak notion of agent. Once the legal subject extends to the AI agent, the AI agent can be identified as the copyright owner of the AIGC.

Keywords:AI Generated Content (AIGC); Generative AI (GenAI); copyrightability; copyright owner; agent