基于深度学习的目标检测研究

摘 要:目标检测是机器视觉领域的核心问题。经过多年的发展,以深度学习技术为基础的目标检测方法已成为研究热点。根据检测的原理和过程,目标检测可分为一阶段目标检测和二阶段目标检测。首先,在进行广泛文献调研的基础上,对比目前主流目标检测方法的原理、思路,其次,使用mAP和FPS两个参数对比各方法的检测效果,分析常见目标检测方法的优缺点;最后,对目标检测的发展做出预测和展望。

关键词:目标检测;深度学习;图像处理;卷积神经网络

中图分类号:TP391.4;TP18 文献标识码:A 文章编号:2096-4706(2024)13-0076-08

Research on Object Detection Based on Deep Learning

ZHU Kejia

(School of Electronics, Software Engineering Institute of Guangzhou, Guangzhou 510990, China)

Abstract: Object detection is a core issue in the field of Machine Vision. After years of development, object detection methods based on Deep Learning technology have become a research hotspot. According to the principle and process of detection, object detection can be divided into one-stage object detection and two-stage object detection. Firstly, based on extensive literature research, the principles and ideas of mainstream object detection methods are compared. Then, the detection effects of various methods are compared using two parameters, the mAP and the FPS, and the advantages and disadvantages of common object detection methods are analyzed. Finally, predictions and prospects are made for the development of object detection.

Keywords: object detection; Deep Learning; image processing; Convolutional Neural Networks

0 引 言

目标检测是对视频图像中感兴趣的对象进行研究,并在图像中标注出来。通常对象为可移动的人、物或者人操作的某些设备装置等。被检测的对象目标又称作前景,图像中周围环境称作背景。因此,视频图像目标检测的一个任务就是,将满足条件的前景从背景中标注、分割出来,为目标提取、分类识别、动作行为判断、危险识别等更深层次含义的应用研究做基础。目前,目标检测在视频监控、智能交通、无人驾驶、工业机器人、无人机等领域都有着越来越深入的应用。

经典目标检测根据前景与背景的相对关系,使用前帧的若干特征或者前后帧的关系,用某特征来表示该目标,通过固定大小窗口在后帧图像滑动,将候选区域与原模板区域特征对比,实现目标分类、检测、跟踪。常用方法主要包括背景差法、帧差法、光流法等。这种算法常遍历窗口,甚至需手动提取特征,智能程度低,所获取的特征通常都是图像的低级特征,同时遍历窗口算法中很多计算都是冗余,较为耗时,且鲁棒性较差,难以准确实时检测多个目标。

1 检测原理与阶段

近年来,在神经网络技术发展的基础上,深度学习得到了快速发展,它引入了能学习深层次特征的工具来优化传统体系结构,使所得模型的网络架构、训练策略、功能性能均得以提升。

2012年Krizhevsky等[1]首次尝试用深层卷积神经网络。AlexNetd [2]用大规模图像数据集ImageNet对图像中目标检测加以分类,获得第一名的佳绩。自此,人们更多的使用深度学习来研究目标检测,用卷积神经网络(CNN)来自动学习目标特征,代替半自动手动选择和提取特征,通过比较区域候选框或回归计算来进行目标检测。

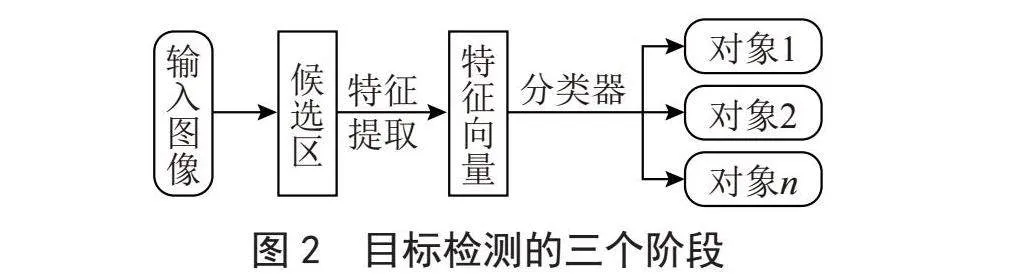

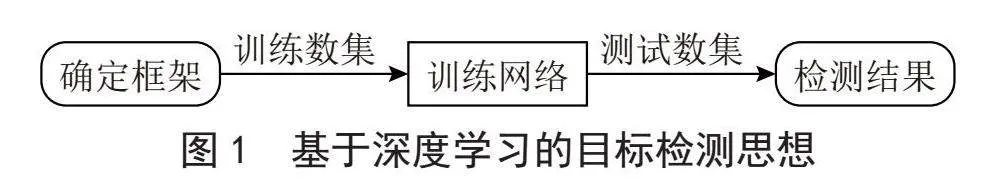

随着深度卷积神经网络获得重大研究进展,目标检测效率大幅提升,检测的准确度和实时性方面也积累了越来越多的研究成果,深度学习逐渐成为人们关注的焦点,目标检测成为深度学习新的研究方向。基于深度学习的目标检测思想如图1所示。通常先设定模型框架,使用数据集对其训练得到训练网络,再对测试数据检测得出测试结果。如果从输入图像至目标标注的过程角度来说,基于深度学习目标检测的三个阶段即是:输入图像得到候选区域;在候选区提取特征;使用分类器对特征进行分类,完成对目标的分类标注,从而完成目标检测。其流程图如图2所示。

经过数据训练的框架生成训练网络,对待检测的图像即测试数据检测,以锚框标注识别结果。这里有两大类思路。第一大类:直接通过网络计算,用概率预测输出目标预选框和标签,称为一阶段检测(One Stage),又称作回归检测;第二大类:将目标检测分成两阶段,在网络中使用候选区域,提取特征图后,通过网络提取感兴趣区域(Region of Interest, RoI),最后使用某种规则对特征图的RoI区域内的内容进行分类,这个方法称为而二阶段检测(Two Stage)或者基于区域生成的检测[3]。

2 二阶段目标检测

2.1 二阶段主要检测方法介绍

2.1.1 R-CNN算法检测

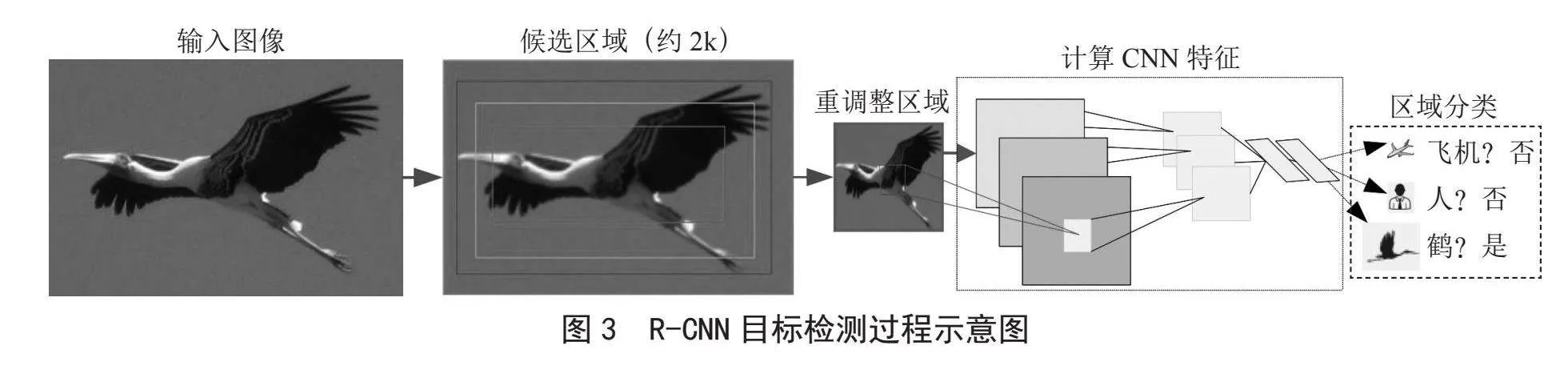

传统手动或者半手动提取图像特征的方法,智能化程度过低。2014年Girshick等[4]采用AlexNet作为骨干网络,利用Selective Search算法[5]提取一系列较可能是物体的候选区域,再用CNN提取图像特征,完成目标检测。其关键步骤主要有:

1)使用Selective Search从输入图像上提取可能的区域,总计共约2 000个候选区域。

2)将所选区域统一为相同227×227维度。

3)使用CNN提取统一后区域特征。

4)将所提取特征输出至两个相邻的连接层。

5)使用支持向量机SVM对特征进行分类。

6)使用极大值抑制法去除多余的标注框。

7)对边界框的位置微调、修改,将其作为目标检测的标记框,使对目标的外围框标注更加准确。R-CNN目标检测过程图如图3所示。

与经典目标检测相比,R-CNN目标检测取得了巨大突破,其使用选择性搜索取代滑动窗口生成候选框,大幅降低了计算量。原来由人工来选取SIFT等特征,改为由CNN计算叠加获得特征,提升了目标特征的表达能力,将由特征表示的目标区分转化为通过计算相似度自动完成对目标的分类标记。经实验,在PASCAL 2007 VOC 2011/2012数据集上,目标的mAP为53.3%;在PASCAL VOC 2010数据集上,目标的mAP为53.7%。但是,R-CNN的选择性搜索使用的是图像的低级特征,目标背景较复杂时,易受干扰,候选框难以选择。而且由于特征提取时,对图像做出图像固定尺寸的处理,可能导致图像的信息发生改变,对每个感兴趣区域进行运算,去除2 000左右冗余框,将耗费大量的时间,R-CNN各个步骤之间关联不够紧密,多处运算对已有的运算结果使用不够充分[6]。

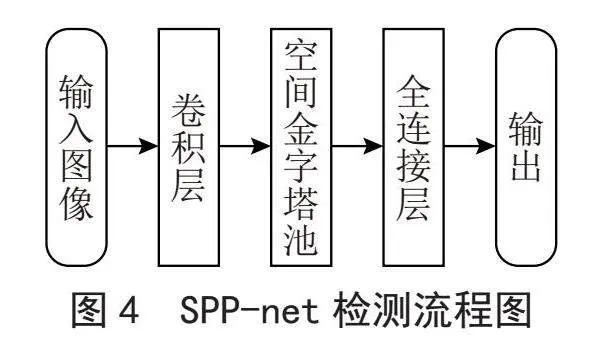

2.1.2 SPP-net算法检测

R-CNN人为的对采集图像大小要求固定一致,会降低待检测图像或子图像的识别精度。He等[7]设计了SPP-net(Spatial Pyramid Pooling Network)算法,其主要思想为:首先,对任意大小的输入图像,卷积运算求取目标特征,这些特征具有固定的维数,对于多个目标重叠的区域,不需要重复运算;其次,使用空间金字塔池化策略,对特征加以筛选;最后,将池化筛选结果送到全连接层,对目标加以区分标注,实现目标检测。在2014年的ImageNet大尺度视觉识别挑战赛(LSVRC)中,文献[7]作者团队在目标检测和图像分类方面排名第2和第3优异成绩。SPP-net检测流程图如图4所示。

SPP-net使用ZF5作为骨干网络,与使用AlexNet作为骨干网络的R-CNN相比,具有稍好的目标检测精度和更优秀的检测实时性。他们在VOC 2007数据集上进行测试,SPP-net最好的目标检测的mAP达到60.9%。使用ZF5作为骨干网络,每帧图片目标检测时间为0.142~0.382 s,处理速度是R-CNN的24~102倍。显然,SPP-net未对SPP层之前的网络进行改进,与R-CNN训练过程相同,训练过程分为多步且单独运行,对各个阶段运行结果需要独立保存,耗费巨大的存储空间;不同大小图像特征提取后特征具有相同固定的维数,因此,候选框的感受野不同。

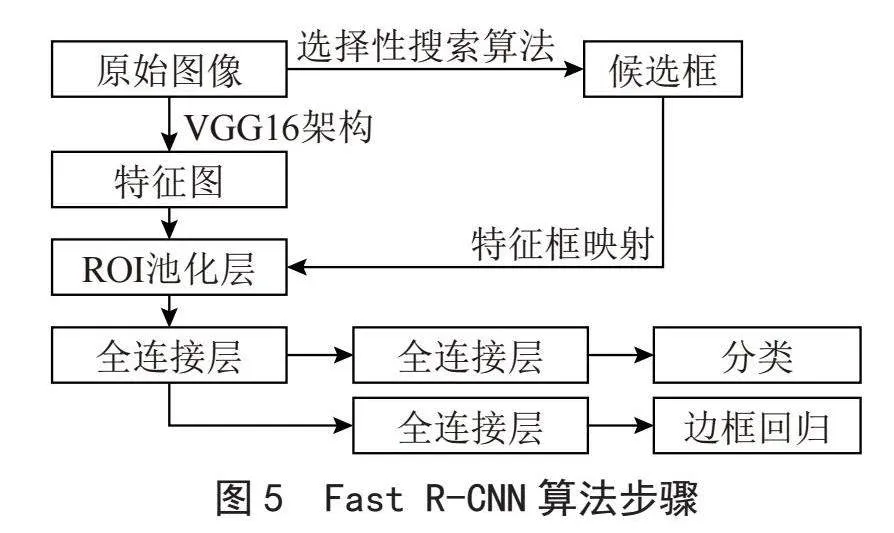

2.1.3 Fast R-CNN算法检测

由于SPP-net使用金字塔池化层,使得获取图像特征变得更加方便,文献[8]提出Fast R-CNN算法,其主要思想是:构建VGG16架构,先直接对原图做一次卷积运算得到特征图,用Selective Search(选择性搜索算法)的方法挑选候选区域,用RoI(感兴趣区域、感兴趣池化层)取代空间金字塔池化层;直接用网格将每个候选区域均匀分成若干个区域块,对每个块进行最大值池化,转变为大小统一的特征向量;然后,放入全连接层中做处理,使用Softmax层代替SVM进行分类,全连接层同时也做回归任务。其算法步骤如图5所示。

在VOC 2007数据集上,目标检测的mAP可达70.0%,每秒可以检测2幅图片,FPS为0.5帧。但Fast R-CNN由于使用Selective Search的方法筛选候选区域,花费较多时间,训练和预测仍需较长时间,实时性检测受到严峻的挑战。

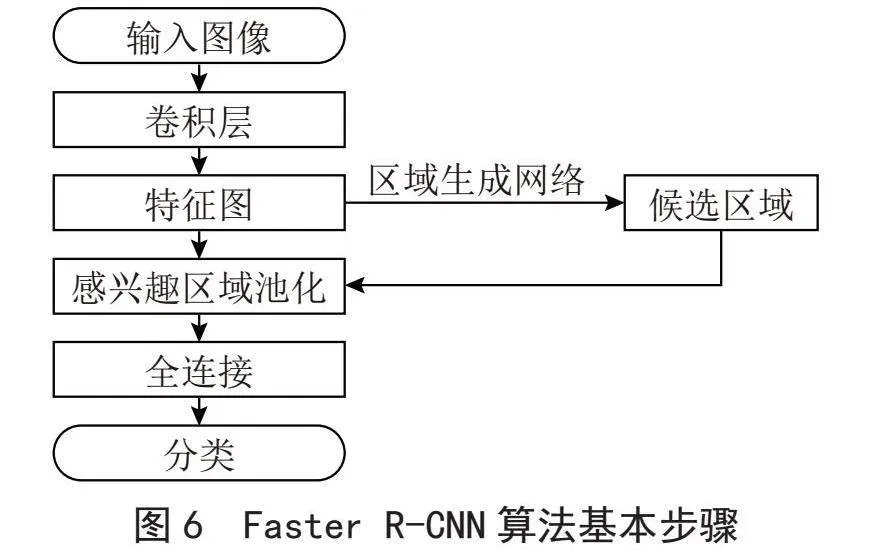

2.1.4 Faster R-CNN算法检测

Ren等[9]在Fast R-CNN的基础上做出改进,提出Faster R-CNN算法,其主要思想是在原图卷积层后添加区域提取网络RPN(Region Proposal Network),代替Fast R-CNN的选择性区域搜索。Faster R-CNN [10]算法基本步骤为:首先,对原始图像做卷积运算特征提取;其次,在其中的RPN层得到候选区域;最后,共用候选区域与目标监测区域,使用RoI以及全连接输出最终分类结果。Faster R-CNN算法基本步骤如图6所示。实验证明在使用VOC 2007+VOC 2012作为训练数据集、VOC 2007和VOC 2012作为测试数据集时,Faster R-CNN目标检测的mAP可达73.2%和70.4%,检测每帧图像耗时198 ms,FPS达到5.05帧/秒。

Faster R-CNN比R-CNN提高了目标检测的mAP和FPS,但仍有不足,主要表现在:使用卷积网络获取候选区域,运算量仍然较大;虽然目标检测速度有提升,但由于正常视频播放速度为每秒24帧以上,对于实时性检测仍然有较大的进步空间。

文献[11]将边缘检测分支融入Faster R-CNN当中,并在损失函数中加入物体边缘损失函数,在RoI Align模块中使用注意力机制过滤和增强特征,目标检测的mAP达到98.42%。

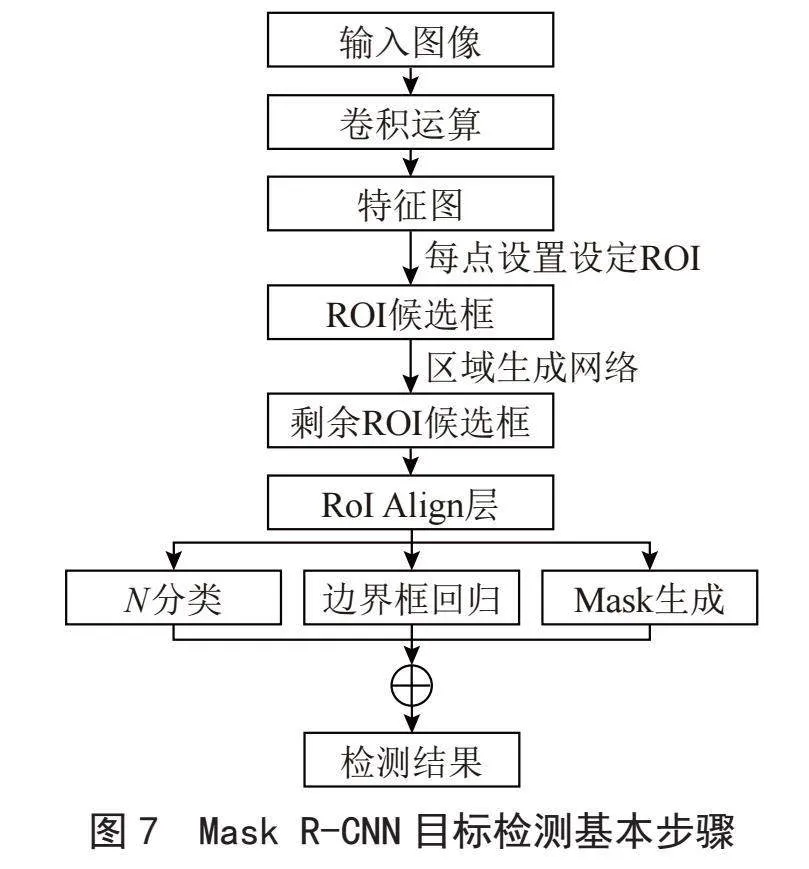

2.1.5 Mask R-CNN算法检测

He等[11]对Faster R-CNN进行了扩展,在既有边界框识别分支的基础上,增加了一个用于预测物体掩码的分支,只增加了一个小的开销更快的R-CNN,很容易推广到其他目标检测任务。Mask R-CNN检测目标基本思想为:Mask R-CNN是在Faster R-CNN的基础上添加一个预测分割Mask的分支,添加了并列的FCN层(Mask层),目标检测基本步骤如图7所示。

通过RoI Align层替换RoI Pooling层,使用双线性插值来确定非整数位置的像素,从RPN网络确定的RoI中生成相同大小的较小的特征图,使得每个感受野取得的特征能更好对齐原图感受野区域[11]。由于Mask R-CNN网络通过掩码对某帧图像进行空间布局编码控制,使得目标在空间布局更加准确精细[11],实际上完成了某帧图像中目标的分割,因此它比Faster R-CNN目标检测的mAP更好。实验证明,在COCO数据集上,Mask R-CNN的目标检测的mAP为39.8%,比Faster R-CNN高了20.1%。但是,Mask R-CNN检测使用分割分支,致使Mask R-CNN比Faster R-CNN检测速度慢一些,可完成5帧/秒的图像检测。

2.2 二阶段目标检测对比分析

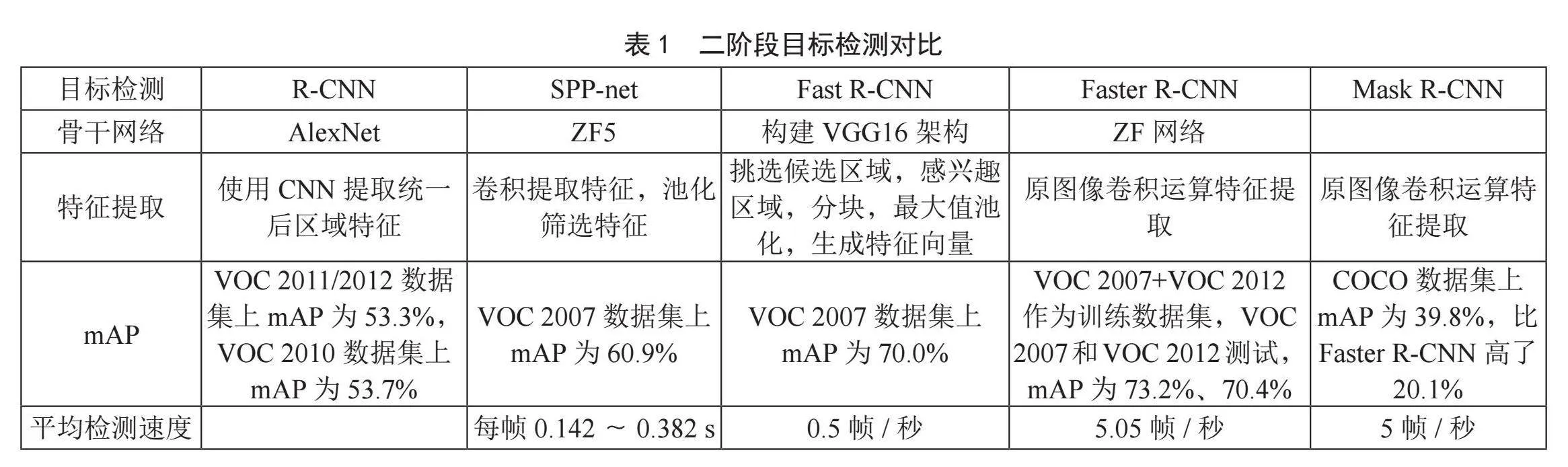

通过以上算法改进过程,可以发现二阶段目标检测mAP提升方法主要有:优化必要的环节,使全范围内遍历目标检测提升为主要特征区域搜索;实现若干环节数据共享,避免重复运算,可大幅度提升算法运行速度;使用新的训练策略,使算法从各个独立步骤运算逐步向端到端运算;引进注意力机制以及更接近真实目标的模型进行大量训练。二阶段目标检测对比如表1所示。

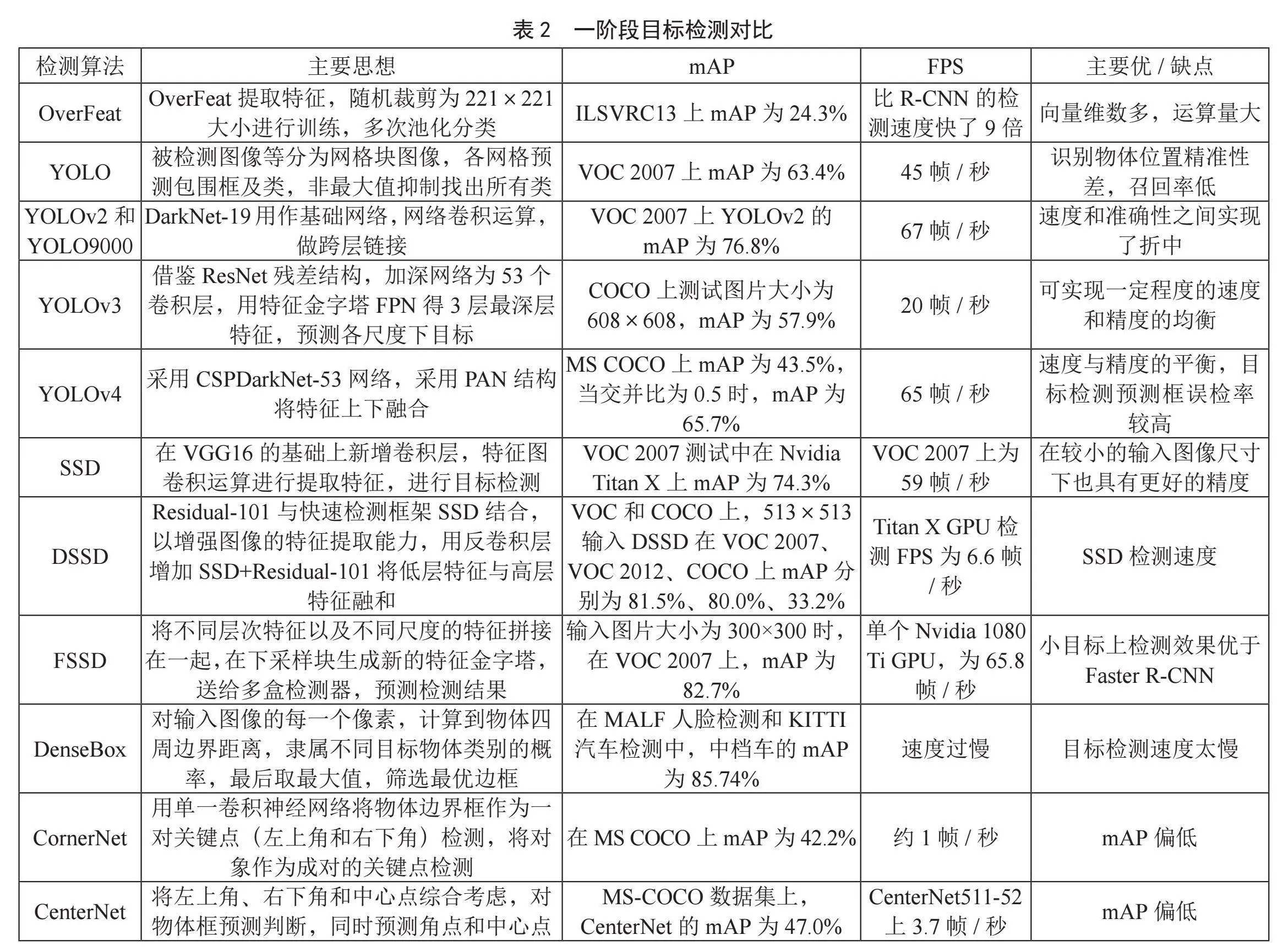

3 一阶段目标检测

二阶段目标检测虽然mAP较高,但算法通常较为复杂,目标检测耗费时间较长。本节主要分析一阶段目标检测方法,其使用区域目标预测法检测目标,通过回归法对目标框计算并加以标注。目前,使用较多的算法主要包括以下几种。

3.1 一阶段主要检测方法介绍

3.1.1 OverFeat算法检测

Sermanet等[12]在2014年提出OverFeat算法,将任务分解为分类、定位、检测三步;首先,他们借鉴AlexNet模型,设计了以快速模型(Fast Model)和准确模型(Accurate Model)为特征的提取器OverFeat。网络训练输入时,每张原图片大小为256×256,随机裁剪为221×221作为CNN输入进行训练。在测试阶段,可使用大小都不相同的图片进行多尺度输入预测。对于特征图,经过重复多次使用非重叠的池化offset pooling后,将其送入分类器。将输出向量在后面把它们拉成一维向量。在分类任务中,特征提取网络5层(池化后的)后面接一个回归网络来做定位,可在定位的基础上训练一个背景区分图像中有没有被检测物体。OverFeat算法在网络结构方面基本上和AlexNet相同,使用同一卷积神经网络作为共享的骨架网络,大幅降低了计算量,是ImageNet大规模视觉识别挑战赛2013(ILSVRC2013)本地化任务的获胜者。ILSVRC13测试集检测结果为:目标检测的mAP达到24.3%,而检测速度比R-CNN的快了9倍。

3.1.2 YOLO算法检测

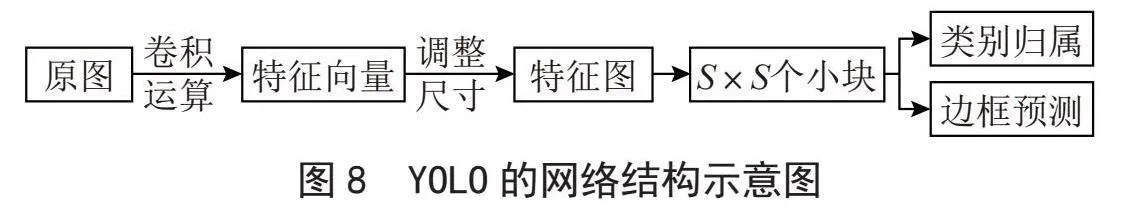

Redmon等[13-14]提出YOLO(You Only Look Once)算法,使用一次卷积神经网络完成候选区选取与对象识别,其基本思想为:将被检测图像等分分割为S×S个网格块图像,每个网格预测K个包围框。对网格块内的图像所属类别进行概率估算,具有最大概率的类被选择并分配给特定的网格单元。剔除非最大值的概率类别,实行非最大值抑制算法,完成一个类别的最高概率包围框。再继续找到具有下一个最高类别概率的包围框,直至完成所有类别的分类。YOLO检测示意图如图8所示。

YOLO算法对全图分割成小块检测目标,基本模型使用VOC 2007/2012复合数据集训练时,目标检测的mAP为63.4% [14],可完成每秒45帧的图像处理速度,实现了端到端的目标检测,基本满足实时性的要求。

YOLO算法目标检测的mAP比Fast R-CNN以及Faster R-CNN要低,YOLO算法背景的误判率为4.75%,而Fast R-CNN误判率为13.6%,可见YOLO误判率更优秀。

3.1.3 YOLOv2和YOLO9000算法检测

Redmon等[15]对YOLO进行改进,在2016年提出YOLOv2和YOLO9000,其主要思想为:他们首先将YOLO的模型改进为YOLOv2,使用DarkNet-19作为基础网络,抛弃了全连接,在网络中做卷积运算后,增加Batch Normalization使网络更易收敛,使用了跨层连接,网络训练变得更容易,YOLOv2模型可以在不同的尺寸下运行。YOLOv2在VOC和COCO数据集上获得了当时最好的结果,在VOC 2007数据集上,YOLOv2的目标检测的mAP为76.8%,目标检测的FPS为67帧/秒;而当目标检测的FPS为40帧/秒时,目标检测的mAP为78.6%,在速度和准确性之间轻松实现了折中。

同时文献[15]分别在COCO目标检测数据集和ImageNet分类数据集上训练了YOLO9000,ImageNet验证集(200类)上目标检测的mAP为19.7%,可实时检测超过9 000类别的目标类别。

3.1.4 YOLOv3算法检测

2018年,Redmon等[15]在YOLOv2和YOLO9000基础上对原目标检测算法加以改进,主要体现在:YOLOv3借鉴了ResNet的残差结构,进一步加深网络为53个卷积层,即Darknet-53网络;使用特征金字塔FPN(Feature Pyramid Networks),获得3层最深层特征,预测各尺度下目标;YOLOv3损失舍弃Softmax函数,而使用Sigmoid函数作为逻辑回归层判断函数,进而对每个类别做二分类。

YOLOv3在COCO数据集测试中,测试图片大小为608×608,当交并比为0.5时,YOLOv3目标检测的mAP可达57.9%,检测速度约为20帧/秒。而相同交并比时,RetinaNet算法目标检测的mAP为57.5%,检测速度约为5.1帧/秒。YOLOv3可实现一定程度的速度和精度的均衡。

3.1.5 YOLOv4算法检测

2020年Bochkovskiy等[16]等人提出YOLOv4算法,他们在原有YOLO目标检测架构上,采用了近些年CNN领域中最优秀的优化策略,在数据处理、主干网络、网络训练、激活函数、损失函数等各个方面都进行了不同程度的优化。算法采用CSPDarkNet-53网络,并采用PAN(Path Aggregation Network)结构将特征上下融合两次,核心是采用Cross Stage Partial Network结构,选择Mish(A Self Regularized Non-Monotonic Neural Activation Function)激活函数,对目标的中心点回归公式加以微调,定位损失采用的是CIoU损失函数,训练时采用数据增强Mosaic、cmBN、SAT自对抗训练等技术。

实验证明,YOLOv4算法模型检测速度快且准确率高:在MS COCO数据集上测试的目标检测的mAP为43.5%,当交并比为0.5时,YOLOv4目标检测的mAP可达65.7%,且图像检测速度可达65帧/秒,实现了速度与精度的较好平衡,其主要缺点是目标检测预测框误检率较高。

3.1.6 SSD算法检测

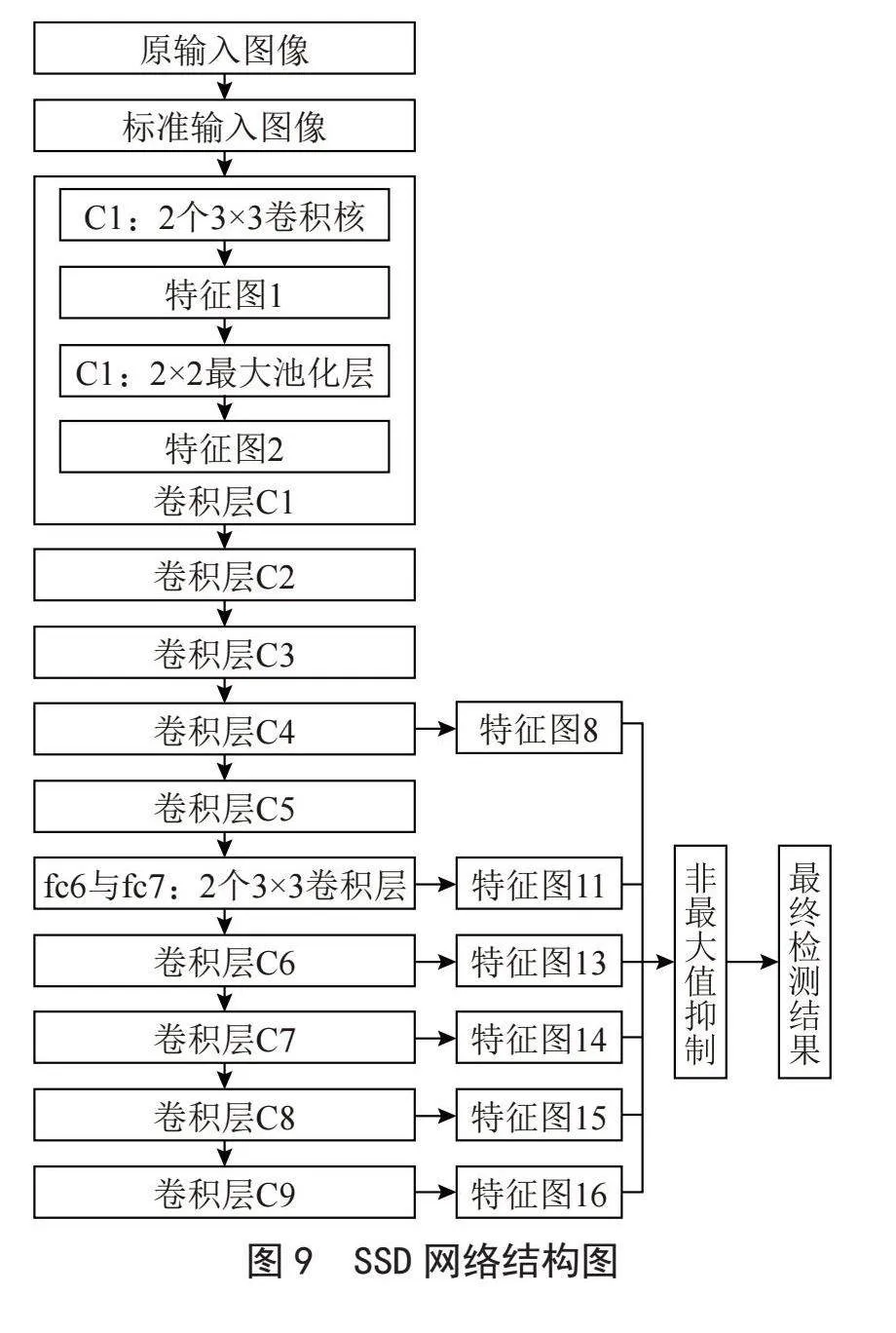

考虑到YOLO目标检测速度较快但精度不高,尤其是小目标检测精度更不高,Liu等[17]在2015年提出SSD(Single Shot MultiBox Detector)算法,SSD算法借鉴了YOLO将图像分格的核心思想,具体如下:

1)采用VGG16作为基础模型,然后在VGG16的基础上新增了卷积层来获得更多的特征,不同层的网络检测不同尺度的对象,使用大特征图来检测小目标,小的特征图检测大目标。

2)舍弃YOLO的全连接,直接对不同的特征图卷积运算进行提取特征,来进行目标检测。

3)为每个网格设定多个先验边界框。

4)训练时使用了数据增强技术。

5)SSD算法的损失函数由包括位置损失(loc)与类别置信度损失(conf)的加权和构成。

SSD网络结构如图9所示。

实验证明,在VOC、COCO和ILSVRC数据集上,SSD比YOLO具有更高准确性,速度更快,对于300×300输入,SSD在VOC 2007测试中目标检测的FPS为59帧/秒,在Nvidia Titan X上实现了74.3%的mAP,对于512×512输入,SSD实现了76.9%的mAP,高于YOLO的63.4%,高于Fast YOLO的52.7%。但是图片检测的FPS为22帧/秒,低于YOLO的45帧/秒,更是远低于Fast YOLO的155帧/秒,优于可比的最先进的Faster R-CNN模型。与其他单级方法相比,SSD即使在较小的输入图像尺寸下也具有更好的精度。

3.1.7 DSSD与FSSD算法检测

针对SSD对小目标检测精度不高的问题,Fu等[18]在2017年提出DSSD算法,将Residual-101与快速检测框架SSD结合,来增强图像的特征提取能力,用反卷积层增加SSD+Residual-101将低层特征与高层特征融和,提高了目标,尤其是小目标的检测精度。实验证明,在VOC和COCO数据集检测中,513×513输入DSSD在VOC 2007、VOC 2012、COCO数据集的测试中,DSSD算法目标检测的mAP分别为81.5%、80.0%、33.2%,在Titan X GPU上目标检测的FPS为6.6帧/秒,低于SSD检测速度。

考虑到SSD的特征金字塔检测方法,使得不同尺度的特征难以融合,Li等[19]将SSD和FPN结合提出FSSD算法,他们设计出一种轻量级的特征融合模块,将不同层次如低层细节特征与高层的语义特征,以及不同尺度的特征拼接在一起,然后通过一些下采样块生成新的特征金字塔,再将其馈送给多盒检测器,预测最终的检测结果。输入图片大小为300×300时,在VOC 2007测试中,使用单个Nvidia 1080 Ti GPU,FSSD算法可以在65.8帧/秒的速度下实现82.7%的mAP,在小目标上检测效果优于Faster R-CNN。

3.1.8 DenseBox算法检测

目前,大多数目标检测方法都是基于锚框进行目标检测,但是,越来越多的学者认为该策略存在天然缺陷[20],主要体现在:

1)对锚框信息标注需要过多的参数标注,引进的参数过多,致使目标检测的向量维数过多。

2)根据目标和锚点的交并比所确定锚框尺寸,以及锚框的回归坐标都是根据经验得来,通常不一定是最优的。

3)三是足够高召回率需要大量的锚点,致使运算量大幅度增加,而大部分锚点对检测结果都是无用的。

4)锚框导致正负样本不均衡,正样本数量会远远小于负样本。

早在2015年,Huang等[21]就提出一种无锚框的DenseBox算法,算法不再预设锚框,直接预测物体的边界框,即对输入图像的每一个像素,计算像素点到所在的物体四周边界的距离,以及隶属不同目标物体类别的概率,最后取最大值,筛选最优边框,实验证明算法,在公共基准数据集MALF人脸检测和KITTI汽车检测中,对中档车的平均检测精度可达85.74%。

3.1.9 CornerNet算法检测

Law等[22]于2020年提出CornerNet算法,使用单一卷积神经网络将物体边界框作为一对关键点(左上角和右下角)进行检测,即将对象作为成对的关键点进行检测。CornerNet算法架构包含3部分:环面网络、右下角和左上角的热图、预测模块。实验证明,在MS COCO数据集上目标检测的mAP达到42.2%。

3.1.10 CenterNet算法检测

CornerNet算法角点精度以及准确性直接影响标记目标的边界框的质量,在CornerNet的目标检测中,常遇到大量不正确的对象边界框的情况,考虑到角点生成的区域内部仍包含重要信息,Duan等[23]提出CenterNet算法,设计出3种Backbone的网络结构,CenterNet算法将左上角、右下角和中心点综合考虑,对物体框进行预测判断,同时预测角点和中心点,他们认为角点定义的预测框内应包含中心点,否则舍弃该预测框。实验证明在MS-COCO数据集上,CenterNet目标检测的mAP达到47.0%。

3.2 一阶段目标检测对比分析

随着目标检测研究的不断深入,使用无锚框目标检测[24-29]的研究也越来越多。一阶段目标检测算法对比如表2所示。

4 结 论

目前,目标检测从传统的通过研究少量图像中背景与对象的区别与联系加以分割检测,逐渐转向通过人工智能设计框架,使用大量数据集训练,得到训练网络,进而对目标进行检测。

提高目标检测的mAP与FPS,是目标检测中是两个相对矛盾的参数,这也与应用场景需求有关。如在无人驾驶中,检测速度要求放在第一位,而在文字检测、桥梁裂痕及信号灯检测等方面,目标检测精度放在首位。综合众多参考文献,提高目标检测精度与提高目标检测速度的思路主要包括:

1)构建高质量的目标检测数据集。提高数据集质量、数量,建立更适合目标检测场景的数据集;增强已有数据集的利用效率、深度。

2)设计更优秀骨干网络,甚至在轻人工干预下,实现骨干网络设计。将VGG、GoogleNet以及ResNet等网络结构应用于目标检测中,使得系统的特征提取能力大幅提升,可见,骨干网络性能的好坏,直接影响特征提取能力。注意到Transformer自注意力机制较强,Facebook AI的研究者便把Transformer用到了目标检测任务中,形成DETR(Detection Transformer),其效检测效果与Faster R-CNN相比拟。

3)可通过锚点、交并比阈值、动态卷积、边界框损失函数等更细节的层面来提升目标检测的精度、速度。

4)基于GAN的目标检测为目标检测提供新的思路。

目标检测除了精度、速度之外,主要还有以下难点:

1)当前目标检测对小目标的检测还不够理想。无人机航拍、卫星遥感、红外目标识别、高空抛物、自动驾驶等领域对小目标检测有很强的需求。小目标图像往往面临着分辨率低、像素少、训练数据难以标记,尤其在数据处理过程中,信息容易弱化甚至丢失等问题,都亟待解决。

2)目前的目标检测基本都是在封闭数据集内对目标检测。如何对未知物体在开放环境进行目标检测也是一个难点。

3)多场景、领域目标检测。目前,目标算法基本只针对特定领域、一定场景下对特定目标物进行检测,应用场景单一,多领域目标检测是一个极具挑战的应用。

相信在不久的将来,随着人们对基于深度学习技术的不断深入研究,对目标检测技术的不断探索,其应用领域会更加广泛,为人类的生产生活发展带来更大的价值。

参考文献:

[1] KRIZHEVSKY A,SUTSKEVER I,HINTON G E. ImageNet Classification with Deep Convolutional Neural Networks [J].Communications of the ACM,2017,60(6):84-90.

[2] DING L,LI H Y,HU C739a3b51819e8ad18c9003821139b507 M,et al. AlexNet Feature Extraction and Multi-Kernel Learning for Objectoriented Classification [C]//The ISPRS Technical CommissionⅢ Midterm Symposium on “Developments, Technologies and Applications in Remote Sensing”.Beijing:[s.n.],2018,42:277-281.

[3] 刘宇昊.基于Faster R-CNN的水下小目标检测识别技术研究 [D].大连:大连理工大学,2021.

[4] GIRSHICK R,DONAHUE J,DARRELL T,et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation [C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:580-587.

[5] 孟祥泽.基于深度卷积神经网络的图像目标检测算法现状研究综述 [J].数字技术与应用,2021,39(1):112-116.

[6] 李柯泉,陈燕,刘佳晨,等.基于深度学习的目标检测算法综述 [J].计算机工程,2022,48(7):1-12.

[7] HE K M,ZHANG X Y,REN S Q,et al. Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[8] GIRSHICK R. Fast R-CNN [C]//2015 IEEE International Conference on Computer Vision (ICCV).Santiago:IEEE,2015:1440-1448.

[9] REN S Q,HE K M,GIRSHICK R,et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):113-1149.

[10] ZHAO K,WANG Y N,ZHU Q,et al. Intelligent Detection of Parcels Based on Improved Faster R-CNN [J/OL]. Applied Sciences,2022,12(14):7158(2022-07-15).https://doi.org/10.3390/app12147158.

[11] HE K M,GKIOXARI G,DOLLÁR P,et al. Mask R-CNN [C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice:IEEE,2017:2980-2988.

[12] SERMANET P,EIGEN D,ZHANG X,et al. OverFeat: Integrated Recognition, Localization and Detection using Convolutional Networks [J/OL].arXiv:1312.6229 [cs.CV].[2023-11-20].https://doi.org/10.48550/arXiv.1312.6229.

[13] JOSEPH R,DIVVALA S,GIRSHICK R. You Only Look Once: Unified,Real-Time Object Detection [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas:IEEE,2016:779-788.

[14] REDMON J,FARHADI A. YOLO9000: Better, Faster, Stronger [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:6517-6525.

[15] REDMON J,FARHADI A. YOLOv3: An Incremental Improvement [J/OL].arXiv:1804.02767 [cs.CV].(2018-04-08).https://arxiv.org/abs/1804.02767.

[16] BOCHKOVSKIY A,WANG Q-C,LIAO H-Y M. YOLOv4: Optimal Speed and Accuracy of Object Detection [J/OL].arXiv:2004.10934 [cs.CV].(2020-04-23).https://arxiv.org/abs/2004.10934.

[17] LIU W,ANGUELOV D,ERHAN D,et al. SSD: Single Shot MultiBox Detector [J/OL].arXiv:1512.02325 [cs.CV].[2023-11-08].https://arxiv.org/abs/1512.02325.

[18] FU C-Y,LIU W,RANGA A,et al. DSSD: Deconvolutional Single Shot Detector [J/OL].arXiv:1701.06659 [cs.CV].[2023-11-18].https://arxiv.org/abs/1701.06659.

[19] LI Z X,YANG L,ZHOU F Q.FSSD: Feature Fusion Single Shot Multibox Detector [J/OL].arXiv:1712.00960 [cs.CV].[2023-11-18].https://arxiv.org/abs/1712.00960.

[20] ZHU C C,HE Y H,SAVVIDES M. Feature Selective Anchor-Free Module for Single-Shot Object Detection [J/OL].arXiv:1903.00621 [cs.CV].[2023-11-16].https://arxiv.org/abs/1903.00621.

[21] HUANG L C,YANG Y,DENG Y F,et al. DenseBox: Unifying Landmark Localization with End to End Object Detection [J/OL].arXiv:1509.04874 [cs.CV].[2023-11-16].https://arxiv.org/abs/1509.04874.

[22] LAW H,DENG J. CornerNet: Detecting Objects as Paired Keypoints [J].International Journal of Computer Vision ,2020,128:642-656.

[23] DUAN K W,BAI S ,XIE L X,et al. CenterNet: Keypoint Triplets for Object Detection [J/OL].arXiv:1904.08189 [cs.CV].[2023-11-16].https://arxiv.org/abs/1904.08189.

[24] PIAO Z Q,WANG J B,TANG L B,et al. Anchor-Free Object Detection with Scale-Aware Networks for Autonomous Driving [J/OL].Electronics,2022,11(20):3303[2023-11-17].https://doi.org/10.3390/electronics11203303.

[25] LI Q M,BI Y Q,CAI R S,et al. Occluded Pedestrian Detection Through Bi-Center Prediction in Anchor-Free Network [J].Neurocomputing,2022,507:199-207.

[26] XIANG Y,ZHAO B X,ZHAO K,et al. Improved Dual Attention for Anchor-Free Object Detection [J].Sensors,2022,22(13):4971-4971.

[27] LIU Y,ZHANG Y,WANG Y X,et al. A Survey of Visual Transformers [J].IEEE Transactions on Neural Networks and Learning Systems,2023:1-21.

[28] 王迪聪,白晨帅,邬开俊.基于深度学习的视频目标检测综述 [J].计算机科学与探索,2021,15(9):1563-1577.

[29] WU X W,SAHOO D,HOI S C H. Recent Advances in Deep Learning for Object Detection [J].Neurocomputing,2020,396:39-64.

作者简介:朱克佳(1982—),男,汉族,安徽阜阳人,讲师,硕士研究生,研究方向:图像处理、智能控制、机器视觉、人工智能。