基于改进3D U-Net模型的肺结节分割方法研究

摘 要:由于肺部CT图像的特征信息复杂度较高,经典3D U-Net网络在肺结节分割方面准确率较低,存在误分割等问题。基于此,提出一种基于改进3D U-Net的网络模型。通过将加入了密集块的3D U-Net网络和双向特征网络(Bi-FPN)融合,提高了模型分割精度。同时采用深度监督训练机制,进一步提高了网络性能。在公开数据集LUNA-16上对模型进行比较实验和评估,结果显示,改进后的3D U-Net网络,Dice相似系数较原模型提高4%,分割精度为93.9%,敏感度为94.3%,证明该模型在肺结节分割精度及准确率方面具有一定的应用价值。

关键词:肺结节分割;CT;3D U-Net;双向特征网络;深度监督

中图分类号:TP391;TP183 文献标识码:A 文章编号:2096-4706(2024)13-0052-05

Research on Lung Nodule Segmentation Method Based on Improved 3D U-Net Model

SHI Zhengjin, LI Wenhui, GAO Tian

(Shenyang Ligong University, Shenyang 110159, China)

Abstract: Due to the high complexity of feature information in lung CT images, the classic 3D U-Net network exhibits low accuracy in lung nodule segmentation, leading to issues such as miss segmentation. To address this, a network model based on improved 3D U-Net is proposed. This model integrates 3D U-Net network with dense blocks with the Bidirectional Feature Pyramid Network (Bi-FPN) to improve the model's segmentation accuracy. The adoption of deep supervision training mechanism further enhances network performance. Comparative experiments and evaluations are conducted on the public dataset LUNA-16, and the results show that the improved 3D U-Net network has a 4% increase in Dice similarity coefficient, a segmentation accuracy of 93.9%, and a sensitivity of 94.3% compared to the original model. This proves that the model has certain application value in the accuracy and precision of lung nodule segmentation.

Keywords: lung nodule segmentation; CT; 3D U-Net; bi-directional feature network; Deep Supervision

0 引 言

目前,肺癌已经成为当今世界死亡率最高的癌症之一[1],给人类的健康及生活带来了严重影响。肺癌早期通常以极少数良性结节的形式存在,由于此时结节的形状不规则、位置不规律,会影响医生的主观判断。近年来,随着医学图像数据集的增加和计算机GPU计算能力的提升,深度学习技术在计算机视觉领域取得了巨大进展,尤其在医学图像领域表现突出。借助深度学习方法辅助医生进行诊断,有效解决了漏诊、误诊等问题。

传统肺结节检测方法是基于人工手动提取肺结节[2],极其依赖医生个人经验,受人的主观影响较大,而基于深度学习的方法可以自动提取病灶特征[3],不需要人工参与,可以更加高效准确的完成分割任务。Çiçek等[4]提出了一种3D U-Net网络模型,该网络在原U-Net架构基础上引入了密集体积分割模块,以增强特征信息的复用;并通过半监督训练机制提高了模型整体性能,但由于半监督训练对数据的依赖性较强,从而限制了模型的分割性能。Milletari等[5]提出了V-Net模型,一种基于U-Net的三维图像分割网络,加入了残差连接模块,但其分割精度仍有待提高。Lin等[6]提出了一种基于3D U-Net改进的图像分割方法,该网络加入了Dense blocks模块,并通过深度监督结构进一步提升性能,但对不同尺度和层次信息的感知能力还有些许不足。

针对以上问题,本文提出了一种基于改进的3D U-Net密集连接双向特征网络,并通过加入深度监督结构,有效提高了模型的性能及对不同尺寸结节的感知能力,进一步提高分割精度,使其适用于多类型肺结节的高效分割。

1 网络结构

1.1 整体网络结构

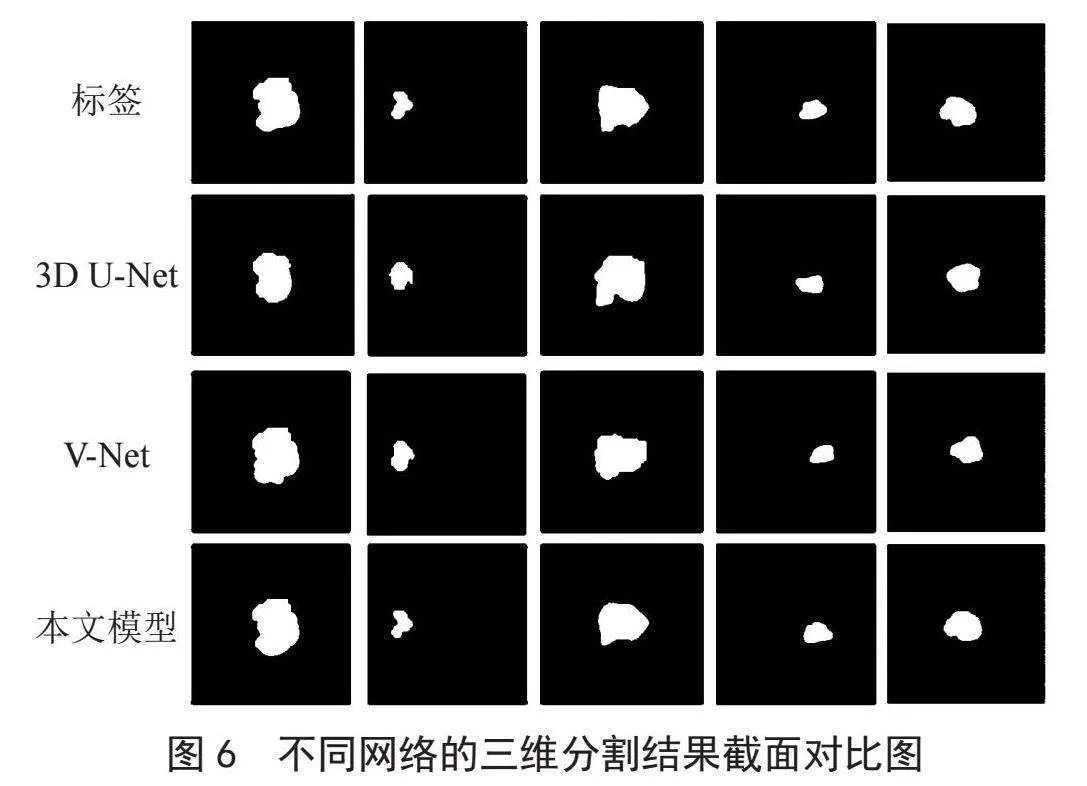

由于肺结节类型多,在肺部CT图像中占比较小,形状复杂,给肺结节的早期发现及治疗带来很大困难。基于这些问题,本研究提出了一种改进的3D U-Net分割模型,通过端到端深度学习方法,在编码器与解码器之间引入双向特征网络,进行多层次的特征融合。并在骨干网络部分采用密集连接网络[7](DenseNet)和深度监督模块,实现特征的重复使用并提高网络性能。整体网络结构如图1所示。

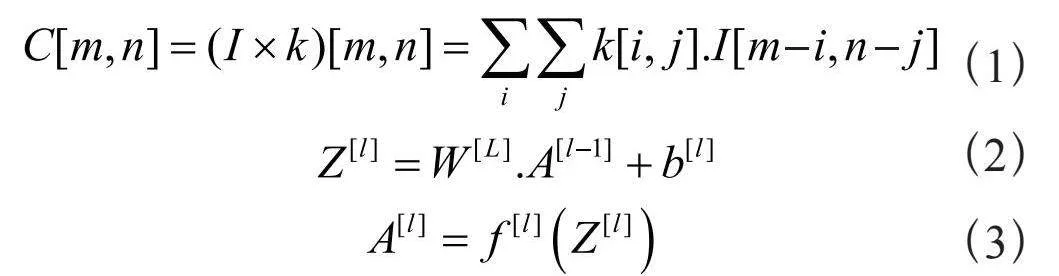

分割网络由加入了密集块的3D U-Net和Bi-FPN融合网络以及深度监督模块构成,在这个架构中,收缩路径具有卷积网络的典型结构,由两个3×3×3的卷积组成,每个卷积后跟一个非线性的Mish激活函数和一个2×2×2的步幅为2的最大池化,用于对输入图像特征进行降采样,收缩路径的深度为5。此外,为了对模型进行正则化,在深度为4的第二个3×3×3卷积块之后使用了一个因子为0.5的Dropout层。在模型的每一层发生的卷积过程计算式为:

式中i和k分别表示输入图像和核,A[l]、W [l]、b[l]、f [l]分别表示第1层的激活度、权值、偏置、激活函数。在5个深度处得到的特征被输入到Bi-FPN,输出的特征向量被输入到扩展部分。扩展路径中的每一步都包括对特征图进行上采样,然后进行2×2×2的卷积。在上采样后获得的特征向量与特征网络中相应的特征向量进行串联。串联操作后紧跟两个3×3×3的卷积。在骨干网络的最后一层,经历两个3×3×3的卷积。接着是Mish激活函数和一个最终的1×1×1卷积块,在网络的最后,通过一个大小为1×1×1步幅为1的卷积层构成一个输出模块,经由Sigmoid激活函数输出CT图像的掩膜,Mish和Sigmoid函数定义如下:

其中,Softplus函数定义为:

1.2 Bi-FPN

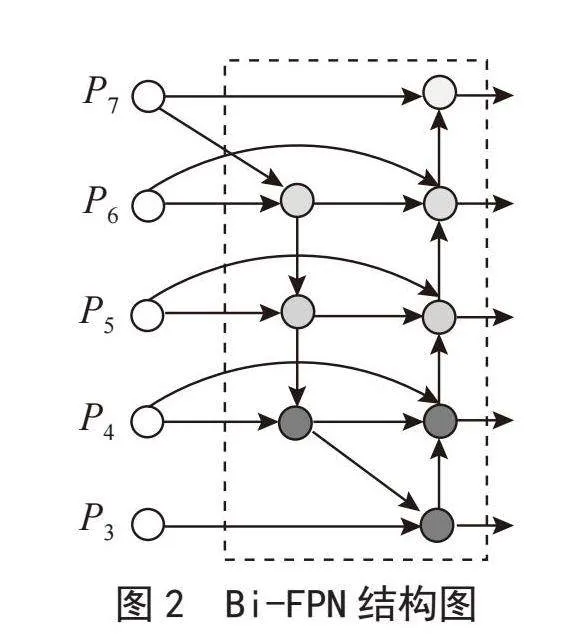

Bi-FPN [8](Bidirectional Feature Pyramid Network)是特征金字塔网络的一种改进版本,其目标是通过引入双向跨尺度连接和权重特征融合,提高网络的特征提取效率,并丰富特征向量,实现对低级精细特征和高级语义特征的融合。Bi-FPN的输入是骨干架构收缩路径相应5个深度的特征图,Bi-FPN的输出馈送到骨干网络的扩展路径,其网络结构图如图2所示。

Bi-FPN在特征融合过程中引入了每个输入的附加权重,使得网络能够学习特定输入特征的重要性。为了实现动态学习行为和准确性,实施了快速标准化融合。此外,为了提高效率,采用了深度可分离卷积,随后进行批归一化和非线性激活函数ReLU。通过双向跨尺度连接,Bi-FPN丰富了网络每个深度的特征图,并在3D U-Net骨干架构的编码器部分各个深度之间提供了高效的特征融合。Bi-FPN的整体结构如下:

式中p1表示自上而下路径,p2表示自下而上路径的特征图;U表示上采样操作,D表示下采样操作;W表示带有权重的特征融合。

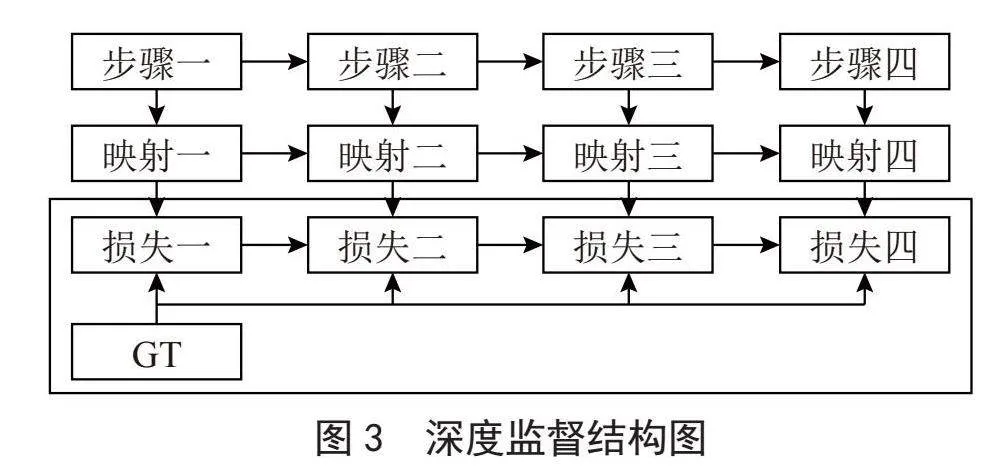

1.3 深度监督模块

深度监督[9]是在深度神经网络的一些中间隐藏层添加一个辅助分类器作为网络分支,用于监督骨干网络,以解决深度神经网络训练中的梯度消失和收敛缓慢的问题。其结构图如图3所示。

一般而言,增加神经网络的深度能够在一定程度上提高网络的表征能力,但随着深度的增加,神经网络会逐渐变得难以训练,包括梯度消失和梯度爆炸等现象。为了更好地训练深层网络,我们尝试在神经网络的某些层添加一些辅助分支分类器来解决这个问题。这个辅助分支分类器可以在评估隐藏层的特征图质量方面发挥作用。

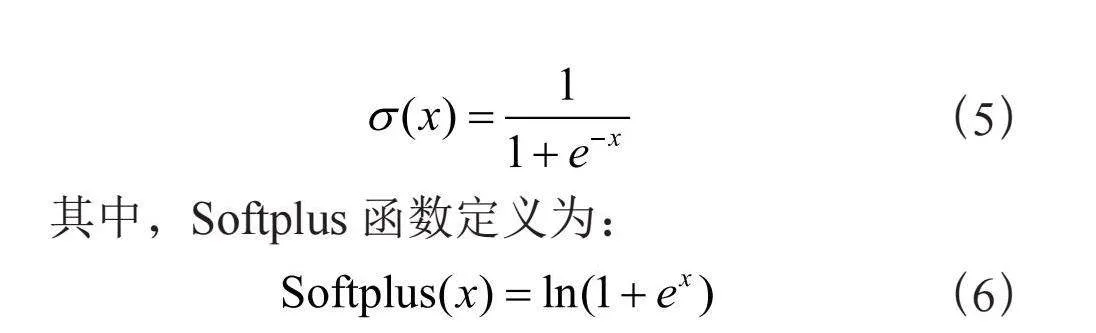

1.4 损失函数

网络训练的目标是提高每个掩膜中每个体素正确类别的概率。为了实现这一目标,本文采用了加权二元交叉熵损失(Weighted Binary Cross-Entropy Loss)作为损失函数。在实施加权二进制交叉熵时,通过对训练集中的负体素与正体素的比例进行加权,对每个样本进行了权重设置。由于肺结节掩膜中正类的大小相对较小,而负类的大小较大,训练集的类别权重被设定为正值,从而增加了对错误输出正值的惩罚。因此,网络将学习减少对输出负体素的偏好,以应对掩膜中的类别不平衡。加权二元交叉熵损失表达式为:

式中,N表示样本数,ωp表示正预测权值, 表示为模型的预测值。

2 数据处理

2.1 实验数据集

本实验所使用的数据来自LUNA16数据集,该数据集源于规模更大的LIDC-IDRI [10]。在LIDC-IDRI数据集的1 018个CT扫描病例中,选择厚度大于2.5 mm的888个CT图像用于模型的训练、验证及测试。在这些图像中,共包含1 186个肺结节[11],并且每张图像都被4名经验丰富的放射科专家进行了标注。

2.2 图像预处理

由于CT原始图片是整个肺部的切片,冗余信息过多,因此需要先提取出肺实质再进行后续结节的分割工作。为了提高图像的对比度,首先对图像进行直方图均衡化处理和二值化处理,粗略分割出肺实质。接着,采用膨胀和腐蚀两种数学形态学方法消除肺实质噪声,使肺实质边缘更加平滑。最后,通过掩膜提取ROI区域,各阶段图像如图4所示。

由于深度神经网络对数据高度依赖,数据量较少可能导致模型过度拟合。为了缓解这一问题,对数据进行不同角度的旋转和翻转,生成更多的新训练样本,以防止过度拟合并提高分割网络的通用性。最后,将整个数据集分成10份,其中8份用于训练,剩下的2份分别用于验证和测试模型。

3 实验结果与分析

3.1 模型训练

本文模型采用学习率为0.001的Adam优化器进行训练,每迭代3次衰减为原来的0.1倍,采用的训练迭代次数Epoch为100。图5是模型在训练过程中的准确率曲线,经过80个Epoch后,模型整体准确率趋于稳定。所用模型在GPU上使用TensorFlow深度学习库实现,编码使用的是Python 3.6。

3.2 对比试验

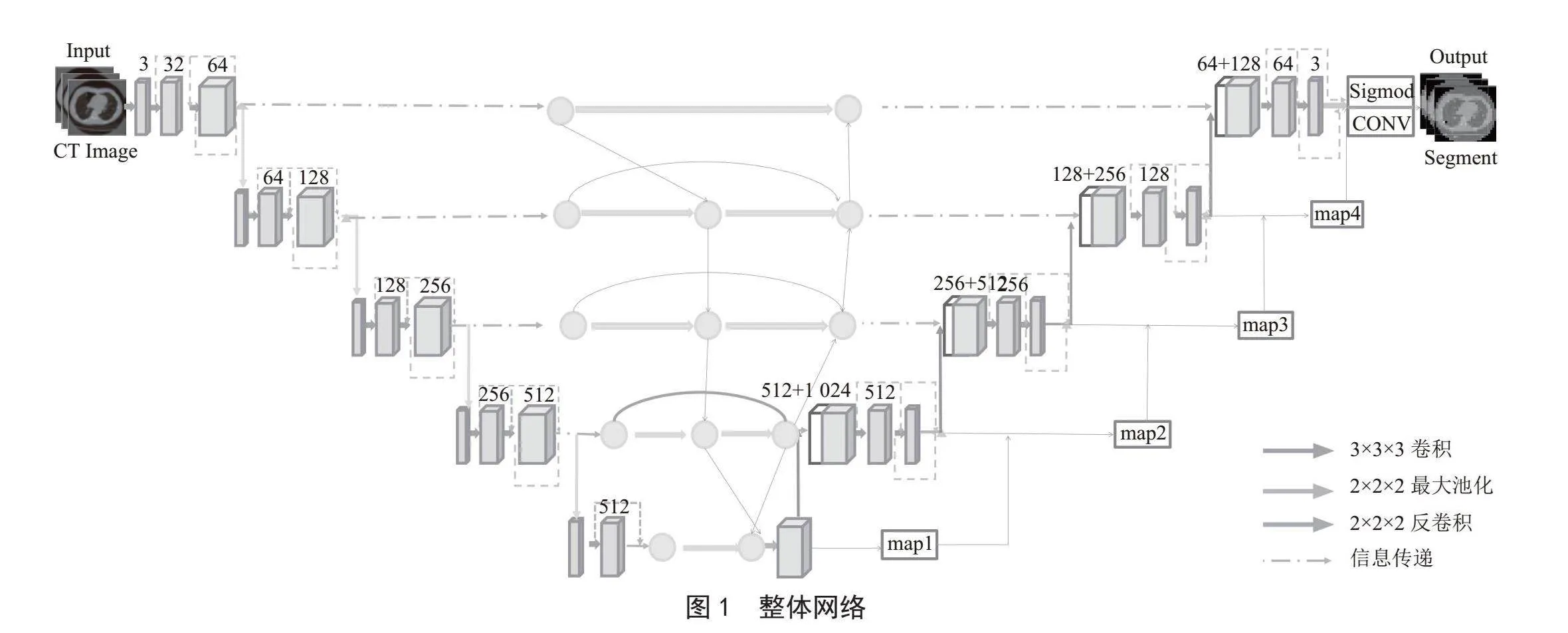

为了评估本文模型在肺结节分割方面的性能,我们将改进后的网络与3D U-Net和V-Net进行了对比实验。图6展示了这3种网络对5种不同尺寸肺结节图像的三维分割剖面图。

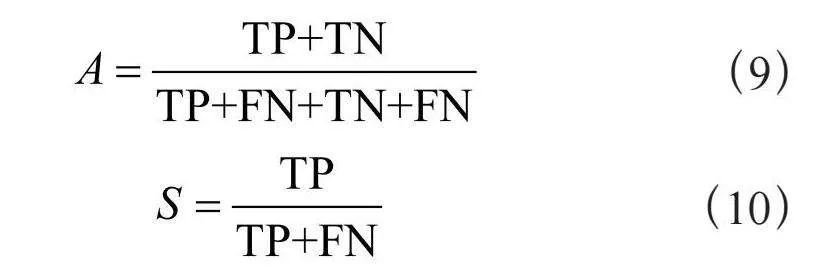

通过观察不同网络分割结果图,可以清晰看出改进后的3D U-Net在结节分割方面更为准确,其分割结果更接近于标签标注的结节边缘信息。为了全面评估模型性能,我们将提出的模型与其他两种网络在LUNA16数据集下进行了分割性能的评估和比较,主要考察了3个关键指标:Dice系数(DSC)、灵敏度(Sensitivity)和准确率(Precision)。其中准确率(A)和灵敏度(S)的计算公式如下:

式中,TP表示真正类;TN表示真负类;FN表示假负类;FP表示假正类。

比较不同网络结构在肺结节分割性能上的表现,表1清晰地展示了本文改进后的3D U-Net网络在该领域取得的结果最佳。具体而言,Dice相似系数达到了79.6%,灵敏度为94.3%,精确度为93.9%。与此相反,3D U-Net和VNet两种网络结构在感知不同尺寸肺结节方面表现较差,难以取得准确的分割结果。相对而言,本文提出的改进的3D U-Net网络通过引入Bi-FPN,将底层特征与顶层特征图进行连接,从而增强了模型对不同尺寸结节的感知能力。同时,结合深度监督训练机制,进一步提升了3D U-Net的网络性能,最终实现了卓越的肺结节分割效果。

4 结 论

本研究提出了一种基于改进的3D U-Net肺癌CT图像分割网络。该网络通过在编码器和解码器之间引入双向特征网络,促使特征在不同深度之间双向传播,从而增强模型的适应性和感知能力,显著提高了模型分割准确性。同时采用深度监督机制,提高了网络的性能和泛化能力。

然而,虽然该算法取得了一定的成果,但仍存在一些局限性,需要在未来的研究中进行改进。肺结节种类繁多且判断标准复杂,目前的数据集并未充分涵盖肺结节的多样性,因此该算法尚未完全应用于临床实践。随着技术的不断进步,计算机辅助诊断系统有望在肺结节检测领域发挥更为重要的作用。未来的研究可以侧重于扩充数据集、改进算法以适应更多肺结节的多样性,并不断优化系统,以提高在临床环境中的实用性和准确性。

参考文献:

[1] 周清华,范亚光,王颖,等.中国肺部结节分类、诊断与治疗指南:2016年版 [J].中国肺癌杂志,2016,19(12):793-798.

[2] ARMATO S G,GIGER M L,MORAN C J,et alQb3h9HaYQJKehJHD0vH8RA==. Computerized detection of Pulmonary Nodules on CT Scans [J].Radiographics,1999,19(5):1303-1311.

[3] LONG J,SHELHAMER E,DARRELL T. Fully Convolutional Networks for Semantic Segmentation [C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Boston:IEEE,2015:3431-3440.

[4] ÇIÇEK Ö,ABDULKADIR A,LIENKAMP S S,et al. 3D U-Net: Learning Dense Volumetric Segmentation from Sparse Annotation [C]//Medical Image Computing and Computer-Assisted Intervention–MICCAI 2016.Athens:Springer,2016:424-432.

[5] MILLETARI F,NAVAB N,AHMADI S,et al. V-Net: Fully Convolutional Neural Networks for Volumetric Medical Image Segmentation [C]//2016 Fourth International Conference on 3D Vision (3DV).Stanford:IEEE,2016:565-571.

[6] LIN H B,XIA L Z,ZHANG Y H,et al. Research of Lung Nodule Segmentation Algorithm Based on 3D U-Net Network [C]//2022 IEEE 10th Joint International Information Technology and Artificial Intelligence Conference (ITAIC).Chongqing:IEEE,2022:1795-1799.

[7] HUANG G,LIU Z,MAATEN L V D,et al. Densely Connected Convolutional Networks [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:2261-2269.

[8] LIN T Y,DOLLÁR P,GIRSHICK R,et al. Feature Pyramid Networks for Object Detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:936-944.

[9] YANG J Z,WU B,LI L T,et al. MSDS-UNet: A multi-Scale Deeply Supervised 3D U-Net for Automatic Segmentation of Lung Tumor in CT [J/OL].Computerized Medical Imaging and Graphics,2021,92:101957[2023-12-03].https://pubmed.ncbi.nlm.nih.gov/34325225/.

[10] ARMATO S G,MCLENNAN G,BIDAUT L,et al. The Lung Image Database Consortium (LIDC) and Image Database Resource Initiative (IDRI): a completed reference database of lung nodules on CT scans [J].Medical physics,2011,38(2):915-931.

[11] HARITH M Z M Z,NOOR N M,IDRIS M Y I,et al. Intersection and Complement Set (IACS) Method to Reduce Redundant Node in Mobile WSN Localization [J/OL].Sensors,2018,18(7):2344[2023-12-03].https://pubmed.ncbi.nlm.nih.gov/30029508/.

作者简介:石征锦(1963—),男,汉族,辽宁锦州人,教授,硕士,主要研究方向:先进控制理论及应用、现代检测与自动化装置;李文慧(1997—),女,汉族,辽宁鞍山人,硕士研究生在读,主要研究方向:复杂系统综合自动化技术;高天(1998—),男,汉族,辽宁朝阳人,硕士研究生在读,主要研究方向:复杂系统综合自动化技术。