具有性能感知排序的深度监督哈希用于多标签图像检索

摘 要:现实生活中的图像大多具有多种标签属性。对于多标签图像,理想情况下检索到的图像应该按照与查询图像相似的程度降序排列,即与查询图像共享的标签数量依次递减。然而,大多数哈希算法主要针对单标签图像检索而设计,而且现有用于多标签图像检索的深度监督哈希算法忽略了哈希码的排序性能且没有充分地利用标签类别信息。针对此问题,提出了一种具有性能感知排序的深度监督哈希方法(deep supervised hashing with performance-aware ranking,PRDH),它能够有效地感知和优化模型的性能,改善多标签图像检索的效果。在哈希学习部分,设计了一种排序优化损失函数,以改善哈希码的排序性能;同时,还加入了一种空间划分损失函数,将具有不同数量的共享标签的图像划分到相应的汉明空间中;为了充分地利用标签信息,还鲜明地提出将预测标签用于检索阶段的汉明距离计算,并设计了一种用于多标签分类的损失函数,以实现对汉明距离排序的监督及优化。在三个多标签基准数据集上进行的大量检索实验结果表明,PRDH的各项评估指标均优于现有先进的深度哈希方法。

关键词:深度监督哈希;多标签图像检索;排序;标签信息

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2024)07-043-2221-08

doi: 10.19734/j.issn.1001-3695.2023.09.0511

Deep supervised hashing with performance-aware ranking formulti-label image retrieval

Abstract: Most images in real life have multi-label attributes. For multi-label images, ideally, the retrieved images should be ranked in descending order of similarity to the query image, namely their numbers of labels shared with the query image decrease sequentially. However, most hashing algorithms are mainly designed for the single label image retrieval, and the exis-ting deep supervised hashing algorithms for multi-label image retrieval ignore the ranking performance of hash codes and do not fully utilize the label category information. To solve this problem, this paper proposed a deep supervised hashing with performance-aware ranking method(PRDH), which could effectively perceive and optimize the performance of the model and improve the effect of the multi-label image retrieval. In the hash learning part, this paper designed a ranking optimization loss function to improve the ranking performance of hash codes. At the same time, this paper adopted a spatial partition loss function to divide images with different numbers of shared labels into corresponding Hamming spaces. In order to fully utilize label information, this paper also explicitly proposed using predictive label for Hamming distance calculation in the retrieval stage, and designed a loss function for multi-label classification to achieve supervision and optimization of Hamming distance ranking. A large number of results of the retrieval experiments conducted in three multi-label benchmark datasets show that the evaluation metrics of PRDH outperform the state-of-the-art hashing approaches.

Key words:deep supervised hashing; multi-label image retrieval; ranking; label information

0 引言

在数字化时代,如何快速且准确地从海量图像中检索到目标图像,是图像处理和计算机视觉领域研究的重点与难点任务之一[1]。为此,早期研究者们提出了一种用于图像检索的哈希算法,该算法将图像从原始空间映射到汉明空间,并以二值码的形式存储。该方法具有存储空间小、检索速度快的优点。在众多检索性能优良的传统哈希方法中,最典型的有局部敏感哈希(locality sensitive hashing,LSH)[2]、迭代量化哈希(iterative quantization, ITQ)[3]、最小损失哈希(minimal loss hashing,MLH)[4]、二值重构嵌入(binary reconstructive embedding,BRE)[5]、核监督哈希(kernel-based supervised hashing,KSH)[6]以及监督汉明哈希(supervised Hamming hashing,SHH)[7]等方法。然而,传统的哈希方法由于采用手工设计,通常具有一定的局限性,尤其在提取更加复杂的语义信息方面,相比于基于深度学习的哈希方法效果较差。深度哈希方法不仅能够自动提取更加抽象的特征信息,而且在大规模图像检索领域中也有广泛应用。在深度监督哈希方法中,具有代表性的有卷积神经网络哈希(convolutional neural network hashing,CNNH)[8]、深度监督哈希(deep supervised hashing,DSH)[9]、深度平衡离散哈希(deep balanced discrete hashing,DBDH)[10]、中心相似性量化(central similarity quantization,CSQ)[11]、正交哈希(orthogonal hashing,OrthoHash)[12]和深度哈希蒸馏(deep hash distillation,DHD)[13]方法等。

目前,基于深度监督哈希的图像检索方法得到了广泛而深入的研究。然而,在深度监督哈希方法中通常存在如下三个问题:a)现实生活中的图像大多数具有多种标签属性,而大多数深度监督哈希方法主要针对单标签图像检索而设计,因而在多标签图像检索中效果不佳;b)大多数深度监督哈希方法忽略了哈希码的排序特性;c)良好的类别信息有助于哈希码排序特性的学习,然而,这并没有被大多数深度监督哈希方法所充分利用。这三个问题的存在使得多标签图像检索研究有着进一步的改进空间,也日益得到研究者的广泛关注。其中,针对前两个问题,大多数方法是在成对或三元组损失函数的基础上改进为多级相似性损失函数来指导哈希函数的学习[14~19],使学习到的哈希码更具有排序特性。同时,针对第三个问题,一些哈希方法在损失函数中加入分类损失[14,15,17,18,20],以使哈希码学习到更多的类别信息。但是它们往往只能在哈希函数中学习类别信息,这是远远不够的。因此,本文希望通过充分利用类别信息来学习到更具有排序特性的哈希码。

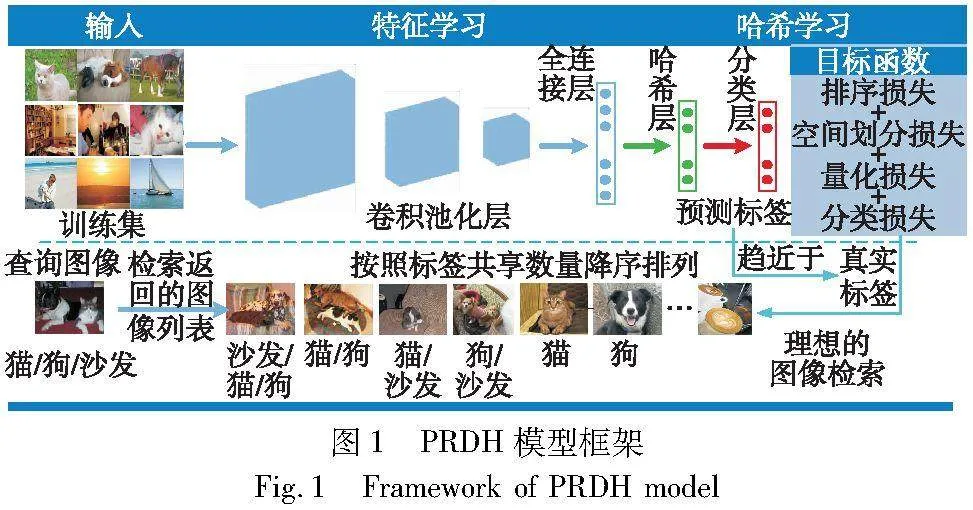

通常,对于多标签图像检索,理想情况下检索到的图像应该按照与查询图像的相似程度降序排列,即与查询图像相同的标签数量依次递减。这既符合人类的认知,也是人们查询时的需求。例如,如图1中的理想图像检索状态所示,查询图像是一幅具有“猫”“狗”和“沙发”三个标签属性的图像,理想情况下检索到的相似图像排序列表如下:首先,与查询图像有三个标签相同的图像在第一区间;其次,三个标签中任意两个相同的图像在第二区间;再次,三个标签中任意一个相同的图像在第三区间;最后,不具有相同标签的图像在第四区间;同时,在以上每区间内的图像均分别按照与查询图像的相似程度进行降序排列。因此,为了能够以最大可能实现理想的多标签图像检索,针对上述问题,本文提出了一种具有性能感知排序的深度监督哈希算法(deep supervised hashing with performance-aware ranking,PRDH)。图1概括了PRDH模型框架。该框架将多标签图像的特征学习和哈希学习结合在一起进行联合学习,其中,哈希学习部分由排序损失、空间划分损失、量化损失和分类损失函数组成,以使学习到的哈希码具有良好的排序特性。同时,为了充分利用标签信息,鲜明地将预测标签用于检索阶段的汉明距离计算上,以监督和优化汉明距离的排序。如果预测标签越接近真实标签,且哈希函数能学习到具有良好排序特性的哈希码,那么汉明距离的排序越接近于按照共享标签数量大小的排序,从而较好地接近、甚至实现理想情况下的多标签图像检索。本文的主要贡献可以概括为以下四个方面:

a)提出了一种具有性能感知排序的深度监督哈希算法,它可以将原始空间与汉明空间统一起来,有效地感知和优化模型的性能,提高了多标签图像检索的性能。

b)设计了一种排序优化损失函数,以改善哈希码的排序特性。还加入了一种空间划分损失函数,以将具有不同数量的共享标签的图像划分到相应的汉明空间中。同时,在量化损失函数的约束下,使得学习到的哈希码更加具有离散特性。

c)鲜明地提出了一种将预测标签用于检索阶段的汉明距离计算的策略,并设计了一种用于多标签分类的损失函数,从而利用标签信息实现对汉明距离排序的监督与优化。

d)在三个多标签基准数据集上的实验结果表明,本文方法的各项评估指标均优于现有先进的深度监督哈希方法。

1 相关工作

目前,由于大多数深度监督哈希方法主要针对单标签图像检索而设计,所以在多标签图像检索中往往性能不佳。为了有效地提高多标签图像检索的性能,已有研究者提出了一些可行的方法。其中,大多数深度监督哈希方法主要在成对或三元组损失函数的基础上进行改进,学习具有排序特性的哈希函数。例如,Zhao等人[21]提出了一种深度语义排序哈希算法DSRH(deep semantic ranking based hashing),该方法采用NDCG(normalized discounted cumulative gain)指标作为三元组损失的权重,来指导哈希函数的学习,使学习到的哈希码具有排序特性。Zhang等人[16]提出了一种改进的深度哈希网络IDHN(improved deep hashing network),该方法将成对相似性分为硬相似性和软相似性两种情况来指导哈希函数的学习,使学习到的哈希码具有较好的排序特性。类似地,Dai等人[18]提出了特征分离与交互学习方法,该方法设计了一种标签引导的相似性损失函数以保持图像间的相似性。为了使哈希码具有更好的排序特性,Ma等人[19]提出了一种排序一致性深度哈希算法RCDH(rank-consistency deep hashing),该方法设计了一种排序一致性哈希函数,以对齐原始空间和汉明空间的相似顺序。为了充分地利用多个标签之间的相关性,Shen等人[20]提出了深度协同图像标签的哈希方法DCILH(deep co-image-label hashing)来利用标签相关性,该方法将图像和标签映射到一个公共的深度汉明空间,以保持图像、标签和标签原型之间的相似性。特别地,为了有效地利用图像的语义信息和标签信息,Chen等人[22]提出了一种基于深度多实例排序的哈希方法DMIRH(deep multiple-instance ranking based hashing),该方法通过具有多标签的图像识别出其中的不同标签实例,并对不同的实例进行分类和特征提取,然后将属于该图像的所有特征信息再聚合起来编码为二值哈希码。类似地,Qin等人[23]提出了一种具有类损失的深度顶端相似性哈希算法DTSHCW(deep top similarity hashing with class-wise loss),该方法直接利用类标签,并引入基于高斯分布的三次约束来优化目标函数,以保持不同类的语义变化。另一方面,还有一些用于多标签图像检索的深度哈希方法,它们为了充分地利用图像的标签信息,根据图像的标签内容生成描述图像的简单文本信息,并将提取的文本信息和提取的图像语义信息相结合,从而有效地提高了模型的多标签图像检索性能,如标签参与哈希[24]、深度语义感知排序保持哈希[25]和具有语义感知保持的深度多相似性哈希[26]等。尽管上述这些多标签深度哈希方法均取得了较好的检索性能,但是它们仅仅在哈希函数中学习类别信息。相比较地,本文方法则希望在哈希学习之外,在检索阶段也可以利用标签信息,以监督和优化汉明距离的排序。

2 所提方法

对于多标签图像数据集,本文希望检索到的图像不仅正确,而且对应的共享标签数量也应该是依次递减的。为此,本文提出了一种具有性能感知排序的深度监督哈希方法。该方法能够有效地实现深度哈希学习和多标签分类,其采用的目标函数为

loss=lossR+αlossS+βlossQ+γlossC(1)

其中:lossR为排序优化损失函数;α、β和γ分别为控制空间划分损失函数lossS、量化损失函数lossQ和多标签分类损失函数lossC的参数。

2.1 哈希学习

为了获得高质量的哈希码,在哈希学习过程中,本文设计了排序优化损失函数、空间划分损失函数和量化损失函数。

2.1.1 排序优化损失函数

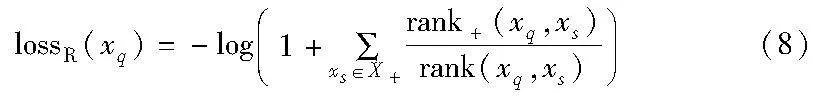

为了最大化AP(xq),并使训练过程中损失最小,xq的排序优化损失函数定义为

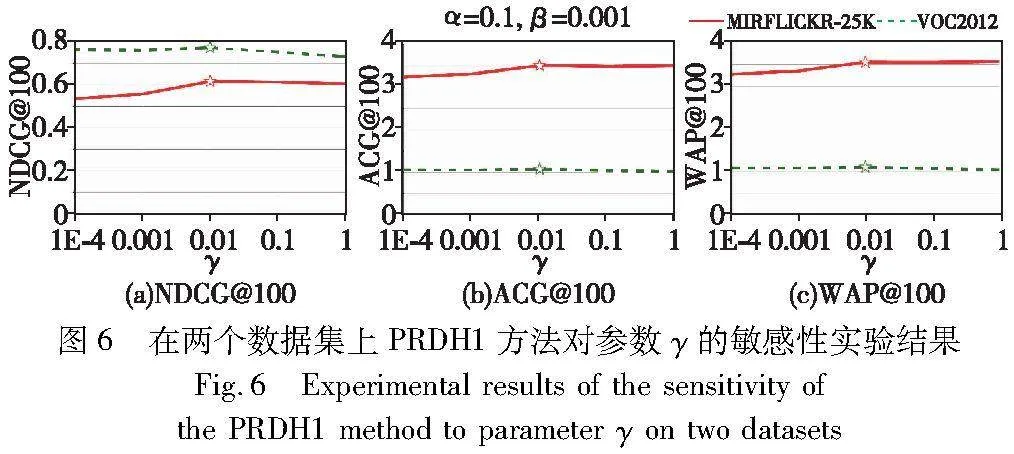

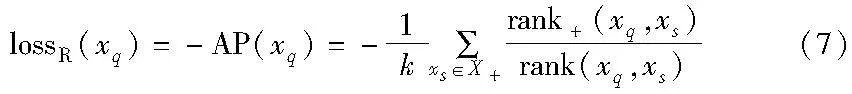

此外,为了便于反向传播更新参数,忽略了式(7)中的1/k。同时,对式(7)取对数,并考虑稳定性,则xq的排序优化损失函数为

另一方面,为了使lossR更好地适用于多标签图像检索,本文为每个相似样本集X+中相似样本的相似性排名添加了相应的共享标签归一化权重wr,可表示为wr=lqs/lmax,q,s∈[1,n],其中,lqs=yqyTs表示xq和xs之间的共享真实标签数,lmax为最大的共享标签数。显然,相似样本之间的共享标签数越多,wr越大,对应的排序优化损失惩罚就越大,使学习到的对应哈希码间更具相似性。相应地,式(8)可改写为

最终,当前批次的样本集的排序优化损失函数为

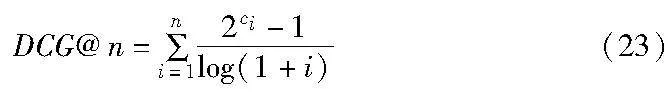

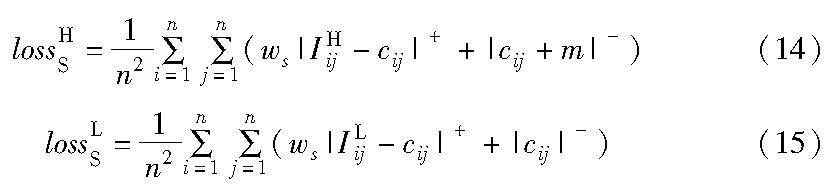

2.1.2 空间划分损失函数

在lossR的基础之上,本文加入了空间划分损失lossS以增强具有多标签的哈希码的排序性能。Ma等人[19]曾根据图像之间共享标签的数量对汉明空间进行划分,并指出图像之间共享标签的数量与对应的汉明距离成正比(汉明距离可表示为dij=(m-cij)/2,其中,i, j∈[1,n],m为哈希码长,cij=bibTj表示第i和j个哈希码间的内积)。可以推断,此时图像之间共享标签数量与对应的哈希码内积成反比。然而,通常认为图像之间共享的标签数量越多,对应的哈希码内积就越大。为此,本文提出了一种新的空间划分模型,如图2所示。它通过绝对值约束使得每一对图像的共享标签数都对应一个区间的哈希码内积,且共享标签的数量与对应的哈希码内积成正比,与对应的汉明距离成反比。

在式(12)(13)中,等式右边第一项分别表示计算相似样本的空间划分上界损失和下界损失,以使每个相似样本根据相似性程度的大小学习到相应大小的哈希码内积;第二项分别表示计算不相似样本的空间划分上界损失和下界损失,以使每个不相似样本学习到的哈希码内积尽可能在-m~0。此外,为了缓解相似样本和不相似样本的不均衡问题,在式(12)(13)中为正样本加入权重ws,它是不相似样本数量和相似样本数量的比值,即

同时,为了便于配合lossR,同样对lossHS和lossLS分别取对数,即

lossS=log(1+lossHS)+log(1+lossLS)(16)

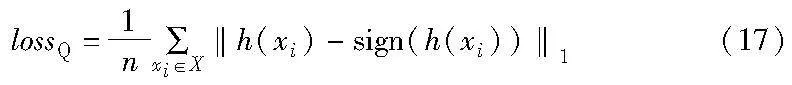

2.1.3 量化损失函数

通常,理想的哈希码是紧凑且离散的二值码。在式(10)(16)中,由于哈希码的离散性,使得模型在训练时,梯度无法进行有效的反向传播。鉴于此问题,使用输入图像x在深度网络哈希层输出的实值h来替换其对应的哈希码b。同时,为了使h的值接近于+1或-1,加入如式(17)所示的量化损失函数,以减少哈希函数学习过程中造成的量化损失。

2.2 多标签分类损失函数

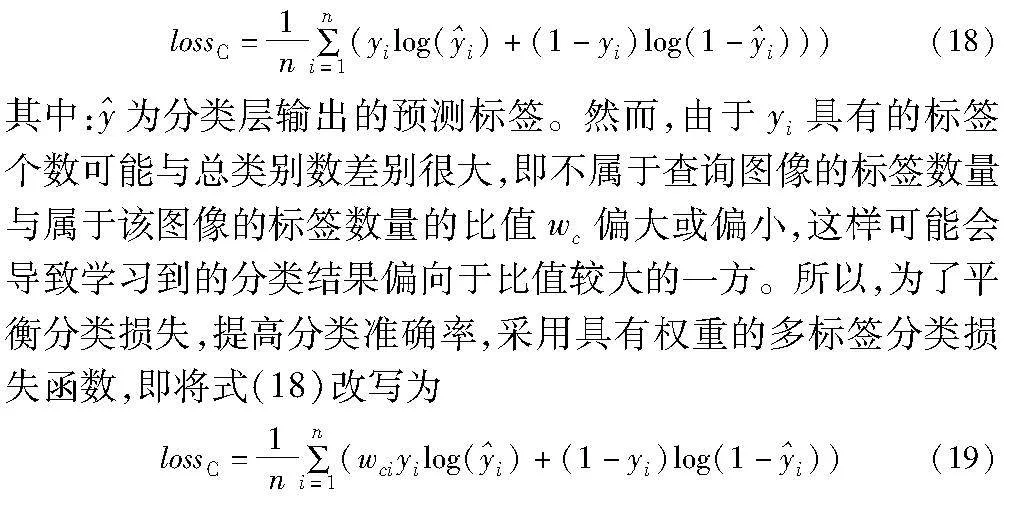

针对多标签图像,在分类层中采用sigmoid激活函数,并对每一个类别进行二分类。通常,对应的分类损失函数采用交叉熵损失,即

2.3 标签强监督

以往的监督哈希方法主要注重在哈希学习过程中采用标签进行监督。然而,对于多标签图像,这种监督不够全面,因为它没有充分挖掘标签信息。此外,在检索阶段,按汉明距离排序时的排序质量往往只依赖于强大的哈希函数去学习一个高质量的哈希码,而本文则希望标签信息也能参与汉明距离的计算,从而优化汉明距离的排序质量,提高模型的检索性能。具体地,在汉明距离计算时,将查询图像的真实标签yt和数据库图像的真实标签yd之间的共享标签数量l=ytyTd作为权重,若它们哈希码之间的内积为c,则其汉明距离计算如下:

3 实验

3.1 数据集

实验采用了MIRFLICKR-25K、VOC2012、NUS-WIDE和MS-COCO四个广泛使用的多标签数据集。

a)MIRFLICKR-25K是一个包含有38个标签的多标签彩色图像数据集。它总共有25 000幅图像,平均每幅图像大约有4.7个标签。同文献[23],本文选择2 000幅图像作为测试集和查询数据集,剩余的作为训练集和数据库。

b)VOC2012是一个包含有20个标签的多标签彩色图像数据集。本文实验中仅使用其训练和验证数据集(共11 540幅图像)。同文献[23],本文随机选择2 000幅图像作为测试集和查询数据集,剩余的作为训练集和数据库。

c)NUS-WIDE是一种包含195 834幅彩色图像的大规模多标签数据集,它有21个类别,每个类别至少包含5 000幅图像。同文献[20],本文采用2 100幅图像(每类100幅)作为测试集和查询集,其余的作为数据库,并从数据库中随机抽取10 500幅图像作为训练集(每类500幅)。

d)MS-COCO数据集是一种包含122 218幅彩色图像的大规模多标签数据集,它有80个类别。同文献[13],本文随机挑选5 000幅图像作为测试集和查询集,其余的作为数据库,并从数据库中随机抽取10 000幅图像作为训练集。

3.2 实验设置和评估指标

所有实验均在一台配置为Geforce RTX 2060 6GB GPU和8 GB RAM的计算机中实现。使用具有预训练权重的AlexNet[28]作为本文模型的骨干网络(也可替换为其他骨干网络),并将上述三个数据集的图像均缩放到224×224像素大小作为网络输入。训练总共进行300个epoch,学习率为0.000 01。根据经验,超参数α、β和γ分别设置为0.1、0.001和0.01;由于分类层采用sigmoid激活函数,所以阈值T设置为0.5。

为了评估本文方法的性能,采用平均精度均值(MAP)、归一化折损累积增益(NDCG)、平均累积增益(ACG)和加权平均精度(WAP)四个常用的检索评估指标。其中,对于NUS-WIDE和MS-COCO数据集,使用返回的前5 000幅图像计算MAP值。

MAP描述的是所有查询图像的平均精度AP的均值,其中,AP是准确率(precision)的均值。通常,检索得到的正确结果排名越靠前,检索系统的MAP就越高。若Q为查询图像数量,为前n个检索结果中与第i幅查询图像相关的图像数量,MAP的计算公式为

其中:I(i, j)为指示性函数,如果第i幅查询图像与第j幅图像共享一些标签,则I(i, j)=1,否则I(i, j)=0。

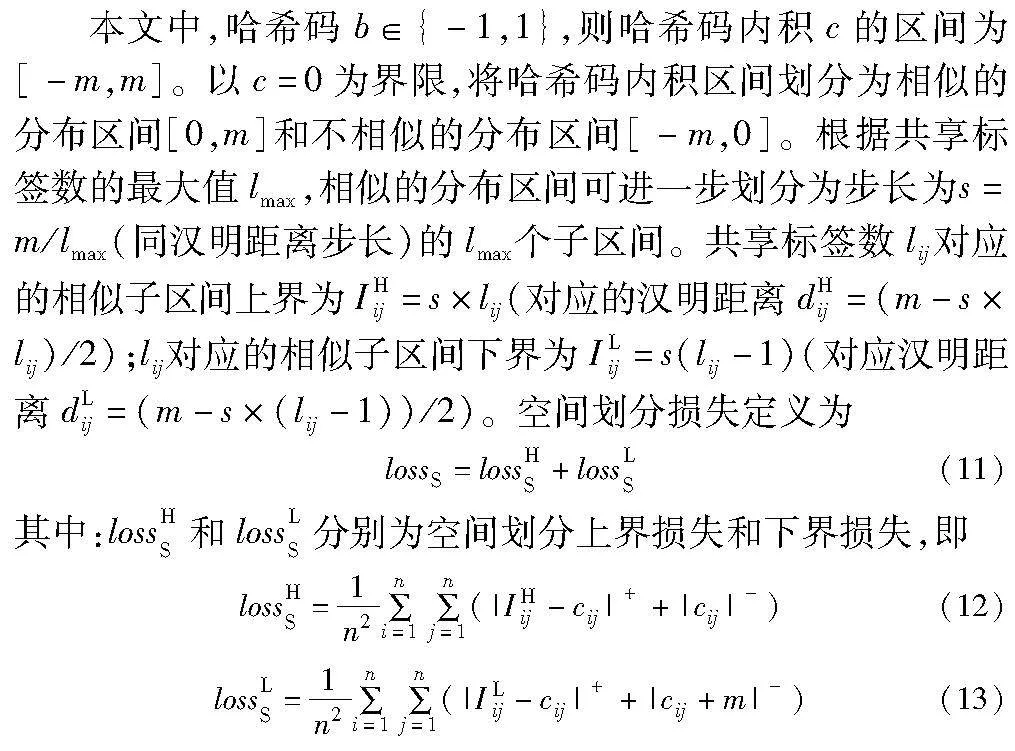

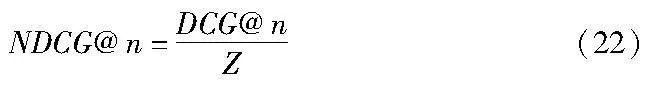

NDCG被广泛用于评估信息检索任务中排名结果的质量,它关注相似度更高的图像。与MAP类似,更相似的正确结果排名越靠前,该指标就越大。检索得到前n个图像的NDCG计算公式为

其中:Z为DCG@n的最大值,它是根据检索返回结果的正确排名列表计算的,DCG的计算公式为

其中:ci表示查询图像与第i幅检索图像之间的共享标签数。

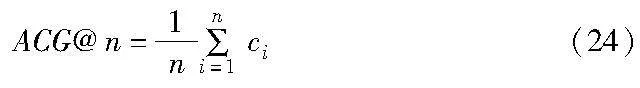

ACG描述的是查询图像和前n个检索图像之间的平均相似度,计算公式为

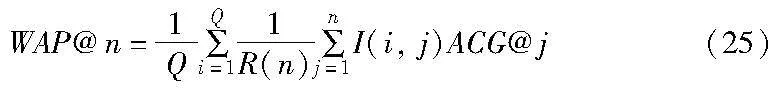

WAP是MAP的一种变体,它可以根据ACG来计算,对于评估模型的检索性能更为准确和科学。检索得到前n个图像的WAP计算公式为

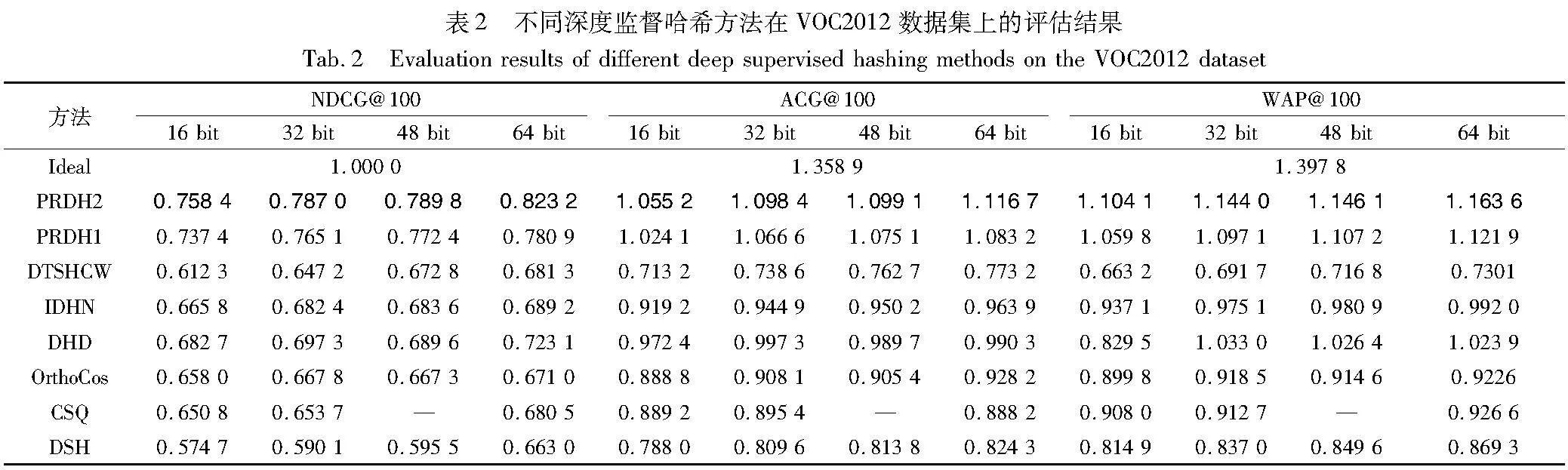

3.3 不同方法检索性能的对比

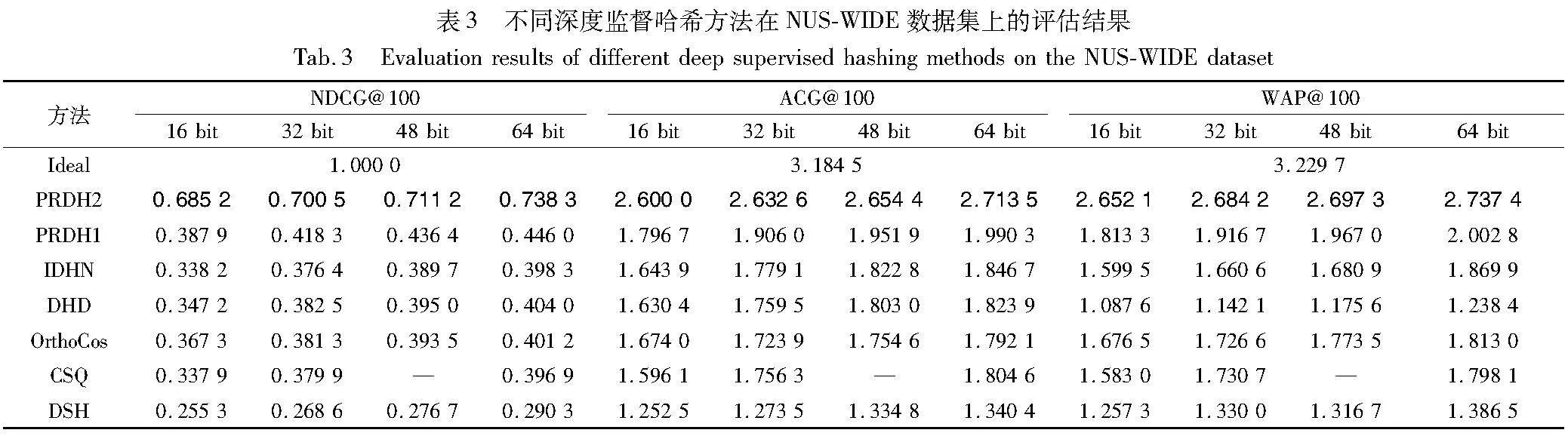

为了有效地评估PRDH1和PRDH2(参见2.3节)的有效性,本文选择参与对比的深度监督哈希方法有DHD[13] 、OrthoCos[12]、CSQ[11]、DHEH[29]、DSH[9]、IDHN[16]、RCDH[19]、DTSHCW[23]、DCILH[20]、HyP2[30]和MCRD[31]十一种典型方法,另外还加入了理想情况下的图像检索“Ideal”方法用于对比。其中,后六种深度哈希方法主要是针对多标签图像检索而设计的。表1~3分别对比了不同的深度监督哈希方法在不同数据集上针对NDCG@100、ACG@100、WAP@100三种评价指标的检索结果,其中,“—”表示对应的方法中没有此结果;黑色加粗字体表示当前对比方法中评价指标最好(“Ideal”方法除外)。通过观察表1~3中的数据,有以下四点发现:

a)综合所有指标考虑,虽然用于多标签图像检索的深度哈希方法优于主要针对单标签图像检索而设计的深度哈希方法,但是后者中少数方法在某些数据集或者某些评估指标上优于前者。例如,在VOC2012数据集上,后者中的DHD方法在三个评估指标中均好于前者,OrthoCos方法在部分评估指标中也仅次于DHD方法。这主要是由于DHD和OrthoCos这两种方法在其哈希函数的学习中分别针对性地设计了一种学习类标签相似性的损失函数和多标签分类损失函数,从而使其学习到的哈希码具有更多的类别信息。

b)本文方法在三个数据集上的三个评估指标均优于所对比的深度哈希方法。例如在MIRFLICKR-25K数据集上,当码长为48 bit时,PRDH1方法相较于DTSHCW方法的NDCG@100指标提升了6.51%、相较于RCDH方法的ACG@100指标提升了8.20%、相较于DHD方法的WAP@100指标提升了12.03%。

c)PRDH2是所对比方法中较为接近于理想图像检索的一种深度监督哈希方法。前述中,PRDH1方法在各项指标上均优于其他深度监督哈希方法。而在数据库的标签信息已知的情况下,PRDH2相对更加接近于“Ideal”方法的理想指标。以检索任务难度最大的NUS-WIDE数据集为例,当码长为48 bit时,PRDH2的三个评价指标NDCG@100、ACG@100和WAP@100达到了“Ideal”方法的71.12%、83.35%、83.51%,而相较于PRDH1也显著提升了62.96%、35.99%、37.12%。

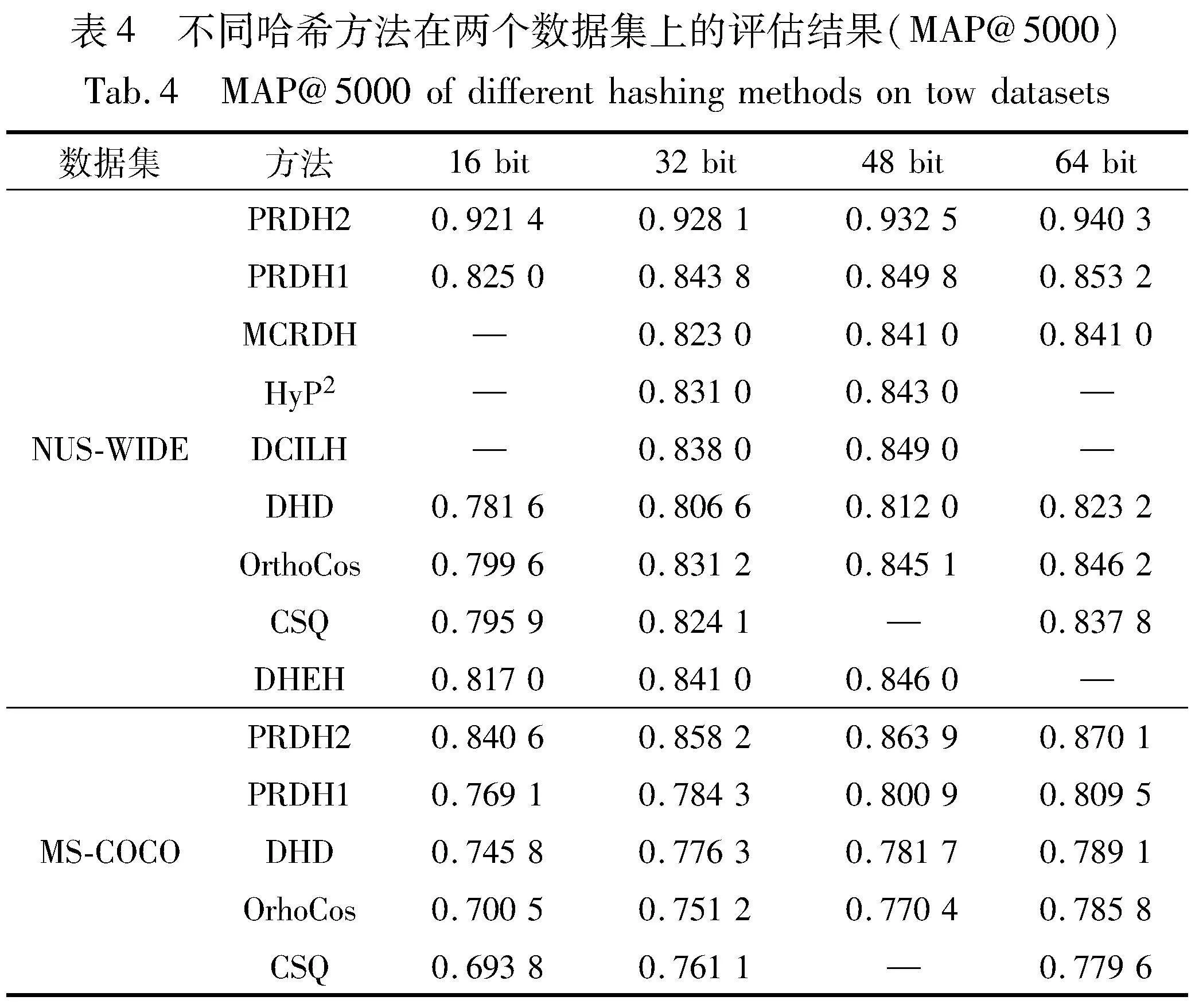

d)实验还在更具有挑战性的NU-SWIDE和MS-COCO数据集上对目前较为先进的深度监督哈希方法的MAP值进行评估,评估结果如表4所示。从表4可以看出,本文方法不论是在NUS-WIDE上,还是在MS-COCO上,不同哈希码长对应的MAP值均优于目前较为先进的深度哈希方法。

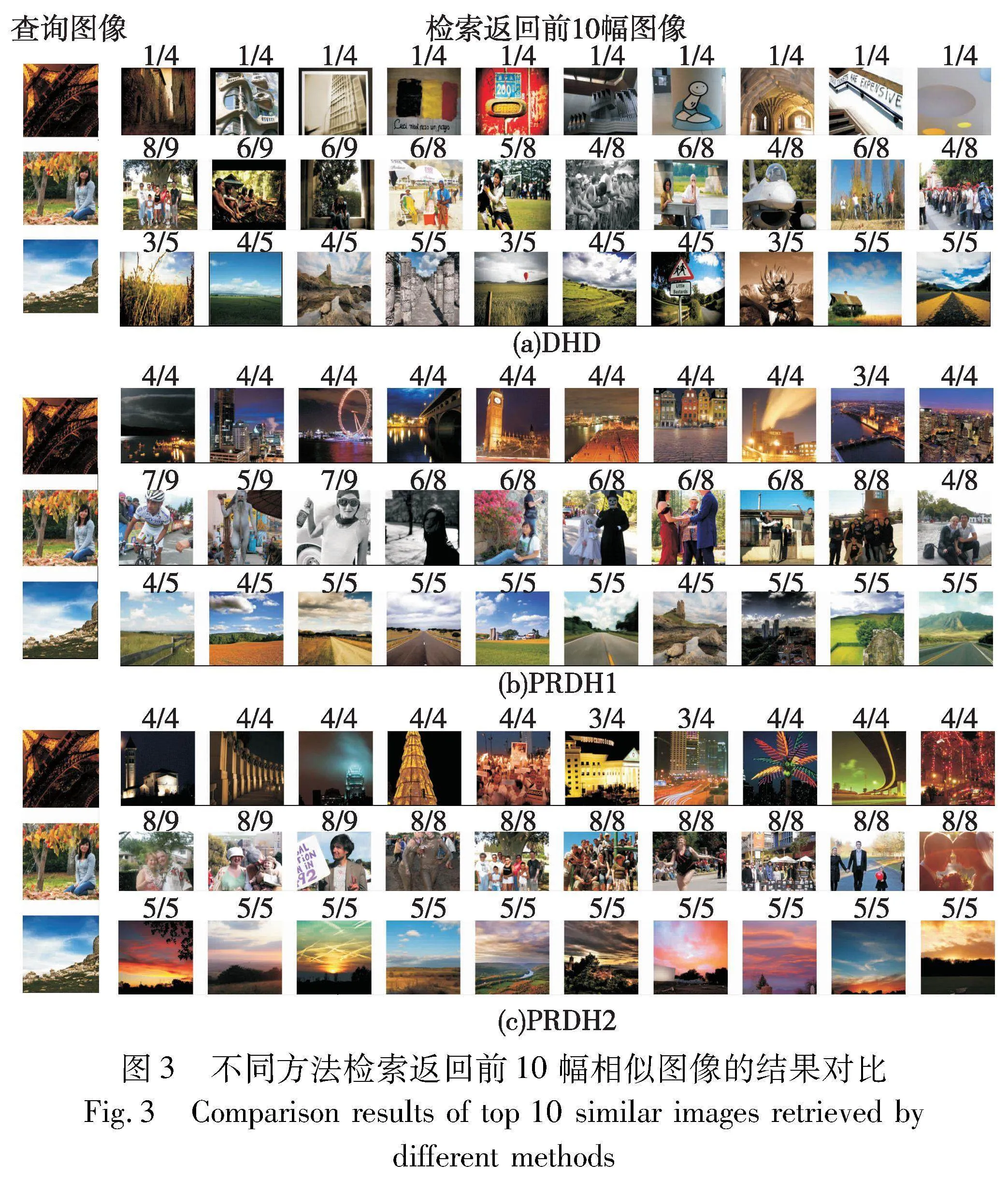

为了从可视化的角度说明本文方法良好的排序性能,实验以MIRFLICKR-25K数据集为例,从测试集中随机挑选三幅查询图像,在哈希码长为48 bit时,将PRDH1和PRDH2方法与深度哈希模型中检索性能较好的DHD方法进行对比,图3可视化了三个哈希方法检索返回的前10幅最相似图像。图中左边第1列为查询图像,第2~11列为检索返回的前10幅图像;返回图像上方的“/”两侧标注的数字分别表示与查询图像共享的真实标签数和理论情况下的标签数。

从图3可知,PRDH1和PRDH2相比DHD方法,检索返回的图像更加相似且共享标签数更多;尤其是PRDH2的检索结果几乎全部正确,检索结果更接近于理想的图像检索。这表明,本文方法具有良好的排序性能。需要指出的是,本文方法检索返回的部分图像列表中,也存在共享标签数排序不理想的情况,例如图3(b)中第二个查询图像的检索返回结果的共享标签数并未完全按照倒序排列,该现象说明本文方法还有进一步的完善空间。

为了进一步说明本文方法的有效性,实验将提出方法中“预测标签用于检索阶段的汉明距离计算上”这一策略用于其他深度哈希方法。以表1~4中深度哈希方法检索性能较为突出的DHD和OrthoCos为例,采用这一策略的这两种深度哈希方法被分别命名为DHD+和OrthoCos+。将改进的两种方法与其原方法在三种数据集上进行不同评估指标的对比实验,其中,码长为48 bit时的评估结果如表5所示。从表5的数据可以看出,改进的这两种深度哈希方法相较其原方法均有明显的提升,这表明标签信息参与汉明距离的计算与排序非常有助于改善多标签图像检索的性能;同时可以看到,本文方法的检索性能仍优于这两种改进方法,验证了本文方法的有效性和优越性。

3.4 参数敏感性

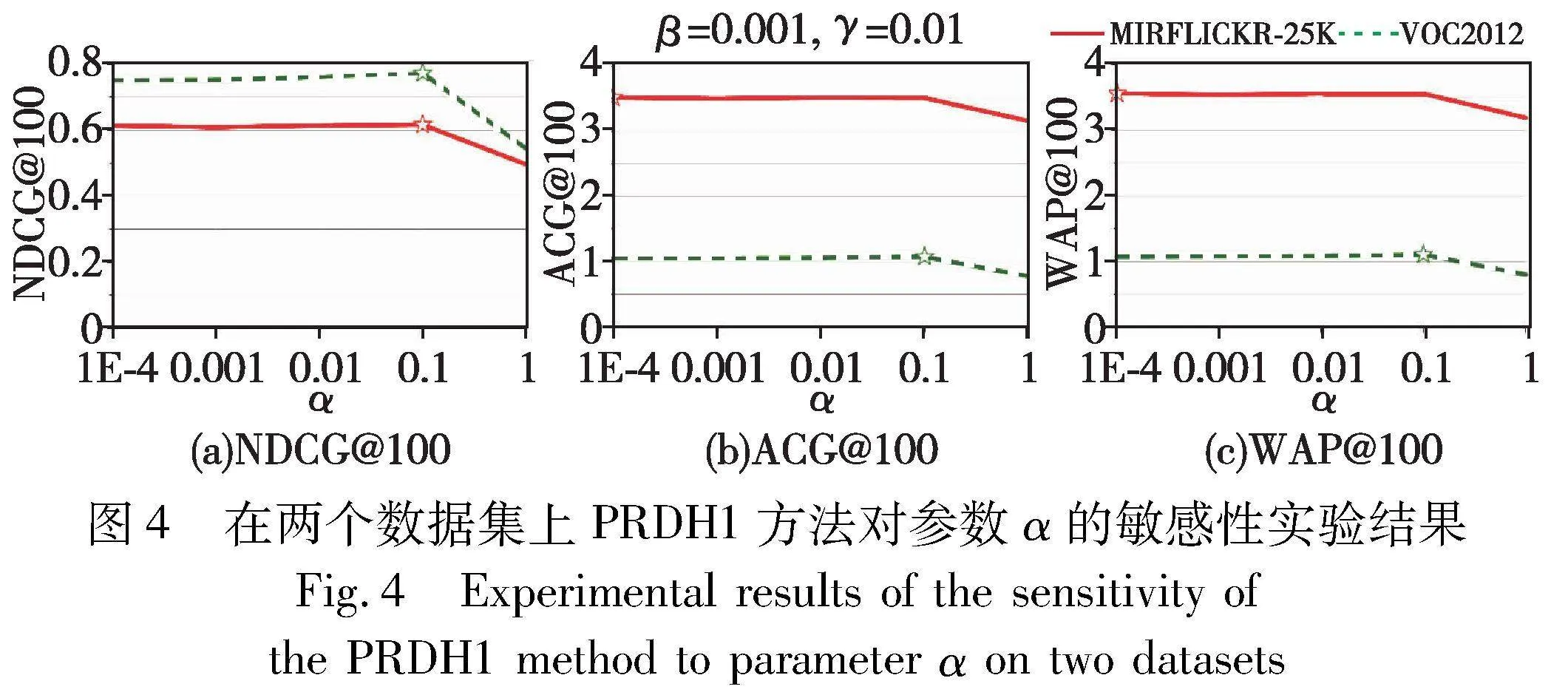

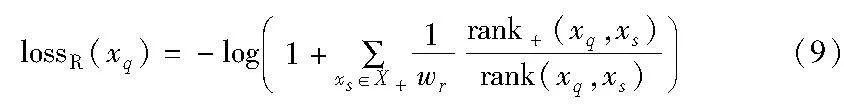

为了评估本文方法对超参数α、β和γ的敏感程度,以PRDH1为例,在MIRFLICKR-25K和VOOC2012数据集上进行实验分析。其中:哈希码长取为48 bit;α、β和γ分别在{1, 0.1, 0.01, 0.001, 0.000 1}取值,且对其中一个参数变量进行实验时,其他参数均保持为最优参数值。PRDH1在不同超参数取不同值时所对应的检索结果(指标分别为NDCG@100、ACG@100和WAP@100)如图4~6所示,其中“☆”标注点表示在对应数据集上,该参数设置使得当前评估指标达到最优。

从图5(a)~(c)中的折线变化趋势可见,当α=0.1和γ=0.01时,β在两个数据集上均取值为0.001,PRDH1方法取得最优的结果。同样地,在图6(a)~(c)中,当α=0.1和β=0.001时,γ在两个数据集上取值为0.01时可使得PRDH1方法取得最优的结果。然而,在图4(a)~(c)中,当β=0.001和γ=0.01时,α在VOOC2012数据集上取值为0.1时,PRDH1方法得到最优的结果;而在MIRFLICKR-25K数据集上,当α=0.1时,虽然只有NDCG@100指标取得最优的结果,但从图4(b)和(c)中也可以看到,对应的评估指标和最优指标变化不明显,这表明PRDH1方法对参数α取值的敏感性相对较低。因此,本文的超参数α、β和γ分别设置为0.1、0.001和0.01。

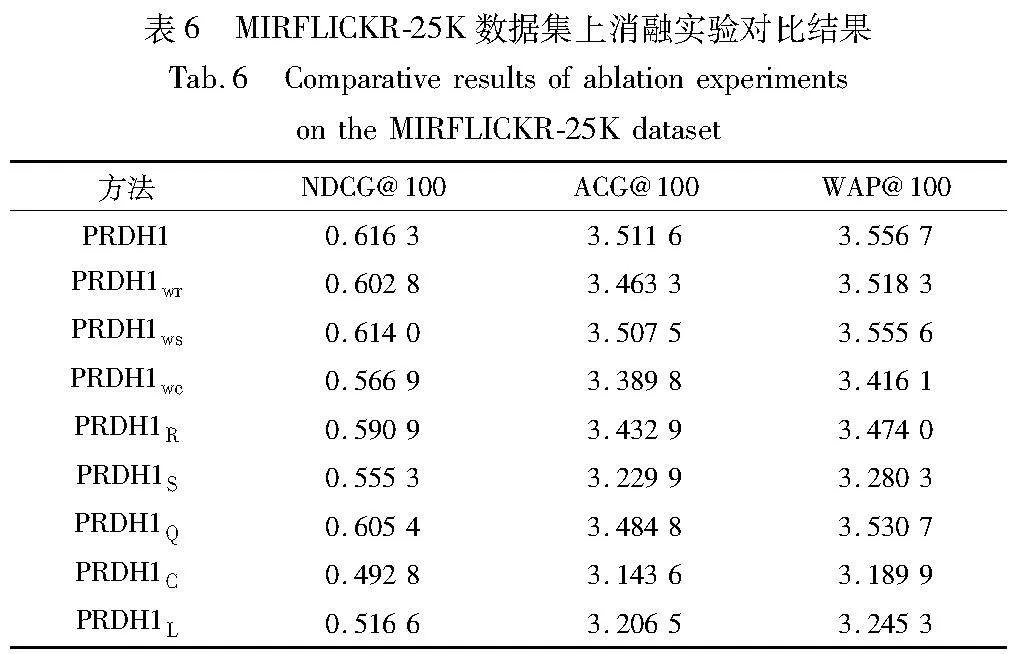

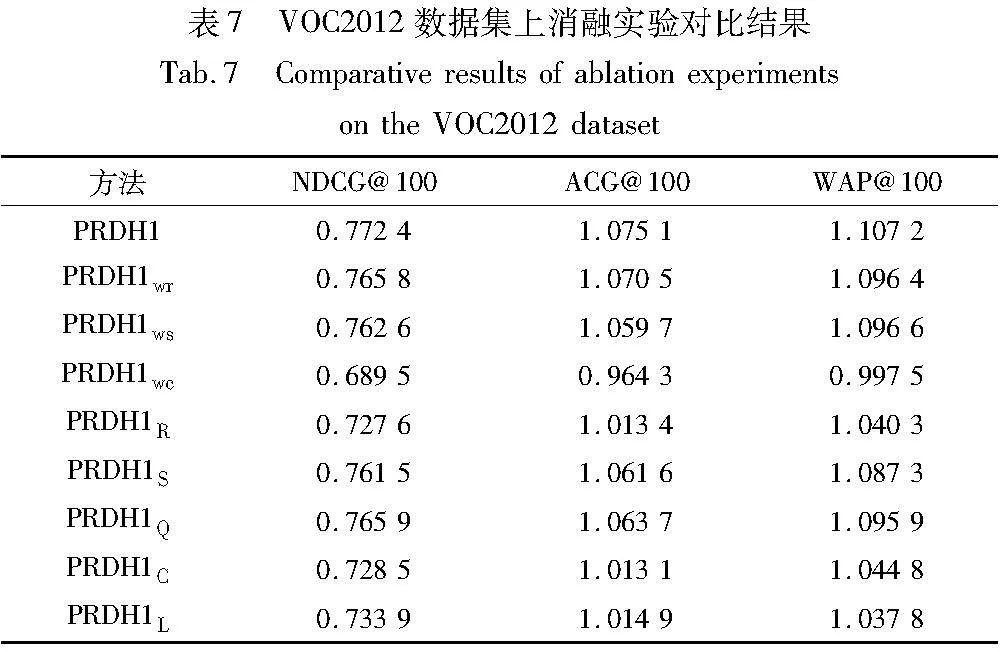

3.5 消融实验

为了评估目标函数中各个部分对于图像检索性能的贡献,以MIRFLICKR-25K和VOOC2012数据集为例,对PRDH1方法进行消融实验分析。首先,在PRDH1方法的排序优化损失函数lossR中不使用权重wr、空间划分损失函数lossS中不使用权重ws或分类损失函数lossC中不使用权重wc的模型这三个方法的实验属于损失函数内的消融实验。然后,将PRDH1方法中不使用lossR、lossS、lossC或lossQ以及在检索阶段不使用预测标签的方法分别命名为PRDH1R、PRDH1S、PRDH1Q、PRDH1C和PRDH1L,这五种方法的实验属于损失函数间的消融实验。

表6、7分别给出了哈希码长为48 bit时,在MIRFLICKR-25K和VOOC2012数据集上的不同评价指标对应的消融实验对比结果。根据表6、7中的数据对比,可以观察到以下三个结论。

a)在损失函数内的消融实验中,针对VOC2012数据集,PRDH1wr、PRDH1ws和PRDH1wc方法与PRDH1方法相比,NDCG@100指标分别降低了0.85%、1.26%和10.73%。因此可以看出,相比于权重wr和ws,权重wc对PRDH1性能的提升较大。这表明,权重wc可以有效地提高预测标签的准确率,进而有助于提升PRDH1的检索性能。同理,针对VOC2012数据集,在损失函数间的消融实验中,PRDH1R、PRDH1S、PRDH1C、PRDH1L和PRDH1Q与PRDH1相比,其NDCG@100指标分别降低了5.80%、1.41%、5.68%、4.98%和0.84%。由此可以看出,lossR、lossS、lossC和在检索阶段使用预测标签对PRDH1检索性能的提升相对于lossQ贡献较大。同时,消融实验数据还表明,每一个权重参数以及每一部分损失函数,在提出的方法中都发挥着重要的作用,它们是一个有机的整体。

b)该消融实验也证明了在检索阶段使用预测标签可以有效地提升多标签图像检索的性能。例如在MIRFLICKR-25K数据集上,PRDH1C和PRDH1L相比于PRDH1,NDCG@100指标分别降低了20.03%和16.17%,可知,lossC对PRDH1方法的检索性能的贡献仅为3.86%,远小于在检索阶段使用预测标签的16.17%。

c)有一个异常的现象值得注意,正常而言,由于PRDH1C或PRDH1L方法相对于PRDH1wc方法没有使用lossC或在检索阶段未使用预测标签,所以PRDH1wc的检索结果应该好于前两者(例如在MIRFLICKR-25K数据集上的检索结果)。然而,在VOC2012数据集上的检索结果却相反,实验分析认为这与在检索阶段使用预测标签有关。为了进一步验证,在图7中绘画出了PRDH1wc在MIRFLICKR-25K和VOOC2012数据集上前100轮的分类正确率曲线。从图7可以明显观察到,在MIRFLICKR-25K数据集上,正确率曲线随着训练轮数增加而逐渐接近于1,而在VOOC2012数据集上,正确率曲线随着训练轮数增加却是先增加后减少。通常,分类正确率越低,标签的预测效果就越差,从而导致了在检索阶段的排序结果也较差。这就是PRDH1wc的检索结果在MIRFLICKR-25K上检索性能正常,而在VOC2012上不佳的原因。

4 结束语

为了使学习到的哈希码具有良好的排序特性,并能将标签类别信息有效地用于图像检索,本文提出了一种具有性能感知排序的深度监督哈希方法(PRDH)。该方法主要在深度哈希学习部分设计了一个目标函数,同时鲜明地将预测标签用于检索阶段的汉明距离计算和排序上。为了验证本文方法的有效性和可行性,在三个基准多标签数据集中进行了大量的检索实验,并从不同深度哈希方法对比、检索结果可视化、参数敏感性和消融实验等方面对本文方法进行评估和分析。实验结果表明,本文方法能有效地感知和优化模型的检索性能,具有良好的排序特性,在各项评价指标中均优于现有先进的深度哈希方法。特别地,实验环节验证了标签信息参与汉明距离的计算与排序对多标签图像检索性能有着重要的影响,因此如何设计一个更加有效的分类损失函数,以及如何使哈希码学习到更有效的类别标签信息,都将是需要进一步深入研究的内容。

参考文献:

[1]Li Xiaoqing,Yang Jiansheng,Ma Jinwen. Recent developments of content-based image retrieval[J]. Neurocomputing,2021,452: 675-689.

[2]Gionis A,Indyk P,Motwani R. Similarity search in high dimensions via hashing[C]// Proc of the 25th International Conference on Very Large Data Bases. New York: ACM Press,1999: 518-529.

[3]Gong Yunchao,Lazebnik S. Iterative quantization: a procrustean approach to learning binary codes[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2011: 817-824.

[4]Norouzi M,Fleet D J. Minimal loss hashing for compact binary codes[C]// Proc of the 28th International Conference on Machine Lear-ning.[S.l.]: Omnipress,2011: 353-360.

[5]Kulis B,Darrell T. Learning to hash with binary reconstructive embeddings[C]// Proc of the 22nd International Conference on Neural Information Processing Systems. Red Hook,NY: Curran Associates Inc.,2009: 1042-1050.

[6]Liu Wei,Wang Jun,Ji Rongrong,et al. Supervised hashing with kernels[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2012: 2074-2081.

[7]Wang Shaohua,Kang Xiao,Liu Fasheng,et al. Supervised discrete hashing for Hamming space retrieval[J]. Pattern Recognition Letters,2022,154: 16-21.

[8]Xia Rongkai,Pan Yan,Lai Hanjiang,et al. Supervised hashing for image retrieval via image representation learning[C]// Proc of the 28th AAAI Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press,2014: 2156-2162.

[9]Liu Haomiao,Wang Ruiping,Shan Shiguang,et al. Deep supervised hashing for fast image retrieval[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2016: 2064-2072.

[10]Zheng Xiangtao,Zhang Yichao,Lu Xiaoqiang. Deep balanced discrete hashing for image retrieval[J]. Neurocomputing,2020,403: 224-236.

[11]Yuan Li,Wang Tao,Zhang Xiaopeng,et al. Central similarity quantization for efficient image and video retrieval[C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2020: 3083-3092.

[12]Hoe J T,Ng K W,Zhang Tianyu,et al. One loss for all: deep hashing with a single cosine similarity based learning objective[C]// Advances in Neural Information Processing Systems. Red Hook,NY: Curran Associates Inc.,2021: 24286-24298.

[13]Jang Y K,Gu G,Ko B,et al. Deep hash distillation for image retrieval[C]// Proc of the 17th European Conference on Computer Vision. Cham: Springer,2022: 354-371.

[14]张志升,曲怀敬,徐佳,等. 稀疏差分网络和多监督哈希用于高效图像检索[J]. 计算机应用研究,2022,39(7): 2217-2223.(Zhang Zhisheng,Qu Huaijing,Xu Jia,et al. Sparse differential network and multi-supervised hashing for efficient image retrieval[J]. Application Research of Computers,2022,39(7): 2217-2223.)

[15]Lai Hanjiang,Yan Pan,Shu Xiangbo,et al. Instance-aware hashing for multi-label image retrieval[J]. IEEE Trans on Image Proces-sing,2016,25(6): 2469-2479.

[16]Zhang Zheng,Zou Qin,Lin Yuewei,et al. Improved deep hashing with soft pairwise similarity for multi-label image retrieval[J]. IEEE Trans on Multimedia,2019,22(2): 540-553.

[17]Song Ge,Tan Xiaoyang. Deep code operation network for multi-label image retrieval[J]. Computer Vision and Image Understanding,2020,193: 102916.

[18]Dai Yong,Song Weiwei,Li Yi,et al. Feature disentangling and reciprocal learning with label-guided similarity for multi-label image retrieval[J]. Neurocomputing,2022,511: 353-365.

[19]Ma Cheng,Lu Jiwen,Zhou Jie. Rank-consistency deep hashing for scalable multi-label image search[J]. IEEE Trans on Multimedia,2020,23: 3943-3956.

[20]Shen Xiaobo,Dong Guohua,Zheng Yuhui,et al. Deep co-image-label hashing for multi-label image retrieval[J]. IEEE Trans on Multimedia,2021,24: 1116-1126.

[21]Zhao Fang,Huang Yongzhen,Wang Liang,et al. Deep semantic ran-king based hashing for multi-label image retrieval[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2015: 1556-1564.

[22]Chen Gang,Cheng Xiang,Su Sen,et al. Multiple-instance ranking based deep hashing for multi-label image retrieval[J]. Neurocomputing,2020,402: 89-99.

[23]Qin Qibing,Wei Zhiqiang,Huang Lei,et al. Deep top similarity ha-shing with class-wise loss for multi-label image retrieval[J]. Neurocomputing,2021,439: 302-315.

[24]Xie Yanzhao,Liu Yu,Wang Yangtao,et al. Label-attended hashing for multi-label image retrieval[C]// Proc of the 29th International Joint Conference on Artificial Intelligence. [S.l.]: International Joint Conferences on Artificial Intelligence Organization,2020: 955-962.

[25]Shen Yiming,Feng Yong,Fang Bin,et al. DSRPH: deep semantic-aware ranking preserving hashing for efficient multi-label image retrieval[J]. Information Sciences,2020,539: 145-156.

[26]Qin Qibing,Xian Lintao,Xie Kezhen,et al. Deep multi-similarity ha-shing with semantic-aware preservation for multi-label image retrieval[J]. Expert Systems with Applications,2022,205: 117674.

[27]Brown A,Xie Weidi,Kalogeiton V,et al. Smooth-AP: smoothing the path towards large-scale image retrieval[C]// Proc of the 16th European Conference on Computer Vision. Cham:

Springer,2020: 677-694.

[28]Krizhevsky A,Sutskever I,Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM,2017,60(6): 84-90.

[29]林计文,刘华文,郑忠龙. 面向图像检索的深度汉明嵌入哈希[J]. 模式识别与人工智能,2020,33(6): 542-550.(Lin Jiwen,Liu Huawen,Zheng Zhonglong. Deep Hamming embedding based ha-shing for image retrieval[J]. Pattern Recognition and Artificial Intelligence,2020,33(6): 542-550.)

[30]Xu Chengyin,Chai Zenghao,Xu Zhengzhuo,et al. HyP2 loss: beyond hypersphere metric space for multi-label image retrieval[C]// Proc of the 30th ACM International Conference on Multimedia. New York: ACM Press,2022: 3173-3184.

[31]Cui Can,Huo Hong,Fang Tao. Deep hashing with multi-central ran-king loss for multi-label image retrieval[J]. IEEE Signal Proces-sing Letters,2023,30: 135-139.