基于深度编码注意力的XLNet-Transformer汉-马低资源神经机器翻译优化方法

占思琦 徐志展 杨威 谢抢来

摘 要:神經机器翻译(NMT)在多个领域应用中已取得显著成效,在大规模语料库上已充分论证其优越性。然而,在语料库资源不足的情形下,仍存在较大的改进空间。由于汉语-马来语(汉-马)平行语料的匮乏,直接导致了汉-马机器翻译的翻译效果不佳。为解决汉-马低资源机器翻译不理想的问题,提出了一种基于深度编码注意力和渐进式解冻的低资源神经机器翻译方法。首先,利用XLNet预训练模型重构编码器,在编码器中使用了XLNet动态聚合模块替代了传统编码层的输出方式,有效弥补了低资源汉-马语料匮乏的瓶颈;其次,在解码器中使用并行交叉注意力模块对传统编码-解码注意力进行了改进,提升了源词和目标词的潜在关系的捕获能力;最后,对提出模型采用渐进式解冻训练策略,最大化释放了模型的性能。实验结果表明,提出方法在小规模的汉-马数据集上得到了显著的性能提升,验证了方法的有效性,对比其他的低资源NMT方法,所提方法结构更为精简,并改进了编码器和解码器,翻译效果提升更加显著,为应对低资源机器翻译提供了有效的策略与启示。

关键词:神经网络; 汉-马机器翻译; 低资源; 渐进式解冻; 预训练

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)03-022-0799-06

doi:10.19734/j.issn.1001-3695.2023.08.0331

XLNet-Transformer optimization method for Chinese-Malay low-resource

neural machine translation based on deep coded attention

Zhan Siqia, Xu Zhizhana, Yang Weib, Xie Qianglaib

(a.College of Information Engineering, b.Big Data Laboratory of Collaborative Innovation Center, Jiangxi University of Technology, Nanchang 330098, China)

Abstract:Neural machine translation(NMT) has achieved remarkable results in applications in many fields, and it has fully demonstrated its superiority on large-scale corpora. However, there is still a huge room for improvement when there are insufficient corpus resources. The lack of a Chinese-Malay parallel corpus directly affects the translation effect of Chinese-Malay machine translation. In order to solve the problem of unsatisfactory Chinese-Malay low-resource machine translation, this paper proposed a low-resource neural machine translation method based on deep encoded attention and progressive unfreezing. Firstly, this method reconstructed the encoder using the XLNet pre-training model and replaced the output mode of the traditional encoding layer with the XLNet dynamic aggregation module in order to effectively compensate for the bottleneck caused by the lack of Chinese-Malay corpus. Secondly, it improved the traditional encoding-decoding attention by using a parallel cross-attention module in the decoder, which enhanced the ability to capture the potential relationship between the source word and the target word. Finally, it adopted a progressive unfreezing training strategy to maximize the release of the models perfor-mance. The experimental results demonstrate that the proposed method significantly improves the performance on a small-scale Chinese-Malay dataset, thus confirming its effectiveness. Compared with other low-resource NMT methods, this method had a simpler structure, and improved the encoder and decode, resulting in a more significant enhancement in the translation effect. The approach provides effective strategies and insights to cope with low-resource machine translation.

Key words:neural network; Chinese-Malay machine translation; low resource; progressive unfreezing; pre-training

0 引言

随着“一带一路”倡议的提出和中国-东盟自贸区的不断发展,中国和东盟国家之间的经贸及文化交流日益频繁[1]。据统计,“一带一路”沿线连接了64个国家和地区,使用了约1/3的全球语言种类,包括许多小语种和方言[2]。由于这些语言的复杂性和多样性,人工翻译已经无法满足当前规模巨大的翻译需求,机器翻译已成为自然语言处理(NLP)领域备受关注的研究领域。为了更好地支持汉语-马来语的跨语言沟通和合作,小语种汉-马机器翻译技术变得尤为重要。

机器翻译经历了从规则到统计再到深度学习的多次迭代,相对于传统的基于规则或统计模型的机器翻译方法,神经机器翻译模型具有更高的自适应性、更强的上下文理解能力以及更高的翻译质量。当前,基于神经网络的机器翻译技术成为了机器翻译领域的研究热点。

NMT是一种数据驱动的机器翻译方法,随着训练数据规模的增大,通常可以获得更好的翻译效果。然而,当神经机器翻译模型的训练数据规模较小时,其翻译效果并不佳,特别是对于一些资源稀缺型语言对(如汉语-马来语)。由于缺乏充足的训练数据,汉-马神经机器翻译面临着重大挑战,导致目前汉-马机器翻译的翻译效果受到了很大的限制,所以,研究如何改进神经机器翻译技术以提高其在低资源场景下的翻译效果是该领域亟待解决的问题之一。

基于此,针对低资源场景下的汉-马神经机器翻译的译文质量不理想的问题,本文利用Transformer[3]和XLNet[4]预训练模型提出了一种基于深度编码注意力(XLNet-Transformer)和渐进式解冻的神经机器翻译方法,该方法在少量汉-马语料对(低资源)上表现出良好的性能。本文主要贡献如下:a)提出使用XLNet重构Transformer编码器,在长距离依赖建模方面相对于传统Transformer模型,能学习到源语句的更多依赖关系,同时使用了预训练权重初始化编码器参数,能明显提升汉-马低资源机器翻译的性能;b)提出动态聚合XLNet编码模块,能动态聚合XLNet各个编码层的编码信息,充分捕获到源语言文本各个层面的信息,从而为解码器提供更丰富的编码特征;c)提出并行交叉注意力模块,能够有效地学习上下文特征,从而捕捉到源句子和目标句子之间潜在的语义关联;d)提出“渐进式解冻”训练优化策略,可以稳定模型的训练过程,能更充分地整合源句子和目标句子的特征,提高了模型在编码-解码任务中的效果。

1 相关工作

机器翻译已成为NLP备受关注的研究领域,然而在汉语-马来语低资源神经翻译领域,由于缺乏足够的训练数据,汉-马神经机器翻译模型的翻译效果面临严峻的挑战。

当前,汉语-马来语低资源神经机器翻译领域所能够依据的参考文献相对匮乏,但是相对于其他语种低资源神经机器翻译方法却积累了大量的研究成果与经验。文献[5~8]通过实验表明,相比传统的基于大量平行语料训练的机器翻译方法(如基于RNN[9]、CNN[10]和Transformer等结构的神经机器翻译),基于预训练模型的低资源机器翻译是一种有效且高效的方法。文献[11,12]利用BERT[13]预训练模型对Transformer进行改进,实验结果显示这种新架构比基线有明显的提升。Wang等人[14]提出SimCSE和注意力学习句子嵌入和相应词嵌入的关系,在低资源语料对的实验表明了该方法的可行性。Guo等人[15]通过将源语言和目标语言领域的两个预训练BERT模型集成到一个序列到序列模型中,提出的模型在实验结果中明显优于基线模型。文献[16,17]利用不同组合的BERT和GPT[18]改进编码器和解码器,实验结果表现出良好的翻译效果。文献[19,20]利用BERT分别融合到编码器和解码器的特征表示,结果显示均能显著提升翻译性能,表明了预训练模型获取知识表示的有效性。文献[21,22]利用BERT和阶段优化策略逐步解冻网络,验证了预训练结合分步训练的有效性。文献[23~26]利用XLNet预训练模型在各种NLP单语言任务中获得了良好的表现,但XLNet应用在NMT的研究相对匮乏。

以上工作为本文研究如何改善汉-马低资源机器翻译性能不佳的现状提供了理论和实验基础。基于此,本文提出了一种基于深度编码注意力和“渐进式解冻”的汉-马低资源神经机器翻译方法,采用性能优于BERT的XLNet预训练模型,模型性能明显优于文献[22]提出的低资源NMT方法。相较于文献[19,20]的方法,本文方法的结构更为精简,并改进了编码器和解码器,翻译的性能也得到了提升,最终的实验验证了本文方法在提升汉-马低资源神经机器翻译质量方面的有效性。

2 基于深度编码注意力和渐进式解冻的XLNet-Transformer神经机器翻译方法

本文提出的XLNet-Transformer模型的整体架构如图1所示,从图中可以直观地理解本文方法的结构和各个组件之间的关系。模型由XLNet完全重构Transformer编码器的六层堆叠,利用XLNet编码器直接对源语言句子进行编码,使得模型相对于传统Transformer可以更好地捕捉源语言文本的信息,提高了其对输入文本的表示能力。为了充分地利用XLNet模型中不同编码层的特征,通过编码动态聚合模块有效地将各编码层的深度编码特征信息聚合,增强模型的表征能力。同时,在解码器中,将第二个注意力子层改进为并行交叉注意力模块,模型能够更加关注源语言句子的上下文信息,从而更准确地捕捉句子的语义。本文模型的伪代码如算法1所示。

3.4 不同学习率对本文模型的影响

本文提出的XLNet-Transformer模型在不同学习率下直接微调的对比结果如表4所示,粗体值表示最佳结果,#表示模型epoch數。

从实验结果可以看出,直接采用XLNet默认的动态学习率进行训练,BLEU为0,这反映了动态学习率在当前情景下未能充分发挥作用,由此对XLNet-Transformer模型的收敛性造成了限制。当学习率为5×10-5时,BLEU分数在第70个epoch达到最优23.92,自此之后,提高学习率反而导致分数下降。当学习率为1.5×10-4之后,学习率过大导致模型发生了梯度爆炸现象,模型无法收敛;设置学习率为1×10-5时,模型的BLEU分数比学习率为5×10-5时低6.80,说明学习率过小可能使模型发生局部最优和过拟合的现象,进而导致模型翻译质量下降。因此,给予合适的学习率时,直接微调模型也可以得到较理想的翻译性能。故在后续实验中,将本文模型在未采用渐进式解冻策略训练的学习率默认设置为5×10-5。

3.5 汉-马低资源神经机器翻译的对比实验

为了验证本文方法的有效性,进行了如表5所示的模型方法对比实验,表中“+、-”表示相对于传统Transformer模型的BLEU差值,粗体值表示最佳结果。其中:

a)XLNet-Decoder,本文提出的编码器完全由XLNet(12-layer,768-hidden,12-heads)模型重构,解码器为Transformer结构的参照模型。

b)BERT-Encoder[22],编码器完全由BERT(12-layer,768-hidden,12-heads)模型重构,解码器为Transformer结构。

c)PhoBERT[20],编码器和解码器分别融合了BERT(12-layer,768-hidden,12-heads)的输出特征。

d)XLNet-Transformer,即XLNet-Decoder+编码动态聚合模块+并行交叉注意力模块。

从表5可以看出,利用预训练做编码器的BERT-Encoder和XLNet-Decoder在低资源数据集上相比于传统的Transformer模型,均有明显提升,而本文模型相较于Transformer模型的BLEU可以达到6.41的提升;相较于BERT-Encoder和PhoBERT方法,本文模型也分别提升了0.97和0.25。通过实验结果表明,本文方法在结构更加精简的前提下,能够在汉-马低资源数据集上实现更好的低资源翻译性能,也充分证明了通过引入XLNet预训练模型、动态聚合编码信息以及并行交叉注意力等关键组件,可以较好地克服低资源条件下的翻译困难,实现了性能改进。

3.6 汉-马低资源神经机器翻译的消融实验

为探究本文方法使用XLNet重构编码器后使用编码动态聚合模块和在解码器融合并行交叉注意力模块的模型对翻译模型性能的影响,进行了如表6所示的消融实验。其中:

a)Transformer with XLNet size。Transformer的网络结构,仅结构参数大小与XLNet一致(12-layer,768-hidden,12-heads)。

b)XLNet-Decoder+编码动态聚合。在XLNet-Decoder的基础上只对编码器进行了动态聚合模块改进。

c)XLNet-Decoder+并行交叉注意力。在XLNet-Decoder的基础上只对解码器进行了并行交叉注意力模块的改进。

根据表6的实验结果可知,虽然Transformer with XLNet size模型参数量有所增加,但最优BLEU仍比Transformer base size模型少1.56,说明模型容量对翻译质量的影响不大,增加参数的数量并没有带来更好的翻译质量,这也反映了XLNet-Transformer模型的优势是模型的学习性能而不是模型参数的数量。

将编码动态聚合模块和并行交叉注意力模块分别应用XLNet-Decoder模型后,均比XLNet-Decoder模型的BLEU值有一定的提高。当编码动态聚合模块与并行交叉注意力模块同时应用于XLNet-Decoder模型(即XLNet-Transformer)后,实验结果优于其他实验组,比传统Transformer模型提高了6.41,说明两个模块在联合使用时的有效性,表明了编码动态聚合模块和并行交叉注意力模块在低资源数据集下对提高翻译模型性能都起到了重要的作用。

3.7 “渐进式解冻”策略的优化训练

为探索提出的XLNet-Transformer模型在训练过程中使用提出的“渐进式解冻”优化策略对翻译模型性能的影响,设计了如表7所示的实验。由表4可以得出,提出的XLNet-Transformer模型直接微调的较优学习率为5×10-5,基线模型Transformer的原始学习率为3×10-4,因此本文实验主要对比的学习率为5×10-5和3×10-4。使用“渐进式解冻”的策略训练XLNet-Transformer模型的实验结果如表7所示,粗体值表示最佳结果,#表示epoch数。

由實验结果可以看出,XLNet-Transformer模型先设置学习率为5×10-5进行冻结编码器训练模型至收敛,BLEU分数可以达到11.64,再设置学习率为3×10-4进行解冻微调,却发现BLEU分数为0.21,模型不收敛,说明需要梯度更新的参数太多而不适合太大的学习率。而将学习率对调,先设置学习率为3×10-4进行冻结编码器训练模型至收敛得到10.98的BLEU,再设置学习率为5×10-5进行解冻微调,XLNet-Transformer的BLEU达到了23.78,而直接采用3×10-4进行训练模型不收敛,这体现了在不同训练阶段需要适合的学习率,证明了使用渐进式解冻方法的有效性。当冻结或者解冻学习率都设置为5×10-5时,在第59(27+32)个epoch达到了最优的24.26,比直接微调减少了11个epoch,BLEU还提升了0.34。这表明在模型的分阶段训练中,经过逐步解冻冻结层,本文方法的性能得到了更为充分的释放,验证了“渐进式解冻”方法的有效性。

3.8 漢-马机器翻译在不同规模语料上的翻译质量对比

为了研究本文方法在不同数量的汉-马数据集上的翻译质量,本文从现有17.4 W训练集中分别随机地抽取8W、11W、14W条汉-马数据集作为独立的实验数据集,对比实验结果如图6所示。其中验证集和测试集均保持一致。

从图6不难看出,相较于基线Transformer模型,随着训练集数量的减少,本文方法提升的幅度越明显,翻译质量越高。证明通过本文方法能够更好地补充在少量数据场景下缺乏的特征表示,从而提升了汉-马低资源神经机器翻译的性能,验证了本文模型在低资源场景下的汉-马NMT任务中的有效性。

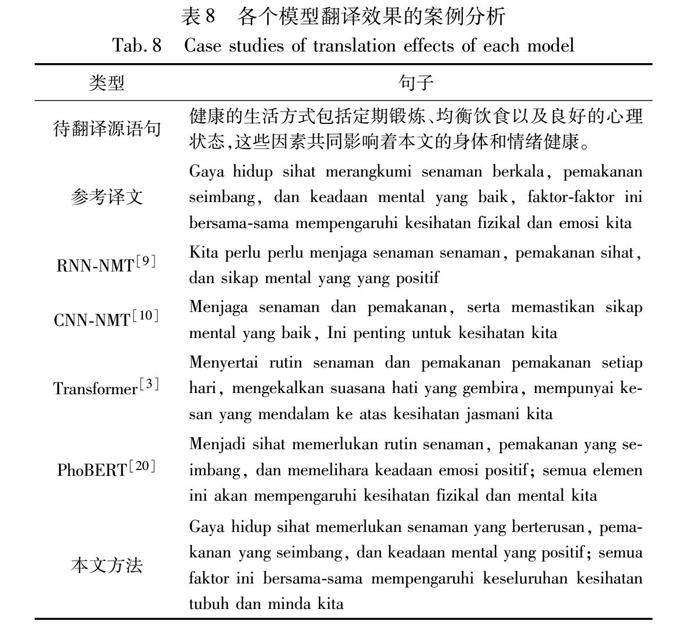

3.9 模型翻译效果的案例分析

为了更直观地比较各个模型的翻译效果,本实验选取一个汉语和马来语的待翻译语句和参考译文作为案例分析的实验样本。各个模型的翻译效果对比如表8所示。其中,相同颜色的标注代表句子的语义相近(参见电子版)。

通过表8的案例分析可以清晰地看到各个模型的翻译效果。RNN-NMT出现了重复翻译(如perlu、enaman等)和大部分的少翻译问题,导致翻译结果不准确;CNN-NMT出现了少翻译的问题(如缺少“健康的生活方式”和“共同影响”等翻译),未能准确传达句子的完整含义;Transformer基线模型虽然能产生大致准确的翻译,但在表达流畅性上存在问题(如未表达出对“情绪健康”的影响);PhoBERT与本文方法的翻译效果相似,但在流畅性和完整性方面略有不足;本文方法在案例中几乎能够准确、流畅地传达句子的含义(如相比PhoBERT表达出了“健康”是“一种生活方式”),在整体翻译的流畅和完整性上具备优势,充分验证了本文方法在汉-马低资源神经机器翻译场景下的可行性和有效性。

4 结束语

本文介绍了一种基于深度编码注意力和“渐进式解冻”的XLNet-Transformer汉-马神经机器翻译方法,旨在解决汉-马低资源翻译任务中性能不佳的问题。通过重构Transformer编码器和动态聚合XLNet编码模块,有效地整合了各编码层的特征,增强了模型的表征能力。在解码器方面,引入了并行交叉注意力模块进一步提高了对上下文信息的关注,从而改善了翻译结果的语义准确性。此外,还采用“渐进式解冻”优化训练策略稳定了模型的训练过程,优化了源句和目标句特征的整合。实验结果表明,本文方法在汉-马低资源翻译任务中性能提升显著,验证了本文方法的有效性和创新性。

为了更好地应对低资源语言对的挑战,在未来的工作中将从探索预训练模型和无监督进行有效结合,从而更进一步提升汉-马神经机器翻译模型的性能,为汉-马低资源神经机器翻译领域的发展带来更多的贡献。

参考文献:

[1]黄家裕, 刘连芳, 邓姿娴, 等. 东南亚语言及信息处理研究进展[J]. 广西科学院学报, 2018, 34(1): 27-31. (Huang Jiayu, Liu Lianfang, Deng Zixian, et al. Progress of studies on southeast Asian languages and information processing thereof[J]. Journal of Guangxi Academy of Sciences, 2018,34(1): 27-31.)

[2]王铭玉. “一带一路”建设与语言战略构建[J]. 中国外语教育, 2017(1): 3-7,99. (Wang Mingyu. “Belt and Road” construction and language strategy construction[J]. Foreign Language Education in China, 2017(1): 3-7,99. )

[3]Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]//Proc of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 6000-6010.

[4]Yang Zhilin, Dai Zihang, Yang Yiming, et al. XLNet: generalized autoregressive pretraining for language understanding[C]//Proc of the 33rd International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2019: 5753-5763.

[5]Hujon A V, Singh T D, Amitab K. Transfer learning based neural machine translation of English-Khasi on low-resource settings[J]. Procedia Computer Science, 2023,218: 1-8.

[6]Xing Xiaolin, Hong Yu, Xu Minhan, et al. Taking actions separately: a bidirectionally-adaptive transfer learning method for low-resource neural machine translation[C]//Proc of the 29th International Conference on Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2022: 4481-4491.

[7]Li Zhaocong, Liu Xuebo, Wong D F, et al. ConsistTL: modeling consistency in transfer learning for low-resource neural machine translation[C]//Proc of Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2022: 8383-8394.

[8]Zhuang Yimeng, Tu Mei. Pretrained bidirectional distillation for machine translation[C]//Proc of the 61st Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2023:1132-1145.

[9]Bahdanau D, Cho K H, Bengio Y. Neural machine translation by jointly learning to align and translate[EB/OL]. (2016-05-19). https://arxiv.org/pdf/1409.0473.pdf.

[10]Gehring J, Auli M, Grangier D, et al. Convolutional sequence to sequence learning[C]//Proc of the 34th International Conference on Machine Learning.[S.l.]: JMLR.org, 2017: 1243-1252.

[11]Chen Xi, Wu Linhui, Zhang Yuanhao. Enhancing use of BERT information in neural machine translation with masking-BERT attention[C]//Proc of the 3rd International Conference on Artificial Intel-ligence, Automation, and High-Performance Computing.[S.l.]: SPIE, 2023: 795-808.

[12]Liu H I, Chen Weilin. X-Transformer: a machine translation model enhanced by the self-attention mechanism[J]. Applied Sciences, 2022,12(9): 4502.

[13]Devlin J, Chang Mingwei, Lee K, et al. BERT: pre-training of deep bidirectional transformers for language understanding[EB/OL]. (2019-05-24). https://arxiv.org/pdf/1810.04805.pdf.

[14]Wang Dongsheng, Wang Shaoyong. SE-Former: incorporating sentence embeddings into Transformer for low-resource NMT[J]. Electronics Letters, 2023,59(11): e12840.

[15]Guo Junliang, Zhang Zhirui, Xu Linli, et al. Adaptive adapters: an efficient way to incorporate BERT into neural machine translation[J]. IEEE/ACM Trans on Audio, Speech, and Language Proces-sing, 2021, 29: 1740-1751.

[16]Weng Rongxiang, Yu Heng, Huang Shujian, et al. Acquiring know-ledge from pre-trained model to neural machine translation[C]//Proc of the 34th AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2020: 9266-9273.

[17]Rothe S, Narayan S, Severyn A. Leveraging pre-trained checkpoints for sequence generation tasks[J]. Trans of the Association for Computational Linguistics, 2020, 8: 264-280.

[18]Radford A, Wu J, Child R, et al. Language models are unsupervised multitask learners[EB/OL]. (2019).https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf.

[19]Zhu Jinhua, Xia Yingce, Wu Lijun, et al. Incorporating BERT into neural machine translation[EB/OL]. (2020-02-17). https://arxiv.org/pdf/2002.06823.pdf.

[20]Vu V H, Nguyen Q P, Tunyan E V, et al. Improving the perfor-mance of Vietnamese-Korean neural machine translation with contextual embedding[J]. Applied Sciences, 2021,11(23): 11119.

[21]Yan Rong, Li Jiang, Su Xiangdong, et al. Boosting the Transformer with the BERT supervision in low-resource machine translation[J]. Applied Sciences, 2022,12(14): 7195.

[22]Imamura K, Sumita E. Recycling a pre-trained BERT encoder for neural machine translation[C]//Proc of the 3rd Workshop on Neural Generation and Translation. Stroudsburg, PA: Association for Computational Linguistics, 2019: 23-31.

[23]Shi Fan, Kai Shaofeng, Zheng Jinghua, et al. XLNet-based prediction model for CVSS metric values[J]. Applied Sciences, 2022,12(18): 8983.

[24]Wang Chenglong, Zhang Fenglei. The performance of improved XLNet on text classification[C]//Proc of the 3rd International Confe-rence on Artificial Intelligence and Electromechanical Automation.[S.l.]: SPIE, 2022: 154-159.

[25]Zamani N A M, Liew J S Y, Yusof A M. XLNET-GRU sentiment regression model for cryptocurrency news in English and Malay[C]//Proc of the 4th Financial Narrative Processing Workshop. Stroudsburg, PA: Association for Computational Linguistics, 2022: 36-42.

[26]Mohtaj S, Mller S. On the importance of word embedding in automated harmful information detection[C]//Proc of the 25th International Conference on Text, Speech, and Dialogue. Berlin: Springer-Verlag, 2022: 251-262.