基于多智能体深度强化学习的实时配电网电压优化控制方法研究

周 荃

(国网江苏省电力有限公司丹阳市供电分公司)

1 光伏系统的动态电压调控机制

1.1 光伏系统在电压管理中的作用原理

光伏系统在电压管理中起到关键作用,其调控机制主要依赖于可变无功功率。光伏系统的无功功率与系统容量的关系遵循方程:

式中,Sinv表示光伏逆变器的总容量;表示光伏逆变器当前的有功功率输出。

1.2 电网内集成分布式能源的电压管理与优化模型

在配电网络中,日内实时无功电压控制旨在通过协调无功调节装置,在日前调度计划的基础上执行更精细的短期调整。这种调整的目标是提升电压稳定性并减少网络损耗:

式中,n表示节点的总数;CLoss表示单位电力损失的成本;PLoss,i表示第i个节点或时间步的电力损失;Ca表示电压偏差的成本系数;m表示在每个节点或时间步考虑的电压测量点的总数;ΔUi,j表示第i个节点或时间步和第j个电压测量点之间的电压偏差。

此模型的约束条件包括:

1)电压限制

式中,Umin表示电压的最小允许值或下限;U表示当前或任一特定节点的电压水平;Umax表示电压的最大允许值或上限。

2)光伏功率范围

3)光伏系统容量和输出功率的关系

式中,Qi,PV表示第i个光伏逆变器的无功功率;Si,PV2表示第i个光伏逆变器的额定容量;Pi,PV表示第i个光伏逆变器的有功功率。

4)电力平衡方程,确保每个时刻发电量与负荷量相匹配

式中,PG,i、QG,i分别表示第i节点的有功发电和无功发电;PL,i、QL,i分别表示第i节点的有功负荷和无功负荷;Ui、Uj分别表示第i和j节点的电压幅值;Gij、Bij表示第i节点和j节点之间的电导和电纳;δij表示第i和j节点电压相角的差值。

2 配电网络电压控制的多智能体深度强化学习方法

2.1 多智能体深度学习与强化学习的结合

在配电网络电压控制领域,MADRL方法的融合展现出显著的优势。深度强化学习(DRL)结合深度学习的数据识别与状态感知能力和强化学习的决策制定优势,实现从策略空间的直接控制决策提取[2]。特别是在Actor-Critic(AC)框架下,深度策略梯度方法以其优化策略的高效性在电网调度等领域受到重视。

多智能体系统(MAS)中,合作型智能体通过协调互动形成协同控制策略,提升系统整体效益。MADRL在离线阶段通过数据训练智能体,以应对在线执行阶段的实时决策挑战,有效处理配电网络中分布式电源和负荷的不确定性问题[3]。

2.2 配电网电压控制中的双延迟深度确定性策略梯度算法

为解决DQN在高维问题处理上的局限性及DDPG算法的过高估计问题,本研究采用了改进型TD3算法。TD3适用于连续动作空间,采用Actor-Critic框架,高效解决无功电压控制问题。它通过最小化损失函数Lθ来调整策略,有效优化电网电压控制策略。

Actor则根据状态st输出动作πφ(st),并依据critic的Q值更新策略φ。actor更新参数的策略梯度计算方法:

TD3算法通过引入裁剪双Q学习、延迟策略更新和目标策略平滑正则化三种技术手段,有效应对维度灾难和次优解问题。具体而言,TD3采用两套目标critic网络Qθ1和Qθ2,计算更新目标值时选取较小者作为时间差分(TD)目标,从而降低过高估计的风险。此外,在TD误差较小时更新actor网络参数,减缓学习速率,避免过度适应特定样本。引入的策略平滑正则化技术通过向动作增加高斯噪音,有效平均目标值,增强算法的泛化能力。

在中心化训练分散式执行(CTDE)框架下,TD3算法通过离线训练中的信息交换和集中式学习优化多智能体决策。在线执行阶段,智能体依据局部观测信息作决策,降低计算复杂度。TD3因此在处理电压控制等复杂问题中显示出卓越性能。

2.3 配电网无功电压控制的部分可观测马尔科夫决策模型

本研究将配电网无功电压控制建模为分布式部分可观测马尔科夫决策过程(Dec-POMDP),适用于多智能体深度强化学习(MADRL)。由于,光伏逆变器被视为独立的智能体,在通信限制下无法获取完整状态信息,因此Dec-POMDP比完全可观测的马尔科夫决策过程(MDP)更适用于MADRL,Dec-POMDP模型定义为元组M表示为:

式中,n为参与决策的智能体数量;S为状态集,包括所有智能体的状态信息如负荷的有功和无功、光伏逆变器的出力等;为联合动作集,包括所有智能体的动作;T为状态转移概率函数,描述智能体的联合动作如何影响环境,从而确定下一状态的概率;为联合观测信息集,包含每个智能体的局部量测信息;O为观测概率函数,描述智能体观测到特定信息的概率;R为奖励函数,根据配电网无功电压控制目标函数设计的即时奖励函数,反映了网损和电压偏差。

配电网无功电压控制的部分可观测马尔科夫决策模型中,智能体依据本地观测数据和动作结果做出决策,旨在最大化网损与电压偏差相关的奖励。该模型利用潮流计算模拟配电网运行,考虑光伏出力和负荷不确定性,指导智能体在每个时间步实现最优化决策[5]。Dec-POMDP模型的实施使智能体能够在部分可观测且动态变化的环境中有效学习,从而提高配电网无功电压控制的性能和效率。

3 算例仿真与分析

3.1 算例介绍和算法参数配置

本研究的仿真测试基于搭载AMD Ryzen7-5800H CPU和NVIDA RTX3050Ti GPU的硬件平台,以改进版IEEE 33节点配电系统为测试案例。系统中第13、18、22、25、29和33号节点装有1.5MW容量的分布式光伏装置,如图1所示。基准电压等级为12.66kV,根节点电压标幺值设为1.00pu,安全运行电压范围为0.95pu至1.05pu。

图1 基于深度强化学习优化的IEEE-33节点配电系统结构图

在仿真环境设置中,本研究采用比利时电网的光伏数据和英国的负荷数据,通过加入标准差为0.1的高斯扰动,有效模拟了实际环境中的波动。该仿真环境包含一年数据,其中选取30天数据作为测试集,其余作为训练集。强化学习训练过程涵盖400回合,每回合使用半天数据,智能体每3min做出一次动作决策。算法参数配置为:批尺寸64,经验池容量5000,折扣因子0.99,步长240,学习率0.0001。该设置为模型训练提供了均衡的数据分布,有助于智能体更好地适应并优化电网运行状态。

此仿真环境旨在测试深度强化学习方法在实际电网电压控制中的应用效果,考虑光伏发电和负荷波动性,模拟电网运行的不确定性,为控制策略评估提供测试平台。

3.2 训练效果分析

在训练效果分析中,实验选取光伏出力最大的典型日进行验证,如图2所示,揭示了在09∶00~15∶00的高峰时间段内,光伏出力显著高于负荷需求。此现象导致功率倒送和电压越限问题,反映了模型中需进一步考虑这种波动性因素以确保电网的稳定运行。

图2 典型日配电网光伏发电与负荷变化曲线

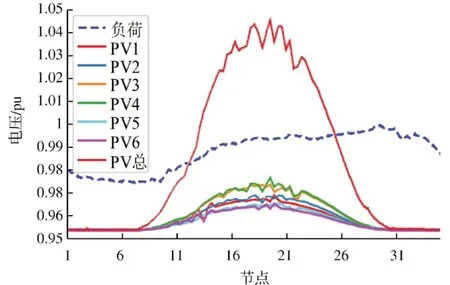

经MATD3策略优化后,典型日测试显示各节点电压分布均处于安全运行范围内。曲线图进一步证实MATD3在电压控制方面的有效性,展示了优化后策略的显著控制效果,如图3所示。

图3 MATD3策略优化下典型日配电网电压波动分析

3.3 对比分析

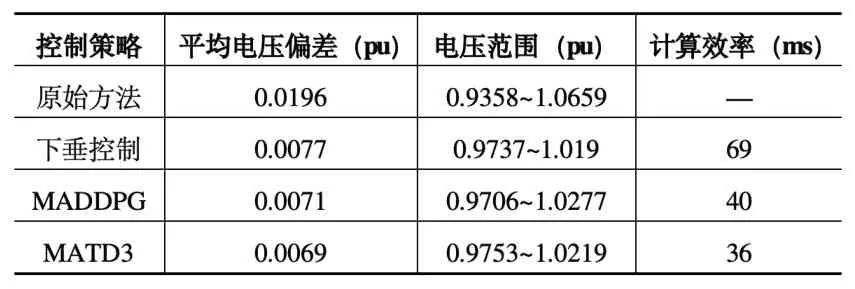

在本研究中,采用的MATD3策略与传统Q-V下垂控制策略、无控制策略及MADDPG策略进行对比。结果显示,MATD3在电压控制和减少网损方面具有显著优势。例如,MATD3策略在电压控制方面实现了最小的平均电压偏差0.0069pu,计算效率为36ms,优于其他策略。结果见表1。

表1 深度强化学习在配电网电压控制中的应用效能比较

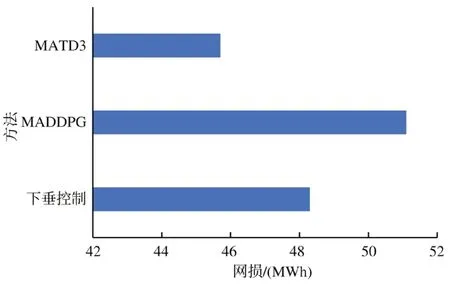

此外,MATD3策略在网损减少方面也展现出最佳性能,相较于下垂控制和MADDPG方法分别减小了5.29%和10.61%的网损,证明了其在配电网无功电压控制领域的应用效能和经济性(见图4)。通过这些对比分析,MATD3策略被证实有效提升配电网的整体性能和稳定性。

图4 典型日内各控制策略对配电网网损影响分析

3.4 扩展性验证

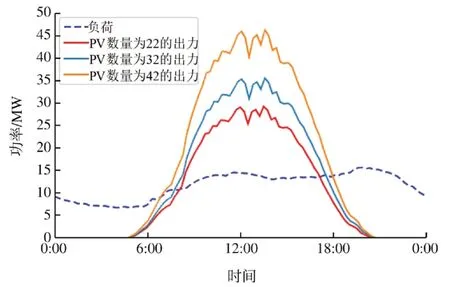

通过在141个节点的配电系统进行仿真测试,成功验证了所提方法的扩展性(见图5)。使用Matpower 7.1参数库和典型日的PV、负荷曲线数据,确保了测试的准确性和一致性。

图5 141节点配电系统在典型日的光伏发电与负荷动态曲线

测试结果表明,如表2所示,在增加智能体数量的情况下,模型成功适应了更大的状态和动作空间。采用CTDE框架有效避免维度灾难问题,确保算法在复杂环境下的有效收敛,同时维持优秀的计算性能和电压控制效果。

表2 智能体数量对配电网电压控制性能影响的测试结果

3.5 鲁棒性验证

在IEEE 33节点系统的测试中,模型面对50%光伏渗透率场景展现出强鲁棒性。通过调整年度光伏最大出力与最大负荷之比,模型适应了3种不同高渗透率场景。测试结果证实模型能有效应对不同PV容量,显示出卓越的适应力和控制效果,如表3所示。

表3 光伏渗透率对电网电压稳定性和网损影响的测试分析

结果表明,随着渗透率增加,逆变器调节容量的提升显著增强了无功调节能力和系统电压质量。研究方法展现出对配电网环境的强泛化能力和鲁棒性,即在光伏出力显著增加的场景下,依然能有效实施高质量的电压控制策略。

4 结束语

本研究展示了MADRL在配电网电压优化控制中的有效性。通过实施改进型TD3算法,解决了DQN和DDPG算法在高维问题处理和Q值估计中的局限性。仿真测试显示,该方法能显著优化电压控制和降低网损,尤其在多变的配电网环境下表现出高效的适应性和鲁棒性。此研究不仅在理论上推进了MADRL技术在电力系统中的应用,也为实际电网运行提供了有效的电压控制策略,进而支持电力系统的可靠性和稳定性,贡献于电力工程领域的持续发展。