基于模型驱动深度学习的OTFS信道估计

蒲旭敏 刘雁翔 宋米雪 陈前斌

(重庆邮电大学通信与信息工程学院 重庆 400065)

1 引 言

下一代无线网络需要支持如无人机、高铁、卫星等高移动性的通信场景,但是相对运动产生的多普勒效应会引起严重的载波间干扰,使目前广泛采用的正交频分复用调制技术,无法在高移动性环境中达到高效可靠的通信要求[1]。正交时频空间(Orthogonal Time Frequency Space, OTFS)技术是由Hadani等人[2]面向第6代(Sixth Generation, 6G)通信系统所提出的一种候选调制方案,它将无线信道建模在2维时延多普勒域中,直接反映信道时延、多普勒频移几何特征。由于运行距离和速度在毫秒数量级时间内变化不大,所以时延和多普勒频移参数在毫秒级观测时间里可近似认为非时变,可以将高移动的快时变信道转换成时延多普勒域中的近似时不变信道[3]。此外,由于真实通信场景中周围的散射体通常有限,只有少数几组反射物具有不同的时延和多普勒频移值,所以估计的参数相对较少,信道处于稀疏状态更易于进行估计[4]。因此,OTFS技术非常适用于高速移动通信场景。此外,OTFS也是通信感知一体化(Integrated Sensing And Communications, ISAC)领域中的关键技术之一,将OTFS技术融合在ISAC中不仅可以大大降低硬件和频谱资源的成本,而且可以实现更高的系统吞吐量[5,6]。

目前OTFS信道估计研究算法可以分为3类,分别是传统算法、压缩感知算法及深度学习算法。文献[7]在时延多普勒域发送单个冲激脉冲作为导频符号,接收端将导频符号能量与阈值进行比较来检测有效信道路径以直接估计信道。该传统算法方案简单有效且实现简便,但在低信噪比(Signal-to-Noise Ratio, SNR)条件下,无法识别一些信道增益较低的路径,导致估计性能较差。此外,精确的阈值选择也比较困难。文献[8]在此基础上进一步提出一种多脉冲导频阈值估计方案,可以有效提高估计性能,但是也面临一些瓶颈,如增加导频数目会增加导频与数据符号之间的干扰,提升导频功率也会加剧系统的峰均比(Peak to Average Power Ratio, PAPR)。为克服其干扰,文献[9]提出一种嵌入式导频估计方案,即在相对高功率的导频符号周围放置较多的保护符号构成嵌入式导频图案,但是导频及保护符号是无用的估计开销,占用资源较多会导致较低频谱效率。为了提高频谱效率并抑制高PAPR,文献[10]在前文基础上取消了保护符号,将一个低功率的导频符号叠加到数据符号上进行传输,接收端再利用阈值对信道进行估计。文献[11]进一步提出一种多分散叠加导频信道估计方案,能够在频谱效率较高的前提下显著降低OTFS的PAPR。为提升OTFS信道估计精度,文献[12]提出基于张量的正交匹配追踪(Orthogonal Matching Pursuit,OMP)算法,可以在低SNR中取得优越估计性能的同时,将计算复杂度从子载波数量和符号数的乘积降低到它们的求和。文献[13]提出一种基于稀疏贝叶斯学习的信道估计算法,能够在不具有任何信道先验信息的情况下获得精确的信道估计结果,大幅提升接收机性能。文献[14]提出一种基于结构稀疏性的广义近似消息传递算法估计OTFS信道,相比于近似消息传递(Approximate Message Passing,AMP)算法,该方案在具有较低计算复杂度的同时,能够获得更好的信道估计性能。近年来,深度学习技术被广泛应用于通信物理层[15],它利用大量数据集对网络进行离线训练,得到最优网络模型,最后直接在线估计信道。文献[16]针对OTFS系统提出一种深度学习信道估计方案,首先利用OMP算法进行初始化,然后使用残差网络(Residual Network, ResNet)对初始化结果进行精调,能够获得比OMP更好的估计精度,但是相比于深度展开迭代算法的模型驱动方案,该方案性能非常受限。

针对单输入单输出(Single Input Single Output,SISO)的OTFS调制系统,本文利用模型驱动的可学习去噪近似消息传递(Learned Denoising based Approximate Message Passing, LDAMP) 算法对OTFS信道进行估计。首先利用去噪卷积神经网络(Denoising Convolutional Neural Network,DnCNN)代替去噪近似消息传递(Denoising based Approximate Message Passing, DAMP)算法中传统的去噪器,对OTFS系统中含噪的时延多普勒信道进行去噪估计,然后利用状态演化(State Evolution, SE)方程来预测LDAMP算法在OTFS中的理论归一化均方误差(Normalized Mean Square Error,NMSE),最后为合理评估本文方案性能,将其与OTFS已有信道估计方案OMP、ResNet算法和常用的去噪算法进行性能对比研究。仿真结果表明,在任意SNR下,LDAMP算法的NMSE性能均优于其他算法,相比于OTFS的估计方案OMP及Res-Net而言,本文方案在SNR=2 dB时,NMSE性能已小于10–2,证明了本文方案在低SNR场景下具有优越的性能表现,而且当OTFS系统中的信道路径总数不变时,本文方案将OTFS帧大小M与N从4扩大至12时,可以增加OTFS的时延与多普勒分辨率以提高信道估计精确度,相比于OMP算法,NMSE性能具有较高增益。

2 系统模型

本文研究SISO-OTFS调制系统的信道估计问题。如图1所示,为OTFS系统模型框图。OTFS将信息符号放置在M×N的2维时延多普勒域网格进行发送,其中M为时延域的维度,N为多普勒域的维度。x[l,k] 为2维网格中第l行和第k列的时延多普勒域发射符号,其中l=0,1,...,M-1,k=0,1,...,N-1。

图1 OTFS调制系统模型框图[17]

x[l,k]经过辛傅里叶逆变换(Inverse Symplectic Finite Fourier Transform, ISFFT)映射为时频域信号X[m,n][17]

其中,X[m,n]表 示分布在时频域网格中第m行 和第n列的发射符号,m=0,1,...,M-1,n=0,1,...,N-1。X[m,n] 经过海森堡变换映射为时域发送信号s(t)的表达式为

其中,gtx(t) 为发送脉冲波形,T为时频域中单个符号的持续时间, ∆f为时频域中的子载波间隔。在传输的整个数据包中,N个符号的总持续时间为NT,M个子载波所占的总带宽为M∆f。OTFS技术利用较少参数就能将无线信道建模在时延多普勒域,所以具有稀疏性的时延多普勒信道h(τ,v)可以表示为[18]

其中,τ和v为信道时延变量与多普勒频移变量,L为传播路径的数量,δ(·) 为狄拉克函数,第i条路径对应的信道参数为 (hi,τi,vi),hi为第i条路径的复增益,τi=li/M∆f为第i条路径对应的时延参数,vi=ki/NT为第i条路径对应的多普勒频移参数,li和ki为2维网格中时延维度与多普勒维度的整数索引, 1/M∆f为时延轴网格的分辨率, 1/NT为多普勒轴网格的分辨率。通过信道可得时域接收信号r(t)为[18]

其中,w(t)是加性高斯白噪声(Additive White Gaussian Noise, AWGN)。接收机利用维格纳变换将时域信号r(t) 映 射为时频域信号Y[m,n],需要首先将r(t) 与持续时间为T的接收脉冲波形grx(t)进行匹配滤波处理,然后以间隔f=m∆f,t=nT进行采样得到匹配滤波器输出Y[m,n]为

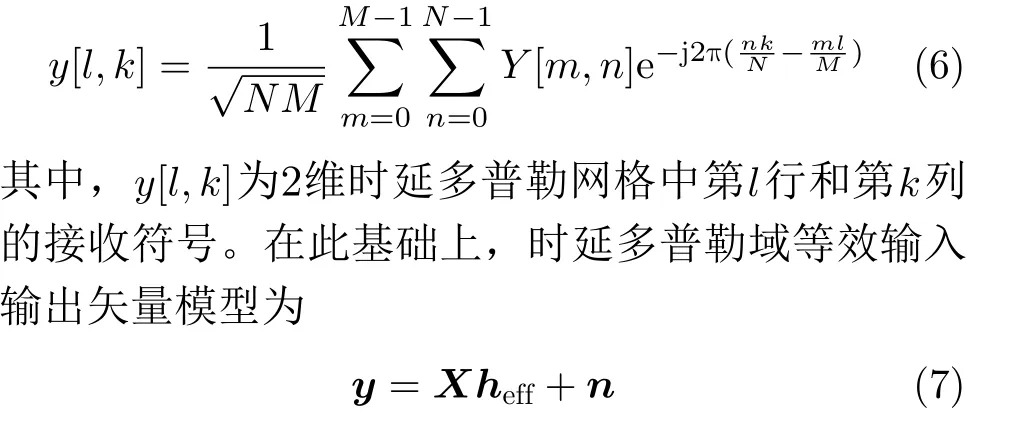

其中,Y[m,n] 表示分布在时频域网格中第m行和第n列的接收符号。最后利用辛傅里叶变换(Symplectic Finite Fourier Transform, SFFT)将时频域信号Y[m,n] 映射为时延多普勒域接收信号y[l,k]为

3 信道估计

由于heff是稀疏的,所以本文将OTFS信道估计问题转化为稀疏信号重构问题,利用压缩感知领域中的DAMP算法[19],与深度学习中的DnCNN网络[20]相结合,形成模型驱动的LDAMP算法[21]进行求解。

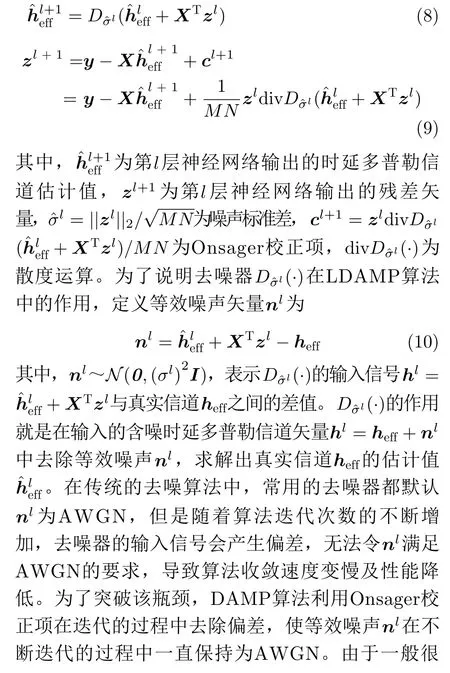

3.1 LDAMP算法

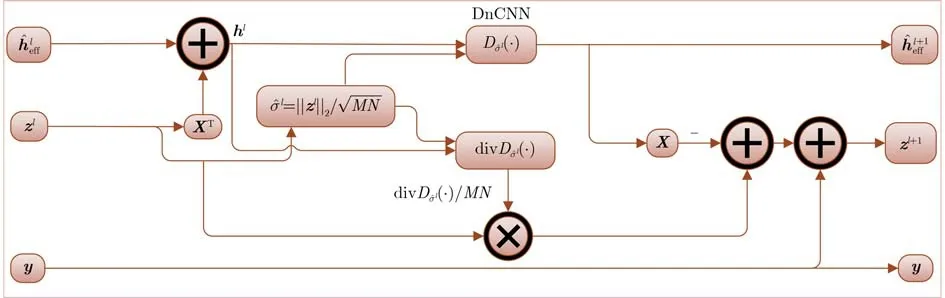

本节将DAMP算法进行深度展开,把DAMP的1次迭代过程作为LDAMP的1层网络,并且选择DnCNN代替DAMP算法中传统的去噪器以学习噪声,对含有未知噪声水平的2维时延多普勒域信道进行去噪估计。值得一提的是,LDAMP算法中只有DnCNN去噪器是由神经网络构成的,其他部分仅是对DAMP算法的实现。该方案既融合了DAMP算法高性能的优势,又结合了深度学习强大的非线性拟合能力。图2为LDAMP算法的第l层网络结构示意图,整体的LDAMP算法共由L层相同的网络级联而成[22]。

图2 LDAMP第 l层网络结构示意图

针对LDAMP算法的第l层,信道估计迭代表达式为

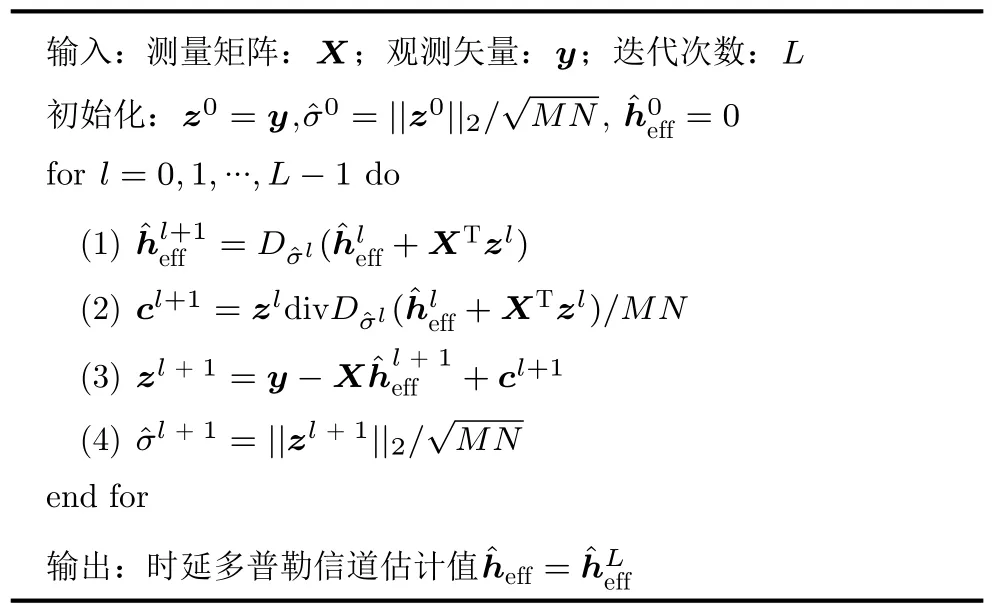

其中,ε是一个非常小的数,设置ε=||hl||∞/1000,算法流程如算法1所示。本文采用逐个去噪器训练的方法对整个LDAMP网络进行训练,首先对未知噪声水平的预期范围进行离散分组,得到多组小范围的噪声标准差后,采用Adam优化器训练DnCNN网络,得到多个训练好的对应不同区间噪声水平的DnCNN模型,使LDAMP网络在最终实现时根据本层的噪声标准差估计值所对应的噪声水平,来选择相对应的DnCNN网络作为该层的去噪器进行去噪工作。

3.2 DnCNN网络

图3为DnCNN网络架构示意图,LDAMP算法中的去噪器DnCNN改进了原始的VGG网络,舍弃了原有的池化层与全连接层,在卷积层(Convolution, Conv)与线性整流函数(Rectified Linear Unit,ReLU)之间加入了批量归一化(Batch Normalization, BN),并且结合了残差学习(Residual Learning, RL)以提高卷积神经网络的训练速度和整个模型的去噪能力。

图3 DnCNN网络架构示意图

算法1 基于OTFS系统的LDAMP算法

整个DnCNN网络共由20个卷积层构成,第1个卷积层使用64个尺寸为3×3×1的卷积核来生成64个特征图,因为反向传播算法求解误差梯度时计算量相对较大,而且对于深层网络,Sigmoid等激活函数在反向传播时很容易出现导数为0导致梯度消失的情况。所以在第1个卷积层配置ReLU激活函数来增加网络的非线性处理能力,ReLU还会使一部分神经元的输出保持为0增加神经网络的稀疏性,减少参数之间互相依存的关系,避免过拟合的发生。第2至第19个卷积层中的每一层都使用64个尺寸为3×3×64的卷积核,每个卷积核都配置ReLU单元和BN层来加快训练速度并提高去噪性能。最后1个卷积层使用一个尺寸为3×3×64的卷积核来重建学习到的噪声信号。经典的去噪算法,如去噪自编码(Denoising AutoEncoder, DAE)网络是直接学习一个恒等映射关系F(hl)=hˆeff以估计真实的信道heff,而DnCNN实质上采用RL规则学习残差映射R(hl)=nˆ 以估计真实的噪声n,从而得到信道估计值为hˆeff=hl-R(hl)。

3.3 SE方程

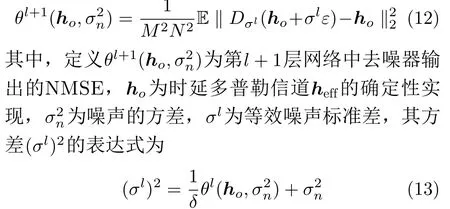

为精确地预测LDAMP算法在OTFS系统中的NMSE性能,本节采用状态演化(State Evolution,SE)作为性能分析框架,由一系列的SE方程所构成[22],其表达式为

其中,θl(ho,σn2) 为LDAMP网络第l层中的去噪器输出的NMSE,通过递推更新式(12)与式(13),就可根据SE方程求解出LDAMP算法的理论NMSE性能,最终通过与蒙特卡罗仿真所得真实NMSE进行对比就可以验证SE方程预测的准确性。

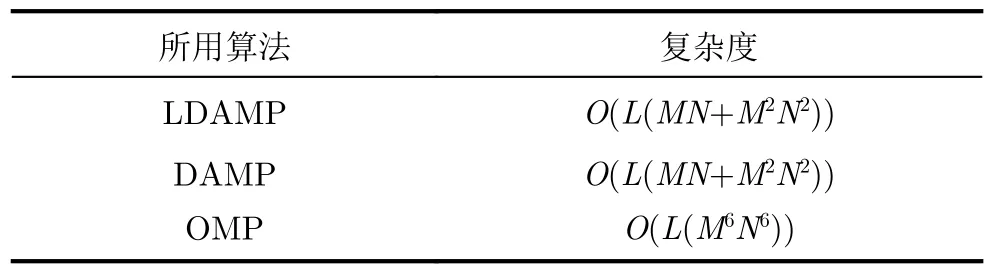

3.4 复杂度分析

本文采用模型驱动深度学习算法LDAMP对OTFS信道进行估计,因为LDAMP算法与DAMP算法都是基于AMP算法所构建的,DAMP算法仅利用去噪器代替AMP算法中的收缩函数,而LDAMP算法仅利用深度学习中的DnCNN网络代替DAMP 算法中的去噪器,其余部分均是对AMP算法的实现,所以LDAMP算法、DAMP算法以及AMP算法的计算复杂度都是相同的,即O(L(MN+M2N2))。相比于LDAMP, OMP算法由于涉及矩阵乘法及矩阵求逆,具有较高的计算复杂度,即O(L(M6N6))。将各算法的复杂度对比结果列于表1中,可以证明本文方案在低复杂度上具有一定的优越性。

表1 不同算法复杂度对比结果

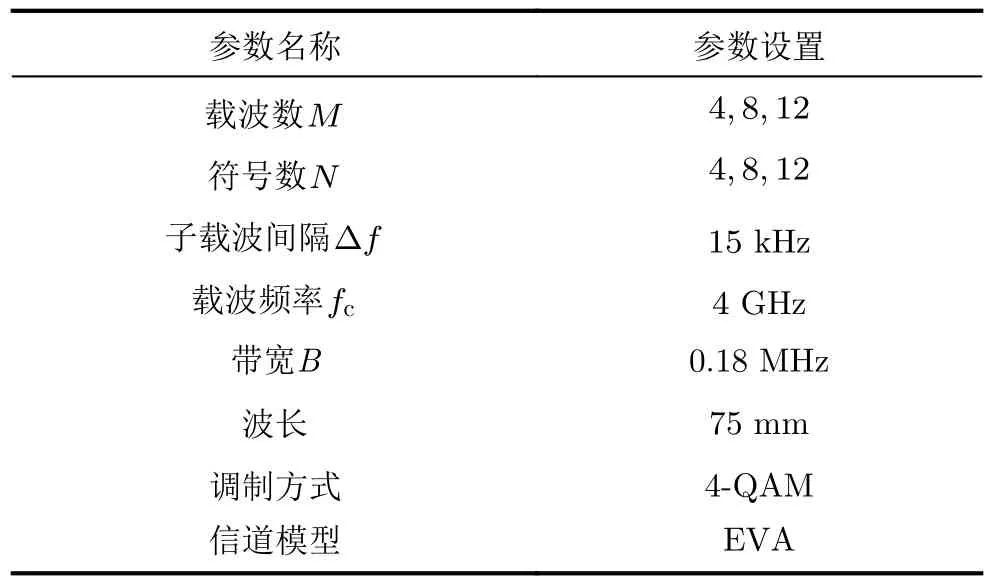

4 仿真结果与分析

本节通过仿真验证所提方案在OTFS系统中的性能表现,仿真参数设置如表2所示。采用NMSE作为衡量指标来描述LDAMP算法信道估计性能,定义NMSE为

表2 主要仿真参数设置

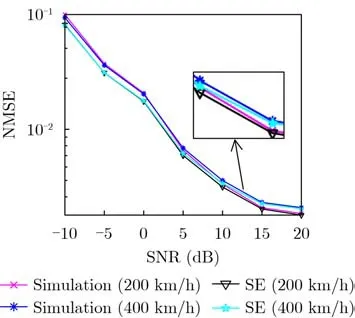

图4展示了本文方案在不同速度下的NMSE性能随SNR变化的对比结果。仿真结果表明,在任意SNR下,本文方案在速度分别为200 km/h和400 km/h的NMSE性能差距几乎可以忽略,并且通过SE方程得到的理论NMSE与仿真得到的真实NMSE性能曲线几乎重合,很好地验证了LDAMP算法在不同移速的情况下,估计OTFS信道的有效性。在SNR为2 dB时,LDAMP算法的NMSE已经可以达到10–2左右,充分表明了本文方案能够在高速移动环境下支持高效可靠的通信传输。

图4 LDAMP算法在不同速度下的NMSE随SNR变化的对比

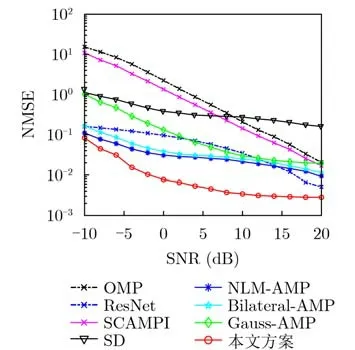

图5展示了不同算法的NMSE性能随SNR变化的对比结果,本文导频图案是采用文献[23]中的嵌入式导频,并且选择高斯随机序列作为发送的导频符号,并且主要研究了OTFS导频处的信道估计性能,即从接收端接收到的导频符号中估计出OTFS时延多普勒信道。此外,引入了文献[16]中针对OTFS系统信道估计所用到的OMP算法和ResNet算法作为对比算法,同时也引入了常用的去噪算法如SCAMPI算法[24]、SD算法[25]以及D-AMP系列[19]算法(NLMAMP、Bilateral-AMP、Gauss-AMP)进行对比。仿真结果表明,由于去噪器具有优越的去噪性能,LDAMP算法及DAMP系列算法在任意SNR下的NMSE性能表现均优于SCAMPI 算法和SD 算法。值得一提的是,LDAMP算法依靠DAMP的算法模型和DnCNN网络优异的学习能力,在SNR为2 dB时,其NMSE性能已小于10–2,远优于OTFS信道估计方案OMP及ResNet的性能表现,证明了本文方案在低SNR场景下具有很好的估计性能。

图5 不同算法NMSE随SNR变化的对比

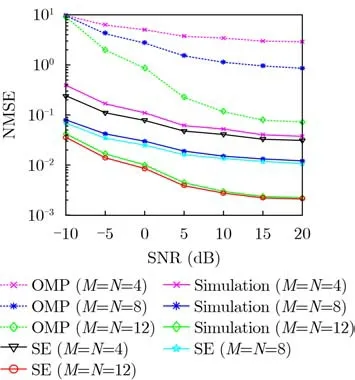

图6展示了OTFS帧大小M与N分别取4, 8, 12时,LDAMP算法通过SE方程得到的理论NMSE性能,与仿真得到的真实NMSE性能随SNR变化的对比曲线。同时,与OTFS常用的估计算法OMP也进行了NMSE性能对比。仿真结果表明,在任意SNR下,SE方程得到的理论NMSE均优于蒙特卡罗仿真得到的真实NMSE,但值得一提的是二者性能差距极小,并且本文方案仿真NMSE始终优于对应的OMP算法得到的NMSE,充分表明了本文方案在不同OTFS帧大小情况下的有效性和优越性,很好地验证了LDAMP算法可以在OTFS信道估计中近似达到理论性能界限。在高SNR下,随着M和N的增加,蒙特卡罗仿真NMSE与SE方程理论NMSE性能曲线几乎重合,因为增加离散采样点数提高了OTFS系统的时延分辨率与多普勒分辨率,可以有效提升时延多普勒信道估计的精确度,大幅减小仿真NMSE与理论NMSE之间存在的误差。

图6 LDAMP算法仿真NMSE与理论NMSE随SNR变化的对比

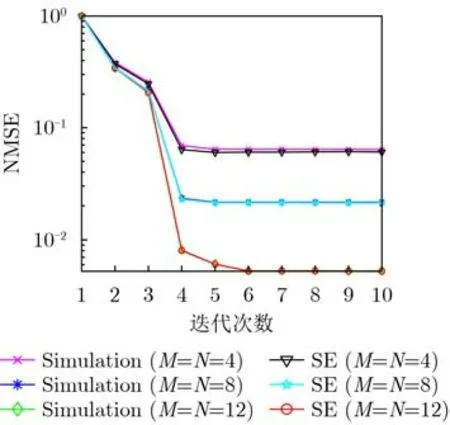

图7展示了 OTFS帧大小M与N分别取4, 8,12时,LDAMP算法通过SE方程所得理论NMSE及仿真所得真实NMSE性能随迭代次数变化的对比曲线。设置 SNR=20 dB。仿真结果表明,当M和N分别取4与8时,LDAMP算法在第4次迭代后达到收敛状态,当M和N分别取12时,LDAMP算法在第6次迭代后达到收敛状态。整体所需迭代次数较少,很好地验证了本文方案的高效性。

图7 LDAMP算法仿真NMSE与理论NMSE随迭代次数变化的对比

5 结束语

针对SISO-OTFS调制系统,本文利用一种模型驱动深度学习的LDAMP算法估计OTFS时延多普勒信道。本文方案首先将DAMP算法进行深度展开,利用DnCNN网络代替DAMP算法中传统的去噪器,对含噪的时延多普勒信道进行去噪估计,然后还提供了SE方程来预测LDAMP算法的理论NMSE性能。相比于OMP算法及DAMP算法,在SNR为2 dB时,LDAMP算法的NMSE性能已小于10–2,证明了本文方案在低SNR场景下具有优越的性能表现,并且本文方案在信道路径总数保持不变时,扩大OTFS 2维网格点数量M与N可以增加OTFS系统中时延与多普勒的分辨率,有效提升OTFS信道估计的精确度,使LDAMP算法的NMSE性能具有较大增益。