基于边界辅助的弱监督语义分割网络

杨大伟 迟津生 毛琳

收稿日期:2023-06-27;修回日期:2023-08-14 基金項目:国家自然科学基金资助项目(61673084);辽宁省自然科学基金资助项目(20170540192,20180550866,2020-MZLH-24)

作者简介:杨大伟,男,黑龙江哈尔滨人,副教授,硕导,博士,主要研究方向为计算机视觉图像处理技术;迟津生,男(通信作者),吉林通化人,硕士研究生,主要研究方向为深度学习图像处理与弱监督语义分割(1152844110@qq.com);毛琳,女,吉林吉林人,副教授,硕导,博士,主要研究方向为机器视觉目标跟踪、多传感器信息融合.

摘 要:由于弱监督语义分割任务中种子区域的随机生长机制,导致弱监督语义分割网络经常出现错分割和漏分割的问题,为此,提出一种基于边界辅助的弱监督语义分割网络。该网络利用边界信息和语义信息,为种子区域的生长提供参考,使种子区域可以自然生长至目标边界,并在目标被遮挡或重叠时正确区分目标类别,生成可以覆盖更完整目标的伪像素掩码。以此伪像素掩码作为监督信息训练分割网络,可以改善弱监督语义分割网络由于伪像素掩码无法准确覆盖目标区域导致的错分割和漏分割问题,提升弱监督语义分割网络精度。在通用数据集PASCAL VOC 2012验证集和测试集上对该网络进行评估,mIoU分别达到71.7%和73.2%。实验结果表明,其网络性能优于当前大多数图像级弱监督语义分割方法。

关键词:弱监督学习; 语义分割; 种子区域; 伪像素掩码

中图分类号:TP391.41 文献标志码:A

文章编号:1001-3695(2024)02-046-0623-06

doi:10.19734/j.issn.1001-3695.2023.06.0265

Weakly supervised semantic segmentation networkbased on boundary assistance

Yang Dawei, Chi Jinsheng, Mao Lin

(College of Mechanical & Electronic Engineering, Dalian Minzu University, Dalian Liaoning 116600, China)

Abstract:Due to the random growth mechanism of the seed region in the weakly supervised semantic segmentation task, the weakly supervised semantic segmentation network often suffers from wrong segmentation and missed segmentation problems. To address the above problems, this paper proposed a boundary-assisted weakly supervised semantic segmentation network. The network provided a reference for the growth of seed regions by utilizing boundary information and semantic information, so that the seed regions could naturally grow to the target boundary and correctly differentiated the target categories when the non-target object blocked or overlapped the target, and generated pseudo-pixel masks that could cover a more complete target. This paper used the pseudo-pixel mask as the supervisory information to train the segmentation network, which could improve the problem of missegmentation and omission by the pseudo-pixel mask that couldnt cover the target region accurately, and improved the accuracy of the weakly supervised semantic segmentation network. It evaluated the network on the generalized dataset PASCAL VOC 2012 validation and test sets, and the mIoU reaches 71.7% and 73.2%, respectively. The experimental results show that the performance of the proposed network outperforms most of the current weakly-supervised semantic segmentation methods at the image level.

Key words:weakly supervised learning; semantic segmentation; seed area; pseudo pixel mask

0 引言

圖像级弱监督语义分割(weakly-supervised semantic segmentation,WSSS)是指仅需要指出图像中的目标类别,就能够实现前背景拆分的图像分割方法[1~5]。由于类激活映射(class activation map,CAM)可以关注到图像中对分类贡献度高的区域,然后利用像素之间的关系生成种子区域,所以目前大多数弱监督语义分割方法都将CAM作为生成种子区域的核心算法[4,6,7]。弱监督语义分割的流程是将CAM生成的伪像素掩码作为监督信息训练网络,从而得到最终的分割结果,故伪像素掩码的质量直接决定了最终分割结果的好坏。伪像素掩码是由种子区域生长而来,但这种生长机制具有随机性,在生长过程中缺乏必要的参考信息进行约束。此外,CAM通过全局平均池化操作获取类别激活的特征图,这会导致损失像素级别的准确性,并且CAM在训练过程中并未使用像素级别的标注信息,很难定位物体的边界和局部细节,因此经种子区域生成的伪像素掩码会出现缺失部分目标或者溢出目标边界的问题,导致其无法完整覆盖目标类的整个语义区域,出现错分割或漏分割的问题,从而影响最终的分割性能。

在最近的研究中,针对CAM通常无法覆盖到目标类的整个语义区域的问题,通常将CAM作为一种初始定位技术,然后再通过其他方法对其进行改进。比如改进CAM的叠加方式以提高它的初始定位能力,Sun等人[8]使用类激活图之间的关系,通过擦除像素的方法抑制图像中的噪声,可以使生成的伪像素掩码更好地表达物体的形状,改善种子区域随机生长导致无法完整覆盖目标区域的问题。Zhang等人[9]通过使用特征映射和CAM之间的对象区域关系增强上下文,从而使网络获得更多与目标相关的信息,使生成的伪像素掩码可以覆盖更多的目标区域。但是这些方法无法确定目标物体的精确边界,经常会出现目标边界与目标区域不匹配的问题。Jo等人[10]提出了一种利用语义一致性的特征消除伪像素中偏见对象的无监督技术,通过将对象和背景进行分离,从而得到质量更高的伪像素掩码,以提高弱监督语义分割的分割性能。Han等人[11]使用一种基于纹元森林和显著性先验的方法,将图像的标注问题转换为能量最小化求解问题,仅使用单幅图像的显著性信息也可以得到较好的分割结果。白雪飞等人[12]使用图像显著性映射和背景迭代产生种子区域,再将其与分类网络生成的类激活映射图结合,获取覆盖更多目标区域的伪像素掩码,提升分割性能。Cermelli等人[13]通过设计一种新的损失函数,使用蒸馏学习的方式,防止网络对背景的偏向预测,对部分注释进行建模,从而改善分割性能。除了利用显著图的方式改进伪像素掩码的质量,也有一些方法通过利用边界信息,使种子区域可以自然生长至目标边界,从而覆盖更多的目标区域[14,15]。

针对种子区域随机生长机制导致伪像素掩码无法完整覆盖目标区域的问题,本文提出一种基于边界辅助的弱监督语义分割网络(weakly supervised semantic segmentation network based on boundary assistance,BAS-Net)。该方法通过融合边界信息和语义信息,使种子区域可以在正确的目标类区域中自然地生长至目标边界,覆盖更完整的目标类语义区域,达到提升分割性能的效果。

1 基于边界辅助的弱监督语义分割网络

1.1 问题分析

目前主流的弱监督语义分割大多是基于两阶段的方法:首先通过分类网络得到一个种子区域,再利用种子区域生长得到伪像素掩码,最后利用伪像素掩码作为监督信息训练分割网络,故伪像素掩码的好坏直接决定了分割网络的性能。伪像素掩码是在CAM生成种子区域的基础上,利用像素之间的关系而生成,与CAM具有相同的性质。而CAM只关注影响分类结果的区域,无法关注目标类的完整语义区域,这就导致了伪像素掩码与真值目标区域存在差异。造成此问题的根本原因在于种子区域的生长具有方向随机性,缺乏必要的约束限制,故以这种生长方式无法生长出覆盖完整目标区域的伪像素掩码,会影响最终的分割性能。由此,本文提出一种基于边界辅助的弱监督语义分割网络。首先通过边界信息给种子区域的生长提供参考,使其可以自然地生长至目标边界。尽管网络利用边界信息作为参考,使种子区域生成的伪像素掩码可以较完整地覆盖目标区域,但图像中存在目标被遮挡或重叠的情况时,网络很难正确区分物体的类别,导致种子区域生长至目标区域外或提前停止生长,造成错分割和漏分割的问题。针对上述问题,本文提出了一个语义感知分支,通过语义信息使网络可以更好地区分目标类别,改善当目标被遮挡或重叠时网络无法区分目标类别的问题。

具体地,本文提出的基于边界辅助的弱监督语义分割网络包含了边界检测分支和语义感知分支。通过设计的语义感知分支学习图像中不同类别的语义信息,将图像像素分配给相应的类别。该模型可以关注到图像中每个像素点的类别预测,能够捕捉目标物体的整体形状和分布,并且可以在只有图像级标签的情况下进行训练。使用该模型,可使不同类别的目标之间差异更明显,网络可以准确捕捉物体的类别并且获得语义上下文,通过上下文分析改善当出现目标重叠或部分遮挡的情况时无法准确分割的问题;通过设计的边界检测分支获取目标的边界信息,更准确地分割出目标边界,使种子区域自然地生长至目标边界,从而达到伪像素掩码覆盖准确的目标区域的目的。通过使用两个模型,可改善弱监督语义分割的网络性能。

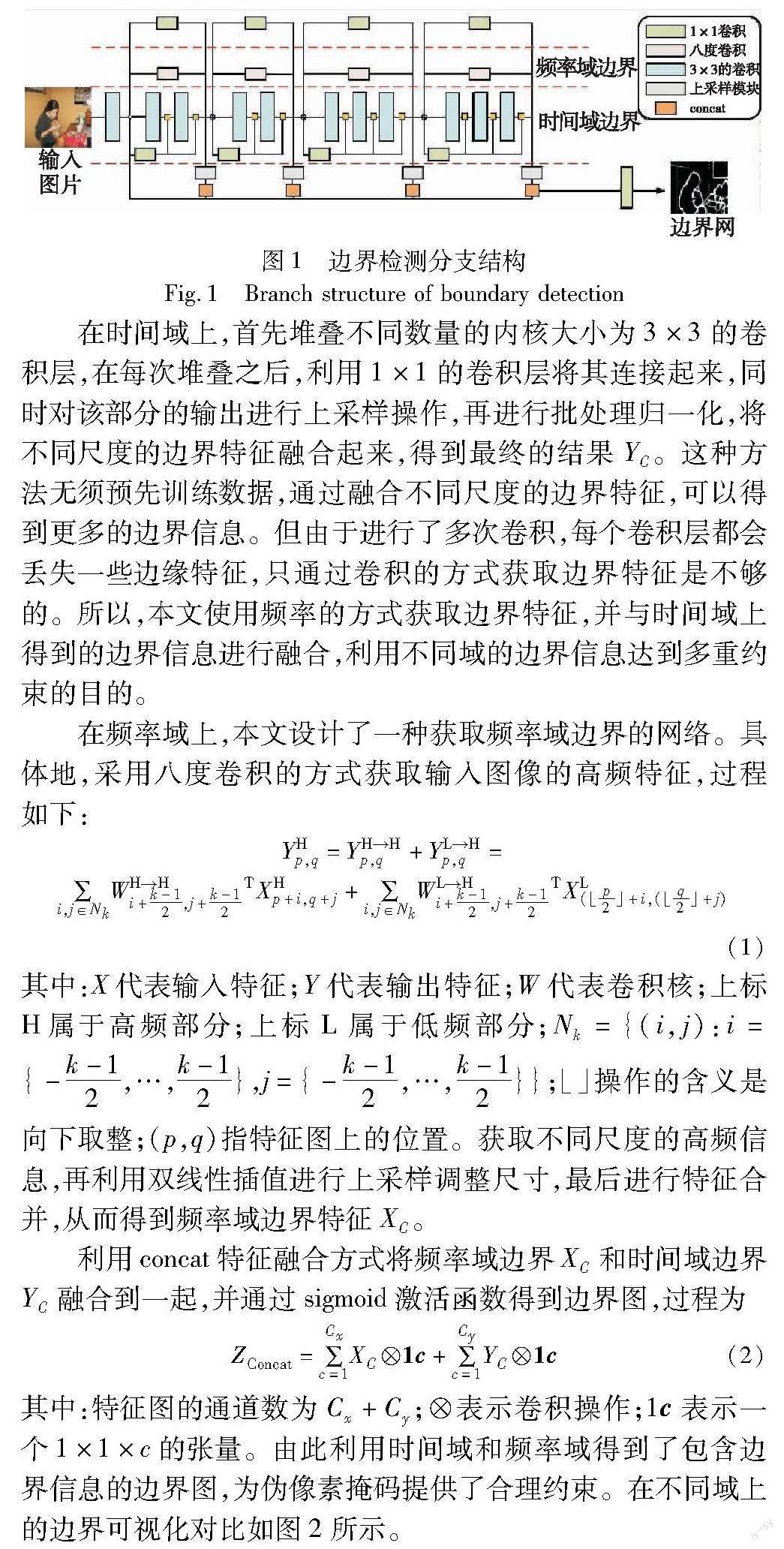

1.2 边界检测分支

为了得到边界信息,BAS-Net通过探索多尺度时间域和频率域的边界信息,并利用两个域的边界信息为种子区域的生长提供多重约束。本文的边界检测分支(boundary detection branching,BDB)结构如图1所示。

在时间域上,首先堆叠不同数量的内核大小为3×3的卷积层,在每次堆叠之后,利用1×1的卷积层将其连接起来,同时对该部分的输出进行上采样操作,再进行批处理归一化,将不同尺度的边界特征融合起来,得到最终的结果YC。这种方法无须预先训练数据,通过融合不同尺度的边界特征,可以得到更多的边界信息。但由于进行了多次卷积,每个卷积层都会丢失一些边缘特征,只通过卷积的方式获取边界特征是不够的。所以,本文使用频率的方式获取边界特征,并与时间域上得到的边界信息进行融合,利用不同域的边界信息达到多重约束的目的。

在频率域上,本文设计了一种获取频率域边界的网络。具体地,采用八度卷积的方式获取输入图像的高频特征,过程如下:

YHp,q=YH→Hp,q+YL→Hp,q=∑i,j∈NkWH→Hi+k-12,j+k-12TXHp+i,q+j+∑i,j∈NkWL→Hi+k-12,j+k-12TXL(p2」+i,(q2」+j)(1)

其中:X代表输入特征;Y代表输出特征;W代表卷积核;上标H属于高频部分;上标L属于低频部分;Nk={(i,j):i={-k-12,…,k-12},j={-k-12,…,k-12}};」操作的含义是向下取整;(p,q)指特征图上的位置。获取不同尺度的高频信息,再利用双线性插值进行上采样调整尺寸,最后进行特征合并,从而得到频率域边界特征XC。

利用concat特征融合方式将频率域边界XC和时间域边界YC融合到一起,并通过sigmoid激活函数得到边界图,过程为

ZConcat=∑Cxc=1XC1c+∑Cyc=1YC1c(2)

其中:特征图的通道数为Cx+Cy;表示卷积操作;1c表示一个1×1×c的张量。由此利用时间域和频率域得到了包含边界信息的边界图,为伪像素掩码提供了合理约束。在不同域上的边界可视化对比如图2所示。

通过观察图2(b)可以明显发现,时间域边界由于多层卷积的缘故会丢失部分目标边界信息,如图2(b)第四行,椅子下半部分的边界明显丢失。此外,如图2(a)第一行,当图像内存在多个物体时,时间域边界并不能探索到某些小尺寸物体的边界,而频率域边界可以探索到图像内不同尺寸大小物体的边界。故本文的边界检测分支通过融合两域的边界特征,使时频边界可以包含更多的边界信息,并且可以探索到图像内不同尺寸物体的边界,生成的边界图可以较好地保持目标边界的完整性和准确性。本文采用时间域边界和频率域边界多重约束种子区域的生长过程,使生成的伪像素掩码可以更好地覆盖目标区域,以提升弱监督语义分割的性能。

1.3 语义感知分支

近年来,注意力机制在语义分割任务中被广泛使用[16~18]。但是大多数方法都只是使用了骨干网中单阶段的信息,并没有使用如空间信息等其他阶段的信息。但是高级语义信息和低级边界信息都在分割任务中起着至关重要的作用。为了解决该问题,本文设计的语义感知分支(semantic-aware branching,SAB),使用双向空间注意力(bi-directional spatial attention,BSA)和通道注意力(channel attention,CA)结合的方式,结合了高级阶段和低级阶段的信息,突出每个通道的重要性,从而提供了辨别力更高的语义信息。语义感知分支整体结构如图3所示。

语义感知分支主要通过编码通道和空间注意力的方式提高对特征提取的能力,该分支主要由通道注意力模块CA和双向空间注意力模块BSA组成。在进行语义信息的提取时,尽管浅层特征会包含更丰富的空间信息,但是无论是深层特征还是浅层特征,都会保留关键的位置信息,所以为了捕获到具有长距离的位置关系,本文使用BSA,将输入特征分化成垂直方向和水平方向,达到同时利用深层和浅层的目的。

具体地,首先对深层特征进行上采样,以达到和浅层特征分辨率一致的目的;再将其通过一组分组卷积(3×1和1×3卷积)的特征与CA得到的特征逐像素相乘;由于BSA模块会输出两个不同的空间注意力图,所以将此结果与BSA生成的两个注意力图分别逐像素相乘再相加到一起,得到注意力加强的高分辨率特征图;最后再将其与分组卷积后的结果相加,从而编码特征图中的每个通道,达到提供更具辨别力语义信息的目的。

1.4 网络整体结构

本文网络基于原始的CAM,并添加边界信息和语义信息作为参考,使网络在目标被遮挡或重叠时可以正确区分目标类别,也可以自然地生长至目标边界,以达到准确分割的目的。网络整体结构如图4所示。

首先经过分类网络获取每个类的类别得分SC,再利用类别得分推导出种子区域Mc,公式如下:

SC=∑kwck∑x,yfk(x,y)=∑x,y∑kwck fk(x,y)(3)

Mc(x,y)=∑kwck fk(x,y)(4)

其中:fk(x,y)代表激活单元k在最后一个卷积层的空间位置(x,y);输入图像执行全局平均池化的结果为Fk=∑x,yfk(x,y);对于一个给定的类c,∑kwckFk为softmax的输入,wck是c类别对应的权重。

得到初始的种子区域后,在种子区域生长的过程中,利用边界信息对其进行像素点的相似度约束。给定一个以像素i为中心,大小为w的滑动窗口,Nci表示c类别的像素在窗口中的数量,则每个类别在窗口中的比例为Sci。

Sci=Nciw×w(5)

其中:像素需滿足以下两个条件即可被认定为边界。首先,在窗口中要有足够多的相同类别像素;其次,窗口中前景区域和背景区域的面积大小需要足够接近。因此判别像素i是否为边界的计算如下:

BSymbolYCpi=0 if min{max Sci,S0i}>2θscaleand |max Sci-S0i|≥2θdiff

1 if min{max Sci,S0i}>2θscale and |max Sci-S0i|<2θdiff(6)

其中:BSymbolYCpi=1代表边界像素;B∧i=0代表目标区域内部像素。在种子区域进行生长的过程中,对所生长后的像素进行权重分配的操作,使受到约束后的种子区域生长成的伪像素掩码可以覆盖更多目标类的语义区域,包含更丰富的语义信息。

设BSymbolYCpi=0的像素点为I,种子区域的质心为Pk,其计算公式为

Pk=∑iF*I∑iI(7)

则由种子区域生成伪像素掩码的过程为

M~k(j)=ReLU(F(j)·Pk‖F(j)‖·‖Pk‖)(8)

1.5 损失函数

在图像级弱监督语义分割中,为了使模型学习图像中不同类别的语义信息,并将像素点分配给相应的类别,本文使用多标签分类损失函数指导模型对图像进行分类预测,并根据预测结果生成初步的语义分割结果。该损失函数如式(9)所示。

Lcls(mD0,z)=-1C∑Cc=1zc log2(11+e-mD0)+(1-zc) log2(e-mD01+e-mD0)(9)

其中:mD0是模型预测向量;z是真值标签的二进制向量;C={c0,c1,…,cN}表示包含背景类的类别数。

由于在训练阶段,边界、前景和背景像素存在显著差异,为了解决该问题,本文将训练数据分为边界像素、前景像素和背景像素三部分。分别计算各个部分的交叉熵,并聚合成最终的边界损失函数:

LB=-∑i∈bryWilog2(Pi)|bry|-12(∑i∈clog2(1-Pi)|c|+∑i∈bglog2(1-Pi)|bg|)(10)

通过设计的边界损失函数可以使模型更准确地捕捉到目标边界,从而提高分割的精度和准确性。

2 实验及结果分析

2.1 数据集

本文算法在 Pascal VOC 2012 进行了实验,仅使用了其中的图像级标签用于训练。Pascal VOC 2012 包括了20个前景类别和1个背景类别。每张图片可能包括多个标签类别。使用从语义边界数据集(semantic boundaries dataset,SBD)收集的扩展数据集,其中有10 582张训练图片、1 449张验证图片,以及1 456张测试图片。为评价分割结果的准确性,以平均交并比(mean intersection over union,mIoU)作为图像语义分割评价指标,mIoU越大表示像素预测值与真实值的交集越大,分类预测结果越准确。mIoU的计算过程为

mIoU=1α+1∑αi=0pii∑αi=0pij+∑αi=0pji-pij(11)

其中:(α+1)表示类别数目;i表示真实类别;j表示预测类别;pij表示像素值真实为i类但被预测为j类;pii表示像素值真实值预测为i类;pji表示将像素预测j预测为真实值i。

2.2 实验细节

硬件配置为NVIDIA GeForce RTX 3090显卡, Intel CoreTM i7-12700k处理器,在Windows 10操作系统中,编程环境为Python 3.6,采用PyTorch 1.12.0深度学习框架进行训练和测试网络模型。在PASCAL VOC 2012数据集下,将批尺寸设置为4,学习率设为0.000 001,epoch设为3,滑动窗口w的大小设置为13,θscale设置为0.35,θdiff设置为0.10,时间域的卷积内核大小为3×3,步长设置为2,并在最后使用条件随机场(conditional random fields,CRF)来细化结果。

2.3 消融实验

为了验证本文网络的有效性,进行了多项实验,通过比较mIoU的值来验证本文网络的效果。本节所有的实验均在同一硬件配置和参数下进行。

本文网络使用VGG16分类网络产生初始化种子区域,并使用本文BAS-Net生成的伪像素掩码来训练以ResNet50为骨干网络的弱监督语义分割网络。其中,BAS-Net包含了边界信息和语义信息,边界信息包括时间域边界和频率域边界,为了验证边界检测分支中每个域边界对实验结果的影响,在保持同一实验条件下,通过添加和减少某一模块进行对比实验,结果如表1所示。

通过观察表1的结果可以看出,当只引入时间域边界时,mIoU从50.0%变为59.3%,提升了9.3%;只引入频率域边界时,mIoU从50.0%变为63.1%。这两组实验数据证明了本文提出的使用边界作为参考的有效性。当进一步将时间域边界和频率域边界融合进行边界辅助参考后,mIoU提升到了67.2%,这验证了本文提出的边界检测分支提高弱监督语义分割性能的可行性。

由于本文使用的频率域边界是采用八度卷积的方式进行,为方便记录,将八度卷积的不同方式按照定义1命名。

定义1 在本文中,根据八度卷积的运算过程,将经一层八度卷积处理后的高频特征命名为OCTH,低频特征命名为OCTL;连续两层八度卷积处理后的特征根据不同的通道命名为OCTHH、OCTHL、OCTLL、OCTLH;多层八度卷积的频率特征命名同上。

为探索在不同频率特征和边界之间的关系,本文构造三层八度卷积,以不同的级联方式获取不同频率的特征,并以不同频率的特征对其分别进行分割网络的训练。在同样的环境配置下将分割网络在PASCAL VOC 2012验证集上进行测试,测试结果如表2所示。

表2中,将只引入时间域边界而不结合频率域边界的分割网络测试结果作为基准,与使用不同级联方式的八度卷积获取频率信息的分割網络测试结果相比,发现OCTHHL级联方式的效果最好,包含了更多准确的边界信息;但OCTHHH效果一般,这是因为高频特征不仅包含边界信息,同样还有噪声。根据实验结果可知,OCTHHL更能有效提升最终的分割性能。所以本文提出的频率域边界采用OCTHHL的级联方式。

在确定边界检测分支可以提高弱监督语义分割网络的网络性能后,在同一实验条件下,通过添加或去除语义感知模块进行实验对比,结果如表3所示。

通过对比表3中的mIoU数值可知,当仅使用最原始的CAM生成伪像素掩码时,mIoU为53%,当给网络中添加边界信息时,mIoU达到67.2%,证明本文所提边界检测分支的有效性;当给网络中仅添加语义感知分支时,mIoU值达到了66.1%,相较原网络提升了13.1%,证明了本文所提边界检测分支的有效性;当同时使用边界检测分支和语义感知分支时,mIoU达到了73.2%,这证明了本文方法的有效性。实验表明,在弱监督语义分割中,语义信息和边界信息可以提高网络的分割性能。

为了更直观地观察到某模块对网络性能的影响,添加或移除某模块的分割结果对比如图5所示。

通过观察图5(a)(b)可以看出,当男孩和沙发重叠,并且男孩遮挡后方的奶瓶时,原始的分割结果不仅不能完整分割沙发区域以及缺少部分男孩的分割结果,出现漏分割,还出现将沙发、奶瓶以及手机错分割为人的情况。通过观察图5(c)可以发现,经过语义感知分支SAM处理后,网络可以正确地将沙发、手机以及奶瓶分类,改善了目标被遮挡或者重叠时出现的错分割情况,但沙发仍然未被正确分割,存在漏分割的问题。通过观察图5(d)可以发现,经过边界检测分支BDM的分割,原本未被分割的沙发部分以及男孩的脚部分被正确分割,改善了漏分割的情况,但是仍存在将沙发、奶瓶以及手机误认为男孩的错分割情况。观察图5(e)可以发现,经过本文提出的计划注意力处理后的分割结果,既可以正确区分目标类别,分割结果也可以相对正确地覆盖目标区域,解决了目标遮挡或重叠时错分割和漏分割的问题。

2.4 算法性能分析

为了验证本文算法的有效性,在语义分割常用的PASCAL VOC 2012数据集上对本文算法进行测试。最终在PASCAL VOC 2012數据集的测试集和验证集,mIoU分别达到了72.1%和73.2%,证明了本文方法的有效性,在该数据集上的可视化结果如图6所示。

观察图6(a)(b)第一行可以明显发现,原始的CAM无法区分原图中的火车、铁路以及火车的影子,出现错分割的问题;再观察图6(a)(c)第一行可以发现,经极化注意力处理后的语义分割网络可以较好地将像素进行分类,并且结果与真值较为接近。观察图6(a)(b)第二行可以发现,CAM无法区分飞机的梯子和飞机本身,和真值有较大差异,最终出现错分割的问题;再观察图6(a)(c)第二行可以发现,经计划注意力处理后的分割结果可以较好地区分属于飞机的像素,改善了错分割的情况。观察图6(a)(b)第三行,当树枝遮挡鸟时,CAM会错将树枝误认为鸟,同时也无法准确分割鸟的全身,和真值有较大差异,出现错分割和漏分割的情况;再观察图6(a)(c)第三行可以发现,经计划注意力处理后的分割结果不仅使鸟漏分割的部分得以正确分割,也解决了当目标被遮挡时出现的错分割问题,改善了弱监督语义分割网络的性能,证明了本文方法的可行性。

在同样的实验条件配置下, 将本文方法与前沿的弱监督语义分割方法在PASCAL VOC 2012验证集与测试集上进行对比,结果如表4所示。本文提出的基于边界辅助的弱监督语义分割网络,不仅使用语义信息更好地区分目标类的像素类别,也使用边界信息让种子区域可以自然地生长至目标边界,进而提升分割性能。与使用点、涂鸦、边框和像素级标签这类监督信息更强的方法相比,本文方法缩小了它们之间的性能差距。

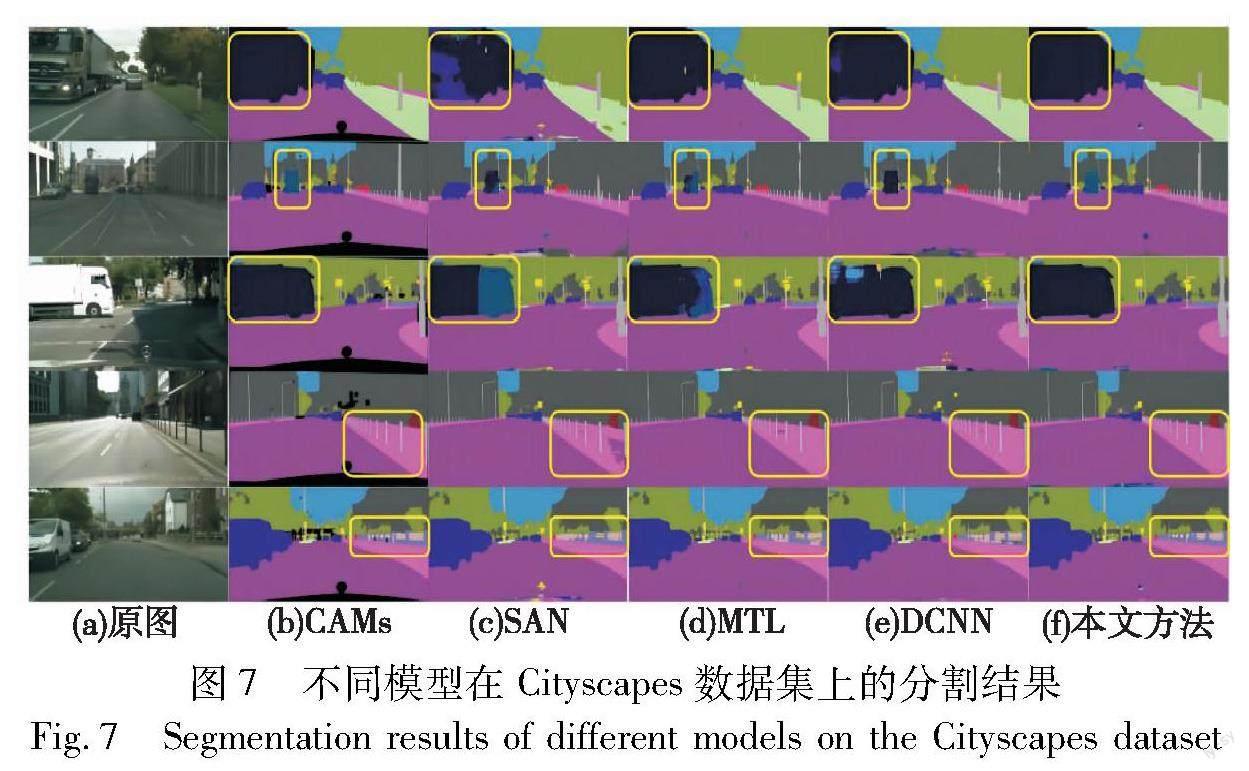

除了在PASVOC CAL 2012数据集进行验证外,也在Cityscapes数据集上对本文方法进行对比验证。Cityscapes数据集包含了交通场景中不同季节的街景图片,共5 000张精细标注的图像、2 000张粗略标注的图像以及30类标注物体,其中19类用于语义分割任务。本文使用3 000张训练集图片训练网络,500张验证集图片进行验证。在训练阶段使用随机尺寸裁剪和随机亮度变换的方式进行数据增强操作,并在相同的实验条件配置下,与近几年主流的弱监督语义分割算法进行对比,对比结果如表5所示。

通过对比表5结果,证明了本文算法相对于其他网络具有更好的分割效果。此外,为了验证本文算法对每一类物体的分割效果,也在Cityscapes数据集的验证集上针对每一类物体的mIoU值进行对比,对比结果如表6所示。

由于本文提出了语义感知模块和边界检测模块,本文方法针对较小的栅栏、细长的电杆等小目标可以保留大量的细节信息,使网络对小目标的分割更为准确。同时,由于引入边界信息,针对卡车、火车、建筑、公共汽车等相对较大目标可以更好地获取目标的边缘信息,使网络有较好的分割效果。

在Cityscapes数据集的验证结果对比如图7所示,其中图7(a)为原图,图7(b)~(e)分别为CAM、SAN、MTL以及DCNN方法的分割结果,图7(f)为本文分割结果。

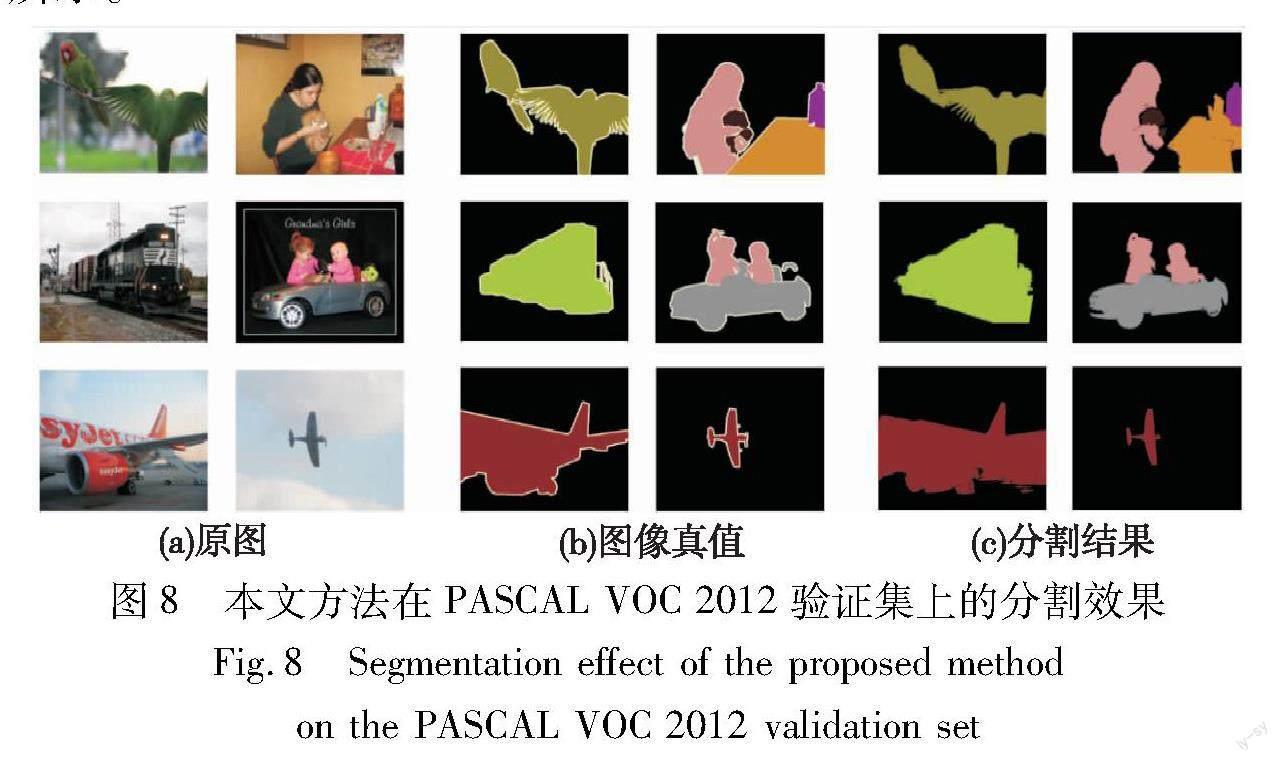

通过观察图7可以发现,本文提出的网络可以有效地保留空间信息,分割效果相对其他方法更为完整,如图7(c)第一、四行,图7(d)第二、三行所示,物体内部混淆的问题也得到改善。本文方法之所以取得了更优的实验性能,得益于采用边界信息和语义信息的方式,不仅使网络更好地区分目标类别,也让种子区域自然地生长至目标边界。这种方法在不添加任何额外标注信息的前提下,使种子区域的生长得到了合理的约束,使其生成的伪像素掩码可以更好地覆盖目标区域,解决了伪像素掩码缺失和溢出目标边界的问题。以这种高质量的伪像素掩码训练分割网络,可以生成更精准的分割结果。除了在Cityscapes数据集上进行实验结果对比外,本文网络也在数据集PASCAL VOC 2012上进行测试,分割结果和真值对比如图8所示。

3 结束语

本文提出了一种基于边界辅助的弱监督语义分割网络,使用语义信息使网络可以更好地区分目标类别,再以边界约束种子区域的生长过程,使其可以生成覆盖更完整目标区域的伪像素掩码。PASCAL VOC 2012验证集和测试集上的实验效果证明了本文方法的有效性,本文方法的性能超越了大多数弱监督语义分割方法。未来还将继续探索使用边界约束弱监督语义分割的方法,开发端到端的弱监督语义分割框架,充分利用边界信息和语义信息解决弱监督语义分割边界对象不匹配,类与背景共生、类间共生的问题,提升弱监督语义分割性能。

参考文献:

[1]Wu Yushuang, Cai Shengcai, Yan Zizheng, et al. PointMatch: a consistency training framework for weakly supervised semantic segmentation of 3D point clouds[EB/OL]. (2022-06-21). https://arxiv.org/abs/2202.10705.

[2]Zhang Binfeng, Xiao Jimin, Wei Yunchao, et al. Credible dual-expert learning for weakly supervised semantic segmentation[J]. International Journal of Computer Vision, 2023,131(8): 1892-1908.

[3]Wang Yuchao, Wang Haochen, Shen Yujun, et al. Semi-supervised semantic segmentation using unreliable pseudo-labels[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 4238-4247.

[4]Zhou Tianfei, Zhang Meijie, Zhao Fang, et al. Regional semantic contrast and aggregation for weakly supervised semantic segmentation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 4289-4299.

[5]Zhang Zhe, Wang Bilin, Yu Zhezhou, et al. Attention guided enhancement network for weakly supervised semantic segmentation[J]. Chinese Journal of Electronics, 2023,32(4): 896-907.

[6]刘腊梅, 宗佳旭, 肖振久, 等. 流形正则化的交叉一致性语义分割算法[J]. 中国图象图形学报, 2022,27(12): 3542-3552. (Liu Lamei, Zong Jiaxu, Xiao Zhenjiu, et al. Cross-consistent semantic segmentation algorithm for manifold regularization[J]. Journal of Image and Graphics, 2022,27(12): 3542-3552.)

[7]缪佩翰, 包翠竹, 高佳, 等. 双域级联决策和协作标注自提升的鲁棒弱监督语义分割[J]. 计算机辅助设计与图形学学报, 2022,34(4): 605-613. (Miu Peihan, Bao Cuizhu, Gao Jia, et al. Robust and weakly supervised semantic segmentation with dual-domain cascade decision-making and collaborative annotation self-promotion[J]. Journal of Computer-Aided Design & Computer Graphics, 2022,34(4): 605-613.)

[8]Sun Kunyang, Shi Haoqing, Zhang Zhengming, et al. ECS-Net: improving weakly supervised semantic segmentation by using connections between class activation maps[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2021: 7263-7272.

[9]Zhang Fei, Gu Chaochen, Zhang Chenyue, et al. Complementary patch for weakly supervised semantic segmentation[C]//Proc of IEEE/CVF International Conference on Computer Vision. Pisca-taway, NJ: IEEE Press, 2021: 7222-7231.

[10]Jo S, Yu I J, Kim K. Mars: model-agnostic biased object removal without additional supervision for weakly-supervised semantic segmentation[EB/OL]. (2023-04-19). https://arxiv.org/abs/2304.09913.

[11]Han Zheng, Xiao Zhitao. Weakly supervised semantic segmentation based on semantic text on forest and saliency prior[J]. Journal of Electronics & Information Technology, 2018,40(3): 610-617.

[12]白雪飛, 李文静, 王文剑. 基于显著性背景引导的弱监督语义分割网络[J]. 模式识别与人工智能, 2021,34(9): 824-835. (Bai Xuefei, Li Wenjing, Wang Wenjian. Salienly background guided network,for weak-supervised semantic segmentation[J].Pattern Re-cognition and Artificial Intelligence, 2021,34(9): 824-835.)

[13]Cermelli F, Mancini M, Buló S R, et al. Modeling the background for incremental and weakly-supervised semantic segmentation[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2022,44(12): 10099-10113.

[14]Makkar N, Yang H L. Entropy and boundary based adversarial lear-ning for large scale unsupervised domain adaptation[C]//Proc of IEEE International Geoscience and Remote Sensing Symposium. Piscataway, NJ: IEEE Press, 2020: 589-592.

[15]欒晓梅, 刘恩海, 武鹏飞, 等. 基于边缘增强的遥感图像弱监督语义分割方法[J]. 计算机工程与应用, 2022,58(20): 188-196. (Luan Xiaomei, Liu Enhai, Wu Pengfei, et al. Remote sensing image weak supervised semantic segmentation method based on edge enhancement[J]. Computer Engineering and Applications, 2022,58(20): 188-196.)

[16]Wang Yude, Zhang Jie, Kan Meina, et al. Self-supervised equivariant attention mechanism for weakly supervised semantic segmentation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2020: 12272-12281.

[17]Ruan Hongjia, Song Huiui, Liu Bo, et al. Intellectual property protection for deep semantic segmentation models[J]. Frontiers of Computer Science: Selected Publications from Chinese Universities, 2023,17(1): 9.

[18]Kuang Sheng, Woodruff H C, Granzier R, et al. MSCDA: multi-level semantic-guided contrast improves unsupervised domain adaptation for breast MRI segmentation in small datasets[EB/OL]. (2023-06-08). https://arxiv.org/abs/2301.02554.

[19]Chen L C, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully con-nected CRFs[J]. Computer Science, 2014,4: 357-361.

[20]Bearman A, Russakovsky O, Ferrari V, et al. Whats the point: semantic segmentation with point supervision[C]// Proc of European Conference on Computer Vision. Berlin: Springer, 2016: 549-565.

[21]Lin Di, Dai Jifeng, Jia Jiaya, et al. ScribbleSup: scribble-supervised convolutional networks for semantic segmentation[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 3159-3167.

[22]Khoreva A, Benenson R, Hosang J, et al. Simple does it: weakly supervised instance and semantic segmentation[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 1665-1674.

[23]Jonnarth A, Felsberg M, Zhang Yushan. Activation-based sampling for pixel-to image-level aggregation in weakly-supervised segmentation[EB/OL]. (2022-03-23). https://arxiv.org/abs/2203.12459v1.

[24]Liu Yang, Zhang Ersi, Xu Lulu, et al. Mixed-UNet: refined class activation mapping for weakly-supervised semantic segmentation with multi-scale inference[EB/OL]. (2022-05-06). https://arxiv.org/abs/2205.04227.

[25]Cao Zhiyuan, Gao Yufei, Zhang Jiacai. Scale-aware attention network for weakly supervised semantic segmentation[J]. Neurocomputing, 2022, 492: 34-49.

[26]Xie Xuanhua, Fan Huijie, Yu Zhencheng, et al. Weakly-supervised medical image segmentation based on multi-task learning[C]//Proc of International Conference on Intelligent Robotics and Applications. Cham: Springer, 2022: 395-404.

[27]Al-Huda Z, Peng Bo, Algburi R N A, et al. Weakly supervised pavement crack semantic segmentation based on multi-scale object localization and incremental annotation refinement[J]. Applied Intelligence, 2023,53(11): 14527-14546.

[28]Strudel R, Laptev I, Schmid C. Weakly-supervised segmentation of referring expressions[EB/OL]. (2022-05-12). https://arxiv.org/abs/2205.04725.