基于短文本扩展和特征融合的市民热线文本分类

郭小磊,张吴波

(湖北汽车工业学院电气与信息工程学院,湖北十堰 442002)

随着城市化建设的不断推进,市民热线成为城市管理中最为重要的途径之一。各类热线问题通过电话、短信等形式向政府部门反映,这些对政府决策和管理至关重要[1]。然而,市民热线文本通常是短文本,具有表述不规范、结构复杂等特点,这给文本分类任务带来了巨大的挑战[2]。将市民热线文本进行自动识别和归类,对于促进政府与市民的沟通交流具有重要意义。目前,已有许多学者尝试使用不同的方法解决短文本分类问题,如基于传统机器学习的分类方法和基于深度学习模型的分类方法。然而,由于热线短文本的特征稀疏性以及语言表述不规范性,导致一般的文本分类方法难以取得理想的分类效果[3]。

针对此问题,提出使用TF-IWF模型和LDA主题模型抽取关键词构建核心词库、利用Word2Vec 模型计算词语相似度,实现对短文本内容及词汇向量的扩展,以提高文本的表征能力;并设计了一种基于双通道特征融合的短文本分类BGTC模型,该模型采用TextCNN 通道学习文本的局部特征,BiGRU-Attention 通道获取上下文的重要语义特征,通过融合2 个通道的特征信息,丰富了词向量的语义特征,最终实现了对市民热线短文本的高效分类。

1 相关工作

1.1 文本分类

传统的市民热线文本分类基于机器学习的方法,使用人工提取特征,将多个特征串联组成高维特征向量,通过各种机器学习算法完成文本分类[4],如支持向量机(Support Vector Machine,SVM)、朴素贝叶斯(Naive Bayes,NB)、逻辑回归模型(Logistic Regression,LR)等。李铭鑫等[5]通过构建LR、NB 模型完成了对政务留言文本的分类。武光华等[6]基于LDA 模型求取语义影响力作为特征词的权重改进了TF-IDF 算法,提高了在95598 热线工单分类任务的准确率。传统机器学习方法的特征选择和提取复杂,针对短文本分类时往往效果较差。目前,市民热线文本分类任务主要运用深度学习技术完成特征的自动提取和分类。承孝敏等[7]提出了一种基于强化联系的注意力(Attention)机制算法,捕获文本之间的关联信息,将分类结果输出给12345热线事件所对应的分拨部门,解决了手工事件分拨耗时长、效率低下等问题。陈钢[8]提出了一种融合RoBERTa 和特征提取的分类方法,通过融合市民热线文本的局部特征和全局特征,取得了更好的文本分类效果。黄秀彬等[9]将残差卷积网络与双向长短时记忆网络结合,来挖掘市民热线文本中的深层语义信息,从而提升了分类的准确度。

1.2 文本扩展

相较于长文本,短文本的长度限制往往会导致内容稀疏、缺乏全面性。针对短文本的分类,常需要对短文本的内容进行扩展,短文本扩展的主要方法有两种:①基于外部语料库的文本特征扩展;②基于短文本自身内容特征扩展[10]。基于外部语料库的文本特征扩展,是使用大规模的语料库来获取与短文本相关的额外信息,以增加短文本的信息量。许淞源等[11]借助知识图谱获取外部知识对短文本进行特征扩展,解决了短文本特征稀疏的问题。另一方面,基于短文本自身内容特征扩展是指利用原始的文本特征进行扩展,如提取命名实体、关键词等元素,该方法摆脱了对外部语料库质量的依赖性,具有更强的适用性。李艳红等[12]使用TF-IDF 算法从评论文本中抽取特征词,完成了对微博文本特征扩展。周国剑等[13]提出了一种基于LDA 模型和文本互扩展的短文本分类方法,基于LDA 模型预测分布信息以及短文本的相异词关系,实现了短文本的特征扩展。考虑到LDA 模型可以构建基于主题粒度的高频词集、词向量模型可以根据语义的粒度丰富短文本内容,邵云飞等[14]使用TF-IDF 模型以及LDA 主题模型构建了基于类别特征的关键词集与主题分布集,完成对短文本内容及词汇向量表征上的扩充。

综上所述,针对市民热线短文本特征稀疏、描述概念弱的特点,提出首先通过LDA 模型、TF-IWF 模型和Word2Vec 模型挖掘短文本自身的内容特征,以构建核心词库实现短文本扩展;然后再使用基于双通道特征融合的BGTC 模型完成对市民热线文本的分类。

2 短文本扩展及分类方法

2.1 基于LDA和TF-IWF提取核心词库

LDA 模型是一种概率主题模型用于对文档集合进行主题分析,该模型假设每个文档都包含若干个主题,每个主题又由多个单词组成。给定一篇文档,LDA 模型会通过生成过程推断出主题分布,即该文档中每个主题的出现概率,每个主题则为特征词的多项分布。

TF-IDF 模型指词频-逆文档频率模型,是用于衡量一个词在文本中的重要性。它采用两个因素:一个是词频(TF,Term Frequency),指在文本中该词出现的频率;另一个是逆文档频率(IDF,Inverse Document Frequency),指在文档集中出现该词的文档数的倒数。TF-IDF 算法将一个单词在文档中出现的频率与该单词在整个语料库中出现的频率相除,得到该单词的TF-IDF 权重。TF-IDF 既反映了单词在当前文档中的重要性,又反映了单词在整个语料库中的普遍性。

TF-IWF 是TF-IDF 的变体,通过将逆文档频率(IDF)替换为逆词频权重(IWF,Inverse Word Frequency),减轻了高词频问题带来的影响,加强了对出现不太频繁但有较大权重的单词的重视度,因此在文本分类场景下会比TF-IDF 更有效[15],TF-IWF 算法的计算公式如式(1)-(3)。

其中:Nd,t为词t在文档d中出现的总次数;Nd为文档d的总词数;Wc为文档集中所有词的频率;Wc,t为词t在文档集所有词中的频率。

结合LDA 模型和TF-IWF 算法统计特征词获取核心词库的具体步骤如下:

(1)对训练集进行预处理,使用分词、去停用词、词性过滤法,仅保留对分类影响较大的单词;

(2)使用LDA 模型处理训练集,获取各个主题下的主题词的概率分布,针对某个主题,从主题词概率分布中选取概率值排名前X个特征词作为该主题的主题词集;

(3)利用TF-IWF 算法计算训练集中每个单词的权重,选取在每个类中权重值大于Y的特征词作为高权重词集;

(4)最终将每个主题的主题词集和高权重词集进行合并,从而得到训练集的核心词库W=(W1,W2,...,WT),T为核心词个数。

2.2 基于Word2Vec计算相似度

Word2Vec 是一种词向量模型,该模型利用词语窗口的上下文信息将一个词转化为低维实数向量,从而能够在向量空间中比较词语之间的相似度,Word2Vec模型通过计算两个单词向量间的距离来评估它们的相似性,其中较小的距离意味着更相似的单词。Word2Vec 模型计算两个词M1 和M2 的相似度方式,如图1。

图1 基于Word2Vec计算相似度方法图

其中,a、b分别为词语M1 和M2 根据Word2Vec 模型计算出的词向量;cos为余弦相似度公式。

2.3 基于核心词库和相似度的短文本扩展

对于训练集,基于核心词库和相似度的短文本扩展的具体过程如下:

(1)对训练集中的短文本进行预处理,使用分词、去停用词、词性过滤法,仅保留对分类影响较大的单词作为特征词集合N=(N1,N2,...,NM),M为特征词个数;

(2)对特征词集合中的每个特征词Ni(Ni∈N)与经过LDA 模型与TF-IWF 算法计算得到的核心词库集合中的每个核心词Wj(Wj∈W)基于Word2Vec模型计算相似度,将相似度排名最高的前Z个单词作为特征词Ni的扩展词。

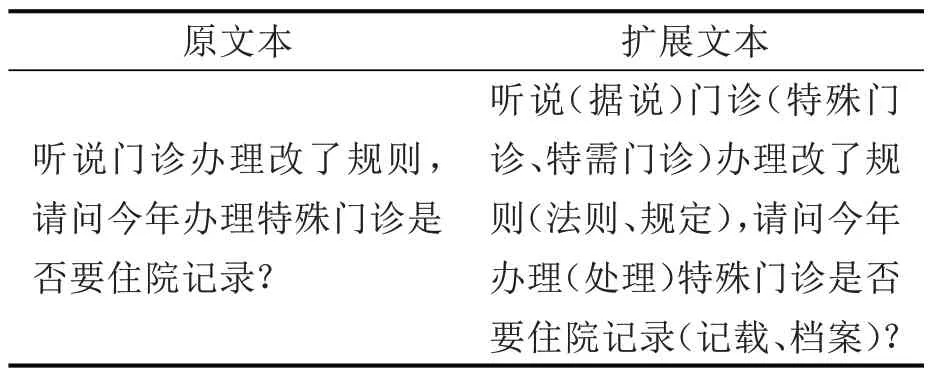

例如,对表1中的市民热线文本进行基于核心词库和相似度的短文本扩展。首先以“特殊门诊”“规则”“住院记录”等词汇为中心,构建核心词库;然后根据余弦相似度计算短文本中每个单词与核心词库中单词的相似度;接着筛选出与短文本相似度较高的核心词汇,如“办理”“规则”“特需门诊”;最终将筛选出的关键词融合到原始短文本中,结果如表1,其中将扩展词加括号后放在被扩展词之后,得到扩展后的新文本。

表1 短文本扩展样例表

2.4 基于文本扩展和BGTC模型的文本分类方法

针对市民热线文本分类任务,提出首先基于LDA 模型和TF-IWF模型抽取关键词构建核心词库,利用Word2Vec计算词语相似度对短文本进行特征扩展,接着使用BGTC 模型进行短文本分类,该方法的具体架构如图2。

图2 基于BERT-CNN的短文本分类架构图

2.4.1 BERT模型

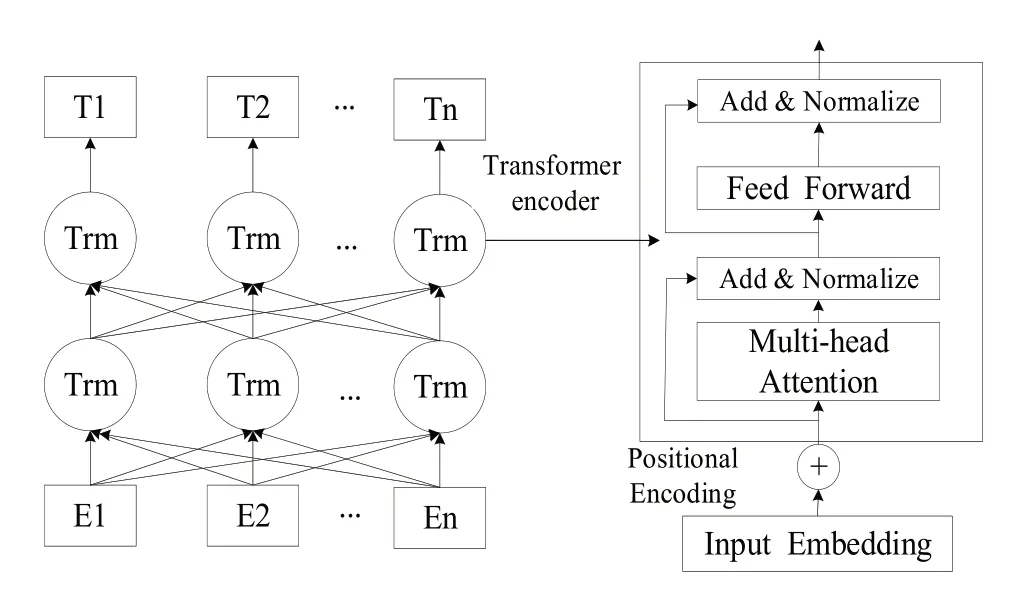

BERT 是一个强大的预训练语义表征模型,该模型基于多层双向的Transformer 编码器构建,可以同时提取上下文的双向语义信息,从而增强词向量的语义表征能力。BERT的模型结构如图3。

图3 BERT模型结构图

BERT 模型的核心是Transformer 编码器的多头注意力(Multi-head Attention)机制,采用多个Attention 模块从不同角度学习输入单词与上下文单词的关联关系并分配相应的权重值,最终学习到了一个与原始词向量长度相同的增强语义向量。Attention机制的计算方法如式(4)。

其中,Q、K、V为输入向量矩阵,dk为字向量维度。

Multi-head Attention 机制通过多个不同的线性变化对Q、K、V 进行投影,将得到的多个Attention 结果进行拼接,计算方法如式(5)-(6)。

BERT 模型通过Multi-head Attention 机制调整每个字词在输入文本中的权重,实现了文本序列的高效向量表征。

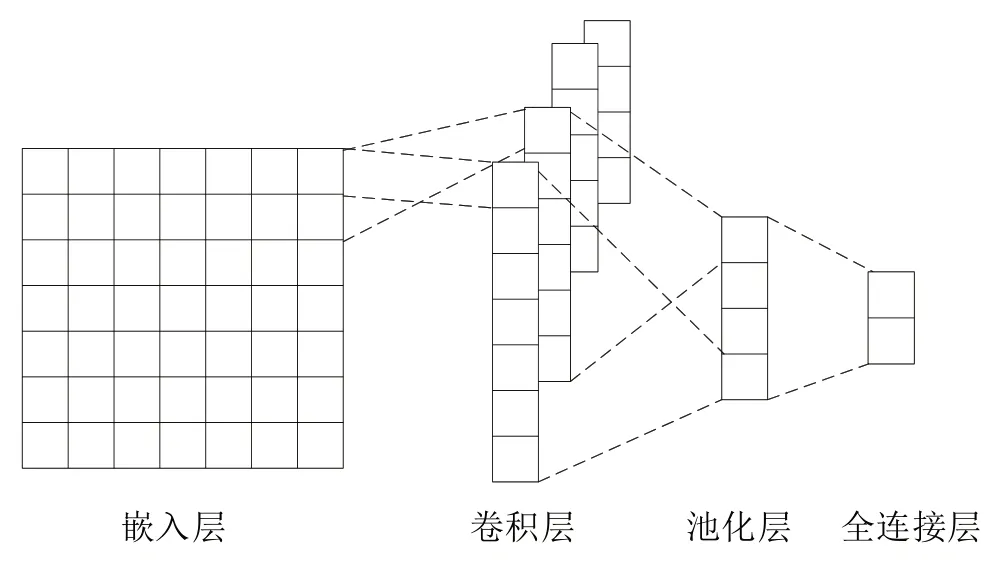

2.4.2 TextCNN模型

TextCNN 是一种经典的文本分类模型,由嵌入层、卷积层、池化层和一个全连接层组成,可以有效地提取文本的关键信息,TextCNN结构如图4。

图4 TextCNN结构图

首先,将BERT 模型输出的特征向量矩阵输入到卷积层,在卷积层通过采用k个不同大小的滑动窗口对文本特征进行卷积操作学习文本的局部特征,计算方法如式(7)-(8)。

其中,Ci为卷积操作后得到的特征向量;Pi为特征向量组成的特征矩阵;Hi∶i+k-1为词向量矩阵H从第i 行到i+k-1行的子矩阵;f为ReLU激活函数;b为偏置向量;L为序列长度;滑动步长为1。

然后,对卷积层输出的特征集合进行池化操作,以保留文本中的局部关键特征,丢弃无关特征,降低特征向量维度,防止过拟合。采用最大池化(Max Pooling)法从每个滑动窗口中筛选出一个最大特征值,计算方法如式(9)。

最终,采用全连接层充当整个模型的分类器,将池化层中得到的特征转化为类别标签,使用Softmax分类器,计算出所属各类别的概率,取概率最大的类别作为最终的分类结果,计算如公式(10)。

2.4.3 BiGRU-Attention模型

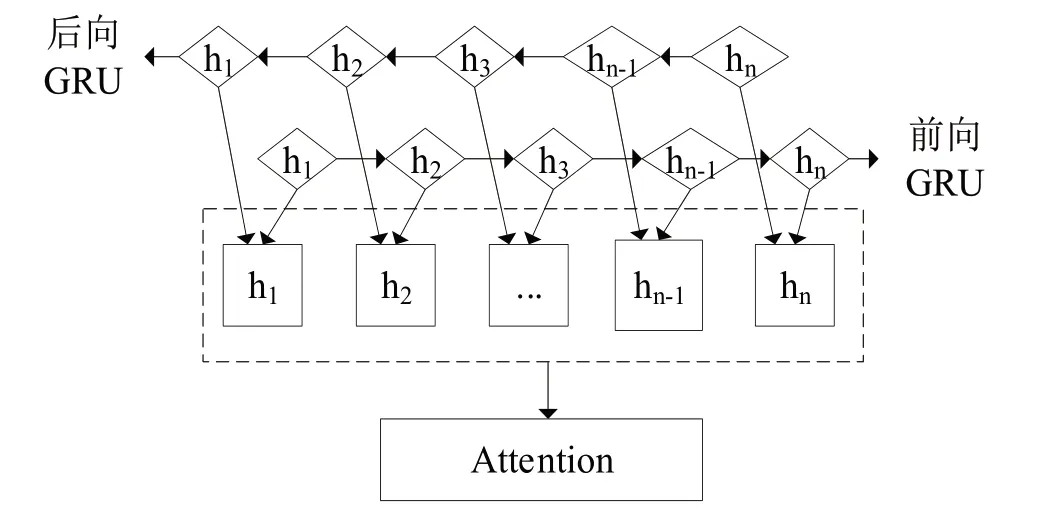

在BiGRU 模型中融合Attention 机制,可以选择性地对文本中的不同词语赋予不同的权重,使模型关注到对分类结果影响更大的特异性信息,从而提高分类的性能。BiGRU-Attention模型结构如图5。

图5 BiGRU-Attention结构图

首先将BiGRU的输出特征Gi输入到Attention机制中,计算出注意力权重zi;然后通过Softmax函数将注意力权重标准化,生成概率向量ai;最后将归一化权重值ai与BiGRU 输出的Gi进行点乘与累加操作,得到最终的输出特征Y。计算方法如式(11)-(13)。

3 实验与分析

3.1 数据集

数据集基于Python 爬虫收集三亚市和永州市市长邮箱中的热线文本,按照8∶2的比例划分成训练集和测试集,进行预处理后用于后续实验,数据集划分为10个类别,具体如表2。

表2 数据集分布情况表 单位/条

3.2 评价指标

实验采用准确值(Accuracy)和F1 值作为模型的评价指标,准确值作为分类任务中经常使用的评价指标之一,定义如式(14)。

其中,T 表示分类器预测正确的样本数目;N 表示分类器预测错误的样本数目。

F1 值需先计算精确度(Precision)和召回率(Recall),F1 值是指精确度等于召回率时的平衡值,计算公式如(15)。

其中,TP 是样本为正,预测结果为正的数量;FP 是样本为负,预测结果为正的数量;FN 是样本为正,预测结果为负的数量。

3.3 实验环境与参数

实验超参数设置:模型中采用Adam 作为优化器,学习率参数设置为e-5,采用L2 正则化最小化交叉熵作为损失函数,其中BERT 层采用谷歌公司开源模型,该模型采用12 层Transformer 编码器,隐层的维度为768;多头注意机制的头数为12;TextCNN 模型中隐藏单元数各为32;GRU 隐藏维度为64;训练过程中batch_size 设置为16,max_sequence 设置为32,drop_rate 设置为0.05,epochs 设置为10。

基于TF-IWF 模型、LDA 模型和Word2Vec 模型构建核心词库时的参数X、Y、Z分别设置为15、0.5、5。

3.4 实验结果

3.4.1 基于扩展后不同模型的分类实验

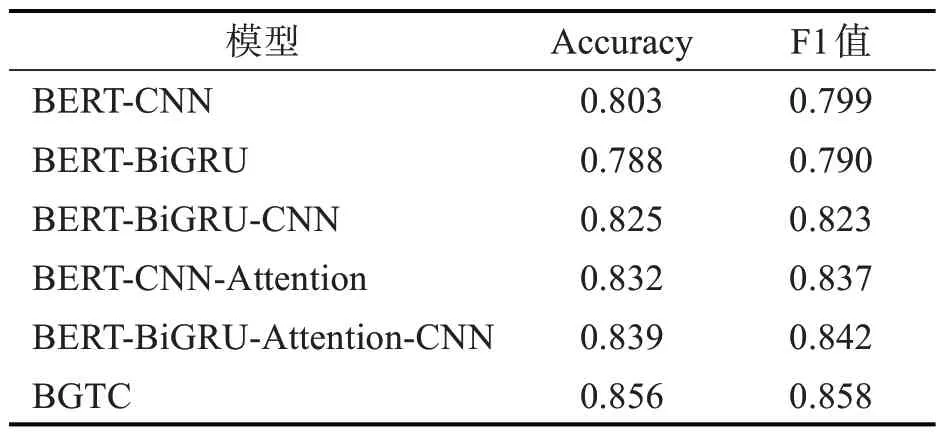

针对市民热线文本数据集,为了验证,采用的BGTC模型对于市民热线文本分类效果的有效性,使用不同模型进行了对比实验。实验前,已对数据集基于TF-IWF 模型、LDA 模型和Word2Vec 模型进行了短文本扩展,结果如表3。

表3 不同模型的分类结果

由表3 可知,BERT-CNN、BERT-BiGRU 模型在针对市民热线文本进行分类时,表现都不甚理想,其中CNN 模型的表现略好于LSTM 模型,准确值和F1 值分别提高了1.5%和0.9%,这是因为LSTM是一种适用于长序列数据的循环神经网络结构,可以对历史状态进行长期的记忆和处理,然而在短文本分类任务中,输入的文本较短信息量比较少,因此不需要过长的历史状态来进行判断,这导致了LSTM 在短文本分类中可能存在着过度建模、参数冗余等问题,从而影响了它的性能表现。BERTCNN-Attention 和BERT-BiGRU-CNN 模型的分类性能都有较大提升,其中,BERT-CNN-Attention 模型通过Attention 机制获取局部关联权值来提取出重要的局部特征,进而提升了区分不同的语义类别的能力。BGTC 模型的准确值和F1 值分别为85.6%和85.8%,相较于其他的模型在准确值和F1 值上都有明显的提升,比单通道的BERT-BiGRU-Attention-CNN 模型提高了1.7%和1.6%,这表明双通道模型凭借融合TextCNN 模型提取局部关键信息和BiGRU-Attention 模型提取上下文特征的能力,进而拥有了更强的表征能力,能够有效地提高分类性能。相较于单通道的BERT-BiGRU-Attention-CNN 模型,BGTC 模型综合利用了双通道的优点,使得模型具备更好的特征提取能力及句子理解能力,进而取得了更好的分类效果。

3.4.2 基于不同扩展方法的分类实验

为了验证基于TF-IWF 模型、LDA 模型构建核心词库以及基于Word2Vec模型的词语相似度计算的短文本扩展方法,基于BGTC分类模型与如下几个公开的短文本扩展方法进行了对比实验,实验结果如表4。

表4 不同短文本扩展方法的分类效果表

方法1:文献[16]基于词嵌入、词相似度和词重要性共同作用的文本扩展方法,在Word2vec 上引入词语相似度,并通过相似度与TF-IDF 模型的乘积来表示扩展词语对短文本的影响因子,构造短文本向量以扩展文本长度和内容。

方法2:文献[17]基于TF-IDF 与LDA 模型提取类别特征,并基于词汇信息熵N-gram 过滤出低类别贡献度词,最终完成了短文本的扩展。

方法3:文献[18]基于TF-IDF 与LDA 模型构建出核心词库,使用了HowNet算法进行相似度计算完成了短文本扩展。

方法4:首先使用LDA 模型获取每个主题下的主题词,然后利用TF-IWF 算法提取出高权重词集,接着将主题词集和高权重词集合并得到核心词库,最终将核心词库集合中的每个核心词基于Word2Vec 模型计算相似度得到扩展词,实现了对短文本的扩展。

由表4 可知,短文本扩展后BGTC 模型的准确值和F1 值都有所提升,其中准确值从82.8%提升到85.6%,F1 值从83.0%提升到85.8%。这表明所提的使用3 种模型:TF-IWF 模型、LDA 模型和Word2Vec模型进行短文本扩展,可以在不同程度上丰富文本的语义信息,有助于模型更全面地理解文本。相较于未扩展的短文本,使用各种方法进行扩展后BGTC模型进行分类的性能都有了不同程度的提高。方法相对于其他3种方法达到了最佳的分类效果,F1值分别有了2.1%、0.5%和1.1%,这表明基于TF-IWF 模型、LDA 模型构建核心词库以及基于Word2Vec 模型的词语相似度计算的短文本扩展方法,针对市民热线文本的扩展方式更加有效,通过加括号的方式,将扩展词直接添加到被扩展词之后,完成了对短文本的扩展,此方法可以有效地对被扩展词进行具体的阐述说明,同时扩展词和被扩展词相邻,更有助于保留句子之间的语法关系,在增加上下文语义信息的同时,使得BGTC模型能够更有效地学习到核心词的特征信息。相较于使用TF-IDF 模型的方法,采用了TF-IWF 模型,TF-IDF 模型仅用词频来表示文档中每个单词的重要性,但是词频并不能完全衡量单词的重要性,也就无法理解单词在不同文集中使用的潜在分布。相反,TF-IWF 模型同时考虑了单词在局部文本和全局语料库中的频率,所以可以更好地捕捉单词的特征,因此更适用于这种短文本场景下。最终,提出的基于TF-IWF 模型、LDA 模型构建核心词库、基于Word2Vec 模型计算词语相似度的短文本扩展方法,在BGTC 模型下取得了更有效的分类效果,准确值和F1值分别达到了85.6%和85.8%。

4 结语

在市民热线短文本分类任务中,提出了首先通过基于TF-IWF 模型、LDA 模型构建核心词库,基于Word2Vec 模型计算词语相似度实现对短文本的扩展,使得扩展后的文本更加全面、准确。然后提出了双通道特征融合的BGTC 模型,利用TextCNN 通道学习文本的局部特征,BiGRU-Attention 通道获取上下文的重要语义特征,并通过融合2个通道的特征信息,丰富了词向量的语义特征,最终实现了对市民热线短文本的有效分类。尽管方法有一定局限性,但仍为解决市民热线领域的短文本分类任务提供了一定的思路和方向。