深度学习辅助的5G OFDM系统的信道估计*

王义元,常 俊,卢中奎,余福慧,魏家齐

(云南大学 信息学院,昆明 650500)

0 引 言

面对5G的多样化智能服务需求,无线通信的信道状态信息(Channel State Information,CSI)的准确获取至关重要。在实际的无线通信环境中,信道容易受到多径传播、多普勒频移和传播环境的非平稳特性的影响,并且在5G NR(New Radio)系统中使用了大带宽,子载波的数据较大,信道频率响应矩阵的维度较高,解调参考信号(Demodulation Reference Signals,DMRS)仅在带宽内的部分子载波上传输,给信道估计增加了很大的难度[1]。传统的信道估计方法如最小二乘(Least Square,LS)算法和最小均方误差估计(Minimum Mean Square Error,MMSE)算法,都是在接收端利用导频位置处插入的已知导频信息来进行信道的估计。其中,LS算法利用导频处的信道信息通过插值的方法来进行信道估计,但其没有考虑信道中噪声的影响,信道估计的性能较差;MMSE算法具有较高的信道估计性能,但其需要信道的统计信息和矩阵的求逆运算来进行信道的恢复,运算复杂度较大,难以实现,在实际的系统中没有得到应用[2]。

随着软硬件技术的飞速发展,深度学习技术在计算机视觉,自然语言处理,无人驾驶等领域取得了巨大的成功。将深度学习(Deep Learning,DL)引入到无线通信中成为现代通信的研究热点,智能通信成为现代通信系统的追求[3-4]。文献[5]提出了一个五层全连接神经网络对一个正交频分复用(Orthogonal Frequency Division Multiplexing,OFDM)符号的信息直接进行端到端的信号检测与估计,仿真结果表明,基于深度学习的信道估计方案在复杂信道环境下较传统算法有明显优势且具有更强的鲁棒性。文献[6-7]利用深度神经网络来代替传统信道估计算法的插值过程来完成信道估计,仿真结果表明深度学习信道估计算法较传统算法性能有显著优势。鉴于深度学习技术在图像处理中取得的巨大成功,以及信道矩阵具有与图片数据相似的特性,将图像处理技术应用在信道估计方面受到了越来越多的关注。文献[8]将快衰落通信信道的时频响应看作二维图像,利用图像处理中的超分辨率(Super Resolution,SR)和图像恢复(Image Restoration,IR)技术来进行信道估计,提出了ChannelNet网络模型,实验结果表明该算法的性能与MMSE算法相当。文献[9-10]提出将大规模多输入多输出(Multiple-Input Multiple-Output,MIMO)系统中的信道矩阵建模为2D图像,使用基于卷积神经网络(Convolutional Neural Network,CNN)的去噪网络来进行信道估计。文献[11]针对毫米波大规模MIMO系统提出了一种基于空间和频率的信道估计方案以减少导频开销,仿真结果表明CNN网络可以有效利用信道相关性来提高毫米波大规模MIMO系统的估计性能。文献[12]提出了一种基于3GPP LTE标准的OFDM信道估计方案,将残差学习的深度神经网络用于信道估计,仿真表明其性能与MMSE算法相当。

在上述的文献中,文献[5-7]虽验证了深度神经网络在信道估计中的有效性,但所处理的数据都只是一个OFDM符号的数据。在实际的通信系统中,数据信息是一帧一帧地发送,导频只存在于部分OFDM符号中,因此其使用的数据与实际通信系统中的数据不符,不能对实际的通信系统数据进行有效验证。在文献[8]和[12]中,所考虑的系统是基于LTE标准,并未考虑5G通信系统。基于以上分析,为了解决5G移动通信系统在高速率需求的情况下传统信道估计算法性能不足的问题,本文在3GPP 5G NR标准协议的基础上搭建通信系统进行数据采集,将系统中的信道矩阵建模为一个具有2个通道的图像,将信道估计问题视为一个图像处理问题,提出了一种基于残差连接的深度卷积神经网络(Convolution Neural Network with Residual Connection,ReCNet)信道估计算法,以卷积神经网络为基础构建优化单元,利用残差连接提升优化单元的拟合能力来恢复出信道矩阵信息。仿真结果表明,本文所提出的信道估计算法性能较传统信道估计算法有较大提升。

1 系统模型

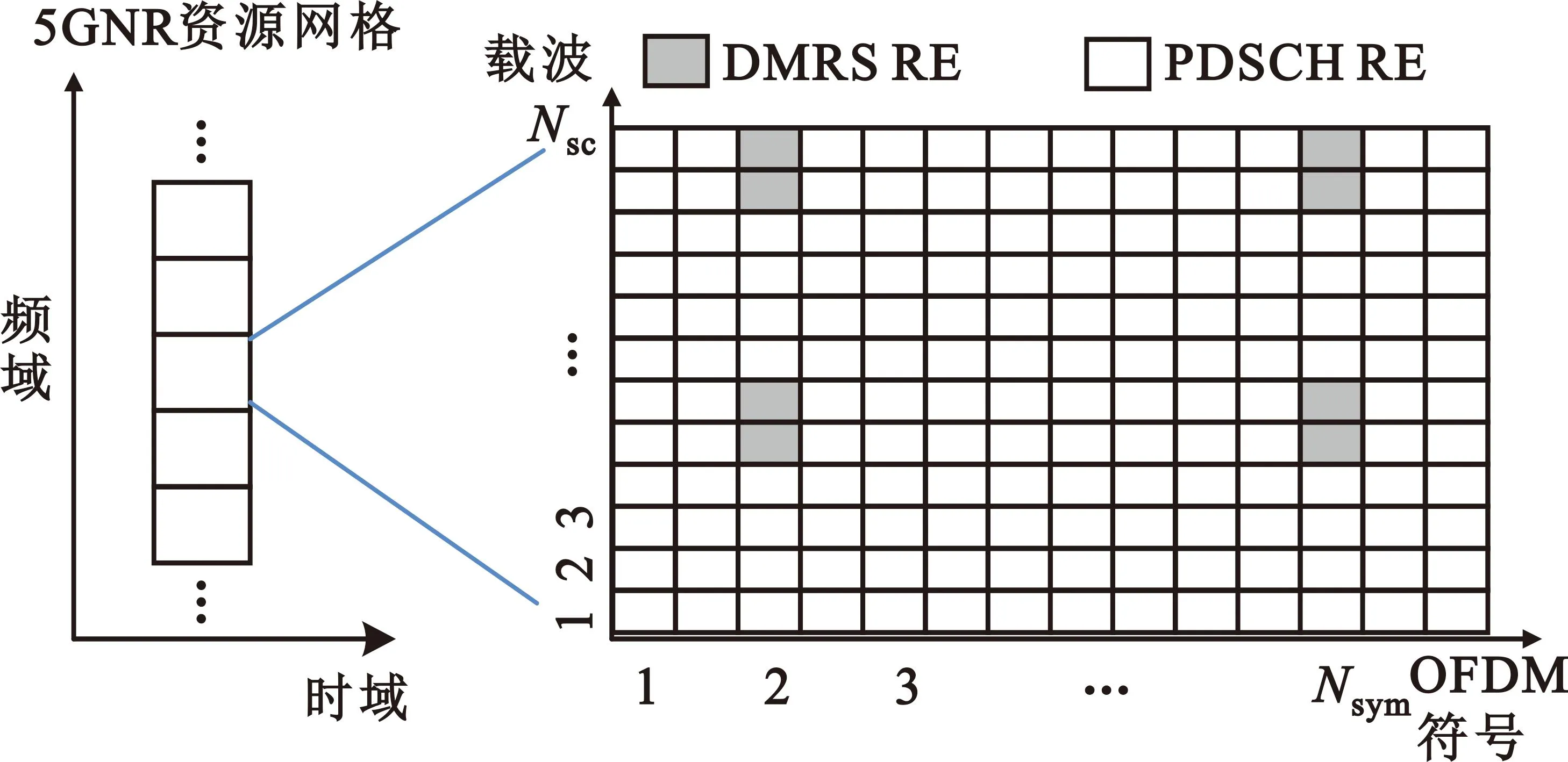

在本文中,以5G NR标准协议来构建OFDM系统,考虑单输入单输出(Single-Input Single-Output,SISO)的OFDM系统的5G物理下行链路共享信道(Physical Downlink Shared Channel,PDSCH)。在系统中数据信息是通过资源元素(Resource Element,RE)进行传输的,每一个RE对应的是一个OFDM符号上的一个载波。在NR标准中Nsym个OFDM符号组成一个时隙(slot),在本文中取Nsym=14。在一个时隙中,Nsc个子载波构成一个资源块(Resource Block,RB),在NR标准中规定Nsc=12,一个slot中可以有Nnum个RB,其中Nnum的数量没有具体规定,可根据需求设定。在本文中,如图1所示,一个RB中共有Nsc×Nsym个RE。在图1中,灰色的RE表示的是解调参考信号(Demodulation Reference Signals,DMRS )即导频信号,空白方格表示PDSCH RE,用来传输发送信号信息。在NR系统中,DMRS的位置可以灵活配置,导频信息通过DMRS RE进行传输,数据信息通过PDSCH RE进行传输。在接收端只有对PDSCH RE处进行信道估计之后,才能检测和解码接收的数据。若想得到PDSCH RE处的信道估计,一般首先要得到DMRS RE处的信道频率响应,然后通过插值的方法PDSCH RE处的频率响应值。

图1 资源网格RB与RE的概念图Fig.1 Concept diagram of resource grid RB and RE

在本文的系统模型中,信道信息被划分为时频网格。第t个OFDM符号中的第k个子载波发送信号可以表示为sk,t,则对应的接收端的信号yk,t可以表示为

yk,t=Hk,tsk,t+wk,t

(1)

式中:Hk,t表示的是OFDM系统中的第t个OFDM符号中的第k个子载波的信道频域响应;wk,t表示该载波上的加性高斯白噪声。对于信道的频率响应H,本文考虑的是时变信道模型,定义为

H=f(φ,φ,ω)

(2)

式中:φ表示的随机延迟剖面;φ表示的是随机生成的信道的延迟扩展;ω表示信道的多普勒频移。

在接收端,最小二乘算法[12]可以利用发送的已知DMRS导频参考信息和对应的接收到的信息,得到DMRS位置处的信道响应。LS信道估计算法可以确定信道响应:

(3)

(4)

Matlab的5G Toolbox工具箱提供了一种实用信道估计算法(Practical Channel Estimation)[13],本文将此算法简称为PCE算法。在工具箱中利用nrChannelEstimate函数进行PCE算法信道估计。该算法是在LS算法的基础上进行了改进:由于LS算法没有考虑信道中噪声的影响,在PCE算法中对信道冲激响应(Channel Impulse Response,CIR)进行去噪。PCE信道估计算法的具体步骤如下:

输入:接收端和发送端在DMRS位置处的信息。

步骤2 在频域和时域执行码域多路复用解扩。

步骤5 将CIR进行去噪处理。

步骤7 移除去噪后的信道响应中的多余子载波。

2 基于深度学习的信道估计

深度学习在通信系统中的应用成为现在研究的热点,信道估计问题可以用图像处理的相关算法进行处理[8-12]。在图像处理领域,将图像从低分辨率恢复成高分辨率的图片是一个经典问题,可以将该问题用数学公式表述为

(5)

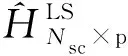

文献[8]提出了ChannelNet信道估计网络,具体的网络流程如图2所示。该网络是由一个图像超分辨率SRCNN网络和一个图像恢复网络DnCNN串联而成,文中将导频值看成是低分辨率图片作为网络的输入,将完整的信道响应视为需要恢复的完美图像作为网络的输出。

图2 ChannelNet信道估计流程[8]Fig.2 ChannelNet channel estimation flowchart[8]

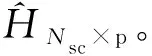

在文献[8]中,ChannelNet网络的信道估计性能虽与LMMSE算法相当,但该网络也存在很多不足,如SRCNN网络和DnCNN网络不是端到端的训练,而是分别进行训练,训练过程比较复杂而且ChannelNet网络共有23个卷积层,网络的规模庞大,对硬件资源要求较高。针对上述不足,本文对深度学习在信道估计中的应用做了进一步优化,并将其应用在5G NR系统的信道估计中。本文提出信道估计流程如图3所示,图中将信道信息进行了可视化。

图3 本文提出的信道估计架构Fig.3 The proposed channel estimation architecture

在接收端的一个时隙数据中,数据中只含有导频位置处的数据。利用LS算法得到导频位置处的信道信息,通过二维线性插值得到分辨率较低的信道矩阵信息,利用LS算法代替ChannelNet网络中的SRCNN网络获得低精度的信道估计值,然后将其输入到本文所提出的深度神经网络中来恢复出信道的真实信道频率响应,整个过程可以表示为

(6)

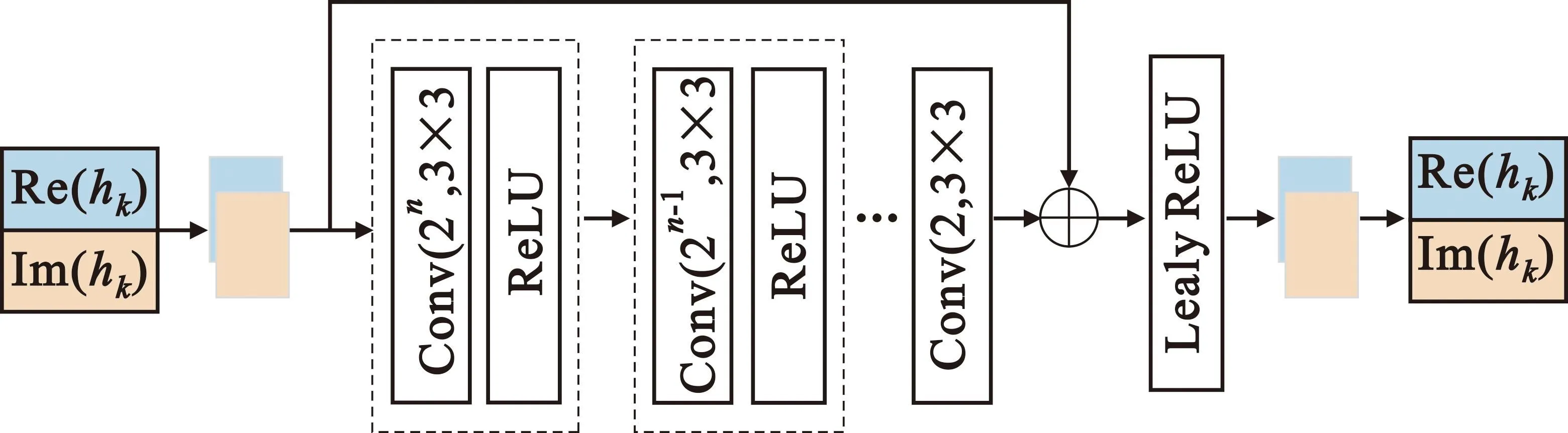

本文提出的ReCNet神经网络模型如图4所示。由于信道频率响应数据是复数形式,而现有的神经网络架构无法对复数进行处理,需要将信道响应的数据改变数据的维度,将复数的实部和虚部分开,形成两个通道的数据,然后将其输入到网络模型中。图4虚线框中的结构称为优化单元,在每一个优化单元中依次级联的是一个卷积层和激活层。本文的模型中使用N个优化单元。对于第n个优化单元来说,1≤n≤N,前一层的输出首先通过一个卷积滤波器数为2N-n的卷积层,此时使用的卷积核的大小为3×3。为了保证信道数据矩阵的长和宽在模型的输入和输出时保持一致,模型使用的填充值为1。在卷积层之后是激活层,使用ReLU激活函数(因为ReLU激活函数可以加快模型的收敛速度,同时也能克服梯度消失的问题)。由于信道数据既有正数也有复数,为保证数据不失真,在本模型中的最后一个优化单元中不使用激活函数层。在优化单元的后面,引入残差连接[14],将模型的输入直接传递到优化单元的最后一层,利用残差连接的方式可以有效避免由于多个非线性操作导致的梯度消失的问题。在通过加法器之后,将数据通过一个Leak ReLU层,最后将得到的数据改变维度即可得到经过模型优化后的信道的频率响应数据。

图4 ReCNet神经网络模型Fig.4 ReCNet neural network model

为了定义输入和输出之间的差异,此模型中使用所有训练样本的均方误差(Mean Square Error,MSE),可以表示为

(7)

3 系统仿真与结果分析

3.1 系统仿真

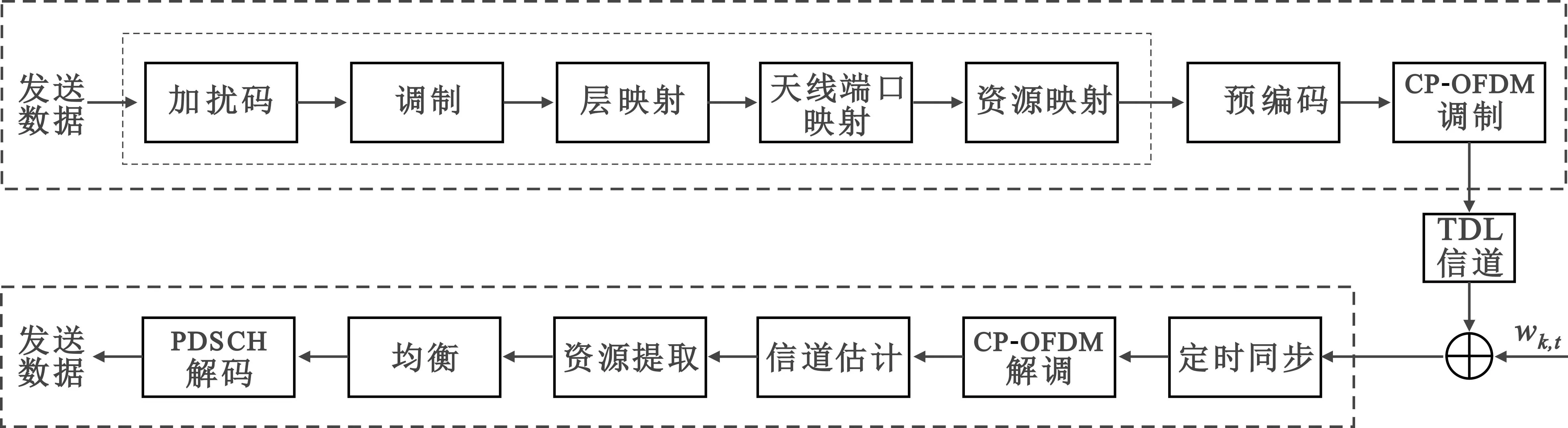

基于3GPP 5G NR标准生成波形和信道。系统仿真图如图5所示,利用Matlab2022a来搭建基于5G NR标准的SISO下行信道链路的仿真模型。PDSCH编码过程是生成资源网格,为了在用户设备(User Equipment,UE)和基站(Base Station,BS)之间共享数据,在此过程中将编码数据映射到PDSCH。设置系统模型的载波为3 GHz,在一个资源网格RB中的子载波的数量Nsc=12,子载波间隔设置为30 kHz,则每一个RB占用360 kHz的带宽。系统设置在一个子帧中有一个slot,在每一个slot中包含的OFDM符号数为Nsym=14。在第3和第12个OFDM符号中设置参考信号DMRS,具体分布如图1所示。与LTE标准不同,在5G NR的标准协议中,在一个slot中RB数量可以灵活设置。本文将资源RB的数量设置为NRB=51,由此可知在每一个slot中信道矩阵的大小为612×14的复数。

图5 系统仿真框图Fig.5 System simulation block diagram

PDSCH编码生成的网格经过预编码后利用快速傅里叶逆变换(Inverse Fast Fourier Transform,IFFT)进行OFDM调制。在OFDM调制中,为避免符号之间的多径干扰,插入保护间隔,即循环前缀(Cyclic Prefix,CP)。经过调制之后生成的波形信号通过信道模型。为不失一般性,本文考虑的是移动状态下的动态信道模型,模型使用抽头延迟线(Tapped Delay Line,TDL)信道,在TDL信道模型中共包含{‘TDL-A’,‘TDL-B’,‘TDL-C’,‘TDL-D’,‘TDL-E’},本系统的每一次运行时会随机使用其中一种的信道参数,信道延迟设置为随机生成[1,300]ns的数值,信道的多普勒频移设置为随机生成[5,400]Hz。在经过信道模型后,向信号中添加高斯白噪声wk,t。通过接收波形与DMRS相关来估计定时频偏,以便执行OFDM解调。经过解调之后,即可进行信道估计。

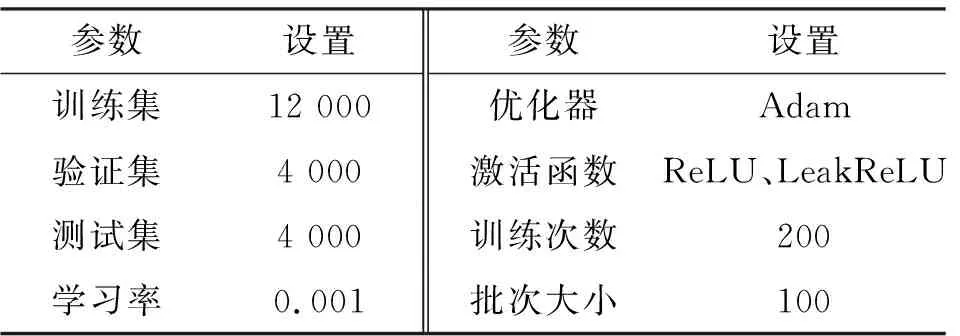

在模型的训练阶段,利用Pytorch深度学习架构搭建神经网络模型,训练模型的参数设置如表1所示。在本文的模型中,使用的优化单元个数N=7,即网络中有7个卷积层,在网络的训练测试过程中,对于信道模型的训练,仅使用25 dB的数据用于模型的训练,待训练模型收敛后,将模型参数保存,用于测试。

表1 训练参数设置Tab.1 Training parameter settings

3.2 不同信道估计算法性能分析

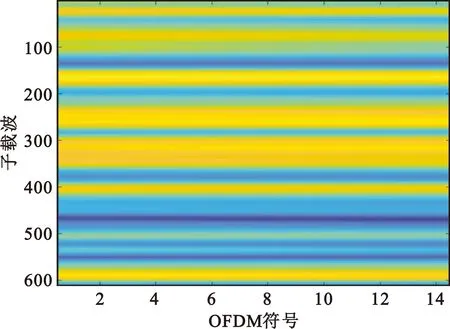

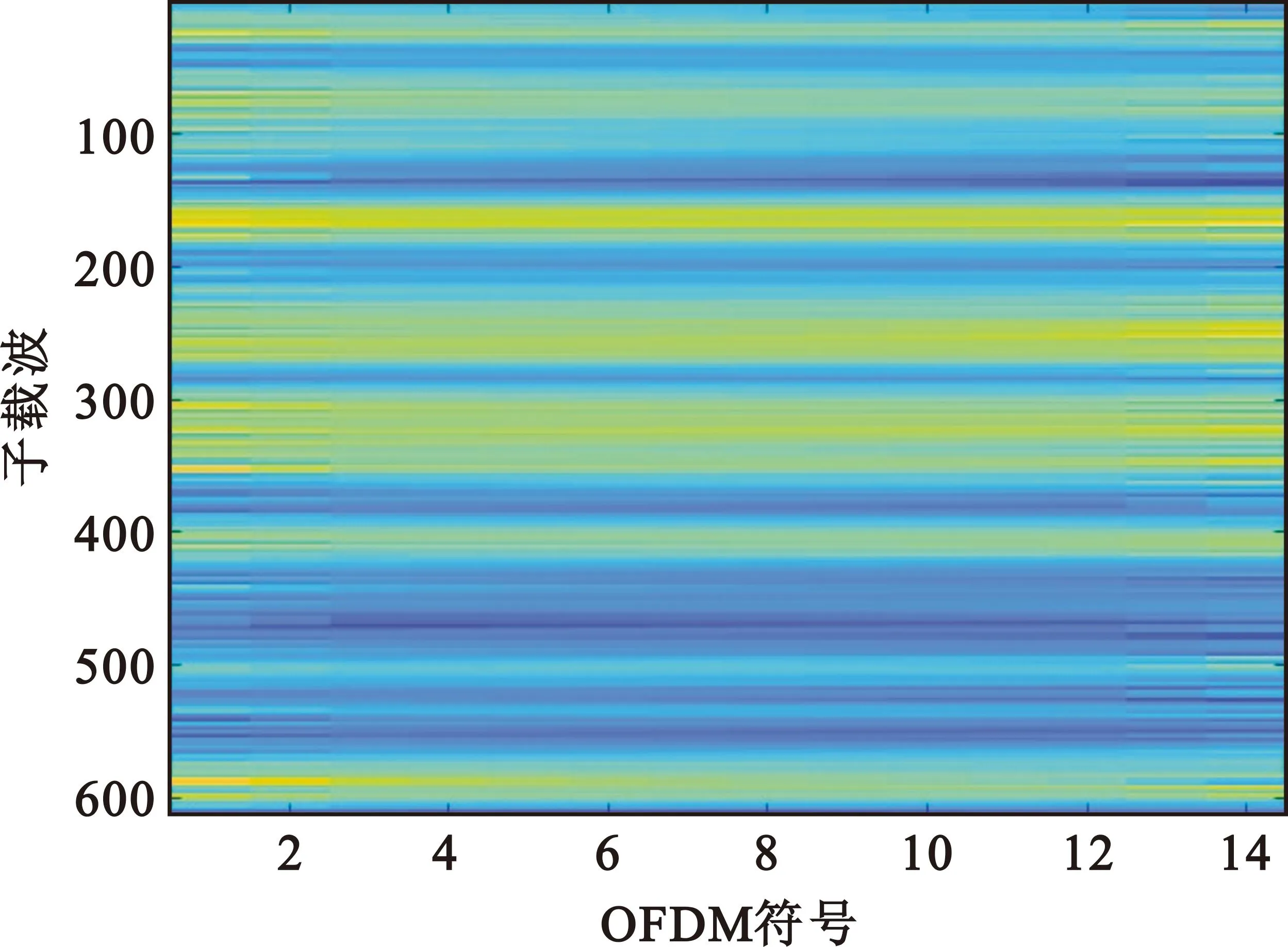

为了更直观地展示用图像处理的方法对信道估计的有效性,本文将信道估计结果进行可视化。在相同的条件下,随机采集信噪比为15 dB时的信道信息(包括接收的导频信息和真实的信道信息),然后利用上述不同的信道估计方法进行信道估计。图6展示的是经过可视化后的实际的信道信息图像。

图6 实际的信道可视化(15 dB)Fig.6 Actual channel visualization (15 dB)

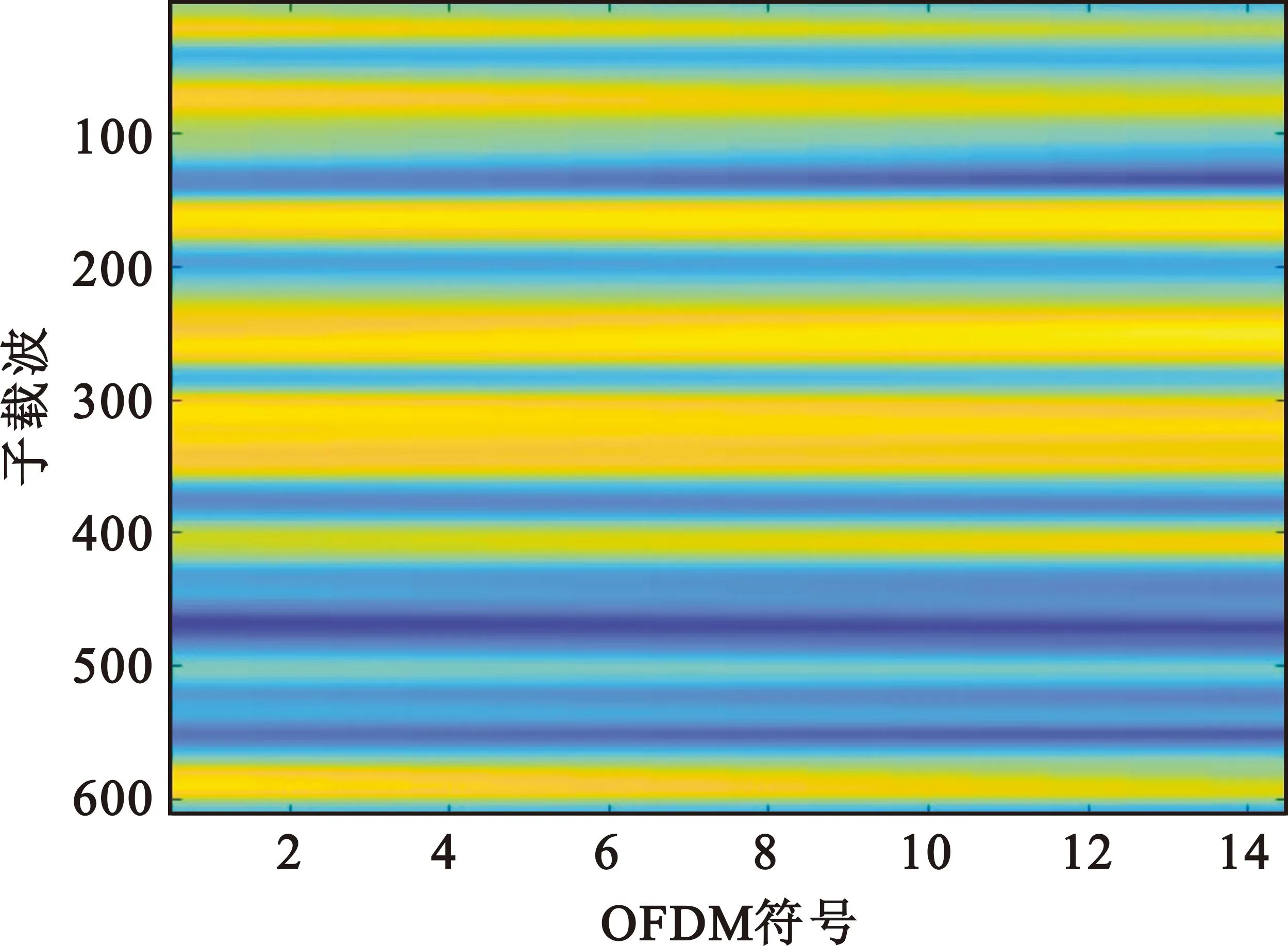

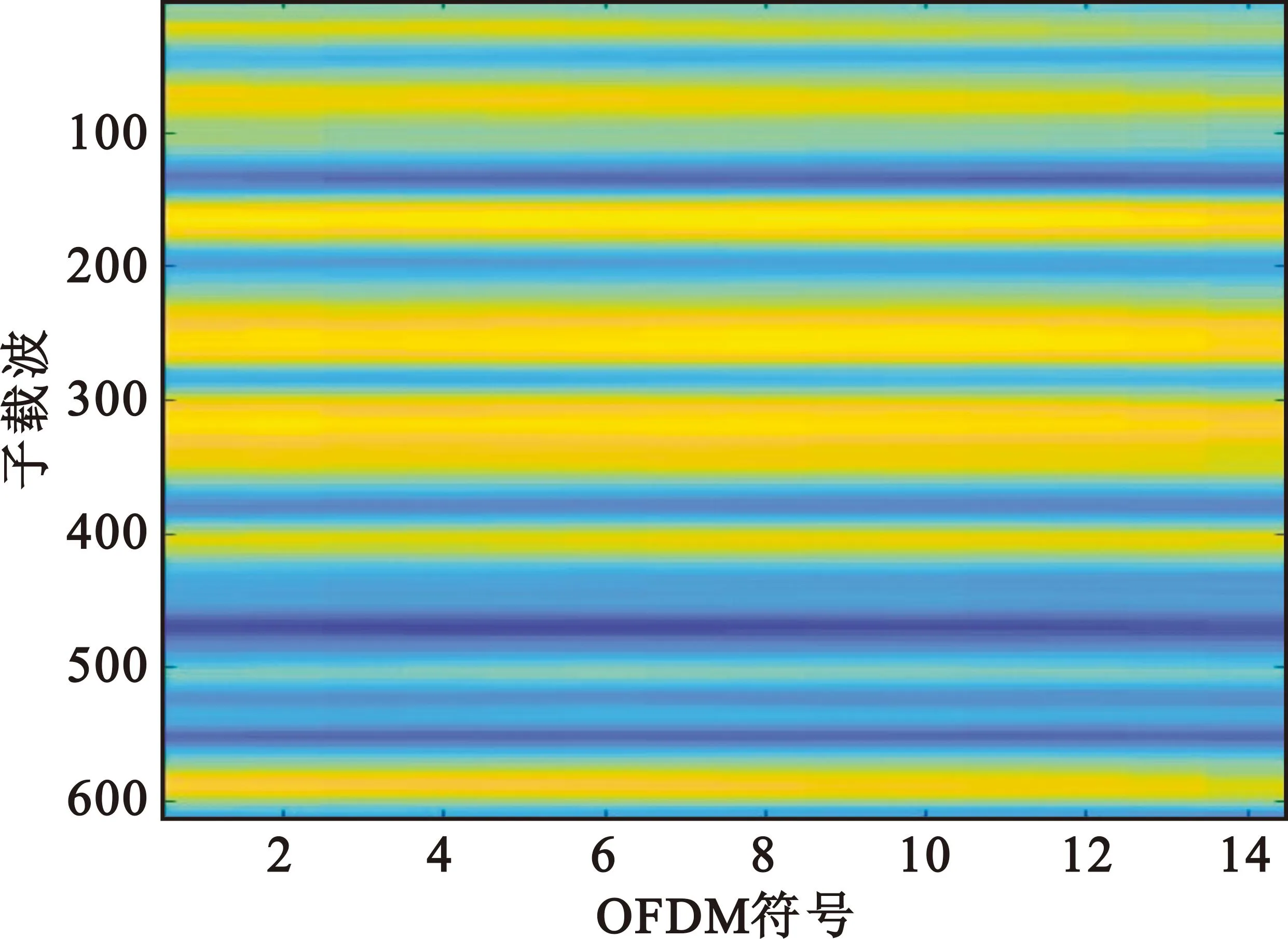

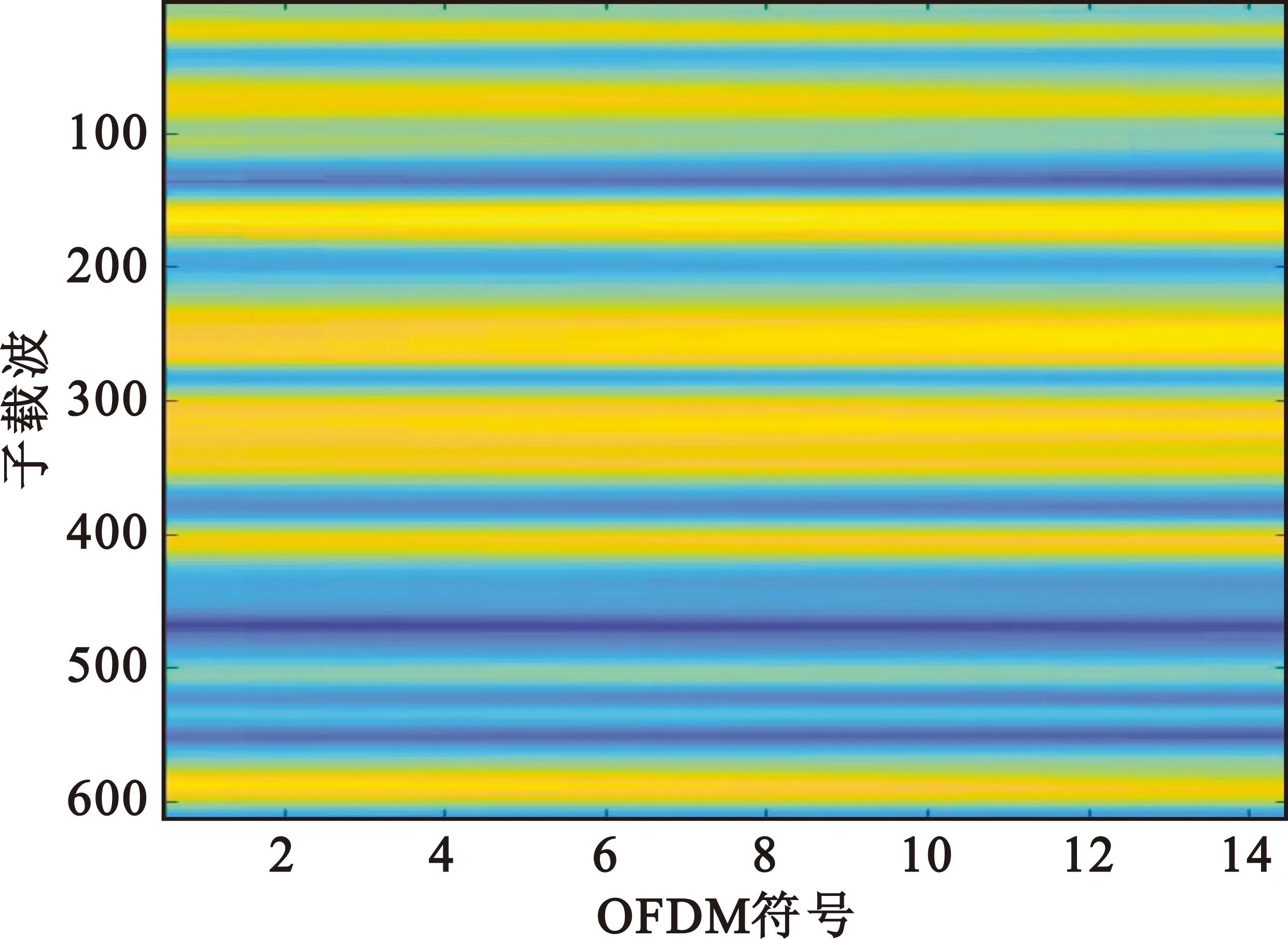

图7是经过信道估计后的可视化结果。与图6中的实际信道图像相比较,从直观的角度分析,LS算法预测的信道矩阵的失真严重,性能最差;含有去噪处理的PCE算法预测效果较LS算法有了较大的提高,但与实际信道图像相比,很多细节仍较为模糊;基于图像处理方法的ChannelNet算法和ReCNet算法的信道估计结果与实际的信道图像最接近。

(a)LS算法

(b)PCE算法

(c)ChannelNet 算法

(d)ReCNet算法图7 不同算法信道估计结果可视化Fig.7 Visualization of channel estimation results using different algorithms

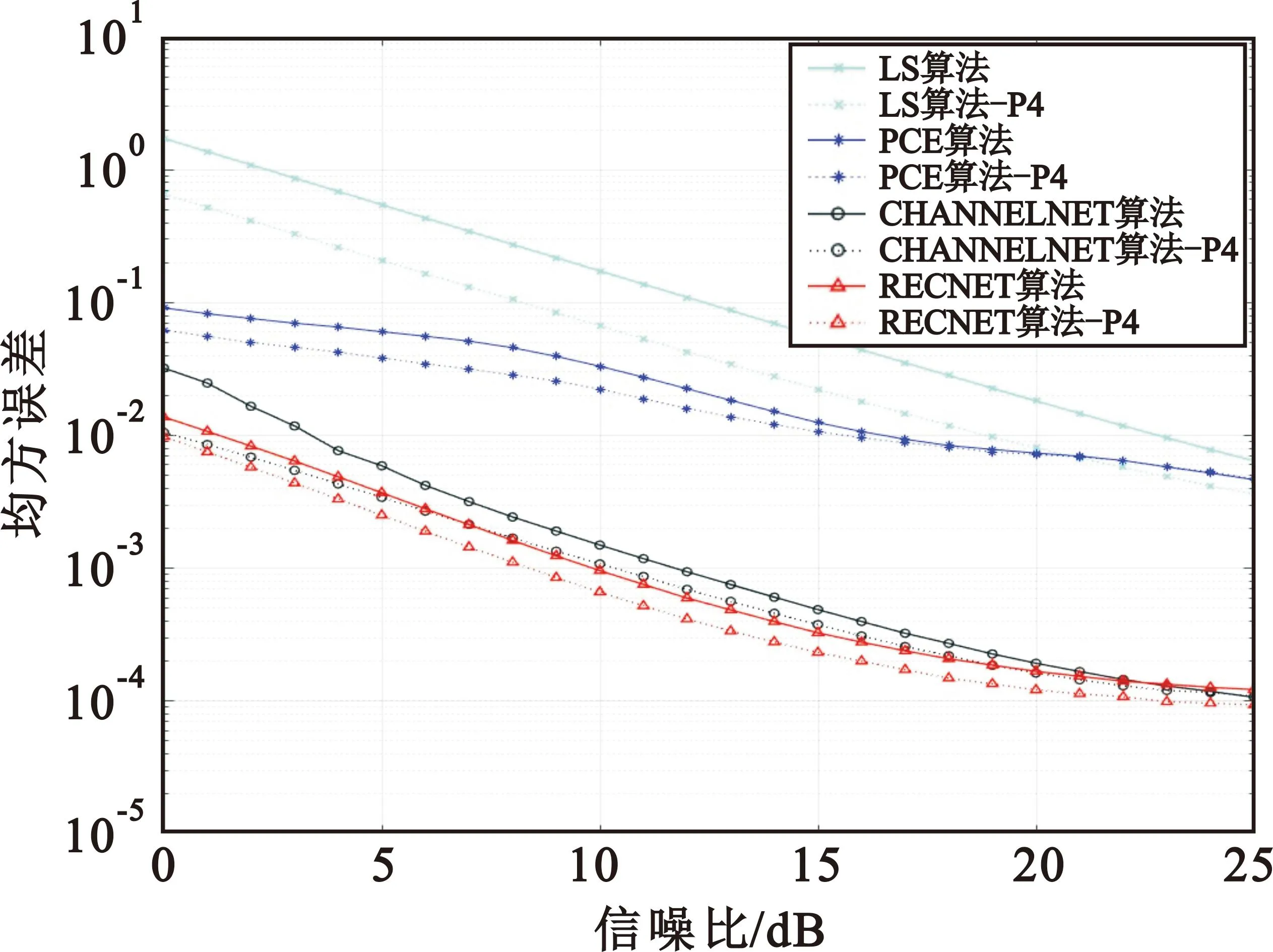

图8显示了本文所提的信道估计算法与传统信道估计LS、实际信道(PCE)算法和ChannelNet信道估计算法的性能对比,其中实线图表示的是按图1中的方式插入导频的情况。从图8中可知,LS算法的性能最差,本文所提出的ReCNet算法性能最好。LS算法由于本身没有考虑信道中噪声的影响,只是进行线性插值,故性能最差。PCE算法进行了去噪处理,所以信道估计性能优于LS算法。而基于深度学习的信道估计算法利用大量的信道先验信息进行训练,可以有效地拟合信道信息,故性能最好。在低信噪比时,本文所提算法性能优于ChannelNet算法;在信噪比为5 dB时,本文所提出的算法性能较ChannelNet算法提高了2 dB;在信噪比较大时,两者性能接近一致。

图8 不同信道估计方法的均方误差结果Fig.8 Mean squared error results of different channel estimation methods

3.3 导频数量对信道估计性能的影响

在信道估计的过程中导频至关重要。一般来说,加入的导频数量越多,信道估计的性能就会越好,但导频的加入会占用频谱资源,造成频谱资源的浪费。在本小节中,将每个RB中的导频数量在图1的基础上增加1倍,在第1个和第14个OFDM符号中增加导频,即在每个RB中有4个OFDM符号中含有导频,仿真结果如图8中的虚线所示。从图8中可知,随着导频数量的增加时,所有的信道估计算法的性能都有所提升,本文所提算法性能最优。其中,LS算法的信道估计性能的改变幅度最大,ChannelNet算法和本文所提算法性能改变较小且保持较好的信道估计性能;在信噪比为5 dB时,本文所提算法在增加导频时较正常导频改变了1 dB,相同情况下LS算法改变了4 dB,这表明传统信道估计算法性能受导频数目的影响更大,本文所提信道估计算法拥有更强的鲁棒性。

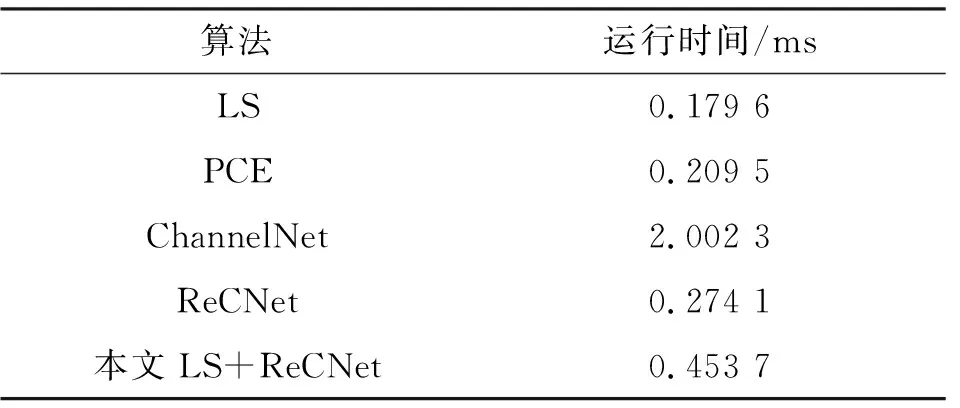

3.4 算法的时间复杂度

在相同条件下,以预测一个RB的信道信息为基本单位,测试运行将本文所提算法、ChannelNet算法、LS算法以及PCE算法所需时间,具体结果如表2所示。

表2 不同算法的运行时间Tab.2 The running time of different algorithms

从表2中可知,在所有的算法中,LS算法所需的时间最短,ChannelNet算法用时最长,主要原因是在LS算法主要的计算是线性插值,计算量较小,而在ChannelNet算法中有23层卷积神经网络,模型的参数较多,所需要计算量较多。本文提出的LS+ReCNet信道估计算法较ChannelNet算法用时减少了77.34%。

4 结 论

近年来,深度学习技术在通信系统中的应用得到了越来越受到了研究者的关注。受前人研究成果[5-12]的启发,本文将通信系统中的信道估计问题看作深度学习中图像处理问题,提出了ReCNet网络用于信道矩阵的恢复。通过仿真5G NR系统采集信道数据信息来评估本文所提算法和文献[8]中的ChannelNet算法以及传统信道估计算法的性能,结果表明本文所提算法可以提高信道估计的精度并拥有较强的鲁棒性,且较ChannelNet算法拥有更快的运算速度。