基于深度学习分类模型的4种果树物候期识别

钟丹 李宗南 王思 黄平 邱霞 蒋怡

摘要:为实现数字果园的机器视觉系统快速准确识别果树关键物候期,采集四川地区苹果、杧果、石榴、柑橘4种果树4个物候期的图像15 000幅,按6∶2∶2的比例随机划分训练、验证和测试数据集,训练VGG16、ResNet50、MobileNetV2及Swin Transformer 4个深度学习图像分类模型,评测不同模型的精度和性能。结果表明,各模型识别物候期精度分别为98.9%、99.3%、99.7%、99.8%,其中杧果成熟期的识别误差较大,精度分别为96.7%、98.2%、99.0%、99.5%;模型识别测试集图像的计算量(GFLOPs)分别为15.50、4.12、0.32、15.14,识别单张图像耗时分别为3.00ms、2.33ms、3.00ms、4.67ms。该结果可为果园嵌入式设备、服务器端的机器视觉系统选择模型提供参考。

关键词:果树;物候期;深度学习;图像分类;注意力机制

中图分类号:S66: TP391.41 文献标识码:A 文章编号:20955553 (2023) 11014807

Phenological phase identification of four fruit trees based on deep learning classification model

Zhong Dan, Li Zongnan, Wang Si, Huang Ping, Qiu Xia, Jiang Yi

(Institute of Remote Sensing and Digital Agriculture, Sichuan Academy of Agricultural Sciences

(Chengdu Agricultural Remote Sensing Center), Chengdu, 610066, China)

Abstract:In order to achieve rapid and accurate identification of key phenological periods of fruit trees using machine vision system in digital orchards, 15 000 images were collected from four phenological periods of four fruit trees such as apple, mango, pomegranate and citrus in Sichuan, and the training, validation and test data sets were randomly divided in a ratio of 6∶2∶2. Four deep learning classification models such as VGG16, ResNet50, MobileNetV2 and Swin Transformer were trained to evaluate the accuracy and performance of different models. The results showed that the accuracy of each model was 98.9%, 99.3%, 99.7%, 99.8%, respectively. The error of identifying phenology in maturation stage of mango was 96.7%, 98.2%, 99.0% and 99.5%, respectively. The computational complexity (GFLOPs) for model recognition on the test data were 15.50, 4.12, 0.32, and 15.14, respectively. The single image test was 3.00 ms, 2.33 ms and 3.00 ms, 4.67 ms, respectively. The results can provide reference for the selection model of machine vision system for orchard server-side and embedded edge devices.

Keywords:fruit tree; phenological phase; deep learning; image classification; self-attention mechanism

0引言

果樹物候期信息是果树生长发育变化的重要指示器,是进行果树标准化栽培管理的重要参考信息之一,果农据此及时开展果树灌溉、施肥、整形及施药等管理,以追求果树最优的水果产量和品质。果树物候期受丘陵山区地形、微气候条件、果树品种、栽培管理等因素影响而表现出提前或推迟[12],在数字化管理的果园中利用机器设备采集物候期信息比人工观测法更为标准规范且便于接入果园数字管理系统。基于感知设备采集的信息估测物候期的方法包括积温法、遥感指数法和图像识别法3种。积温是反映植物生长期间物候变化的重要指标[34],其模型稳定性受作物品种、下限基点温度等影响[56]。遥感指数法是基于长时序遥感指数与植物叶片生长衰落、花开花谢的关系识别物候期,借助影像覆盖面广的优势,该方法已成为获取宏观尺度物候期重要方法[710]。基于图像识别提取物候信息主要包括长时序的指数法[11]和深度学习识别法[1214],长时序指数法通过固定点位的物候相机采集图像,然后计算感兴趣区的相对绿度指数、相对蓝度指数、相对红度指数、红绿指数作为植被生长曲线指标,根据曲线特征识别物候期,常用于生态群落尺度的物候期识别;深度学习识别法快速准确地从图像中提取关键特征,适用于更精细尺度的物候期识别[1516]。

在果树机器视觉领域,为满足嵌入式设备实时检测分析和云计算服务的需要已开展了轻量级模型和大参数量模型的研究。张鹏程等[17]改进MobileNetV2算法并以边缘计算的形式部署在手机上智能识别不同种类的柑橘虫害。王卓等[18]为实现苹果采摘机器人实时识别果实的需求,提出改进轻量化算法YOLOv4-CA。Ji等[19]为实现拣选机器人快速识别果实等级,测试基于YOLOX-Tiny的轻量级苹果探测器算法并部署于Jetson Nano嵌入式平台。安小松等[20]使用CNN-Transformer算法跟踪预测柑橘运输路线可与机器手结合实现柑橘实时分类。张善文等[21]基于物联网和深度卷积神经网络(DCNN)对冬枣病害识别,能对物联网采集的冬枣大规模视频病害图像进行识别。孙文杰等[22]基于卷积神经网络(CNN)和双向长短时记忆网络(BiLSTM)提出VGGNet-BiLSTM算法模型识别桃树叶部病害,具有较高的识别准确率。Zhang等[23]针对病害部位颜色和质地变化对病害检测影响大的问题,提出基于深度多尺度的双通道卷积神经网络(DMCNN)的苹果病害检测物联网系统,提高了苹果病害检测率。刘凯[24]基于YOLOv5模型结合注意力机制改进得到SK-YOLOv5模型,设计“云-边-端”技术模式的物联网平台网站为载体,对苹果园进行墒情监测、病害识别和果实计数等高效管理。目前,在数字果园系统集成中基于深度学习图像识别法主要集中在果树的病虫害检测、果实采摘和分类管理等方面,在果树物候期识别领域的研究应用相对较少。深度学习图像识别法可以高效处理图像数据,提取物候信息,在果树物候期自动识别领域具有较高的应用潜力。

针对数字果园系统中嵌入式设备和服务器快速准确识别果树物候期的需求,在四川多地采集苹果、杧果、石榴、柑橘等果树图像,建立苹果、杧果、石榴、柑橘4种果树的4个物候期图像数据集,选择具有不同参数量的深度学习模型VGG16、ResNet50、MobileNetV2、Swin Transformer等进行模型训练和性能、精度验证,并比较不同模型识别果树物候期图像的精度和效率,为嵌入式设备、服务器等选择合适的果树物候期识别模型提供参考。

1数据与试验

1.1数据采集与预处理

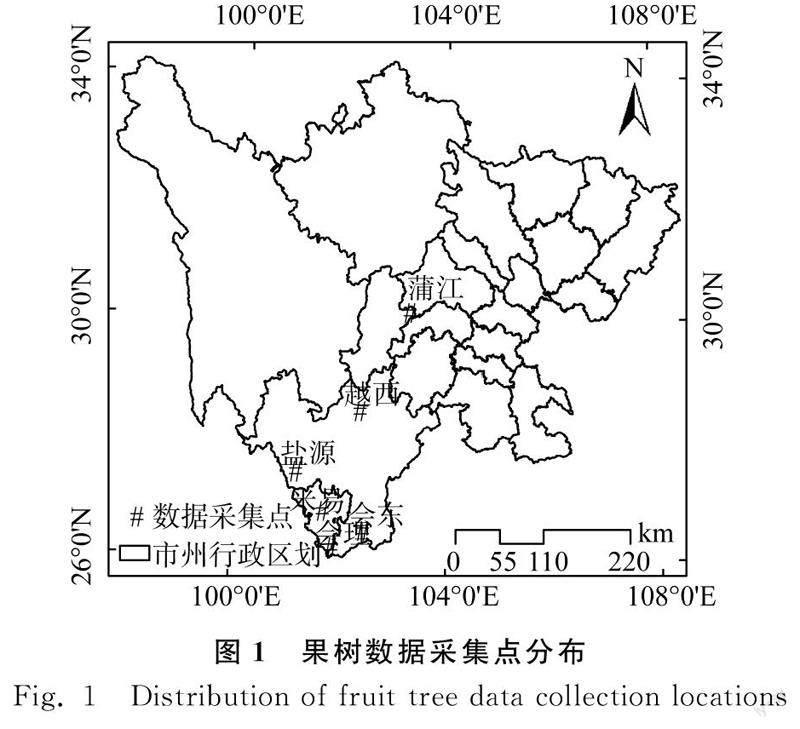

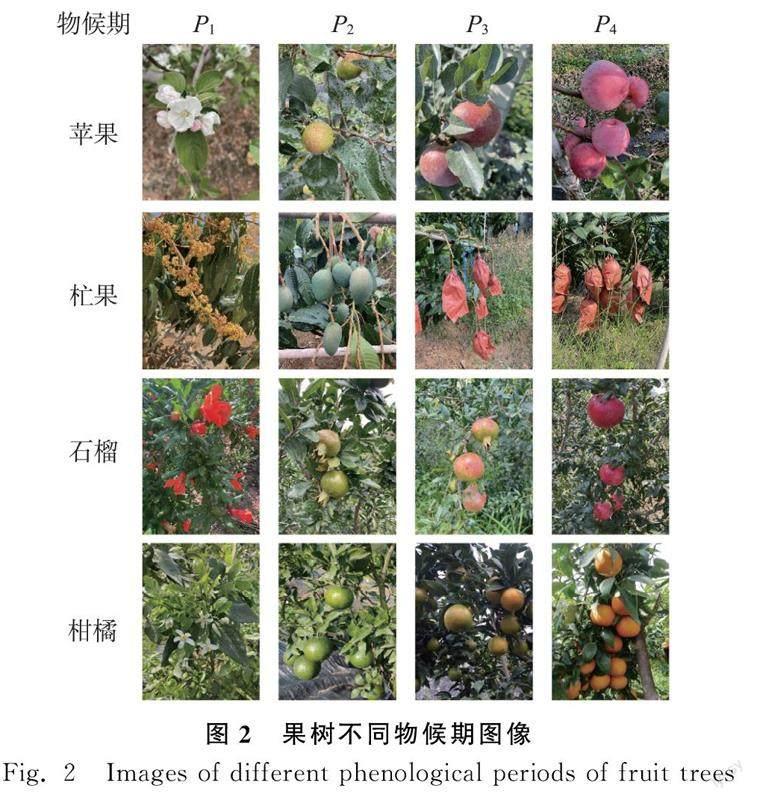

该研究以苹果、杧果、石榴、柑橘等果树花期(P1)、幼果期(P2)、果实膨大期(P3)、果实成熟期(P4)等关键物候期分类为目标。于2021年11月—2022年12月分别在四川省的越西县和盐源县、米易县和会东县、会理市、蒲江市等多地(图1)使用1 200万像素的数码相机多角度采集苹果、杧果、石榴、柑橘图像共15 000张作为数据集。并将图像数据按6∶2∶2的比例随机分为训练集(9 000张)、验证集(3 000张)和测试数据集(3 000张),果树不同时期图像样本如图2所示。

P3时期的苹果和石榴图像在颜色和形状上有较多相似;P3和P4时期的杧果图像均套袋且背景有相似杂草。为保证数据训练的网络能够具有很好的鲁棒性,训练集和验证集用于调整模型参数,测试集评估模型在最佳参数下的性能。

为简化数据量计算,加快网络模型训练的速度,在满足计算机提取图像特征的前提下,将采集的图像数据预处理为360像素×480像素的图像。

1.2试验设计

该研究通过参数量分别为134.32M、25.56M、2.24M、86.76M的VGG16、ResNet50、MobileNet V2和Swin Transformer等神经网络模型对不同物候期图像分类来实现果树物候期识别。选择常用的VGG16和ResNet50作为参考模型,轻量级的代表MobileNet V2和加入注意力机制的Swin Transformer作為试验模型对采集到的各期图像进行分类以实现物候期识别,以图像分类评价指标作为果树物候期识别指标。

1.2.1模型运行环境

运行环境的硬件配置主要包括R740服务器、64 GB内存、Tesla V100GPU(显存16GB、CUDA核5 120个)。软件配置主要为Ubuntu18.04操作系统、CUDA11.1、深度学习框架为Pytorch1.8。

1.2.2训练参数设置

设置图像分类模型基本参数,批处理大小bitch size为32、image size为224,模型训练步骤如下。

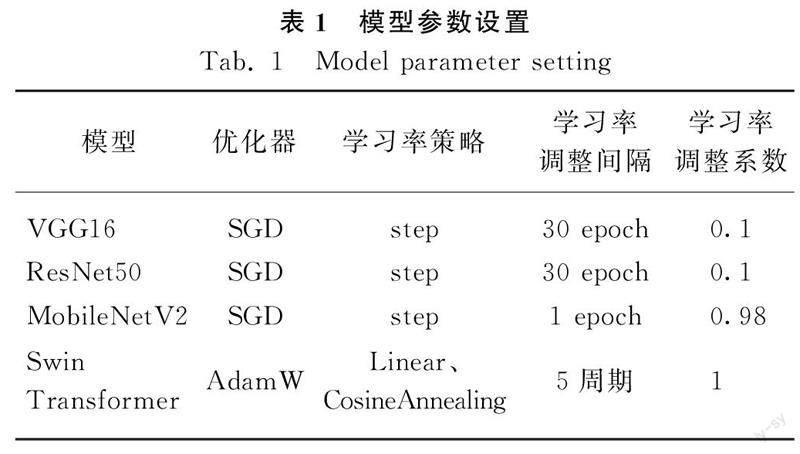

1) 构建VGG16、ResNet50、MobileNetV2、Swin Transformer网络框架,表1为模型基本参数设置。VGG16、ResNet50和MobileNetV2的学习率采用随机梯度下降算法。Swin Transformer采用带权重衰减机制的自适应算法,对学习率先预热再下降。

2) 分别设置初始学习率为0.000 01、0.000 1、0.001、0.01,epoch为100,对预处理后训练集和验证集进行迭代训练,以训练集损失函数收敛情况确定模型最佳学习率。Swin Transformer、MobileNetV2、ResNet50、VGG16模型在其他参数不变的情况下,采用不同学习率进行反复训练,得到训练集损失值如图3所示。

Swin Transformer 模型学习率为0.000 01和0.000 1时均迭代到15次后损失值稳定在1.3左右,学习率为0.001和0. 01时不收敛。MobileNetV2模型学习率为0.000 01时不收敛;在0.000 1时,迭代到40次后损失值稳定在1.0以下;学习率为0.001和0.01时,均迭代到20次后损失值保持在0.2以下。ResNet50模型均迭代到30次左右收敛,稳定损失值与学习率成反比,学习率为0.01时迭代到30次后损失值保持在0.2左右。VGG16模型在学习率为0.000 01和0.000 1时不收敛;学习率为0.001,迭代到30次后损失值降至0.5左右;学习率为 0.01,迭代到30次时损失值稳定在0.2左右。针对该试验数据,VGG16、ResNet50、MobileNetV2、模型最佳学习率为0.01,Swin Transformer模型的较优学习率为0.000 1。

3) 不同模型分别设置最佳学习率对测试集进行测试,评估4个模型对果树物候期识别的效果。

1.2.3试验结果评价

采用图像分类精度和分类效率评价果树物候期识别效果。果树物候期识别精度以平均精度(Average Precision,AP)表示,具体计算公式如式(1)所示。

AP =2×TP/2×FP +FN +FP×100%(1)

式中: TP ———模型分类出正确的物候期图像数;

FP ———模型分类出错误的物候期图像数;

FN ———模型未分类出的物候期图像数。

图像分类效率用浮点运算数即计算量(Floatingpoint operations, FLOPs)和分类一张图像所需时长表示。FLOPs是浮点运算次数,可以用来衡量模型复杂度,常用每秒十亿次的浮点运算(GFLOPs)表示。

2结果与分析

2.1物候期图像分类精度

VGG16、ResNet50、MobileNetV2、Swin Transformer各模型均能较准确地对4种果树物候期图像分类(表2),总体分类平均精度分别为 98.9%、99.3%、99.7%、99.8%。杧果P4期的图像分类精度最差,各模型分别为96.7%、98.2%、99.0%、99.5%,可知MobileNetV2和Swin Transformer模型對较难识别的杧果P4期图像有较好地分类效果。

试验发现,P3期的苹果图像易错分类为P3或者P4期的石榴图像;杧果P3和P4期图像出现互相错分类情况(图4)。模型的分类混淆矩阵如图5所示。由图5可知,VGG16、ResNet50、MobileNetV2和Swin Transformer模型将P3期的苹果图像判别为P3或者P4期的石榴图像数分别为5、0、0、1;P3期杧果判别为P4期杧果的图像数为4、1、1、1;P4期杧果判别为P3期杧果的图像数为5、2、1、1。与参考模型相比,MobileNetV2和Swin Transformer对4类果树物候期图像的错误分类数更少。

2.2物候期图像分类效率

不同模型测试参数如表3所示,VGG16、ResNet50、MobileNetV2模型随着参数量减少,模型总计算量逐渐减少,其中MobileNetV2计算量出现大幅减少;VGG16、ResNet50、MobileNetV2模型单张图像分类时间相近,分别为3ms、2.33ms、3.00ms。Swin Transformer加入自注意力机制增加了计算复杂度,用时相应增加,单张图像分类时间为4.67ms,但也能满足实际生产中对物候期识别的实用性要求。

综上所述,MobileNetV2和Swin Transformer模型能够有效提升柑橘、石榴、杧果、苹果4种果树物候期图像的分类精度,在分类效率方面也能够较好地满足实际生产的需求。MobileNetV2在减小大量参数的同时能够保持较高的精度,是4类果树物候期识别效果较好的轻量型模型。Swin Transformer引入注意力机制可对有较多相似特征的图像进行细微差别区分,达到最高分类精度,但是其参数量较大,对设备内存要求较高。

3讨论

3.1应用图像识别果树物候期的方法选择

基于深度学习图像识别物候期的研究主要采用目标检测法、多模态特征法和图像分类法。目标检测需要对图像中局部细粒度特征标注,通过检测图像数据中的芽、叶、花、果等器官来识别物候期。朱永宁等[25]采用卷积神经网络(Faster R-CNN)检测枸杞花和果实,识别枸杞花期和果期。许增等[15]使用改进的Minor-YOLOv3-dense模型检测识别幼果期、膨大期和成熟期的苹果用以判断苹果物候期。多模态特征法主要就是通过图像与文本特征结合识别物候期,以提高物候识别精度,陈果[26]设计MultiModalNet多模态网络模型,融合从图像数据和气象数据得到的多模态特征,实现对白茶物候期的识别。图像分类法不对图像局部细粒度特征做标签,基于图像整体特征进行分类,崔晓晖等[27]基于 ResNet50残差神经网络引入了注意力机制,识别林木关键物候期。综合前人研究结果,利用图像分类法识别特征差别大的果树物候期可行性较高。该研究采用图像分类法识别4种果树的4个物候期,由于4个物候期的特征差别大且数据质量稳定,取得了较高的识别精度,能满足果树物候期识别要求。

3.2果树物候期识别的后续工作

该研究以苹果、杧果、石榴、柑橘4种果树物候期图像为研究对象,收集15 000张图片并构建了4类果树4个完整物候期图像数据集,该数据具有质量稳定、图像特征差异明显等特点。在服务器上训练经典图像分类模型VGG16、ResNet50、MobileNetV2和Swin Transformer识别果树物候期图像,对比模型训练性能和精度,优选Swin Transformer和MobileNetV2作为果园机器视觉系统集成模型。但是未在嵌入式端对优选模型进行测试,后续将测试其在移动硬件平台上的实际应用效果。

模型训练时,使用稳定的高质量数据训练模型,模型可能会过度依赖训练数据导致实际应用中表现不佳,后续将采集多样性数据测试模型的抗干扰性和泛化能力。测试发现P3时期的苹果和石榴易出现错误分类,为避免具有相似特征的不同种类果树的物候期误判,后续考虑按不同种类果树训练物候期识别模型。

研究结果仅对苹果、杧果、石榴、柑橘4类果树的4个物候期识别试验得出,需进一步在多种类果树更小时间粒度的物候期识别上测试以得到实用性更强的结果。后续考虑定点安置延时相机采集更加规范统一的时序图像,开展深度学习模型识别特征相似的果树时序物候图像的研究,并与物联网气象数据、专家文本信息等进行多模态特征融合以提高更小时间粒度的果树物候期识别精度。

4结论

该研究使用不同参数量模型VGG16、ResNet50、MobileNetV2和Swin Transformer对苹果、杧果、石榴、柑橘4种果树的4个物候期进行自动识别,评测不同模型的精度和性能,为果园嵌入式设备、服务器端的机器视觉系统选择模型提供参考。

1) 通过数据集测试各模型均能较准确地识别4种果树的物候期,总体平均精度分别为 98.9%、99.3%、99.7%、99.8%;在错误分类较多的杧果P4期,各模型分别为96.7%、98.2%、99.0%、99.5%,可知MobileNetV2和Swin Transformer模型对4类果树物候期图像有较高的分类精度,满足果园机器视觉系统对集成模型精度的要求。

2) VGG16、ResNet50、MobileNetV2、Swin Transformer模型对测试集单张图像测试时间分别为3ms、2.33ms、3.00ms、4.67ms,均能满足果树物候期识别的应用要求。综上,Swin Transformer分类精度最高,但是参数量较大,对设备内存要求较高,可作为果园机器视觉系统服务器端模型;MobileNetV2作为轻量模型在减小大量参数的同时能够保持较高的精度,可作为嵌入式设备端模型。

参考文献

[1]Jiang L L, Wang S P, Meng F D, et al. Relatively stable response of fruiting stage to warming and cooling relative to other phenological events [J]. Ecology, 2016, 97(8): 1961-1969.

[2]李婷婷, 郭增长, 马超. 中国第二、三级阶梯地形过渡带山前植被物候时空变化探析[J]. 地理研究, 2022, 41(11): 3000-3020.Li Tingting, Guo Zengzhang, Ma Chao. Spatiotemporal changes of piedmont phenology in the transitional zone between the second and third steps, China [J]. Geographical Research, 2022, 41(11): 3000-3020.

[3]周祎鳴, 张莹, 田晓华, 等. 基于积温的文冠果开花物候期预测模型的构建[J]. 北京林业大学学报, 2019, 41(6): 62-74.Zhou Yiming, Zhang Ying, TianXiaohua, et al. Establishment of the flowering phenological model of Xanthoceras sorbifolium based on accumulated temperature [J]. Journal of Beijing Forestry University, 2019, 41(6): 62-74.

[4]胡园春, 安广池, 张越, 等. 基于积温的枣庄地区石榴始花期预测模型初探[J]. 山东农业大学学报, 2021, 52(4): 567-570.Hu Yuanchun, An Guangchi, Zhang Yue, et al. Preliminary study on prediction model of pomegranate flowering date in Zaozhuang city based on accumulated temperature [J]. Journal of Shandong Agricultural University, 2021, 52(4): 567-570.

[5]栾青, 郭建平, 马雅丽, 等. 基于线性生长假设的作物积温模型稳定性比较[J]. 中国农业气象, 2020, 41(11): 695-706.Luan Qing, Guo Jianping, Ma Yali, et al. Comparison of models stability about integrated temperature based on linear hypotheses [J]. Chinese Journal of Agrometeorology, 2020, 41(11): 695-706.

[6]姜会飞, 郭勇, 张玉莹, 等. 不同下限基点温度对积温模型模拟效果的影响[J]. 中国农业大学学报, 2018, 23(5): 131-141.Jiang Huifei, Guo Yong, Zhang Yuying, et al. Impact of base temperature on the growing degree-day and simulation effect of GDD model [J]. Journal of China Agricultural University, 2018, 23(5): 131-141.

[7]Wei J, Li Z, Peng Y, et al. MODIS Collection 6.1 aerosol optical depth products over land and ocean: Validation and comparison [J]. Atmospheric Environment, 2019, 201: 428-440.

[8]Zhang X, Liu L, Liu Y, et al. Generation and evaluation of the VIIRS land surface phenology product [J]. Remote Sensing of Environment, 2018, 216: 212-229.

[9]王敏钰, 罗毅, 张正阳, 等. 植被物候参数遥感提取与验证方法研究进展[J]. 遥感学报, 2022, 26(3): 431-455.Wang Minyu, Luo Yi, Zhang Zhengyang, et al. Recent advances in remote sensing of vegetation phenology: Retrieval algorithm and validation strategy [J]. National Remote Sensing Bulletin, 2022, 26(3): 431-455.

[10]Ikasari I H, Ayumi V, Fanany M I, et al. Multiple regularizations deep learning for paddy growth stages classification from LANDSAT-8 [C]. 2016 International Conference on Advanced Computer Science and Information Systems (ICACSIS). IEEE, 2016: 512-517.

[11]周玉科. 基于数码照片的植被物候提取多方法比较研究[J]. 地理科学进展, 2018, 37(8): 1031-1044.Zhou Yuke. Comparative study of vegetation phenology extraction methods based on digital images [J]. Progress in Geography, 2018, 37(8): 1031-1044.

[12]Le Cun Y, Boser B, Denker J S, et al. Backpropagation applied to handwritten zip code recognition [J]. Neural computation, 1989, 1(4): 541-551.

[13]Kamilaris A, Prenafeta-Boldú F X. Deep learning in agriculture: A survey [J]. Computers and Electronics in Agriculture, 2018, 147: 70-90.

[14]Richardson A D, Hufkens K, Milliman T, et al. Tracking vegetation phenology across diverse North American biomes using PhenoCam imagery [J]. Scientific Data, 2018, 5(1): 1-24.

[15]許增, 王志伟, 胡桃花, 等. 改进的轻量级YOLO在苹果物候期自动观测中的研究[J]. 计算机工程与设计, 2021, 42(12): 3478-3484.Xu Zeng, Wang Zhiwei, Hu Taohua, et al. Improved lightweight YOLO in automatic observation of apple phenology [J]. Computer Engineering and Design, 2021, 42(12): 3478-3484.

[16]Wang X A, Tang J, Whitty M. DeepPhenology: Estimation of apple flower phenology distributions based on deep learning [J]. Computers and Electronics in Agriculture, 2021, 185: 106123.

[17]张鹏程, 余勇华, 陈传武, 等. 基于改进MobileNetV2的柑橘害虫分类识别方法[J]. 华中农业大学学报, 2023(3): 161-168.Zhang Pengcheng, Yu Yonghua, Chen Chuanwu, et al. A classification and recognition method for citrus insect pests based on improved MobileNetV2 [J]. Journal of Huazhong Agricultural University, 2023(3): 161-168.

[18]王卓, 王健, 王枭雄, 等. 基于改进YOLO v4的自然环境苹果轻量级检测方法[J]. 农业机械学报, 2022, 53(8): 294-302.Wang Zhuo, Wang Jian, Wang Xiaoxiong, et al. Lightweight real-time apple detection method based on improved YOLO v4 [J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(8): 294-302.

[19]Ji W, Pan Y, Xu B, et al. A real-time apple targets detection method for picking robot based on Shufflenetv2-YOLOX [J]. Agriculture, 2022, 12(6): 856.

[20]安小松, 宋竹平, 梁千月, 等. 基于CNN-Transformer的视觉缺陷柑橘分选方法[J]. 华中农业大学学报, 2022, 41(4): 158-169.An Xiaosong, Song Zhuping, Liang Qianyue, et al. A CNN-Transformer based method for sorting citrus with visual defects [J]. Journal of Huazhong Agricultural University, 2022, 41(4): 158-169.

[21]張善文, 黄文准, 尤著宏. 基于物联网和深度卷积神经网络的冬枣病害识别方法[J]. 浙江农业学报, 2017, 29(11): 1868-1874.Zhang Shanwen, Huang Wenzhun, You Zhuhong. Recognition method of winter jujube diseases based on Internet of Things and deep convolutional neural network [J]. Acta Agriculturae Zhejiangensis, 2017, 29(11): 1868-1874.

[22]孙文杰, 牟少敏, 董萌萍, 等. 基于卷积循环神经网络的桃树叶部病害图像识别[J]. 山东农业大学学报(自然科学版), 2020, 51(6): 998-1003.Sun Wenjie, Mu Shaomin, Dong Mengping, et al. Image recognition of peach leaf diseases based on convolutional recurrent neural network [J]. Journal of Shandong Agricultural University (Natural Science Edition), 2020, 51(6): 998-1003.

[23]Zhang W, Zhou G, Chen A, et al. Deep multi-scale dual-channel convolutional neural network for Internet of Things apple disease detection [J]. Computers and Electronics in Agriculture, 2022, 194: 106749.

[24]刘凯. 基于“云—边—端”的果园信息监测平台研究[D]. 长春: 吉林大学, 2022.Liu Kai. Research on orchard information monitoring platform based on “cloud-side-end” [D]. Changchun: Jilin University, 2022.

[25]朱永宁, 周望, 杨洋, 等. 基于Faster R-CNN的枸杞开花期与果实成熟期识别技术[J]. 中国农业气象, 2020, 41(10): 668-677.Zhu Yongning, Zhou Wang, Yang Yang, et al. Automatic identification technology of Lycium barbarum flowering period and fruit ripening period based on Faster R-CNN [J]. Chinese Journal of Agrometeorology, 2020, 41(10): 668-677.

[26]陈果. 基于数据增强和多模态特征的茶树物候期识别模型设计[D]. 重庆: 重庆大学, 2020.Chen Guo. Design of tea plant phenology recognition model based on data augment and multi-modal feature [D]. Chongqing: Chongqing University, 2020.

[27]崔晓晖, 陈民, 陈志泊, 等. 基于注意力机制的林木物候期识别方法[J]. 中南林业科技大学学报, 2021, 41(7): 11-19.Cui Xiaohui, Chen Min, Chen Zhibo, et al. Forest phenology recognition method based on attention mechanism [J]. Journal of Central South University of Forestry & Technology, 2021, 41(7): 11-19.