管窥深度合成技术的法律规制路径

吴玄

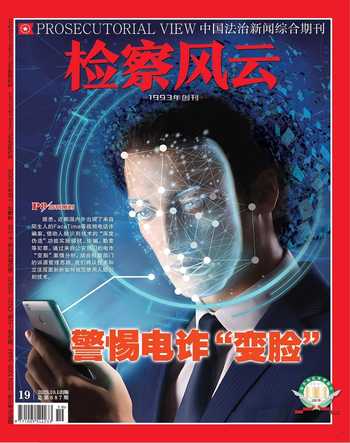

近日,全国多地发生FaceTime诈骗事件,同时有不少苹果用户在社交平台上反映相关问题。作为一种常见的交流方式,线上视频在为人们的工作生活带来极大便利的同时,也存在着诸多个人信息风险。当下,以ChatGPT为代表的生成式人工智能技术的突破,更加凸显出个人信息保护面临的新问题与新挑战。

不断迭代的人工智能技术

随着信息技术的发展,在线上视频中伪造受害者的人脸已经不是难事,其具体使用的,就是人工智能的深度合成技术。

深度合成技术,是指利用深度学习、虚拟现实等生成合成类算法制作文本、图像、音频、视频、虚拟场景等网络信息的技术,包括但不限于文本编辑、语音文字转换、音乐生成、人脸生成与视频生成、图像生成、数字仿真等。其合成的内容在视觉、听觉上具有极佳的仿真效果,甚至能够做到“以假乱真”。

深度合成技术源于人工智能系统生成对抗网络(GAN)的发展,近期大热的ChatGPT就运用了该模型架构。GAN包含两个部分:一个生成模型与一个判别模型。前者的任务是生成看似真实的,与原始数据相似的内容;后者则对生成内容进行真实与否的判断。与传统人工智能算法模型不同,生成式人工智能模型(GAI,Generative Artificial Intelligence)充分贯彻了“大数据、大算力、大模型”。

大数据为生成式人工智能系统提供了训练原材料,ChatGPT不仅可以“理解”和生成广泛的自然语言文本,还具备极强的图像与视频生成能力。大算力是处理海量数据必备的基础,训练生成式人工智能模型所需要的算力取决于模型的规模(参数数量)、训练数据集的大小、训练轮次、批次大小。大模型是一个智能载体,在大算力的支撑下从大数据中提炼出“智能”。算法自身通过深度学习不断自我迭代,产生出复杂架构的人工智能模型并展现出较高的智能水准。

警惕不法之徒利用视频电话窃取人脸、声音信息

在生成式人工智能系统的推动下,深度合成的应用端变得不再遥不可及:

一方面,深度合成内容的准确度和效率大大提升。经深度合成的内容更加“无懈可击”。以“换脸”(Deepfake)为例,仅需提供一张本人照片,即可按照要求生成相应的图片乃至视频,达到人脸的重现、替换、编辑与合成。2019年6月,一则以脸书创始人兼首席执行官马克·扎克伯格为主角的换脸视频出现,引发媒体和舆论的广泛关注。

另一方面,深度合成应用的成本在不断降低。随着一些应用程序的出现,不懂技术的人也能简单制作换脸假视频。2018年4月,美國娱乐网站Buzzfeed发布了一条非常逼真的视频。视频内容是美国前总统奥巴马的一段讲话,而现实中,这段讲话从未发生过。这条视频采用FakeApp制作,据说花费了56个小时来搜集和汇总奥巴马的相关模型。而如今,借助最新的生成式人工智能模型,这一流程得以大幅简化且不影响内容效果。

基于ChatGPT等生成式人工智能的加持,网络信息内容的生产也发生了代际变化。已从早期的Web1.0、Web2.0,正式过渡到Web3.0时代。如果说专业媒体内容生产和用户交互内容生产(自媒体)是前两个时代的特征,那么人工智能生成内容(AIGC)正逐渐成为新的发展方向。利用深度合成技术生成的影视剧片段、明星话题和公众人物的换脸视频等具有极强的娱乐性与传播性。有学者指出,深度合成将重新定义虚拟数字化空间,从传播社会学意义上看,一个新的人类生存场景将以深度合成技术为基石展开。

技术滥用导致社会风险

技术是一把双刃剑,深度合成技术在改变人类生活场景的同时也引发了一系列社会风险和安全挑战。随着深度合成技术的推广和使用成本的降低,不法之徒可以批量伪造音频、视频,实施诽谤、诈骗、勒索等违法行为,甚至捏造公众人物言论扰乱社会秩序。随之而来的是,传统的新闻信息服务许可、用户账号管理和平台算法过滤、人工审核标注等手段所面临的治理挑战:

首先,深度合成技术被用于非法目的,侵犯个人的合法权益。2021年10月,安徽合肥警方曾查获一起非法利用深度合成技术伪造手机用户人脸动态视频破解身份核验,为黑灰产业提供注册虚拟手机卡等技术支撑的案件。此外,不法之徒还利用Facetime、微信视频等线上通话应用来窃取人脸和声音信息,用于伪造不雅视频,侵害个人名誉权。

其次,深度合成技术的滥用容易滋生谣言及破坏社会秩序。一些不法之徒利用深度合成技术,生成高度逼真的图片、音频和视频,并杜撰文字加以传播,张冠李戴、无中生有,颠覆了传统“有图有真相”的认知,进一步加剧了人们发现与识别谣言的难度。

最后,深度合成技术容易被恶意利用,威胁国家安全。当前,国外已出现多起利用深度合成技术伪造政治或公众人物发表言论,不仅影响国内政治稳定,还可能引发国际危机。

深度合成技术的法律规制路径

针对人工智能技术应用产生的风险,我国较早开始了法律规制的尝试。除网络安全法、数据安全法、个人信息保护法等网信基础立法之外,又有多部相关法规相继出台。如2022年3月开始实施的《互联网信息服务算法推荐管理规定》将生成合成类算法列入监管范围;2023年1月开始实施的《互联网信息服务深度合成管理规定》是针对深度合成技术应用的专门立法;2023年8月开始实施的《生成式人工智能服务管理暂行办法》则是在生成式人工智能最新发展动向基础上的及时应对。

从技术角度来看,个人信息在深度合成技术应用中处于核心地位。无论是人工智能模型用于训练的数据,需要合成时使用的“样本”信息,还是经过深度合成的图像、音频、视频等内容,均离不开个人信息。因此,个人信息保护将成为深度合成应用治理的重要环节。2023年8月8日公布的《人脸识别技术应用安全管理规定(试行)》(征求意见稿)也是将法律规制的重点移回到个人信息保护上。生成式人工智能模型在一定程度上模糊了真实与虚拟的边界。然而,浮于表象的数字“真实”终究难以掩盖本质的现实“虚假”。因此,对深度合成应用中的个人信息保护也应当围绕区分“真”和“假”展开——

一方面,应当保障“真”个人信息的权益。所谓“真”个人信息是指现实世界中涉及每个人的真实的个人信息。首先,是从个人信息收集的源头予以保护。在信息收集阶段,应当落实“知情-同意”要求,严格控制使用范围。对用于人工智能训练的数据进行去标识化处理。如《互联网信息服务深度合成管理规定》明确要求深度合成服务提供者和技术支持者提供人脸、人声等生物识别信息编辑功能的,应当提示深度合成服务使用者依法告知被编辑的个人,并取得其单独同意。其次,是加强对敏感个人信息的保护。个人信息保护法规定对敏感信息应进行更为严格的保护。人脸信息即属于敏感个人信息中的生物识别类信息。在深度合成应用中,无论是“换脸”还是生成视频、图像或音频内容,第一步是输入作为“样本”数据的(人脸)信息。《人脸识别技术应用安全管理规定(试行)》(征求意见稿)重申了敏感个人信息非必要不采集:“只有在具有特定的目的和充分的必要性,并采取严格保护措施的情形下,方可使用人脸识别技术处理人脸信息。实现相同目的或者达到同等业务要求,存在其他非生物特征识别技术方案的,应当优先选择非生物特征识别技术方案。”

另一方面,对于“假”个人信息的使用和流动应当予以控制。这里的“假”个人信息是指运用深度合成技术生成的虚假音频、视频、图片等内容。首先,是在技术上进行标识化处理。此处的“标识化”是指深度合成服务提供者对使用其服务生成或者编辑的信息内容,应当采取技术措施添加标识。其目的在于帮助用户识别信息真假,重新建立真实与虚假的区分界限。其次,是健全审核和辟谣机制。识别违法内容是深度合成应用治理的基础。深度合成服务提供者应当建立相应机制,第一时间发现生成内容非法,并采取措施制止相关内容的传播,从而将生成内容对社会与个人的侵害控制在最小范围内。

(作者系上海师范大学副教授)