改进AOD-Net的端到端图像去雾实验研究

马学条

(杭州电子科技大学电子信息学院,杭州 310018)

0 引言

常用的图像去雾算法有基于对比度增强、基于物理模型和基于卷积神经网络等。基于对比度增强的去雾算法和基于物理模型的去雾算法,两种传统数字图像去雾算法比较依赖参数的估计,并且无法调用硬件设备进行算法加速,当图像尺寸较大、样本数量较多时,图像去雾处理效率会显著下降。

基于变形大气散射模型的快速去雾网络AODNet,是一种使用卷积神经网络构建的端到端的图像去雾模型,通过将大气散射模型需要分别计算的大气光值和投射率整合为一个中间未知量,简化了去雾模型,大幅度提升了去雾的处理速度,但是该算法进行去雾处理时容易出现图像色调丢失和图像偏暗等现象[1]。随着深度学习在图像处理领域的快速发展,卷积神经网络凭借高效的特征提取效率,使其在图像去雾领域得到了广泛的应用。

本文针对AOD-Net去雾图的细节信息丢失问题,提出一种基于改进AOD-Net 的端到端图像去雾算法,从网络结构和损失函两个方面对算法进行了改良,拟有效提升了雾图细节的处理能力。

1 图像去雾数学模型

1.1 雾天图像大气散射模型

Mc Cartney提出的大气散射模型由入射光衰减模型(attenuation model)和大气光成像模型(airlight model)两部分组成[2]。

(1)入射光衰减模型

式中:E0为入射光在距离为0 的地方的光照强度;d为场景深度;β为单位体积内大气中的微粒对光线散射的能力,即散射系数。

(2)大气光成像模型

式中,A表示大气光值,通常是全局上的常量。

大气光值模型也为有雾图像的成像退化模型,其表达式为2 个衰减模型的总和,即:

式中,N为有雾图像素点个数。为方便,定义EN=I(x),E0=J(x),e-βd=t(x),可得:

式中:I(x)为有雾图像;J(x)为待恢复的无雾图像;t(x)为投射率。

1.2 AOD-Net去雾模型

将式(4)进行变形整理,得到待恢复的无雾图像表达式为

将式(4)中的大气光值和投射率整合为1 个中间未知量K,定义为K值估计模型,其表达式为

式中,b为常数偏置,默认值为1。

根据大气散射模型原理,将估计得到的K(x)代入式(5),可得清晰无雾图片生成模型

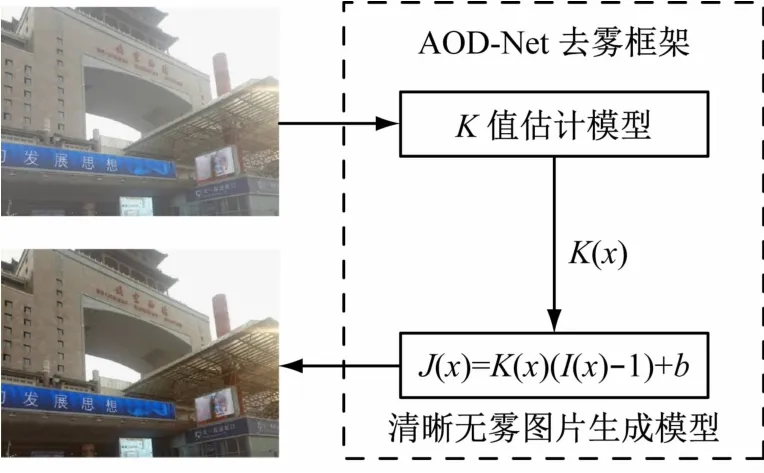

AOD-Net去雾模型算法由K值估计模型和清晰无雾气图片生成模型2 部分组成,AOD-Net 算法的去雾框架如图1 所示。

图1 AOD-Net去雾框架

K值估计模型的网络结构由5 个卷积层和3 个连接层组成,如图2 所示。

图2 K值估计模型的网络结构

K值估计模型中,卷积层采用不同大小的卷积核来获取图像特征,每个卷积层都使用了3 个卷积核[3]。为了将不同卷积层获取到的特征相结合,网络结构在不同的卷积层间加入了连接层。第1 个连接层将第1 个和第2 个卷积层提取到的特征相结合,第2个连接层将第2 个和第3 个卷积层提取到的特征相结合,第3 个连接层将第1 个、第2 个、第3 个和第4 个卷积层提取到的特征相结合[4]。网络模型利用连接层实现了从低层特征到高层特征的平滑转换,又补偿了在卷积过程中的信息损失[5]。

2 改进AOD-Net去雾算法

2.1 多尺度网络结构设计

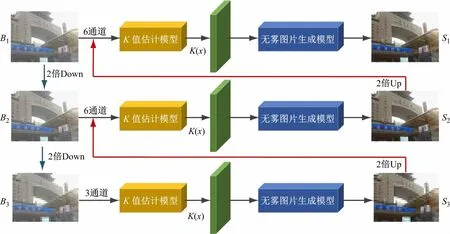

AOD-Net算法采用单尺度的网络结构进行特征提取,对图像的纹理和细节恢复程度较差[6]。本文采用高斯图像金字塔模型设计了3 个尺度图像的网络结构,提升去雾图像的边缘细节质量,使其更加符合人眼视觉感受,改进AOD-Net 多尺度网络结构如图3所示。

图3 改进AOD-Net多尺度网络结构

多尺度网络结构中将原尺度输入图片B1进行2次下采样操作,获得2 倍下采样图片B2和4 倍下采样图片B3,B1、B2、B3的尺寸分别为640 ×480、160 ×120、40 ×30。将B3输入到小尺度网络结构的K值估计模型得到该尺度的特征图,结合无雾图片生成模型提取该尺度的无雾图S3[7]。将S3进行2 倍上采样,恢复至与中尺度网络结构输入图一致的尺寸,将恢复后的S3与B2进行通道合并后输入到中尺度网络结构的K值估计模型,类似操作得到无雾图S2[8]。最后,将进行2 倍上采样S2的与B1合并输入到大尺度网络结构,获得最终的无雾图S1。由于小尺度、中尺度的输出图会合并到中尺度、大尺度K值估计模型的输入端,因此这2 个尺度网络结构的输入通道数为6。

2.2 损失函数设计

常见的损失函数一般是基于L1和L2进行设计,它们也被称为MAE和MSE。L1损失函数是比较像素差异后将像素相减取绝对值,L2损失函数是比较像素差异后将对应像素相减取平均值,L1损失函数和L2损失函数的表达式分别为:

式中:P为图像块;p为图像块中的像素点;N为图像块中的像素数;x(p)表示生成的无雾图的像素值;y(p)表示有雾图的像素值。

本文在设计网络损失函数时将结构相似性(Structural Similarity,SSIM)的差异值作为损失函数的一部分加入网络训练[9]。由于SSIM 值是越大越好,因此取1-SSIM 的值作为损失函数,其损失函数表达式为

由于损失函数通常配合卷积网络使用,因此计算损失函数时只需要计算中央像素的损失,其表达式为

式中:α为损失函数的权重系数;G为像素的高斯分布系数。

3 实验结果及分析

3.1 评价指标

(1)SSIM 评价指标。SSIM是衡量2 幅图像相似度的指标,其指标越大代表对比图的3 个指标越接近标准清晰图。给定2 个图像x和y,其结构相似性。

式中:μx为x的平均值;μy为y的平均值;为x的方差;为y的平均值;σxy为x和y的协方差;c1和c2为用来维持稳定的常数。

(2)PSNR评价指标。峰值信噪比(Peak Signal to Noise Ratio,PSNR)代表了图像峰值信号的能量与图像噪声的平均能量之比,用来衡量处理图的失真程度,两幅图像间的PSNR越大,则越相似[10]。它是原图像与被处理图像之间的均方误差相对于(2n-1)2的对数值,其表达式为

(3)Entropy评价指标。图像熵Entropy表示图像信源的平均信息量,Entropy 值越大图像去雾效果越好,图像灰度值的出现概率pij和图像熵Eij表达式分别为:

式中:f(i,j)为灰度图像在坐标(i,j)处的灰度值;pij为每一灰度级出现的概率;M为图像尺度。

(4)BRISQUE 评价指标。BRISQUE 是一个经典的利用自然场景统计进行无参考图像评价的模型,其值越小图片质量越高。算法总体原理是从图像中提取均值减去对比度归一化(MSCN)系数,将MSCN系数拟合成非对称性广义高斯分布,提取拟合的高斯分布的特征,输入到支持向量机中做回归,从而得到图像质量的评估结果。

(5)图像均值Mean 评价指标。图像均值反映图像的亮度,均值越大反应图像亮度越大,均值越大说明图像的质量越好,其表达式为

式中:xi为像素值为图像像素均值;N为像素个数。

3.2 损失函数权重系数分析

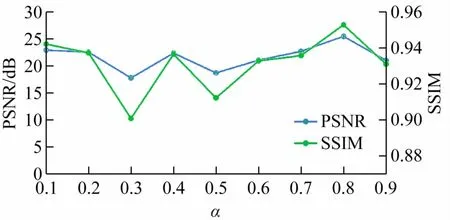

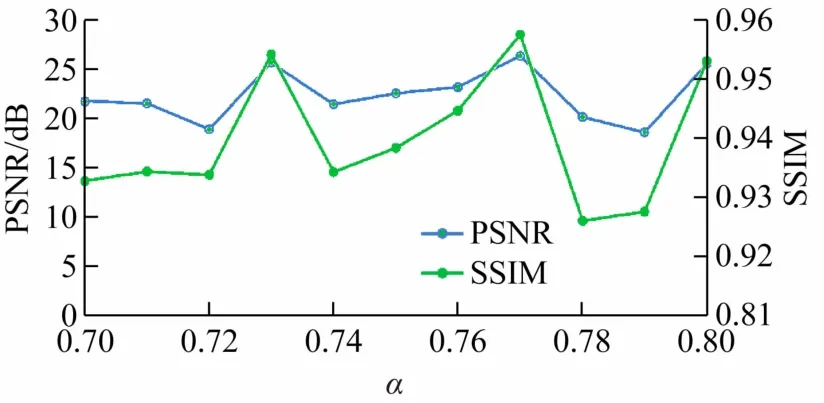

本文选用NYU 雾气数据集进行训练[11],数据集含有1449 张清晰图和27531 张合成雾图,训练时将合成雾图按8∶1∶1的比例分为训练集、测试集和验证集。为了确定本文设计的混合损失函数的权重系数α,采用了一种范围缩小的方法进行取值确定,训练迭代次数为1000。设置α=0.1 ~0.9,间隔为0.1,使用式(11)混合损失函数对网络进行训练,计算改进AOD-Net算法生成图与标准图之间的SSIM 和PSNR值,如图4 所示为其图像指标变化曲线。由图4 可知,权重系数α=0.7 ~0.8,SSIM 和PSNR 的值同时为最大值,因此,可确定最优取值在0.7 ~0.8 之间,继续以0.01为间隔,使用式(11)混合损失函数对网络进行训练。改进的AOD-Net 算法SSIM 和PSNR 曲线如图5所示。

图4 α为0.1 ~0.9时改进AOD-Net算法图像指标变化曲线

图5 α为0.71 ~0.79时改进AOD-Net算法图像指标变化曲线

由图5 可知,综合SSIM和PSNR两种评价指标,α的取值为0.77 最适合本文雾气数据集的训练。

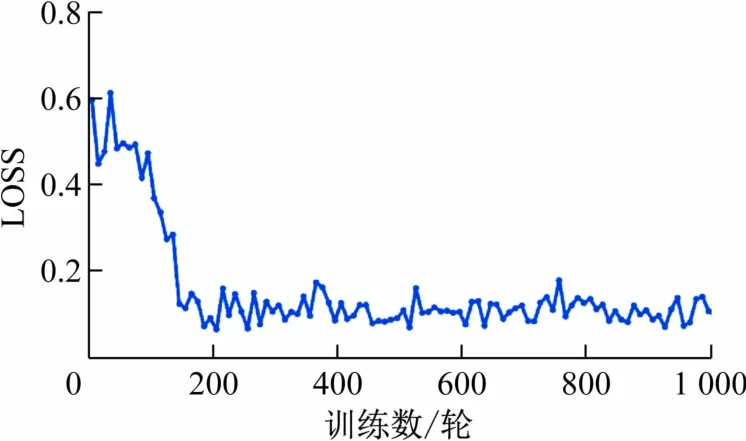

α=0.77 时,式(11)的混合损失函数对改进AODNet网络模型训练时的Loss走势曲线如图6 所示。由图可知,当训练1000 轮时曲线已处于收敛状态。

图6 改进AOD-Net算法损失函数曲线

3.3 合成雾图实验结果分析

本文所提出的基于改进AOD-Net 的端到端去雾算法与几种经典的去雾算法进行了主观视觉质量和客观评价指标的对比,包括2 种传统数字图像去雾算法(CAP 和DCP)、1 种基于卷积神经网络去雾算法(AOD-Net)。

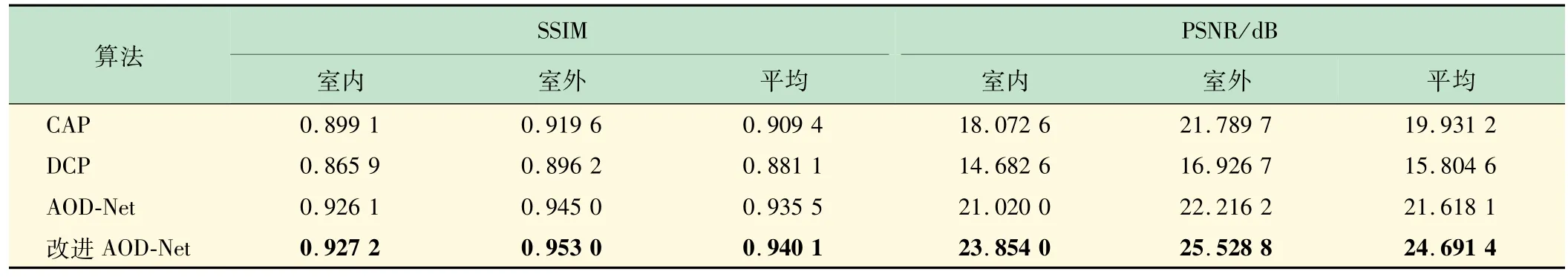

在合成有雾数据集上进行去雾效果实验,通过主观视觉感受分析各算法的优劣,再结合SSIM 和PSNR 2 个评价指标从客观数值上系统性的评价各算法的去雾效果[12]。如图7 所示为4 种去雾算法在室内办公室、室内厨房、室外马路和室外建筑物4 幅合成雾图上的去雾效果。表1 所示为4 种去雾算法在室内办公室、室内厨房、室外马路和室外建筑物4 幅合成雾图上的SSIM和PSNR指标平均值。

表1 4 种去雾算法在4 幅合成雾图上的SSIM和PSNR平均值

图7 展示了各算法在NYU 合成雾图上的去雾效果。由图7(c)可见,CAP算法处理的图像去雾效果不佳,图像对比度过高;由图7(d)可见,DCP算法处理的图像略微偏暗,图像细节存在一定的失真情况;由图7(e)可见,AOD-Net算法处理的图像整体偏暗,过于简单的损失函数使得图像细节恢复效果不理想;由图7(f)可见,改进的AOD-Net 算法去雾后的图像较为清晰,去雾图的细节和色调均与清晰无雾图十分接近[13]。

由表1 可见,改进的AOD-Net算法在合成雾图上的SSIM 和PSNR 平均数值相较CAP、DCP、AOD-Net算法均有一定幅度的提升,实验数据表明改进的AODNet算法去雾后的图像与标准清晰图像的相似度更接近,同时也验证了本文所提出的改进方式是有效的。

3.4 真实雾图实验结果分析

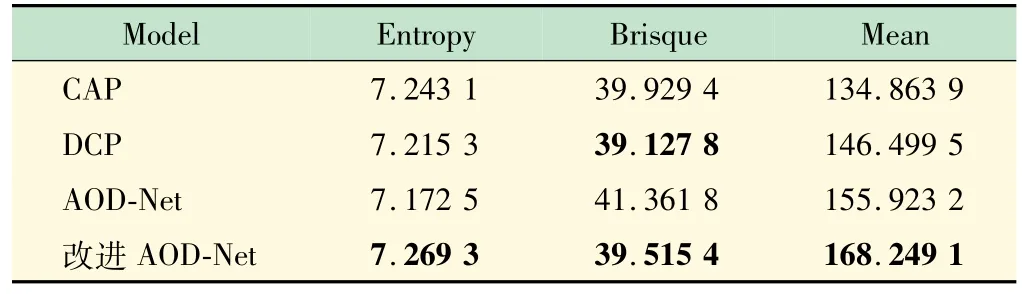

对自然环境中拍摄的真实雾图进行去雾实验,通过主观视觉感受分析各算法的优劣,再结合Entropy、Brisque、Mean 3 个数值从客观上分析各算法的去雾效果[14]。如图8 所示为CAP、DCP、AOD-Net、改进AODNet 4 种算法在室外建筑群、室外景点、室外山水和室内餐厅4 幅真实雾图上的去雾效果。表2 所示为各去雾算法在室外建筑群、室外景点、室外山水和室内餐厅4 幅真实雾图上的Entropy、Brisque和Mean指标平均值。由图8 可见,各算法在真实雾图上去雾效果与合成雾图上的效果基本类似。由图8(b)可见,CAP算法去雾效果不佳;由图8(c)可见,DCP 算法容易出现图像失真情况;由图8(d)可见,AOD-Net 算法处理的图像整体亮度偏暗,图像细节恢复质量不佳;由图8(e)可见,改进的AOD-Net算法较为有效地去除了图像中的雾气,去雾后的图像也较为清晰。

表2 去雾算法在4 幅真实雾图上的Entropy、Brisque和Mean平均值

图8 3种去雾算法对4幅真实雾图的去雾效果对比(从左到右依次为室外建筑群、室外景点、室外山水和室内餐厅)

由表2 可知,改进的AOD-Net 算法在真实雾图上的Entropy和Mean平均数值相较DCP、CAP、AOD-Net算法均有一定幅度的提升,表明改进的AOD-Net 算法在图像去雾效果、图像细节保留程度和图像对比度等方面有着更好的表现[15]。改进的AOD-Net 算法在真实雾图上,Brisque 平均数值较DCP 算法虽然有小幅的上升,但从图8 展示的去雾效果分析可知,该算法出现了严重的图像失真;改进的AOD-Net算法在真实雾图上,Brisque平均数值相较CAP 和AOD-Net 算法均有一定幅度的下降,实验数据表明改进的AOD-Net 算法在图像去雾效果、图像细节保留程度和图像对比度等方面有着很好的表现,再次验证了本文所提出的改进方式是有效的[16]。

4 结语

本文从网络结构和损失函数两部分对AOD-Net去雾算法进行了改进,提出了改进AOD-Net 去雾算法,该算法在合成雾图上的SSIM和PSNR平均数值分别为0.9401 和24.6914,在真实雾图上的Entropy、Brisque和Mean平均数值分别为7.2693、39.5154 和168.2491,相比其他算法,在图像去雾效果等方面有着更优秀的表现。后续将继续增加数据集的图片数量和更多的雾天场景,进一步提高去雾效果,为应用于雾天环境的智能辅助驾驶奠定基础。