WT-U-Net++:基于小波变换的表面缺陷检测网络

何国欢,朱江平

WT-U-Net++:基于小波变换的表面缺陷检测网络

何国欢,朱江平*

(四川大学 计算机学院,成都 610065)( ∗ 通信作者电子邮箱zjp16@scu.edu.cn)

针对传统机器视觉算法在表面缺陷检测中精度低、无法适应环境变化和噪声影响的问题,提出一种基于小波变换(WT)的改进UNet++——WT-U-Net++。首先,由WT获取缺陷图像的高频与低频分量,再通过多尺度模块MCI(Mix-Conv Inception)提取高、低频分量的细节特征;其次,将MCI模块提取到的细节特征与原始图像融合,并将融合结果作为改进UNet++的输入;再次,在UNet++的下采样阶段引入通道注意力模块,从而使网络在捕获更多上下文语义信息的同时提高跨层特征级联的质量,而在上采样阶段采用反卷积恢复更多的缺陷细节信息;最后,从UNet++的多个输出中选择最佳结果作为检测结果。在铁轨、磁瓦、硅钢油污这3个公开缺陷数据集上的实验结果表明,相较于次优的UNet++,WT-U-Net++的交并比(IoU)分别提高了7.98%、4.63%和8.74%,相似度度量指标(DSC)分别提高了4.26%、2.99%和4.64%。

UNet++;表面缺陷检测;小波变换;通道注意力;反卷积

0 引言

目前我国制造业持续快速发展,缺陷检测是把控质量的关键环节。传统的人工缺陷检测效率低,检测结果易受人为因素干扰,不能满足现代工业检测场景需求。因此,非接触式的高精度、高效率的缺陷检测对工业生产制造有着重大的意义。

根据不同的图像特征,可以将传统的机器视觉缺陷检测算法分为3类:基于纹理特征、颜色特征和形状特征的算法。纹理特征反映图像的同质性现象,通过像素点及其邻近空间邻域的灰度分布表征图像组织结构和排列属性,常见的算法有局部二值模式(Local Binary Pattern, LBP)[1-2]、线性尺度微分(Linear Scale-space Differential, LSD)[3]法和小波变换(Wavelet Transform, WT)[4]等。基于颜色特征的方法计算量小,并且不受图像尺寸、方向、视角等因素的限制,鲁棒性强,典型的算法有颜色直方图(Color Histogram, CH)[5]、色矩(Color Moment, CM)[6]法。形状特征属于中间层特征,主要描述图像的轮廓和区域特征,如傅里叶形状描述子(Fourier Shape Descriptor, FSD)[7]、霍夫变换(Hough Transform, HT)[8]。传统缺陷检测算法特别依赖缺陷特征和图像质量,它的特征提取算子需人为设计,多针对单一场景,无法适应背景、光照等环境变化和噪声影响,检测精度较低。

近年来,卷积神经网络(Convolutional Neural Network, CNN)在缺陷检测领域取得飞速发展,为实现高精度、高效率的表面缺陷检测提供了新方法。基于CNN的表面缺陷检测算法大致分为分类网络、检测网络和分割网络。基于CNN的分类网络已成为表面缺陷检测最常用的算法,Soukup等[9]首先采集光度立体图像训练CNN,实现轨道表面缺陷分类。Deitsch等[10]将改进的VGG19(Visual Geometry Group 19)网络应用于太阳能电池板缺陷检测,并证明该算法优于尺度不变特征变换(Scale-Invariant Feature Transform, SIFT)和支持向量机(Supported Vector Machine, SVM)分类器。检测网络可分为两阶段网络(如Faster R-CNN[11-12])和单阶段网络(如SSD(Single Shout multibox Detector)[13]、YOLO[14])。两阶段网络具有更好的精度,而单阶段网络具有更快的速度。分类网络仅能够判断缺陷是否存在和不同缺陷类别,但是无法定位缺陷,因此在实际应用场景中存在一定的局限性;检测网络通过预测框可以直接定位缺陷位置,且检测算法已趋向成熟,算法精度较高,在工业缺陷检测中广泛应用,但它只能定位缺陷位置,无法准确描述缺陷的轮廓。

分割网络通过区分缺陷与正常区域,将表面缺陷检测任务转换为语义分割或者实例分割问题,不仅可以精细分割缺陷区域,还可以获取缺陷的位置、类别和相应的几何属性。典型的分割网络包括全卷积网络(Fully Convolutional Network, FCN)[15]、SegNet[16-17]系列和U-Net[18]系列。U-Net是一种典型的编码解码结构,与FCN相比,U-Net的跳层连接将编码器与解码器的特征跨层融合,有利于恢复图像细节。U-Net在医学图像处理取得了瞩目的成绩,而工业缺陷图像与医学图像相似,它们的语义信息简单、结构固定,且通常为小规模数据集。针对工业缺陷图像检测模型过大、参数过多容易导致过拟合的问题,U-Net系列编码器‒解码器这一从低分辨到高分辨的轻量网络结构完美契合了工业缺陷图像的特性。

在编码阶段,U-Net的下采样通过扩大感受野提取深层的图像特征,这些深层特征有助于判断图像是否存在缺陷;但是在下采样的过程中,图像的分辨率也随之下降,导致图像丢失一些细节信息,如颜色、形状等。UNet++[19]是U-Net的变体网络,UNet++在解码阶段采用多解码器设计,多解码器通过从编码器不同层解码,能够同时捕获深层特征和浅层特征,融合深、浅层特征以获取丰富的多尺度信息,加强网络性能,提高泛化能力。因此,本文将UNet++应用于表面缺陷检测。另外,深度学习方法虽然在提取特征的能力上相较于传统算法有着明显优势,但由于它的“黑盒”属性,难以针对具体场景调参。相反,传统算法虽然对背景、光照等环境变化和噪声干扰适应性差,但它的计算复杂度低,可以提取并应用图像的一些底层特征。基于此,本文提出一种基于小波变换[20]的改进UNet++——WT-U-Net++,用于工业场景下的表面缺陷检测。

本文主要工作如下:

1)提出一种基于小波变换的表面缺陷检测网络WT-U-Net++,通过小波变换获取图像的高、低频分量,增加缺陷特征的丰富度;

2)引入MCI(Mix-Conv Inception)模块,对高、低频分量提取多尺度特征,使它更好地融入检测网络;

3)改进UNet++,在下采样阶段引入通道注意力增强网络的检测性能,在上采样阶段使用反卷积加强网络细节恢复能力。

1 理论分析

1.1 整体网络架构

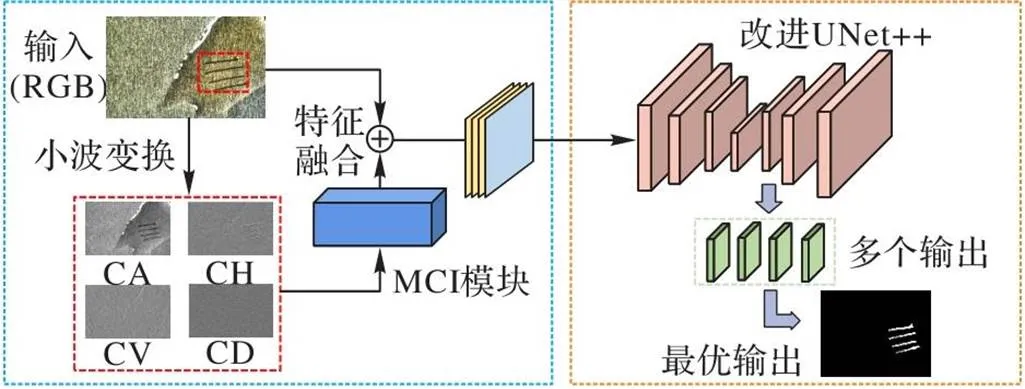

WT-U-Net++的整体结构如图1所示,网络由MCI模块和改进UNet++构成。首先,将待检测三通道(RGB)缺陷图像输入网络,经过小波变换提取特征,得到近似分量(CA)、水平分量(CH)、垂直分量(CV)和对角分量(CD)这4个单通道分量;其次,将4个分量融合,作为MCI模块的输入,使小波变换得到的特征更好地融入网络;最后,与原始输入融合,作为检测网络改进UNet++的输入。其中,经过MCI模块得到的特征首先经过改进UNet++的编码器提取下采样特征,对缺陷定位与分割;同时,在编码器阶段,引用注意力机制获取更多的上下文语义信息,增强网络性能。其次,通过解码器上采样恢复缺陷形状,解码器中采用反卷积上采样模块(D-Up)增强缺陷细节恢复能力。最后,经过检测网络预测得到多个输出,选择最优输出作为网络的输出。

图1 所提网络的整体结构

1.2 具体网络架构

1.2.1小波变换

小波变换将空域信息转换到小波域进行特征提取,通过缩放、平移等操作函数对图像进行多尺度细化分析,其次将图像分解为不同的特征向量。通过哈尔小波变换(Haar Wavelet Transform, HWT)将输入图像分解成1个低频分量与3个高频分量,计算公式为:

1.2.2MCI模块

为了使小波变换得到的分量都能够提供有效的缺陷信息,本文构建了MCI模块,从分量中提取有效特征,减少噪声干扰。为了避免不同分量的相互影响,首先将4个分量通过concat操作在通道上叠加,其次经过两个3×3卷积块提取粗特征:

卷积核的大小表征着不同的特征提取能力,大核卷积更容易捕获全局信息,而小核卷积提取局部特征的能力更强。大部分的缺陷图像语义信息简单,所占图像面积比例较小,因而缺陷是一种局部特征。基于此,本文构建一种小核卷积的Inception结构[21],即MCI,如图2所示。

图2 MCI模块

表1 卷积层的组成

1.3 改进UNet++

1.3.1UNet++

WT-U-Net++以UNet++为基础,如图3所示,UNet++主要由编码器与解码器两部分组成:编码器负责下采样,压缩缺陷图像并提取特征;解码器通过上采样恢复图像尺寸和缺陷细节信息。通常,对于不同应用场景,网络的最佳深度取决于数据集的大小和难度,而UNet++将多个不同深度的U-Net统合到一个网络,从多个U-Net路径中选择最佳结果作为最终输出,这种结构不仅可以提高网络的多尺度检测性能,同时也加强对不同尺寸的图像的适应性,提升网络的泛化性。另外,与大多数的级联操作仅连接同层的编码器,与解码器相比,UNet++的级联操作还连接了同层的浅层解码器,有助于深层解码器从浅层解码器捕获更丰富的空间域信息,获取更丰富的缺陷特征。

图3 改进UNet++

1.3.2通道注意力模块

受注意力机制在计算机视觉领域成功应用的启发,在UNet++的下采样阶段引入通道注意力机制[22]。除了可以使网络学习到广泛的上下文信息从而提高检测性能外,引入通道注意力机制还有以下两个好处。首先,小波变换提取的特征与原始图像在通道层面融合,通道注意力侧重通道关系,通过显性建模加强通道之间的相互依赖性,从而可以校准不同通道间的特征响应;其次,通道注意力作用于特征跨层融合阶段,原始UNet++级联操作未考虑不同通道的特征的差异性和浅层特征存在的噪声等,通道注意力通过对特征重新编码,计算通道间的相互关系,对不同通道的权重重新分配,提高了特征融合的质量。如图4所示,通道注意力模块主要包括池化操作、多层感知机(Multi-Layer Perceptron, MLP)。

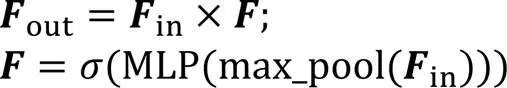

在缺陷检测任务中,更加关注缺陷本身的特征而非缺陷图像的背景,即更关注局部特征而非全局特征,因此采用最大池化获得更准确的语义信息。输入特征首先经过池化操作,得到一个包含空间上下文信息的1×1×(为通道数)特征图;其次将它送入包含两个1×1卷积的MLP,第一层卷积操作后为激活函数ReLU,通过MLP的特征图经过Sigmoid函数得到注意力特征;最后,与输入特征相乘,得到输出特征。通道注意力模块计算公式如下:

其中:表示Sigmoid函数;MLP代表多层感知机;max_pool表示最大池化操作;、和分别为输入、中间特征和输出特征。

1.3.3反卷积上采样模块

在下采样阶段,网络对图像提取特征的同时也降低了图像的分辨率,减少了网络运算量并过滤部分噪声,但同时也会使图像丢失掉大量的细节,因此需要通过上采样恢复图像的尺寸及其细节信息。传统的上采样通常采用线性插值,而线性插值的方式需要人工设计参数,插值结果的好坏取决于插值参数的设计;而反卷积与预先定义的插值法不同,它有可学习的参数,可以自动学习适当的变换,从而增强网络对不同图像的适应能力。如图5所示,输入特征经过反卷积操作扩展图像尺寸,其次通过卷积操作学习参数与特征分配得到输出特征。

图5 反卷积模块

2 实验与结果分析

2.1 参数设置

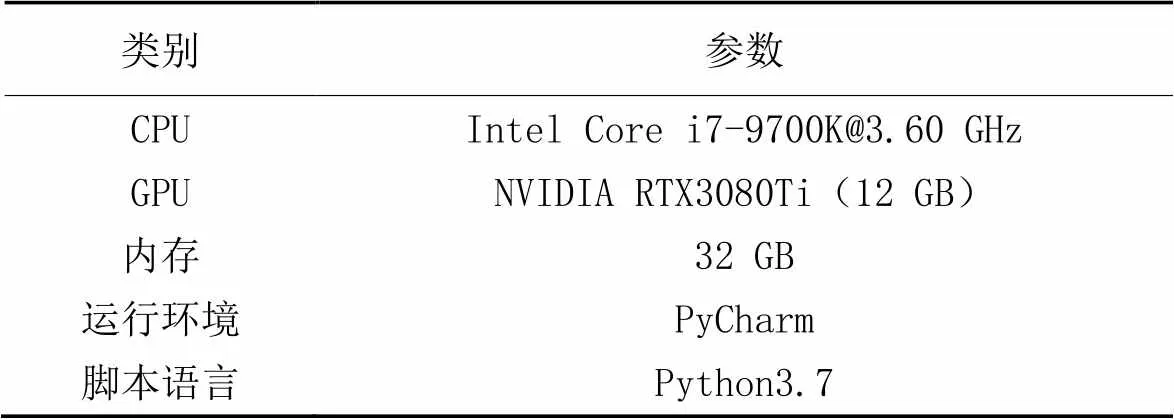

本文实验基于Windows10专业版下搭建的PyTorch深度学习框架,详细运行环境见表2。训练过程中使用了Adam优化器,初始学习率设置为0.000 1,迭代80个周期。

表2 实验运行环境

2.2 数据集

为了验证WT-U-Net++的性能,分别采用多个开源数据集验证,主要包括:铁轨数据集(Type-Ⅰ RSDDs)[23]、磁瓦数据集[24]和硅钢油污数据集[25]。由于磁瓦数据集中缺陷图像大小不一,为了统一尺寸且不影响缺陷特征,从中挑选118张缺陷图像。数据集样例见图6,每对图像分别为缺陷图像及其真值。数据集简介见表3。

表3 数据集

图6 数据集样例

上述数据集中铁轨数据集和磁瓦数据集均已给出真值,硅钢油污数据由人工标注,标注工具为LabelMe[26]。深度学习是以数据为驱动的科学方法,数据量不仅影响结果,同时也影响训练的难度,而在真实的工业场景中,缺陷数据集的规模通常较小,它的数量通常在几十例到几百例不等。为了解决数据短缺的问题,使用数据增强手段,同时为尽可能模拟工业场景下复杂的检测环境,在图像处理过程中加入随机高斯噪声、随机Gamma、高斯模糊等方式仿真生成噪声数据;通过调整对比度、明亮度、饱和度、加入光学畸变等方式,仿真生成不同光照条件下的缺陷数据,具体增强方式如表4所示。使用基于OpenCV的快速图像增强库Albumentations[27],训练过程中按照8∶2将数据集划分为训练集、测试集,再将数据等比例增强,增强后的数据量为原始数据的20倍。

表4 数据增强方式

2.3 评价指标

通过两个评价指标评估WT-U-Net++的有效性,指标为交并比(Intersection over Union, IoU)和相似度度量指标(Dice Similarity Coefficient, DSC),计算公式如下:

2.4 实验结果分析

选择U-Net[18]、UNet++[19]、AttentionU-Net[28]、SegNet[16]作为实验对比对象,不同网络在测试集上的部分检测结果如图7~9所示。

如图7所示,第1行缺陷图像有大小不同的两个缺陷,5个网络均能完整地检测较大的缺陷,而U-Net、AttentionU-Net与SegNet无法完整检测较小的缺陷。UNet++虽然能较好地恢复缺陷形状,但严重受到噪声干扰,只有WT-U-Net++既完整恢复了缺陷信息,又较少受到噪声干扰。第2行的缺陷形状更小且受到光照反射的干扰,只有WT-U-Net++能够完整地检测所有缺陷信息,其他对比网络均有不同程度的缺陷漏检。第3行中,只有U-Net与WT-U-Net++受到伪缺陷影响较小,但WT-U-Net++的缺陷检测结果更完整。

从图8可以看出,在第1行中,U-Net、AttentionU-Net和SegNet在不同程度上受到噪声干扰,WT-U-Net++和UNet++均达到了较好的检测效果。在第2行中,UNet++表现较差,WT-U-Net++表现最优。在第3行中,只有WT-U-Net++能够较为完整地恢复图像右方的缺陷。

从图9可以看出,在第1行中,WT-U-Net++恢复了最完整的缺陷信息,而其他对比网络都未能恢复完整缺陷形状,SegNet甚至出现误检。在第2行中,U-Net、AttentionU-Net和UNet++虽然都完整地恢复了缺陷形状,但它们在不同程度上都受到了伪缺陷的干扰,导致产生一些额外的噪声信息;SegNet虽然受到伪缺陷干扰程度小,但是恢复缺陷信息能力较差;只有WT-U-Net++受伪缺陷影响最小且完整恢复了缺陷形状。第3行中,由于位于图像下方的缺陷对比度较低且缺陷较小,只有WT-U-Net++恢复缺陷形状最为完整。

图7 不同网络在铁轨数据集上的检测结果对比

图8 不同网络在磁瓦数据集上的检测结果对比

图9 不同网络在硅钢油污数据集上的检测结果对比

为了充分验证WT-U-Net++的优越性,本文在IoU与DSC两个评价标准下进行比较,具体结果见表5。可以看出,WT-U-Net++在IoU指标上最低为0.758,最高为0.814,在DSC指标上最低为0.856,最高达到0.897,在IoU、DSC上的平均精度分别达78.53%、87.73%,WT-U-Net++在3个数据集上的表现在5个网络之中最好。在3个数据集上,相较于次优的UNet++,WT-U-Net++的交并比分别提高了7.98%、4.63%和8.74%,相似度度量指标提高了4.26%、2.99%和4.64%,WT-U-Net++在不同的缺陷数据类型下均有较好的表现,具有一定的通用性。

2.5 消融实验

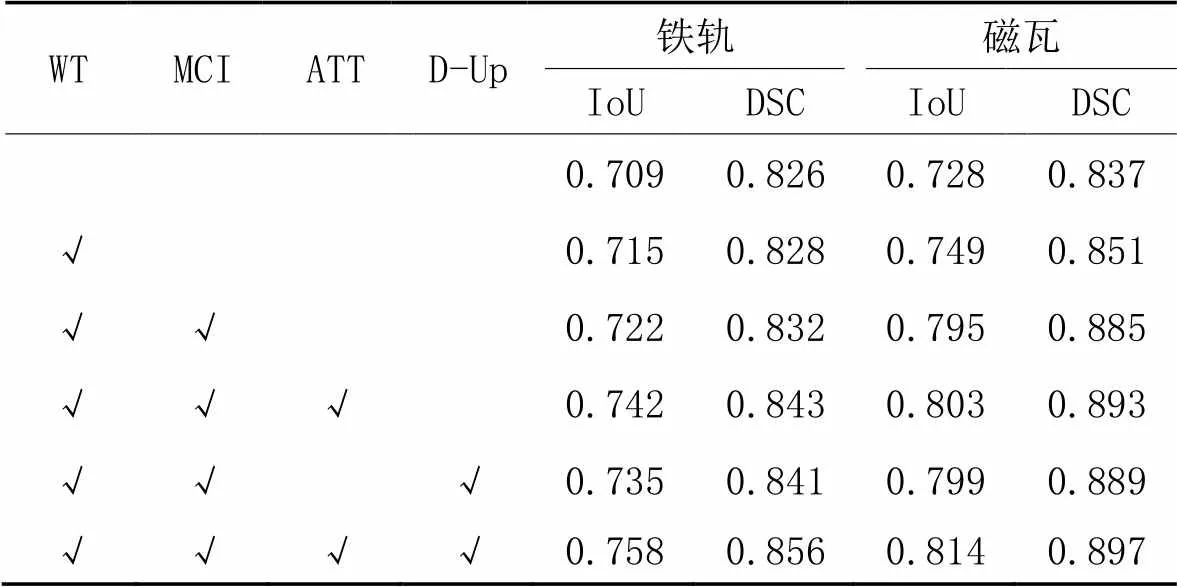

为了验证所提模块的有效性,在铁轨数据集和磁瓦数据集上进行消融实验,结果如表6所示。原始模块未添加小波变换(WT)、MCI模块、通道注意力模块(ATT)和反卷积上采样模块(D-Up),上采样由二次线性插值代替。

表6 消融实验结果

从表6中可以看出,在铁轨和磁瓦数据集上,相较于原始模块,WT分别使IoU、DSC提升0.85%、0.24%和2.88%、1.67%;在添加WT的基础上,MCI模块分别使IoU、DSC再次提升0.98%、0.48%和6.14%、4.00%。在添加WT和MCI模块的基础上,分别又针对ATT和D-Up模块进行验证,结果表明两个模块对IoU、DSC两个指标均有所提升。最后同时使用4个模块,两个指标上达到最优效果,由此验证了本文所提出的4个模块可以有效提高检测性能。

3 结语

本文提出一种基于小波变换的表面缺陷检测网络WT-U-Net++,通过引入小波变换获取缺陷图像的高频以及低频分量,丰富了缺陷特征信息。同时,构建MCI模块对特征信息进行多尺度融合,使通过小波变换得到的细节信息更好地融入网络。另外,改进UNet++,引入通道注意力机制增强对特征语义信息的获取且提高跨层特征融合的质量,从而增强网络的性能和鲁棒性。最后,引入反卷积进行上采样,使恢复的缺陷信息更加完整且准确。实验结果表明,WT-U-Net++在多个应用场景下均有较好的检测效果,相较于其他对比网络,WT-U-Net++具有较大的优势。

然而由于缺陷样本不同类型样本量的不平衡,所提网络的缺陷识别精度仍有待提高,因此在后续工作中,将会针对数据的不平衡性对数据进行扩充,并对网络模型持续优化,提升检测精度。

[1] LIU Y, XU K, XU J. An improved MB-LBP defect recognition approach for the surface of steel plates[J]. Applied Sciences, 2019, 9(20): No.4222.

[2] SU B, CHEN H, ZHU Y, et al. Classification of manufacturing defects in multicrystalline solar cells with novel feature descriptor[J]. IEEE Transactions on Instrumentation and Measurement, 2019, 68(12): 4675-4688.

[3] LI S, LI D, YUAN W. Wood chip crack detection based on linear scale-space differential[J]. Measurement, 2021, 175: No.109095.

[4] RYU S G, KOO G, KIM S W. An adaptive selection of filter parameters: defect detection in steel image using wavelet reconstruction method[J]. ISIJ International, 2020, 60(8):1703-1713.

[5] REN H, TIAN K, HONG S, et al. Visualized investigation of defect in cementitious materials with electrical resistance tomography[J]. Construction and Building Materials, 2019, 196:428-436.

[6] MA N, GAO X, WANG C, et al. Influence of hysteresis effect on contrast of welding defects profile in magneto-optical image[J]. IEEE Sensors Journal, 2020, 20(24): 15034-15042.

[7] PAN Y, LU R, ZHANG T. FPGA-accelerated textured surface defect segmentation based on complete period Fourier reconstruction[J]. Journal of Real-Time Image Processing, 2020, 17(5): 1659-1673.

[8] LI R, TIAN F, CHEN S. Research on surface defect detection method of E-TPU midsole based on machine vision[J]. Journal of Computer and Communications, 2020, 8(11):145-160.

[9] SOUKUP D, HUBER-MÖRK R. Convolutional neural networks for steel surface defect detection from photometric stereo images[C]// Proceedings of the 2014 International Symposium on Visual Computing, LNCS 8887. Cham: Springer, 2014: 668-677.

[10] DEITSCH S, CHRISTLEIN V, BERGER S, et al. Automatic classification of defective photovoltaic module cells in electroluminescence images[J]. Solar Energy, 2019, 185:455-468.

[11] 陈仁祥,詹赞,胡小林,等. 基于多注意力Faster RCNN的噪声干扰下印刷电路板缺陷检测[J]. 仪器仪表学报, 2021, 42(12):167-174.(CHEN R X, ZHAN Z, HU X L, et al. Printed circuit board defect detection based on the multi-attentive Faster RCNN under noise interference[J]. Chinese Journal of Scientific Instrument, 2021, 42(12):167-174.)

[12] 郭文明,刘凯,渠慧帆. 基于Faster R-CNN模型X-射线图像的焊接缺陷检测(英文)[J]. 北京邮电大学学报, 2019, 42(6):20-28.(GUO W M, LIU K, QU H F. Welding defect detection of X-ray images based on Faster R-CNN model[J]. Journal of Beijing University of Posts and Telecommunications, 2019, 42(6):20-28.)

[13] LI Y, HUANG H, XIE Q, et al. Research on a surface defect detection algorithm based on MobileNet-SSD[J]. Applied Sciences, 2018, 8(9): No.1678.

[14] 韩航迪,徐亦睿,孙博,等. 基于改进Tiny-YOLOv3网络的航天电子焊点缺陷主动红外检测研究[J]. 仪器仪表学报, 2020, 41(11):42-49.(HAN H D, XU Y R, SUN B, et al. Using active thermography for defect detection of aerospace electronic solder joint base on the improved Tiny-YOLOv3 network[J]. Chinese Journal of Scientific Instrument, 2020, 41(11): 42-49.)

[15] DUNG C V, ANH L D. Autonomous concrete crack detection using deep fully convolutional neural network[J]. Automation in Construction, 2019, 99: 52-58.

[16] BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet: a deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495.

[17] ZOU Q, ZHANG Z, LI Q, et al. DeepCrack: learning hierarchical convolutional features for crack detection[J]. IEEE Transactions on Image Processing, 2019, 28(3): 1498-1512.

[18] RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]// Proceedings of the 2015 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9351. Cham: Springer, 2015: 234-241.

[19] ZHOU Z, SIDDIQUEE M M R, TAJBAKHSH N, et al. UNet++: redesigning skip connections to exploit multiscale features in image segmentation[J]. IEEE Transactions on Medical Imaging, 2020, 39(6):1856-1867.

[20] SHENSA M J. The discrete wavelet transform: wedding the a trous and Mallat algorithms[J]. IEEE Transactions on Signal Processing, 1992, 40(10):2464-2482.

[21] SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016:2818-2826.

[22] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11211. Cham: Springer, 2018: 3-19.

[23] GAN J, LI Q, WANG J, et al. A hierarchical extractor-based visual rail surface inspection system[J]. IEEE Sensors Journal, 2017, 17(23): 7935-7944.

[24] HUANG Y, QIU C, YUAN K. Surface defect saliency of magnetic tile[J]. The Visual Computer, 2020, 36(1): 85-96.

[25] 硅钢油污数据集[DS/OL]. [2021-05-22].http://faculty.neu.edu.cn/yunhyan/SLSM.html.(Oil pollution defect database[DS/OL]. [2021-05-22].http://faculty.neu.edu.cn/yunhyan/SLSM.html.)

[26] RUSSELL B C, TORRALBA A, MURPHY K P, et al. LabelMe: a database and web-based tool for image annotation[J]. International Journal of Computer Vision, 2008, 77(1/2/3): 157-173.

[27] BUSLAEV A, IGLOVIKOV V I, KHVEDCHENYA E, et al. Albumentations: fast and flexible image augmentations[J]. Information, 2020, 11(2): No.125.

[28] OKTAY O, SCHLEMPER J, FOLGOC L L, et al. Attention U-Net: learning where to look for the pancreas[EB/OL]. (2018-05-20) [2022-02-24].https://arxiv.org/pdf/1804.03999.pdf.

WT-U-Net++: surface defect detection network based on wavelet transform

HE Guohuan, ZHU Jiangping*

(,,610065,)

To address the problems of traditional machine vision algorithms such as low detection accuracy, inability to adapt to environmental changes and noise influence in surface defect detection, a improved UNet++ based on Wavelet Transform (WT) — WT-U-Net++ was proposed. Firstly, the high frequency and low frequency components of the defect image were obtained by the WT, and the detailed features of the high and low frequency components were extracted by the multi-scale module MCI (Mix-Conv Inception). Secondly, the detailed features extracted by MCI module were fused with the original image, and the fusion results were used as the input of the improved UNet++. Thirdly, in the downsampling stage of UNet++, channel attention module was introduced to enable the network to capture more contextual semantic information and improve the quality of cross-layer feature cascade at the same time. In the upsampling stage, deconvolution was adopted to recover more defect details. Finally, the best result was selected from the multiple output of UNet++ as the detection result. Experimental results on three public defect datasets of rail, magnetic tile and silicon steel oil stain show that compared with the sub-optimal algorithm UNet++, WT-U-Net ++ has the Intersection over Union (IoU) increased by 7.98%, 4.63%, and 8.74% respectively, and the Dice Similarity Coefficient (DSC) improved by 4.26%, 2.99% and 4.64% respectively.

UNet++; surface defect detection; Wavelet Transform (WT); channel attention; deconvolution

This work is partially supported by Key Research and Development Project of Sichuan Province (2022YFG0053).

HE Guohuan, born in 1996, M. S. candidate. His research interests include computer vision, defect detection.

ZHU Jiangping, born in 1984, Ph. D., associate professor. His research interests include computer vision, three dimensional reconstruction, defect detection.

1001-9081(2023)10-3260-07

10.11772/j.issn.1001-9081.2022091452

2022⁃09⁃30;

2022⁃12⁃17;

四川省重点研发专项(2022YFG0053)。

何国欢(1996—),男,陕西安康人,硕士研究生,主要研究方向:计算机视觉、缺陷检测; 朱江平(1984—),男,四川达州人,副教授,博士,主要研究方向:计算机视觉、三维重建、缺陷检测。

TP389.1

A

2022⁃12⁃28。