基于加权值函数分解的多智能体分层强化学习技能发现方法

邹启杰 李文雪 高兵 赵锡玲 张汝波

摘 要:

针对目前大多数多智能体强化学习算法在智能体数量增多以及环境动态不稳定的情况下导致的维度爆炸和奖励稀疏的问题,提出了一种基于加权值函数分解的多智能体分层强化学习技能发现算法。首先,该算法将集中训练分散执行的架構与分层强化学习相结合,在上层采用加权值函数分解的方法解决智能体在训练过程中容易忽略最优策略而选择次优策略的问题;其次,在下层采用独立Q学习算法使其能够在多智能体环境中分散式地处理高维复杂的任务;最后,在底层独立Q学习的基础上引入技能发现策略,使智能体之间相互学习互补的技能。分别在简易团队运动和星际争霸Ⅱ两个仿真实验平台上对该算法与多智能体强化学习算法和分层强化学习算法进行对比,实验表明,该算法在奖励回报以及双方对抗胜率等性能指标上都有所提高,提升了整个多智能体系统的决策能力和收敛速度,验证了算法的可行性。

关键词:多智能体强化学习;分层强化学习;集中训练分散执行;值函数分解;技能发现

中图分类号:TP181 文献标志码:A 文章编号:1001-3695(2023)09-027-2743-06

doi:10.19734/j.issn.1001-3695.2022.12.0795

Research on multi-agent hierarchical reinforcement learning skill discovery

method based on weighted value function decomposition

Zou Qijie1, Li Wenxue1, Gao Bing1, Zhao Xiling1, Zhang Rubo2

(1. Dept. of Information Engineering, Dalian University, Dalian Liaoning 116622, China; 2. Dept. of Mechanical & Electrical Engineering, Dalian Nationalities University, Dalian Liaoning 116600, China)

Abstract:

Aiming at the problem of dimension explosion and sparse rewards caused by the increase in the number of agents and the dynamic instability of the environment in most multi-agent reinforcement learning algorithms, this paper proposed a multi-agent hierarchical reinforcement learning skill discovery algorithm based on weighted value function decomposition. Firstly, the algorithm combined the architecture of centralized training and decentralized execution with hierarchical reinforcement learning, and adopted the method of weighted value function decomposition in the upper level to solve the problem that agents tended to ignore the optimal strategy and chose the suboptimal strategy in the training process. Secondly, it adopted the independent Q learning algorithm in the lower level to enable it to deal with high-dimensional complex tasks in a multi-agent environment in a decentralized manner. Finally, it introduced a skill discovery strategy on the basis of independent Q learning at the lower level, so that agents could learn complementary skills from each other. Compared the algorithm with the multi-agent reinforcement learning algorithms and the hierarchical reinforcement learning algorithms on the two simulation experimental platforms of simple team movement and StarCraft Ⅱ respectively. The experiment shows that the algorithm has improved performance indicators such as rewards and the victory rate of both sides, improves the decision-making ability and convergence speed of the entire multi-agent system, and verifies the feasibility of the algorithm.

Key words:multi-agent reinforcement learning; hierarchical reinforcement learning; centralized training decentralized execution; value function decomposition; skill discovery

0 引言

随着分布式人工智能的不断发展,多智能体系统(multi-agent system,MAS)需要面对更加复杂的应用场景[1]。然而随着智能体数量的不断增加,智能体状态空间呈指数级增长,导致智能体对环境的探索不足,无法学习鲁棒的策略。同时,在MAS中,每个智能体获得的奖励都与团队其他智能体的动作相关[2],导致智能体在做出动作后无法立刻得到奖励,也无法使某个智能体的奖励最大化,因此多智能体在协作完成任务时会受到很大的约束。为了适应更多数量的智能体以及更加复杂的任务环境的需要,分层强化学习(hierarchical reinforcement learning,HRL)为分布式人工智能计算提供了新的研究思路。

在多智能体分层强化学习领域中,Dietterich[3]提出了一种典型的分级控制模型方法MAXQ,该算法通过将总任务向下逐层分解为不同的子任务,进而递归求解各个子任务,可以有效地解决状态维度空间过大的问题。为了提高智能体之间的合作效率,Ahilan等人[4]在Feudal[5]方法和FuNs[6]方法的基础上对管理者和工作者进行预定义,工作者根据管理者制定的目标执行相应的动作。Kim等人[7]提出让智能体在顶层学习教学或者是传递知识,对于奖励评估较低的动作给出建议并进行更新,从而加速协同智能体的学习进程。Vezhnevets等人[8]将分层多智能体强化学习扩展到马尔可夫博弈中,在顶层选择对对手的战略响应,在底层实现响应原始动作行为的策略。

在技能发现领域中,Shankar等人[9]提出一种共同学习机器人技能的框架,以及学习如何在无监督的情况下从演示中使用这些技能来学习任务的时间分解。DIAYN[10]方法和DADs[11]方法都是基于互信息的目标函数来动态学习技能,并且提出将学习到的技能用于学习HRL的底层策略中。RODE[12]方法提出通过将联合动作空间分解为受限的角色动作空间的方法来实现可扩展的多智能体学习。

目前也有研究者借鉴集中训练分散执行的思想来实现多智能体分层,例如Tang等人[13]提出要求每个智能体都独立地学习自身的分層策略,并且每个智能体只能关心本地信息,将其他智能体视做环境的一部分进行训练和学习;Yang等人[14]提出一种集中训练分散执行的双层框架来训练和协调个人技能。

但随着环境的复杂程度不断增大,多智能体环境存在着各种各样复杂且多变的问题[15,16]。本文提出一种基于加权值函数分解的多智能体分层强化学习的方法(multi-agent hierarchical reinforcement learning method based on weighted QMIX,H-WQMIX)。该算法主要通过采用分层强化学习的思想来解决多智能体强化学习(multi-agent reinforcement learning,MARL)中出现的维度灾难和奖励稀疏的问题。针对维度灾难问题,本文算法采用顶层集中训练策略,底层分散执行各自任务的框架;同时在顶层训练智能体协同策略的时候引入加权值函数,使智能体可以更准确、快速地选择最优策略;在底层执行动作过程中加入技能发现的思想,使智能体根据环境观测信息来选择合适的技能执行动作。

1 背景知识

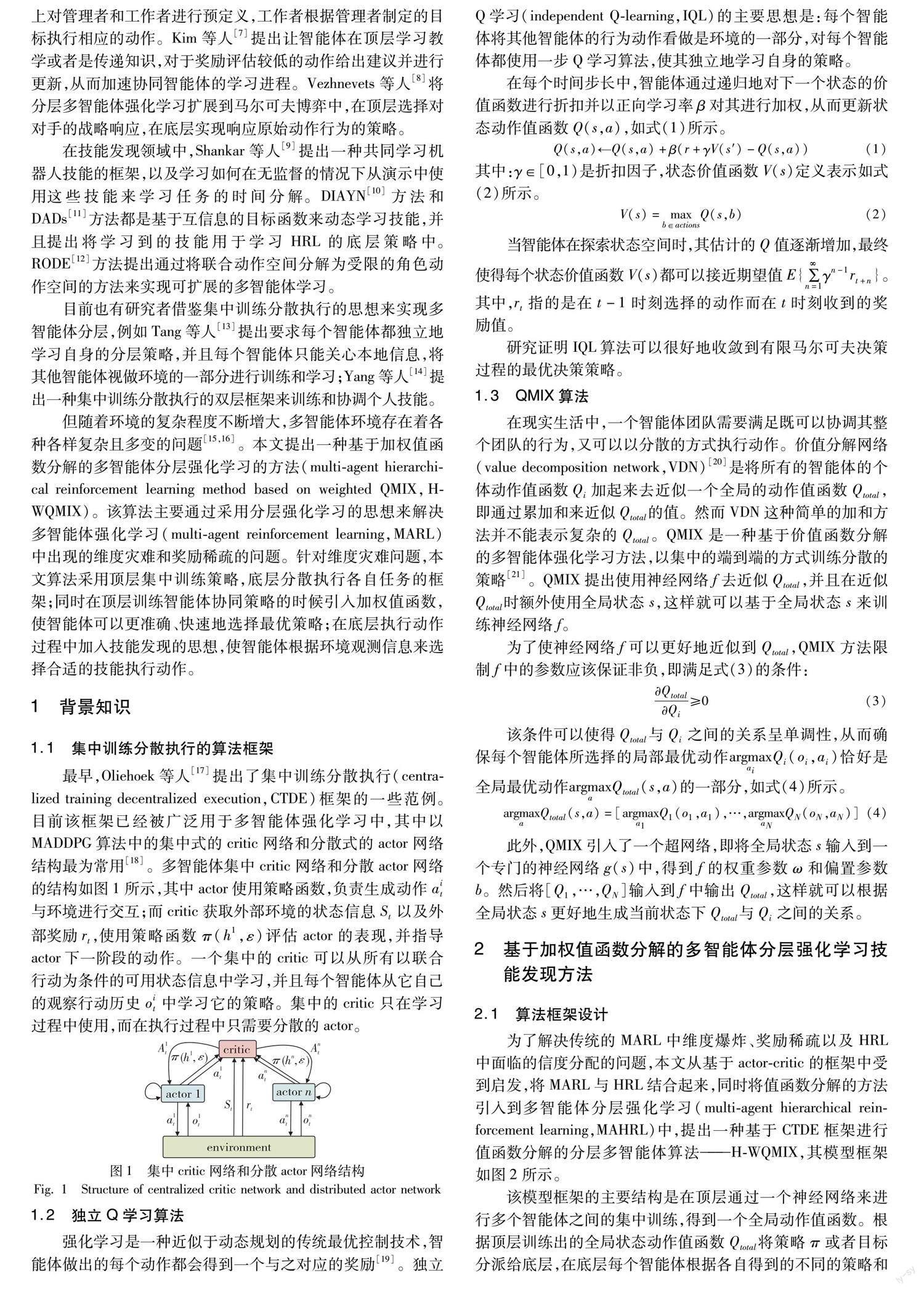

1.1 集中训练分散执行的算法框架

最早,Oliehoek等人[17]提出了集中训练分散执行(centra-lized training decentralized execution,CTDE)框架的一些范例。目前该框架已经被广泛用于多智能体强化学习中,其中以MADDPG算法中的集中式的critic网络和分散式的actor网络结构最为常用[18]。多智能体集中critic网络和分散actor网络的结构如图1所示,其中actor使用策略函数,负责生成动作ait与环境进行交互;而critic获取外部环境的状态信息St以及外部奖励rt,使用策略函数π(h1,ε)评估actor的表现,并指导actor下一阶段的动作。一个集中的critic可以从所有以联合行动为条件的可用状态信息中学习,并且每个智能体从它自己的观察行动历史oit中学习它的策略。集中的critic只在学习过程中使用,而在执行过程中只需要分散的actor。

3 仿真设计与结果分析

3.1 实验环境平台搭建

实验硬件环境采用Intel Xeon Silver 4210R CPU+Quadro RTX 6000+32 GB内存;软件环境使用Ubuntu 20.04+TensorFlow+Torch+pygame。为了验证本文算法的性能,采用文献[24]中推出的简易团队运动模拟器(simple team sports simulator,STS2)以及文献[25]中提出的星际争霸Ⅱ微观管理(StarCraft Ⅱ micromanagement,SMAC)两个实验场景。

3.2 简易团队运动模拟器

3.2.1 实验设计

STS2通过有用的技能模拟类似于人类玩家的智能体和传统游戏AI玩家的合作。在模拟器的最底层上,智能体的动作和移动应该与真正的人类玩家相似;在最高层次上,智能体应该学习如何遵循顶层的游戏计划;在中等层次上,智能体应该学会展示技能和协调彼此的动作。本文所涉及的训练是在一个中级的模拟器上进行的,该模拟器将游戏规则和物理元素植入一个高层次的层面,并将低层次的战术抽象出来。模拟器支持任意正整数N的N对抗 N匹配。两支球队显示为红色(主场)和白色(客场),如图6所示(红色为在左侧球场得分的本地智能体,白色为在右侧球场得分的AI玩家,被黑色圈住的智能体为控球者(见电子版))。传统游戏AI玩家由少量规则和约束组成,这些规则和约束控制着智能体的游戏策略。模拟器的状态信息主要包含每个队球员的坐标位置和速度等,离散动作集合包含前进、后退、左移、右移、传球、射门、什么都不做。

在本文实验设置中,主要设置在3v3的模式下进行训练,训练回合数为50 000次。两队双方各设置三个球员(智能体),通过人类智能体玩家和传统游戏AI玩家的合作进球来获取更高的团队奖励。智能体需要观测除自身之外的其他智能体的动作和相对位置信息以及球门的位置。每个智能体在训练过程中学习不同的技能,球员通过阻断对方进球或者抢夺控球权或者进球获得奖励。团队合作运动场景参数设置如表1所示。其中,Home-players表示我方战队,Away-players表示对方战队;α用于决定内在奖励和外部团队奖励数量的动态权重。首先设置α=αthreshold,其中αthreshold表示阈值,在训练评估过程中如果胜率超过这个阈值,则α值将会降低αstep。在α值较高时,底层的策略进行自主学习要执行的动作,通过选择有用的动作来最大化团队奖励。随着α的不断降低,底层策略跟顶层的技能相关联,在技能不同的情况下通过调整自己的动作行为来获得更多的内在奖励。

在本文所设置的团队运动场景中,球队双方的奖励主要来自以下两个方面:

a)球队双方是否进球的奖励定义,如式(12)所示。

R1=+1 球队进球-1 对方球队进球(12)

b)双方球队从对方手中夺得控球权的奖励定义,如式(13)所示。

R2=+0.1 球队夺得控球权-0.1 对方球队夺得控球權(13)

球员(agent)每个回合获得的总奖励定义为RA=R1+R2。

3.2.2 实验结果与讨论

在本文算法中,顶层网络输入的是一个具体的状态。经过两层隐藏层,第一层的单元数设置为128,第二层的单元数设置为256。通过增加第二层的单元数,算法可以较之前更收敛,通过顶层的前向网络输出维数为64的全局Q值;底层网络的两个隐藏层每层的单元数为64,最后输出当前智能体的动作。

同时设置一个记忆缓冲池将技能zi和轨迹τ存储到缓冲池中,每次再从缓冲池中选择zi和τ来更新训练。实验的基本参数设置如表2所示。其中:buffer_size表示的是缓冲池大小;batch_size表示的是批尺寸;gamma表示的是折扣因子;tau表示网络超参数;lr_Q表示的是顶层的网络学习率;lr_actor表示的是底层actor网络的学习率。

本文首先研究了改变顶层权重函数参数的影响,当满足式(8)中的条件,权重函数的参数为ω。如图7所示,随着ω值的不断增加,球队的胜率越来越低,性能也越来越差。当设置ω=0.7时,球队的胜率最低达到了10%以下。当ω值不断减小时,胜率的波动区间较大,但最高胜率也未超过50%。所以由图7可得,当设置参数为ω=0.5时,性能最好,方差相较之下最小,球队的胜率较其他的参数设置胜率更高。

为了评估在团体合作运动中各智能体的学习效率,本文算法在STS2模拟器中与HSD、QMIX、IQL方法进行对比。通过50 000回合的迭代评估来训练该算法模型,得到的算法平均奖励和总奖励结果如表3所示。

从表3中可以看出,在相同的参数设置和环境条件下,本文算法的平均奖励比HSD方法高了0.072,比QMIX方法高了0.078,比IQL方法高了0.165。其中,虽然HSD采取了分层的结构训练策略,但是HSD并没有很好地估计全局Q值,导致其探索的速率稍慢。并且本文方法的方差与其他三个方法相比更低,收敛更稳定,性能更好。

同时,记录了每100步的平均奖励并绘制出与其他算法相比的平均奖励曲线,如图8所示。

根据图8可以看出,对比于另外三种方法,本文方法在5 000回合之后出现较明显的上升趋势,并且在大约10 000回合的时候开始收敛,而另外三种方法在大约17 000回合的时候开始逐渐收敛,本文方法比另外三种方法收敛得更快,且平均奖励在另外三种方法之上。尽管QMIX和IQL方法在多智能体的协作中可以达到很好的效果,但是在此环境的团队运动合作中,分层比非分层的学习效果更好。与HSD方法相比,本文方法在HSD方法的基础上增加权重函数,可以更加准确地计算智能体的Q值,从而获得更高的奖励。

另外,记录了每100个回合中球员(agent)击败对手队伍的胜率,针对不同算法的胜率曲线如图9所示。

从图9可以看出,尽管在训练前期,本文方法波动较大,但是在大约20 000回合之后本文方法的胜率基本上都会略高于其他三个方法,胜率最高可以达到70%。在20 000回合之后,H-WQMIX训练的智能体逐渐能够根据自己的位置信息选择更合适的技能来更好地协调多个智能体之间的合作,进而提高在每个回合中击败对手的胜率。

为了进一步验证本文算法的实验性能,分别在STS2模拟器的参数设置中设置不同的人类智能体玩家和传统AI玩家的智能体数量进行实验验证。算法的胜败次数对比如表4所示。

从表4可以看出,在本文设置的约100个测试集中,尽管本文算法在全人类玩家训练时性能不及QMIX,但是当队伍中有一个或者两个队友被脚本机器人取代时,H-WQMIX仍然可以表现得很好,这是由于H-WQMIX的底层策略开始是独立训练的,在胜率达到一定的阈值之后与顶层相结合一起选择合适的技能来训练。而QMIX和IQL方法表现越来越差,这可能是由于未当经过训练的机器人加入队伍时,会给原本依靠完全集中训练的智能体制造很大的困难,导致其性能低下。

3.3 Linux星际争霸Ⅱ平台

3.3.1 实验设计

为了进一步验证本文算法的性能,选择星际争霸Ⅱ平台作为其丰富环境和高复杂性环境的测试平台。在星际争霸Ⅱ的常规完整游戏中,一个或多个人类相互竞争或与内置游戏AI进行竞争,以收集资源、建造建筑、组建军队来击败对手。SMAC由一组星际争霸Ⅱ微场景组成,旨在评估独立智能体协调解决复杂任务的能力。每一个场景都是两个军队单位之间的对抗。本文设置每个智能体特工的行动可以向东南西北四个主要方向移动、停止、什么也不做或者在每个时间步选择一个敌人进行攻击。

本文将所有地图的缩放因子λe设置为10,并收集实验样本,利用式(9)所述的损失函数分别训练200万个和500万个时间步长的预测模型,同时设置batch_size为32进行训练。

3.3.2 实验结果与讨论

SMAC地图分为简单模式、困难模式以及超难模式三种。为了验证本文算法在复杂环境中的性能,主要测试算法在困难地图模式(2c_vs_64zg)和超难地图模式(3s5z_vs_3s6z、corridor、MMM2)下的性能。

在困难地图模式(2c_vs_64zg)下,如图10所示。算法在执行200万步的时候效果就已经十分明显并且逐渐趋于平稳,且H-WQMIX算法始终优于其他算法。

在超难地图模式(3s5z_vs_3s6z)下,算法在训练后期才会出现较为明显的训练结果。如图11所示,在地图中,3名潜行者和5名狂热者试图击败3名敌方潜行者和6名敌方狂热者。尽管前期没有很快地学习到好的策略,但是在后期H-WQMIX算法胜率始终高于其他算法。

与3s5z_vs_3s6z 地图不同的是,在超难地图模式(corridor)中,6名狂热者面对24名敌方虫族,所有的攻击动作都具有相似的效果,因为敌人都是同质的。如图12所示,算法在训练的前期效果并不是很理想,尽管在训练后期没有达到收敛的效果,但本文算法的胜率仍然远远高于其他算法。

在超难地图模式(MMM2)中,双方军队由1个医疗救护队,2个掠夺者和7个陆战队员对战1个医疗救护队,3个掠夺者和8个陆战队员,只有当医疗救护队出现之后,对抗才开始具备战斗力。

如图13所示,H-WQMIX算法虽然相较于QMIX方法并没有十分明显的优势,但是较于其他几个算法仍然具有很大的优势。

同时,根据以上数据可以得出,H-WQMIX算法在困难地图模式中的胜率比其他算法平均提高了约18%;在超难地图模式中的胜率比其他算法平均提升了约23%。尽管在MMM2地图中与QMIX方法性能相差不大,但是从收敛效果看,本文算法仍然优于其他几个算法,并且与HSD方法相比具有更好的迁移性。总的来说,本文方法在SMAC场景中仍然可以保持较好的性能。

4 结束语

本文提出了一种基于加权值函数分解的多智能体分层强化学习方法来发现在团队活动中有用的技能。本文通过集中训练分散执行的框架分别训练算法的顶层策略和底层策略,并通过内外奖励结合机制来解决智能体之间的奖励稀疏以及信度分配的问题。通过对值函数进行加权来提高智能体动作的有效性,更加准确地评估智能体的行为动作,从而获得更高的奖励,加快了智能体的学习和探索效率。分别在STS2模拟器和星际争霸Ⅱ平台上验证了本文算法的性能和有效性,从实验结果可以看出,本文算法在较为简单和稍加复杂的场景中仍然可以保持较好的训练性能,获得更高的胜率。实验结果表明,该算法在不同的操作系统以及实验平台上都表现出了较好的性能,具有十分重要的应用价值,为后期将其应用在实际开发环境中奠定了十分重要的基础。近些年来,DeepMind、OpenAI等人工智能实验室以及国外著名大学研究实验室,清华大学智能技术与系统国家重点实验室以及华为诺亚方舟实验室等多个国内外实验室针对多智能体强化学习和分层强化学习的多项研究成果在星际争霸Ⅱ以及团队运动游戏实验平台上都展现了很好的效果,并将其应用在解决智能决策、资源智能化调配、交通控制等民用领域中,同时也应用在可以解决异构的多智能体各类战略协同的军事领域中。

在未来,将进一步研究子任務分配的问题,以简化和加快智能体的训练步骤。同时可以引入课程学习和策略迁移的思想,将分层强化学习扩展到解决更多更复杂大型的多智能体任务中。

参考文献:

[1]殷昌盛,杨若鹏,朱巍,等. 多智能体分层强化学习综述 [J]. 智能系统学报,2020,15(4): 646-655. (Yin Changsheng,Yang Ruopeng,Zhu Wei,et al. A survey on multi-agent hierarchical reinforcement learning [J]. CAAI Trans on Intelligent Systems,2020,15(4): 646-655.)

[2]Gronauer S,Diepold K. Multi-agent deep reinforcement learning: a survey [J]. Artificial Intelligence Review,2022,55(2): 895-943.

[3]Dietterich T G. Hierarchical reinforcement learning with the MAXQ value function decomposition [J]. Journal of Artificial Intelligence Research,2000,13(1): 227-303.

[4]Ahilan S,Dayan P. Feudal multi-agent hierarchies for cooperative reinforcement learning [C]// Proc of the 4th Multidisciplinary Confe-rence on Reinforcement Learning and Decision Making. Cambridge,MA: JMLR Press,2019: 57.

[5]Dayan P,Hinton G E. Feudal reinforcement learning [J]. Advances in Neural Information Processing Systems,1992,5: 271-278.

[6]Vezhnevets A S,Osindero S,Schaul T,et al. Feudal networks for hie-rarchical reinforcement learning [C]// Proc of the 34th International Conference on Machine Learning. Edmore,MI: JMLR Press,2017: 3540-3549.

[7]Kim D K,Liu Miao,Omidshafiei S,et al. Learning hierarchical tea-ching in cooperative multiagent reinforcement learning [EB/OL]. (2019) [2022-11-15]. https://arxiv. org/pdf/1903. 03216v2. pdf.

[8]Vezhnevets A,Wu Yuhuai,Eckstein M,et al. Options as responses: grounding behavioural hierarchies in multi-agent reinforcement lear-ning [C]// Proc of the 37th International Conference on Machine Learning. Edmore,MI: JMLR Press,2020: 9733-9742.

[9]Shankar T,Gupta A. Learning robot skills with temporal variational inference [C]// Proc of the 37th International Conference on Machine Learning. Edmore,MI: JMLR Press,2020: 8624-8633.

[10]Eysenbach B,Gupta A,Ibarz J,et al. Diversity is all you need: lear-ning skills without a reward function [C]// Proc of the 6th Internatio-nal Conference on Learning Representations. Edmore,MI: JMLR Press,2018: 1-22.

[11]Sharma A,Gu S,Levine S,et al. Dynamics-aware unsupervised discovery of skills [C]// Proc of the 7th International Conference on Learning Representations. Berkeley,CA: PMLR Press,2019: 1-21.

[12]Wang Tonghan,Gupta T,Mahajan A,et al. RODE: learning roles to decompose multi-agent tasks [EB/OL]. (2020) [2022-11-20]. https://arxiv. org/pdf/2010. 01523. pdf.

[13]Tang Hongyao,Hao Jianye,Lyu Tangjie,et al. Hierarchical deep multiagent reinforcement learning with temporal abstraction [EB/OL]. (2018) [2022-12-01]. https://arxiv. org/pdf/1809. 09332. pdf.

[14]Yang Jiachen,Borovikov I,Zha Hongyuan. Hierarchical cooperative multi-agent reinforcement learning with skill discovery [C]// Proc of the 19th International Conference on Autonomous Agents and Multi-agent Systems.2020: 1566-1574.

[15]曹潔,邵紫旋,侯亮. 基于分层强化学习的自动驾驶车辆掉头问题研究 [J]. 计算机应用研究,2022,39(10): 3008-3012,3045. (Cao Jie,Shao Zixuan,Hou Liang. Research on autonomous vehicle U-turn problem based on hierarchical reinforcement learning [J]. Application Research of Computers,2022,39(10): 3008-3012,3045.)

[16]Zhang Kaiqing,Yang ZhuoranT. Multi-agent reinforcement learning: a selective overview of theories and algorithms [J]. Stu-dies in Systems,Decision and Control,2021,325: 321-384.

[17]Oliehoek F A,Spaan M T J,Vlassis N. Optimal and approximate Q-value functions for decentralized POMDPs [J]. Journal of Artificial Intelligence Research,2008,32(1): 289-353.

[18]Lowe R,Wu Y,Tamar A,et al. Multi-agent actor-critic for mixed cooperative-competitive environments [C]// Proc of the 31st International Conference on Neural Information Processing Systems. Red Hook,NY: Curran Associates Inc.,2017: 6382-6393.

[19]Tan Ming. Multi-agent reinforcement learning: independent vs. coo-perative agents [C]// Proc of the 10th International Conference on Machine Learning. San Francisco,CA: Morgan Kaufmann Publi-shers,1993: 330-337.

[20]Sunehag P,Lever G,Gruslys A,et al. Value-decomposition networks for cooperative multi-agent learning based on team reward [C]// Proc of the 17th International Conference on Autonomous Agents and Multiagent Systems. 2018: 2085-2087.

[21]Rashid T,Samvelyan M,Schroeder C,et al. QMIX: monotonic value function factorisation for deep multi-agent reinforcement learning [C]// Proc of the 35th International Conference on Machine Lear-ning.2018: 4295-4304.

[22]Rashid T,Farquhar G,Peng Bei,et al. Weighted QMIX: expanding monotonic value function factorisation for deep multi-agent reinforcement learning [J]. Advances in Neural Information Processing Systems,2020,33: 10199-10210.

[23]Ding Fan,Zhu Fei. HLifeRL: a hierarchical lifelong reinforcement learning framework [J]. Journal of King Saud University-Computer and Information Sciences,2022,34(7): 4312-4321.

[24]Zhao Yunqi,Borovikov I,Rupert J,et al.On multi-agent learning in team sports games[EB/OL].(2019)[2023-02-19].https://arxiv.53yu.com/pdf/1906.10124.pdf.

[25]Samvelyan M,Rashid T,De Witt C S,et al. The StarCraft multi-agent challenge [C]// Proc of the 18th International Conference on Auto-nomous Agents and Multiagent Systems. Rech Land,SC: IFAAMAS.org,2019: 2186-2188.

收稿日期:2022-12-10;修回日期:2023-02-22 基金項目:国家自然科学基金资助项目(61673084);2021年辽宁省教育厅项目(LJKZ1180)

作者简介:邹启杰(1978-),女,山东黄县人,副教授,硕导,博士,主要研究方向为智能驾驶、计算机视觉、智能规划与决策;李文雪(1997-),女(通信作者),山东临沂人,硕士,主要研究方向为多智能体深度强化学习、分层强化学习(li_wenx@163.com);高兵(1976-),男,辽宁铁岭人,副教授,硕导,博士,主要研究方向为大数据分析、知识图谱;赵锡玲(1999-),女,山东济南人,硕士研究生,主要研究方向为分层强化学习;张汝波(1963-),男,吉林人,教授,院长,主要研究方向为强化学习、智能规划

.