四维标注在智能驾驶BEV感知中的应用

张盼盼,宋佳顺

(1. 北京华为数字技术有限公司,北京 100095; 2. 上海科之锐人才咨询有限公司北京分公司,北京 100020)

车辆感知作为高等级辅助驾驶产品的关键要素之一,是以多种传感器的数据与高精度地图的信息为输入,经过一系列的计算及处理,对自动驾驶车的周围环境精确感知的系统,相当于人眼。能否准确识别静态和动态物体是智能驾驶产品竞争力的评价指标之一[1-2]。

车辆感知模型的训练需要大量的数据支撑[3],传统标注主要是对二维图像进行框点标注、对三维点云数据进行三维框标注[4],这种标注方法对于单通道感知模型而言已足够且技术相对成熟。

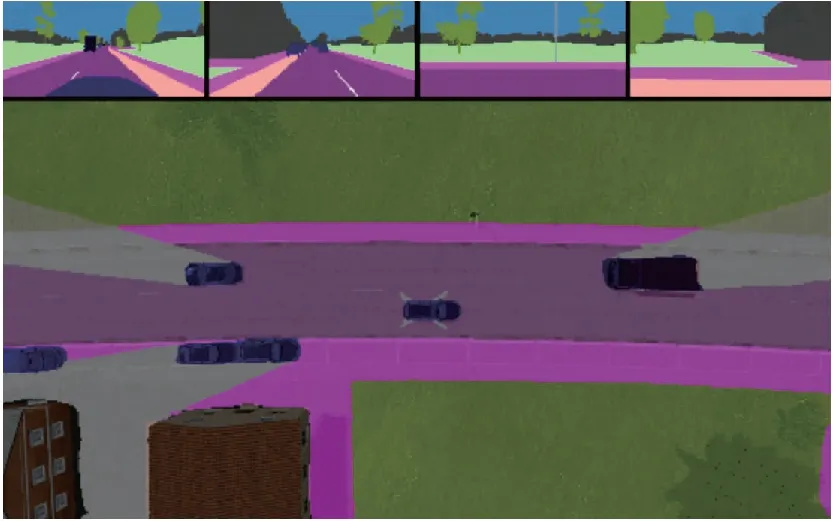

BEV(bird’s-eye view)感知,即俯视图下的感知技术,是基于多个摄像头的图像输入,推断出鸟瞰视角下的车辆周围环境信息,如图1所示。

图1 BEV感知示意

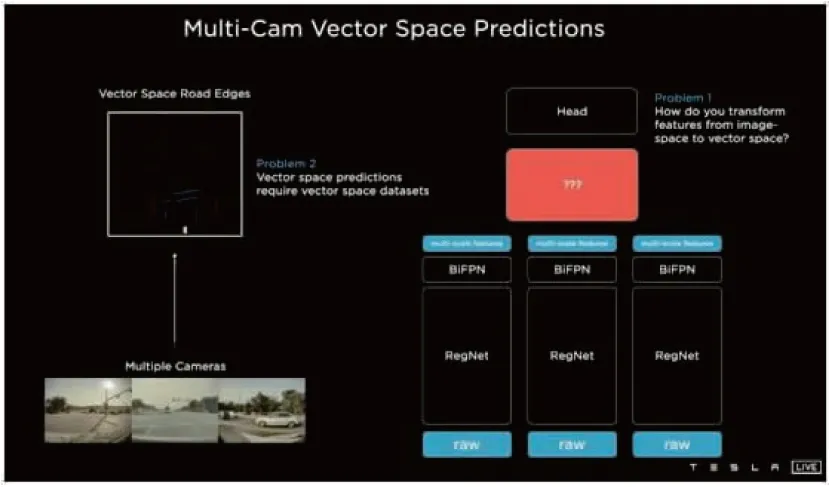

随着特斯拉FSD高等级辅助驾驶产品(L2+)的商业化实施,6个摄像头通道数据甚至更多的传感器数据引进后,实现感知结果的融合,输出唯一稳定的感知结果,成为一个重要的课题。端到端的感知对数据标注提出了新的要求。无论是特斯拉AI Day,还是行业“重感知、轻地图”的提议,新感知都倾向于直接在三维向量空间输出局部地图,同时也期望解决遮挡物体的感知能力。因此,需要构建一个从输入图像到输出局部地图的神经网络,在这个过程中需要有大量有效的标注样本训练出一个好的感知模型。

1 感知面临的问题

开展BEV视角的感知工作,除了更好地做多传感器融合外,最主要的是BEV结果更加适合下游预测和规划的任务,以及解决通过规则的方式从二维提升至三维所带来的不可扩展性[5]。

现在主流的规划和控制算法,都是在物理的、笛卡尔坐标系中展开的。因此,无论上游的传感器信息来自什么视角,经过传感器融合(sensor fusion)模块后,一般都会转换到以自车为中心的坐标系中(vehicle coordinate system,VCS)。由于车在地面上,因此实际上VCS坐标系中的x和y平面上的感知结果最为重要,即BEV感知结果所输出的空间。

传统的机器学习问题设定都是在图像空间(检测是在图像上画框、语义分割是标出每个像素点的类别),对于自动驾驶,摄像头仅拍到对面的行人和车在图像上的位置是不够的,需要恢复到物理世界的坐标和向量空间。大部分公司采取的方案是先通过模型得到图像坐标,然后通过编程得到向量空间的坐标。但从图像坐标到向量空间坐标的数据是相关的,转换代码变得极复杂且难以扩展(不断出现新的长尾问题,否则不断膨胀)[6]。

此外,当每个摄像头通道在感知同一地物(如空中标牌),且在融合唯一的地物时,不可避免会出现不唯一的情况,即错位,如图2所示。

图2 多通道相机后融合问题(来自特斯拉AI Day视频)

传统的数据标注方法,无论是二维图像框点标注还是三维框标注,都是针对单帧数据的标注,未考虑时间维度的时序信息,既不能解决要素遮挡问题,也无法解决数据融合质量问题。因此,寻找一种有效解决因多传感器感知造成的数据不一致的问题,是该技术方案主要探讨的内容。

2 解决方案

从解题思路上看,多通道图像感知融合输出的标注结果本质上与高精地图相似[7],主要体现为以下几点。

(1)多通道感知所输出的唯一解是车辆当前所在位置的局部地图,也包括动态物体信息。

(2)理论上,每个通道内的感知信息与局部地图呈映射关系,且地图是三维场景下的精确表达。

唯一差异点为高精地图只关注三维空间的标注,而本文提出的四维标注还会引入时序信息,解决标注效率和物体遮挡标注等问题。四维标注是三维空间+时间维度的联合标注方式。

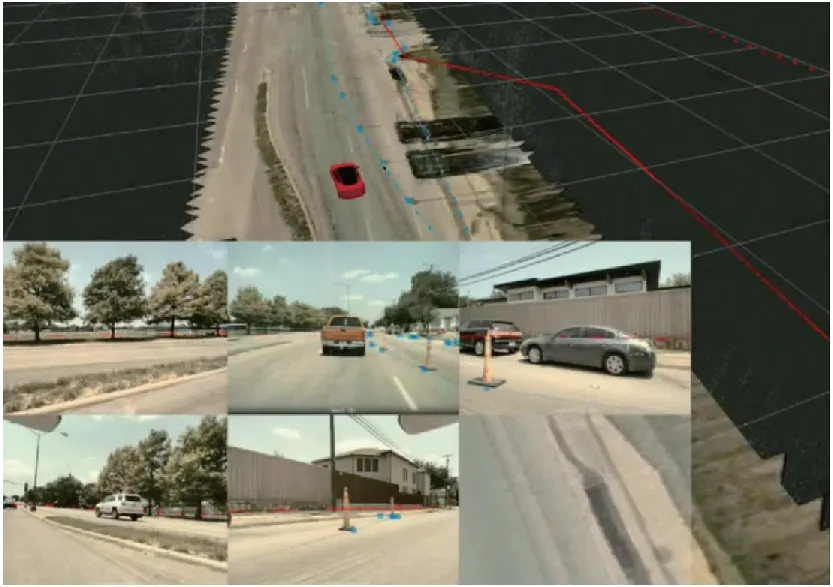

可以直接采用模型估计向量空间。因此,需要与之相对应的训练数据。标注系统会把6个摄像头的图像信息映射到向量空间(像素点映射到向量空间),如图3所示。标注人员在向量空间标注(标注静态物体,如车道线、路沿、路面、人行道、交通标志牌等)。标注系统会把标注员的标注同时映射到各个摄像头的图像上,标注员可以进一步调整,保证在各个摄像头上的标注是一致的。如图3中蓝色的线可能是标注为不可行驶区域,红色的线标注为路沿。标注员可以改变视角,保证标注合理的高度(本文均是贴在地面)。

图3 四维标注示例(来自特斯拉AI Day视频)

数据标注解决的是提供现实世界静态数据(车道线、交通标牌等)的快速标注[8],在三维环境下标注一个静态数据要素,联动标注该三维要素在多趟观测多个视角(如6v视角)下的图像位置,同时解决现实世界动态物体(车辆、行人等)的时序标注,标注每个物体的三维位置,联动标注到图像空间,并标注动态物体的运动轨迹。

从采集的每一时刻原始数据开始,到重建三维空间,再到在三维空间去标注现实世界的任意物体,可以快速投影对照到图像空间,修正细化标注结果,从而获取高质量的标注样本,用于训练BEV等感知模型,让机器具备超强的感知能力。

3 技术路线和试验结果

当数据采集车在实际道路上行驶并收集回传每一时刻获取的图像数据和点云数据时,首先云端算法模块进行三维空间的点云重建,将一定时间内的数据重建合成局部三维点云数据;然后标注员在三维空间内进行车道线、交通标牌等感知要素标注,可以在反投影的图像空间同步显示标注效果,经调整后可以输出高质量的标注样本,用于训练模型,让模型具有自动标注能力;最后通过反复迭代,自动标注能力越来越强,系统可更加快速且低成本地实现标注。样本积累到一定程度,可用于训练端侧的感知模型,提升自动驾驶感知能力,真正实现端到端的感知。具体技术路线如图4所示。

图4 四维标注技术路线

3.1 点云重建

从技术路线上看,点云重建是在采集并回传数据的基础上,通过一定算法在三维空间进行的立体重建。以纯视觉方案为例,搭载了6个摄像头的采集车在北京某区域内从不同方向、不同车道进行数据采集,可以得到多趟数据,包括6v图像、GPS轨迹、轮速计等信息,这是点云重建的输入。点云重建需要经过单次重建和全局聚合等操作后才能获取较高质量的有效点云数据。

单次重建是利用原始图像和轨迹等信息,通过SFM等算法获取高精度自车位置和姿态。具体原理为:首先通过轮速计和GPS/IMU获取自车的大致位置和姿态,主要用于指导图像匹配;然后通过粗略轨迹在空间中提取出同名点,输入给SFM算法[9],获取自车高精度无尺度姿态;最后引入CAN和GPS估计,恢复SFM的尺度信息,从而得到自车高精度位置和姿态信息[10-11]。单次重建输出的是每个视频片段(clip)的单次重建结果,而对于同一区域,实际上是由多个clip构成的,由于不同车辆或同一车辆行驶在不同车道上进行数据采集,因此,单次重建完成后需要进行全局聚合。

全局聚合是在单次重建的基础上,通过寻找clip间的同名点作全局对齐和融合,对原有的clip信息进行增量重建,通过连续的clip聚合处理,最终融合成一个局部区域的三维点云数据。为更近一步获取稠密清晰的点云数据,算法采用传统的多视图立体(MVS)稠密重建[12-13],在单次SFM基础上,对每个clip对进行特征提取和立体匹配,生成稠密点云。

图5为某区域纯视觉点云重建的效果。可以看出,地面的车道线、停止线、斑马线及空中的红绿灯等要素都能够被清晰地重建,甚至道路两侧的建筑物也清晰可见。

图5 点云重建示例

点云数据采集后,可从0至1进行要素标注,也可在积累了一定样本数据且让自动标注模型具备能力后,直接进行模型预刷,生成预标注结果。

3.2 自动标注

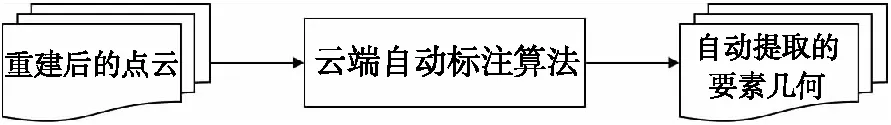

从实际量产需求看,点云重建后靠人工标注几乎是无法达成目标的。人和计算机有不同的优缺点,人擅长标注语义类的东西,而计算机擅长几何、重建、三角化、跟踪,因此引入自动标注可极大提升标注效率[14],替代很大一部分人工繁重的工作。

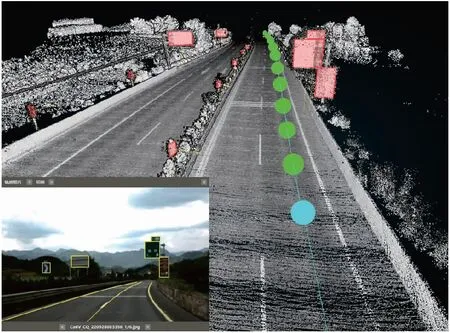

图6为自动标注的输入输出示意图,算法可对某一小区域重建的三维点云数据自动化提取要素特征信息,如地面的车道线、停止线、空中的交通标牌等信息几何和相关属性,提取的要素信息取决于自动标注模型的设计。

图6 自动标注业务

为让云端自动标注模型具备自动提取要素的能力,需要用大量的标注样本训练模型。标注员在重建后的点云数据上,采用人工标注方式对点云数据进行要素标注,标注车道线、交通标牌等,标注完成每个点云数据后,形成点云及对应的要素矢量数据,将这些样本输入自动标注模型后,经过不断的训练可输出一个较稳健的云端自动标注模型。当新采集一批数据后,先经过三维点云重建生成点云数据后,输入云端自动标注大模型进行预测,可以实现要素自动化提取。

仅通过机器的自动化处理,输出的要素几何和属性信息能够达到一定的准确率和召回率指标,但仍然需要少量的人工校验和修正,才能输出满足质量要素的训练样本。

3.3 人工标注

无论是早期用于自动标注算法的样本生产,还是后期对自动标注结果的检查修正,都离不开人工标注环节。

在人工标注工具上,四维标注不同于传统的三维标注工具,需要支持时序信息的引入。在标注工具上,支持将三维空间内所标注的要素信息实时投影至每一帧的所有图像通道上,并支持在图像空间内的编辑操作,效果如下。

(1)如果点云数据质量不好或重建的点云有缺失,如交通标牌缺了一边,那么完全依赖于点云上的标注较盲目,甚至是直接丢弃。通过反投影到图像空间上,可以实时看到图像上标注的效果,若叠加图像效果不好,可随时在二维或三维上进行调整,极大提升了标注的样本质量。

(2)如果因遮挡导致在点云上没有要素,那么要素的标注会有缺失。通过该区域的不同车道行驶的轨迹和图像信息,在其他轨迹上找到未遮挡的信息成为可能,这时该轨迹和图像可以作为标注的参考,标注完成后再通过投影的方式可以实现所有轨迹图像信息的标注,即便遮挡也能实现标注,最终使模型具备遮挡预测的能力。

(3)同一区域采集过多次,有多条轨迹和图像数据,在三维空间内只需要标注一次,透过反投影至图像的功能,可以快速实现所有轨迹图像的标注,真正实现对样本的一次标注,大大提升样本生产的效率。

本文涉及两个关键功能点:一个是相机畸变改正;另一个是三维投影二维功能。

图7为人工标注工具的一个效果。可以看出,浅蓝色方块对应的是一条轨迹上的一个时刻点,左下角是该时刻点车辆6个摄像头(左前视、前视、右前视、左后视、后视、右后视)拍摄的图像信息,通过切换,可选择查看不同视角摄像头图片。在三维空间标注的车道线和交通标牌可以实时投影到图像空间中,辅助标注。

图7 人工标注工具示意

4 总结与讨论

从自动驾驶行业未来发展趋势来看,随着L2+级别城市NOA的逐步落地,重感知技术路线必然会推动端到端感知成为一个强需求,四维标注的重要性占比将越来越大,高效生产高质量的标注样本是未来争夺的控制点之一。本文主要通过分析当前行业感知面临的问题,从现阶段主流标注业务局限性出发,受来自高精地图数据制作的灵感[15]启发,提出了一种四维标注方法,并将BEV感知的高质量样本生产方案运用到实际试验中,证实了可行性。

虽本文方案可有效地解决BEV感知模型训练样本的生产,但仍然需要持续对方案中涉及的核心技术点进行深入研究和应用试验。在本文的基础上,今后将从以下两方面重点展开研究。

(1)三维点云重建。点云重建是四维标注的基础条件,不同的车辆传感器配置方案对三维点云重建的适应性、重建质量和效果都可能不同,需要进一步研究。

(2)自动标注。自动标注是四维标注的核心,深化自动标注模型设计、提升标注精度和召回率需要持续不断进行研究。