基于孪生网络的异源遥感影像动态目标对象级变化检测

夏凡凡 肖志峰 谈筱薇 王凯

(1.武汉大学测绘遥感信息工程国家重点实验室,湖北 武汉 430079;2.武汉大学遥感信息工程学院,湖北 武汉 430079)

变化检测广泛应用于土地利用变化监测[1]、灾害识别[2]等领域。近年来,变化检测技术实现了从像素级变化检测到对象级变化检测,从二值变化检测到语义变化检测,从面向同源光学遥感数据到面向异源遥感数据三方面的发展。

“从像素级变化检测到对象级变化检测”,旨在解决噪声或混合像元的存在给土地覆盖类型变化检测带来干扰混淆的问题[3]。使用证据理论和形态学知识将基于像素的结果扩展到基于对象的结果。DCA-Det[4]提出一种单阶段对象级变化检测网络,解决建筑物变化检测问题。“从二值变化检测到语义变化检测”,强调前一时相与后一时相图像中对象具体类别转变的检测,而不是仅识别出“变化”和“不变”两种状态[5]。将语义变化检测视为两步分类任务——对象实例分割和变化检测[6],以端到端的方式完成了整个过程。“从面向同源光学遥感数据到面向异源遥感数据”,是指利用来自多个传感器的多时相数据进行变化检测,其关键是在异构数据中找到地物的特征一致性[7],发现地物在光学和SAR 数据上具有局部结构一致性[8],发现了Landsat-5 和Landsat-7 对于同类地物的光谱一致性。

尽管基于多时相遥感数据的变化检测技术取得了巨大进步,但仍存在许多挑战[9]。船舶或飞机等动态目标的实时状态和状态变化是异常检测和监测的重要基础,但基于这些动态目标的变化检测的研究较少。此外,随着遥感技术的发展,可获取的多传感器、多时相遥感影像越来越丰富,但目前公开的变化检测数据集仍以光学影像为主,缺乏包含异源数据的数据集。

论文针对现阶段变化检测的主要挑战,提出了一种面向多时相光学和SAR 遥感影像中动态目标的对象级变化检测方法,构建基于孪生网络的对象级变化检测框架,对异源遥感数据深度语义特征图提取和语义特征相似度的定量描述,判别异源影像上动态目标的状态变化。同时提出对象级变化检测数据集OCD3k,利用OCD3k 数据集和两组高分二号和高分三号卫星影像,验证了该方法的有效性。

1 实验数据

大多数变化检测数据集仅对图像进行了像素级标注,难以应用于对象级变化检测研究。为验证和评估论文方法的有效性,构建了一个对象级变化检测数据集OCD3k,以模拟真实场景下动态目标在不同时相的异源遥感影像上的状态变化。

1.1 OCD3k 数据集

论文从光学遥感图像目标检测数据集DOTA[10]中收集光学影像目标切片,从MSAR[11,12]、Air-SARShip-1.0[13]等SAR 遥感图像目标检测数据集和高分三号卫星影像中收集SAR 影像目标切片。这些数据集标注了图像上目标的边界框和类别,通过以下步骤将这些数据集转换为OCD3k 数据集:

(1)根据原始数据集的标注,通过边界框获取目标的切片,并按类别分组。

(2)所有类分为两大类:动态目标和静态场景。动态目标切片包含从光学图像和SAR 图像中获取的飞机和船只目标切片。静态场景包括棒球场、篮球场、桥梁、操场、港口、十字路口、足球场、油罐、游泳池和网球场。其中,桥梁和油罐既有光学影像切片也有SAR 图像切片,其余静态场景仅包含光学影像切片。

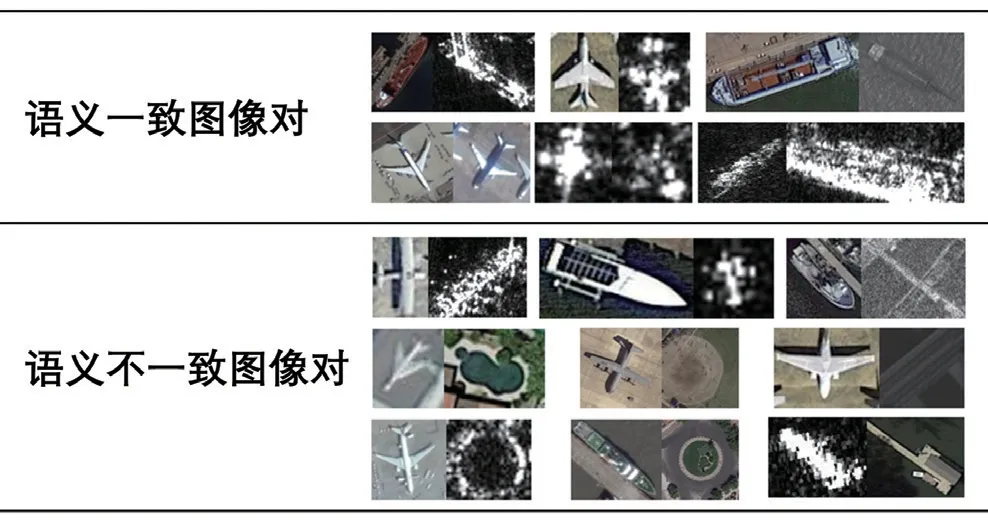

(3)对象级变化检测对划分。所有切片两两组合成图像对。同一类别的两个动态目标被标记为语义不变图像对(对应真实场景中目标状态不变的情况),其余均被标记为语义变化图像对(对应真实场景中目标状态改变的情况)。语义一致图像对和语义不一致图像对示例如图1 所示。

图1 语义一致图像对和语义不一致图像对示例

(4)数据集图片总数为3024 张,训练集、验证集、测试集中,每个传感器每类的图片数之比约为4∶1∶16。记每个传感器每类的图片数为N,静态场景的图片数为Nss,飞机和船的图片总数分别为Npl和Nsh,语义不一致图像对数量为Nlabel=1,语义一致图像对数量为Nlabel= 0:

公式(1)(2)中,C表示组合计算。根据上述规则,可将3024 张图像切片扩充至百万对不重复的对象级变化检测对。OCD3k 数据集图片和图片对的组成如表1 所示。

1.2 高分卫星数据

论文选用两组高分卫星影像,每组由一张分辨率为1m 的高分二号全色波段影像和一张分辨率为3m 的高分三号SAR 影像组成。数据一为新加坡某机场2020 年5 月29 日的高分二号卫星全色波段影像(8305×8721),和2020 年10 月27 日的高分三号卫星影像(8089×8338),该场景包含船只目标图像对130 个,其中状态变化的59 个,状态未变化的71 个。数据二为荷兰某港口2021 年4 月27 日的高分二号卫星全色波段影像(11424×11142),和2020 年10 月23 日的高分三号卫星影像(14091×11127),该场景包含飞机目标图像对203 个,其中状态变化的109 个,状态未变化的94 个。

2 基于孪生网络的异源影像对象级变化检测框架

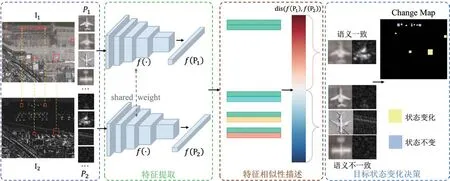

论文提出一种基于孪生网络的对象级变化检测框架。该框架包含异源影像目标特征提取、特征相似性描述以及目标状态变化决策三个阶段,整体框架如图2 所示。在异源影像目标语义特征提取阶段,异源图像目标切片图像作为孪生网络的输入,其深度语义特征通过两个共享参数f(·)的并列子网提取。两个子网输出特征的语义差异在相似性描述阶段进行定量表示。最后,在目标变化决策阶段,差异度大的目标对被标识为发生变化的目标对,反之则为未发生变化的目标对。

图2 基于孪生网络的对象级变化检测框架

2.1 异源影像目标特征提取

记两个时相的影像分别为I1和I2,前一时相影像I1上的任一目标切片记为P1,后一时相影像I2上与P1相同地理位置的目标切片记为P2。孪生网络同时接收两张图片作为输入,与单分支网络相比,保留了输入数据的原始信息。并列的两个子网共享网络参数,分别接收P1和P2作为输入,输出特征图可以表述为:

公式(3)中,t表示第t个卷积层。卷积神经网络中,浅层特征图包含更丰富的细节和位置信息,深层特征图则包含更丰富的语义信息。由于论文主要关注语义信息的变化,因此仅使用最后一个卷积层的特征图,与全连接层连接起来,得到整合后的图像特征。输入图像对中的两张图像分别被编码为f(P1)和f(P2)。

2.2 特征相似性描述

两个特征向量间的距离通常用于衡量特征之间的相似性,其中欧氏距离是最常见的。欧氏距离的定义如下:

欧氏距离保留了特征向量的原始性,平方计算能够对特征间不明显的差异进行放大。但在训练阶段开始时,高维特征向量f(P1)和f(P2)的数值差异很大,使用欧氏距离可能会导致梯度爆炸问题。因此,论文引入余弦距离,将特征向量的差异值拉伸至[0,1]之间。两个特征向量的余弦距离定义为:

2.3 目标状态变化决策

目标状态变化决策阶段通过比较相似性描述模块输出的特征向量间的距离与距离阈值间的关系,将图像对判别为语义一致和语义不一致图像对。判别规则如下:

公式(7)中,变量y表示给图像对赋予的标签,y= 0 表示图像对语义一致,y= 1 表示图像对语义不一致表表示示两张图片特征向量的距离,margin是距离阈值。

通过计算前一时相上的目标,与后一时相相同地理位置图像切片的深度语义特征的距离相似度,在合适的距离阈值下,根据公式(7),给该地理位置的图像对分配标签,判别目标状态是否发生变化。重复上述过程直至给前一时相上所有的目标均分配标签。

3 实验与分析

3.1 实验设置

论文使用在ImageNet[14]上进行预训练的ResNets[15]作为特征提取网络。训练和测试过程在16GB 内存的Tesla-V100 GPU 上进行。训练过程中,使用随机梯度下降(SGD)优化器,动量为0.9,权重衰减为1×10−4。在更改特征维度和主干网络时,保持训练轮次为30,初始学习率为0.01,然后在第18 个和第27 个轮次时分别降低为0.001 和0.0001。网络输入的图像大小为64×64。使用余弦距离时,距离阈值设置为0.6,使用欧氏距离时设置为1.0。

3.2 评估准则

论文使用精确率(Precision,prec)、召回率(Recall,rec)和特异度(Specificity,spec)评估对象级变化检测方法的性能。

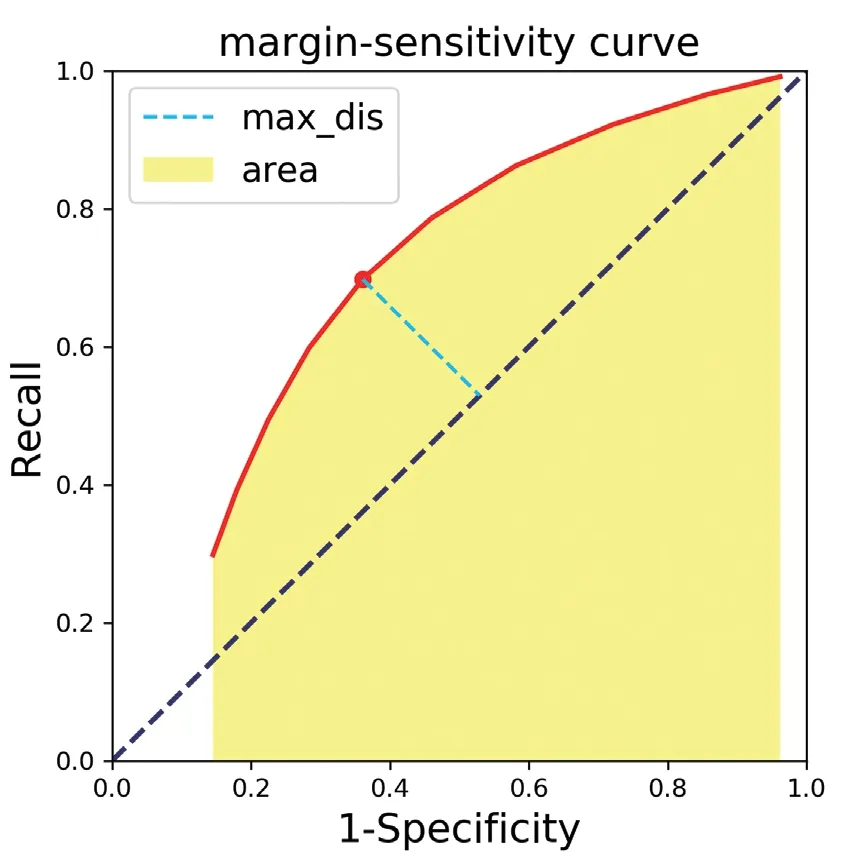

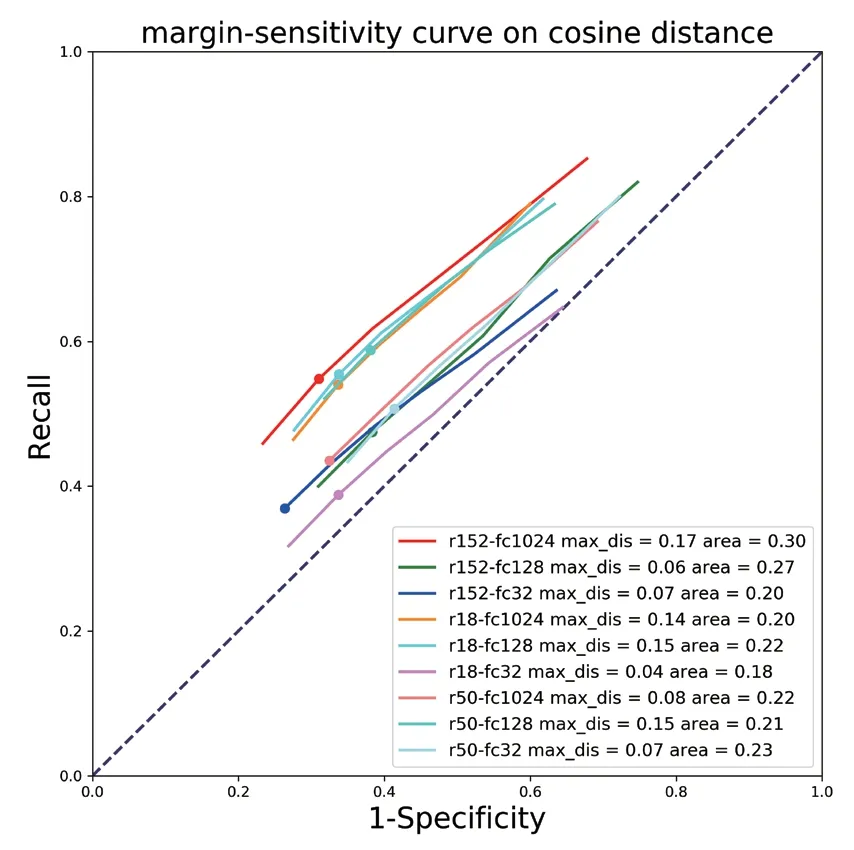

考虑到测试集和训练集的数据差异性较大,训练时用的距离阈值不一定是测试阶段的最优阈值。在ROC 曲线的启发下,以0.1 为间隔,统计在大于0 且小于等于训练阶段距离阈值的所有阈值下的精确度、召回率和特异度指标。绘制 “recall-(1-specificity)”曲线,记为“阈值灵敏性曲线”(Margin-sensitivity Curve),曲线示意图如图3 所示。

图3 阈值灵敏性曲线

和ROC 曲线类似,“阈值灵敏性曲线”图中有一条线通过(0,0)和(1,1)的直线,表示“随机猜测”模型,其在二分类问题中表示的可信度为0.5 的模型。在“随机猜测”线上方的曲线代表有效模型,任意“阈值灵敏性曲线”中,如果一个点比任何其他点离“随机猜测”线更远,即认为模型在对应的距离阈值上表现最佳。与该点对应的指标将被记录为测试集的结果。同时,曲线和x 轴包围的面积越大表示曲线对应模型的性能越高。

3.3 实验结果及分析

3.3.1 OCD3k 数据集实验结果

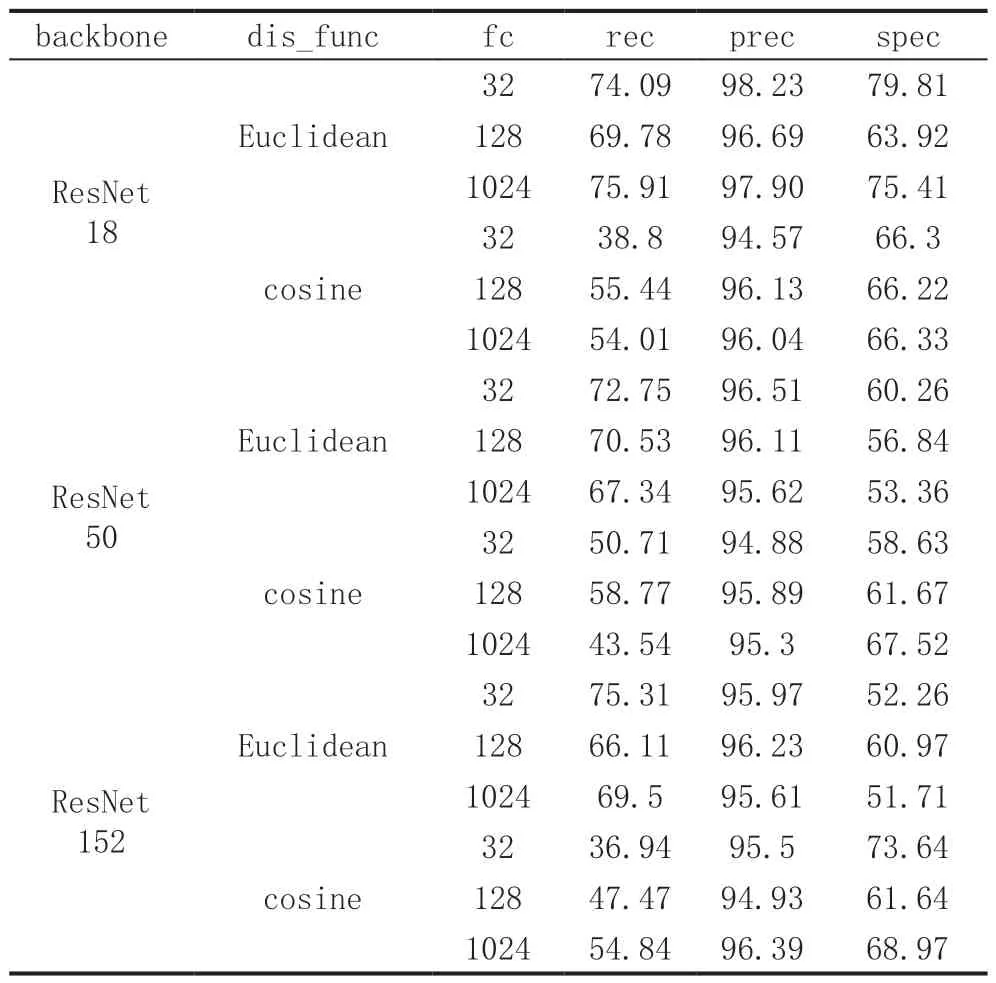

实验在2.1 节所提及的OCD3k 数据集的测试集上进行。表2 统计不同深度的特征提取网络(backbone,分别为ResNet18、ResNet50 和ResNet152)、全连接层特征维度(fc,可设置为32 或128 或152)和损失函数中距离公式(dis_func,cosine 表示使用余弦距离,Euclidean 表示使用欧氏距离)的情况下,每个模型的召回率(rec),精度(prec)和特异性(spec)指标,这些指标依据3.2 节中的“阈值灵敏性曲线”筛选得到。

表2 OCD数据集测试集实验结果

实验结果表明,即使在数据集的组织上,测试集中包含训练集中未出现的语义变化组合,当实验设置不同的“特征提取网络-距离函数-特征维度”(“ backbone -dis_fun-fc”)组合时,所有模型都表现出较高准确率,除“ResNet18-cosine-32”“ResNet50-cosine-32”和“ResNet152- cosine-128”三组设置的模型准确度略低外,其余设置下模型的准确度均高于95.00%,在选用ResNet18 作为主干网络、欧氏距离作为距离函数、全连接层特征维度设置为32 时(“ResNet18-Euclidean-32”),准确度最高,达到98.23%。这表示论文方法不仅能检测经过训练类别间的语义变化,在检测未经训练类别的图像语义变化上也表现出巨大潜能。

使用余弦距离和欧氏距离的模型的“阈值灵敏性曲线”分别如图4 和图5 所示。从表2、图4、图5 分析得出,随着网络层数和特征向量维数的增加,模型在余弦距离和欧氏距离上的表现趋势几乎相反。具体表现为:

图4 距离函数为余弦距离时的阈值灵敏性曲线

图5 距离函数为欧氏距离时的阈值灵敏性曲线

(1)如果没有梯度爆炸,使用欧氏距离的模型在最佳阈值下的性能整体上优于使用余弦距离的模型;

(2)网络较浅且特征维度较小的模型在使用欧氏距离时效果更好,但在使用余弦距离时效果更差。使用欧氏距离时,最好效果的模型的主干网络为ResNet18、全连接层特征维度为32(“ResNet18-Euclidean-32”),最差效果的模型的主干网络为ResNet152、全连接层特征维度为1024(“ResNet152-Euclidean-1024”);使用余弦距离时,最好效果的模型的主干网络为ResNet152、全连接层特征维度为1024(“ResNet152-cosine-1024”),最差效果的模型的主干网络为ResNet18、全连接层特征维度为32(“ResNet18-cosine-32”)。

(3)总体来说,使用欧氏距离的模型在识别语义不一致图像对方面显示出明显优势,特别是网络较浅且特征维度较少时,但随着网络层和特征维数的增加,欧氏距离优势减弱,使用余弦距离的模型开始显示出优势。这是由于余弦距离能够对数据进行压缩,抑制了无用的信息,更适合更深的网络和更高的特征维度。从另一个角度来看,欧氏距离强调有用的信息,特别是在使用较浅的网络和较少维度的特征时。综上,在数据量较小时,选择较深的网络和余弦距离,或者选择较浅的网络和欧氏距离,可以取得更好的效果。

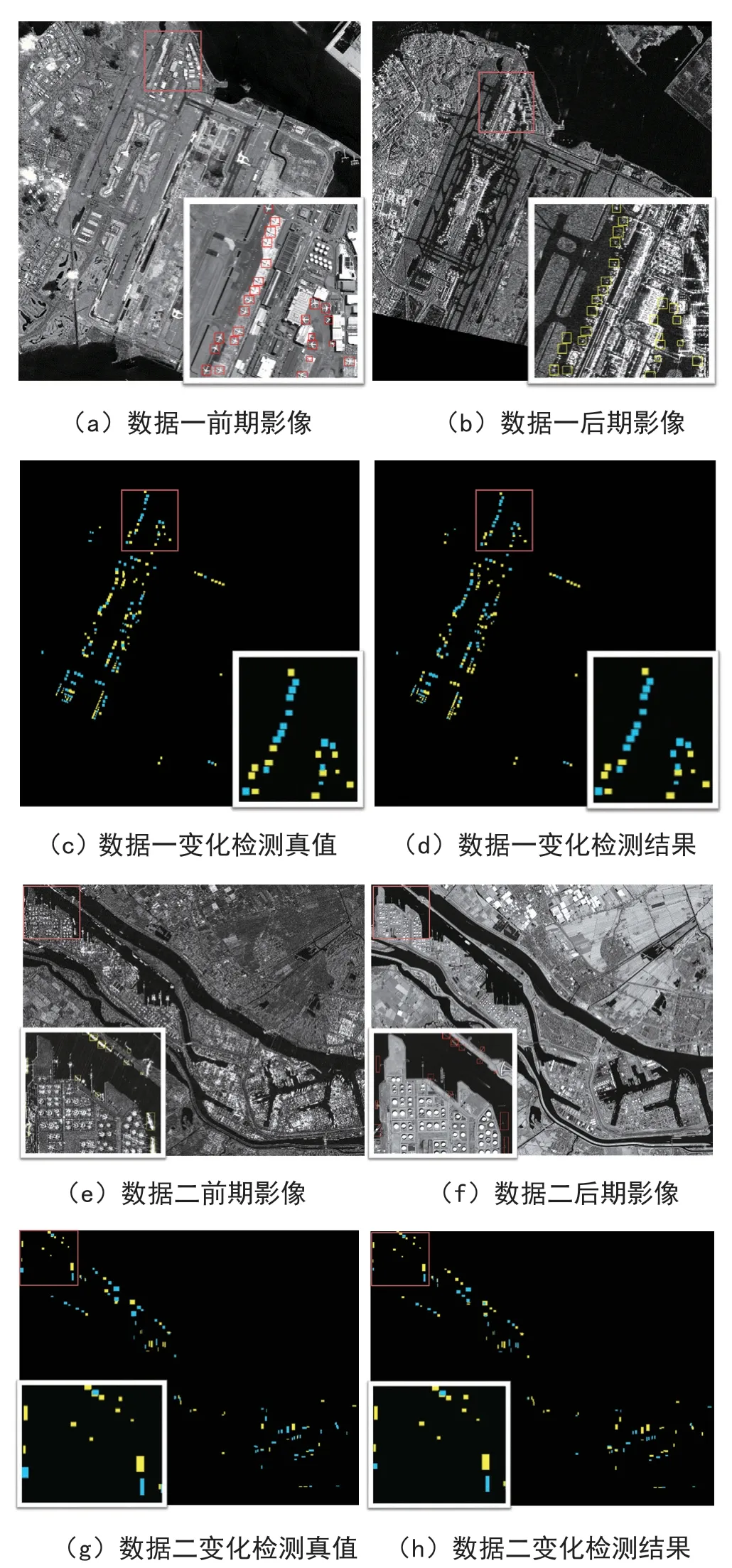

3.3.2 动态目标变化检测实例

利用2.2 节提及的两组高分卫星影像,将论文提出的对象级变化检测方法扩展至真实卫星影像的应用上。图6 中,(a)(b)展示了数据一的原始影像,(e)(f)展示了数据二的原始影像,(c)(g)分别展示了数据一和数据二的变化检测真值,(d)(h)展示了选用ResNet50 作为主干网络、欧氏距离作为距离函数、特征维度设置为1024 的模型,对前一时相遥感影像上的飞机或船只目标,在后一时相影像中的状态是否发生变化进行检测的结果。图中,蓝色方块表示前后时相图像的目标状态不变,黄色方框表示目标状态改变。

图6 异源高分影像变化检测结果

4 结束语

论文针对异源遥感影像动态目标变化检测问题,提出一种基于孪生网络结构的对象级变化检测方法。通过两个结构和权重完全相同的分支,提取异源图像对具有判别性的语义特征;利用距离函数构建图像对深度特征相似性描述符,抑制无效信息,增强特征差异。为解决异源遥感影像对象级变化检测数据不足问题,论文收集了典型类别目标的图像切片3024 张,组合成包含百万对同源和异源图像对的数据集,构建了一种适用于异源影像对象级变化检测的数据集OCD3k。论文方法的有效性在数据集和真实卫星数据上得到了验证,在区分经过训练及未经训练的目标类别间的语义变化问题上,都表现出较高的准确率。