基于Faster R-CNN 的损害控制手术器械检测方法研究

罗 锋,陈 锋,吴 航,许兆坤,宋丽梅,韩思齐,赵子贤,余 明*

(1.军事科学院系统工程研究院,天津 300161;2.天津理工大学,天津 300384)

0 引言

手术器械检测可应用于手术器械实时跟踪[1]、手术视频回顾性分析[2]、人机协同手术[3]等方面,其相关的研究显著增加。大部分研究都是基于微创手术视觉数据集[4-6],传统开放性手术相关的研究较少。开放性手术是外科手术中重要的组成部分,在自然灾害、战场等特定环境中十分重要。微创手术需要内窥镜辅助开展,内窥镜的运用简化了微创手术视频数据的采集过程,使其更加便捷,而开放性手术存在伦理、技术等问题难以构建数量和质量均满足卷积神经网络训练的真实手术视觉数据集。损害控制手术是以维持伤病员基本生命体征为主的简易开放性外科手术[7]。本文基于高仿真生物模拟人系统构建损害控制手术视觉数据集,用于手术器械检测等相关方面的研究。该数据集不仅可用于手术器械检测,还可支持后续的手术技能评估、手术流程识别等相关研究。

手术器械检测方法可大致分为以下几种:(1)改造手术器械,安装传感器[8];(2)处理手术器械表面,通过涂抹颜色、雕刻棋盘格或二维码[9]等方式赋予手术器械标签;(3)不对手术器械做任何处理,仅基于计算机视觉完成手术器械检测任务[10]。前2 种方法的实施难度较低,但会改变手术器械的形状和质量,干扰外科医生操作,且手术器械改造会增加设备成本和灭菌任务,不利于技术推广。传统的目标检测任务主要是基于尺度不变特征转换[11](scale invariant feature transform,SIFT)和方向梯度直方图[12](histogram of oriented gradients,HOG)等方法实现,但精度和检测速度不如目前的深度学习[13]。

深度学习中的目标检测网络可分为一阶段网络和二阶段网络,两者的代表性网络分别是YOLO(you only look once)系列[14-19]和基于区域的卷积神经网络(region-based convolutional neural networks,R-CNN)系列[20-23]。一阶段网络无独立生成建议区域的子网络,将目标检测任务直接视为回归任务,检测速度快,但精度低。二阶段网络先生成建议区域进行粗调,然后筛选部分符合条件的建议区域进行微调完成目标检测任务。二阶段网络的检测精度高,但速度较慢。目前国内外开放性损害控制手术相关研究较少,且本文课题的后续研究以手术视频回顾性分析为主,确保手术器械的检测精度即可,对检测速度无严格要求。因此,二阶段网络更符合本文要求。二阶段目标检测网络R-CNN 系列主要包含R-CNN、Fast R-CNN、Faster R-CNN 和Mask R-CNN 等。Faster R-CNN 的检测精度和检测速度优于R-CNN 和Fast R-CNN,而Mask R-CNN 是在Faster R-CNN 基础上添加了全卷积网络[24](fully convolutional networks,FCN)分支,可同时实现目标检测任务和实例分割任务。本文仅实现手术器械检测任务,因此采用Faster R-CNN作为手术器械目标检测模型。

1 损害控制手术数据集

目前,国内外公开的手术视觉数据集以微创手术为主,暂未检索到公开的开放性外科手术数据集。本研究用的数据集是由本研究团队和上海某三甲医院创伤科合作构建的损害控制手术视觉数据集。该数据集包含135 例手术视频,由9 名外科医生在高仿真生物模拟人系统上执行。每名外科医生均需执行3种手术任务(肠道吻合、肝破裂修复和临时开关腹),并重复执行每个手术任务5 次。该模拟人系统主要包含肝脏、肠道、肾脏等模拟脏器以及腹部模拟皮肤,腹腔内脏器采用以水凝胶为主的生物材料,与人体组织有高度的相似性和相近性,且模拟人系统脏器的含水率、弹性模量、电导率等关键参数与人体脏器偏差不超过20%,可表现出与人体组织相近的触感和力反馈。

患者伤情不同,处理优先级亦不同。美国外科学院创伤委员会(American College of Surgeons Committee on Trauma,ACS COT)提供的高级创伤生命支持项目旨在向医生传授一种有效的、系统的创伤患者评估和治疗方法,在全世界范围内有着巨大影响力。项目中指出优先处理气道损伤,其次是控制出血。但气道损伤属于战术区救治阶梯中的现场急救阶段,而损害控制手术属于早期救治阶段,且后送过程中存活的患者基本脱离气道损伤造成的生命危险。因此,构建损害控制手术视觉数据集优先选择控制出血相关术式,如肠道吻合、肝破裂修复。而为了丰富损害控制手术视觉数据集的术式,本文又增加了与损害控制手术密切相关的临时开关腹术式。

如图1 红框所示位置,手术视频数据采集设备集成在手术灯中。手术视频采集设备的采集视野和手术灯的灯照视野的中心线重合,本文称该摄影方式为手术灯同轴摄影。

图1 手术灯同轴摄影

本文以1 帧/s 的频率对手术视频进行抽帧,并使用标注工具(如labelimg 软件)标注手术器械边界框等手术器械信息。手术器械包含手术过程中直接或者间接用于人体的仪器、设备、器具、体外诊断试剂及校准物等。而本文所指的手术器械仅为损害控制手术视觉数据集中的手术剪、镊子、持针器、止血钳、明胶海绵及手术刀6 种手术器械。

2 方法

2.1 损害控制手术数据集划分

为了损害控制手术视觉数据集能够应用于手术器械检测模型训练以及后续的相关研究,本文没有简单地按照8∶1∶1 的比例随机划分为训练集、验证集和测试集,而是将数据集以视频例数为单位按照2∶1进行分层划分(确保3 种手术术式的数量在各个划分子集中较为均衡)得到视频数据集A 和视频数据集B。视频数据集B 抽帧获得的图像数据集作为手术器械检测模型的测试集,而视频数据集A 再以图像张数为单位按照9∶1 进行随机划分,分别作为手术器械检测模型的图像训练集C 和图像验证集D。按上述数据集划分方式所获得的训练集C、验证集D以及由视频数据集B 抽帧所得图像测试集的图像数量分别为33307、3701、16294 张。

2.2 手术器械检测模型

本文基于卷积神经网络Faster R-CNN 实现损害控制手术器械检测。如图2 所示,Faster R-CNN 架构主要包括网络骨架(Backbone)、建议区域网络(region proposal network,RPN)和感兴趣区域(region of interest,ROI)网络3 个模块。

首先,Backbone 用于提取图像特征图,主要由卷积层组成,文中使用的Backbone 是VGG16[25]。其次,RPN 根据特征图生成若干个可能含有手术器械的建议区域,并输出每个建议区域的边界框坐标和区域内含手术器械的概率。最后,先将符合要求的建议区域输入ROI 池化层统一尺寸后再输入全连接层(即ROI 模块)微调建议区域的边界框坐标和手术器械分类置信度。RPN 和ROI 网络均预测手术器械边界框坐标的偏移量,同时两者均预测分类置信度(前者预测的是建议区域中是否包含手术器械的分类置信度,后者预测的是建议区域内手术器械种类的分类置信度)。因此,本文在训练RPN 和ROI 网络时使用了相似的损失函数,损失函数L({pi},{ti})的定义如下:

式中,Lcls是交叉熵损失函数;Lreg是平滑L1(Smooth L1)损失函数;i 是同一批次建议区域的索引值;pi是建议区域的分类置信度;pi*是真实地面值的标签,当建议区域和手术器械真实边界框之间的交并比(intersection over union,IoU)值大于所设定阈值时,pi*为1,当IoU 小于设定阈值时,pi*为0;ti是预测的边界框坐标偏移量,而ti*则是“正”标签建议区域与手术器械真实边界框之间的位置偏移量;Ncls和Nreg是损失标准化权重,在文中两者的值等于参与损失计算的所有建议区域的数量,如256 和128;λ 是确保分类损失和位置偏移量损失在同一个数量级上的权重,文中取值为1。需要说明的是,RPN 和ROI 网络预测的位置偏移量分别是锚框与真实边界框的位置偏移量和输入ROI 网络的建议区域与真实边界框的位置偏移量,故解释式(1)时使用的名词“建议区域”既表示RPN 中的锚框也表示输入ROI 网络中的建议区域。

本文的手术器械检测模型共训练30 轮,采用随机梯度下降法(stochastic gradient descent,SGD)更新模型参数,初始学习率为0.001,模型训练20 轮后,学习率降为0.0001。为加快模型收敛速度,本文采用迁移学习技术,模型初始化参数为在ImageNet 上预训练获得。同时为了减少过拟合,本文使用图像水平、垂直随机翻转等数据增强方式增加图像样本量。此外,图像预处理通常使用ImageNet 训练集的均值和标准差进行图像归一化处理。但损害控制手术视觉数据集中的图像主要为医疗手术器械,而ImageNet中包含手术器械的图像较少。因此,本文统计了手术器械检测模型训练集(即2.1 节内容中的图像训练集C)的均值和标准差,两者分别为0.3404、0.3647、0.3541 和0.3406、0.3535、0.3488,并使用其进行图像归一化处理。

3 结果

平均精度(average precision,AP)是目标检测任务常用的评价指标,AP 是Precision-Recall(P-R)曲线下的面积,P-R 曲线以精度为纵坐标、召回率为横坐标。

精度(Precision,P)又称为查准率,其计算公式如下:

式中,TP 为模型预测目标种类正确(即预测的分类分数大于设定的阈值),且预测边界框与实际边界框之间IoU 大于设定的阈值的例数;FP 为模型预测的目标种类和边界框与实际边界框之间的IoU 至少有一个小于设定的阈值的例数。

召回率(Recall,R)又称为查全率,其计算公式如下:

式中,FN 为模型预测当前图像中不存在感兴趣的目标,但实际存在的例数。

由上述可知,P 和R 的值与设定的分类置信度阈值和IoU 阈值相关。IoU 不变时,多个分类置信度阈值对应多组P 和R,因此构成P-R 曲线。AP 衡量的是模型对单种目标的检测精度,而平均精度均值(mean average precision,mAP)则是衡量模型的整体性能,即多种目标AP 的均值。

本文IoU 阈值为0.5,即手术器械的预测边界框与真实边界框之间的IoU 大于0.5,且器械分类无误,则认为模型预测正确。使用不同均值和标准差进行图像归一化处理时手术器械检测模型的检测精度对比见表1。

从表1 可以看出,当使用本文的损害控制数据集的均值和标准差进行图像归一化处理时,6 种手术器械的AP 均有提升,且mAP 为79.0%,模型整体性能表现较好。但其中明胶海绵和手术刀的AP 仅有44.5%和65.8%,检测精度较低。

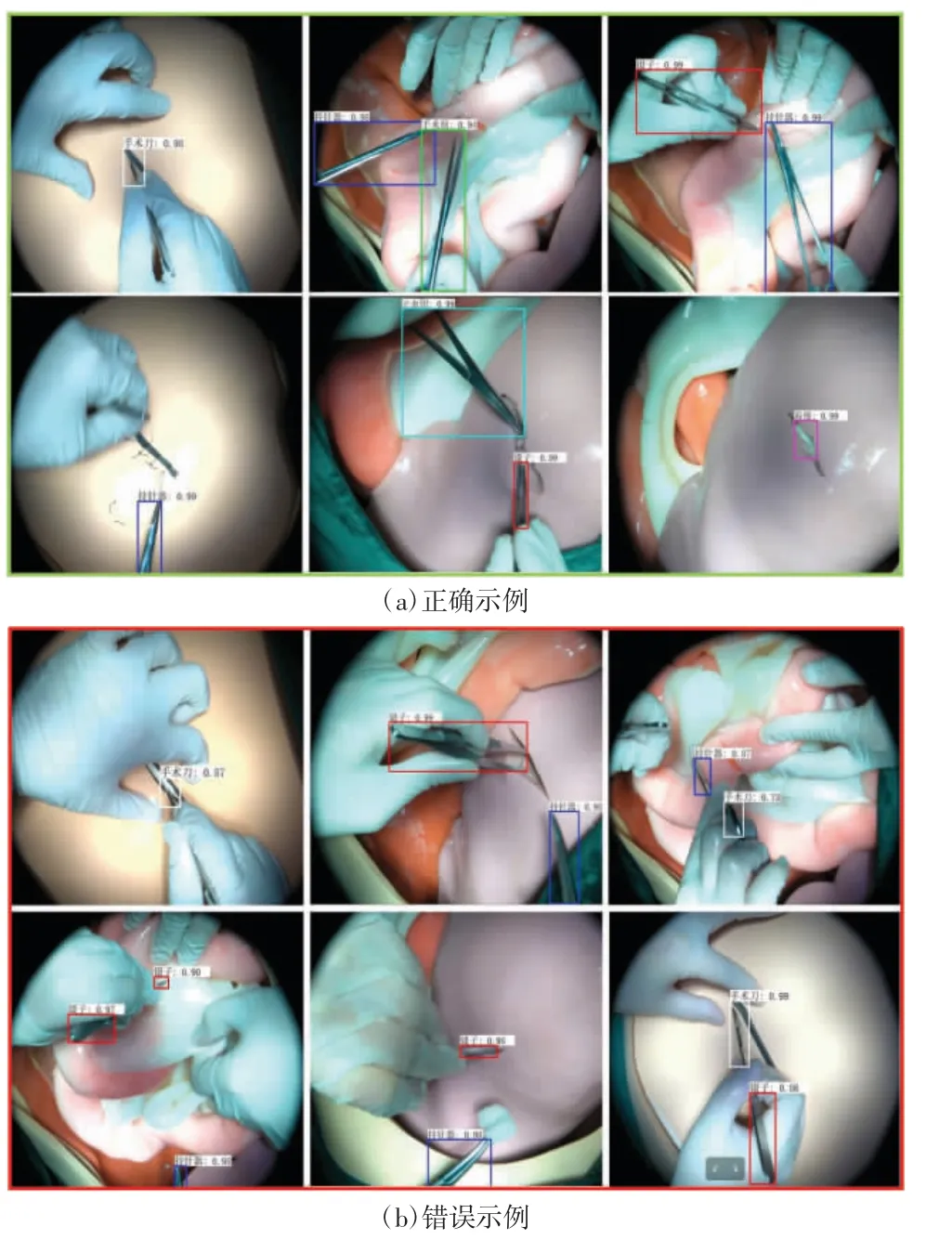

图3 展示了手术器械检测模型检测的正确以及错误例子。图中错误例子主要暴露了模型存在的2个问题:(1)持针器和止血钳因角度问题容易混淆,甚至是手术剪亦可能被识别成持针器;(2)出现在手术视频中的手术刀和明胶海绵大部分呈狭长状,定位精度误差较大,且模型对非狭长状手术刀或是明胶海绵无法识别。

图3 手术器械检测模型检测示例

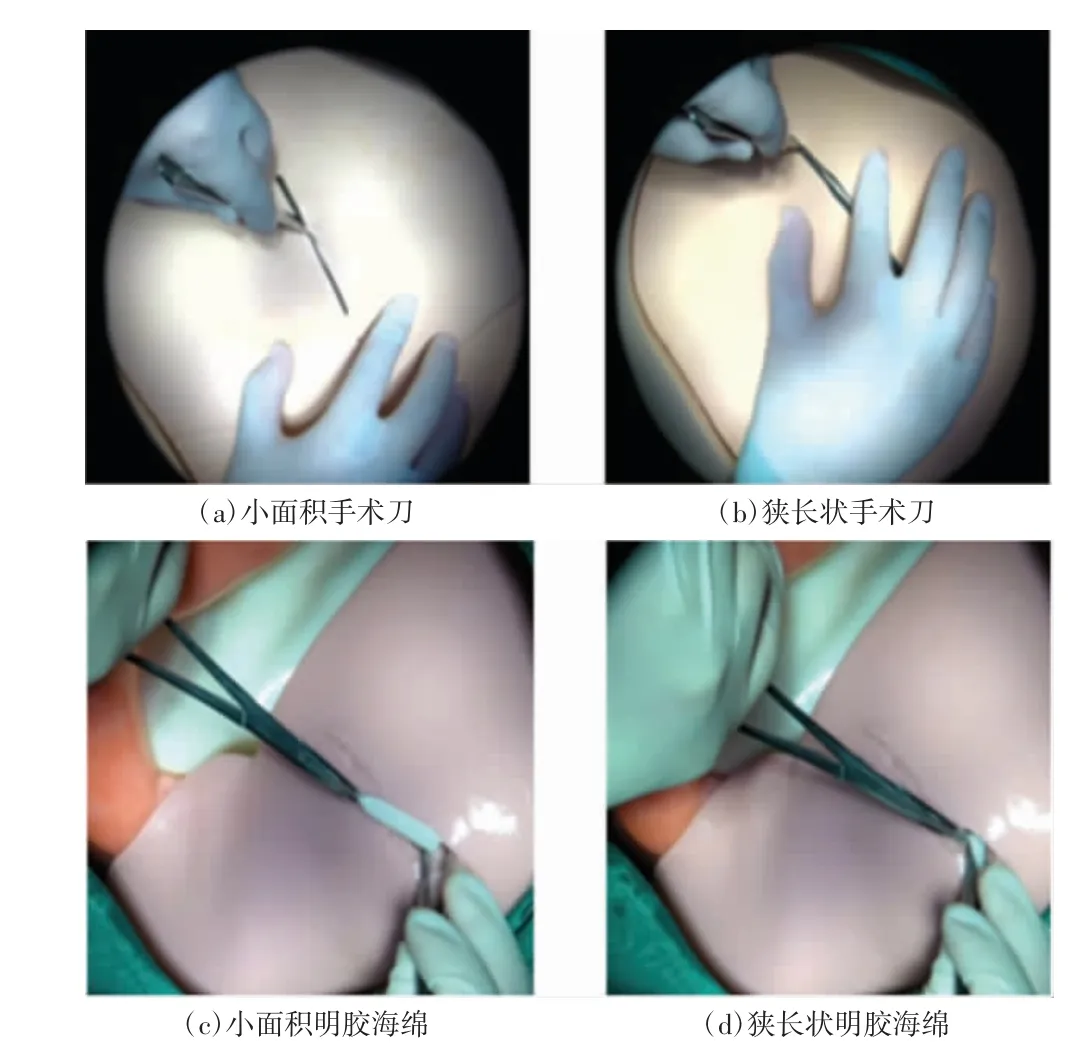

手术刀和明胶海绵AP 偏低的主要原因可能是:(1)损害控制手术视觉数据集包含3 种手术术式,但手术刀仅在临时开关腹中的开腹阶段出现,而明胶海绵仅在肝破裂修复中的止血阶段出现,模型训练时相应的数据偏少。(2)手术刀本身为狭长的形状,且在开腹时主刀医生使用执笔式执刀,导致手术刀的长轴与手术灯同轴摄影设备的视线之间的角度较小,因此手术视频中手术刀的形状通常如图4 中的(a)、(b)所示,常呈狭长或者小面积形状。而Faster R-CNN 对于狭长状和小面积目标检测的精度较差。第三,明胶海绵在肝破裂修复手术中被处理成了狭长状,且明胶海绵的作用是止血,在止血阶段的大部分时间位于伤口内,暴露在采集视野的面积较小,因此手术视频中明胶海绵的形状通常如图4 中的(c)、(d)所示,亦呈狭长或者小面积形状,不利于Faster R-CNN 模型检测。

图4 手术视频中的手术刀和明胶海绵

4 结语

手术器械检测对于手术视频自动分析非常重要,但基于开放性外科手术的手术器械检测相关研究较少,且目前尚未检索到公开的、可获取的开放性外科手术视频数据集。本文基于高仿真生物模拟人系统构建了损害控制手术视觉数据集,数据集中包含了3 种手术术式。且本文使用Faster R-CNN 网络模型实现了手术器械检测,6 种手术器械的mAP 为79.0%,模型性能较好,但是明胶海绵和手术刀的数据量较少,且出现在手术视频中的形状常呈狭长状或面积较小,导致二者的检测精度较低,仅有44.5%和65.8%。

开放性外科手术较微创手术有如下几点不同:(1)手术场景更为复杂,包含待手术器官和组织、手术器械、医生和助理的手等;(2)部分手术器械主要区别在于手术器械尖端的特征,但手术过程中手术器械的尖端通常会被待手术组织、医生手部等遮挡。综上所述,开放性外科手术的单张图像的手术器械检测模型精度提升难度较大。Faster R-CNN 对小目标检测精度较差,可考虑加入多尺度特征融合提升小目标检测的精度,并结合上下文信息等技巧提升手术器械检测模型的整体检测精度。

此外,本文采用的Faster R-CNN 属于二阶段网络,检测精度较高,但实时性较差。选择该网络的主要原因是在后续的损害控制手术视频分析研究中对手术器械检测精度要求较高。未来,在损害控制手术视频分析方法成熟后,可考虑使用实时性更好的网络(如一阶段网络中的YOLO 系列)替换本文的Faster R-CNN 网络,以实现损害控制手术的器械在线检测以及视频在线分析。