基于CycleGAN的服装图像混搭风格迁移

王伟珍 张功

摘 要:为解决复杂背景下服装图像的风格迁移形式单一和局部细节失真问题,提出一种基于CycleGAN的服装图像混搭风格迁移的方法,用于实现服装款式和图案的多风格迁移。通过加入分割掩码,一方面,对特定区域的风格化形成空间约束,在判别器中加入谱归一化和引入背景优化损失保留了局部细节的真实度,实现服装风格款式的风格迁移;另一方面,提出图像融合的方式,将图案融入判别器输出的服装图像中,实现多风格迁移。最后,通过与CycleGAN和InstaGAN比较,依据生成图像的效果进行主观分析,使用图像质量评估指标IS和SSIM进行客观评估以验证该方法的有效性。

关键词:混搭风格迁移;生成对抗网络;服装款式;服装图案;智能设计;服装设计

中图分类号:TS941.26

文献标志码:A

文章编号:1009-265X(2023)04-0250-09

收稿日期:2022-11-11

网络出版日期:2023-02-21

基金项目:教育部社科规划基金项目(21YJAZH088);辽宁省教育厅高校基本科研重点攻关项目(LJKZZ20220069);教育部产学协同育人项目(220404211305120); 辽宁省教育厅项目(1010152); 中国纺织工业联合会项目(2021BKJGLX321)

作者简介:张功(1995—),男,山东滕州人,硕士研究生,主要从事服装图像处理方面的研究。

通信作者:王伟珍,E-mail:wz-wang@foxmail.com

应用计算机程序辅助服装设计师进行创作,已成为服装设计过程中不可或缺的技术手段。随着消费者对个性化需求的提高,服装设计师需要更短的时间设计出更加新颖的作品。此外由于深度学习[1]的兴起,人工智能与服装设计的融合变得尤为迫切。尽管人工智能相关技术在时尚领域研究的应用逐步深入,如服装分类、服装检测、服装推荐以及虚拟试穿等[2],但是针对当前服装辅助智能设计的研究,服装图像的风格迁移仍然困囿于诸多技术问题。例如,服装图像只能完成单一形式(图案或者款式)的风格迁移,导致生成服装图像的多样性不足,设计师仍需要耗时耗力地对比不同款式和图案的搭配效果;生成的服装图像存在着边界伪影问题,降低了服装图像的质量[3-5]。因此,如何利用现有技术在短时间内对服装图像添加多种风格,生成风格多样、效果真实的服装图像,给予设计师更多设计灵感,正是其中技术痛点之一。

目前,风格迁移已成为解决上述技术痛点的着力点之一。服装风格迁移是将一张图像A的风格和另一张服装图像B的内容结合,生成同时具有图像A风格和图像B内容的服装图像C。一种比较前沿的SC-FashionG模型于2021年被提出,该模型将多种样式混合于给定的服装图像中,并把这种组合称为混搭风格(Mix and match style)[6]。在以往的研究中,人们提出许多方法[7-9]实现风格迁移并将其应用于服装图像的生成,主要集中于基于图像迭代的神经风格迁移算法和基于模型迭代的生成对抗网络(Generative adversarial networks,GAN)模型。

为解决不同风格对图像语义内容渲染困难的问题,Gatys等[10]提出了一种基于VGG(Visual geometry group)的卷积神经网络结构,创新地将一种内容图像和风格图像结合在一起。此后,有学者使用该方法并结合图像分割实现服装局部风格迁移[11],但是服装边界容易产生伪影,使生成的图像显得不自然。Li等[12]提出一种基于WCT(Whitening and coloring transform)的方法。通过白化原有风格并彩化新风格,有效的提高了图像生成的质量和艺术效果,并尝试了多风格迁移,但是应用于服装中只能改变图案纹理风格,无法改变款式。

为了使生成数据分布尽可能的逼近真实数据分布,Goodfellow等[13]提出GAN模型。由于在生成图像和应用在服装设计过程中展现出良好的效率和质量,很多研究者将注意力转移至GAN模型來实现服装风格迁移。Isola等[14]通过向GAN引入约束条件,提出pix2pix来进行图像转换,该方法虽然生成图像的效果自然,但是需要成对的数据集训练。为了解决对数据集依赖的问题,Zhu等[15]提出CycleGAN在无配对数据集情况下实现了两域之间互相转换,但是生成的图像缺乏多样性,很难改变服装的形状,并且会改变内容域中的背景。为克服无监督学习中形状转换难以完成的风格迁移问题,Mo等[16]结合实例信息,引入了上下文保留损失,提出InstaGAN实现了服装款式的转换,但是在生成图像中局部细节会出现失真,如腿部皮肤显得不自然。Jiang等[6]提出将多种风格混搭在一个服装图像中,通过分割掩码改变服装中图案的结构,生成的服装图像颇为新颖,但是该方法也仅改变服装中图案并且没有人物背景作为参考。

上述方法主要局限包括:单一风格迁移的研究(仅对图案或者服装款式进行风格迁移),极大地限制了生成服装图像的多样性;在带有背景的服装图像中,容易产生图像局部细节失真的问题。为了克服上述两大缺陷,降低自动生成多风格服装图像的难度,本文基于CycleGAN的结构提出一种服装图像的混搭风格迁移方法。与以往生成单一风格形式的模型相比,有三点不同:首先本文提出混搭风格迁移,即关注于服装款式和服装图案的多风格迁移;其次,改进了CycleGAN网络结构用于多风格图像的生成;最后,加入了背景优化损失,结合引入的服装图像二值图,提升生成图像的质量。另外,通过使用图像评估指标IS(Iception Score)[17]和SSIM(Structural similarity)[18]对CycleGAN和InstaGAN进行比较,并结合生成的图像效果进行主客观分析,以验证本文方法的有效性。

1 相关理论

GAN和CycleGAN都是通过生成器和判别器互相博弈来生成图像,即通过建立生成器G和判别器D互相博弈来使双方进化。其两者关系如式(1):

minGmaxDLGAN(G,D)=Ex~Pdata(x)logD(x)+

Ez~Pdata(z)log(1-D(G(z)))(1)

式中:z為生成器产生的噪声数据,服从Pdata(z)的先验分布;x代表真实数据,x服从真实样本分布Pdata(x)。当D(x)越大,判别器越能够准确识别出真实样本;当D(G(z))越小,则1-D(G(z))越大,判别器也能增强判别能力,若固定判别器,增强生成器生成能力,判别器会将假数据判别为真,即D(G(z))增大,所以有minGmaxDLGAN(G,D)。

这种方法虽然能够生成较为逼真的图像,但是难以保证在风格迁移中生成图像的有效性,即无法限定生成图像的范围,保证图像的内容不发生变化。相较GAN模型,CycleGAN有两大优势,一方面,CycleGAN包含两个生成器(G和F)和两个判别器(Dx和Dy),通过对偶学习[19]方法建立不同域之间的联系,因此CycleGAN的训练数据集不需要成对;另一方面,建立了循环一致性损失,如式(2):

Lcyc(G,F)=Ex~Pdata(x)F(G(x))-x)1+

Ey~Pdata(y)G(F(y))-y1(2)

式中:F(G(x))为生成的重构图像,与x相似,下标1为L1范数。F(G(x))重构了源域的图像减少与源域图像的差距,来弥补了使用GAN风格迁移过程中内容发生变化的缺陷。加入L1范数防止过拟合出现。

因此,CycleGAN的总损失函数为对抗性损失和循环一致性损失之和,如式(3):

LossGAN=LGAN(G,Dx)+LGAN(F,Dy)+ωLcyc(G,F)(3)

式中:ω为权值,用于调节该损失的重要性。

2 本文方法

为实现服装图像的混搭风格迁移,利用CycleGAN不需要成对训练数据集和风格迁移效果好的优势,本研究通过结合分割掩码改进CycleGAN网络结构和损失函数,完成服装图像中下装的几何变换。同时,为了将图案更好地融入服装局部,提出图案融合的方法,增强图像真实感而非艺术效果,对服装图像分割后获得的分割掩码与图案按照一定权值融合。

2.1 网络结构

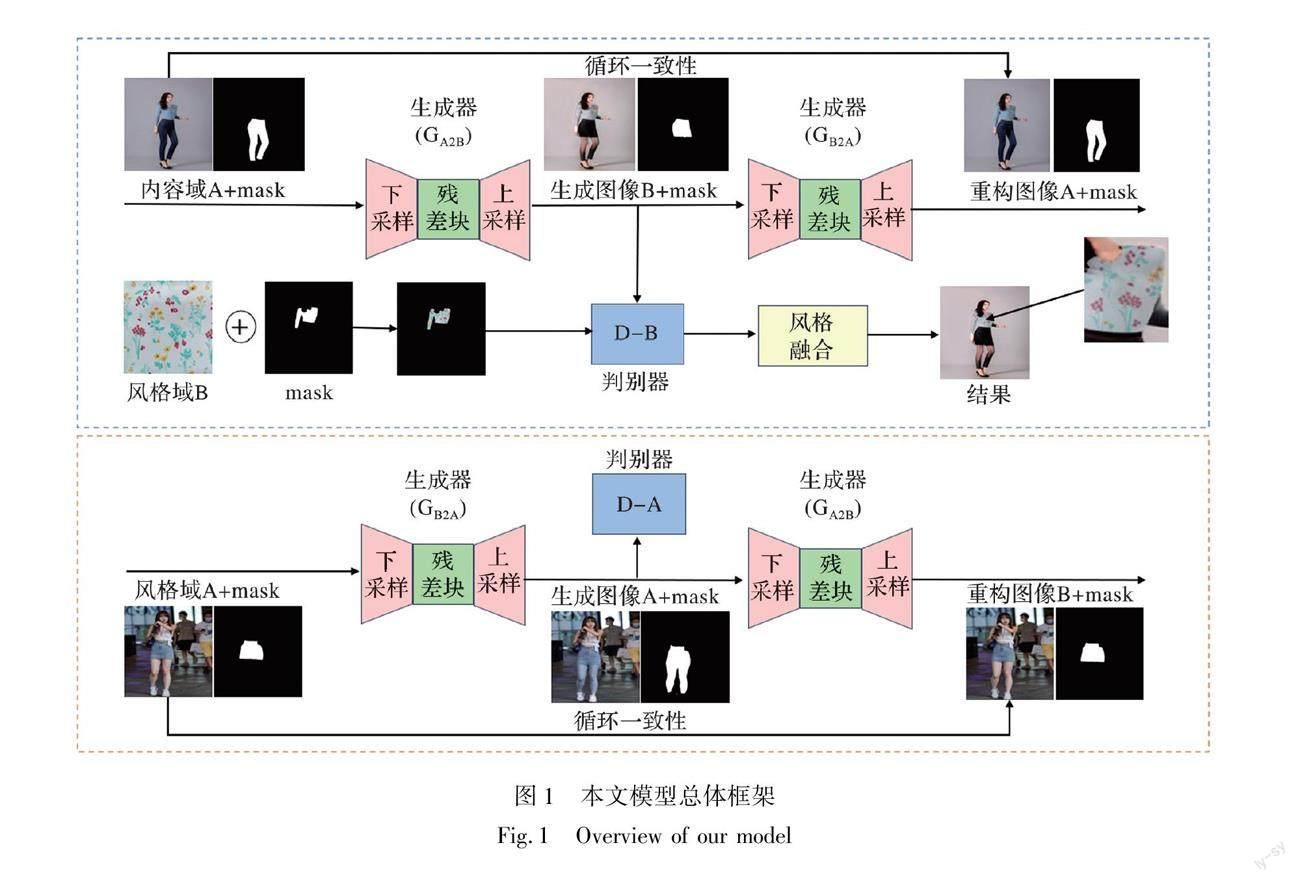

本文的模型框架如图1所示,He等[20]提出的Resnet和林泓等[21]使用的PatchGAN分别作为生成器和判别器。其中,生成器和判别器各有两个,分别用GA2B、GB2A、DA和DB表示。GA2B是将内容域A(长裤)中的风格生成具有风格域A中的风格(裙子)的服装图像,并使用DB判断GA2B生成图像的真假,若为真,则输出具有风格域A风格以及具有内容域A内容的图像(生成图像B)。同理,GB2A是将风格域A(裙子)中的风格转换为内容域A(长裤)中的风格,并使用DA判断GB2A生成图像的真假,若为真,则输出具有内容域A的风格以及具有风格域A内容的服装图像(生成图像A)。同时,输入图像与重构图像通过训练会尽可能相似,体现CycleGAN中循环一致性。

本文的Resnet生成器由下采样块、残差块和上采样块组成,如图2所示。在下采样块中,使用实例归一化(IN)在一个通道内作归一化,计算图像的H*W的均值,保持了图像实例的独立性,加快了模型的收敛。ReLU作为激活函数,降低计算的复杂度,加快计算速度。同时,为了达到更好的训练效果,Resnet残差块设置了9层,保留了卷积层、实例归一化和激活层。此后,通过上采样块中逆卷积层减少通道数来扩大图像尺寸,用于生成目标(如裙装)图像。为了得到更好地生成效果,模型的PatchGAN判别器由5层卷积层组成,如图3所示。与CycleGAN不同的是,为了规范判别器参数,让其满足利普茨连续(1-Lipschitz continuity),卷积层本文在首尾卷积层中采用了谱归一化(SpectralNorm)[22]。此外,使用前3层卷积层提取特征后,后2层卷积层再进行分类,获得了较好的生成效果。

2.2 损失函数的设计

上述的损失函数虽然能够实现跨类别的图像翻译,尤其是纹理的风格迁移,但在几何变换和细节处理方面表现不佳。本研究更加关注图像转换过程中的上下文衔接,服装款式(即形状)的风格迁移效果和生成图像中人物背景的肢体的真实感。为此,加入了背景优化损失Lback,如式(4):

Lback=ω2 f(a,b′)⊙(x-y′)1+

ω3N∑Nn=1∑3c=1(G(x)-x)-(y-F(y))1(4)

式中:

x代表内容域图像,a代表内容域掩码选中区域,

y′代表内容域图像转换后的图像,

b′代表内容域被转换后的掩码迭中区域,ω2和ω3分别作为调整内容保留和肤色显示的权重,N代表转换区域内的像素数,c为通道数。设实例为0,背景为1时,则f=a∪b为可转换状态,实现了实例的转换和背景的保留。由于边缘区域的细节要比中心区域复杂,ω2的权重值由中心向边缘逐渐增加。此外,为了弥补转换过程中转换区域形状纹理会发生的差异性变化,如长裤转换为短裤后,腿部存在仍然保留着部分长裤纹理的问题。本研究将生成器G生成的图像(如短裤风格图像)和内容域x(如长裤风格图像)的差异值与风格域(如短裤风格图像)和生成器F(如生成的长裤风格图像)的差异值作差,通过训练不断缩小差距,使人物腿部细节更加真实。其中,ω3为超参数。

因此,本文所提方法的总损失为式(5):

Ltotal=γ1LLSGAN+γ2Lcyc+γ3Lback(5)

式中:γi(i=1~3)为超参数。

尽管在风格迁移中,尤其是艺术领域,大部分使用神经网络来完成,并获得了较好的艺术风格图像。但是对于服装的图案纹理迁移,使用神经网络来完成并不理想或者说过于艺术,缺乏真实感。然而,本文提出一种图案融合方式,通过mask将服装与处理后的图案按一定比例进行融合,使图案纹理能够较好的在服装中展示,获得了较为新颖的服装图像,如式(6):

Imer=(Iori-t1*Iseg)+t2*Ipat*Imask(6)

式中:Iori为原始的服装图像,Iseg为分割后所要融合的服装局部,Ipat为所要融合的图案,Imask为所要融合的服装局部的掩码,t1为保留原始服装局部纹理的比例,t2为融合图案纹理的比例,且t1+t2≈1。

3 结果与分析

3.1 数据集与实验细节

本文所使用的数据集包含两部分:服装协同数据集[23](Clothing co-parsing dataset,CCP)和自建数据集。CCP共有2098张高分辨率时尚街头图像,所有图像带有图像级注释,里面有各种款式、配饰、服装和姿势,共有59个标签。自建数据集共有3000张图像。其中,长裤图像1000张,短裤图像1000张以及短裙图像1000张。增加自建数据集是对CCP的补充,增加训练数据为了更有针对性地完成服装款式的转换,获得更好的风格迁移效果。

实验环境与模型训练:CUDA 11.3,cuDNN 8,Ubuntu 18.04系统,Pytorch 1.10深度学习框架,Python 3.8程序语言,NVIDIA GeForce RTX 3090显存24 GB的显卡。共训练了500轮,训练过程中损失的变化如图4所示。由于在训练200轮次后损失下降幅度减小甚至难以继续下降,因此,选择了200轮次的预训练模型进行测试。

3.2 实验细节

本文主要针对服装图像进行款式和图案纹理的风格迁移。在实验中,一方面将风格域A中的服装样式(短裤或者裙子)迁移至内容域的下装,并将风格域B的图案纹理迁移至内容域的上装;另一方面通过选择有人物背景的作为内容域,在风格迁移后,通过人物背景作为参考,可以更加直观展示风格迁移效果,如不同图案款式对不同人群搭配的适应性。

如图5(a)所示,前两行展示的是将内容域中长裤的形状转换为与风格域A中短裤相似的样式。同理,后面两行图像是将长裤转换为裙子,并将风格域中的图案纹理分别融合在上装和下装中。不管是样式形状迁移还是图案纹理迁移,都获得了较好的生成效果。值得注意的是,轉换所生成的裙子的色彩与风格域A无关,与输入的内容域有关,如内容域中服装色彩较深的往往转换为颜色较深的服装款式。风格域A所展示的图像仅仅只是一种样式(如裙子的样式)的代表,并非单个样式形状迁移。此外,在完成款式风格迁移后还可将对上装和下装同时进行图案的风格迁移,由图5(b)可见,将风格A、风格B和风格C的3种风格混搭在同一张服装图像中,生成了效果真实、新颖独特的服装图像。当然,这还需要根据不同图案来设置好式(6)中的参数。

3.3 多模型效果比较与评估

为了验证本文方法在款式风格迁移的有效性,将本文基于CycleGAN所提的方法与CycleGAN和InstaGAN进行主客观的比较与分析,包括在相同数据集上不同方法生成的图像效果、图像生成指标IS和图像质量评估指标SSIM。

a)主观比较与分析

由图6所示,从测试效果角度来讲,CycleGAN并没有改变服装的形状,而是对服装的色彩略有影响,InstaGAN明显改变了服装的形状,但是处理其他服装图像尤其是浅色服装时,生成的图像中服装

并不清晰,并且生成的人物肢体显得不自然(如第一行中生成人物的腿部皮肤不够接近肤色,第三行人物与背景拟合较差)。相比较之下,本文的模型生成的服装效果更好,更加自然。

b)客观评价指标分析

衡量风格迁移过程中不同模型生成的质量是困难的,缺乏客观统一标准的评估[24],尤其是设计美学方面,往往带有主观性。为了检验生成图像的质量和图像中的多样性,本文参考了图像生成的评价指标和其他计算机视觉方面的评价指标,选择了IS和SSIM分别对CycleGAN、InstaGAN和本文方法进行评估和对比。

IS是对生成图像的清晰度和多样性衡量,如式(7):

IS(G)=exp(Ex~PgDKL(p(y|x)p(y)))(7)

式中:对于p(y|x)log(p(y|x)),熵值越小表明数据分布越集中,则图像具有较好的清晰度;对于p(y)log(y),熵值越大,表明图像种类越多,则生成的图像具有很好的多样性。因此,IS分数为边缘分布p(y)和条件分布p(y|x)的KL散度的期望,即给定一个生成图像x,类别信息y的不确定性的减少程度。IS虽然一定程度能够衡量生成图像的清晰度和多样性,但是没有侧重点。

为了评估的客观性,本文引入一种衡量两幅图像相似度的SSIM指标[25],通过感知的模型,评价图像质量上更加贴近于人类视觉特性。如式(8):

SSIM(x,y)=(2uxuy+c1)(2σxy+c2)(u2x+u2y+c1)(σ2x+σ2y+c2)(8)

式中:x代表风格图像,y代表生成图像。ux是x的平均值,σ2x是x的方差,uy是y的平均值,σ2y是y的方差,σxy是x和y的协方差,c1和c2是两个用于维持稳定的常数,避免出现除零的情况。因此,SSIM越接近1,表明风格图像与生成图像越相近[26]。

为了进行更为直观的对比分析,对IS和SSIM数据进行了归一化。如表1所示,本文模型的IS值和SSIM值都高于其他模型,表明了生成服装图像的真实感和多样性要优于其他模型。针对长裤向短裤的款式风格迁移,由IS值可知,CycleGAN虽然难以改变服装款式,但是在生成图像清晰度上要比InstaGAN要好,而代表多样性的SSIM值偏低;针对长裤向短裙的款式风格迁移,虽然SSIM值远大于CycleGAN和InstaGAN,但是IS值却与CycleGAN相近,表明本文模型在生成图像多样性方面占优,在转换为裙子款式风格迁移后生成的图像清晰度还需要提高。

综上数据和视觉效果比较,与前文所述经典模型CycleGAN和InstaGAN不同的是,本文模型将服装款式和图案共同作用于服装图像中,克服服装图像风格迁移的单调性,形成了不同服装款式和图案的混搭。此外,本研究受比较前沿的混搭风格模型SC-FashionG启发,也通过加入分割掩码形成对服装局部的空间约束,并将多种风格作用于同一服装图像中,但又与该模型有显著差异:SC-FashionG模型使用了无背景的服装图像,而本研究使用的服装图像带有人物背景;SC-FashionG模型使用分割掩码对服装内部纹理进行改变以实现服装图案的多样性,而本研究使用分割掩码作用于服装外部边缘来改变服装的款式和图案以增加生成图像的多样性。

4 结 语

本文提出一种混搭风格迁移的方法,解决了生成服装图像风格形式单一以及背景细节失真的问题,通过主观比较和客观评估分析,表明本文方法在多风格迁移任务中的有效性。其中,多风格主要包括了服装下装的款式风格和图案风格。一方面,针对服装款式的风格迁移,使用了图像分割掩码,引导和约束风格迁移对特定区域风格化,引入背景优化损失,用于保留背景和建立腿部肤色相似性,在判别器中加入谱归一化SN用于特性提取和分类任务中,优化背景细节纹理;另一方面,提出风格融合方式,按照权值使图案在服装中展示出来。最后,通过与CycleGAN和InstaGAN比较分析,本文采用的方法得到了较高的评价。

在此次辅助智能设计的实践中,虽然获得了有效的结果,但也存在着一些不足。如对输入的内容图像分辨率要求较高,将长裤转换为裙子的成功率相对偏低,后期将继续提升模型的泛化能力,并注重生成过程中服装图像的情感元素[27],以推进计算思维与设计思维的融合。

参考文献:

[1]LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[2]CHENG W H, SONG S J, CHEN C Y, et al. Fashion meets computer vision: A survey[J]. ACM Computing Surveys, 2022, 54(4): 1-41.

[3]施倩,罗戎蕾.基于生成对抗网络的服装图像生成研究进展[J].现代纺织技术,2022,31(2):36-46.

SHI Qian, LUO Ronglei. Research progress of clothing image generation based on generative adversarial networks[J]. Advanced Textile Technology, 2022,31(2):36-46.

[4]CHEN H, LEI S, ZHANG S G, et al. Man-algorithm cooperation intelligent design of clothing products in multi links[J]. Fibres and Textiles in Eastern Europe, 2022,30(1): 59-66.

[5]趙梦如.人工智能在服装款式设计领域的应用进展[J].纺织导报,2021(12):74-77.

ZHAO Mengru. Application progress of artificial intelligence in clothing style design[J]. China Textile Leader, 2021(12): 74-77.

[6]JIANG S, LI J, FU Y. Deep learning for fashion style generation[J]. IEEE Transactions on Neural Networks and Learning Systems, 2022, 33(9): 4538-4550.

[7]唐稔为,刘启和,谭浩.神经风格迁移模型综述[J].计算机工程与应用,2021,57(19):32-43.

TANG Renwei, LIU Qihe, TAN Hao. Review of neural style transfer models[J]. Computer Engineering and Applications, 2021, 57(19): 32-44.

[8]JING Y C, YANG Y Z, FENG Z L, et al. Neural style transfer: A review[J]. IEEE Transactions on Visualization and Computer Graphics, 2020, 26(11): 3365-3385.

[9]MO D, ZOU X, WONG W K. Neural stylist: Towards online styling service[J]. Expert Systems with Applications, 2022, 203: 117333.

[10]GATYS L, ECKER A, BETHGE M. A neural algorithm of artistic style[J]. Journal of Vision, 2016, 16(12): 356.

[11]WANG H Y, XIONG H T, CAI Y Y. Image localized style transfer to design clothes based on CNN and interactive segmentation[J]. Computational Intelligence and Neuroscience, 2020, 2020: 8894309.

[12]LI Y J, FANG C, YANG J M, et al. Universal style transfer via feature transforms[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, California, USA. New York: ACM, 2017: 385-395.

[13]GOODFELLOW I, POUGET-ABADIE J, MIRZA M B, et al.Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems:Volume 2. Montreal, Canada. New York: ACM, 2014: 2672-2680.

[14]ISOLA P, ZHU J Y, ZHOU T, et al. Image-to-image translation with conditional adversarial networks[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA. IEEE, 2017: 5967-5976.

[15]ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//IEEE International Conference on Computer Vision (ICCV). Venice, Italy. IEEE, 2017: 2242-2251.

[16]MO S, CHO M, SHIN J. InstaGAN: Instance-aware Image-to-Image Translation[J]. ArXiv, 2018: 1812.10889. https://arxiv.org/abs/1812.10889.

[17]SALIMANS T, GOODFELLOW I, ZAREMBA W, et al. Improved techniques for training GANs[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona, Spain. New York: ACM, 2016: 2234-2242.

[18]WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2004, 13(4): 600-612.

[19]YI Z, ZHANG H, TAN P, et al.DualGAN: Unsupervised dual learning for image-to-image translation[C]//Proceedings of the IEEE International Conference on Computer Vision(ICCV). Venice, Italy. IEEE, 2017: 2868-2876.

[20]HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Las Vegas, NV, USA. IEEE, 2016: 770-778.

[21]林泓,任碩,杨益,等.融合自注意力机制和相对鉴别的无监督图像翻译[J].自动化学报,2021,47(9):2226-2237.

LIN Hong, REN Shuo, YANG Yi, et al. Unsupervised image-to-image translation with self-attention and relativistic discriminator adversarial networks[J]. ACTA Automatica Sinica, 2021, 47(9): 2226-2237.

[22]GULRAJANI I, AHMED F, ARJOVSKY M, et al. Improved training of wasserstein gans[J]. ArXiv, 2017:1704. 00028. https://arxiv.org/abs/1704.00028.

[23]LIANG X D, LIN L, YANG W, et al. Clothes Co-parsing via joint image segmentation and labeling with application to clothing retrieval[J]. IEEE Transactions on Multimedia, 2016, 18(6): 1175-1186.

[24]陳淮源,张广驰,陈高,等.基于深度学习的图像风格迁移研究进展[J].计算机工程与应用,2021,57(11):37-45.

CHEN Huaiyuan, ZHANG Guangchi, CHEN Gao, et al. Research progress of image style transfer based on depth learning[J]. Computer Engineering and Applications, 2021, 57(11): 37-45.

[25]李敏,刘冰清,彭庆龙,等.基于CycleGAN算法的迷彩服装图案设计方法研究[J].丝绸,2022,59(8):100-106.

LI Min, LIU Bingqing, PENG Qinglong, et al. A camouflage suit pattern design based on the CycleGAN algorithm[J]. Journal of Silk, 2022, 59(8): 100-106.

[26]曾宪华,陆宇喆,童世玥,等.结合马尔科夫场和格拉姆矩阵特征的写实类图像风格迁移[J].南京大学学报(自然科学),2021,57(1):1-9.

ZENG Xianhua, LU Yuzhe, TONG Shiyue, et al. Photorealism style transfer combining MRFs-based and gram-based features[J]. Journal of Nanjing University (Natural Science), 2021, 57(1): 1-9.

[27]QUINON P. Engineered emotions[J]. Science, 2017, 358(6364): 729.

Mix and match style transfer for the images of clothes with CycleGAN

WANG Weizhena,b, ZHANG Gonga

(a.School of Fashion; b. Clothing Human Factors and Intelligent Design Research Center, Dalian Polytechnic University, Dalian 116034, China)

Abstract:

With the continuous integration of artificial intelligence (AI) technology and the fashion field, the use of style transfer technology to generate new images has become one of the research hotspots of aided intelligent clothing design. However, the use of current style transfer technology in the process of aided intelligent design still has great limitations. Only completing the transfer of a single style limits the diversity of generated clothing images, and the detail distortion of the clothing image with the character background reduces the authenticity of the generated clothing images.

Aiming at solving the problems of the undiversified transfer form and local detail distortion of clothing image styles in complicated conditions, a method of clothing image mixing and matching style transfer was proposed to realize the multi-style transfer of clothing styles and patterns. During the experiment, we took CycleGAN as the baseline model, with the advantage of improving the effect of style transfer without requiring pairwise training and cyclic consistency loss, used Resnet generator and PatchGAN discriminator for training, and introduced the segmentation mask. On the one hand, spatial constraints were formed for the stylization of specific areas, instance normalization was added to the discriminator to maintain the independence of image instances, spectral normalization was added to the first and last layers of the convolution layer to enhance the classification ability of the network, and background optimization loss was added to optimize the local details of the generated images, especially the boundary artifacts, which jointly promoted the generation effect and realized the style transfer of clothing styles. On the other hand, the method of image fusion was proposed. According to the pattern fusion mapping relationship, the pattern was integrated into the clothing image output by the discriminator to realize the multi-style transfer of clothing styles and patterns. In order to verify the effectiveness of the above method in the multi-style transfer of clothing images, the clothing image design sketches generated in the experiment were compared with the design sketches generated by CycleGAN and InstaGAN models. By subjectively analyzing the style diversity and detail differences of the design sketches, the IS and SSIM were used for quantitative analysis, and the subjective visual effect and objective numerical comparison both showed the advantages of this experimental method in the diversity and the authenticity of image details.

The multi-style transfer of clothing styles and patterns can provide designers with creative inspiration and shorten the time period required for effect presentation, making AI more suitable for assisting clothing design behavior. In subsequent experiments, we will explore the transfer of more types of clothing styles, so as to achieve a diversified and controllable style transfer method. In addition, emotional elements needed for perceptual design should be added in the process of image style transfer, so as to promote the integration of computational thinking and design thinking of future-oriented design paradigm.

Keywords:

mix and match style transfer; generative adversarial network; clothing style; clothing pattern; intelligent design; clothing design