聊聊ChatGPT

河北师范大学附属民族学院 王际川

一款名为ChatGPT 的智能聊天程序自2022 年11 月30 日发布至今年2 月,就在全球狂揽1 亿名用户!它不仅可以让用户享受到“秒回式”的聊天体验,而且面对任何问题都能对答如流,就像和一名知识渊博的朋友在面对面交流。

ChatGPT 是美国人工智能研究公司OpenAI 研发。它能够学习和理解人类的语言,还能根据聊天的上下文内容像人类一样进行对话互动,甚至能撰写邮件、视频脚本和文案,还能翻译、写代码、写论文等。如此强大的功能很快引起了大众的高度关注,其中不乏想不劳而获走捷径的“聪明人”。很快,欧洲和美洲的各大高校明确提出禁止学生使用ChatGPT 做作业。Chat⁃GPT 具有足够高的智能化,但学习没有捷径,青少年朋友千万不要效仿那些“聪明人”的不良行为。

我们一起来实际体验ChatGPT 的奇妙吧!我使用的是Visual Studio Code 程序中的扩展程序“CHAT-GPT 中文版”体验智能聊天。

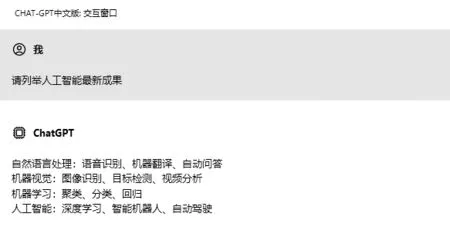

◎体验一:首先和它聊聊互联网知识储备。提出问题“请列举人工智能最新成果”。

ChatGPT 从四个方面给出了精准答案,非常不错!

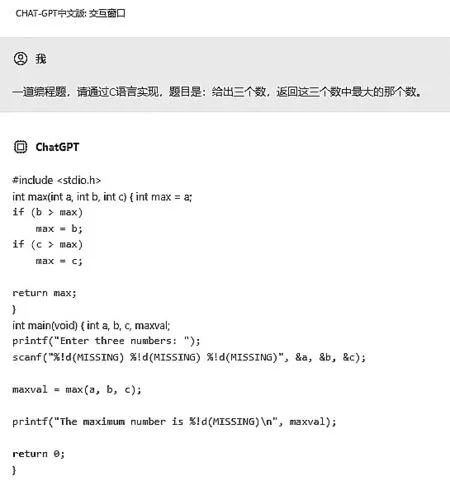

◎体验二:在发布时,团队称ChatGPT是编程神器,可写程序代码,甚至可以修改程序的bug(程序错误、缺陷),我们就考考它的编程能力。问题是“一道编程题,请通过C 语言实现。题目是:给出三个数,返回这三个数中最大的那个数。”这个题目首先需要明确是编程题,还要指定用C 语言实现,然后才是程序的要求。没有足够高的理解能力,不精通计算机编程C 语言,是万万做不到的。

当它经过简短“思考”后,给出的答案从语法结构、程序语句都无可挑剔。Chat⁃GPT 显示出的这种能力给人感觉今后编程将会变得非常简单,在它的辅助下,甚至人人都可以成为优秀的程序员。

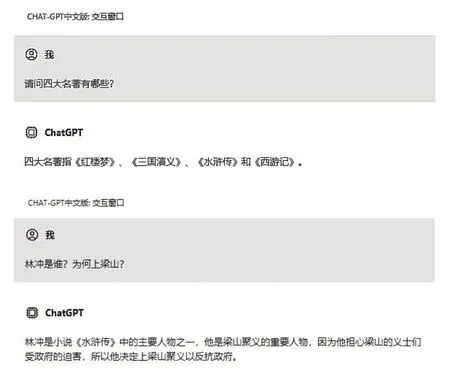

◎体验三:我们考考ChatGPT 对博大精深的中华文化掌握得怎么样。

前一问回答得完全正确。对有点儿难度的“林冲是谁?为何上梁山?”回答虽不太严谨,也能给出简要的答案。

◎体验四:提升难度,看看它的数学推理能力。经典数学问题:鸡兔同笼。第一题“鸡兔同笼。有20 个头,54 只脚,鸡、兔各有多少只?”

面对一再的“逼问”,不知是故意的还是没训练好,它开始一本正经地“胡说”,面对提醒仍然“不知悔改”。于是我再换一道同类型的题“有鸡、兔共36 只,它们共有100 只脚,鸡、兔各有多少只?”。

看着它“自信”的秒回答案,看来Chat⁃GPT 的奥数水平还有待提高,放过它这一马吧!

◎体验五:最后我们来向它“寻计问策”。问“有些中学生不热衷公益活动是什么心态?”“怎样去改变他们的心态?”

这两个问题的回答中规中矩,基本满意。

通过上述案例及参考网上其他案例,我们能够体会到,面对常识类问答,Chat⁃GPT 显得比较轻松,但对逻辑推理类等问题还有待进一步学习提升。对于ChatGPT的智能性,复旦大学人工智能创新与产业研究院院长漆远的感觉是“惊讶”。他说,鸡兔同笼、相遇问题等小学数学题,Chat⁃GPT 全都顺利作答(与我们体验不太相符,难道是英文表述的鸡兔同笼的问题?也有可能是没有选择对程序,笔者没有亲测),而此前这对AI(人工智能)来说是不可能实现的。这表明,随着算法迭代,实现了从量变到质变,ChatGPT 不仅具备了语言方面的能力,更具备了数学推理能力。

ChatGPT 是如何实现具有“前所未有”的智能呢?ChatGPT 是基于NLP(自然语言处理)的产物。马萨诸塞大学洛厄尔分校计算机科学教授Jie Wang 认为,ChatGPT 最主要的突破在于其背后架构GPT-3.5 中使用的few-shots(小样本)和用户反馈的技术。而且,ChatGPT 拥有其他语言模型所不具备的千亿级别参数规模,也使它能够捕获更复杂的语言模式和关系。

下面通过解读几个关键词让大家理解上述表述,了解ChatGPT。

1.NLP(自然语言处理)。

ChatGPT 之所以能够成为一个现象级的火爆应用,在于它能够自动生成类似于人类撰写的文本。支持ChatGPT 能够如此出色地生成有意义的文本是NLP(自然语言处理),它能够让计算机理解、解释和生成人类语言。

2.few-shots(小样本)和反馈的技术。

小样本技术又名few shots learning(小样本学习),在机器学习领域中泛指从少量标注数据中学习的方法和场景。要理解小样本,涉及到另一个概念——提示(prompt⁃ing),因为“提示”是ChatGPT 接受用户反馈的形式。

举一个非常简单的例子帮助大家理解。假设作为校园小记者的小明使用ChatGPT 辅助编写新闻稿时,需要ChatGPT对一段较长的新闻进行归纳总结或生成一个标题,这时可以给ChatGPT 一点小提示——例如,小明是《农村青少年科学探究》杂志“创客校园”版块的小记者,他需要几个“吸睛”的标题。相比简单要求“请生成一个标题”,有了关键词的提示,会让ChatGPT 有更明确目标和显著效果。

3.千亿级别参数。

据称,基于8 000 亿个单词的语料库(或45TB 的文本数据),ChatGPT 包含了1 750 亿个参数。8 000 亿 是ChatGPT 的 训练数据,1 750 亿个参数则是它从这些训练数据中学习、沉淀下来的内容。如此巨大的参数规模使得ChatGPT 能够捕获更复杂的语言模式和关系,从而提高复杂自然语言处理任务的准确性。

我们可以将1 750 亿个参数理解为ChatGPT 具有1 750 亿神经元,而人的大脑仅有120 亿~140 亿个神经元。让人瞠目结舌的是,自2018 年始,巨型神经网络模型参数每年都会增大一个数量级。权威专家预言,OpenAI 的下一代GPT-4 将会突破万亿参数,甚至将达到100 万亿参数。也就是说,未来的Chat⁃GPT 有可能会比人脑聪明一万倍。

具有了这种超大模型千万亿级参数,也仅仅是它的“物质基础”——“大脑”,还需要通过“训练”“学习”才能让这个“大脑”“善解人意”。这种训练又需要高性能网络支撑、链路负载均衡与故障快速恢复技术做支撑。

首先,ChatGPT 整体技术方案是基于GPT-3.5 大规模语言模型通过人工反馈强化学习来微调模型,让模型一方面学习人的指令,另一方面学习回答得好不好。ChatGPT 具有及时互动的价值,因此面对来自不同国家地区、不同语言、不同文化背景、不同需求的人群,“反馈”也是来自网络世界的不同角落,是一种分布式训练,自然需要高性能网络的支持。

其次,ChatGPT 是一个巨大人工智能模型,以现行的具有1 750 亿参数的大规模集群来说,进行大模型训练一般会将数据并行、流水线并行、张量并行等多种并行模式混合使用,以充分利用集群的算力。无论是哪种并行模式,多机之间都会涉及一种叫AllReduce(全规约,简单可以理解为分布式训练中的服务器数据同步)的集合通信。一个AllReduce 任务包含多个点对点的通信,而AllReduce 的完成需要所有点对点通信都成功完成。因此,集合通信存在“木桶效应”,即AllReduce 的完成时间,由其中最慢的点对点通信时间决定。因此,除了高性能的网络互联“高铁”外,还需要链路负载均衡与故障快速恢复。

目前,在技术应用层面ChatGPT 还存在一些弱点。这主要是因为ChatGPT 本质是语言模型,当前的训练技术模型还不具备推理能力,或者说推理能力很弱,因此给出的回答不是完全正确可信。其次,目前的ChatGPT 底层技术方案不支持获取社会热点新闻,不能够回答2021 年之后的问题,存在一定的信息滞后。最后就是成本问题。

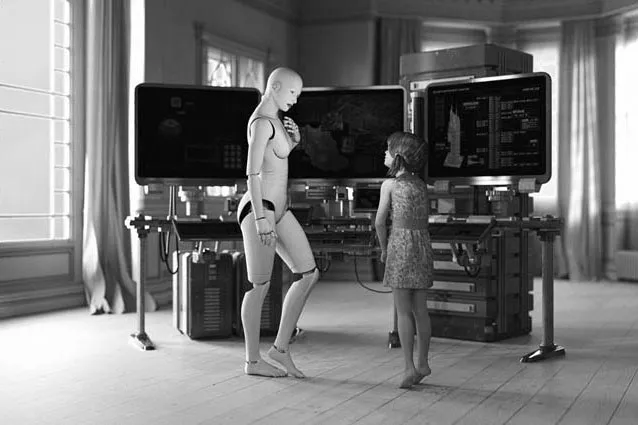

在对未来世界的幻想或展望中,在我们的学习工作生活中会出现具备与人类同等智慧、或超越人类的人工智能(AI)。它能表现正常人类所具有的所有智能行为,能思考、能判断、有思想、有伦理——这就是通用AI。2001 年6 月26 日上映的科幻电影《人工智能》给出了人类对人工智能的期望。那么ChatGPT 的出现似乎让人类看到了通用AI 的曙光,具有里程碑式的意义,距离实现人类对人工智能期望的目标又前进了一大步。

回顾人类社会的发展历史,已经出现了计算机、互联网、智能手机等数次超级工具,极大地改变了人们的思维和生活方式。可以设想如果用ChatGPT 来代表基于大型通用语言模型的应用,那么ChatGPT 很有可能成为下一个改变世界的超级工具,也许会改变人类学习、工作和生活的方式。不过,以目前的实际情况来看,ChatGPT 离通用AI 仍然还有一段很长的路要走。希望青少年朋友好好学习,能够在未来人工智能领域作出自己的贡献,早日实现人类对人工智能的期盼!