基于改进YOLOv5s的名优绿茶品质检测

尹 川,苏议辉,潘 勉,段金松

•农业信息与电气技术•

基于改进YOLOv5s的名优绿茶品质检测

尹 川,苏议辉,潘 勉※,段金松

(杭州电子科技大学电子信息学院,杭州 310018)

针对实际检测过程中茶叶数量多、体积小、茶叶之间颜色和纹理相似等特点,该研究提出了一种基于YOLOv5s的名优绿茶品质检测算法。首先,该算法在骨干网络层引入膨胀卷积网络,通过增大感受野的方式增强茶叶微小特征的提取。其次,改进特征融合进程,基于通道注意力和空间注意力抑制无关信息的干扰,构建CBAM注意力机制优化检测器。接着根据swin transformer网络结构在多个维度对小尺度茶叶的特征进行交互和融合。最后,配合SimOTA匹配算法动态分配茶叶正样本,提高不同品质茶叶的识别能力。结果表明,改进后的算法精准度、召回率、平均精度均值、模型体积、检测速度分别为97.4%、89.7%、91.9%、7.11MB和51帧/s,相较于基础的YOLOv5s平均精度均值提高了3.8个百分点,检测速度提高了7帧/s。利用相同数据集在不同目标检测模型上进行对比试验,与Faster-RCNN、SSD、YOLOv3、YOLOv4等模型相比,平均精度均值分别提升10.8、22.9、18.6、8.4个百分点,进一步验证了该研究方法的有效性和可靠性。

机器视觉;图像识别;茶叶品质检测;YOLOv5s;感受野;swin transformer;注意力机制;SimOTA

0 引 言

中国是世界上茶叶的主要生产和出口国家之一,近年来茶叶生产呈现迅速增长的趋势[1-3],茶叶产量不断提高,在国民经济占据相当重要的地位。茶叶是一种历史悠久的传统饮品,其品质的好坏关系到消费者对茶叶的认可和信赖。茶叶品质检测通常会运用感官审评法[4-6],该方法是评审员根据自身的经验对茶叶进行相应的评定,确定茶叶的等级和品质,评审结果随机性大,可重复性差。为了改变目前茶叶市场良莠不齐、鱼龙混杂的不良状况,除加强监管力度外,通过科技手段对茶叶品质进行量化评估是另一种有效途径。

随着图像处理技术的不断进步[7-8],计算机视觉在茶叶品质检测的研究也日益增多,目前对于茶叶品质的研究大多使用机器学习[9]的方式。国内外相关学者借助传统的图像分割[10]、标记以及HIS颜色模型等技术在提取茶叶色泽特征等领域开展了大量研究[11-14],徐海卫等[15]提出了基于灰度共生矩和Tamura的茶叶特征提取方法,并将其应用在BP神经网络上,仿真试验具有一定成效;刘自强等[16]采集了10种茶叶鲜叶,使用灰度共生矩阵提取颜色、形态、分形以及纹理4类特征,在6种分类器中训练,结果表明SVMKM和随机森林的检测效果最好。汪建等[17]提出了基于HIS模型的特征提取方法,在BP神经网络中加入茶叶颜色参数和形状参数,检测效果良好。然而传统的图像识别技术依赖于人工特征提取,对光照、视角和尺度敏感,不仅工作量大而且泛化能力及鲁棒性较差。

与传统的机器视觉技术相比,基于深度学习[18-19]的算法根据大量样本数据,自动提取样本的多维特征,具有更强的适应性和可移植性,常用的检测算法有:R-CNN[20]、YOLO[21]、SSD等。吕军等[22]利用AlexNet卷积神经网络识别茶叶嫩芽状态,实现了自然光照下茶叶嫩芽的分类。孙肖肖等[23]提出了基于YOLO的茶叶图像检测模型,采用中尺度和大尺度预测层,提升了检测效率。YANG等[24]改进了YOLOv3网络,利用残差结构和新的卷积运算,有效提升茶叶的检测精度。

通过上述文献可以看出,主流的深度学习模型算法[25-29]具有高度的鲁棒性,但研究目标主要为嫩芽,针对名优绿茶的品质检测相关研究较少,本文针对实际检测过程中茶叶颜色纹理相似,数量多、体积小等特点,提出了一种基于改进YOLOv5s的名优绿茶品质检测算法YOLOv5s-tea。该算法首先在骨干网络的末端设计新的TDC(three-branch dilated convolution)膨胀卷积结构,增强网络的感受野从而提高网络对茶叶的特征提取能力,得到茶叶相邻区域的特征信息。其次基于注意力机制,自适应学习输入数据中的通道和空间信息。然后引入Swin transfomer增强茶叶小目标的语义信息和全局感知能力;最后采用了SimOTA正样本匹配算法,为每颗茶叶正样本分配一个真实目标框,结果表明,本文所提方法可以显著提升名优绿茶品质检测的效率及精度。

1 茶叶图像数据获取与预处理

1.1 图像采集方法

本文检测目标选用新昌扁形名优绿茶,综合评茶师鉴定和市场标准将茶叶根据牙尖、条索、净度、色泽4项指标分为5个等级。如图1所示,第一等级茶叶条索紧结,牙尖细窄,叶脉平滑,色泽翠碧;第二等级茶叶条索饱满,主侧脉成对多为闭合,张口略小;第三等级茶叶条索交错,叶脉散开,呈多齿状,少数侧脉短小,张口略大;第四等级茶叶细小,形态各异,参差不齐,色泽暗沉;第五等级茶叶呈粉末细屑状,多为杂质。

图像采集于浙江省新昌县茶叶数字化生产基地,采集时保证背景单一,光照稳定,避免太阳光直射和光线不足,角度统一为正上方30~40 cm,共采集茶叶图像412张。利用目标标注工具Labelling对采集到图像中的各个等级茶叶进行人工标注,图像标注时使用最小外接矩阵保证矩形框内尽可能排除无关像素。将原始图像中茶叶归纳成5个等级进行数据标注并生成XML格式文件,按9∶1的比例划分为训练集和测试集。

图1 不同品质茶叶外形特征

1.2 图像数据预处理

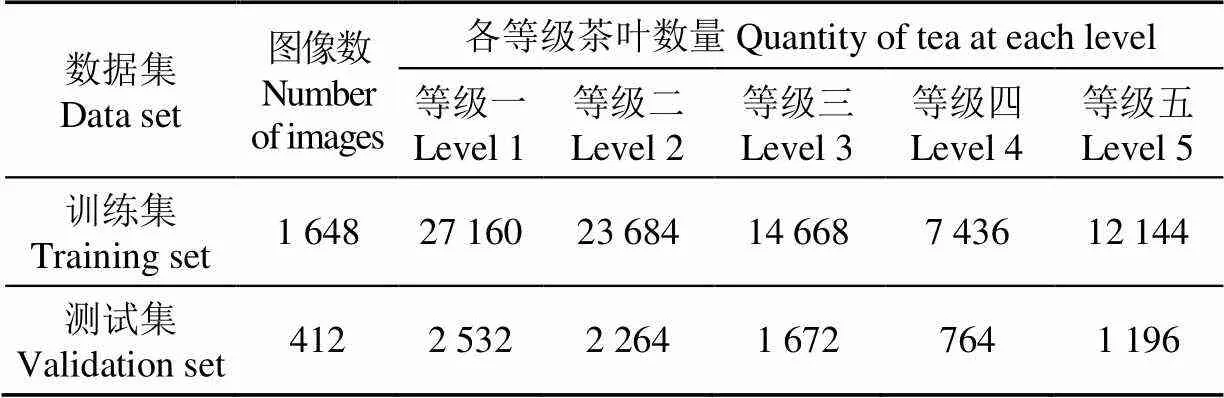

为丰富训练集数据的多样性,本文模拟不同环境下茶叶外形特征的表现形式,增强模型泛化能力,采用水平镜像、旋转角度、对比度增强和亮度增强4种方式进行数据集扩增。亮度增强和对比度增强权重均设置为0.9和1.1之间的随机数。数据增强后生成图像2 060张,每张图像含40~70颗茶叶,共计茶叶数量95 580颗,如图 2所示。最终得到的各等级茶叶数量如表1所示。

图2 数据增强示例

表1 茶叶数据增强后数据集

2 改进YOLOv5s的茶叶图像目标检测算法

2.1 YOLOv5s网络

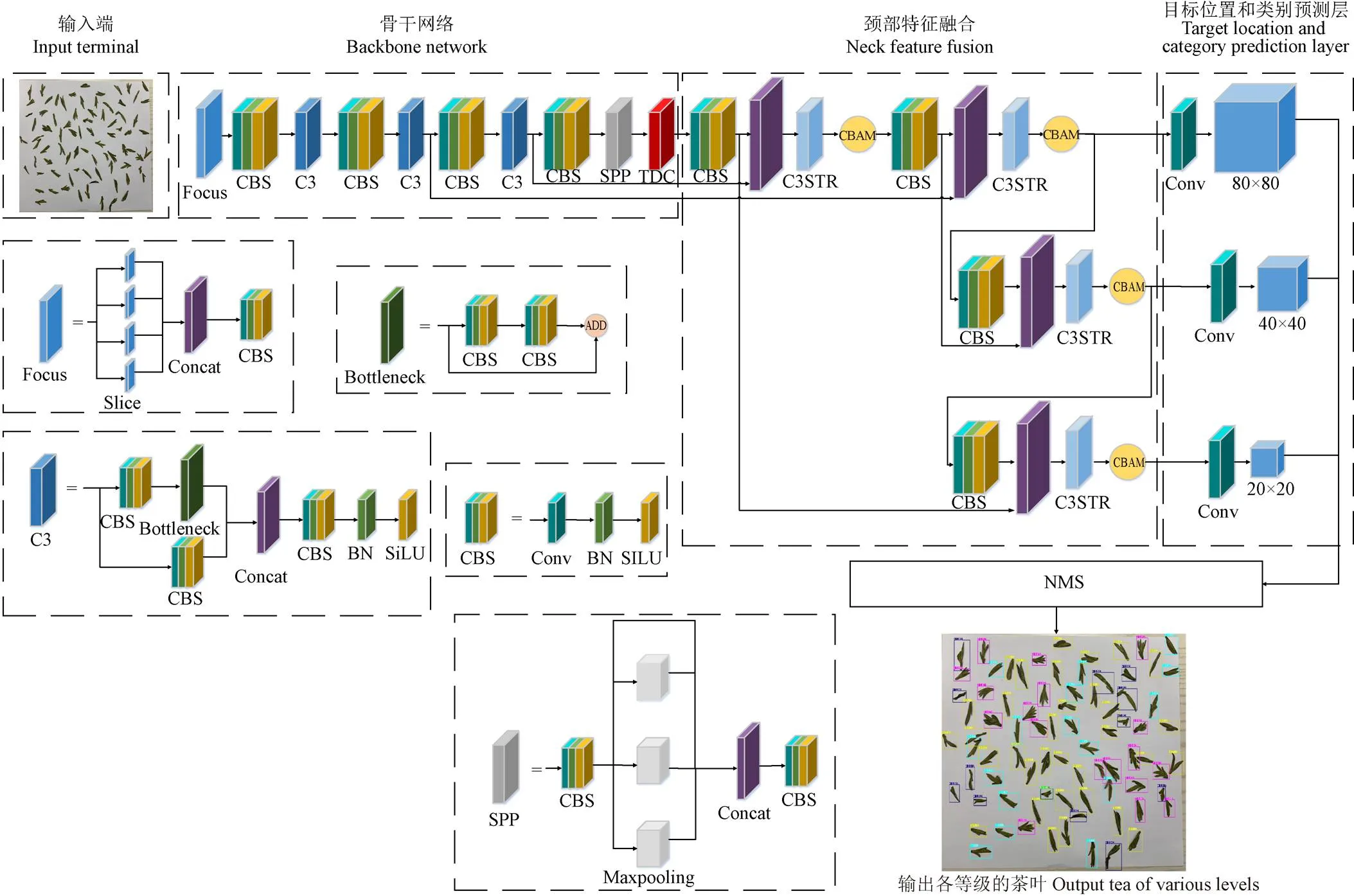

YOLOv5s算法框架主要由输入端,主干网络,特征融合,预测层4个模块组成,如图3所示。输入端输入尺寸大小为640×640的训练图像。

图3 YOLOv5s算法结构

YOLOv5s采用CSPDarknet作为主干网络,每个模块包含多个卷积层和一个跨阶段连接块,结合切片结构(Focus)和空间金字塔池化(spatial pyramid pooling,SPP)共同提取特征。特征融合部分采用FPN+PAN的结构,FPN层从顶部传达语义信息,PAN结构从底部传达定位信息,以多尺度特征融合的方式将提取到的特征传入预测层,输出尺度分别为80×80、40×40、20×20,实现不同大小目标的类型和位置预测,最后通过非极大抑制算法获得最终预测框。

2.2 YOLOv5s网络改进

本研究所用茶叶品质检测网络以图3中YOLOv5s作为基准线网络,改进后的整体框架结构如图4所示。在骨干网络的末端加入TDC膨胀卷积结构,增强网络的感受野从而提高网络对茶叶的特征提取能力,得到茶叶相邻区域的特征信息。由于茶叶目标比较密集,容易出现误检情况,因此使用CBAM注意力机制进行更新,将网络的注意力集中于茶叶的感兴趣区域,进一步增强小目标信息的提取能力。接着在颈部C3模块中添加Swin Transformer,克服CNN卷积操作的局限性,识别底层特征的抽象信息,增强小目标茶叶的语义信息。最后使用SimOTA正样本匹配算法动态分配正样本,根据中心先验确定茶叶正样本候选区域,提升网络的检测速度的同时也提高茶叶品质的检测精度。

注:Conv为卷积,BN为批量归一化,SILU为激活函数,SPP为池化层,Concat为特征拼接层,Slice为对输入张量进行切片操作,NMS为非极大抑制算法。

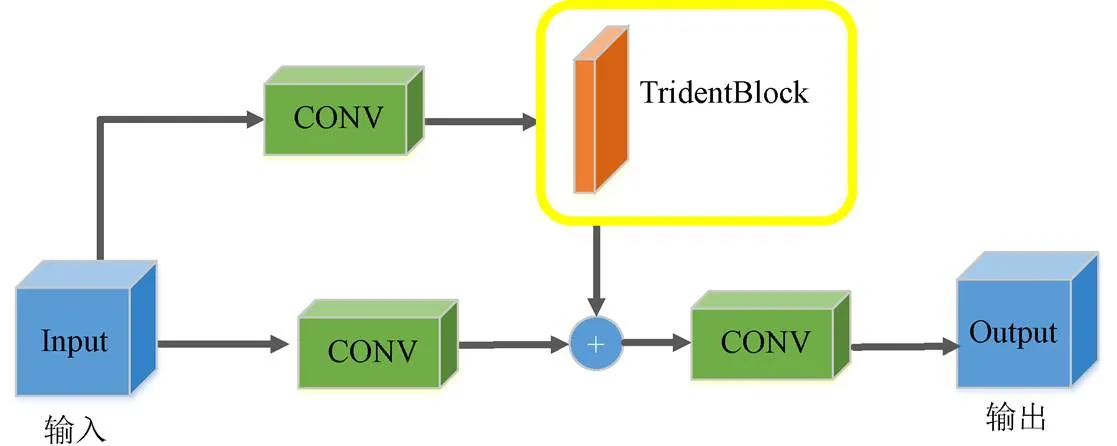

2.2.1 膨胀卷积模块

由于数据集中不同等级茶叶颜色纹理相近,YOLOv5骨干网络不能提取到有效的特征。为了增强骨干网络对茶叶图像全局特征的提取能力,本文基于膨胀卷积模块的感受野优势,提出一种改进的三支路特征融合的结构TDC,如图5所示。

该模块利用TridentBlock网络得到不同感受野的特征图,特征图分别输入到两个1×1的卷积层,减少模型参数,上层特征图经过TridentBlock 结构增强网络的特征提取能力,并与下层特征图相加,建立输入层和输出层的直接映射关系,实现特征的转换和提取。

图5 TDC结构

TridentBlock网络通过膨胀率为1、2、3的膨胀卷积扩大网络的感受野,在不增加卷积核大小的情况下忽略空间因素的影响,使特征图覆盖到更大的范围,提高计数准确率。膨胀卷积的表达式如下所示:

2.2.2 注意力机制模块

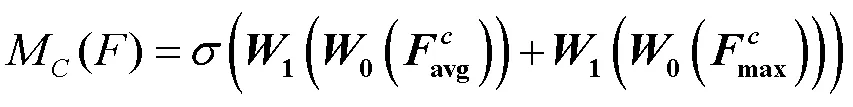

通道注意力利用全局平均池化对每个通道进行池化,然后通过全连接层自适应地学习通道之间的相互依赖关系,降低冗余或无关信息的通道权重,从而提高特征的判别性。通道注意力的表现形式具体为

空间注意力通过学习输入图像中不同部分的权重,加强不同位置特征的关注度。在茶叶品质检测任务中,引入空间注意力关注茶叶的空间位置特征,其计算如下:

2.2.3 C3STR结构

随着网络结构的加深,经过多次卷积操作之后,茶叶数据集的小尺度目标的位置信息粗糙,特征信息易丢失。因此,本研究在特征融合部分引入了Swin Transformer,将其嵌入到C3卷积模块中,借助窗口自注意力模块增强小目标的语义信息和特征表示,改进后的卷积结构如图6所示。

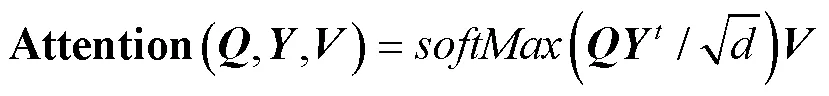

Swin Transformer采用了一种新的层次化构建方法,通过块合并层进行下采样得到更深维度的特征图。主要由多层感知机、窗口多头自注意力层、滑动窗口多头自注意力层、标准化层构成,注意力计算式如下:

与传统Transformer的多头自注意力模块(MSA)相比,C3STR模块在局部窗口内计算自注意力,将输入图像分成若干个子窗口,并且引入滑动窗口自注意力机制实现各个窗口之间的信息交互,在一定程度上减小了网络计算量,提高了计算效率。

图6 C3STR 结构

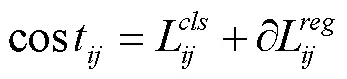

2.2.4 SimOTA算法

2.3 试验环境

试验模型的硬件选择Intel Core i9-10900X CPU@ 3.70 GHz、GeForce RTX3090 Ti GPU,软件选择windows10操作系统、PyTorch深度学习框架、YOLOv5s网络模型、Python编程语言。训练时初始学习率设置为0.001,迭代次数设置为200次,批次大小设置为 16。

2.4 模型性能评估指标

选用精准度(precision,)、召回率(recall,)、平均精度均值(mean average precision,mAP)、模型体积以及检测速度作为评估指标[25]。设定预测目标和实际目标的平均交并比(intersection over union,IoU)阈值为0.5,若IoU超过该阈值则为正样本,反之则为负样本。

3 结果与分析

3.1 YOLOv5s改进后的试验结果对比

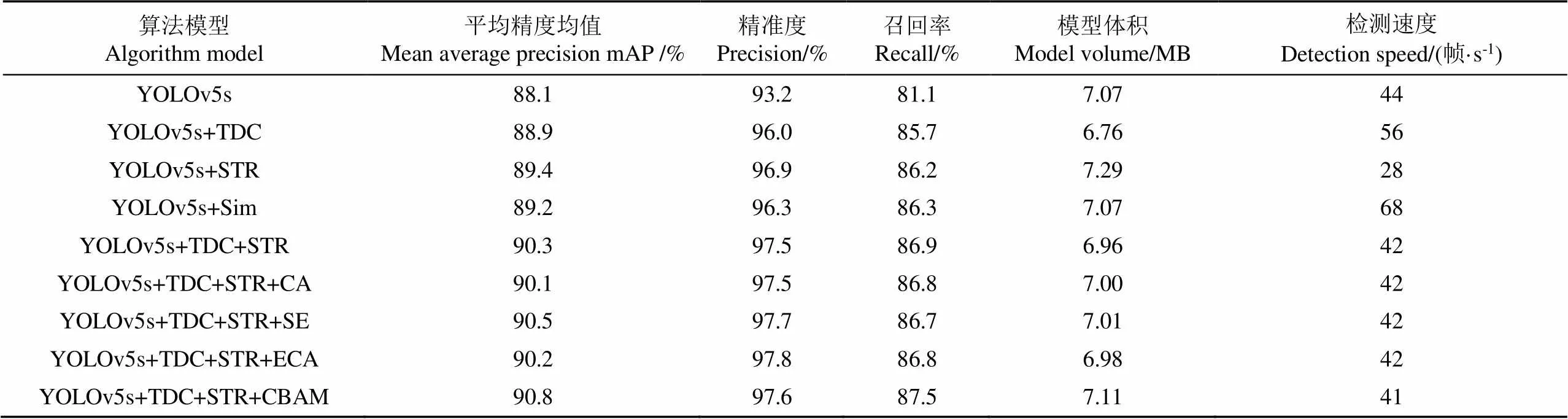

为了验证不同改进方案对茶叶品质检测的优化作用,以YOLOv5s为基础网络研究膨胀卷积TDC结构、Swin transformer网络以及SimOTA算法的有效性,试验结果如表2所示。

将原始YOLOv5s模型中特征提取网络的C3结构替换成TDC,改进后的网络模型体积有一定量的减小,检测速度提高了12帧/s,平均精度均值提高了0.8个百分点。证明膨胀卷积TDC结构能够有效增强网络的感受野,提高对茶叶特征的提取能力。在算法中特征融合部分引入Swin Transformer网络,其余部分不做改动。改进后的网络模型的平均精度均值提高了1.3个百分点,模型体积略微变大,检测速度下降了16帧/s,证明Swin transformer能够以牺牲部分检测速度为代价,有效提高对茶叶小尺度特征的全局感知能力。在原有网络中加入SimOTA正样本匹配算法,模型平均精度均值提升了1.1个百分点,模型检测速度提高了24帧/s,证明SimOTA算法通过动态分配正样本,能更好地匹配真实目标框,进而提高检测效率和检测精度。

表2 YOLOv5s改进后试验结果对比

考虑到注意力机制容易受网络结构影响,以YOLOv5s+TDC+STR为基础网络研究注意力机制的优劣,在基础网络中分别加入CA 注意力模块、SE注意力模块、CBAM 注意力模块和ECA 注意力模块,可以看出,4种注意力机制都会增加少量的模型体积,但几乎不影响检测速度。CA注意力模块和ECA注意力模块会影响模型的检测精度,其中CA注意力模块使平均精度均值降低了0.2个百分点,ECA模块使平均精度均值降低了0.1个百分点,明显不适用于茶叶图像的目标检测任务。CBAM注意力模块和SE注意力模块对网络的平均精度均值带来一定提升,分别提升了0.5个百分点和0.2个百分点。因此,本文引入的CBAM注意力机制在该模型的应用更具有优越性。

3.2 消融试验结果分析

本研究提出的4种改进方法分别为 TDC、 Swin Transformer、CBAM、SimOTA。在自制茶叶数据集上,设计以下消融试验方法:1)基于改进前的YOLOv5s 网络,分别加入4种改进方法,以评估每种改进方法对原算法的优化效果;2)基于改进后的YOLOv5s-tea算法,分别移除4种改进方法,以评估每种改进方法对最终算法的效果影响。从表3中可以看出,对比改进前的YOLOv5s 算法,Swin transformer结构对检测精度的改进效果最为显著,平均精度均值提高了1.3个百分点,但模型体积增大了0.22 MB,检测速度降低了14帧/s。引入SimOTA算法对检测速度的改进效果最强,检测速度提高了24帧/s,而且对检测精度也有较好的提升,平均精度均值提高了1.1个百分点。相比于改进后的YOLOv5s-tea算法,移除Swin tranformer,平均精度均值降低了1.2个百分点,对模型的精度影响最大。移除TDC,模型体积增大了0.33 MB,检测速度降低了12帧/s,对速度影响最大。本文最终提出的YOLOv5s-tea算法相比于改进前的 YOLOv5s,在茶叶数据集上检测平均精度提升了3.8个百分点,模型体积略微增加了0.04 MB,但检测速度提高了7帧/s,能够在提高检测精度的同时保证检测效率。

表3 消融试验结果

注:“√”表示引入改方法。

Note:“√”"indicates the introduction of modification methods.

本文对最终改进后的算法的效果在各个等级数据集中进行了对比试验,如图7所示。将原始图放入模型中,各个等级的茶叶均被检测出并标注不同颜色的目标框。改进前少数等级一茶叶被误识别为等级三和等级四,少数等级二茶叶被误识为等级一和等级三,少数等级四茶叶被误识别为等级一,改进后误检率均有所下降,模型预测的置信度更高,识别效果更好。

3.3 不同网络的试验结果对比

在自制茶叶数据集上,将本文算法模型与当前主流算法模型在同一环境下进行对比。选择Fast-RCNN,SSD,YOLOv3,YOLOv4,YOLOv5s 5种主流网络模型进行对比试验,试验结果如表4。

注:浅蓝色目标框表示等级一的茶叶,黄色目标框表示等级二的茶叶,红色目标框表示等级三的茶叶,深蓝色目标框表示等级四的茶叶,绿色目标框表示等级五的茶叶,箭头指向误检或漏检的茶叶。

表4 与当前主流方法的对比试验结果

结果表明,本文提出的算法相比于其他主流检测模型,在检测精度和速度上均有很大提升,平均精度均值达到91.9%,检测速度达到51帧/s相比于YOLOv5s、YOLOv4、YOLOv3、SSD,平均精度均值分别提高了3.8、8.4、18.6、22.9个百分点,检测速度分别提高了7、28、20、16帧/s。相比于传统的 two-stage 算法 Faster R-CNN,平均精度均值提高了10.8个百分点,检测速度提高了44帧/s。综上所述,本文提出的 YOLOv5s-tea算法不论在检测精度还是在检测效率上都具有明显的优势。

4 结 论

本研究提出基于改进YOLOv5s的名优绿茶品质检测算法,为茶叶品质的量化评估提供新的科技手段。首先加入膨胀卷积增大网络的感受野。其次利用注意力机制改进特征融合模块。然后根据Swin Transformer采用新的层次化构建方法,借助窗口自注意力模块增强茶叶小目标的语义信息和特征表示。最后配合SimOTA匹配算法动态分配茶叶正样本,提高不同品质茶叶的识别能力。

试验结果表明,本文所提方法可以有效检测名优绿茶的品质,平均精度均值可以达到91.9%,与Faster-RCNN、SSD、YOLOv3、YOLOv4等模型相比,平均精度均值分别提升10.8、22.9、18.6、8.4个百分点,检测速度分别提高了44、16、20、28帧/s本文算法的检测精度和效率均有较大的提升,具有较高的应用价值,可以为后续的茶叶品质检测提供参考。

[1] LIU T, ZHANG L, YANG D, et al. Evaluation of uncertainty in determination of four organophosphorus pesticide residues in fresh tea leaves by gas chromatography[J]. Science and Technology of Food Industry, 2023, 44(1): 323-331.

[2] YE T, YAN H, WANG X, et al. Determination of four aflatoxins on dark tea infusions and aflatoxin transfers evaluation during tea brewing[J]. Food Chemistry, 2023, 405: 134969.

[3] 陶德臣. 近代中国茶叶对外贸易兴盛的社会影响[J]. 重庆大学学报(社会科学版),2023(1):188-200. TAO Dechen. The social influence of the prosperity of tea trade in modern China[J]. Journal of Chongqing University (Social Science Edition),2023(1):188-200. (in Chinese with English abstract)

[4] 郭艺丹. 茶叶检测评审研究进展与关键技术分析[J]. 茶叶学报,2023,64(1):10-20.

[5] 童阳,艾施荣,吴瑞梅,等. 茶叶外形感官品质的计算机视觉分级研究[J]. 江苏农业科学,2019,47(5):170-173.

[6] 何环珠,苏成家. 水质差异对铁观音冲泡品质的影响研究[J]. 福建茶叶,2020,42(6):11-12.

[7] 张新. 计算机图像处理中人工智能算法的运用探究[J]. 信息与电脑(理论版),2022,34(24):43-45. ZHANG Xin. Research on the application of artificial intelligence algorithm in computer image processing[J]. Information and Computer (Theoretical Edition), 2022, 4(24): 43-45. (in Chinese with English abstract)

[8] 张波. 在智能优化算法模式下探索计算机图像处理技术的应用[J]. 电子技术与软件工程,2021(1):133-134.

[9] 薛懿威,王玉,王缓,等. 基于高光谱的绿茶加工原料生化成分检测模型建立[J]. 食品工业科技,2023,44(10):282-291. XUE Yiwei, WANG Yu, WANG Huan, et al. Establishment of a hyperspectral spectroscopy-based biochemical component detection model for green tea processing materials[J]. Science and Technology of Food Industry, 2023, 44(10): 282-291. (in Chinese with English abstract)

[10] 陈超,齐峰. 卷积神经网络的发展及其在计算机视觉领域中的应用综述[J]. 计算机科学,2019,46(3):63-73. CHEN Chao, QI Feng. Review on development of convolutional neural network and its application in computer vision[J]. Computer Science, 2019, 46(3): 63-73. (in Chinese with English abstract)

[11] 孙旭东,廖琪城,韩熹,等. 基于电磁振动上料的茶梗和昆虫异物近红外光谱和荧光图像在线检测研究[J]. 光谱学与光谱分析,2023,43(1):100-106. SUN Xudong, LIAO Qicheng, HAN Xi, et al. Research on online detection of tea stalks and insect foreign bodies by near-infrared spectroscopy and fluorescence image combined with electromagnetic vibration feeding[J]. Spectroscopy and Spectral Analysis, 2023, 43(1): 100-106. (in Chinese with English abstract)

[12] 宋彦,汪小中,赵磊,等. 基于近红外光谱技术的眉茶拼配比例预测方法[J]. 农业工程学报,2022,38(2):307-315. SONG Yan, WANG Xiaozhong, ZHAO Lei, et al. Predicting the blending ratio of Mee tea based on near infrared spectroscopy[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(2): 307-315. (in Chinese with English abstract)

[13] LI X, SUN C, LUO L, et al. Determination of tea polyphenols content by infrared spectroscopy coupled with iPLS and random frog techniques[J]. Computers and Electronics in Agriculture, 2015, 112: 28-35.

[14] HU D, ZHANG Y, LI X, et al. Detection of material on a tray in automatic assembly line based on convolutional neural network[J]. IET Image Processing, 2021, 15(13): 3400-3409.

[15] 徐海卫,胡常安,汤江文,等. 基于机器视觉的神经网络在茶叶鉴别中的应用[J]. 中国测试,2014,40(3):89-92. XU Haiwei, HU Chang'an, TANG Jiangwen, et al. Application of BP neural network in classification of fresh tea grade based on machine vision[J]. China Measurement and Test, 2014, 40(3): 89-92. (in Chinese with English abstract)

[16] 刘自强,周铁军,傅冬和. 基于纹理和分形的鲜茶叶图像特征提取在茶树品种识别中的应用[J]. 中阿科技论坛,2021(6):123-127.

[17] 汪建,杜世平. 基于颜色和形状的茶叶计算机识别研究[J]. 茶叶科学,2008,28(6):420-424. WANG Jian, DU Shiping. Identification investigation of tea based on HSI color space and figure[J]. Journal of Tea Science, 2008, 28(6): 420-424. (in Chinese with English abstract)

[18] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Columbus, 2014: 580-587.

[19] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, 2016: 779-788.

[20] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[21] REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 7263-7271.

[22] 吕军,夏华鹍,方梦瑞,等. 基于AlexNet的茶叶嫩芽状态智能识别研究[J]. 黑龙江八一农垦大学学报,2019,31(2):72-78. LYU Jun, XIA Huayu, FANG Mengrui, et al. Research on intelligent identification of tea sprouts state based on AlexNet[J]. Journal of Heilongjiang Bayi Agricultural University, 2019, 31(2): 72-78. (in Chinese with English abstract)

[23] 孙肖肖,牟少敏,许永玉,等. 基于深度学习的复杂背景下茶叶嫩芽检测算法[J]. 河北大学学报(自然科学版),2019,39(2):211-216. SUN Xiaoxiao, MOU Shaomin, XU Yongyu, et al. Detection algorithm of tea tender buds under complex background based on deep learning[J]. Journal of Hebei University (Natural Science Edition), 2019, 39(2): 211-216. (in Chinese with English abstract)

[24] YANG H, CHEN L, CHEN M, et al. Tender tea shoots recognition and positioning for picking robot using improved YOLO-V3 model[J]. IEEE Access, 2019, 7: 180998-181011.

[25] 林森,刘美怡,陶志勇. 采用注意力机制与改进YOLOv5的水下珍品检测[J]. 农业工程学报,2021,37(18):307-314. LIN Sen, LIU Meiyi, TAO Zhiyong. Detection of underwater treasures using attention mechanism and improved YOLOv5[J].Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 307-314. (in Chinese with English abstract)

[26] WANG Jinpeng, GAO Kai, JIANG Hongzhe, et al. Method for detecting dragon fruit based on improved lightweight convolutional neural network[J].Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(20): 218-225.

王金鹏,高凯,姜洪喆,等. 基于改进的轻量化卷积神经网络火龙果检测方法(英文)[J]. 农业工程学报,2020,36(20):218-225. (in English with Chinese abstract)

[27] 毛腾跃,张雯娟,帖军. 基于显著性检测和Grabcut算法的茶叶嫩芽图像分割[J]. 中南民族大学学报(自然科学版),2021,40(1):80-88. MAO Tengyue, ZHANG Wenjuan, TIE Jun Image segmentation of tea buds based on salient object detection and Grabcut[J]. Journal of South-Central University for Nationalities( Natural Science Edition),2021,40( 1) : 80-88.

[28] 王子钰,赵怡巍,刘振宇. 基于SSD算法的茶叶嫩芽检测研究[J]. 微处理机,2020,41(4):42-48. WANG Ziyu, ZHAO Yiwei, LIU Zhenyu. Research on tea buds detection based on SSD algorithmon[J]. Microprocessor, 2020, 41(4): 42-48. (in Chinese with English abstract)

[29] BANERJEE M B, ROY R B, TUDU B, et al. Black tea classification employing feature fusion of E-Nose and E-Tongue responses[J]. Journal of Food Engineering, 2018, 244: 55-63.

[30] RICHTER B, RURIK M, GURK S, et al. Food monitoring: Screening of the geographical origin of white asparagus using FT-NIR and machine learning[J]. Food Control, 2019, 104: 318-325.

[31] 安晓飞,王培,罗长海,等. 基于K-means聚类和分区寻优的秸秆覆盖率计算方法[J]. 农业机械学报,2021,52(10):84-89. AN Xiaofei, WANG Pei, LUO Changhai, et al. Corn straw coverage calculation algorithm based on K-means clustering and zoning optimization method[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(10): 84-89. (in Chinese with English abstract)

[32] 张振国,邢振宇,赵敏义,等. 改进YOLOv3的复杂环境下红花丝检测方法[J]. 农业工程学报,2023,39(3):162-170. ZHANG Zhenguo, XING Zhenyu, ZHAO Minyi, et al. Detecting safflower filaments using an improved YOLOv3 under complex environments[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(3): 162-170. (in Chinese with English abstract)

[33] 冯俊鑫,陈国坤,左丽君,等. 基于GF-6 WFV影像和CSLE模型的山区耕地侵蚀定量评价及特征分析[J]. 农业工程学报,2022,38(21):169-179. FENG Junxin, CHEN Guokun, ZUO Lijun, et al. Quantitative evaluation and characteristic analysis of farmland erosion in mountainous areas based on GF-6 WFV image and CSLE model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(21): 169-179. (in Chinese with English abstract)

[34] 段洁利,王昭锐,邹湘军,等. 采用改进YOLOv5的蕉穗识别及其底部果轴定位[J]. 农业工程学报,2022,38(19):122-130. Duan Jieli, Wang Zhaorui, Zou Xiangjun, et al. Recognition of bananas to locate bottom fruit axis using improved YOLOv5[J].Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(19): 122-130. (in Chinese with English abstract)

[35] 王根,江晓明,黄峰,等. 基于改进YOLOv3网络模型的茶草位置检测算法[J]. 中国农机化学报,2023,44(3):199-207. WANG Gen, JIANG Xiaoming, HUANG Feng, et al. An algorithm for localizing tea bushes and green weeds based on improved YOLOv3 network model[J].Journal of Chinese Agricultural Machinery, 2023, 44(3): 199-207. (in Chinese with English abstract)

[36] 黄少华,梁喜凤. 基于改进YOLOv5的茶叶杂质检测算法[J]. 农业工程学报,2022,38(17):329-336. HUANG Shaohua, LIANG Xifeng. Detecting the impurities in tea using an improved YOLOv5 model[J]. Transactions of theChinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(17): 329-336. (in Chinese with English abstract)

Detection of the quality of famous green tea based on improved YOLOv5s

YIN Chuan, SU Yihui, PAN Mian※, DUAN Jinsong

(,,310018,)

The evaluation of tea quality can directly dominate the market value in the tea industry. Among them, the sensory evaluation is widely combined with the rational analysis to assess the quality of tea in recent years. However, some limitations are prone to the random evaluation with high error and strong repeatability. Physical and chemical approaches are also limited in the tea quality assessment, due to the costly, time-consuming, and destructive tasks. In this study, a computer vision-based approach was proposed to assess the appearance and sensory quality of Xinchang's renowned flat green tea. Various characteristics of tea were also considered during detection, such as the small scale, high density, and weak feature significance. A quality detection model was established for the tea shape sensory usingYOLOv5s deep learning and machine vision. A three-band diluted convolution (TDC) structure with the receptive fields was introduced to enhance the extraction of tea features in the backbone network. Additionally, the Convolution Block Attention Module (CBAM) was introduced to determine the attention area in the dense scenes using channel and spatial attention. The local perception of the network was also promoted to improve the detection accuracy of small-scale tea. Furthermore, the Swin Transformer network structure was also introduced to enhance the semantic information and feature representation of small targets with the help of window self-attention in the feature fusion stage. Finally, the positive sample matching was improved by the dynamically allocating positive samples using the SimOTA. An optimal box of sample matching was assigned to each positive tea sample for the high efficiency and the detection accuracy of the network. The ablation experiment was performed on the self-made tea dataset. The results show that the modified model was significantly improved the average accuracy of target detection on tea images. The improved YOLOv5 presented the higher confidence score in the tea quality detection than the conventional one. The higher accuracy was also achieved in the positioning. The detection accuracy increased by 3.8 percentage points in the applied dataset, indicating the greatly reduced false detection. Mean Average Precision (mAP) and Frame Per Second (FPS) reached 91.9% and 51 frames/s, respectively, indicating the multiclass average accuracy of YOLOv5. The FPS was also improved by 7 frames/s. The excellent real-time performance was achieved in the higher recognition accuracy and speed, compared with current mainstream target detections, indicating the feasibility and superiority of this model. These findings can provide a strong reference to improve the quality detection in tea market. In conclusion, the computer vision-based approach of the YOLOv5s can be expected to serve as a novel and effective way for the appearance and sensory quality of tea, with the better accuracy, speed, and efficiency in tea industry.

machine vision;image recognition;tea quality detection; YOLOv5s; receptive field; swin transformer; attention mechanism; SimOTA

2022-12-21

2023-04-24

浙江省自然科学基金资助项目(LQY20F010001)

尹川,博士,副教授,研究方向为深度学算法在农业方向的应用。Email:yinc@hdu.edu.cn

潘勉,博士,副教授,研究方向为计算机视觉、农业智能信息处理等。Email:ai@hdu.edu.cn

10.11975/j.issn.1002-6819.202212151

TP391.4;S24

A

1002-6819(2023)-08-0179-09

尹川,苏议辉,潘勉,等. 基于改进YOLOv5s的名优绿茶品质检测[J]. 农业工程学报,2023,39(8):179-187. doi:10.11975/j.issn.1002-6819.202212151 http://www.tcsae.org

YIN Chuan, SU Yihui, PAN Mian, et al. Detection of the quality of famous green tea based on improved YOLOv5s[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(8): 179-187. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.202212151 http://www.tcsae.org